2 ハードウェアの拡張

Oracle Exadata Database Machineは、クオータ・ラックからハーフ・ラック、ハーフ・ラックからフル・ラックに拡張したり、ラック同士を配線することによって拡張できます。

すべての新しい機器は、カスタマ・サポートID(CSI)を受け取ります。Oracle Engineered System Rackの新しい機器には、新しいCSIがあります。新しいCSIと既存のOracle Engineered System Rack CSIを調整する場合は、Oracleサポート・サービスに連絡してください。Oracleサポート・サービスに連絡する場合は、元のインスタンス番号または使用可能なシリアル番号、および新しい番号をお手元に用意してください。

- Oracle Engineered System X4-2以降でのエイス・ラックからクオータ・ラックへの拡張

- Oracle Exadata Database Machine X3-2でのエイス・ラックからクオータ・ラックへの拡張

- エラスティック構成の拡張

Oracle Engineered Systemは、Oracle Exadata Configuration Assistant (OECA)で定義されているように、最大でラックの容量までの多数のデータベース・サーバーおよびストレージ・サーバーで構成されるエラスティック構成で使用できます。 - 別のラックの追加によるラックの拡張

別のラックの追加によるOracle Engineered System Rackの拡張では、ラックの配線と構成を一緒に行います。

2.1 Oracle Engineered System X4-2以降でのエイス・ラックからクオータ・ラックへの拡張

Oracle Engineered System X4-2またはX5-2をエイス・ラックからクオータ・ラックに拡張するには、ソフトウェアを使用します。ラックの拡張にハードウェアを変更する必要はありません。

ただし、その他のOracle Engineered Systemバージョンでは、ハードウェアの変更が必要になる場合があります。詳細は、Oracle Exadata Database Machine X6-2: 大容量ディスクおよびフラッシュ・カードの追加およびOracle Engineered System X7-2、X8-2、X8M: エイス・ラック・システムからクオータ・ラックへのアップグレードを参照してください。

この手順は、ローリング・データベース停止以外に停止時間または停止を発生することなく実行できます。

注意:

次の手順でディスク・グループの名前およびサイズは例です。実際のシステムに合せて、コマンドの値を変更するようにしてください。

この手順では、最初のデータベース・サーバーおよび他のすべてのデータベース・サーバーのrootユーザーと、すべてのストレージ・セルのcelladminユーザーの間にユーザー等価が存在すると仮定しています。

セル・ホスト名とデータベース・サーバー・ホスト名それぞれのリストを含むテキスト・ファイルcell_groupおよびdb_groupを作成する必要があります。

- エイス・ラックのOracle Exadata Database Machine X4-2以降の現在の構成の確認と検証

次の手順では、現在の構成を確認および検証する方法について説明します。 - エイス・ラックのOracle Exadata Database Machine X4-2以降のデータベース・サーバー・コアのアクティブ化

次の手順では、データベース・サーバー・コアをアクティブ化する方法について説明します。 - Oracle Exadata Database Machine X6-2: 大容量ディスクおよびフラッシュ・カードの追加

- Oracle Engineered System X7-2、X8-2、X8M: エイスラック・システムからクオータ・ラックへのアップグレード

- エイス・ラックのOracle Exadata Database Machine X4-2以降のストレージ・サーバー・コアおよびディスクのアクティブ化

次の手順では、ストレージ・サーバー・コアおよびディスクをアクティブ化する方法について説明します。 - エイス・ラックのOracle Exadata Database Machine X4-2以降のグリッド・ディスクの作成

グリッド・ディスクの作成では、適切なオフセットを確保するために特定の順序に従う必要があります。 - エイス・ラックのOracle Exadata Database Machine X4-2以降のグリッド・ディスクのOracle ASMディスク・グループへの追加

次の手順では、グリッド・ディスクをOracle ASMディスク・グループに追加する方法について説明します。 - Oracle Exadata Database Machine X4-2以降の新しいクオータ・ラック構成の検証

Oracle ASMディスク・グループにグリッド・ディスクを追加したら、構成を検証します。

親トピック: ハードウェアの拡張

2.1.1 エイス・ラックのOracle Exadata Database Machine X4-2以降の現在の構成の確認と検証

次の手順では、現在の構成を確認および検証する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用して、データベース・サーバーの現在の構成を確認します。

# dcli -g db_group -l root 'dbmcli -e list dbserver attributes coreCount'たとえば、Oracle Exadata Database Machine X5-2エイス・ラックの場合、コマンドの出力は次のようになります。

dm01db01: 18 dm01db02: 18注意:

Oracle Exadata Database Machine X5-2エイス・ラック・データベース・サーバーのアクティブ・コア数は18です。Oracle Exadata Database Machine X4-2エイス・ラック・データベース・サーバーのアクティブ・コア数は12です。

エイス・ラックに構成されているデータベース・サーバーのコア数が異なる場合は、Oracleサポート・サービスに問い合せてください。

-

次のコマンドを使用して、ストレージ・サーバーの現在の構成を確認します。予想される出力は

TRUEです。# dcli -g cell_group -l celladmin 'cellcli -e LIST CELL attributes eighthrack'

2.1.2 エイス・ラックのOracle Exadata Database Machine X4-2以降のデータベース・サーバー・コアのアクティブ化

次の手順では、データベース・サーバー・コアをアクティブ化する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

データベース・サーバー・グループで、次のdcliユーティリティ・コマンドを使用してすべてのデータベース・サーバー・コアをアクティブにします。

# dcli -g db_group -l root 'dbmcli -e \ ALTER DBSERVER pendingCoreCount = number_of_cores'前述のコマンドで、number_of_coresは、アクティブ化するコアの合計数です。この値には、既存のコア数とアクティブ化する追加のコア数が含まれます。次のコマンドは、Oracle Exadata Database Machine X5-2エイス・ラックのすべてのコアをアクティブ化します。

# dcli -g db_group -l root 'dbmcli -e ALTER DBSERVER pendingCoreCount = 36'各サーバー・モデルでサポートされるコア数の詳細は、Oracle Exadata Database Machineのキャパシティ・オンデマンドの制限に関する項を参照してください

-

各データベース・サーバーを再起動します。

注意:

Oracle DatabaseとOracle Grid Infrastructureがアクティブな状態でローリング方式でこの手順を実行する場合は、データベース・サーバーを再起動する前に次の点を確認してください。

-

すべてのOracle ASMグリッド・ディスクがオンラインになっていること。

-

アクティブなOracle ASMリバランス操作がないこと。リバランス操作のステータスを確認するには、

V$ASM_OPERATIONビューに問い合せます。 -

Oracle DatabaseとOracle Grid Infrastructureを適切な方法で停止し、必要であればサービスをフェイルオーバーすること。

-

-

再起動が完了して次のサーバーに進む前に、データベース・サーバーで次の点を確認します。

-

Oracle DatabaseとOracle Grid Infrastructureサービスがアクティブであること。

『Oracle Real Application Clusters管理およびデプロイメント・ガイド』のインスタンスが実行中であることを確認するためのSRVCTLの使用に関する項および

crsctl status resource –w "TARGET = ONLINE" —tコマンドを参照してください。 -

アクティブ・コア数が正しいこと。

dbmcli -e list dbserver attributes coreCountコマンドを使用して、コア数を確認します。

-

関連項目:

-

『Oracle Real Application Clusters管理およびデプロイメント・ガイド』のSRVCTLを使用した1つ以上のインスタンスおよびOracle RACデータベースの停止に関する項

2.1.3 Oracle Exadata Database Machine X6-2: 大容量ディスクおよびフラッシュ・カードの追加

Oracle Exadata Database Machine X6-2エイス・ラック大容量システムのアップグレードではハードウェアの変更が必要になりますが、X6-2 Extreme Flashのアップグレードの場合は必要ありません。

2.1.4 Oracle Engineered System X7-2、X8-2、X8M: エイスラック・システムからクオータ・ラックへのアップグレード

Oracle Engineered System X7-2、X8-2またはX8M-2エイス・ラック・システムのアップグレードには、ハードウェアの変更が必要になります。エイス・ラックのデータベース・サーバーでは、CPUの1つがなくなり、CPU1のすべてのメモリーがCPU0に移動されています。ストレージ・サーバーは半分のコアが有効で、ディスクとフラッシュ・カードの半分が取り外されています。

Extreme Flashストレージ・サーバーを搭載したOracle Engineered System X7-2、X8-2またはX8Mエイス・ラック・システムでは、CPUおよびフラッシュ・カードを追加して、システムをクオータ・ラックに拡張できます。

大容量ストレージ・サーバーを搭載したOracle Engineered System X7-2、X8-2またはX8M-2エイス・ラック・システムの場合は、CPUおよびメモリーをデータベース・サーバーおよびエイス・ラック高容量ストレージ・サーバーに追加してシステムを拡張できます。

-

Exadata X7-2、X8-2またはX8M-2データベース・サーバーで、CPU1を取り付け、CPU0のメモリーの半分をCPU1に移動し、10/25GbE PCIカードをPCIeスロット1に移動します。

-

Exadata X7-2、X8-2またはX8M-2 Extreme Flashストレージ・サーバーで、4個のF640/F640v2フラッシュ・カードをPCIeスロット2、3、8および9に取り付けます。

2.1.5 エイス・ラックのOracle Exadata Database Machine X4-2以降のストレージ・サーバー・コアおよびディスクのアクティブ化

次の手順では、ストレージ・サーバー・コアおよびディスクをアクティブ化する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用してストレージ・サーバー・グループのコアをアクティブ化します。このコマンドはdcliユーティリティを使用し、

celladminユーザーとして実行します。# dcli -g cell_group -l celladmin cellcli -e "alter cell eighthRack=false" -

次のコマンドを使用して、セル・ディスクを作成します。

# dcli -g cell_group -l celladmin cellcli -e "create celldisk all" -

次のコマンドを使用して、フラッシュ・ログを再作成します。

# dcli -g cell_group -l celladmin cellcli -e "drop flashlog all force" # dcli -g cell_group -l celladmin cellcli -e "create flashlog all" -

次のコマンドを使用して、フラッシュ・キャッシュを拡張します。

# dcli -g cell_group -l celladmin cellcli -e "alter flashcache all"

2.1.6 エイス・ラックのOracle Exadata Database Machine X4-2以降のグリッド・ディスクの作成

適切なオフセットを確保するために、グリッド・ディスクの作成は特定の順序で行う必要があります。

グリッド・ディスク作成の順序は、グリッド・ディスクが最初に作成された順序と同じにしてください。Oracle Exadata Deployment Assistantを使用する標準デプロイメントの場合は、DATA、RECO、DBFS_DGの順です。すべてのDATAグリッド・ディスクをまず作成し、次にRECOグリッド・ディスク、さらにDBFS_DGグリッド・ディスクを作成します。

次の手順では、グリッド・ディスクを作成する方法について説明します。

注意:

この手順で示すコマンドでは、標準のデプロイメント・グリッド・ディスク接頭辞名DATA、RECOおよびDBFS_DGを使用しています。サイズのチェックはセル・ディスク02で行います。セル・ディスク02を使用するのは、セル・ディスク00および01のディスク・レイアウトがサーバーの他のセル・ディスクとは異なるためです。-

次のコマンドを使用して、グリッド・ディスクのサイズをチェックします。同じグリッド・ディスク接頭辞で開始するグリッド・ディスクでは各セルが同じサイズを返します。

# dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'DATA.*_02_.*\'" # dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'RECO.*_02_.*\'" # dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'DBFS_DG.*_02_.*\'"表示されるサイズは、グリッド・ディスク作成で使用します。

-

ステップ1で表示したサイズを使用してディスク・グループのグリッド・ディスクを作成します。次の表に、ラック・タイプとディスク・グループに応じてグリッド・ディスクを作成するコマンドを示します。

表2-1 Oracle Exadata Database Machine X4-2以降のエイス・ラックを拡張する際にディスク・グループを作成するコマンド

| ラック | コマンド |

|---|---|

|

Extreme Flash Oracle Exadata Database Machine X5-2以降 |

|

|

High Capacity Oracle Exadata Database Machine X5-2またはOracle Exadata Database Machine X4-2以降 |

|

2.1.7 エイス・ラックのOracle Exadata Database Machine X4-2以降のグリッド・ディスクのOracle ASMディスク・グループへの追加

次の手順では、グリッド・ディスクをOracle ASMディスク・グループに追加する方法について説明します。

エイス・ラックのOracle Exadata Database Machine X4-2以降のグリッド・ディスクの作成で作成されたグリッド・ディスクは、対応する既存のOracle ASMディスク・グループにOracle ASMディスクとして追加する必要があります。

-

次を検証します。

- リバランス操作が現在実行していないこと。

- すべてのOracle ASMディスクがアクティブになっていること。

-

Oracle Grid Infrastructureソフトウェアを実行している所有者として、最初のデータベース・サーバーにログインします。

-

サーバーの+ASMインスタンスにアクセスするように環境を設定します。

-

次のコマンドを使用して、ASMインスタンスに

sysasmユーザーとしてログインします。$ sqlplus / as sysasm -

次のように現在の設定を検証します。

SQL> set lines 100 SQL> column attribute format a20 SQL> column value format a20 SQL> column diskgroup format a20 SQL> SELECT att.name attribute, upper(att.value) value, dg.name diskgroup FROM V$ASM_ATTRIBUTE att, V$ASM_DISKGROUP DG WHERE DG.group_number=att.group_number AND att.name LIKE '%appliance.mode%' ORDER BY att.group_number;出力は次のようになります。

ATTRIBUTE VALUE DISKGROUP -------------------- -------------------- -------------------- appliance.mode TRUE DATAC1 appliance.mode TRUE DBFS_DG appliance.mode TRUE RECOC1 -

次のコマンドを使用して、

TRUEが表示されたすべてのディスク・グループのappliance.mode属性を無効化します。SQL> ALTER DISKGROUP data_diskgroup set attribute 'appliance.mode'='FALSE'; SQL> ALTER DISKGROUP reco_diskgroup set attribute 'appliance.mode'='FALSE'; SQL> ALTER DISKGROUP dbfs_dg_diskgroup set attribute 'appliance.mode'='FALSE';このコマンドで、data_diskgroup、reco_diskgroupおよびdbfs_dg_diskgroupは、それぞれDATA、RECOおよびDBFS_DGディスク・グループの名前です。

-

グリッド・ディスクをOracle ASMディスク・グループに追加します。次の表に、ラック・タイプとディスク・グループに応じてグリッド・ディスクを作成するコマンドを示します。新しいディスクを調整するとシステムのリバランスが必要になります。

表2-2 エイス・ラックのOracle Exadata Database Machine X4-2以降を拡張する際にディスク・グループを追加するコマンド

ラック コマンド Extreme Flash Oracle Exadata Database Machine X5-2以降

SQL> ALTER DISKGROUP data_diskgroup ADD DISK 'o/*/DATA_FD_0[4-7]*' \ REBALANCE POWER 32; SQL> ALTER DISKGROUP reco_diskgroup ADD DISK 'o/*/RECO_FD_0[4-7]*' \ REBALANCE POWER 32; SQL> ALTER DISKGROUP dbfs_dg_diskgroup ADD DISK 'o/*/DBFS_DG_FD_0[4-7]*'\ REBALANCE POWER 32;High Capacity Oracle Exadata Database Machine X5-2またはOracle Exadata Database Machine X4-2以降

SQL> ALTER DISKGROUP data_diskgroup ADD DISK 'o/*/DATA_CD_0[6-9]*',' \ o/*/DATA_CD_1[0-1]*' REBALANCE POWER 32; SQL> ALTER DISKGROUP reco_diskgroup ADD DISK 'o/*/RECO_CD_0[6-9]*',' \ o/*/RECO_CD_1[0-1]*' REBALANCE POWER 32; SQL> ALTER DISKGROUPdbfs_dg_diskgroupADD DISK ' \ o/*/DBFS_DG_CD_0[6-9]*',' o/*/DBFS_DG_CD_1[0-1]*' REBALANCE POWER 32;成功すると、前述のコマンドによって

Diskgroup alteredが返されます。 -

(オプション)次のコマンドを使用して、現在のリバランス操作を監視します。

SQL> SELECT * FROM gv$asm_operation; -

次のコマンドを使用して、

appliance.mode属性を有効化します(ステップ6で無効化した場合)。SQL> ALTER DISKGROUP data_diskgroup set attribute 'appliance.mode'='TRUE'; SQL> ALTER DISKGROUP reco_diskgroup set attribute 'appliance.mode'='TRUE'; SQL> ALTER DISKGROUP dbfs_dg_diskgroup set attribute 'appliance.mode'='TRUE';

2.1.8 Oracle Exadata Database Machine X4-2以降の新しいクオータ・ラック構成の検証

グリッド・ディスクをOracle ASMディスク・グループに追加したら構成を検証します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用して、コア数をチェックします。

# dcli -g db_group -l root 'dbmcli -e list dbserver attributes coreCount' -

次のコマンドを使用して、ストレージ・サーバーの構成を確認します。

# dcli -g cell_group -l celladmin 'cellcli -e list cell attributes eighthrack'出力は

FALSEになる必要があります。 -

次のコマンドを使用して、各ディスク・グループのアプライアンス・モードを確認します。

SQL> set lines 100 SQL> column attribute format a20 SQL> column value format a20 SQL> column diskgroup format a20 SQL> SELECT att.name attribute, upper(att.value) value, dg.name diskgroup \ FROM V$ASM_ATTRIBUTE att, V$ASM_DISKGROUP DG \ WHERE DG.group_number = att.group_number AND \ att.name LIKE '%appliance.mode%' ORDER BY DG.group_number; -

次のコマンドを使用して、Oracle ASMディスクの数を検証します。

SQL> SELECT g.name,d.failgroup,d.mode_status,count(*) \ FROM v$asm_diskgroup g, v$asm_disk d \ WHERE d.group_number=g.group_number \ GROUP BY g.name,d.failgroup,d.mode_status; NAME FAILGROUP MODE_ST COUNT(*) ------------------------- ----------------------------- ------- ---------- DATAC1 EXA01CELADM01 ONLINE 12 DATAC1 EXA01CELADM02 ONLINE 12 DATAC1 EXA01CELADM03 ONLINE 12 RECOC1 EXA01CELADM01 ONLINE 12 RECOC1 EXA01CELADM02 ONLINE 12 RECOC1 EXA01CELADM03 ONLINE 12 RECOC2 EXA01CELADM01 ONLINE 12 RECOC2 EXA01CELADM02 ONLINE 12 RECOC2 EXA01CELADM03 ONLINE 12 DBFS_DG EXA01CELADM01 ONLINE 10 DBFS_DG EXA01CELADM02 ONLINE 10 DBFS_DG EXA01CELADM03 ONLINE 10すべての2ソケット・システム(エイス・ラック構成を除く)では、どのシステム・モデルでも、セルごとに12個のディスクが搭載されます。エイス・ラック構成では、セルごとに6個のディスクが搭載されます。

2.2 Oracle Exadata Database Machine X3-2でのエイス・ラックからクオータ・ラックへの拡張

Oracle Exadata Database Machine X3-2以前のラックをエイス・ラックからクオータ・ラックに拡張するには、ソフトウェアを使用します。ラックの拡張にハードウェアを変更する必要はありません。この手順は、ローリング・データベース停止以外に停止時間または停止を発生することなく実行できます。この項の次の手順で、Oracle Exadata Database Machine X3-2のエイス・ラックをクオータ・ラックに拡張する方法について説明します。

- Oracle Exadata Database Machine X3-2エイス・ラックでの現在の構成の確認と検証

- Oracle Exadata Database Machine X3-2エイス・ラックのデータベース・サーバー・コアのアクティブ化

このタスクでは、キャパシティオンデマンドでデータベース・サーバー・コアをアクティブ化する方法について説明します。 - Oracle Exadata Database Machine X3-2エイス・ラックのストレージ・サーバー・コアおよびディスクのアクティブ化

- Oracle Exadata Database Machine X3-2エイス・ラックでのグリッド・ディスクの作成

グリッド・ディスクの作成では、適切なオフセットを確保するために特定の順序に従う必要があります。 - Oracle Exadata Database Machine X3-2エイス・ラックでのグリッド・ディスクのOracle ASMディスク・グループへの追加

この手順では、グリッド・ディスクをOracle ASMディスク・グループに追加する方法について説明します。 - 新しいOracle Exadata Database Machine X3-2クオータ・ラックの構成の検証

親トピック: ハードウェアの拡張

2.2.1 Oracle Exadata Database Machine X3-2エイス・ラックでの現在の構成の確認と検証

次の手順では、現在の構成を確認および検証する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用して、データベース・サーバーの現在の構成を確認します。

# dcli -g db_group -l root /opt/oracle.SupportTools/resourcecontrol -show

次に、コマンドの出力例を示します。

dm01db01: [INFO] Validated hardware and OS. Proceed. dm01db01: dm01db01: system_bios_version: 25010600 dm01db01: restore_status: Ok dm01db01: config_sync_status: Ok dm01db01: reset_to_defaults: Off dm01db01: [SHOW] Number of cores active per socket: 4 dm01db02: [INFO] Validated hardware and OS. Proceed. dm01db02: dm01db02: system_bios_version: 25010600 dm01db02: restore_status: Ok dm01db02: config_sync_status: Ok dm01db02: reset_to_defaults: Off dm01db02: [SHOW] Number of cores active per socket: 4

注意:

Oracle Exadata Database Machine X3-2エイス・ラック・データベース・サーバーのアクティブ・コア数は4です。

エイス・ラックに構成されているデータベース・サーバーのコア数が異なる場合は、Oracleサポート・サービスに問い合せてください。

この手順を続行する前に、

restore_statusおよびconfig_sync_statusの出力が「OK」と表示されていることを確認してください。 -

次のコマンドを使用して、ストレージ・サーバーの現在の構成を確認します。予想される出力は

TRUEです。# dcli -g cell_group -l celladmin 'cellcli -e LIST CELL attributes eighthrack'

-

次のコマンドを使用して、フラッシュ・ディスクがOracle ASMディスク・グループで使用されないようにします。フラッシュ・キャッシュは、この手順で削除されて再作成されます。

# dcli -g cell_group -l celladmin cellcli -e "list griddisk attributes \ asmDiskgroupName,asmDiskName,diskType where diskType ='FlashDisk' \ and asmDiskgroupName !=null"

このコマンドでは、行は返されません。

2.2.2 Oracle Exadata Database Machine X3-2エイス・ラックのデータベース・サーバー・コアのアクティブ化

このタスクでは、キャパシティオンデマンドでデータベース・サーバー・コアをアクティブ化する方法について説明します。

:

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

データベース・サーバー・グループで、次の

dcliユーティリティ・コマンドを使用してすべてのデータベース・サーバー・コアをアクティブにします。# dcli -g db_group -l root /opt/oracle.SupportTools/resourcecontrol \ -core number_of_cores前述のコマンドで、number_of_coresは、アクティブ化するコアの合計数です。すべてのコアをアクティブ化するには、コア数として

Allを入力します。 -

次のコマンドを使用して、ローリング方式でデータベース・サーバーを再起動します。

# shutdown -r now注意:

ストレージ・サーバー・コアおよびディスクをアクティブ化する前に、restore_statusとconfig_sync_statusの出力がOkであることを確認します。再起動後、BIOSからステータスを取得するには、数分かかる場合があります。

2.2.3 Oracle Exadata Database Machine X3-2エイス・ラックのストレージ・サーバー・コアおよびディスクのアクティブ化

次の手順では、ストレージ・サーバー・コアおよびディスクをアクティブ化する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用してストレージ・サーバー・グループのコアをアクティブ化します。このコマンドはdcliユーティリティを使用し、

celladminユーザーとして実行します。# dcli -g cell_group -l celladmin cellcli -e "alter cell eighthRack=false"

-

次のコマンドを使用して、セル・ディスクを作成します。

# dcli -g cell_group -l celladmin cellcli -e "create celldisk all"

-

次のコマンドを使用して、フラッシュ・ログを再作成します。

# dcli -g cell_group -l celladmin cellcli -e "drop flashlog all force" # dcli -g cell_group -l celladmin cellcli -e "create flashlog all"

-

次のコマンドを使用して、フラッシュ・キャッシュを拡張します。

# dcli -g cell_group -l celladmin cellcli -e "alter flashcache all"

2.2.4 Oracle Exadata Database Machine X3-2エイス・ラックでのグリッド・ディスクの作成

適切なオフセットを確保するために、グリッド・ディスクの作成は特定の順序で行う必要があります。

グリッド・ディスク作成の順序は、グリッド・ディスクが最初に作成された順序と同じにしてください。Oracle Exadata Deployment Assistantを使用する標準デプロイメントの場合は、DATA、RECO、DBFS_DGの順です。すべてのDATAグリッド・ディスクをまず作成し、次にRECOグリッド・ディスク、さらにDBFS_DGグリッド・ディスクを作成します。

次の手順では、グリッド・ディスクを作成する方法について説明します。

注意:

この手順で示すコマンドでは、標準のデプロイメント・グリッド・ディスク接頭辞名DATA、RECOおよびDBFS_DGを使用しています。サイズのチェックはセル・ディスク02で行います。セル・ディスク02を使用するのは、セル・ディスク00および01のディスク・レイアウトがサーバーの他のセル・ディスクとは異なるためです。-

次のコマンドを使用して、グリッド・ディスクのサイズをチェックします。同じグリッド・ディスク接頭辞で開始するグリッド・ディスクでは各セルが同じサイズを返します。

# dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'DATA.*02.*\'" # dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'RECO.*02.*\'" # dcli -g cell_group -l celladmin cellcli -e \ "list griddisk attributes name, size where name like \'DBFS_DG.*02.*\'"表示されるサイズは、グリッド・ディスク作成で使用します。

-

ステップ1で表示したサイズを使用してディスク・グループのグリッド・ディスクを作成します。次の表に、ラック・タイプとディスク・グループに応じてグリッド・ディスクを作成するコマンドを示します。

表2-3 Oracle Exadata Database Machine X3-2エイス・ラックを拡張する際にディスク・グループを作成するコマンド

ラック コマンド High PerformanceまたはHigh Capacity Oracle Exadata Database Machine X3-2

dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_06_\`hostname -s\` celldisk=CD_06_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_07_\`hostname -s\` celldisk=CD_07_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_08_\`hostname -s\` celldisk=CD_08_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_09_\`hostname -s\` celldisk=CD_09_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_10_\`hostname -s\` celldisk=CD_10_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DATA_CD_11_\`hostname -s\` celldisk=CD_11_\`hostname -s\`,size=datasize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_06_\`hostname -s\` celldisk=CD_06_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_07_\`hostname -s\` celldisk=CD_07_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_08_\`hostname -s\` celldisk=CD_08_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_09_\`hostname -s\` celldisk=CD_09_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_10_\`hostname -s\` celldisk=CD_10_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ RECO_CD_11_\`hostname -s\` celldisk=CD_11_\`hostname -s\`,size=recosize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_06_\`hostname -s\` celldisk=CD_06_\`hostname -s\`,size=dbfssize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_07_\`hostname -s\` celldisk=CD_07_\`hostname -s\`,size=dbfssize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_08_\`hostname -s\` celldisk=CD_08_\`hostname -s\`,size=dbfssize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_09_\`hostname -s\` celldisk=CD_09_\`hostname -s\`,size=dbfssize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_10_\`hostname -s\` celldisk=CD_10_\`hostname -s\`,size=dbfssize" dcli -g cell_group -l celladmin "cellcli -e create griddisk \ DBFS_DG_CD_11_\`hostname -s\` celldisk=CD_11_\`hostname -s\`,size=dbfssize"

2.2.5 Oracle Exadata Database Machine X3-2エイス・ラックでのグリッド・ディスクのOracle ASMディスク・グループへの追加

この手順では、グリッド・ディスクをOracle ASMディスク・グループに追加する方法について説明します。

Oracle Exadata Database Machine X3-2エイス・ラックでのグリッド・ディスクの作成で作成されたグリッド・ディスクは、対応する既存のOracle ASMディスク・グループにOracle ASMディスクとして追加する必要があります。

-

次を検証します。

-

リバランス操作が現在実行していないこと。

-

すべてのOracle ASMディスクがアクティブになっていること。

-

-

Oracle Grid Infrastructureソフトウェアを実行している所有者として、最初のデータベース・サーバーにログインします。

-

サーバーの+ASMインスタンスにアクセスするように環境を設定します。

-

次のコマンドを使用して、ASMインスタンスに

sysasmユーザーとしてログインします。$ sqlplus / as sysasm -

次のように現在の設定を検証します。

SQL> set lines 100 SQL> column attribute format a20 SQL> column value format a20 SQL> column diskgroup format a20 SQL> SELECT att.name attribute, upper(att.value) value, dg.name diskgroup \ FROM V$ASM_ATTRIBUTE att, V$ASM_DISKGROUP DG \ WHERE DG.group_number = att.group_number AND \ att.name LIKE '%appliance.mode%' ORDER BY att.group_number;出力は次のようになります。

ATTRIBUTE VALUE DISKGROUP -------------------- -------------------- -------------------- appliance.mode TRUE DATAC1 appliance.mode TRUE DBFS_DG appliance.mode TRUE RECOC1 -

次のコマンドを使用して、

TRUEが表示されたすべてのディスク・グループのappliance.mode属性を無効化します。SQL> ALTER DISKGROUP data_diskgroup set attribute 'appliance.mode'='FALSE'; SQL> ALTER DISKGROUP reco_diskgroup set attribute 'appliance.mode'='FALSE'; SQL> ALTER DISKGROUP dbfs_dg_diskgroup set attribute 'appliance.mode'='FALSE';このコマンドで、data_diskgroup、reco_diskgroupおよびdbfs_dg_diskgroupは、それぞれDATA、RECOおよびDBFS_DGディスク・グループの名前です。

-

グリッド・ディスクをOracle ASMディスク・グループに追加します。次の表に、ラック・タイプとディスク・グループに応じてグリッド・ディスクを作成するコマンドを示します。新しいディスクを調整するとシステムのリバランスが必要になります。

表2-4 Oracle Exadata Database Machine X3-2エイス・ラックを拡張する際にディスク・グループを追加するコマンド

ラック コマンド High CapacityまたはHigh Performance Oracle Exadata Database Machine X3-2

SQL> ALTER DISKGROUP data_diskgroup ADD DISK 'o/*/DATA_CD_0[6-9]*',' \ o/*/DATA_CD_1[0-1]*' REBALANCE POWER 32; SQL> ALTER DISKGROUP reco_diskgroup ADD DISK 'o/*/RECO_CD_0[6-9]*',' \ o/*/RECO_CD_1[0-1]*' REBALANCE POWER 32; SQL> ALTER DISKGROUP dbfs_dg_diskgroup ADD DISK ' \ o/*/DBFS_DG_CD_0[6-9]*',' o/*/DBFS_DG_CD_1[0-1]*' REBALANCE POWER 32;成功すると、前述のコマンドによって

Diskgroup alteredが返されます。 -

(オプション)次のコマンドを使用して、現在のリバランス操作を監視します。

SQL> SELECT * FROM gv$asm_operation; -

次のコマンドを使用して、

appliance.mode属性を有効化します(ステップ6で無効化した場合)。SQL> ALTER DISKGROUP data_diskgroup set attribute 'appliance.mode'='TRUE'; SQL> ALTER DISKGROUP recodiskgroup set attribute 'appliance.mode'='TRUE'; SQL> ALTER DISKGROUP dbfs_dg_diskgroup set attribute 'appliance.mode'='TRUE';

2.2.6 新しいOracle Exadata Database Machine X3-2クオータ・ラックの構成の検証

グリッド・ディスクをOracle ASMディスク・グループに追加したら構成を検証します。次の手順では、構成を検証する方法について説明します。

-

最初のデータベース・サーバーに

rootユーザーとしてログインします。 -

次のコマンドを使用して、コア数をチェックします。

# dcli -g db_group -l root 'dbmcli -e list dbserver attributes coreCount'

-

次のコマンドを使用して、ストレージ・サーバーの構成を確認します。

# dcli -g cell_group -l celladmin 'cellcli -e list cell attributes eighthrack'

出力は

FALSEになる必要があります。 -

次のコマンドを使用して、各ディスク・グループのアプライアンス・モードを確認します。

SQL> set lines 100 SQL> column attribute format a20 SQL> column value format a20 SQL> column diskgroup format a20 SQL> SELECT att.name attribute, upper(att.value) value, dg.name diskgroup \ FROM V$ASM_ATTRIBUTE att, V$ASM_DISKGROUP DG \ WHERE DG.group_number =att.group_number AND \ att.name LIKE '%appliance.mode%' ORDER BY DG.group_number;

-

次のコマンドを使用して、Oracle ASMディスクの数を検証します。

SQL> SELECT g.name,d.failgroup,d.mode_status,count(*) \ FROM v$asm_diskgroup g, v$asm_disk d \ WHERE d.group_number=g.group_number \ GROUP BY g.name,d.failgroup,d.mode_status;

2.3 エラスティック構成の拡張

Oracle Engineered Systemは、Oracle Exadata Configuration Assistant (OECA)で定義されているように、最大でラックの容量までの多数のデータベース・サーバーおよびストレージ・サーバーで構成されるエラスティック構成で使用できます。

領域が使用可能な場合は、追加のデータベースおよびストレージ・サーバーを追加できます。詳細は、OECAを参照してください。アップグレード・プロセスには、新しいサーバーとケーブルの追加が含まれます。

注意:

マシンがオンラインのときに停止することなくハードウェアを拡張できます。ただし、十分に注意する必要があります。また、ハードウェアを拡張する前に既存のスイッチおよびサーバーのパッチを適用する必要があります。- ドアの取外し

この手順では、Oracle Engineered Systemのドアを取り外す方法について説明します。 - 新しいスイッチの追加

増加するリソース要件に応じて、新しいRDMAネットワーク・ファブリック・スイッチを個別に追加できます。 - 新しいサーバーの追加

エイス・ラックではないシステムの場合、容量がいっぱいでないOracle Engineered System Rackに新しいサーバーを追加できます。 - データベース・サーバーの配線

- ストレージ・サーバーの配線

新しいストレージ・サーバーを設置したら、既存の機器に接続する必要があります。 - ラックを閉じる

新しい機器を設置した後、パネルを交換してラックを閉じる必要があります。

親トピック: ハードウェアの拡張

2.3.1 ドアの取外し

この手順では、Oracle Engineered Systemのドアを取り外す方法について説明します。

注意:

Oracle Engineered System X7システムについては、次を参照してください- Oracle Engineered SystemのX7ラックにハードウェアを追加する場合は、Oracle Rack Cabinet 1242ユーザーズ・ガイドのドアの取り外し(https://docs.oracle.com/cd/E85660_01/html/E87280/gshfw.html#scrolltoc)を参照してください。

- 以前のOracle Engineered Systemラックにハードウェアを追加する場合は、Sun Rack IIユーザーズ・ガイドのドアの取り外し(https://docs.oracle.com/cd/E19657-01/html/E29153/z40004911007624.html#scrolltoc)を参照してください。

親トピック: エラスティック構成の拡張

2.3.2 新しいスイッチの追加

増加するリソース要件に応じて、新しいRDMAネットワーク・ファブリック・スイッチを個別に追加できます。

X8MとRDMA over RoCE Network Fabricの場合と、X8以前とRDMA over InfiniBand Network Fabricの場合とでは、その手順は異なります。

親トピック: エラスティック構成の拡張

2.3.2.1 Cisco Nexus 9336C Switchの追加(オプション)

この手順は、X8MとRDMA over RoCE Network Fabricの場合に使用します。

-

Oracle Engineered System X8M-2を別のX8M-2に拡張します。

-

Oracle Engineered System X8M-8を別のX8M-8に拡張します。

-

X8以前には適用できません。

注意:

この手順のステップは、Oracle Engineered Systemに固有のものです。Cicso Nexusマニュアルのステップとは異なります。

-

Cisco Nexusスイッチのコンポーネントを梱包箱から取り出します。次の項目が梱包箱にあります。

-

Cisco Nexus 9336C-FX2 Switch

-

ケーブル金具およびラック取付けキット

-

ケーブル管理金具およびカバー

-

2つのラック・レール構成部品

-

各種ねじおよび係留ナット

-

Cisco Nexus 9336C-FX2 Switchのドキュメント

スイッチの上のサービス・ラベル手順には、前の項目の説明が含まれます。

-

-

RU1のラックからトラフを取り外します。RDMAネットワーク・ファブリック・スイッチの設置中は、ケーブルを脇に置きます。トラフは破棄できます。

-

適切な穴に各ラック・レールのケージ・ナットを設置します。

-

カットアウト付きの金具をスイッチの電源側に取り付けます。

-

C金具をスイッチのポート側に取り付けます。

-

前面からラックの途中までスイッチをスライドします。右側のC金具をとおして2本の電源コードを抜く間、できるだけスイッチをラックの左側に保持します。

-

ラックU2のサーバーをロックされたサービス位置にスライドアウトします。これで、この後の組立ての際にスイッチの背面の作業が行いやすくなります。

-

スライド・レールをラックの背面からスイッチのC金具に取り付け、ラックのレールに押し込みます。

-

組み立てたケーブル・アーム金具をスライド・レールに取り付け、No. 3プラス・ドライバを使用してラック・レールにねじで留めます。

-

ケーブル・アーム金具を90度下方向に回転して、下のねじを緩めに設置します。こうすると、ねじに指が届きやすくなります。

-

ケーブル・アーム金具を正しい位置まで回転します。

-

上のねじを設置します。

-

両方のねじを締めます。

できれば長い柄(16インチ/400mm)のドライバを使用すると、ラックの外側で柄の部分を持ってケーブルごしに作業できるため、取付けが簡単に行えるようになります。

-

-

前面からスイッチをラックにすべて押し込んで、レール金具のカットアウトに電源コードを配線します。

-

スイッチを前面ラック・レールにM6 16mmのねじで固定します。No.3プラス・ドライバを使用して、ねじを締めます。

-

スイッチの後部にケーブル管理アームの下部を設置します。

-

ケーブルを適切なポートに接続します。

-

ケーブル管理アームの上部を設置します。

-

ラックU2のサーバーをラックにスライドします。

-

電源コードを前面のスイッチ電源装置スロットに取り付けます。

-

通気フィラー・パネル金具を取り付けるために、前面のねじを緩めます。ねじを締めて、スイッチの前に通気フィラー・パネルをはめ込みます。

関連項目:

-

ラック・レイアウトを確認するには、『Oracle Exadata Database Machineシステム概要』を参照してください。

-

ネットワーク・ケーブルの詳細は、Oracle Exadata Database Machineシステム概要を参照してください。

親トピック: 新しいスイッチの追加

2.3.2.2 Sun Datacenter InfiniBand Switch 36の追加(オプション)

この手順は、X8以前とRDMA over InfiniBand Network Fabricの場合に使用します。

-

これは、Oracle Engineered System X8Mには適用されません。

-

Sun Fire X4170 Oracle Database Serverを使用するラックからOracle Exadata Database Machineハーフ・ラックまたはOracle Exadata Database Machineフル・ラックへのアップグレード。

-

クオータ・ラックまたはエイス・ラックの拡張。

-

Oracle Exadata Database Machine X4-2ラックの拡張。

注意:

この手順のステップは、Oracle Exadata Database Machineに固有のものです。Sun Datacenter InfiniBand Switch 36マニュアルのステップとは異なります。-

梱包箱からSun Datacenter InfiniBand Switch 36スイッチ・コンポーネントを取り出します。次の項目が梱包箱にあります。

-

Sun Datacenter InfiniBand Switch 36スイッチ

-

ケーブル金具およびラック取付けキット

-

ケーブル管理金具およびカバー

-

2つのラック・レール構成部品

-

各種ねじおよび係留ナット

-

Sun Datacenter InfiniBand Switch 36ドキュメント

スイッチの上のサービス・ラベル手順には、前の項目の説明が含まれます。

-

-

X5ラックのみ: RU1のラックからトラフを取り外し、Sun Datacenter InfiniBand Switch 36スイッチの設置中はケーブルを脇に置いておきます。トラフは破棄できます。

-

適切な穴に各ラック・レールのケージ・ナットを設置します。

-

カットアウト付きの金具をスイッチの電源側に取り付けます。

-

C金具をスイッチのSun Datacenter InfiniBand Switch 36ポート側に取り付けます。

-

前面からラックの途中までスイッチをスライドします。右側のC金具を介した2つの電源コードを抜く間、できるだけスイッチをラックの左側に維持する必要があります。

-

ラックU2のサーバーをロックされたサービス位置にスライドアウトします。これで、この後の組立ての際にスイッチの背面の作業が行いやすくなります。

-

スライド・レールをラックの背面からスイッチのC金具に取り付け、ラックのレールに押し込みます。

-

組み立てたケーブル・アーム金具をスライド・レールに取り付け、No. 3プラス・ドライバを使用してラック・レールにねじで留めます。

-

ケーブル・アーム金具を90度下方向に回転して、下のねじを緩めに設置します。こうすると、ねじに指が届きやすくなります。

-

ケーブル・アーム金具を正しい位置まで回転します。

-

上のねじを設置します。

-

両方のねじを締めます。

できれば長い柄(16インチ/400mm)のドライバを使用すると、ラックの外側で柄の部分を持ってケーブルごしに作業できるため、取付けが簡単に行えるようになります。

-

-

前面からスイッチをラックにすべて押し込んで、レール金具のカットアウトに電源コードを配線します。

-

スイッチを前面ラック・レールにM6 16mmのねじで固定します。No.3プラス・ドライバを使用して、ねじを締めます。

-

スイッチの後部にケーブル管理アームの下部を設置します。

-

ケーブルを適切なポートに接続します。

-

ケーブル管理アームの上部を設置します。

-

ラックU2のサーバーをラックにスライドします。

-

電源コードを前面のSun Datacenter InfiniBand Switch 36スイッチ電源装置スロットに取り付けます。

-

通気フィラー・パネル金具を取り付けるために、前面のねじを緩めます。ねじを締めて、スイッチの前に通気フィラー・パネルをはめ込みます。

関連項目:

-

ラック・レイアウトを確認するには、『Oracle Exadata Database Machineシステム概要』を参照してください。

-

InfiniBandネットワーク・ケーブルの詳細は、『Oracle Exadata Database Machineシステム概要』を参照してください。

親トピック: 新しいスイッチの追加

2.3.3 新しいサーバーの追加

エイス・ラックではないシステムの場合、容量がいっぱいでないOracle Engineered System Rackに新しいサーバーを追加できます。

エラスティック構成方法を使用して、リソース要件の増加に対応するために必要に応じて個々のデータベース・サーバーまたはストレージ・サーバーを追加できます。領域が使用可能な場合は、追加のデータベースおよびストレージ・サーバーを追加できます。詳細は、Oracle Exadata Configuration Assistant (OECA)を参照してください。アップグレード・プロセスには、新しいサーバーとケーブルの追加が含まれます。ハードウェアの追加が必要な場合があります。

注意:

-

ラックの上側が重くなって倒れないように、常に下から上にラックに機器を搭載してください。機器の設置中にラックが倒れないように、転倒防止バーを伸ばしてください。

-

新しいサーバーは手動で構成する必要があります。

- 新しいサーバーの設置準備

新しいサーバーを設置する前に、サーバーを取り付けるためのラック・ユニットを準備します。 - ラック・アセンブリの設置

設置の準備が完了したら、次に、新しいサーバーを保持するラック・アセンブリを取り付けます。 - サーバーの設置

設置の準備およびラック構成部品の取り付け後、新しいサーバーを設置します。

関連トピック

親トピック: エラスティック構成の拡張

2.3.3.1 新しいサーバーの設置準備

新しいサーバーを設置する前に、サーバーを取り付けるためのラック・ユニットを準備します。

-

サーバーを設置するラック・ユニットを確認します。ラックの一番下の段から見て、空いている最初のユニットに設置します。

-

ユニットにサーバーが設置されるまではケーブル・ハーネスが取り付けられているトラフを外して破棄します。

-

詰め物を取り出して破棄します。

親トピック: 新しいサーバーの追加

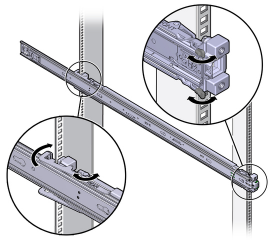

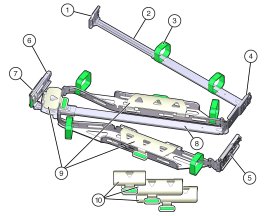

2.3.3.2 ラック・アセンブリの設置

設置の準備が完了したら、次に、新しいサーバーを保持するラック・アセンブリを取り付けます。

-

スライド・レール・ロックがサーバーの前にあり、取付け金具の5つのキー穴開口部が、シャーシ側面の5つの位置決めピンに合うように取付け金具をシャーシに対して配置します。

-

ボール・ベアリング・トラックが前方で、適切な位置で固定されるように、スライド・レール構成部品を正しい向きに置きます。

-

ラックの左側または右側のいずれかから、スライド・レール構成部品の背面をラック・レールの内側に合せ、カチッという音がしてロックされるまでアセンブリを押します。

-

スライド・レール構成部品の前面をラック・レールの前面の外側に合せ、カチッという音がしてロックされるまでアセンブリを押します。

親トピック: 新しいサーバーの追加

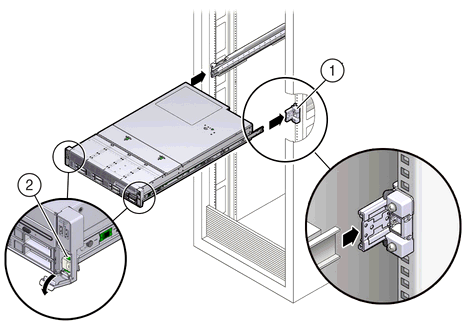

2.3.3.3 サーバーの設置

設置の準備およびラック構成部品の取り付け後、新しいサーバーを設置します。

警告:

-

サーバーは重いので、サーバーの設置には少なくとも2名の作業者またはリフトが必要です。この手順を1人で実行すると、機器が損傷したり、けがをしたりする可能性があります。

-

ラックの上側が重くなって倒れないように、常に下から上にラックに機器を搭載してください。機器の設置中にラックが倒れないように、転倒防止バーを伸ばしてください。

-

ラックにサーバーを設置する前に、サーバーの上部カバーのサービス・ラベルを参照します。

-

スライド・レール構成部品にサーバーをはめ込みます。

-

スライド・レールをスライド・レール構成部品にできるだけ奥まで押し込みます。

-

取付け金具の後端が、機器ラックに取り付けられているスライド・レール構成部品と揃うようにサーバーの位置を決めます。

図内で引出し線で示しているのは次の部分です。

1: スライド・レールに挿入される取付け金具

2: スライドレール・リリース・レバー

-

取付け金具をスライド・レールに挿入し、取付け金具がスライド・レールのストップに接触するまでサーバーをラック内に押し込みます(約30cm(12インチ))。

-

両方の取付け金具のスライド・レール開放レバーを同時に押しながら、サーバーをラック内に押し込みます。

注意:

1人がラックへのサーバーの出入れを行い、もう1人がケーブルやケーブル管理アーム(CMA)に目を配るというように、ラックへのサーバーの設置は2人で行うことをお薦めします。 -

取付け金具の前面のスライド・レール・ロックがスライド・レール構成部品にかみ合って、カチッという音がするまで押し込みます。

-

-

Exadata Storage Serverの配線の説明に従って、新しいサーバーを配線します。

親トピック: 新しいサーバーの追加

2.3.4 データベース・サーバーの配線

新しいデータベース・サーバーを設置したら、既存の機器を配線する必要があります。次の手順は、ラックの新しい機器を配線する方法を示しています。手順内のイメージは、Sun Fire X4170 M2 Oracle Database Serverを示しています。

注意:

-

ラックの既存のケーブル接続は変更されません。

-

青色のケーブルをOracle Database Serverに接続し、黒色のケーブルをExadata Storage Serverに接続します。これらのネットワーク・ケーブルは、NET0イーサネット・インタフェース・ポートに使用されます。

-

一度に1つのサーバーのCMAおよび背面パネルに管理ケーブルを接続および配線します。一度に複数のサーバーをスライドしないでください。

-

ラックの下から上に順次作業してください。上部にドングル、下部に電力ケーブルを装備したCMAを介してケーブルを配線します。

-

3本のCAT5eケーブルまたは2本のTwinAxケーブルを配線する場合は、長めのフックとループ・ストラップが必要です。

-

CAT5eケーブル、AC電源ケーブル、USBをサーバー背面のそれぞれのポートに接続します。ドングルの平らな面がCMA内部レールに接触していることを確認します。

-

ケーブル管理アーム(CMA)の緑色の金具を調整します。

CMAの図内引出し線の説明

-

コネクタA

-

前部スライド・バー

-

マジックテープ・ストラップ(6)

-

コネクタB

-

コネクタC

-

コネクタD

-

スライドレール・ラッチ金具(コネクタD用)

-

後部スライド・バー

-

ケーブル・カバー

-

ケーブル・カバー

-

-

CMAをサーバーに接続します。

-

CAT5eと電源ケーブルをワイヤ・クリップで配線します。

-

CAT5eと電源ケーブルを、曲げ半径を最小に保持しながら曲げて、CMAに通します。

-

CAT5eと電源ケーブルがケーブル留め具の下になるようにします。

-

CMAを経由してケーブルを配線し、フックとループ・ストラップの間隔が同じになるようにします。

-

RDMAネットワーク・ファブリックまたはTwinAxケーブルを、最初に曲げた状態でCMAに接続します。TwinAxケーブルはデータベース・サーバーへのクライアント・アクセス用です。

-

RDMAネットワーク・ファブリックまたはTwinAxケーブルを、等間隔のフック・アンド・ループ・ストラップで固定します。

図2-9 等間隔のフック・アンド・ループ・ストラップで固定されたRDMAネットワーク・ファブリックまたはTwinAxケーブル

「図2-9 等間隔のフック・アンド・ループ・ストラップで固定されたRDMAネットワーク・ファブリックまたはTwinAxケーブル」の説明 -

ファイバ・コア・ケーブルを配線します。

-

ケーブルをCMAの緑の留め具に通して収めます。

-

赤のILOMケーブルをデータベース・サーバーに接続します。

-

ネットワーク・ケーブルをOracle Database Serverに接続します。

-

Oracle DatabaseサーバーからRDMAネットワーク・ファブリック・スイッチにケーブルを接続します。

-

オレンジ色のイーサネット・ケーブルをKVMスイッチに接続します。

-

赤と青のイーサネット・ケーブルをCiscoスイッチに接続します。

-

次に示すように、各サーバーのスライド・レールおよびCMAの動作を確認します。

注意:

このステップは、2人の作業者で実行することをお薦めします。1人がサーバーをラックの前後に動かし、もう1人がケーブルとCMAを監視します。

-

スライド・レールがストップに達するまで、ラックからサーバーをゆっくりと引き出します。

-

バインドまたはねじれがないか、接続されたケーブルを検査します。

-

CMAがスライド・レールから一杯まで伸びることを確認します。

-

-

次に示すように、サーバーをラック内に押し込みます。

-

2対のスライド・レール・ストップを解放します。

-

両方のレバーを同時に押し、サーバーをラックに向かってスライドさせます。最初の対のストップは各スライド・レールの内側(サーバーの背面パネルのすぐ後ろ)にあるレバーです。レバーには

PUSHというラベルが付いています。サーバーは、約46cm(18インチ)スライドして停止します。 -

ケーブルおよびCMAが引っかからずに格納されることを確認します。

-

両方のスライド・レール・リリース・ボタンを同時に押すか引いて、両方のスライド・レールがかみ合うまでサーバーを完全にラック内に押し込みます。2番目の対のストップは、各取付け金具の前面近くにあるスライド・レール・リリース・ボタンです。

-

-

ケーブルをまとめてストラップで固定します。まとめるケーブルの数は8個以下にすることをお薦めします。

-

ケーブルが動きにくかったり引っかかったりしていないか確認するため、サーバーをスライドアウトしてから完全に押し込んでケーブル配線を確認します。

-

残りのサーバーにこの手順を繰り返します。

-

電力ケーブルを配電ユニット(PDU)に接続します。電力ケーブルを接続する前に、ブレーカ・スイッチがOFFになっていることを確認します。今回は施設のソケットに電力ケーブルを接続しないでください。

関連項目:

-

配線表の詳細は、『Oracle Exadata Database Machineシステム概要』を参照してください。

-

最小曲げ半径は、ケーブル管理アーム・ガイドラインの確認を参照してください。

親トピック: エラスティック構成の拡張

2.3.5 ストレージ・サーバーの配線

新しいストレージ・サーバーを設置したら、既存の機器に接続する必要があります。

次の手順は、ラックの新しい機器を配線する方法を示しています。

注意:

-

ラックの既存のケーブル接続は変更されません。

-

青色のケーブルをOracle Database Serverに接続し、黒色のケーブルをExadata Storage Serverに接続します。これらのネットワーク・ケーブルは、NET0イーサネット・インタフェース・ポートに使用されます。

-

一度に1つのサーバーのCMAおよび背面パネルに管理ケーブルを接続および配線します。一度に複数のサーバーをスライドしないでください。

-

ラックの下から上に順次作業してください。

-

3本のCAT5eケーブルまたは2本のTwinAxケーブルを配線する場合は、長めのフックとループ・ストラップが必要です。

-

CMAをサーバーに取り付けます。

-

フック・アンド・ループ・ストラップを通して、各ケーブルをそれぞれのポートに挿入し、次の順番でCMAにケーブルを配線します。

-

電源

-

イーサネット

-

RDMAネットワーク・ファブリック

-

-

CMAを通してケーブルを配線し、CMAの内側と外側の両方のカーブで、フック・アンド・ループ・ストラップを使用して固定します。

-

クロスバー・カバーを閉じて、ケーブルを真っ直ぐに固定します。

-

各サーバーのスライド・レールおよびCMAの動作を確認します。

注意:

1人がラックへのサーバーの出入れを行い、もう1人がケーブルやCMAに目を配るというように、このステップは2人で行うことをお薦めします。

-

スライド・レールがストップに達するまで、ラックからサーバーをゆっくりと引き出します。

-

バインドまたはねじれがないか、接続されたケーブルを検査します。

-

CMAがスライド・レールから一杯まで伸びることを確認します。

-

-

サーバーをラック内に戻します。

-

2対のスライド・レール・ストップを解放します。

-

各スライド・レールの内側(サーバーの背面パネルのすぐ後ろ)にあるレバーを探します。「PUSH」というラベルが付いています。

-

おおよそ46cm (18インチ)で止まるまで、両方のレバーを同時に押し、サーバーをラックに向かってスライドさせます。

-

ケーブルおよびCMAが絡まらずに格納されることを確認します。

-

各取付け金具の前面近くにあるスライド・レール開放ボタンを探します。

-

両方のスライド・レール開放ボタンを同時に押して、両方のスライド・レールがかみ合うまでサーバーを完全にラック内にスライドさせます。

-

-

ケーブルをまとめてストラップで固定します。8個以下のバンドルのRDMAネットワーク・ファブリック・ケーブルを使用することをお薦めします。

-

各サーバーを引き出し、完全に元に戻して、ケーブルが絡まったり引っかかったりしていないことを確認します。

-

すべてのサーバーにこの手順を繰り返します。

-

電力ケーブルを配電ユニット(PDU)に接続します。電力ケーブルを接続する前に、ブレーカ・スイッチがOFFになっていることを確認します。まだ、施設のソケットに電力ケーブルを接続しないでください。

親トピック: エラスティック構成の拡張

2.3.6 ラックを閉じる

新しい機器を設置した後、パネルを交換してラックを閉じる必要があります。

Oracleエンジニアド・システム・ラックで使用されているラック・モデルは2つあります。最新のステップは、該当するドキュメントを参照してください。

- Oracle Rack Cabinet 1242ユーザーズ・ガイド(

http://docs.oracle.com/cd/E85660_01/html/E87280/index.html) - 『Sun Rack IIユーザーズ・ガイド』(

https://docs.oracle.com/cd/E19657-01/html/E29153/index.html)

次のステップは、プロセスの概要を示しています。

-

次に示すように、ラックの前部ドアと後部ドアを元に戻します。

-

ドアを取り出して、ドア・ヒンジに慎重に置きます。

-

前部ドアと後部ドアの接地ストラップをフレームに接続します。

-

ドアを閉じます。

-

(オプション)ドアをロックします。キーは発送キットにあります。

-

-

(オプション)次に示すように、アップグレード用に取り外されていた場合はサイド・パネルを元に戻します。

-

各サイド・パネルを持ち上げて、ラックの側面に配置します。ラックの上部で、サイド・パネルの重量を支えます。パネル留具とラック・フレームの溝が整列していることを確認します。

-

サイド・パネルの取外し工具を使用して、各サイド・パネル留具を時計回りに1/4回転します。パネル・ロック付近の留具を時計回りに回転します。サイド・パネルごとに10個の留具があります。

-

(オプション)各サイド・パネルをロックします。キーは発送キットにあります。ロックはサイド・パネル中央の下部にあります。

-

接地ストラップをサイド・パネルに接続します。

-

ラックを閉じた後、新しいハードウェアの構成に進み、新しいハードウェアを構成します。

親トピック: エラスティック構成の拡張

2.4 「別のラックの追加によるラックの拡張」

別のラックの追加によるOracle Engineered System Rackの拡張では、ラックの配線と構成を一緒に行います。

モデルX8までのラックは、停止時間なしで配線できます。X8M以降のラックでは、ラックの配線時に停止時間が必要になることがあります。

警告:

重大な破損を避けるために、ライブ・ネットワーク内の配線を慎重に行う必要があります。- 既存のシステムへの別のラックの追加の概要

ラックを配線する前に次の注意事項を確認してください。 - 2ラック配線

エンジニアド・システム・ラックの拡張の最も簡単な例は、2つのラックの配線です。 - 複数のラックの配線

特定の順序で一連のステップに従って、複数のラックをまとめて配線できます。

親トピック: ハードウェアの拡張

2.4.1 既存のシステムへの別のラックの追加の概要

ラックを配線する前に次の注意事項を確認してください。

-

X8までのモデルでは、ラック配線中にパフォーマンスが若干低下します。このパフォーマンスの低下は、ネットワーク帯域幅が小さくなったことと、ケーブルを抜いた時のパケット損失によるデータ再送信によるものです。

-

X8-2モデルまでにラックを接続する場合、リーフ・スイッチを1つオフにする必要があるため、高可用性環境にはなりません。トラフィックはすべて残りのリーフ・スイッチ経由で送信されます。

-

ラックを追加するときは、既存のラックのみが稼働します。新しいラックのサーバーは、電源を切断する必要があります。

-

システム上で実行中のソフトウェアにRDMAネットワーク・ファブリックの再起動関連の問題はありません。複数のラックを接続する前に構成を検証するには、パフォーマンス・テストなしで

infinicheckを実行します(-eオプションを使用)。 -

各Oracle Engineered System Rackに3つのRDMAネットワーク・ファブリック・スイッチがすでに設置されていると想定されています。

-

新しいラックには配線前に拡張システムに移行される適切なIPアドレスが構成されており、重複するIPアドレスはありません。

-

RDMA over RoCE Network Fabricを使用するX8Mラックを拡張する手順は、RDMA over InfiniBand Network Fabricを使用するラック(X8以前)の場合の手順とは異なります。

- X8Mラックの場合、Oracle Engineered Systemでスパイン・スイッチごとに1つのループバックIPインタフェースが必要となります。IPアドレス指定スキームでは、IANAの共有アドレス領域100.64.0.0/10が使用されます。これにより、他のスキームを使用するネットワークのIPv4アドレスと重複することはありません。

- リーフのループバック0のIPは、100.64.0.101、100.64.0.102、100.64.0.103などとして割り当てられます。

- スパインのループバック0のIPは、100.64.0.201、100.64.0.202から100.64.0.208までとして割り当てられます。

親トピック: 別のラックの追加によるラックの拡張

2.4.2 「2ラック配線」

エンジニアド・システム・ラックの拡張の最も簡単な例は、2つのラックの配線です。

- 2ラック配線 - X8M

RDMA over RoCE Network Fabricを使用する2つのラックを配線するには、この手順を使用します。 - 2ラック配線 - X8以前

RDMA over InfiniBand Network Fabricを使用する2つのラックを配線するには、この手順を使用します。

関連トピック

親トピック: 別のラックの追加によるラックの拡張

2.4.2.1 2ラック配線 – X8M

RDMA over RoCE Network Fabricを使用する2つのラックを配線するには、この手順を使用します。

注意:

2つのX8Mラックを配線するには、両方のラックで停止時間が必要となります。2.4.2.2 2ラック配線 - X8以前

RDMA over InfiniBand Network Fabricを使用する2つのラックを配線するには、この手順を使用します。

-

次のように、スパイン・スイッチで現在アクティブなサブネット・マネージャ・マスターの優先度を

10に設定します。-

アクティブなシステム上のRDMAネットワーク・ファブリック・スイッチにログインします。

-

getmasterコマンドを使用して、スパイン・スイッチでサブネット・マネージャ・マスターが実行中であるかどうかを確認します。そうでない場合は、Oracle Exadata Database Machineインストレーションおよび構成ガイドのOracle Exadata Database Machineフル・ラックおよびOracle Exadata Database Machineハーフ・ラックのサブネット・マネージャ・マスターの設定の手順に従います。 -

スパイン・スイッチにログインします。

-

disablesmコマンドを使用して、サブネット・マネージャを停止します。 -

setsmpriority 10コマンドを使用して優先度を10に設定します。 -

enablesmコマンドを使用して、サブネット・マネージャを再起動します。 -

ステップ1.bを繰り返して、スパイン・スイッチでサブネット・マネージャ・マスターが実行中であることを確認します。

-

-

新しいラックが既存ラックの近くにあることを確認します。RDMAネットワーク・ファブリック・ケーブルは、各ラックのサーバーに到達できる必要があります。

-

新しいラック(R2)を完全に停止します。

-

2ラック配線に従って、2台のリーフ・スイッチ R2 IB2とR2 IB3を新しいラック内で配線します。新しいラックR2内の(既存ラックR1ではありません)リーフ・スイッチとスパイン・スイッチ間の2つの接続および各リーフ・スイッチ間の7つの既存のスイッチの相互接続を解除する必要があります。

-

すべてのデータベース・ノードおよびストレージ・セルで両方のRDMAネットワーク・ファブリック・インタフェースが起動していることを確認します。各ノードで

ibstatコマンドを実行し、両方のインタフェースが起動しているかどうかを確認できます。 -

リーフ・スイッチR1 IB2の電源をオフにします。すべてのデータベース・サーバーおよびExadata Storage ServerのRDMAネットワーク・ファブリック・トラフィックがR1 IB3にフェイルオーバーされます。

-

R1 IB2とR1 IB3間の7つすべてのスイッチ間リンクを解除し、R1 IB2とスパイン・スイッチR1 IB1の間の1つの接続も解除します。

-

2ラック配線に従って、リーフ・スイッチR1 IB2を配線します。

-

リーフ・スイッチR1 IB2の電源をオンにします。

-

R1 IB2が完全に操作状態になるまで3分待ちます。

スイッチをチェックするには、スイッチにログインして

ibswitchesコマンドを実行します。3つのスイッチ、R1 IB1、R1 IB2およびR1 IB3が出力表示されます。 -

すべてのデータベース・ノードおよびストレージ・セルで両方のRDMAネットワーク・ファブリック・インタフェースが起動していることを確認します。各ノードで

ibstatコマンドを実行し、両方のインタフェースが起動しているかどうかを確認できます。 -

リーフ・スイッチR1 IB3の電源をオフにします。すべてのデータベース・サーバーおよびストレージ・サーバーのRDMAネットワーク・ファブリック・トラフィックがR1 IB2にフェイルオーバーされます。

-

R1 IB3とスパイン・スイッチR1 IB1間の1つの接続を解除します。

-

2ラック配線に従って、リーフ・スイッチR1 IB3を配線します。

-

リーフ・スイッチR1 IB3の電源をオンにします。

-

R1 IB3が完全に操作状態になるまで3分待ちます。

スイッチをチェックするには、スイッチにログインして

ibswitchesコマンドを実行します。3つのスイッチ、R1 IB1、R1 IB2およびR1 IB3が出力表示されます。 -

R2のすべてのInfiniBandスイッチの電源をオンにします。

-

スイッチが完全に操作状態になるまで3分待ちます。

スイッチをチェックするには、スイッチにログインして

ibswitchesコマンドを実行します。6つのスイッチ、R1 IB1、R1 IB2、R1 IB3、R2 IB1、R2 IB2およびR2 IB3が出力表示されます。 -

任意のスイッチから

getmasterコマンドを実行し、R1 IB1でサブネット・マネージャ・マスターが実行中であることを確認します。 -

R2のすべてのサーバーの電源をオンにします。

-

スパイン・スイッチR1 IB1にログインし、次のように優先度を8に下げます。

-

disablesmコマンドを使用して、サブネット・マネージャを停止します。 -

setsmpriority 8コマンドを使用して優先度を8に設定します。 -

enablesmコマンドを使用して、サブネット・マネージャを再起動します。

-

-

スパイン・スイッチのいずれかでサブネット・マネージャ・マスターが実行中であることを確認します。

ラックを配線した後、新しいハードウェアの構成に進み、ラックを構成します。

親トピック: 2ラック配線

2.4.3 「複数のラックの配線」

特定の順序で一連のステップに従って、複数のラックをまとめて配線できます。

この手順では、相互に隣接するラックを仮定します。既存のラックはR1, R2, ... Rnで、新しいラックはRn+1です。たとえば、4つのラックがあり、5つ目を追加する場合、既存のラックはR1、R2、R3およびR4で、新しいラックはR5になります。

追加スイッチなしで最大18ラックをまとめて配線できます。

RDMA over RoCE Network Fabric (X8M)の手順は、RDMA over InfiniBand Network Fabric (X8以前)の手順とは異なります。

- 複数のラックの配線 – X8M

より大きいエンジニアド・システムを作成する場合は、複数のX8Mラックを配線できます。 - 複数のラックの配線 ー X8以前

特定の順序で一連のステップに従って、複数のラックをまとめて配線できます。

親トピック: 別のラックの追加によるラックの拡張

2.4.3.1 複数のラックの配線 – X8M

より大きいエンジニアド・システムを作成する場合は、複数のX8Mラックを配線できます。

この手順は、X8MとRDMA over RoCE Network Fabricの場合に使用します。

この手順では、既存のラックはR1、R2、…、Rnで、新しいラックはRn+1です。次のステップでは、次に示すサンプルのスイッチ名が使用されています。

rack5sw-roces0:ラック5のスパイン・スイッチ(SS)rack5sw-rocea0: ラック5の下位リーフ・スイッチ(R5LL)rack5sw-roceb0: ラック5の上位リーフ・スイッチ(R5UL)

注意:

3つ以上のラックを配線する場合、既存のラックR1、R2、…、Rnに停止時間は必要となりません。新しいラックRn+1の電源のみを切断します2.4.3.2 複数のラックの配線 - X8以前

特定の順序で一連のステップに従って、複数のラックをまとめて配線できます。

サブネット・マネージャ・マスターは最初のラック(R1 IB1)の最初のRDMA over InfiniBand Network Fabricスイッチで実行されているとみなされます。

この手順は、X8以前とRDMA over InfiniBand Network Fabricの場合に使用します。

親トピック: 複数のラックの配線