6 Oracle Linux KVMゲストの管理

Exadata Database Machine X8M-2以降、Oracle Linux KVMは、RoCEネットワーク・ファブリックを使用するシステムの仮想化テクノロジです。

- Oracle Linux KVMおよびExadata Database Machine

Exadata Database Machine X8M-2以降をデプロイするときに、データベース・サーバーにOracle Linux KVMを実装できます。 - ベア・メタルOracle RACクラスタからOracle Linux KVMのOracle RACクラスタへの移行

既存のOracle Real Application Clusters (Oracle RAC)クラスタは、KVMで管理する仮想環境に移行できます。 - 実行中のドメインの表示

実行中のドメインのリストを表示するには、vm_makerユーティリティを使用します。 - ゲストの起動

手動でゲストを起動することも、KVMホストの起動時に自動的にゲストを起動するように構成することもできます。 - 診断ISOファイルを使用したゲストの起動

診断ISOファイル(diagnostics.iso)を使用してゲストを起動するには、この手順を使用します。 - 起動時のゲスト・コンソールの監視

ゲスト起動時のOracle Linux起動メッセージを表示するには、vm_maker --start-domainコマンドに--consoleオプションを使用します。 - Oracle Linux KVMゲストの自動起動の管理

デフォルトでは、ゲストは、作成するとき、KVMホストが起動するときに自動的に起動するように構成されます。この機能は必要に応じて有効/無効を切り替えることができます。 - ユーザー・ドメイン内部のユーザー・ドメインのシャットダウン

- KVMホストからのゲストのシャットダウン

KVMホストからゲストをシャットダウンできます。 - KVMホストとゲストのバックアップ

Oracle Linux KVMデプロイメントでは、KVMホストとゲストをバックアップする必要があります。 - KVMゲストでのOracleデータベースのバックアップおよびリストア

KVMゲストのOracleデータベースのバックアップとリストアは、物理ノードのOracleデータベースのバックアップとリストアと同じです。 - ゲストへのメモリー割当ての変更

ゲストへのメモリー割当ては、vm_makerを使用して変更できます。 - ゲストへの仮想CPU割当て数の変更

ゲストに割り当てられた仮想CPUの数は、vm_maker --set --vcpuコマンドで動的に変更できます。 - ゲストのディスク領域の増加

KVMゲストのローカル領域は、ローカル・ディスク・イメージを追加することにより、初期デプロイメント後に拡張できます。 - KVMホストでの/EXAVMIMAGESの拡張

KVMホストの使用可能な領域を使用して/EXAVMIMAGESを拡張するには、この手順を使用します。 - Oracle Linux KVMクラスタの追加

Oracle Exadata Deployment Assistant (OEDA)を使用して、既存のExadata Database Machineに新しいOracle Linux KVMクラスタを作成できます。 - OEDACLIを使用したOracle Linux KVMでのOracle RACクラスタの拡張

Oracle Exadata Deployment Assistantコマンドライン・インタフェース(OEDACLI)を使用してゲストを追加することにより、Oracle Linux KVM上の既存のOracle RACクラスタを拡張できます。 - ゲストの別のデータベース・サーバーへの移動

ゲストは、別のデータベース・サーバーに移動できます。 - KVMデプロイメントのリカバリ

KVMホストはバックアップからリカバリでき、ゲストはスナップショット・バックアップからリカバリできます。 - ゲストの削除

Oracle Linux KVMでゲストを削除するには、OEDACLIまたはvm_makerユーティリティを使用します。 - Oracle Linux KVMと組み合せたクライアント・ネットワークのVLANタグ付けの使用

このトピックでは、Oracle Linux KVMと組み合せたクライアント・ネットワークのタグ付けされたVLANインタフェースの実装について説明します。 - Oracle Linux KVMと組み合せたExadata Secure RDMA Fabric Isolationの使用

このトピックでは、Oracle Linux KVMと組み合せたExadata Secure RDMA Fabric Isolationの実装について説明します。 - Oracle Linux KVMゲストへの結合ネットワーク・インタフェースの追加

この手順を使用して、既存のOracle Linux KVMゲストに結合ネットワーク・インタフェースを追加します。 - Oracle Linux KVM環境でのOracle EXAchkの使用

Oracle EXAchkバージョン12.1.0.2.2以降は、Exadata Database Machineでの仮想化をサポートしています。

6.1 Oracle Linux KVMおよびExadata Database Machine

Exadata Database Machine X8M-2以降をデプロイする場合は、データベース・サーバーにOracle Linux KVMを実装できます。

それぞれのデータベース・サーバーに、1つのKVMホストと1つ以上のゲストがインストールされます。Oracle Exadata Deployment Assistant (OEDA)で作成されたスクリプトを使用して初期デプロイメントでOracle Linux KVM環境を構成するか、既存の環境をOracle Linux KVMに移行できます。

ノート:

Oracle Linux KVMは、X8M-8などの8ソケット・サーバーではサポートされていません。- Oracle Linux KVMについて

Oracle Linux KVMを使用すると、KVMで管理されるサポート対象の仮想環境内に、Oracle Linuxオペレーティング・システムとアプリケーション・ソフトウェアをデプロイできます。 - Oracle Linux KVMデプロイメントの仕様と制限

このトピックでは、Oracle Linux KVMをOracle Exadata Database Machineで使用するためのデプロイメントの仕様と制限について説明します。 - KVMHostでサポートされる操作

手動でKVMホストを変更すると、パフォーマンスの低下やサービスの損失につながる構成の問題が発生する可能性があります。 - Oracle Linux KVMリソース

Oracle Linux KVMインフラストラクチャの2つの基本部分であるネットワークとストレージが、Oracle Linux KVMの外部で構成されます。

親トピック: Oracle Linux KVMゲストの管理

6.1.1 Oracle Linux KVMについて

Oracle Linux KVMを使用すると、KVMで管理されるサポート対象の仮想環境内に、Oracle Linuxオペレーティング・システムとアプリケーション・ソフトウェアをデプロイできます。

Oracle Linux KVMをExadata Database Machineで使用する場合、Oracle Linux KVMは、ワークロードにCPU、メモリー、オペレーティング・システムおよびシステム管理の分離を提供します。仮想マシン(VM)とネットワークおよびI/Oの優先度付けを組み合せることで、完全なスタック分離を実現できます。統合の場合、Oracle Linux KVMを使用して信頼できる複数のデータベースまたはプラガブル・データベースを作成でき、リソースをより動的に共有できます。

Oracle Exadata System Softwareリリース19.3.0以降のKVMは、RDMA over Converged Ethernet (RoCE)インターコネクトによって構成されたExadata Database Machineシステムで使用する仮想化テクノロジです。Oracle Linux KVM環境は、管理サーバー(KVMホスト)、仮想マシンおよびリソースで構成されます。KVMホストは、軽量でセキュアなサーバー・プラットフォームを提供する管理対象仮想環境です。このプラットフォームでゲストとも呼ばれるVMを実行します。

KVMホストは、ベア・メタル・コンピュータにインストールします。各KVMホストのハイパーバイザは、フットプリントが非常に小さいVMマネージャおよびスケジューラです。システムで唯一完全な権限を持つエンティティとなるように設計されています。CPUとメモリーの使用量、権限の確認、ハードウェア割込みなど、システムの最も基本的なリソースのみを制御します。

ハイパーバイザは、1台のホスト・コンピュータで複数のVMを安全に実行します。各VMは専用のゲストで実行され、専用のオペレーティング・システムを持ちます。KVMホストもハイパーバイザの上位のゲストとして実行されます。KVMホストには、ハードウェアおよびデバイス・ドライバへの特権アクセス権があります。この環境からすべてのゲストを管理します。

ゲストは、RoCEインタフェースにアクセスできる非特権VMです。ゲストは、KVMホストで起動および管理されます。ゲストはその他のVMとは独立して動作するため、ゲストの仮想リソースに適用した構成の変更は、その他のゲストには影響しません。ゲストの障害は、その他のゲストには影響しません。

「ゲスト」、「ドメイン」および「仮想マシン」は、ほとんど同じ意味で使用されます。

通常、KVMホストごとに最大12個のゲストがサポートされます。ただし、384GBのRAMを含み、Exadata Secure RDMA Fabric Isolationをサポートするように構成されたサーバーでは、ゲストの上限は8つです。

各ゲストは、KVMホストとともに起動されます。ゲストがKVMホストと直接相互作用することはありません。これらの要件は、ハイパーバイザ自体によって処理されます。KVMホストは、ハイパーバイザを管理する手段のみを提供します。

Exadata Database MachineでOracle Linux KVMを作成および構成するには、Oracle Exadata Deployment Assistant (OEDA)を使用します。

6.1.2 Oracle Linux KVMデプロイメントの仕様と制限

このトピックでは、Oracle Linux KVMをOracle Exadata Database Machineで使用するためのデプロイメントの仕様と制限について説明します。

表6-1 Oracle Linux KVMデプロイメントの仕様と制限

| 属性 | X8M-2の値 | X8M-2エイス・ラックの値 | X9M-2の値 | X9M-2エイス・ラックの値 |

|---|---|---|---|---|

|

各データベース・サーバーのOracle Linux KVMゲストの最大数 |

384GBのRAMを含み、Exadata Secure RDMA Fabric Isolationをサポートするように構成されたサーバー: 8 それ以外の場合: 12 |

384GBのRAMを含み、Exadata Secure RDMA Fabric Isolationをサポートするように構成されたサーバー: 8 それ以外の場合: 12 |

12 |

12 |

|

各データベース・サーバーの合計物理メモリー |

デフォルト: 384GB 最大値: 1536GB |

デフォルト: 384GB 最大値: 768GB |

デフォルト: 512 GB 最大値: 2048 GB |

デフォルト: 384GB 最大値: 1024 GB |

|

すべてのOracle Linux KVMゲストの各データベース・サーバー上の使用可能メモリーの合計 |

デフォルト: 328GB 最大値: 1390GB |

デフォルト: 328GB 最大値: 680GB |

デフォルト: 440 GB 最大値: 1870 GB |

デフォルト: 328GB 最大値: 920 GB |

|

各Oracle Linux KVMゲストの最小メモリー制限 |

16GB |

16GB |

16GB |

16GB |

|

各データベース・サーバーの合計CPUコア(仮想CPU) |

48 (96) |

24 (48) |

64 (128) |

32 (64) |

|

すべてのOracle Linux KVMゲストの各データベース・サーバー上のCPUコア(仮想CPU)のオーバープロビジョニング制限 ノート: CPUのオーバープロビジョニングによってパフォーマンスの競合が発生する可能性があります。 |

92 (184) |

46 (92) |

124 (248) |

62 (124) |

|

各Oracle Linux KVMゲストのCPUコア(仮想CPU)制限 |

最小値: 2 (4) 最大値: 46 (92) |

最小値: 2 (4) 最大値: 23 (46) |

最小値: 2 (4) 最大値: 62 (124) |

最小値: 2 (4) 最大値: 31 (62) |

|

各データベース・サーバーのOracle Linux KVMゲストの合計使用可能ディスク領域 |

デフォルト: 3.15TB |

デフォルト: 3.15TB |

デフォルト: 3.15TB |

デフォルト: 3.15TB |

表6-2 Oracle Linux KVMの使用可能メモリーの制限

| データベース・サーバーの物理メモリーの合計 | Oracle Linux KVMゲストの使用可能メモリーの合計 |

|---|---|

|

384 GB |

328 GB |

|

512 GB |

440 GB |

|

768 GB |

680 GB |

|

1024 GB |

920 GB |

|

1536 GB |

1390 GB |

|

2048 GB |

1870 GB |

ノート:

1つのCPUコア= 1つのOCPU = 2つの仮想CPU = 2つのハイパー・スレッド

6.1.3 KVMHostでサポートされる操作

手動でKVMホストを変更すると、パフォーマンスの低下やサービスの損失につながる構成の問題が発生する可能性があります。

注意:

Oracleでは、ドキュメント化されている内容以外のKVMホストへの変更はサポートされていません。KVMホストとゲストにサードパーティ製アプリケーションをインストールできますが、Oracleソフトウェアにかかわる問題がある場合、Oracleサポート・サービスは、その原因のトラブルシューティング中にサードパーティ製アプリケーションの削除を依頼することがあります。KVMホストでの操作がサポートされているかどうか不明な場合は、Oracleサポート・サービスにお問い合せください。

6.1.4 Oracle Linux KVMリソース

Oracle Linux KVMインフラストラクチャの2つの基本部分であるネットワークとストレージが、Oracle Linux KVMの外部で構成されます。

ネットワーク

Oracle Exadata Deployment Assistant (OEDA)を使用してOracle Exadataラックの構成詳細を指定する場合は、Oracle Linux KVM環境に必要なネットワークIPアドレスの作成方法を入力します。生成されたOEDA設定ファイルはOracle Exadataラックに転送され、ネットワーク・アドレスの作成に使用されます。

ストレージ

Oracle Linux KVMには、仮想マシン(VM)の作成および管理に不可欠な環境リソースを格納する場所が常に必要です。こういったリソースには、ISOファイル(仮想DVDイメージ)、VM構成ファイル、およびVM仮想ディスクがあります。このようなリソースのグループが格納される場所を記憶域リポジトリといいます。

Exadata Database Machineでは、Oracle Linux KVM用のストレージにXFSファイル・システムを使用します。

2ソケットのOracle Exadata Database Machineシステムでのみ、ディスク拡張キットを購入してストレージ容量を増やすことができます。追加のディスク領域を使用することで、/EXAVMIMAGESを拡張して、サポートするOracle Linux KVMゲストの数を増やしたり(最大12個まで)、各ゲストの/u01パーティションのサイズを増やすことができます。

6.2 ベア・メタルOracle RACクラスタからOracle Linux KVMのOracle RACクラスタへの移行

既存のOracle Real Application Clusters (Oracle RAC)クラスタは、KVMで管理する仮想環境に移行できます。

ノート:

このトピックは、2ソケットのx86サーバーにのみ適用されます。Exadata Database Machine X8M-8などの8ソケット・サーバーには適用されません。ベア・メタルOracle RACクラスタからOracle Linux KVMのOracle RACクラスタへの移行は次の方法で実行できます。

-

既存のベア・メタルOracle RACクラスタを使用してOracle Linux KVMのOracle RACクラスタに移行します(停止時間は発生しません)。

-

Oracle Linux KVMに新しいOracle RACクラスタを作成してOracle Linux KVMのOracle RACクラスタに移行します(最小限の停止時間が発生します)。

-

Oracle Data Guardを使用してOracle Linux KVMのOracle RACクラスタに移行します(最小限の停止時間が発生します)。

-

Oracle Recovery Manager (RMAN)バックアップおよびリストアを使用してOracle Linux KVMのOracle RACクラスタに移行します(完全な停止時間が発生します)。

ベア・メタルOracle RACクラスタからOracle Linux KVMのOracle RACクラスタに変換することは、次のことを示唆します。

-

各データベース・サーバーは、KVMホストがゲストとともに作成されているOracle Linux KVMサーバーに変換されます。ゲストの数は、デプロイされるOracle RACクラスタの数によって異なります。データベース・サーバー上の各ゲストは、特定のOracle RACクラスタに属します。

-

変換手順の一環として、最初にベア・メタルOracle RACクラスタがOracle Linux KVM内の1つのOracle RACクラスタに変換されます。データベース・サーバーごとに、1つのゲストが存在するようになります。

-

変換が終わった後のストレージ・セルのセル・ディスクとグリッド・ディスクの構成は、変換の開始時の構成と同じになります。

-

KVMホストは、各データベース・サーバーの少量のシステム・リソースを使用します。通常、KVMホストは、24 GBとサーバーRAMの6%、および4つの仮想CPUを使用します。Oracle Linux KVMと組み合せて実行するデータベースのSGAのサイズを設定する際には、これらのリソース要件を考慮に入れてください。

- 詳細な手順は、My Oracle Supportノート2099488.1を参照してください。

6.5 診断ISOファイルを使用したゲストの起動

診断ISOファイル(diagnostics.iso)を使用してゲストを起動するには、この手順を使用します。

親トピック: Oracle Linux KVMゲストの管理

6.6 起動時のゲスト・コンソールの監視

ゲスト起動時のOracle Linux起動メッセージを表示するには、vm_maker --start-domainコマンドに--consoleオプションを使用します。

親トピック: Oracle Linux KVMゲストの管理

6.7 Oracle Linux KVMゲストの自動起動の管理

デフォルトでは、ゲストは、作成するとき、KVMホストが起動するときに自動的に起動するように構成されます。この機能は必要に応じて有効/無効を切り替えることができます。

- ゲストの自動起動の有効化

ゲストは、KVMホストの起動時に自動的に起動するように構成できます。 - ゲストの自動起動の無効化

KVMホスト起動時のゲストの自動起動は無効化できます。

親トピック: Oracle Linux KVMゲストの管理

6.10 KVMホストとゲストのバックアップ

Oracle Linux KVMデプロイメントでは、KVMホストとゲストをバックアップする必要があります。

バックアップは、データベース・サーバーの物理データまたは論理データの問題が発生し、データベース・サーバーのオペレーティング・システム・ファイルをリストアすることが必要となった場合に、リストアおよびリカバリするために必要です。

- スナップショット・ベースのバックアップを使用したKVMホストのバックアップ

この手順は、KVMホストのスナップショット・ベースのバックアップを作成する方法を示しています。 - Oracle Linux KVMゲストのバックアップ

次の手順を使用して、Oracle Linux KVMゲストをバックアップできます。

親トピック: Oracle Linux KVMゲストの管理

6.10.1 スナップショット・ベースのバックアップを使用したKVMホストのバックアップ

この手順は、KVMホストのスナップショット・ベースのバックアップを作成する方法を示しています。

次のステップに示す値は例です。実際の状況に応じて、別の値に置き換えることが必要になる場合があります。

rootユーザーとして、すべてのステップを実行する必要があります。

親トピック: KVMホストとゲストのバックアップ

6.10.2 Oracle Linux KVMのゲストのバックアップ

次の手順を使用して、Oracle Linux KVMゲストをバックアップできます。

ゲストをバックアップする方法は3つあります。

表6-3 Oracle Linux KVMゲストのバックアップ方法

| 方式 | 説明 | 管理者 | 最適な状況 |

|---|---|---|---|

| 方法1: すべてのKVMゲストのバックアップ |

KVMホストから、XFS reflinkを使用して一貫性バックアップを取得し、 |

KVMホスト管理者 |

計算ノードの障害が発生した後、ゲストがブート可能でないときに、すべてのゲストをリカバリする場合。 |

| 方法2: 個々のゲストのバックアップ |

KVMホストから、XFS reflinkを使用して一貫性バックアップを取得し、 |

KVMホスト管理者 |

計算ノードの障害が発生した後、ゲストがブート可能でなくなったが、他のすべてのゲストに影響するわけではないときに、ゲストを選択的にリカバリする場合。 |

| 方法3: ゲストの内部的なバックアップ |

ゲスト内部で実行されるスナップショット・ベースのバックアップ手順を使用して、ゲストをバックアップします。 |

ゲスト管理者 |

障害が発生した後、ゲストがまだブート可能で、 |

- 方法1: すべてのKVMゲストのバックアップ

/EXAVMIMAGESの下にある記憶域リポジトリをバックアップすることで、すべてのゲストをバックアップできます。 - 方法2: 個々のゲストのバックアップ

/EXAVMIMAGESの下にある特定のフォルダをバックアップすることで、個々のゲストをバックアップできます。 - 方法3: ゲストの内部的なバックアップ

ゲスト内部からゲストのスナップショット・ベースのバックアップを取得できます。

親トピック: KVMホストとゲストのバックアップ

6.10.2.1 方法1: すべてのKVMゲストのバックアップ

/EXAVMIMAGESの下にある記憶域リポジトリをバックアップすることで、すべてのゲストをバックアップできます。

バックアップ先は、書込み可能なNFSの場所など、KVMホスト・サーバーとは別の場所で、バックアップを保持できる十分な大きさにする必要があります。バックアップに必要な領域は、システムにデプロイされるゲストの数に比例します。各ゲストのバックアップに必要な領域は、約200GBです。

親トピック: Oracle Linux KVMゲストのバックアップ

6.10.2.2 方法2: 個々のゲストのバックアップ

/EXAVMIMAGESの下にある特定のフォルダをバックアップすることで、個々のゲストをバックアップできます。

バックアップ先は、書込み可能なNFSの場所など、KVMホスト・サーバーとは別の場所で、バックアップを保持できる十分な大きさにする必要があります。個々のゲストのバックアップに必要な領域は、約200GBです。

親トピック: Oracle Linux KVMゲストのバックアップ

6.10.2.3 方法3: ゲストの内部的なバックアップ

ゲスト内部からゲストのスナップショット・ベースのバックアップを取得できます。

すべてのステップは、ゲスト内から実行されます。

ノート:

このバックアップ方法は、ゲストの内部で実行され、論理ボリュームのスナップショットを使用します。他のバックアップ方法と比較すると、この方法で提供されるリカバリ・オプションは制限されています。これは、このバックアップは、ゲストがブート可能であり、かつrootユーザー・ログインが可能な場合にのみ有用であるためです。

この手順では、ゲスト内の現在アクティブなすべてのファイル・システムの内容をバックアップします。開始する前に、バックアップするすべてのファイル・システムがマウントされていることを確認します。

次のステップに示す値は例です。実際の状況に応じて、別の値に置き換えることが必要になる場合があります。

rootユーザーとして、すべてのステップを実行する必要があります。

親トピック: Oracle Linux KVMゲストのバックアップ

6.11 KVMゲストでのOracleデータベースのバックアップおよびリストア

KVMゲストのOracleデータベースのバックアップとリストアは、物理ノードのOracleデータベースのバックアップとリストアと同じです。

親トピック: Oracle Linux KVMゲストの管理

6.12 ゲストへのメモリー割当ての変更

ゲストへのメモリー割当ては、vm_makerを使用して変更できます。

この操作には、ゲストの再起動が必要です。メモリー構成の変更後に、vm_makerでゲストを再起動することもできます。

6.13 ゲストへの仮想CPU割当て数の変更

ゲストに割り当てられた仮想CPUの数は、vm_maker --set --vcpuコマンドで動的に変更できます。

ゲストに割り当てられた仮想CPUの数を変更するアクションのすべては、KVMホストで実行します。

仮想CPUをオーバーコミットすると、すべてのゲストに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。ただし、CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

親トピック: Oracle Linux KVMゲストの管理

6.14 ゲストのディスク領域の増加

KVMゲストのローカル領域は、ローカル・ディスク・イメージを追加することにより、初期デプロイメント後に拡張できます。

- 新規LVMディスクのゲストへの追加

新しいLVMディスクをOracle Linux KVMゲストに追加すると、ゲストで使用可能なディスク領域の量を増やすことができます。 - rootファイル・システムのサイズの増加

この手順では、システム・パーティションと/(root)ファイル・システムのサイズを増やす方法について説明します。 - /u01ファイル・システムのサイズの増加

この手順では、Oracle Linux KVMの/u01ファイル・システムのサイズを増やす方法について説明します。 - Grid InfrastructureホームまたはDatabaseホーム・ファイル・システムのサイズの増加

Oracle Linux KVMゲストのOracle Grid InfrastructureまたはOracle Databaseホームのファイル・システムのサイズを増やすことができます。 - スワップ領域のサイズの増加

ゲストで構成されたスワップの量は増やすことができます。

親トピック: Oracle Linux KVMゲストの管理

6.14.1 新規LVMディスクのゲストへの追加

新しいLVMディスクをOracle Linux KVMゲストに追加すると、ゲストで使用可能なディスク領域の量を増やすことができます。

ファイル・システムまたはスワップ領域のサイズを拡大するために、ゲストにLVMディスクを追加できます。この手順の実行中も、システムはオンラインのままです。

ノート:

この手順では、KVMホストとゲストの両方でアクションを実行します。すべてのステップを、rootユーザーとして実行してください。

この手順によりボリューム・グループに追加される追加の領域を使用して、様々なファイル・システムのサイズを増やすには、次のトピックを参照してください。

親トピック: ゲストのディスク領域の増加

6.14.2 rootファイル・システムのサイズの増加

この手順では、システム・パーティションおよび/ (ルート)ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

ノート:

2種類のシステム・パーティション、LVDbSys1およびLVDbSys2が使用できます。片方のパーティションがアクティブでマウントされます。もう一方のパーティションは非アクティブで、アップグレード中、バックアップする場所として使用します。この2つのシステム・パーティションは、サイズが等しい必要があります。

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

親トピック: ゲストのディスク領域の増加

6.14.3 /u01ファイル・システムのサイズの増加

この手順では、Oracle Linux KVMの/u01ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

ノート:

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です

関連トピック

親トピック: ゲストのディスク領域の増加

6.14.4 Oracle Grid InfrastructureホームまたはDatabaseホーム・ファイル・システムのサイズの増加

Oracle Linux KVMゲストのOracle Grid InfrastructureまたはOracle Databaseホームのファイル・システムのサイズを増やすことができます。

Oracle Grid Infrastructureソフトウェア・ホームおよびOracle Databaseソフトウェア・ホームのために、それぞれのディスク・イメージ・ファイルがKVMホストに作成されます。ディスク・イメージ・ファイルの場所は、/EXAVMIMAGES/GuestImages/DomainName/ディレクトリです。ディスク・イメージ・ファイルは、仮想マシンの起動時に自動的にゲストにアタッチされ、LVMではない別個のファイル・システムとしてゲストにマウントされます。

このタスクでは、追加のディスク領域を使用できることを想定しています。

親トピック: ゲストのディスク領域の増加

6.15 KVMホストでの/EXAVMIMAGESの拡張

KVMホストの使用可能な領域を使用して/EXAVMIMAGESを拡張するには、この手順を使用します。

Exadataデータベース・サーバーでは、ローカル・ディスク記憶域はボリューム・マネージャによって管理され、使用可能なすべての記憶領域が単一のボリューム・グループに割り当てられます。また、ボリューム・グループには、様々なファイル・システムをサポートする多数の論理ボリュームが含まれています。KVMホストでは、ほとんどの領域がゲスト記憶域に使用される/EXAVMIMAGESに割り当てられます。

通常、必要に応じてファイル・システムを容易に拡張できるように、ボリューム・グループには適度な空き領域が確保されます。ディスク拡張キットをデータベース・サーバーに追加することで、追加の領域も使用できます。キットは4台のハード・ドライブで構成されます。これらのドライブはデータベース・サーバーの未使用のスロットに取り付けられます。

ノート:

ディスク拡張キットは、2ソケットのOracle Exadata Database Machineシステムでのみサポートされています。ディスク拡張キットをインストールした場合は、この手順を続行する前に、「データベース・サーバーX8M-2以前へのディスク拡張キットの追加」で説明されている手順を完了していることを確認してください。

親トピック: Oracle Linux KVMゲストの管理

6.16 Oracle Linux KVMクラスタの追加

Oracle Exadata Deployment Assistant (OEDA)を使用して、既存のExadata Database Machineに新しいOracle Linux KVMクラスタを作成できます。

親トピック: Oracle Linux KVMゲストの管理

6.17 OEDACLIを使用したOracle Linux KVMでのOracle RACクラスタの拡張

Oracle Linux KVM上の既存のOracle RACクラスタは、Oracle Exadata Deployment Assistantコマンドライン・インタフェース(OEDACLI)を使用してゲストを追加することにより拡張できます。

OEDACLIは、目的のクラスタに適した既知のバージョンのOEDA XMLファイルがある場合に適した方法です。

ノート:

この手順の実行中、既存のOracle RACクラスタ・ノードとそのデータベース・インスタンスでは、停止時間は発生しません。この手順のユースケースは次のとおりです。

- Oracle Exadataラックのデータベース・サーバーのサブセットのみを使用する既存のOracle RACクラスタがあり、現在クラスタによって使用されていないノードが使用候補になった場合。

- データベース・サーバーを追加することで最近拡張したExadata Database Machineに既存のOracle RACクラスタがある場合。

- 完全なノード障害が発生たノードを削除して新しくイメージ化したノードに置き換えた、既存のOracle RACクラスタがある場合。

この項のステップを実行する前に、「クラスタへの新しいデータベース・サーバーの追加」の説明に従って新しいデータベース・サーバーを設定しておく必要があります。これには、次の項目も含まれます。

- KVMホストが含まれるネットワークに、新しいデータベース・サーバーをインストールして構成します。

- 最新のOracle Exadata Deployment Assistant (OEDA)をダウンロードします(ダウンロードするファイルのバージョンが2019年7月以降のリリースであることを確認します)。

- 既存のクラスタ構成を正確に反映したOEDA構成XMLファイルを用意します。このXMLファイルを検証するには、そのファイルからインストール・テンプレートを生成して現在の構成と比較します。OEDACLIコマンドSAVE FILESを参照してください。

- 現在のシステム構成についてのOEDAインストール・テンプレートのレポートを確認して、既存のノードのノード名とIPアドレスを取得します。新しく追加するノードのために新しいホスト名とIPアドレスが必要になります。次の新しいホスト名とIPアドレスが必要になります。

- KVMホストおよびゲストの管理ホスト名とIPアドレス(ADMINNETと呼ばれます)。

- KVMホストおよびゲストのプライベート・ホスト名とIPアドレス(PRIVNETと呼ばれます)。

- KVMホストのIntegrated Lights Out Manager (ILOM)ホスト名とIPアドレス。

- ゲストのクライアント・ホスト名とIPアドレス(CLIENTNETと呼ばれます)。

- ゲストの仮想IP (VIP)ホスト名とIPアドレス(VIPNETと呼ばれます)。

- 新しいノードの物理ラック番号とラック内のでの場所(

U番号単位)

-

各KVMホストは、既存のデータベース・サーバーで使用されているイメージと同じになるようにイメージ化またはパッチ適用されています。現在のシステム・イメージは、新しいKVMホスト・ノードの

/EXAVMIMAGES/ System.first.boot.*.imgファイルのバージョンと一致している必要があります。ノート:

この後で参照される~/dom0_groupファイルは、既存のノードと新しく追加するノードのすべてのKVMホストのホスト名が含まれているテキスト・ファイルです。すべてのKVMホストのイメージ・バージョンが同じであることを確認します。

dcli -g ~/dom0_group -l root "imageinfo -ver" exa01adm01: 19.2.0.0.0.190225 exa01adm02: 19.2.0.0.0.190225 exa01adm03: 19.2.0.0.0.190225イメージのバージョンに異なるものがある場合は、そのバージョンが一致するようにノードをアップグレードする必要があります。

すべてのKVMホストの

System.first.bootのバージョンが、前のステップで取得したイメージのバージョンと一致していることを確認します。dcli -g ~/dom0_group -l root "ls -1 /EXAVMIMAGES/System.first.boot*.img" exa01adm01: /EXAVMIMAGES/System.first.boot.19.2.0.0.0.190225.img exa01adm02: /EXAVMIMAGES/System.first.boot.19.2.0.0.0.190225.img exa01adm03: /EXAVMIMAGES/System.first.boot.19.2.0.0.0.190225.imgいずれかのノードに、現在のイメージと一致する

System.first.boot.imgファイルがない場合は、必要なファイルを取得します。My Oracle SupportのドキュメントID 888828.1で、対象のExadataリリース用の補足READMEノートを確認し、"DomU System.img OS image for V.V.0.0.0 VM creation on upgraded dom0s"という説明文に対応するパッチ・ファイルを見つけてください。 -

klone.zipファイル(gi-klone*.zipとdb-klone*.zip)を、クラスタに追加する新しくイメージ化されたKVMホスト・ノードの/EXAVMIMAGESの場所に配置します。これらのファイルは、最初にシステムをデプロイしたKVMホスト・ノードの/EXAVMIMAGESディレクトリにあります。

このステップでは、exa01adm03vm01という新しいゲストを含むexa01adm03という新しいKVMホスト・ノードを追加する方法を示します。このステップでは、OEDACLIコマンドを使用して、既存のOracle RACクラスタをゲストに拡張する方法を示します。既存のクラスタには、exa01adm01およびexa01adm02という名前のKVMホスト・ノードと、exa01adm01vm01およびexa01adm02vm01という名前のゲスト・ノードがあります。

6.18 ゲストの別のデータベース・サーバーへの移動

ゲストは、別のデータベース・サーバーに移動できます。

ターゲットのExadata Database Machineデータベース・サーバーは、次の要件を満たしている必要があります。

-

ターゲット・データベース・サーバーに、同一リリースのOracle Exadata System SoftwareおよびOracle Linux KVMがインストールされていることが必要です。

-

ターゲット・データベース・サーバーに、同一のネットワークが表示されている。

-

ターゲットのデータベース・サーバーは、同一のExadata Database Machineストレージ・サーバーにアクセスできることが必要です。

-

ターゲットのデータベース・サーバーには、ゲストの動作のために十分な空きリソース(メモリー、CPUおよびローカル・ディスク領域)があることが必要です。

-

仮想CPUをオーバーコミットすると、すべてのドメインに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

-

メモリーをオーバーコミットすることはできません。

-

ディスク・イメージをターゲット・データベース・サーバーにコピーすると、ディスク・イメージ・ファイルの領域の割当てが増加する場合があります。これは、コピーされたファイルは、reflinkを利用してディスク領域を省略できないためです。

-

-

ゲストの名前は、ターゲットのデータベース・サーバーで未使用のものにする必要があります。

次の手順に従い、ゲストを同一のOracle Exadata System Software構成内の新しいデータベース・サーバーに移動します。

親トピック: Oracle Linux KVMゲストの管理

6.19 KVMデプロイメントのリカバリ

KVMホストはバックアップからリカバリでき、ゲストはスナップショット・バックアップからリカバリできます。

重大な障害が発生してOracle KVMホストが損傷した場合や、サーバー・ハードウェアを新しいハードウェアに交換した場合は、スナップショット・ベースのバックアップからKVMホストをリカバリできます。

たとえば、すべてのハード・ディスクを交換すると、システムの元のソフトウェアはトレースできません。これは、ソフトウェアの完全なシステムの交換と似ています。

この項で説明するリカバリ手順には、Exadataストレージ・サーバーやOracle Databaseのデータのバックアップまたはリカバリは含まれていません。バックアップとリカバリ手順は定期的にテストすることをお薦めします。

- KVMホストのスナップショット・ベースのリカバリの概要

KVMホストのリカバリは、一連のタスクで構成されています。 - KVMシステムのリカバリ・シナリオ

KVMシステム・デプロイメントをリカバリする方法。

親トピック: Oracle Linux KVMゲストの管理

6.19.1 KVMホストのスナップショット・ベースのリカバリの概要

KVMホストのリカバリは、一連のタスクで構成されています。

リカバリ手順では、仮想CD-ROMとしてdiagnostics.isoイメージを使用し、Integrated Lights Out Manager (ILOM)を使用してレスキュー・モードでKVMホストを再起動します。大まかなステップは次のとおりです。

- 次のものを再作成します。

- ブート・パーティション

- 物理ボリューム

- ボリューム・グループ

- 論理ボリューム

- ファイル・システム

- スワップ・パーティション

- スワップ・パーティションをアクティブ化します

/bootパーティションがアクティブなブート・パーティションであることを確認します- データをリストアします

- GRUBを再構成します

- サーバーを再起動します

親トピック: KVMデプロイメントのリカバリ

6.19.2 KVMシステムのリカバリ・シナリオ

KVMシステム・デプロイメントをリカバリする方法。

次の例は、KVMシステムのリカバリに適用されます。

- KVMホストとゲストのバックアップからのリカバリ

この手順では、KVMホストのバックアップとKVMホストのゲストのバックアップから、KVMホストとそのすべてのゲストをリカバリします。 - KVMホストの再イメージ化とゲストのバックアップからのリストア

この手順では、管理ドメインを再イメージ化し、KVMゲストのバックアップからすべてのユーザー・ドメインを再構築します。 - 1つのKVMゲストのリカバリと再起動

KVMホストから、特定のゲストをリカバリできます。 - スナップショット・バックアップからのゲストのリストアおよびリカバリ

この手順は、ゲスト内から取得したゲストのスナップショット・ベースのバックアップを使用して、消失または損傷したKVMゲストのファイルをリストアするために使用できます。

親トピック: KVMデプロイメントのリカバリ

6.19.2.1 KVMホストとゲストのバックアップからのリカバリ

この手順では、KVMホストのバックアップとKVMホストのゲストのバックアップから、KVMホストとそのすべてのゲストをリカバリします。

重大な障害が発生して管理ドメインが損傷した場合や、サーバー・ハードウェアを新しいハードウェアに交換した場合は、次のステップを使用して、スナップショット・ベースのバックアップからKVMホストをリカバリできます。

NFSサーバーを準備して、スナップショット・ベースのバックアップを使用したKVMホストのバックアップで作成したバックアップ・アーカイブをホストします

IPアドレスを使用して、NFSサーバーにアクセスできる必要があります。たとえば、ディレクトリ/Backupにバックアップ・アーカイブが含まれる、IPアドレスnfs_ipを持つNFSサーバーなどです。

- Exadata X9M-2上のKVMホストのリカバリ

この手順では、Exadata Database Machine X9M-2データベース・サーバーのKVMホストをリカバリする方法について説明します。 - Exadata X8M-2でのKVMホストのリカバリ

この手順では、Exadata Database Machine X8M-2データベース・サーバーのKVMホストをリカバリする方法について説明します。 - KVMホストの再起動

KVMホストを起動し、管理者操作を続行します。 - KVMゲストのリカバリと再起動

KVMホストから、すべてのKVMゲストをリカバリします。

親トピック: KVMシステムのリカバリ・シナリオ

6.19.2.1.1 Exadata X9M-2でのKVMホストのリカバリ

この手順では、Exadata Database Machine X9M-2データベース・サーバーのKVMホストをリカバリする方法について説明します。

親トピック: KVMホストとゲストのバックアップからのリカバリ

6.19.2.1.2 Exadata X8M-2でのKVMホストのリカバリ

この手順では、Exadata Database Machine X8M-2データベース・サーバーのKVMホストをリカバリする方法について説明します。

親トピック: KVMホストとゲストのバックアップからのリカバリ

6.19.2.1.3 KVMホストの再起動

KVMホストを起動し、管理者操作を続行します。

ExadataLinux_1が最初のデバイスになっています。

親トピック: KVMホストとゲストのバックアップからのリカバリ

6.19.2.1.4 KVMゲストのリカバリと再起動

KVMホストからすべてのKVMゲストをリカバリします。

この手順は、方法1: すべてのKVMゲストのバックアップで説明されている推奨バックアップ手順を補完するものです。これは、リカバリ後にKVMホストが動作可能であることと、すべてのゲストがリカバリされることが前提となっています。

親トピック: KVMホストとゲストのバックアップからのリカバリ

6.19.2.2 KVMホストの再イメージ化とゲストのバックアップからのリストア

この手順では、管理ドメインを再イメージ化し、KVMゲストのバックアップからすべてのユーザー・ドメインを再構築します。

次の手順は、修復不可能な損傷がKVMホストで発生したときに、KVMホストのバックアップは存在しないが、すべてのゲストを含む記憶域リポジトリ(/EXAVMIMAGESファイル・システム)のバックアップが利用可能な場合に使用できます。

親トピック: KVMシステムのリカバリ・シナリオ

6.19.2.3 1つのKVMゲストのリカバリと再起動

KVMホストから、特定のゲストをリカバリできます。

この手順は、方法2: 個々のゲストのバックアップで説明されているバックアップ手順を補完するものです。これは、KVMホストが動作可能であることと、リカバリされるゲストがKVMホストに存在しないことが前提となっています。

親トピック: KVMシステムのリカバリ・シナリオ

6.19.2.4 スナップショット・バックアップからのゲストのリストアおよびリカバリ

この手順は、ゲスト内から取得したゲストのスナップショット・ベースのバックアップを使用して、消失または損傷したKVMゲストのファイルをリストアするために使用できます。

親トピック: KVMシステムのリカバリ・シナリオ

6.20 ゲストの削除

Oracle Linux KVMでゲストを削除するには、OEDACLIまたはvm_makerユーティリティを使用します。

- OEDACLIを使用したOracle RACクラスタからのゲストの削除

OEDACLIを使用してクラスタからゲストを削除できます。 - vm_makerを使用したゲストの削除

vm_makerユーティリティを使用してゲストを削除できます。

親トピック: Oracle Linux KVMゲストの管理

6.20.1 OEDACLIを使用したOracle RACクラスタからのゲストの削除

OEDACLIを使用してクラスタからゲストを削除できます。

次の手順で、クラスタからゲストが削除されます。ゲストがクラスタの一部ではない場合、クラスタに関連するコマンドをスキップできます。

親トピック: ゲストの削除

6.20.2 vm_makerを使用したゲストの削除

vm_makerユーティリティを使用してゲストを削除できます。

次の手順で、クラスタからゲストが削除されます。ゲストがクラスタの一部ではない場合、Oracle Clusterwareに関連するコマンドをスキップできます。

親トピック: ゲストの削除

6.21 Oracle Linux KVMと組み合せたクライアント・ネットワークのVLANタグ付けの使用

このトピックでは、Oracle Linux KVMと組み合せたクライアント・ネットワークのタグ付けされたVLANインタフェースの実装について説明します。

Exadata Database Machine上のOracle Linux KVMゲストで実行しているOracleデータベースは、Oracle Exadata Deployment Assistant (OEDA)構成ツールで定義したクライアントEthernetネットワークを通じてアクセスします。KVMホストとゲストの両方のクライアント・ネットワーク構成は、初期デプロイ中にOEDAインストール・ツールが最初にゲストを作成するときに自動的に実行されます。

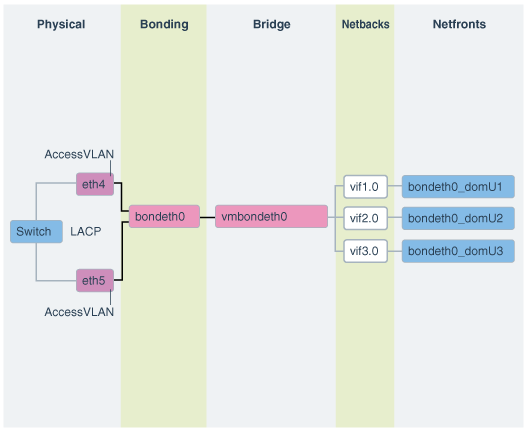

次の図に、デフォルトの結合クライアント・ネットワーク構成を示します。

ネットワークは、次のように構成されます:

-

KVMホストでは、OEDAで定義されていてゲスト・クライアント・ネットワークへのアクセスが許可されているethスレーブ・インタフェース(たとえば、eth1とeth2またはeth4とeth5)が、検出、構成および起動されますが、IPは割り当てられません。

-

KVMホストでは、bondeth0マスター・インタフェースが構成され、起動されますが、IPは割り当てられません。

-

KVMホストでは、ブリッジ・インタフェースvmbondeth0が構成されますが、IPは割り当てられません。

-

KVMホストでは、特定のゲストのbondeth0インタフェースにマッピングされる仮想バックエンド・インタフェース(VIF)がゲストごとに1つ構成され、起動されますが、IPは割り当てられません。これらのVIFは、ブリッジ・インタフェースvmbondeth0の上部に構成されます。また、KVMホストのVIFインタフェースとそれに対応するゲストのインタフェースbondeth0との間のマッピングは、

vm.cfgというゲスト構成ファイルで定義されます。このファイルは、/EXAVMIMAGES/GuestImages/guest nameにあります。

デフォルトのインストールでは、単一のbondeth0と対応するvmbondeth0ブリッジ・インタフェースは、前述で説明するようにKVMホスト内で構成されます。このbondeth0インタフェースはデフォルトのAccess VLANに基づいています。Access VLANに対して、bondeth0を構築するスレーブ・インタフェースで使用されるスイッチ上のポートが構成されます。

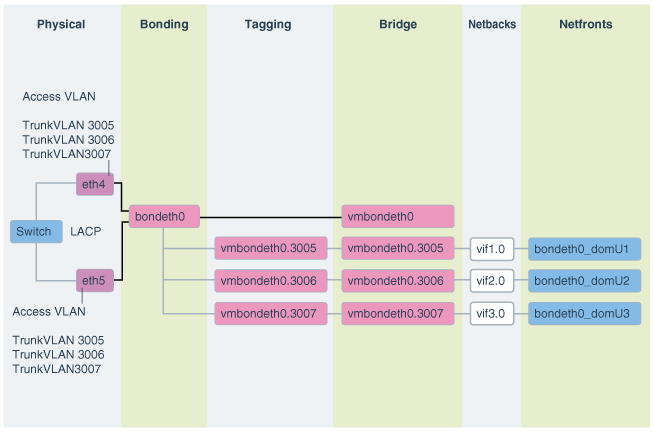

VLANタグ付けの使用

Exadataの仮想デプロイメントで、ゲスト全体でネットワーク分離を有効にするなど、クライアント・ネットワーク上の他のVLANにアクセスする必要がある場合、802.1QベースのVLANタグ付けにより解決できます。次の図に、VLANタグ付けをしたクライアント・ネットワーク構成を示します。

図6-2 VLANタグ付けをしたOracle Virtual EnvironmentのNICレイアウト

「図6-2 VLANタグ付けをしたOracle Virtual EnvironmentのNICレイアウト」の説明

ノート:

2020年3月のOEDAリリース以降、ブリッジ名の形式はvmbethXY.VLANIDになりました。ここで、XとYはスレーブ・インタフェースに関連付けられた数値識別子で、VLANIDはVLAN IDです。

これにより、以前に一部の状況で発生していた潜在的なネーミング競合が回避されます。

たとえば、新しいネーミング・スキームでは、前の図のブリッジの名前はvmbeth45.3005、vmbeth45.3006およびvmbeth45.3007になります。

タグ付けされたVLANインタフェースをOracle Linux KVMと組み合せて手動で構成する手順は、My Oracle Supportのノート2710712.1を参照してください。

6.22 Oracle Linux KVMと組み合せたExadata Secure RDMA Fabric Isolationの使用

このトピックでは、Oracle Linux KVMと組み合せたExadata Secure RDMA Fabric Isolationの実装について説明します。

Secure Fabricにより、Exadata Database Machineの複数テナント間のセキュアな統合および厳密な分離が可能になります。各テナントは、Oracle Linux KVMで実行されるデータベース・サーバーVMを使用した、専用の仮想マシン(VM)クラスタに存在します。

Secure Fabricを使用すると、各データベース・クラスタで、Oracle RACのノード間メッセージングをサポートするデータベース・サーバー間のクラスタ・ネットワーキングに、専用のネットワーク・パーティションおよびVLAN IDが使用されます。このパーティションでは、すべてのデータベース・サーバーが完全なメンバーです。これらは、パーティション内では自由に通信できますが、他のパーティションのデータベース・サーバーとは通信できません。

別のVLAN IDを持つ別のパーティションでは、ストレージ・ネットワーク・パーティションがサポートされます。ストレージ・サーバーはストレージ・ネットワーク・パーティション内の完全なメンバーで、それぞれのデータベース・サーバーVMは制限されたメンバーでもあります。ストレージ・ネットワーク・パーティションを使用すると、次のようになります。

- 各データベース・サーバーは、すべてのストレージ・サーバーと通信できます。

- 各ストレージ・サーバーは、サポートしているすべてのデータベース・サーバーと通信できます。

- ストレージ・サーバーは、セルからセルへの操作を実行するために、相互に直接通信できます。

クラスタ・ネットワーク・パーティションおよびストレージ・ネットワーク・パーティションをサポートするために、各データベース・サーバーVMは4つの仮想インタフェースでplumbされます。

clre0およびclre1は、クラスタ・ネットワーク・パーティションをサポートします。-

stre0およびstre1は、ストレージ・ネットワーク・パーティションをサポートします。対応する

stre0およびstre1のインタフェースも、各ストレージ・サーバーでplumbされます。

各サーバーで、RoCEネットワーク・インタフェース・カードは、VLANタグの強制を実行するハイパーバイザのスイッチのように機能します。このことはKVMホスト・レベルで行われるため、データベース・サーバーVMでのソフトウェアの悪用または構成ミスによって、クラスタの分離がバイパスされることはありません。

このリリースでは、Oracle Exadata Deployment Assistant (OEDA)を使用する初期システム・デプロイメントの一部としてSecure Fabricを有効にすることのみ可能です。既存のシステムでのSecure Fabricは、システムをワイプしてOEDAを使用してそれを再デプロイしないと、有効化できません。有効にすると、Secure Fabricは、同じRoCEネットワーク・ファブリックを共有するすべてのサーバーおよびクラスタに適用されます。

6.23 Oracle Linux KVMゲストへの結合ネットワーク・インタフェースの追加

この手順を使用して、既存のOracle Linux KVMゲストに結合ネットワーク・インタフェースを追加します。

たとえば、この手順を使用して、Oracle Linux KVMゲストにバックアップ・ネットワークを追加できます。

Oracle Linux KVMゲストに結合ネットワーク・インタフェースを追加する手順は、次のとおりです。

親トピック: Oracle Linux KVMゲストの管理

6.24 Oracle Linux KVM環境でのOracle EXAchkの使用

Exadata Database Machineでの仮想化は、Oracle EXAchkバージョン12.1.0.2.2以降でサポートされています。

- Oracle Linux KVM環境でのOracle EXAchkの実行

Exadata Database MachineのOracle Linux KVM環境でOracle EXAchk監査チェックの完全なセットを実行するには、Oracle EXAchkをインストールして、複数の場所から実行する必要があります。 - Oracle EXAchkによって実行される監査チェック

Oracle EXAchkは、KVMホストとゲストで異なる監査チェックを実行します。 - Exadata Database Machineに対するOracle EXAchkのコマンドライン・オプション

Oracle EXAchkには、特別なコマンドライン・オプションは必要ありません。これにより、Exadata Database MachineのOracle Linux KVM環境で実行していることが自動的に検出されます。

親トピック: Oracle Linux KVMゲストの管理

6.24.1 Oracle Linux KVM環境でのOracle EXAchkの実行

Exadata Database MachineのOracle Linux KVM環境でOracle EXAchk監査チェックの完全なセットを実行するには、Oracle EXAchkをインストールして、複数の場所から実行する必要があります。

- 1つのKVMホストからOracle EXAchkを実行します。

- Oracle Linux KVMで実行している各Oracle Real Application Clusters (Oracle RAC)クラスタの1つのゲストからOracle EXAchkを実行します。

たとえば、4つのOracle RACクラスタを含む2つのデータベース・サーバー(両方のデータベース・サーバーで合計8つのゲスト、クラスタごとに2つのノード)を搭載しているExadata Database Machineクオータ・ラックでは、次のようにOracle EXAchkを個別に5回実行する必要があります。

-

最初のクラスタの最初のゲストでOracle EXAchkを実行します。

-

2番目のクラスタの最初のゲストでOracle EXAchkを実行します。

-

3番目のクラスタの最初のゲストでOracle EXAchkを実行します。

-

4番目のクラスタの最初のゲストでOracle EXAchkを実行します。

-

最初のKVMホストでOracle EXAchkを実行します。

6.24.2 Oracle EXAchkによって実行される監査チェック

Oracle EXAchkは、KVMホストとゲストで異なる監査チェックを実行します。

Oracle EXAchkをKVMホストにインストールして実行すると、次のハードウェアおよびオペレーティング・システム・レベルのチェックが実行されます。

- データベース・サーバー(KVMホスト)

- ストレージ・サーバー

- RDMAネットワーク・ファブリック

- RDMAネットワーク・ファブリックのスイッチ

Oracle EXAchkをゲストにインストールして実行すると、ゲストのオペレーティング・システムのチェックと、Oracle Grid InfrastructureおよびOracle Databaseのチェックが実行されます。

6.24.3 Exadata Database Machineに対するOracle EXAchkのコマンドライン・オプション

Oracle EXAchkは、KVMホストとゲストのどちらで実行されているかを自動的に検出し、適切な監査チェックを実行します。たとえば、最も簡単なケースとして、コマンドライン・オプションなしでOracle EXAchkを実行できます。

./exachk

KVMホストでOracle EXAchkを実行すると、RDMAネットワーク・ファブリック・ネットワーク経由でアクセス可能なすべてのデータベース・サーバー、ストレージ・サーバーおよびRDMAネットワーク・ファブリック・スイッチで監査チェックが実行されます。

サーバーまたはスイッチのサブセットでOracle EXAchkを実行するには、次のコマンドライン・オプションを使用します。

オプション

-

-clusternodes: データベース・サーバーのカンマ区切りリストを指定します。 -

-cells: ストレージ・サーバーのカンマ区切りリストを指定します。

例6-1 ノードとスイッチのサブセットに対するOracle EXAchkの実行

たとえば、最初のクオータ・ラックのみが仮想化用に構成されているが、RDMAネットワーク・ファブリックネットワーク経由ですべてのコンポーネントにアクセス可能なExadata Database Machineフル・ラックの場合、データベース・サーバーdm01adm01から次のようなコマンドを実行できます。

./exachk -clusternodes dm01adm01,dm01adm02

-cells dm01celadm01,dm01celadm02,dm01celadm03