概要

このガイドでは、KubernetesでOracle WebCenter Portalインスタンスをプロビジョニングおよび管理する方法について説明します。

はじめに

このガイドでは、Kubernetes環境内でOracle WebCenter Portalインスタンスをプロビジョニングおよび管理するプロセスの概要を示します。これは、Kubernetesでこれらのインスタンスを効果的に作成および管理しようとするユーザーのリソースとして機能します。

対象読者

このガイドは、KubernetesでOracle WebCenter Portalインスタンスを作成および管理するユーザーを対象としています。

Oracle WebCenter Portal on Kubernetes

WebLogic Kubernetes Operatorは、Kubernetes上でのWebLogic ServerおよびFusion Middleware Infrastructureドメインの実行をサポートして、Kubernetes環境でのOracle WebCenter Portalのデプロイメントを容易にします。

このリリースでは、Oracle WebCenter Portalドメインは、ドメイン・ホームが永続ボリュームに格納される「永続ボリューム上のドメイン」モデルのみを中心に構成されます。

このリリースには、ポートレット管理対象サーバーのサポートが含まれており、Oracle WebCenter Portal環境内でのポートレット・アプリケーションのデプロイメントおよび管理が可能です。

オペレータは、KubernetesでのOracle WebCenter Portalドメインのデプロイおよび管理に役立ついくつかの主要な機能を提供します。これらの機能では次が可能です:

- ネットワーク・ファイル・システム(NFS)またはその他のタイプのKubernetesボリュームでホストできるKubernetes永続ボリューム(PV)にOracle WebCenter Portalインスタンスを作成します。

- 宣言的な起動パラメータと適切な状態に基づいてサーバーを起動します。

- 外部アクセス用にOracle WebCenter Portalサービスを公開します。

- オンデマンドで管理対象サーバーを起動および停止するか、REST APIとの統合を使用して、Oracle WebCenter Portalドメインをスケーリングします。

- Kibanaを介して対話するために、オペレータとWebLogic Serverの両方からElasticsearchにログを公開します。

- PrometheusおよびGrafanaを使用してOracle WebCenter Portalインスタンスをモニターします。

現在のリリース

KubernetesでのOracle WebCenter Portalドメイン・デプロイメントの現在のリリースは、24.4.3です。このリリースでは、WebLogic Kubernetes Operatorバージョン4.2.9を使用します。

最近の変更および既知の問題

KubernetesでのOracle WebCenter Portalドメイン・デプロイメントの最近の変更および既知の問題については、リリース・ノートを参照してください。

このドキュメントについて

このドキュメントには、様々な読者を対象とした項が含まれています。より簡単に探している内容を見つけるには、この目次を使用してください:

クイック・スタートでは、特別なことをせずにデフォルト設定を使用してOracle WebCenter Portalドメイン・インスタンスを迅速に実行する方法を説明しています。これは、開発およびテストのみを目的としていることに注意してください。

インストール・ガイドおよび管理ガイドでは、Kubernetesオペレータの使用に関するすべての側面について、次のような詳細情報を提供しています:

- オペレータのインストールおよび構成

- オペレータを使用したOracle WebCenter Portalドメインの作成および管理

- WebCenter Portalの検索機能の構成

- Kubernetesロード・バランサの設定

- WebCenter PortalをモニターするためのPrometheusおよびGrafanaの構成

- Elasticsearchでのロギングの設定

リリース・ノート

最近の変更

Oracle WebCenter Portal on Kubernetesのリリース・ノートを確認します。

| 日付 | バージョン | 変更 |

|---|---|---|

| 2024年12月 | 14.1.2.0.0 GitHubリリース・バージョン24.4.3 |

Oracle WebCenter Portal on Kubernetes 14.1.2.0.0の最初のリリース。 |

インストール・ガイド

WebLogic Kubernetes Operatorをインストールし、Oracle WebCenter Portalドメインを準備してデプロイします。

要件および制限事項

WebLogic Kubernetes Operatorを使用してOracle WebCenter Portalをデプロイおよび実行するためのシステム要件および制限事項を理解します。

概要

このドキュメントでは、WebLogic Kubernetes Operatorを使用してWebCenter Portalドメインをデプロイおよび実行する際の具体的な考慮事項について説明します。ここで説明する考慮事項の他に、WebCenter PortalドメインはFusion Middleware InfrastructureおよびWebLogic Serverドメインと同様に動作します。

このリリースでは、WebCenter Portalドメインは、ドメインが永続ボリューム(PV)に存在する「永続ボリューム上のドメイン」モデルに基づいています。

システム要件

リリース24.4.3には、次のシステム要件があります:

- Kubernetes: バージョン1.24.0+、1.25.0+、1.26.2+、1.27.2+、1.28.2+および1.29.1+ (

kubectl versionで確認)。 - ネットワーキング: v0.13.0-amd64以降(

docker images | grep flannelで確認)またはCalico v3.16.1+。 - Helm: バージョン3.10.2+ (

helm version --client --shortで確認)。 - コンテナ・ランタイム: Docker 19.03.11+ (

docker versionで確認)またはCRI-O 1.20.2+ (crictl version | grep RuntimeVersionで確認)。 - WebLogic Kubernetes Operator: バージョン4.2.9 (オペレータのリリース・ノートを参照)。

- Oracle WebCenter Portal: バージョン14.1.2.0イメージ。

プロキシ設定: 次のプロキシ構成を使用して、必要なバイナリおよびソース・コードをそれぞれのリポジトリからプルします:

export NO_PROXY="localhost,127.0.0.0/8,$(hostname -i),.your-company.com,/var/run/docker.sock"

export no_proxy="localhost,127.0.0.0/8,$(hostname -i),.your-company.com,/var/run/docker.sock"

export http_proxy=http://www-proxy-your-company.com:80

export https_proxy=http://www-proxy-your-company.com:80

export HTTP_PROXY=http://www-proxy-your-company.com:80

export HTTPS_PROXY=http://www-proxy-your-company.com:80制限事項

オペレータを使用したKubernetesでのWebLogic Serverドメインの実行と比較して、現在、WebCenter Portalドメインには次の制限があります:

「イメージ内のドメイン」モデルは、このバージョンのオペレータではサポートされていません。また、WebLogic Deploy Tooling (WDT)ベースのデプロイメントは、現在サポートされていません。- 構成済クラスタのみがサポートされています。動的クラスタは、WebCenter Portalドメインではサポートされていません。すべてのスケーリング機能を引き続き使用できます(ドメインの作成時にクラスタの最大サイズを定義するだけです)。

- 現在、WebCenter PortalはLinux以外のコンテナでは実行されません。

- WebCenter Portalドメインのデプロイおよび実行は、オペレータのバージョン4.2.9でのみサポートされています。

- WebLogic Logging Exporterプロジェクトがアーカイブされました。FluentdまたはLogstashを使用することをお薦めします。

- WebLogic Monitoring Exporterは現在、WebLogic MBeanツリーのみをサポートしています。JRF MBeanのサポートはまだ追加されていません。

環境の準備

Oracle WebCenter Portalドメインの作成を準備します。この準備には、必要なシークレット、永続ボリューム、ボリューム要求およびデータベース・スキーマの作成が含まれますが、これらに限定されません。

KubernetesクラスタおよびWebLogic Kubernetes Operatorの確立など、環境を設定します。

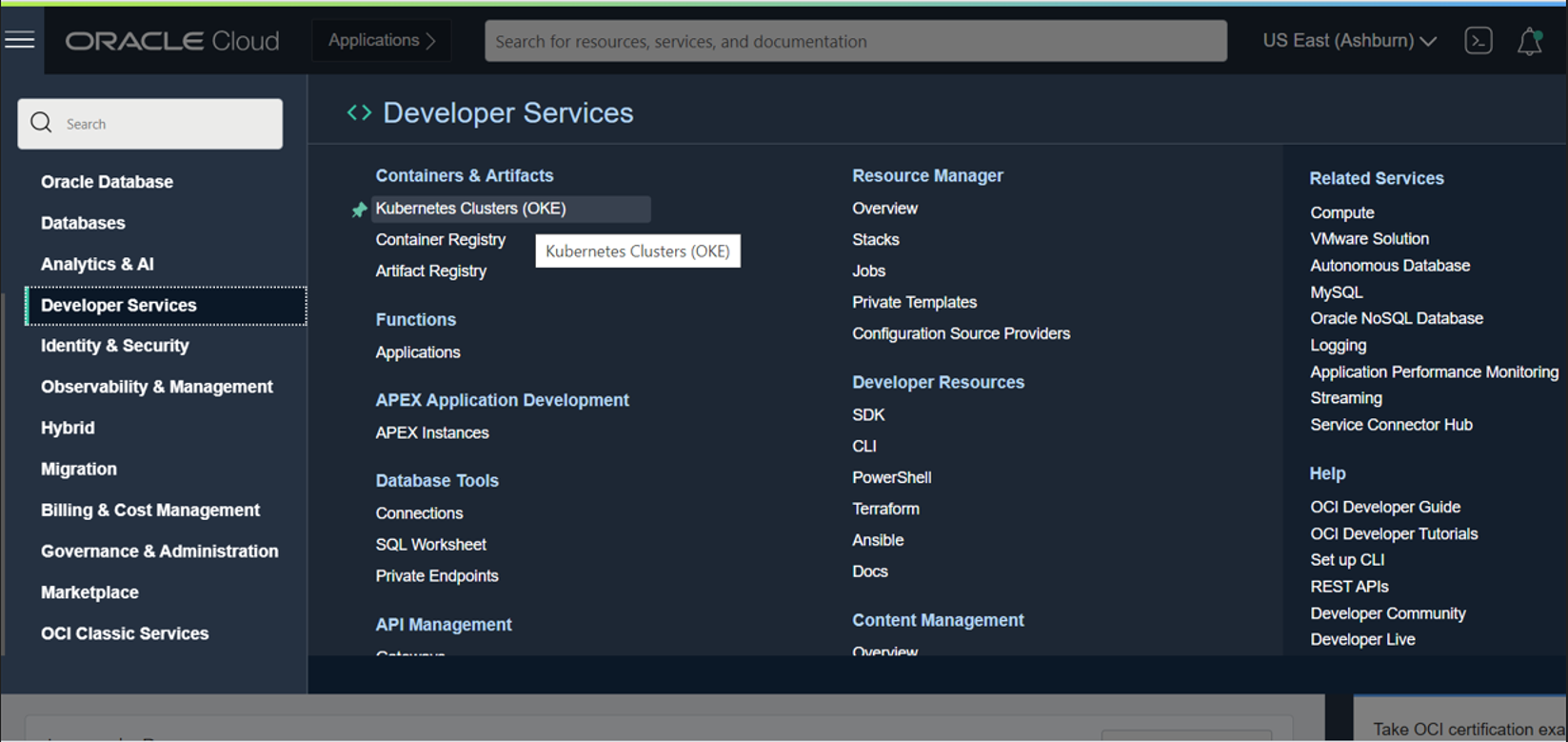

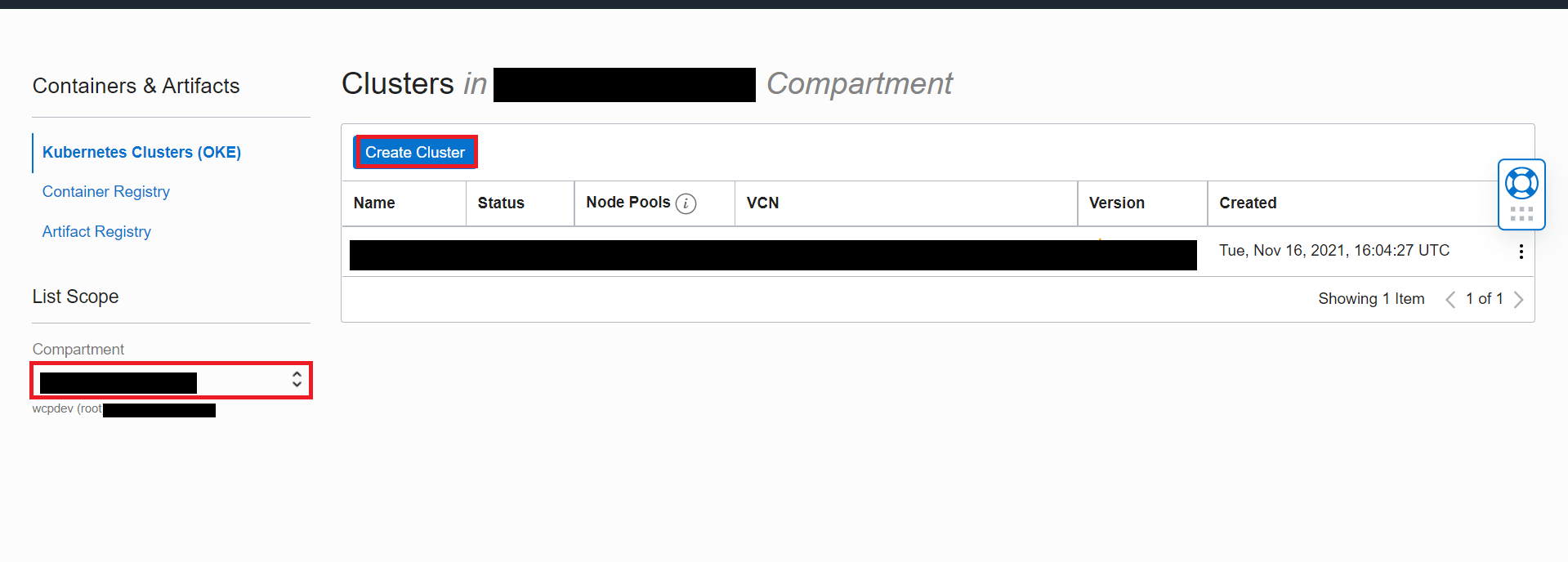

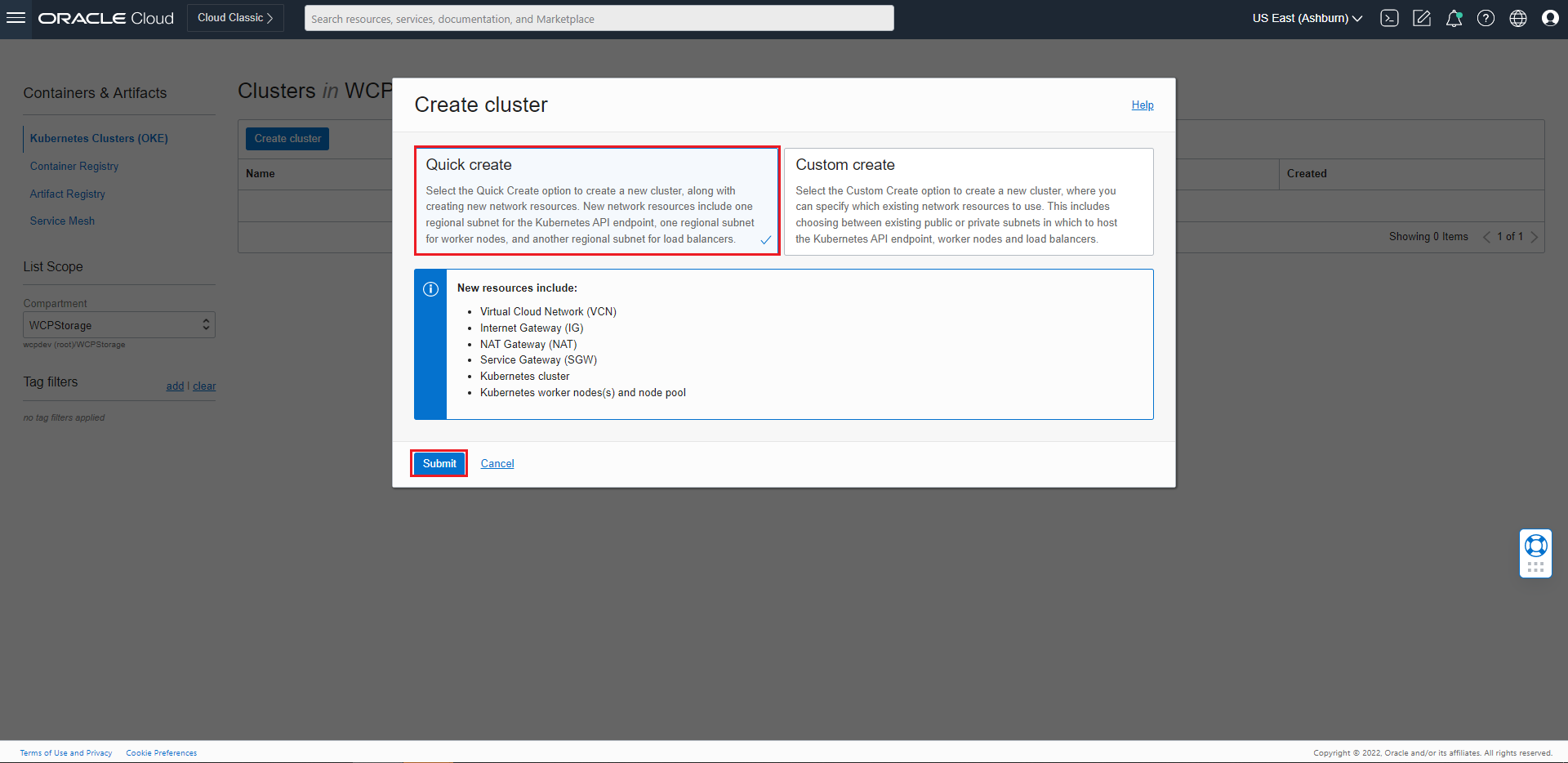

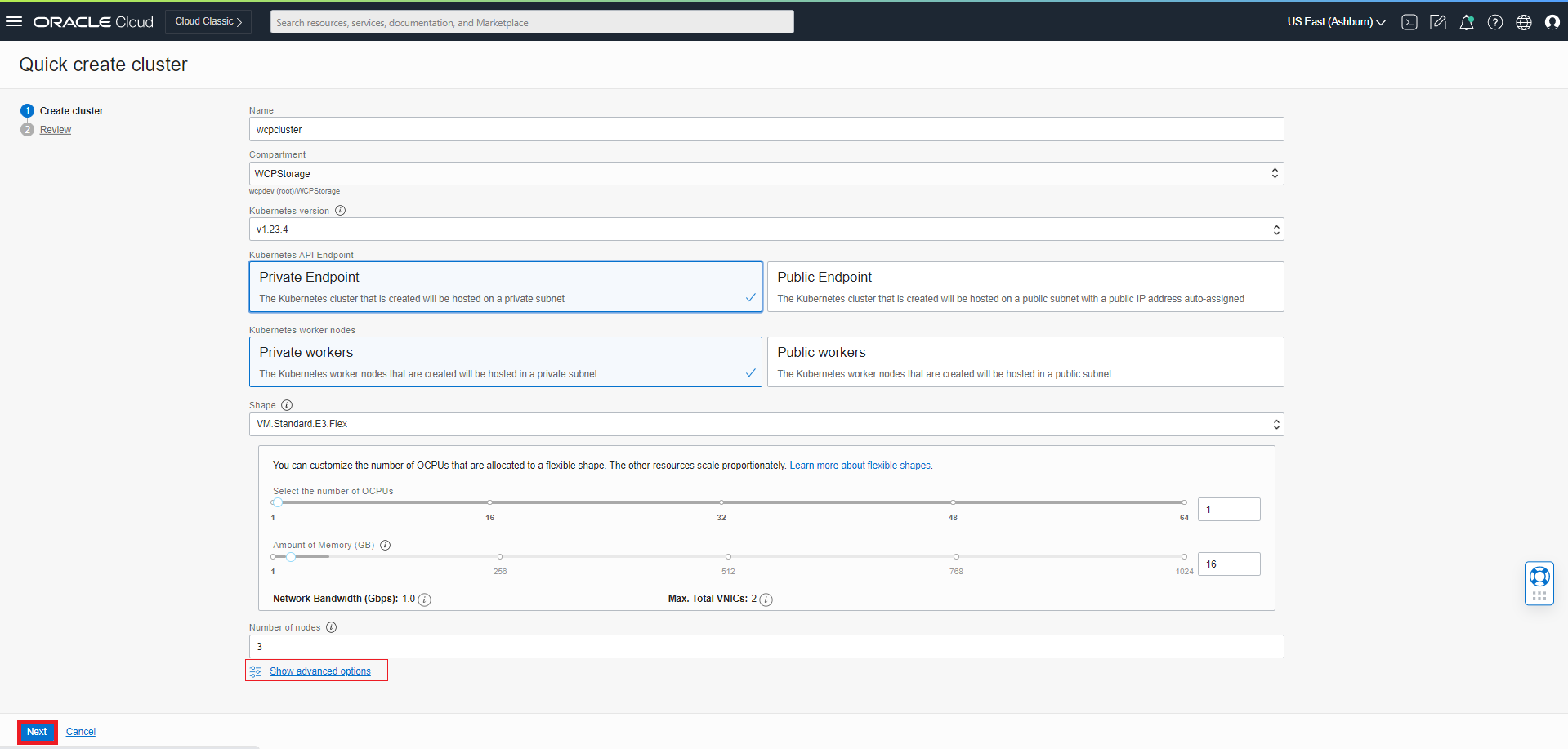

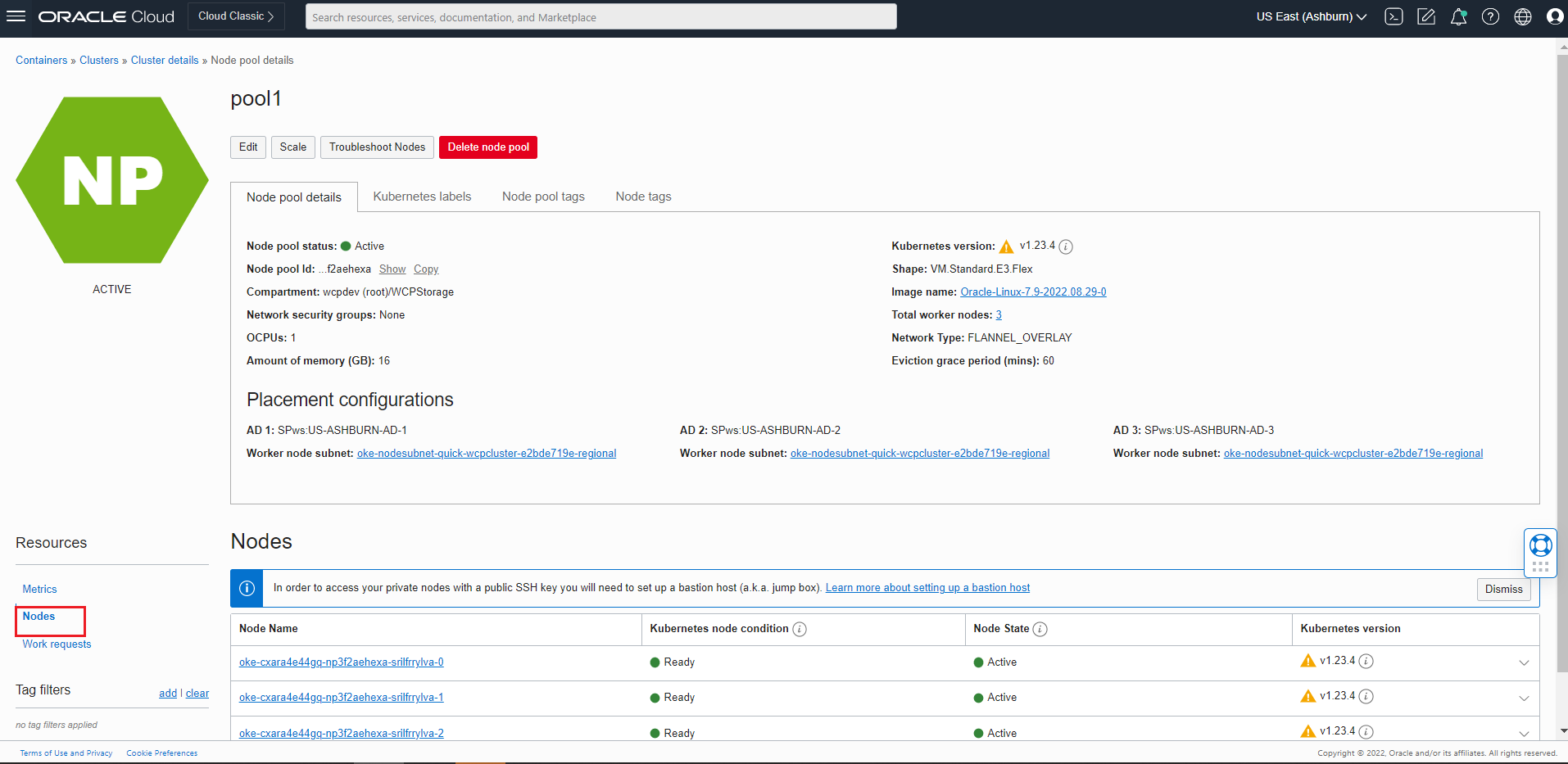

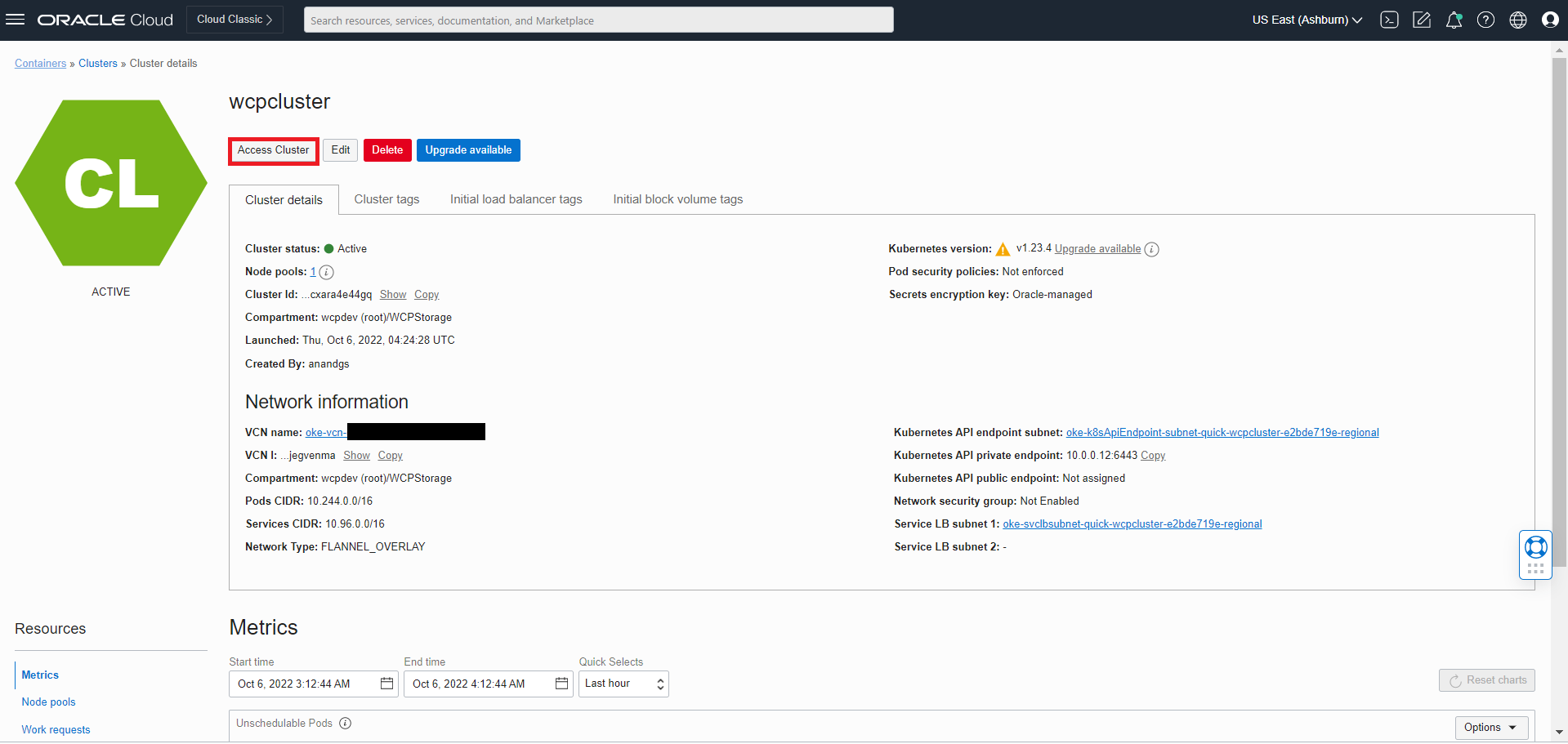

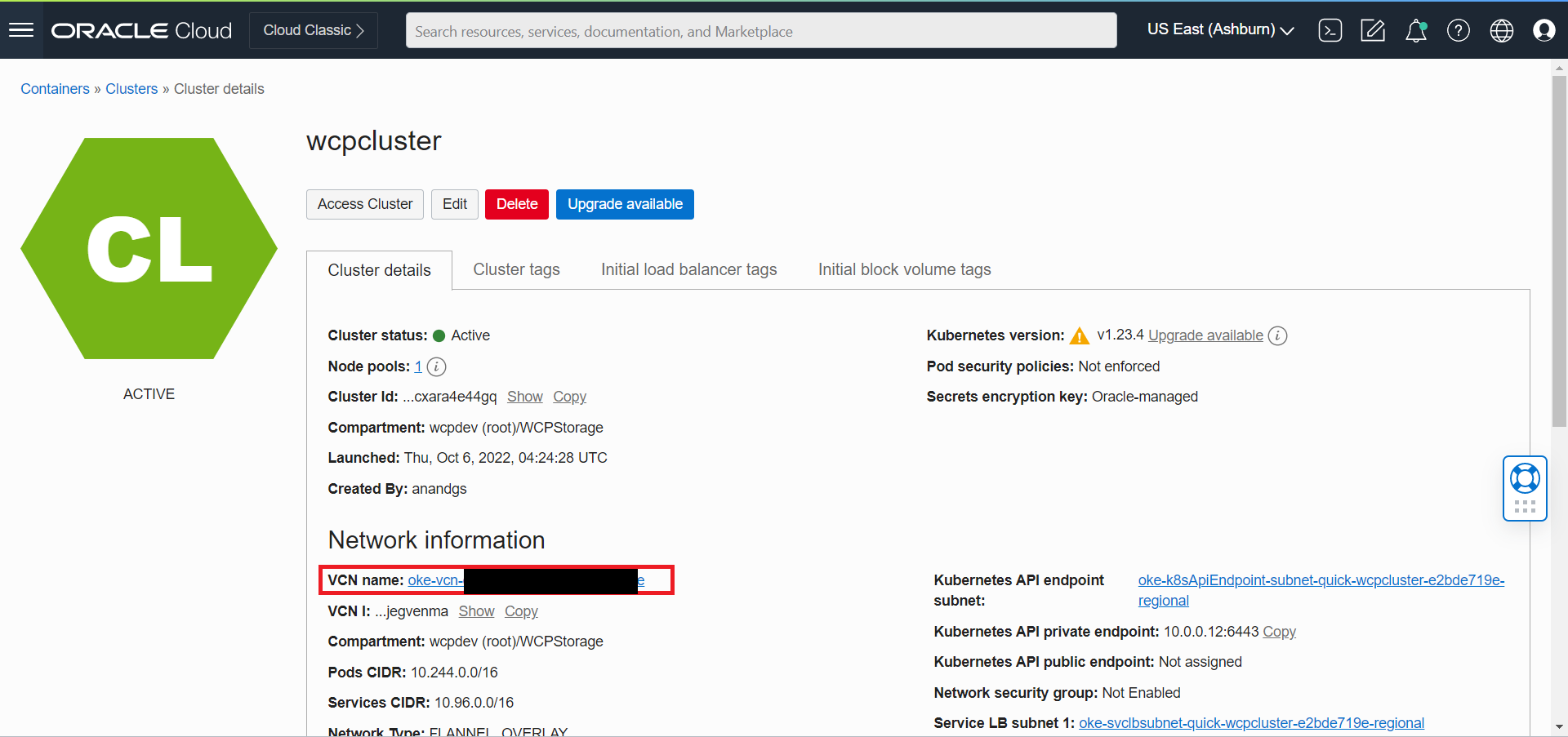

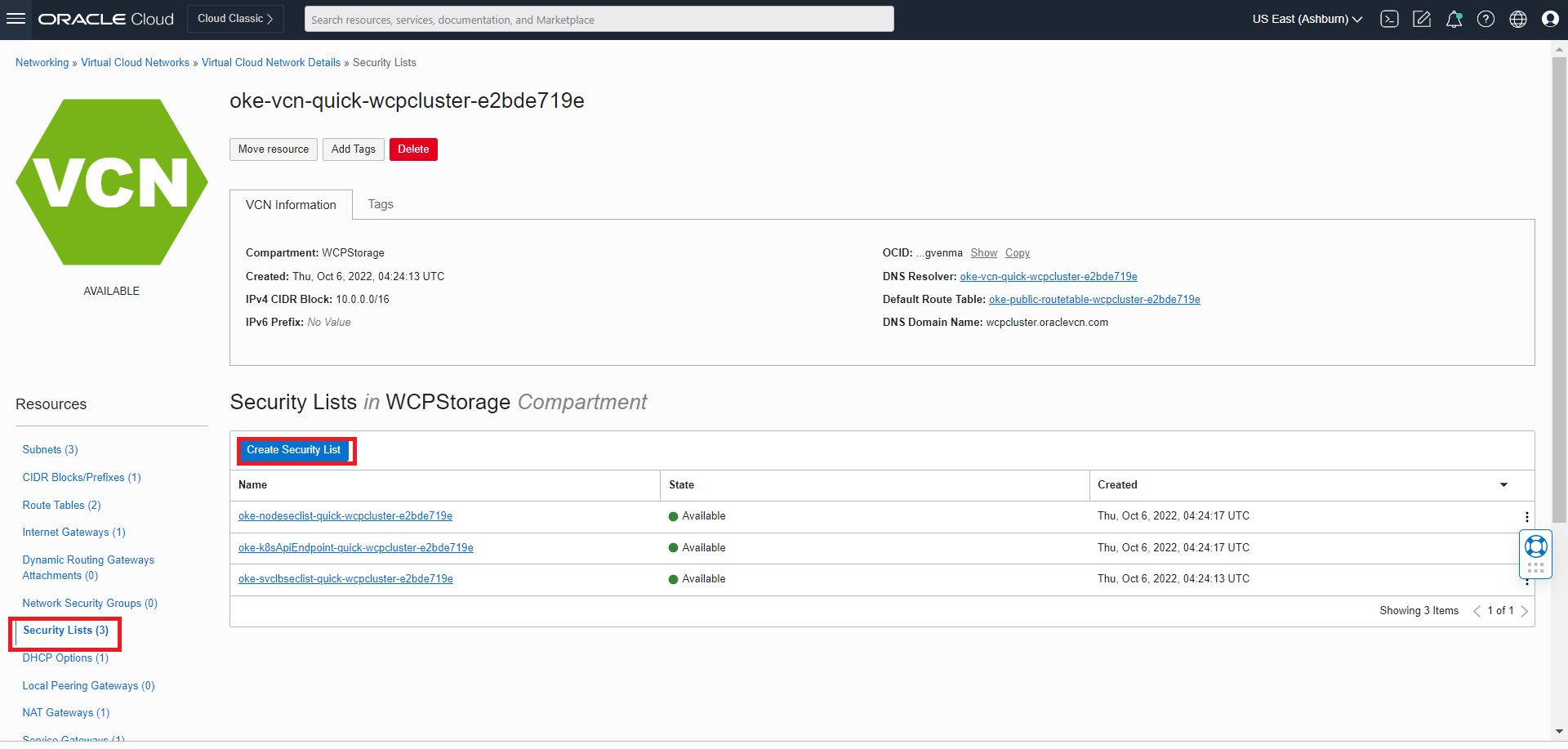

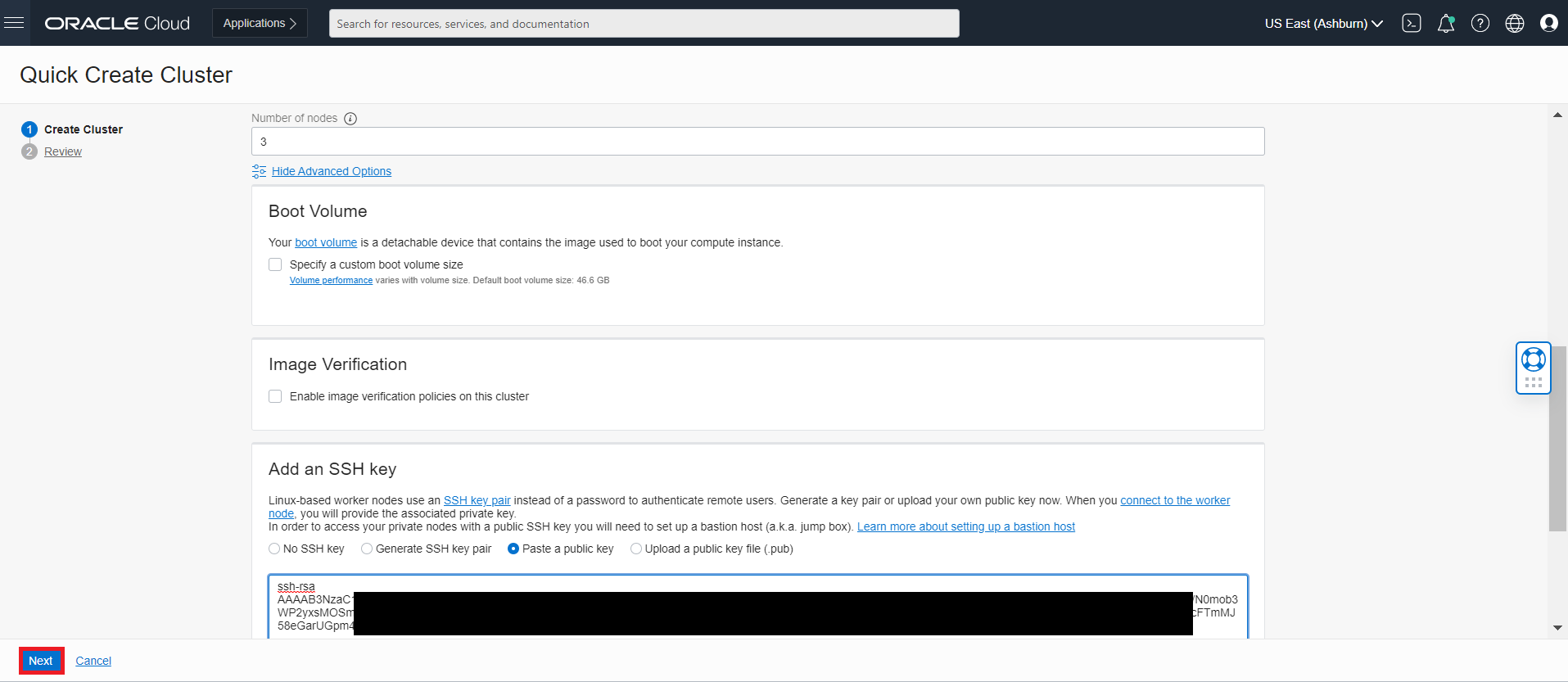

Kubernetesクラスタの設定

公式のKubernetesの設定ドキュメントを参照して、本番グレードのKubernetesクラスタを確立します。

Kubernetesクラスタの作成後、オプションで次のことができます:

- ロード・バランサを作成して、トラフィックをバックエンド・ドメインに転送します。

- オペレータ・ログ用にKibanaおよびElasticsearchを構成します。

Helmのインストール

オペレータは、Helmを使用して必要なリソースを作成およびデプロイし、Kubernetesクラスタでオペレータを実行します。Helmのインストールおよび使用方法の詳細は、ここを参照してください。

他の依存イメージのプル

依存イメージには、WebLogic Kubernetes Operator、データベースおよびTraefikが含まれます。これらのイメージをプルして、ローカル・レジストリに追加します:

これらのdockerイメージをプルして、次に示すように再度タグ付けします:

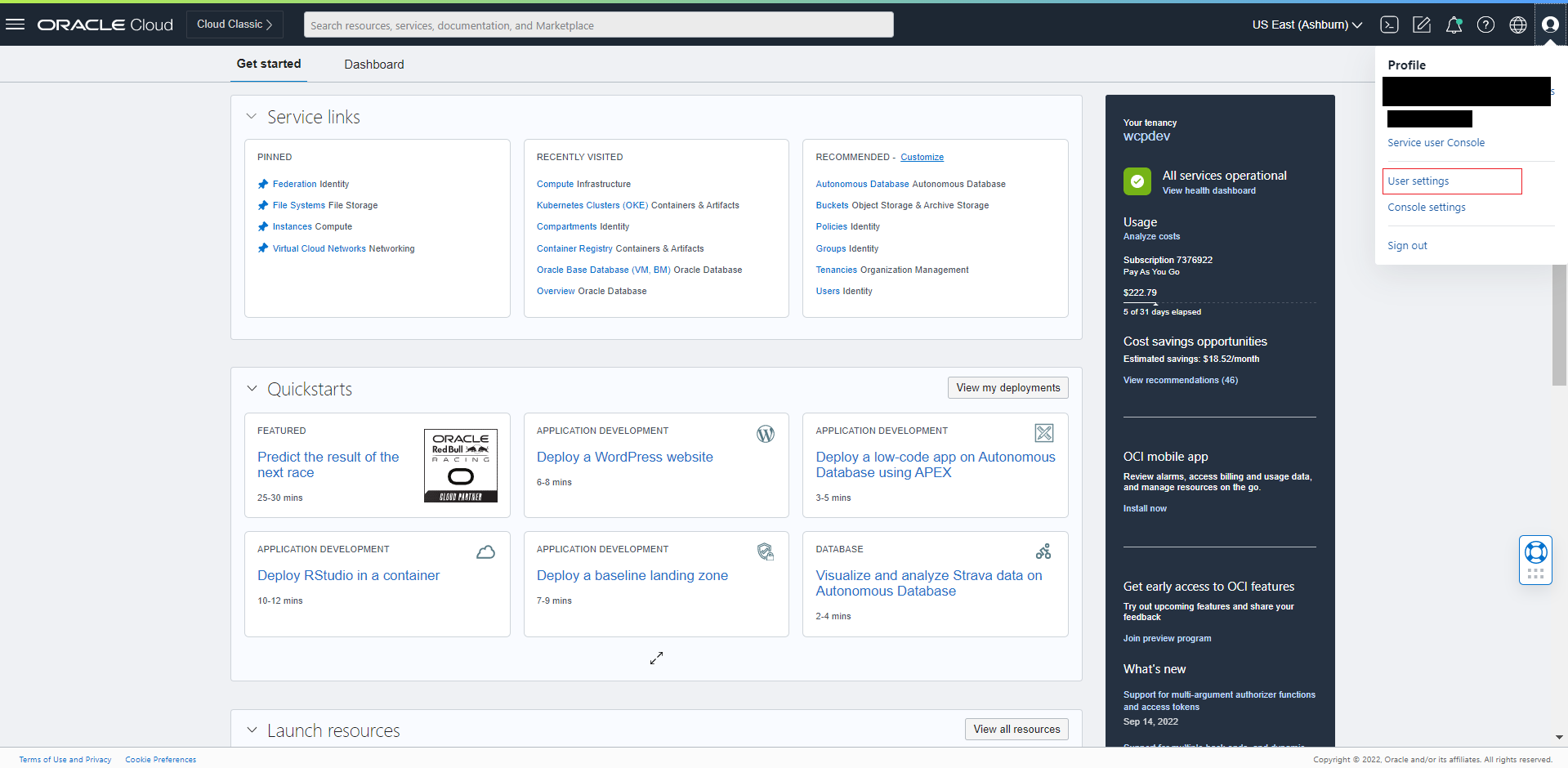

Oracle Container Registryからイメージをプルするには、Webブラウザで

https://container-registry.oracle.comに移動し、Oracle Single Sign-On認証サービスを使用してログインします。SSO資格証明がまだない場合は、ページの上部にある「Sign In」リンクをクリックして作成します。Webインタフェースを使用して、デプロイするOracleソフトウェア・イメージのオラクル社標準の条件および規制に同意します。これらの条件の同意は、ソフトウェア・イメージをOracle Single Sign-Onログイン資格証明にリンクするデータベースに格納されます。

次に、これらのdockerイメージをプルします:

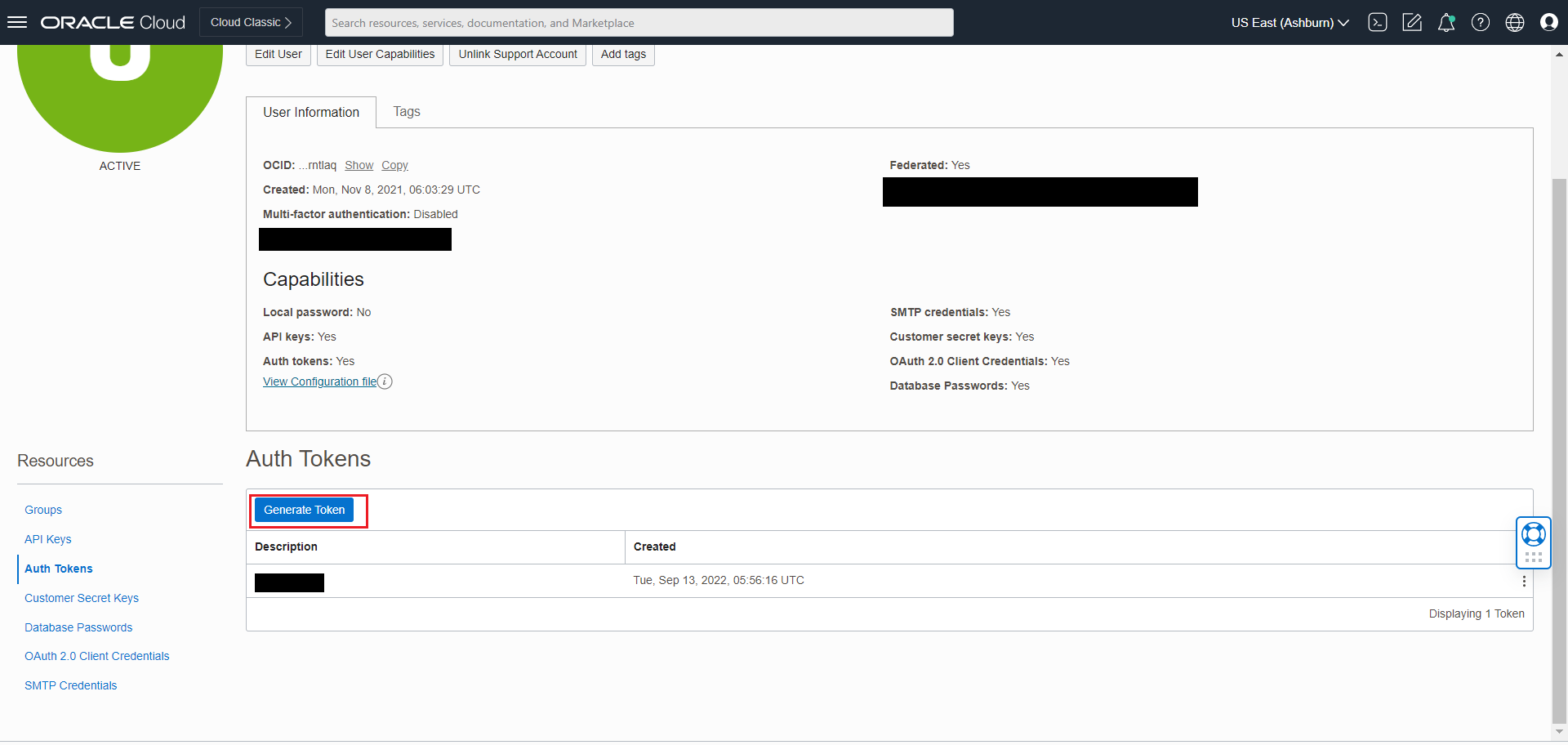

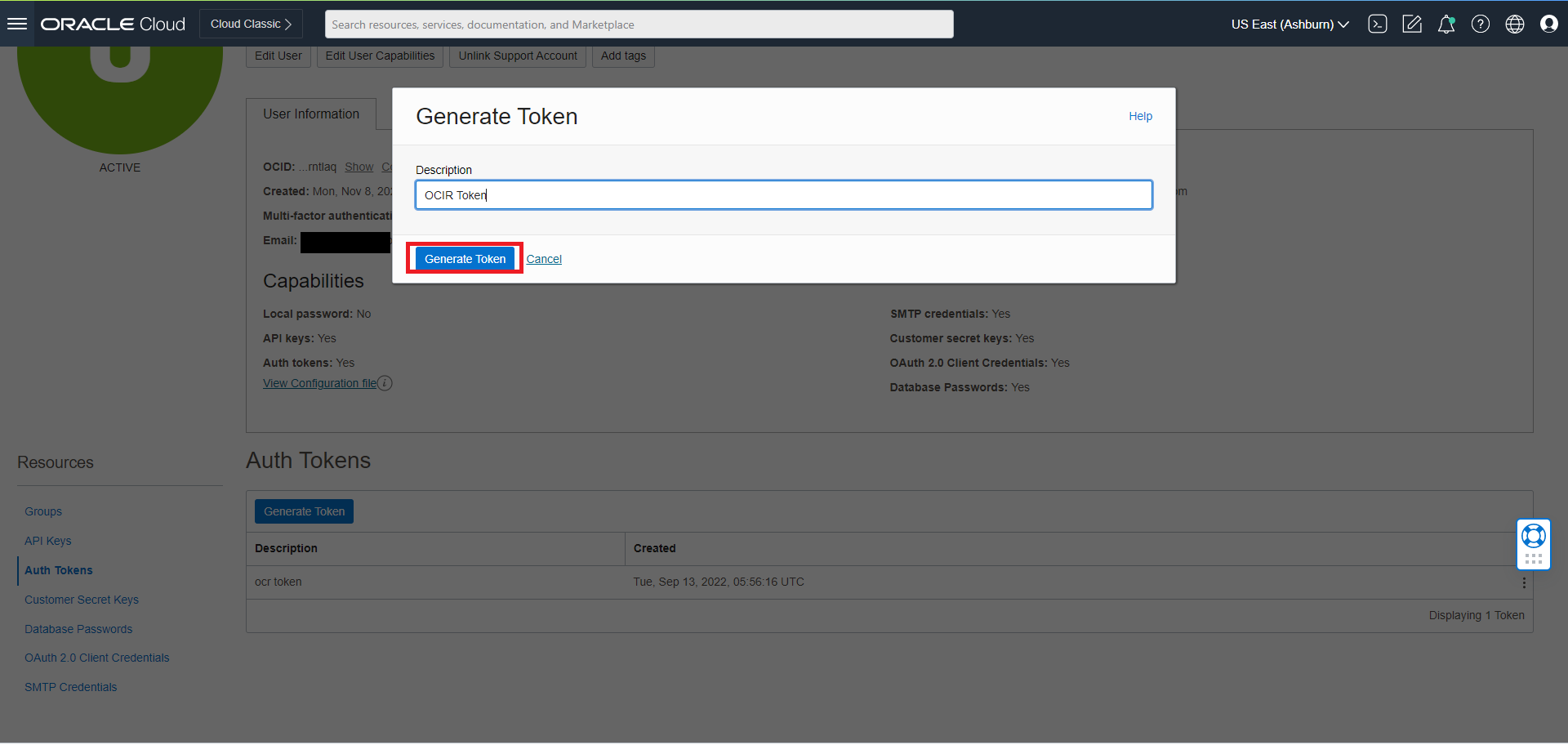

#This step is required once at every node to get access to the Oracle Container Registry. docker login https://container-registry.oracle.com (enter your Oracle email Id and password)WebLogic Kubernetes Operatorイメージ:

docker pull ghcr.io/oracle/weblogic-kubernetes-operator:4.2.9ビルドおよびプルされたすべてのイメージをクラスタ内のすべてのノードにコピーするか、クラスタがアクセスできるDockerレジストリに追加します。

ノート: 開発マシンでKubernetesを実行していない場合は、Kubernetesクラスタから認識できるレジストリでDockerイメージを使用できるようにする必要があります。

次のように、DockerおよびKubernetesを実行しているマシンにイメージをアップロードします:

# on your build machine docker save Image_Name:Tag > Image_Name-Tag.tar scp Image_Name-Tag.tar YOUR_USER@YOUR_SERVER:/some/path/Image_Name-Tag.tar # on the Kubernetes server docker load < /some/path/Image_Name-Tag.tar

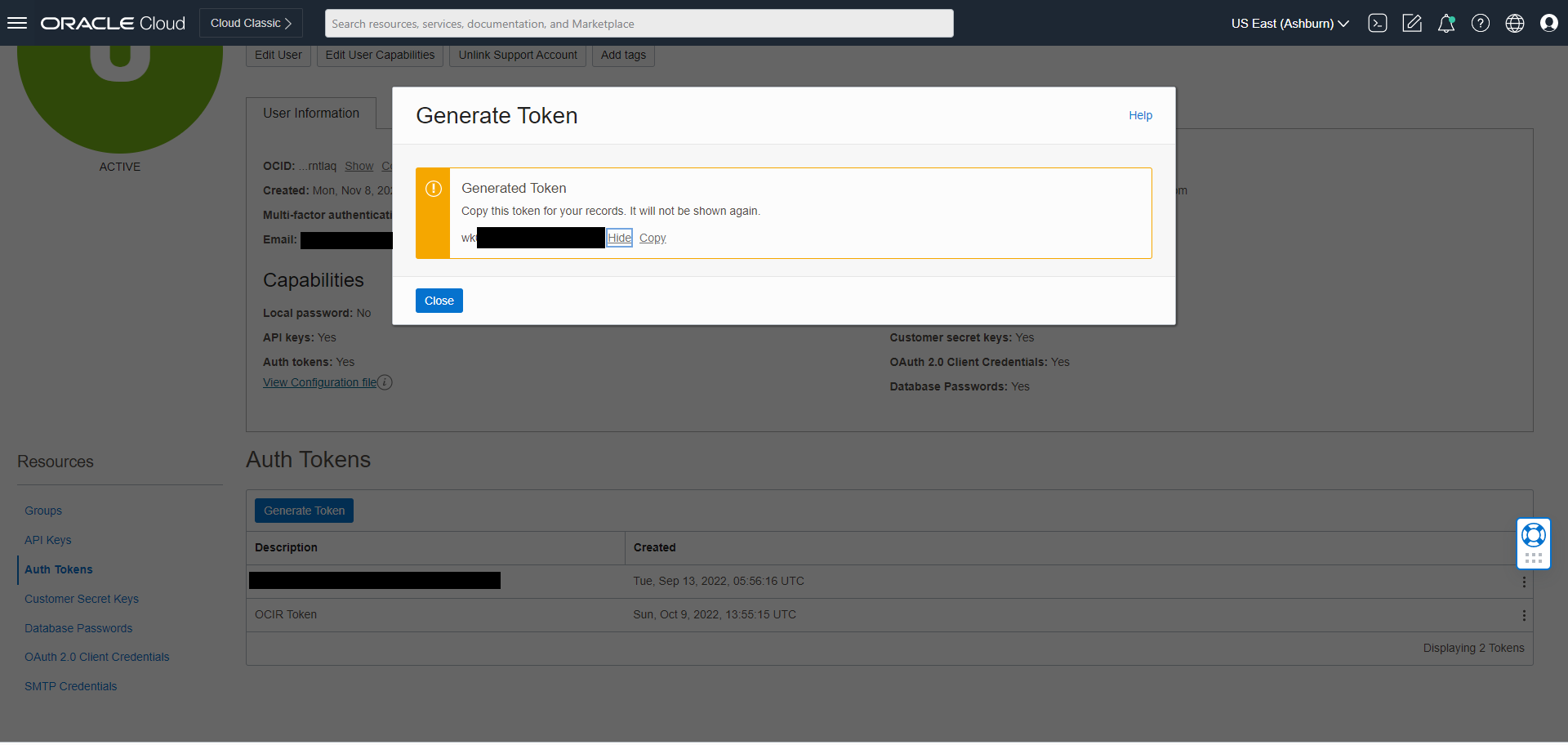

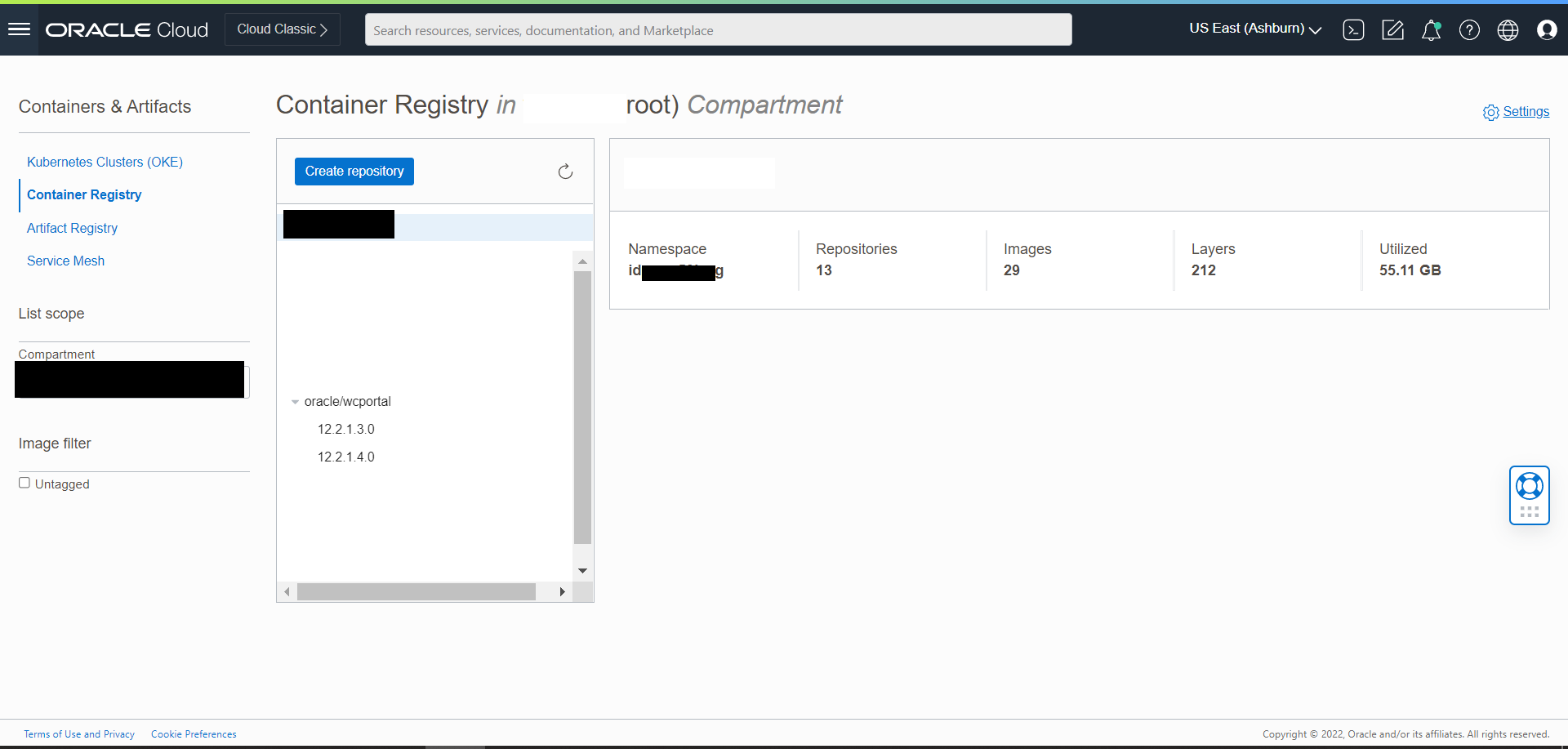

Oracle WebCenter Portal Dockerイメージの取得

Oracle Container Registry (OCR)からのOracle WebCenter Portalイメージの取得

初回のユーザーの場合、次のステップに従ってOracle Container Registryからイメージをプルします:

Oracle Container Registryに移動し、Oracle Single Sign-On (SSO)認証サービスを使用してログインします。

ノート: SSO資格証明がまだない場合は、ここでOracleアカウントを作成できます。

Webインタフェースを使用して、デプロイするOracleソフトウェア・イメージのオラクル社標準の条件および規制に同意します。

ノート: これらの条件の同意は、Oracle Single Sign-On資格証明にリンクされたデータベースに格納されます。

次のコマンドを使用して、Oracle Container Registryにログインします:

docker login container-registry.oracle.com- 次のコマンドを実行して、事前ビルドされたOracle WebCenter Portalイメージを検索してプルします:

docker pull container-registry.oracle.com/middleware/webcenter-portal_cpu:14.1.2.0-<TAG>Oracle WebCenter Portalコンテナ・イメージのビルド

別の方法として、追加バンドルまたは個別パッチを含め、WebLogic Image ToolでOracle WebCenter Portalコンテナ・イメージをビルドして使用する場合は、これらのステップに従ってイメージを作成します。

ノート:

- Oracle WebCenter Portalドメイン・デプロイメントに使用されるデフォルトのOracle WebCenter Portalイメージ名は、

oracle/wcportal:14.1.2.0です。- 作成するイメージには、

docker tagコマンドを使用してoracle/wcportal:14.1.2.0とタグ付けする必要があります。- イメージに別の名前を選択した場合は、

create-domain-inputs.yamlファイルと、oracle/wcportal:14.1.2.0イメージ名が参照される他のすべてのインスタンスで新しいタグ名を更新する必要があります。

Oracle WebCenter Portalドメインをデプロイするためのコード・リポジトリの設定

KubernetesでのOracle WebCenter Portalドメイン・デプロイメントでは、WebLogic Kubernetes Operatorインフラストラクチャを利用します。Oracle WebCenter Portalドメインをデプロイするには、次のようにデプロイメント・スクリプトを設定する必要があります:

ソース・コードを設定する作業ディレクトリを作成します。

mkdir $HOME/wcp_14.1.2.0 cd $HOME/wcp_14.1.2.0GithubリポジトリからOracle WebCenter Portal Kubernetesデプロイメント・スクリプトをダウンロードします。必要なアーティファクトは、

FMW-DockerImages/OracleWeCenterPortal/kubernetesにあります。git clone https://github.com/oracle/fmw-kubernetes.git export WORKDIR=$HOME/wcp_14.1.2.0/fmw-kubernetes/OracleWebCenterPortal/kubernetes/

このドキュメントで後述するように、<$WORKDIR>のデプロイメント・スクリプトを使用してWebCenter Portalドメインを設定できるようになりました。

ロールの付与および失効したリソースの消去

WebLogicカスタム・リソース定義がすでに存在するかどうかを確認するには、次のコマンドを実行します:

kubectl get crdサンプル出力:

NAME CREATED AT domains.weblogic.oracle 2020-03-14T12:10:21Z次のコマンドを実行して、WebLogicカスタム・リソース定義(見つかった場合)を削除します:

kubectl delete crd domains.weblogic.oracleサンプル出力:

customresourcedefinition.apiextensions.k8s.io "domains.weblogic.oracle" deleted

WebLogic Kubernetes Operatorのインストール

WebLogic Kubernetes Operatorは、Kubernetes環境でのOracle WebCenter Portalドメインのデプロイメントをサポートします。

このドキュメントのステップに従って、オペレータをインストールします。

オプションで、これらのステップに従って、オペレータのログの内容をElasticsearchに送信できます。

WebLogic Kubernetes Operatorをインストールする次のコマンド例では、opnsはネームスペースで、op-saはオペレータ用に作成されたサービス・アカウントです:

kubectl create namespace operator-ns

kubectl create serviceaccount -n operator-ns operator-sa

helm repo add weblogic-operator https://oracle.github.io/weblogic-kubernetes-operator/charts --force-update

helm install weblogic-kubernetes-operator weblogic-operator/weblogic-operator --version 4.2.9 --namespace operator-ns --set serviceAccount=operator-sa --set "javaLoggingLevel=FINE" --waitノート: この手順では、ネームスペースは

operator-nsと呼ばれていますが、任意の名前を使用できます。次の値を使用できます:

- ドメインUID/ドメイン名:wcp-domain

- ドメイン・ネームスペース:wcpns

- オペレータ・ネームスペース:operator-ns

- Traefikネームスペース:traefik

WebCenter Portalドメインの環境の準備

Oracle WebCenter Portalドメインのネームスペースの作成

デフォルト・ネームスペースを使用する場合を除き、ドメインのKubernetesネームスペース(wcpnsなど)を作成します。詳細は、ドメイン実行の準備を参照してください。

kubectl create namespace wcpnsサンプル出力:

namespace/wcpns createdこのネームスペースのドメインを管理するには、helmを使用してオペレータを構成します:

Helmはweblogic-operatorをアップグレードします

helm upgrade --reuse-values --set "domainNamespaces={wcpns}" \

--wait weblogic-kubernetes-operator charts/weblogic-operator --namespace operator-nsサンプル出力:

NAME: weblogic-kubernetes-operator

LAST DEPLOYED: Wed Jan 6 01:52:58 2021

NAMESPACE: operator-ns

STATUS: deployed

REVISION: 2ドメイン資格証明を使用したKubernetesシークレットの作成

ドメインと同じKubernetesネームスペースで、管理アカウントのKubernetesシークレットusernameおよびpasswordを作成します:

cd ${WORKDIR}/create-weblogic-domain-credentials

./create-weblogic-credentials.sh -u weblogic -p welcome1 -n wcpns -d wcp-domain -s wcp-domain-domain-credentialsサンプル出力:

secret/wcp-domain-domain-credentials created

secret/wcp-domain-domain-credentials labeled

The secret wcp-domain-domain-credentials has been successfully created in the wcpns namespace.説明:

- -u ユーザー名。指定する必要があります。

- -p パスワード。-p引数を使用して指定する必要があります。指定しないと、ユーザーは値の入力を求められます。

- -n ネームスペース。例: wcpns

- -d domainUID。例: wcp-domain

- -s secretName。例: wcp-domain-domain-credentials

ノート: 次のように資格証明を検査できます:

kubectl get secret wcp-domain-domain-credentials -o yaml -n wcpns詳細は、このドキュメントを参照してください。

RCU資格証明を使用したKubernetesシークレットの作成

ドメインと同じKubernetesネームスペースでcreate-rcu-credentials.shスクリプトを使用して、リポジトリ構成ユーティリティのKubernetesシークレット(ユーザー名とパスワード)を作成します:

cd ${WORKDIR}/create-rcu-credentials

sh create-rcu-credentials.sh \

-u username \

-p password \

-a sys_username \

-q sys_password \

-d domainUID \

-n namespace \

-s secretNameサンプル出力:

secret/wcp-domain-rcu-credentials created

secret/wcp-domain-rcu-credentials labeled

The secret wcp-domain-rcu-credentials has been successfully created in the wcpns namespace.このパラメータは次のとおりです。

-u username for schema owner (regular user), must be specified.

-p password for schema owner (regular user), must be provided using the -p argument or user will be prompted to enter a value.

-a username for SYSDBA user, must be specified.

-q password for SYSDBA user, must be provided using the -q argument or user will be prompted to enter a value.

-d domainUID, optional. The default value is wcp-domain. If specified, the secret will be labeled with the domainUID unless the given value is an empty string.

-n namespace, optional. Use the wcpns namespace if not specified.

-s secretName, optional. If not specified, the secret name will be determined based on the domainUID value.ノート: 次のように資格証明を検査できます:

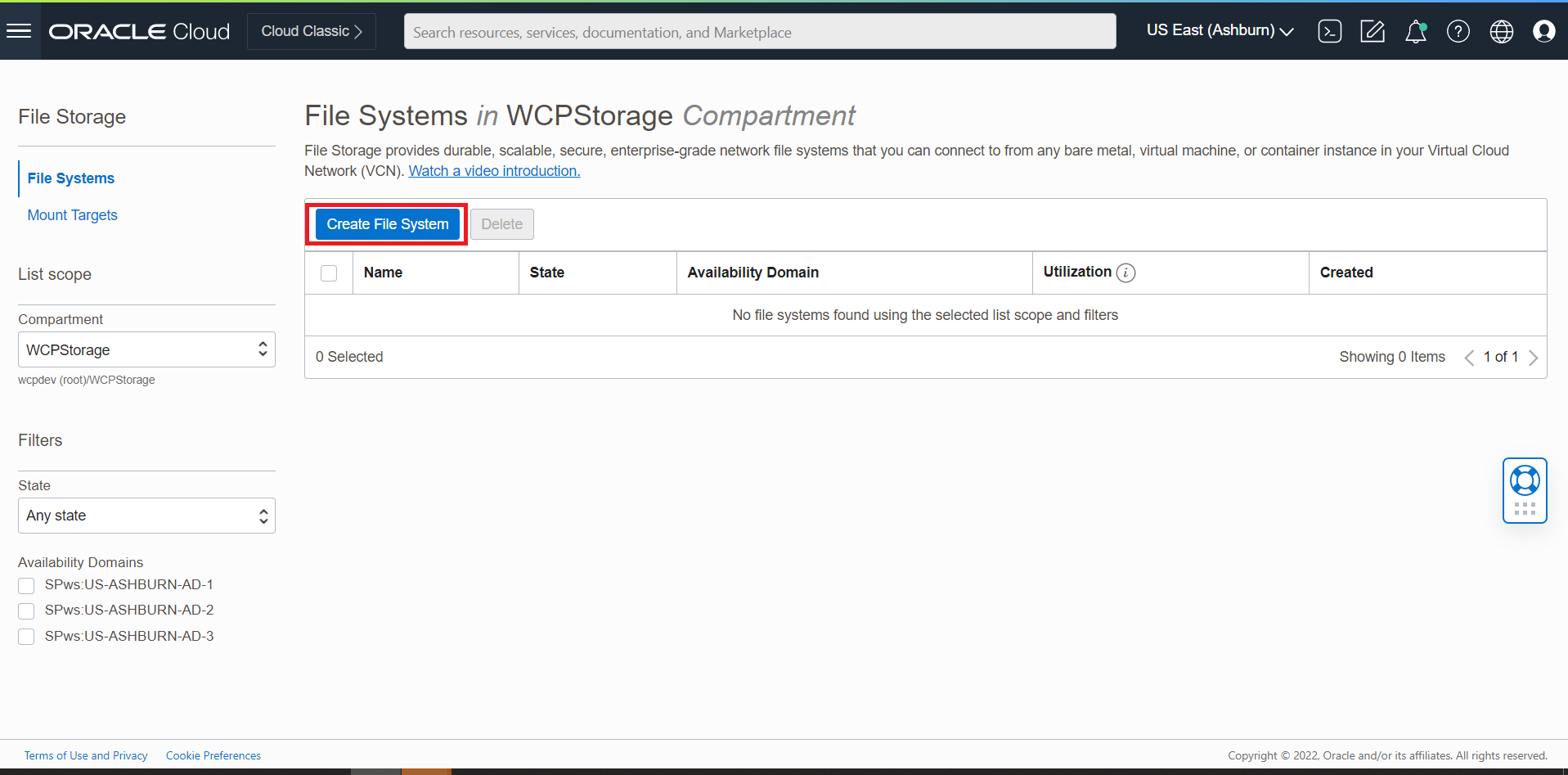

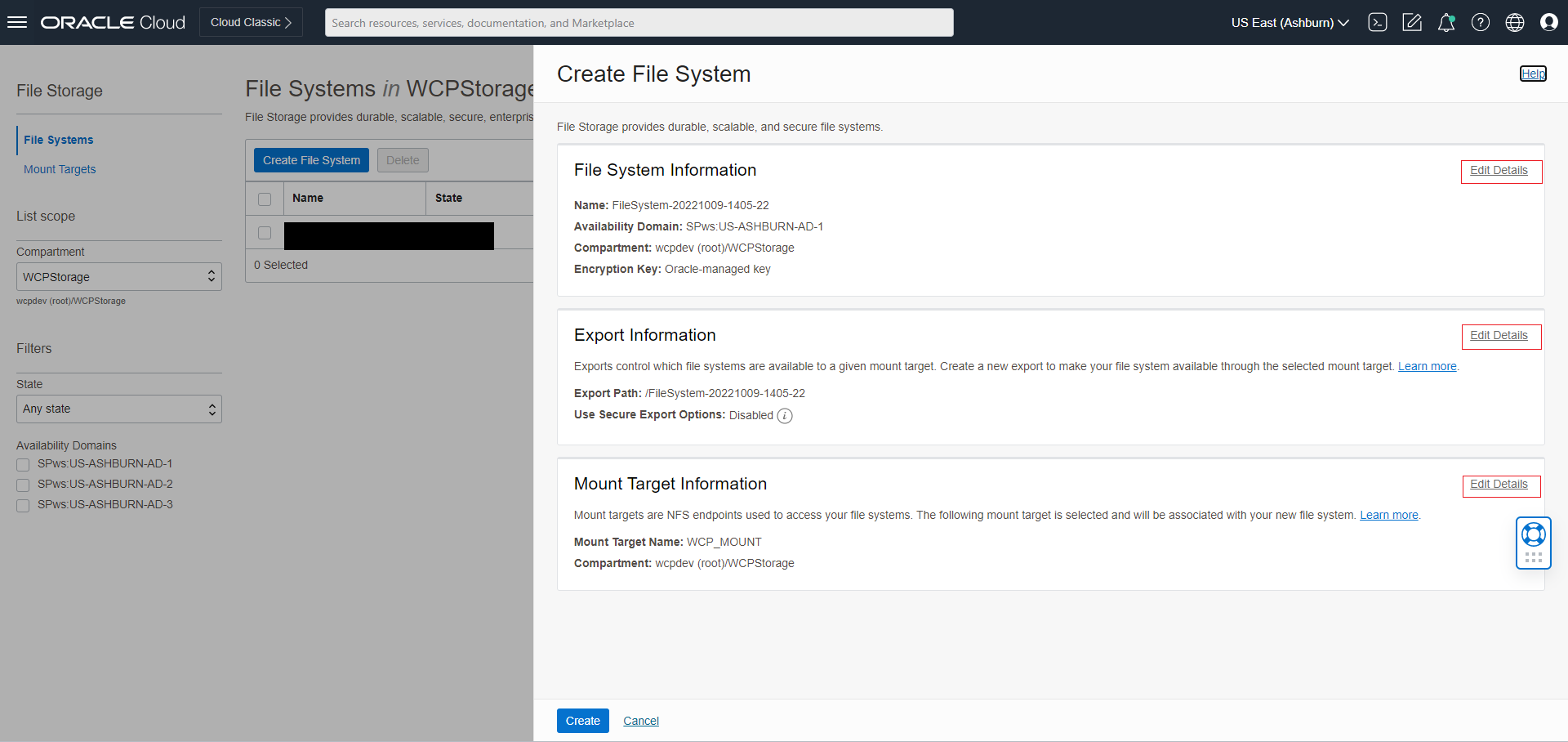

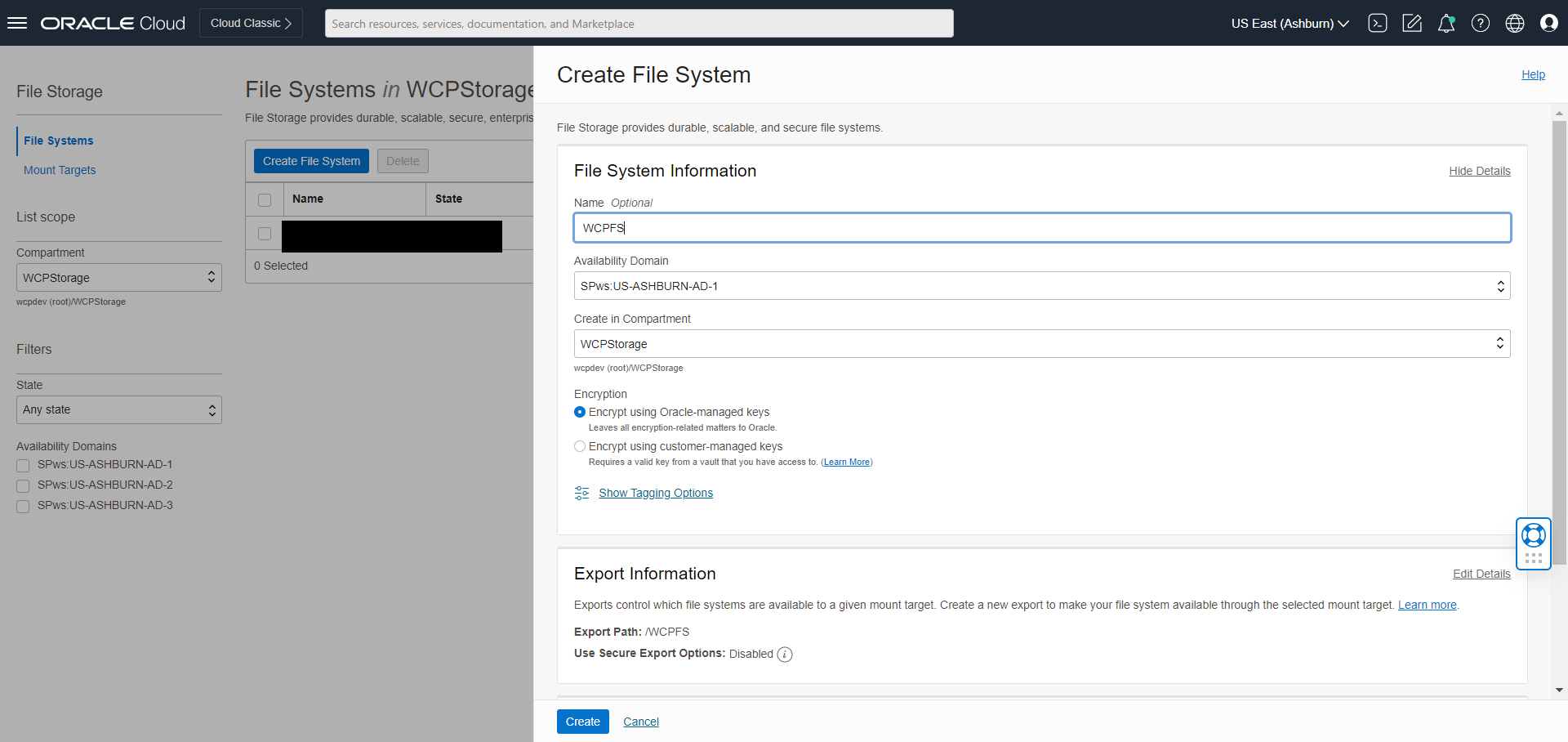

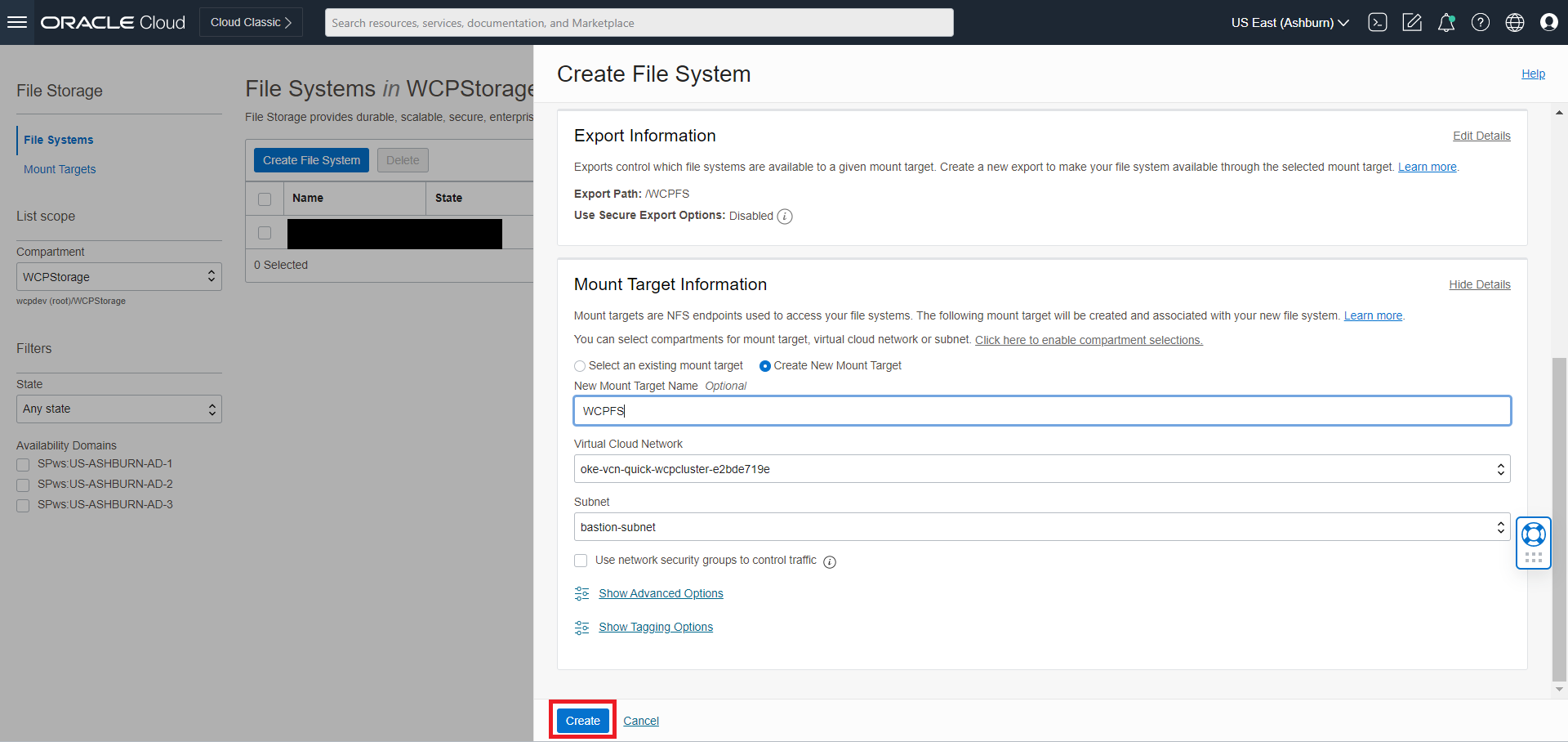

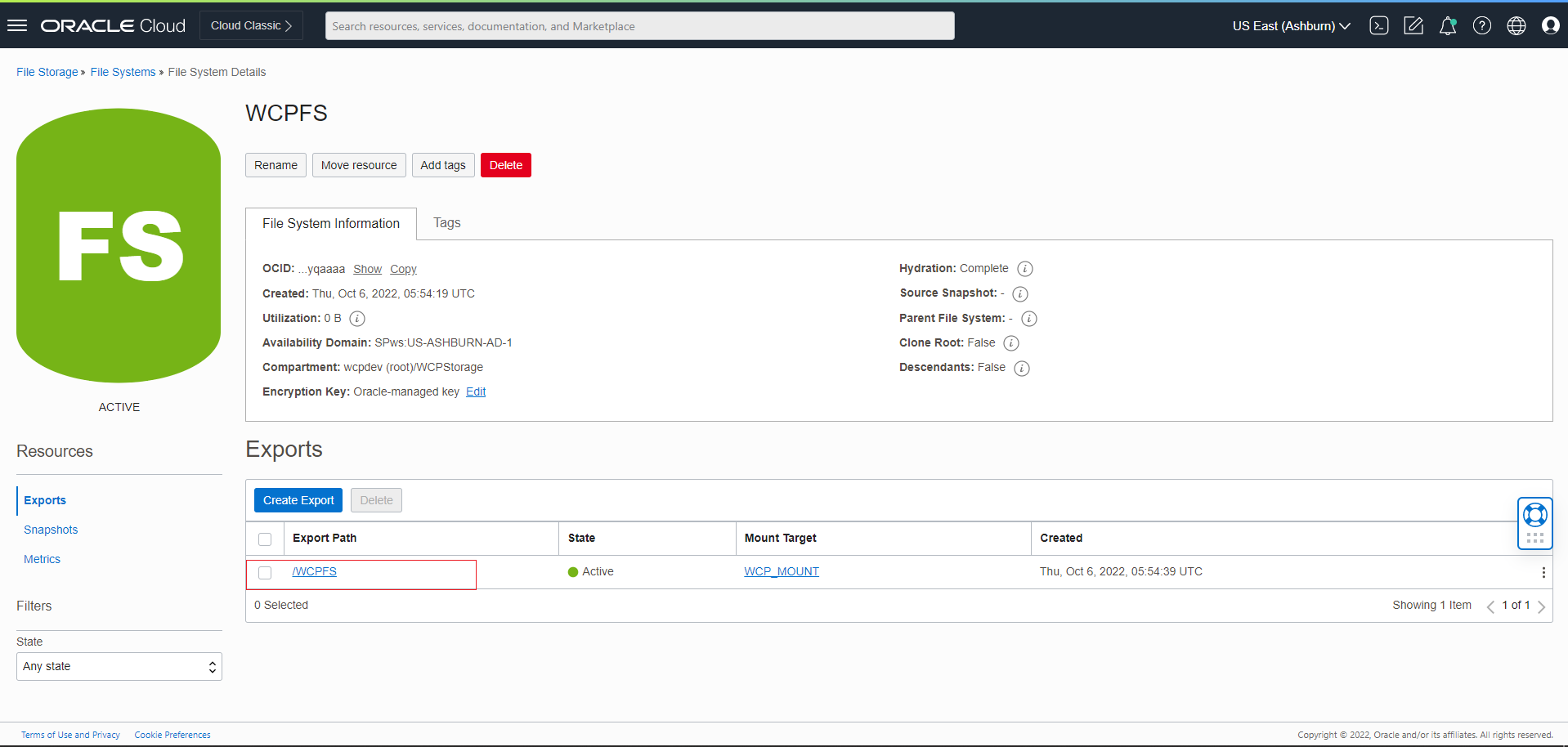

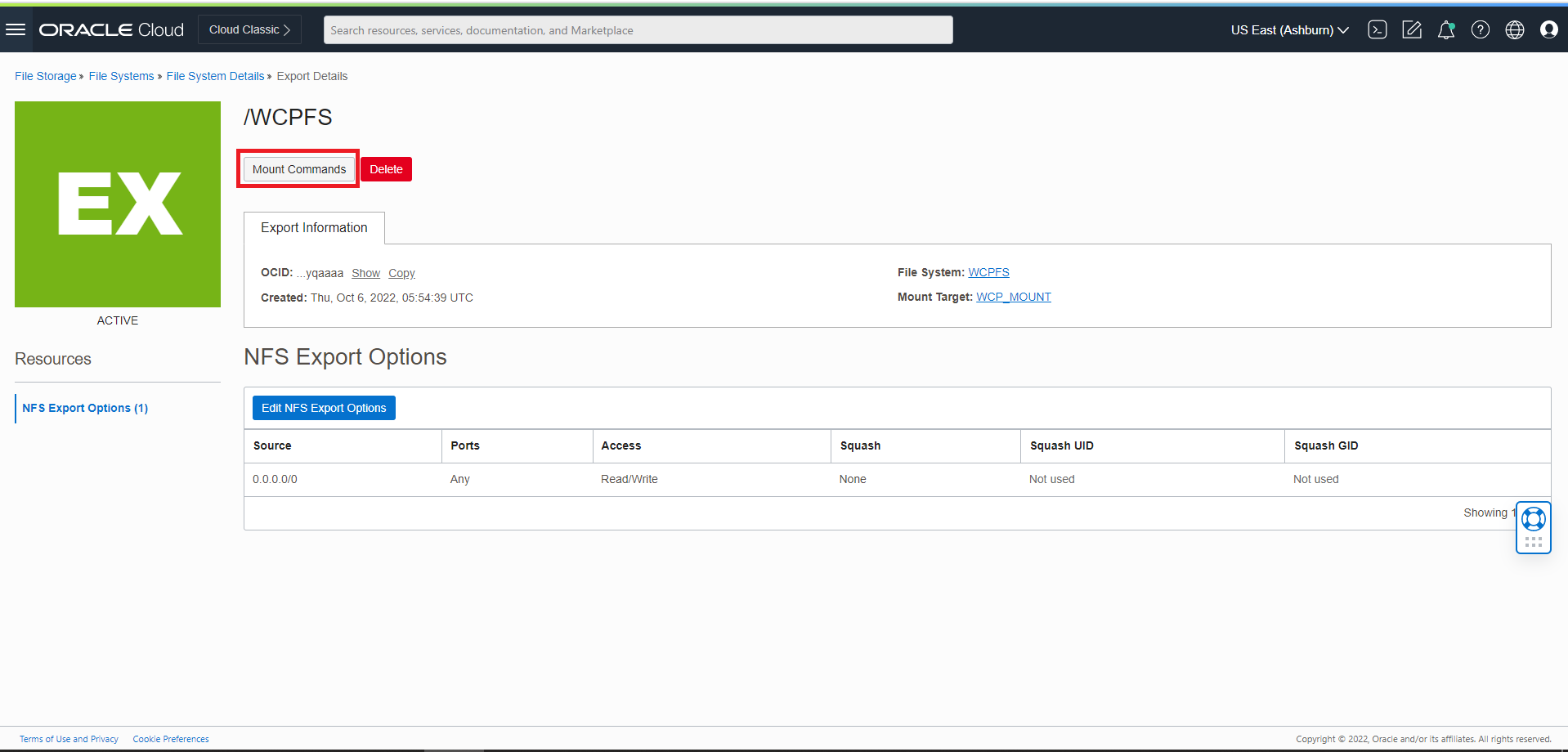

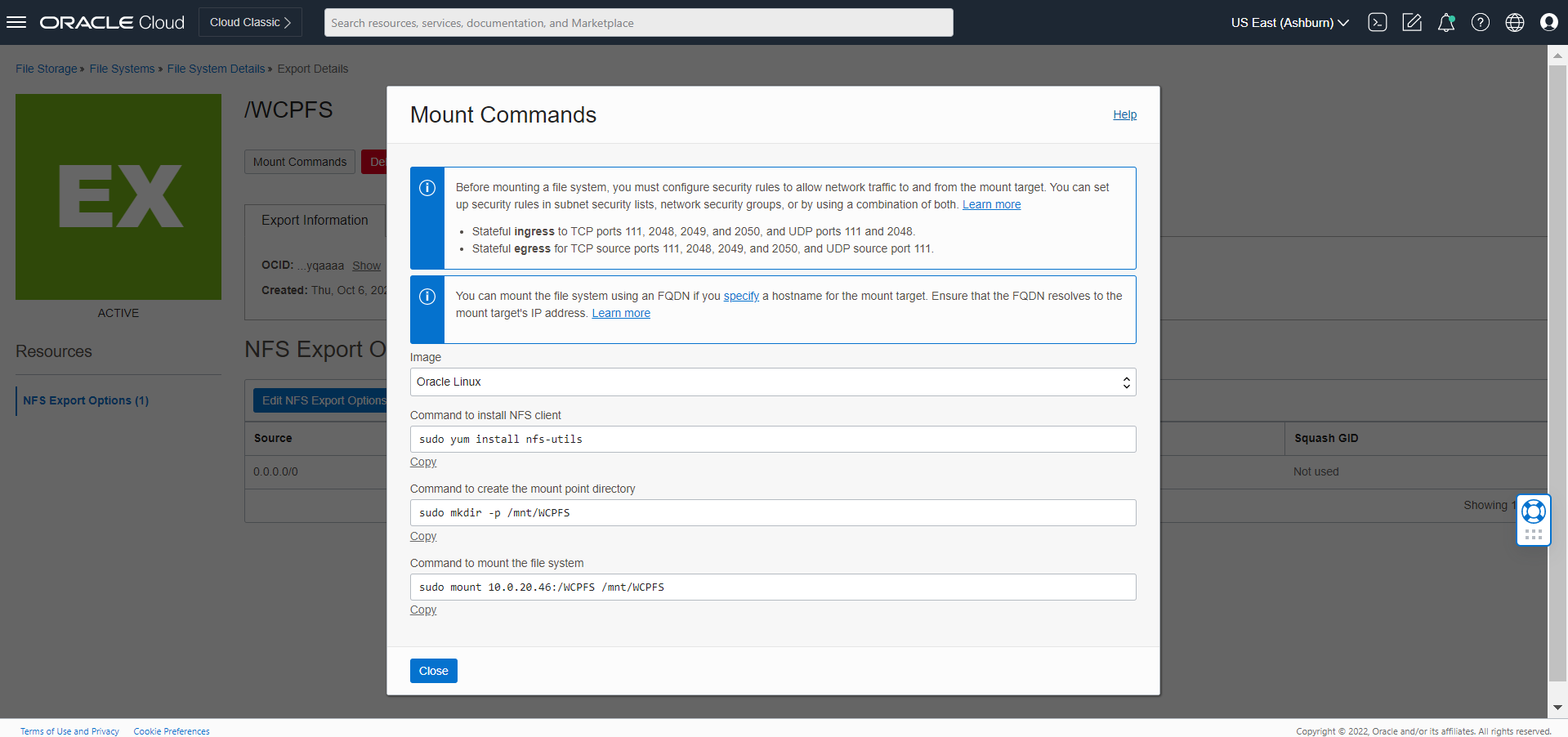

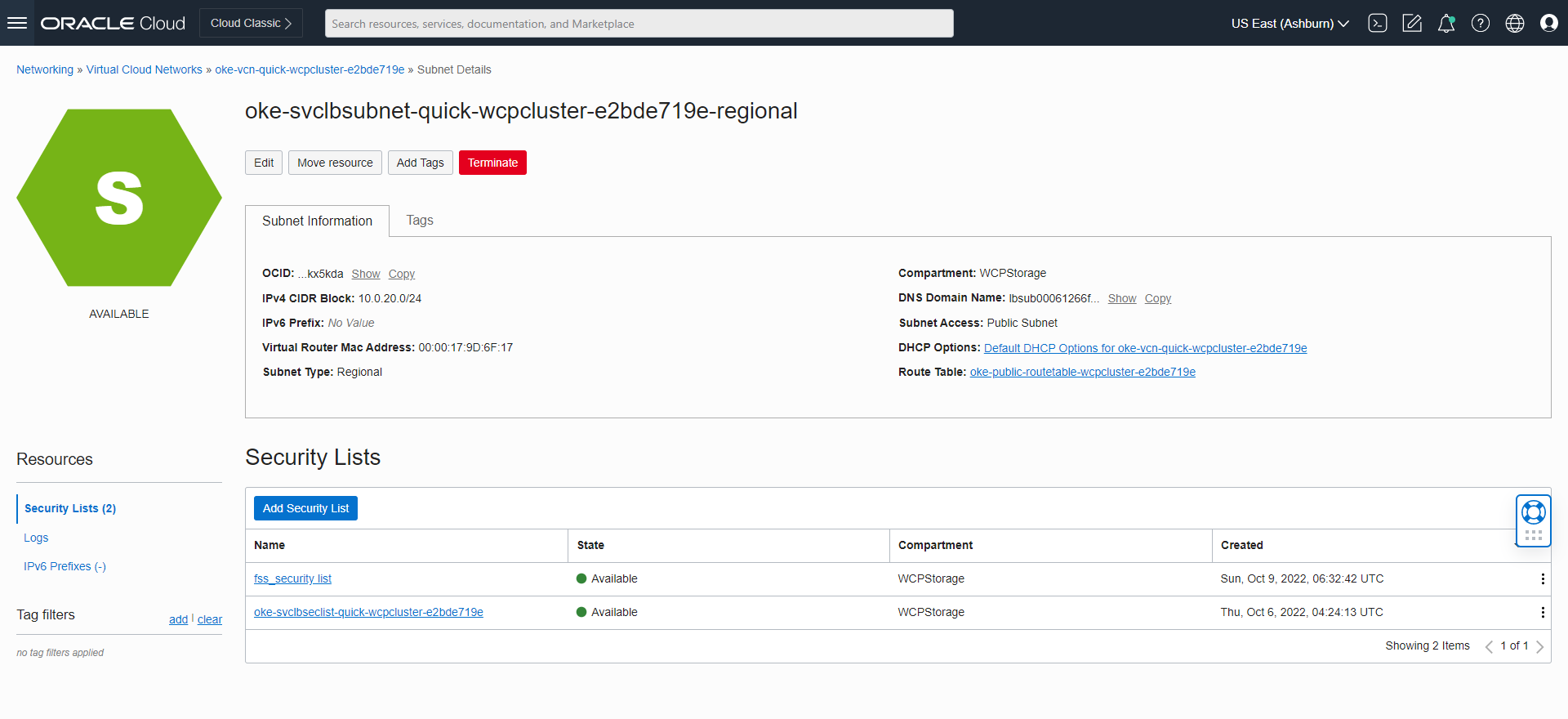

kubectl get secret wcp-domain-rcu-credentials -o yaml -n wcpnsOracle WebCenter Portalドメインの永続ストレージの作成

Kubernetes PVおよびPVC (永続ボリュームおよび永続ボリューム要求)を作成します:

作成したKubernetesネームスペースで、create-pv-pvc.shスクリプトを実行してドメインのPVおよびPVCを作成します。スクリプトを使用する手順に従って、Oracle WebCenter Portalドメイン専用のPVおよびPVCを作成します。

PV作成用の構成パラメータを確認します。要件に基づいて、

${WORKDIR}/create-weblogic-domain-pv-pvc/にあるcreate-pv-pvc-inputs.yamlファイルの値を更新します。Oracle WebCenter Portalドメインのサンプルの構成パラメータ値は、次のとおりです:baseName: domaindomainUID: wcp-domainnamespace: wcpnsweblogicDomainStorageType: HOST_PATHweblogicDomainStoragePath: /scratch/kubevolume

weblogicDomainStoragePathプロパティのパスが存在し(存在しない場合は作成)、その完全なアクセス権限があり、フォルダが空であることを確認します。create-pv-pvc.shスクリプトを実行します:cd ${WORKDIR}/create-weblogic-domain-pv-pvc ./create-pv-pvc.sh -i create-pv-pvc-inputs.yaml -o outputサンプル出力:

Input parameters being used export version="create-weblogic-sample-domain-pv-pvc-inputs-v1" export baseName="domain" export domainUID="wcp-domain" export namespace="wcpns" export weblogicDomainStorageType="HOST_PATH" export weblogicDomainStoragePath="/scratch/kubevolume" export weblogicDomainStorageReclaimPolicy="Retain" export weblogicDomainStorageSize="10Gi" Generating output/pv-pvcs/wcp-domain-domain-pv.yaml Generating output/pv-pvcs/wcp-domain-domain-pvc.yaml The following files were generated: output/pv-pvcs/wcp-domain-domain-pv.yaml output/pv-pvcs/wcp-domain-domain-pvc.yamlcreate-pv-pvc.shスクリプトは、指定された/path/to/output-directoryディレクトリの下にサブディレクトリpv-pvcsを作成し、PVおよびPVC用の2つのYAML構成ファイルを作成します。kubectl create -fコマンドを使用して、次の2つのYAMLファイルを適用し、PVおよびPVC Kubernetesリソースを作成します:kubectl create -f output/pv-pvcs/wcp-domain-domain-pv.yaml kubectl create -f output/pv-pvcs/wcp-domain-domain-pvc.yaml

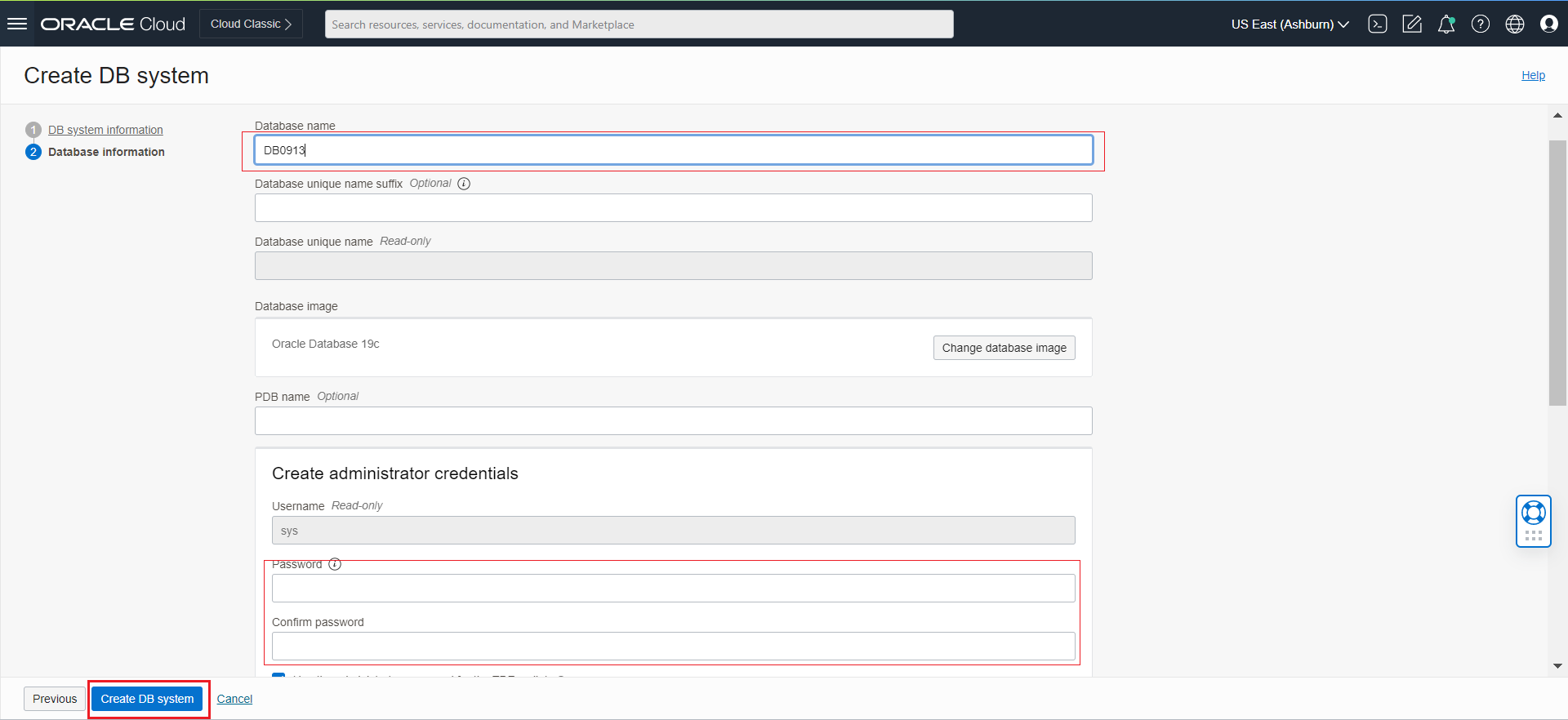

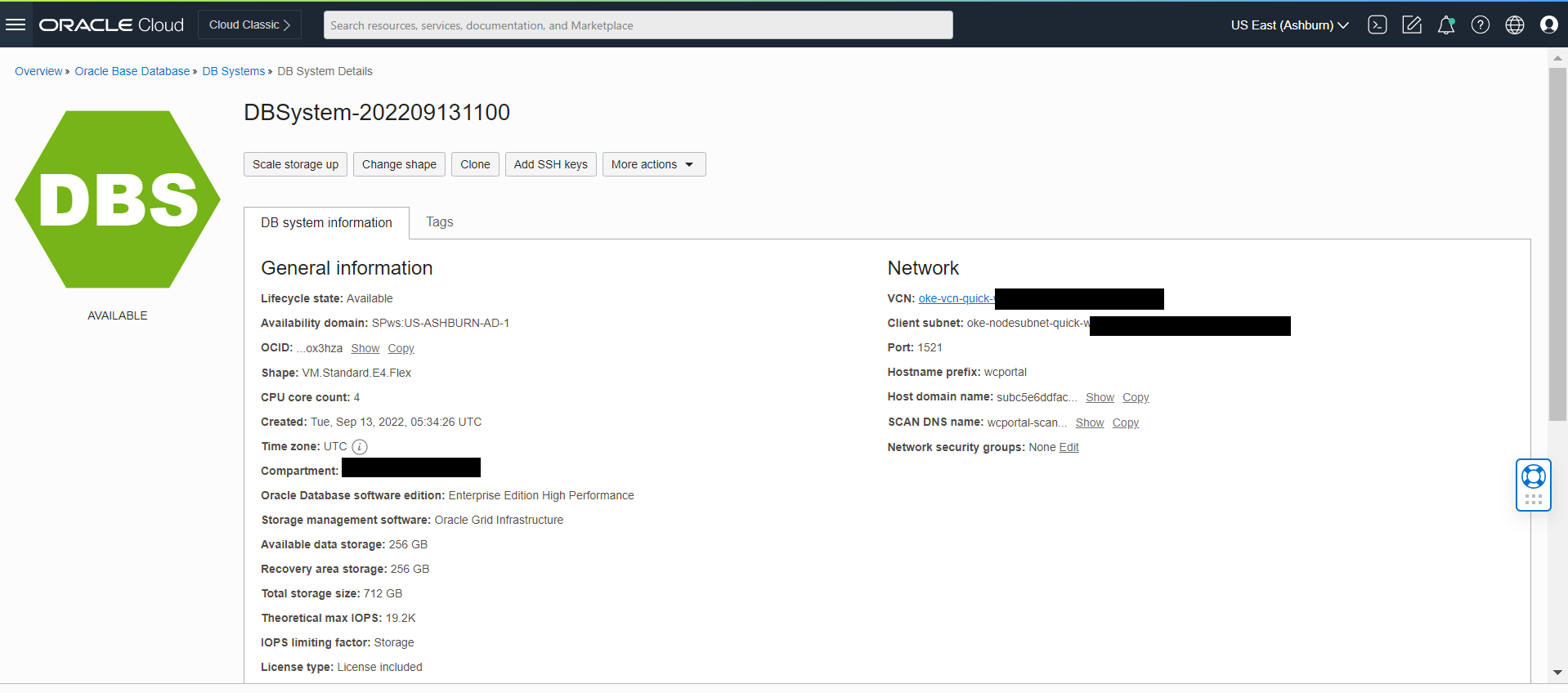

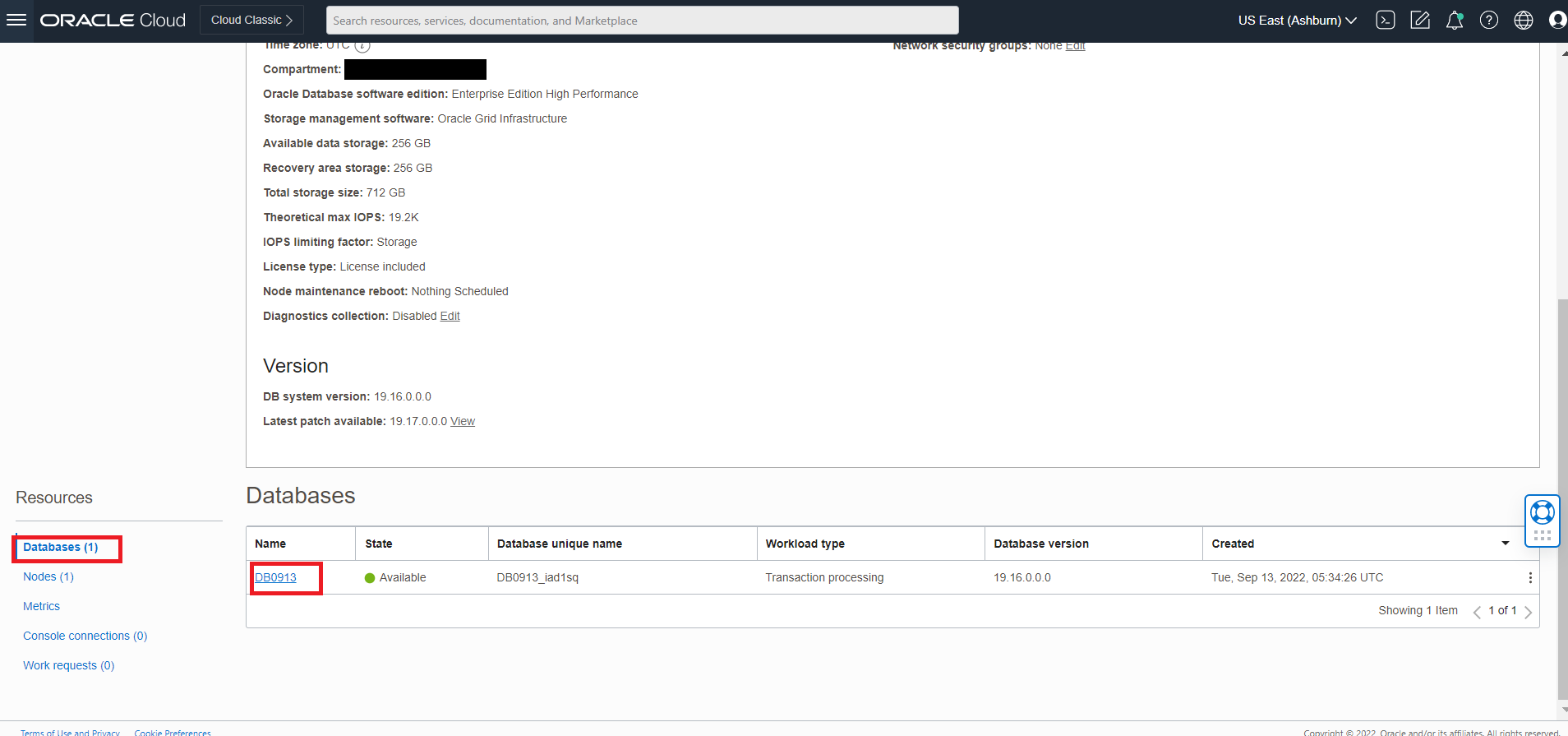

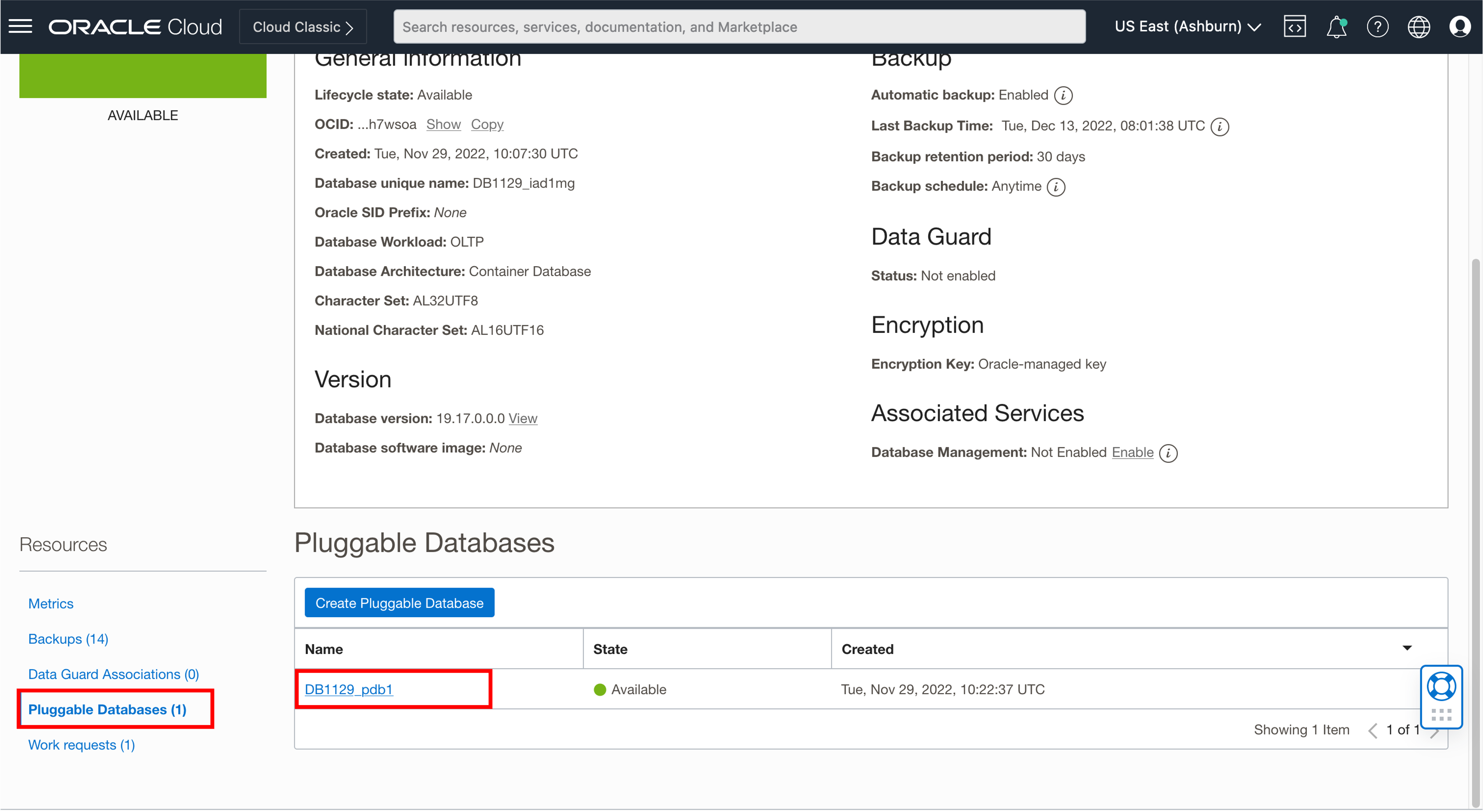

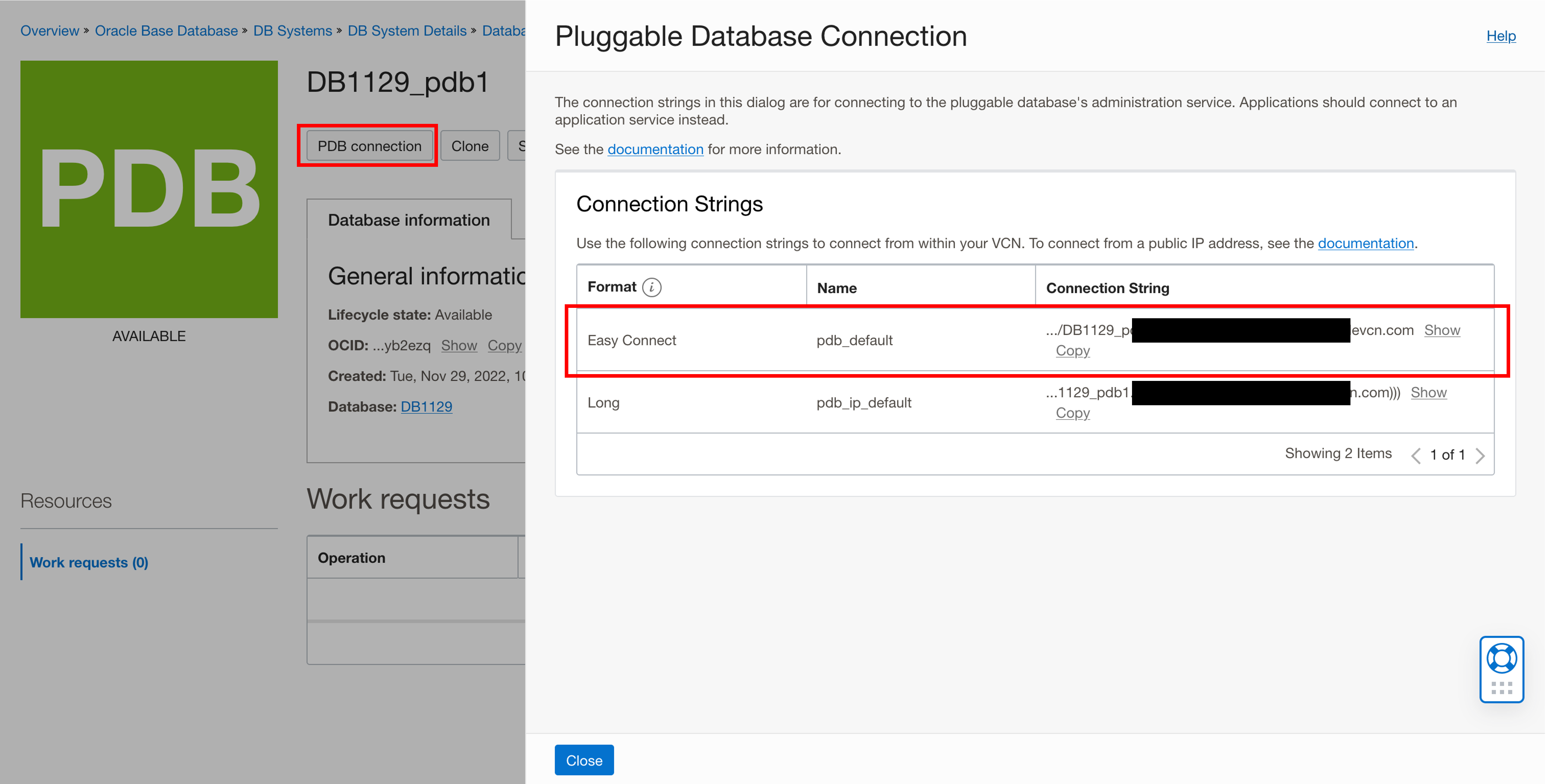

データベース・アクセスの構成

Oracle WebCenter Portalドメインには、特定のスキーマで構成されたデータベースが必要です。このスキーマは、リポジトリ作成ユーティリティ(RCU)を使用して作成できます。ドメインを作成する前にデータベースを設定することが不可欠です。

本番環境では、Kubernetesの外部で実行されているスタンドアロン(非コンテナ化)データベースを使用することをお薦めします。

ドメインの作成に進む前に、必要なスキーマがデータベースに設定されていることを確認してください。

リポジトリ作成ユーティリティの実行によるデータベース・スキーマの設定

Oracle WebCenter Portalドメインのデータベース・スキーマを作成するには、create-rcu-schema.shスクリプトを実行します。

cd ${WORKDIR}/create-rcu-schema

./create-rcu-schema.sh \

-s WCP1 \

-t wcp \

-d xxx.oraclevcn.com:1521/DB1129_pdb1.xxx.wcpcluster.oraclevcn.com \

-i iad.ocir.io/xxxxxxxx/oracle/wcportal:14.1.2.0 \

-n wcpns \

-c wcp-domain-rcu-credentials \

-r ANALYTICS_WITH_PARTITIONING=N使用方法:

./create-rcu-schema.sh -s <schemaPrefix> [-t <schemaType>] [-d <dburl>] [-n <namespace>] [-c <credentialsSecretName>] [-p <docker-store>] [-i <image>] [-u <imagePullPolicy>] [-o <rcuOutputDir>] [-r <customVariables>] [-l <timeoutLimit>] [-e <edition>] [-h]

-s RCU Schema Prefix (required)

-t RCU Schema Type (optional)

(supported values: wcp,wcpp)

-d RCU Oracle Database URL (optional)

(default: oracle-db.default.svc.cluster.local:1521/devpdb.k8s)

-n Namespace for RCU pod (optional)

(default: default)

-c Name of credentials secret (optional).

(default: oracle-rcu-secret)

Must contain SYSDBA username at key 'sys_username',

SYSDBA password at key 'sys_password',

and RCU schema owner password at key 'password'.

-p OracleWebCenterPortal ImagePullSecret (optional)

(default: none)

-i OracleWebCenterPortal Image (optional)

(default: oracle/wcportal:release-version)

-u OracleWebCenterPortal ImagePullPolicy (optional)

(default: IfNotPresent)

-o Output directory for the generated YAML file. (optional)

(default: rcuoutput)

-r Comma-separated custom variables in the format variablename=value. (optional).

(default: none)

-l Timeout limit in seconds. (optional).

(default: 300)

-e The edition name. This parameter is only valid if you specify databaseType=EBR. (optional).

(default: 'ORA$BASE')

-h Help

Note: The c, p, i, u, and o arguments are ignored if an rcu pod is already running in the namespace.ノート:

- RCUスキーマ・タイプ

wcpはWebCenter Portal関連のスキーマを生成し、wcppはWebCenter Portalとポートレットのスキーマを生成します。- Oracle WebCenter Portalでのアナリティクス・インストール用のデータベース・パーティション化を有効または無効にするには、-rフラグを使用します。データベース・パーティション化を有効にするにはYを、無効にするにはNを入力します。例: -r ANALYTICS_WITH_PARTITIONING=N。ANALYTICS_WITH_PARTITIONINGでサポートされている値は、YおよびNです。

WebCenter Portalドメインの作成

既存のPVまたはPVCにOracle WebCenter Portalドメイン・ホームを作成し、生成されたOracle WebCenter Portalドメインをデプロイするためのドメイン・リソースYAMLファイルを作成します。

- 概要

- 前提条件

- WebCenter Portalドメイン作成の入力ファイルの準備

- WebCenter Portalドメインの作成

- WebCenter Portalドメインの初期化

- WebCenter Portalドメインの検証

- WebCenter Portalの管理

概要

サンプル・スクリプトを使用して、既存のKubernetes永続ボリューム(PV)および永続ボリューム要求(PVC)にWebCenter Portalドメイン・ホームを作成できます。このスクリプトは、対応するドメインのKubernetesアーティファクトを起動するのに役立つドメインYAMLファイルも生成します。

前提条件

- 「環境の準備」のすべてのステップが完了していることを確認します。

- データベースおよびWebLogic Kubernetes Operatorが稼働していることを確認します。

WebCenter Portalドメイン作成の入力ファイルの準備

必要に応じて、create-domain-inputs.yamlファイルでドメインの作成に使用するパラメータをカスタマイズできます。

WebCenter Portalドメイン・デプロイメントのサンプル・スクリプトは、以前にダウンロードしたリポジトリ(${WORKDIR}/create-wcp-domain/domain-home-on-pv/)から入手できます。

デフォルト値を更新する前に、create-domain-inputs.yamlファイルのコピーを作成します。

スクリプトによって作成されたデフォルト・ドメインには、次の特性があります:

- ポート

7001でリスニングするAdminServerという管理サーバー。 - サイズが

5のwcp-clusterという構成済クラスタ。 - ポート

8888でリスニングするwcpserverという管理対象サーバー。 configurePortletServerがtrueに設定されている場合、サイズが5のwcportlet-clusterというクラスタと、ポート8889でリスニングするwcportletserverという管理対象サーバーが構成されます。/shared/logs/<domainUID>にあるログ・ファイル。

構成パラメータ

入力ファイルには、次のパラメータを指定できます:

| パラメータ | 定義 | デフォルト |

|---|---|---|

sslEnabled |

SSLモード有効化フラグ | false |

configurePortletServer |

ポートレット・サーバー・クラスタを構成します | false |

adminPort |

Kubernetesクラスタ内の管理サーバーのポート番号。 | 7001 |

adminServerSSLPort |

Kubernetesクラスタ内の管理サーバーのSSLポート番号。 | 7002 |

adminAdministrationPort |

Kubernetesクラスタ内の管理サーバーの管理ポート番号。 | 9002 |

adminServerName |

管理サーバーの名前。 | AdminServer |

domainUID |

この特定のドメインを識別する一意のID。生成されたWebLogicドメインの名前およびKubernetesドメイン・リソースの名前として使用されます。このIDは、Kubernetesクラスタ内のすべてのドメインで一意である必要があります。このIDには、Kubernetesサービス名で有効ではない文字を含めることはできません。 | wcp-domain |

domainHome |

WebCenter Portalドメインのホーム・ディレクトリ。ノート: このフィールドは変更できません。 | /u01/oracle/user_projects/domains/wcp-domain |

serverStartPolicy |

WebLogic Kubernetes Operatorによって起動されるWebLogic Serverインスタンスを決定します。有効な値: Never、IfNeeded、AdminOnly。Neverは、サーバーを起動しないことを意味し、IfNeededは、必要に応じて管理サーバーと管理対象サーバーの両方を起動します。AdminOnlyは、管理サーバーのみを起動します。 |

IfNeeded |

clusterName |

ドメイン用に生成するWebLogicクラスタ・インスタンスの名前。デフォルトでは、WebCenter Portalドメイン用のクラスタ名はwcp-clusterです。 |

wcp-cluster |

configuredManagedServerCount |

ドメインの管理対象サーバー・インスタンスの数。 | 5 |

initialManagedServerReplicas |

ドメインで最初に起動する管理対象サーバーの数。 | 2 |

managedServerNameBase |

管理対象サーバー名の生成に使用されるベース文字列。 | wcpserver |

managedServerPort |

各管理対象サーバーのポート番号。デフォルトでは、wcpserverのmanagedServerPortは8888で、wcportletserverのmanagedServerPortは8889です。 |

8888 |

managedServerSSLPort |

各管理対象サーバーのSSLポート番号。デフォルトでは、wcpserverのmanagedServerPortは8788で、wcportletserverのmanagedServerPortは8789です。 |

8788 |

managedAdministrationPort |

各管理対象サーバーの管理ポート番号。このポートは、管理対象サーバーとの管理通信に使用されます。 | 9008 |

portletClusterName |

ドメイン用に生成するポートレット・クラスタ・インスタンスの名前。デフォルトでは、ポートレットのクラスタ名はwcportlet-clusterです。 |

wcportlet-cluster |

portletServerNameBase |

ポートレット・サーバー名の生成に使用されるベース文字列。 | wcportletserver |

portletServerPort |

各ポートレット・サーバーのポート番号。デフォルトでは、wcportletserverのportletServerPortは8889です。 |

8889 |

portletServerSSLPort |

各ポートレット・サーバーのSSLポート番号。デフォルトでは、wcportletserverのportletServerSSLPortは8789です。 |

8789 |

portletAdministrationPort |

各ポートレット・サーバーの管理ポート番号。このポートは、ポートレット・サーバーとの管理通信に使用されます。 | 9009 |

image |

WebCenter Portal Dockerイメージ。WebLogic Kubernetes Operatorには、WebCenter Portalリリース14.1.2.0が必要です。イメージを取得または作成する方法の詳細は、WebCenter Portal Dockerイメージを参照してください。 | oracle/wcportal:14.1.2.0 |

imagePullPolicy |

WebLogic Dockerイメージがリポジトリからプルされる場合を定義します。有効な値: IfNotPresent (デフォルト。イメージがノードに存在しない場合のみプルします)、Always (すべてのデプロイメントでイメージをプルします)、およびNever (イメージをプルしません。イメージはローカルで使用可能である必要があります)。 |

IfNotPresent |

productionModeEnabled |

ドメインが本番モードで実行されているかどうかを示すブール・フラグ。本番モードでは、WebLogic Serverはより厳密なセキュリティおよびリソース管理設定を適用します。 | true |

secureEnabled |

ドメインでセキュア・モードが有効かどうかを示すブール。trueに設定すると、WebLogicはSSL構成などの追加のセキュリティ設定を有効にし、より厳密な認証および暗号化プロトコルを適用します。これは、セキュリティがクリティカルな本番環境に適切です。これは、WebLogicを本番モード(productionModeEnabledがtrue)で実行する場合に重要です。falseに設定すると、ドメインはこれらの追加のセキュリティ対策なしで動作します。 |

false |

weblogicCredentialsSecretName |

管理サーバーのユーザー名とパスワードのKubernetesシークレットの名前。指定しない場合、値はdomainUIDから<domainUID>-weblogic-credentialsとして導出されます。 |

wcp-domain-domain-credentials |

includeServerOutInPodLog |

ポッドのstdoutストリームにserver.outログを含めるかどうかを示すブール。trueに設定すると、WebLogic Serverの標準出力がポッドのログ出力にリダイレクトされ、Kubernetesログ管理ツールを介してログに簡単にアクセスできるようになります。 |

true |

logHome |

ドメイン・ログ、サーバー・ログ、サーバー出力およびノード・マネージャ・ログ・ファイルのポッド内の場所。ノート: このフィールドは変更できません。 | /u01/oracle/user_projects/logs/wcp-domain |

httpAccessLogInLogHome |

HTTPアクセス・ログ・ファイルが書き込まれる場所を示すブール。trueに設定すると、ログはlogHomeディレクトリに書き込まれ、falseに設定すると、WebLogic domain homeディレクトリに書き込まれます。 |

true |

t3ChannelPort |

NetworkAccessPointのT3チャネルのポート。 | 30012 |

exposeAdminT3Channel |

管理サーバーのT3チャネルをサービスとして公開するかどうかを示すブール。falseに設定すると、T3チャネルはクラスタの内部に残ります。 |

false |

adminNodePort |

Kubernetesクラスタ外部の管理サーバーのポート番号。これにより、WebLogic管理サーバーへの外部アクセスが可能になります。 | 30701 |

exposeAdminNodePort |

管理サーバーがKubernetesクラスタの外部に公開されているかどうかを示すブール。 | false |

namespace |

WebLogicドメインを作成するKubernetesネームスペースで、リソースを分離し、クラスタ内での管理を容易にします。 | wcpns |

javaOptions |

管理サーバーおよび管理対象サーバーを起動するためのJavaオプション。Javaオプションには、WebLogicドメイン情報を取得するための事前定義された次の1つ以上の変数への参照を含めることができます: $(DOMAIN_NAME)、$(DOMAIN_HOME)、$(ADMIN_NAME)、$(ADMIN_PORT)および$(SERVER_NAME)。 |

-Dweblogic.StdoutDebugEnabled=false |

persistentVolumeClaimName |

ドメイン・ホームをホストするために作成された永続ボリューム要求の名前。指定しない場合、値はdomainUIDから<domainUID>-weblogic-sample-pvcとして導出されます。 |

wcp-domain-domain-pvc |

domainPVMountPath |

ドメイン永続ボリュームのマウント・パス。ノート: このフィールドは変更できません。 | /u01/oracle/user_projects/domains |

createDomainScriptsMountPath |

ドメイン作成スクリプトがポッド内にあるマウント・パス。create-domain.shスクリプトは、ドメイン・ホームを作成するKubernetesポッドでスクリプト(createDomainScriptNameプロパティで指定)を実行するKubernetesジョブを作成します。createDomainFilesDirディレクトリ内のファイルはポッドのこの場所にマウントされるため、Kubernetesポッドはスクリプトおよびサポート・ファイルを使用してドメイン・ホームを作成できます。 |

/u01/weblogic |

createDomainScriptName |

ドメイン作成スクリプトがWebLogicドメインの作成に使用するスクリプト。create-domain.shスクリプトは、ドメイン・ホームを作成するこのスクリプトを実行するKubernetesジョブを作成します。このスクリプトは、createDomainScriptsMountPathプロパティで指定されたポッド内のディレクトリにあります。組込みスクリプトを使用するかわりに、ドメイン・ホームを作成するための独自のスクリプトを指定する必要がある場合は、このプロパティを使用して、ドメイン作成ジョブで実行するスクリプトの名前を設定する必要があります。 |

create-domain-job.sh |

createDomainFilesDir |

createDomainScriptNameプロパティで指定されたスクリプトを含め、WebLogicドメインの作成に必要なすべてのファイルを検索するホスト・マシン上のディレクトリ。デフォルトでは、このディレクトリは相対パスwlstに設定され、作成スクリプトは、wlstディレクトリの組込みWLSTオフライン・スクリプトを使用してWebLogicドメインを作成します。絶対パスも、ファイル・システム内の任意のディレクトリを指すようにサポートされています。組込みスクリプトは、ファイルが指定されたディレクトリにあるかぎり、ユーザーが指定したスクリプトまたはモデル・ファイルに置き換えることができます。このディレクトリ内のファイルは、Kubernetes構成マップに配置され、さらにcreateDomainScriptsMountPathにマウントされます。これにより、Kubernetesポッドがスクリプトおよびサポート・ファイルを使用してドメイン・ホームを作成できるようになります。 |

wlst |

rcuSchemaPrefix |

データベースで使用するスキーマ接頭辞(WCP1など)。RCUスキーマとの一致ドメインを簡略化するために、これをdomainUIDと同じにできます。 |

WCP1 |

rcuDatabaseURL |

データベースURL。 | dbhostname:dbport/servicename |

rcuCredentialsSecret |

データベース資格証明を含むKubernetesシークレット。 | wcp-domain-rcu-credentials |

loadBalancerHostName |

K8S環境の外部でアクセス可能な最終URLのホスト名。 | abc.def.com |

loadBalancerPortNumber |

K8S環境の外部でアクセス可能な最終URLのポート。 | 30305 |

loadBalancerProtocol |

K8S環境の外部でアクセス可能な最終URLのプロトコル。 | http |

loadBalancerType |

ロード・バランサ名。例: Traefikまたは"" | traefik |

unicastPort |

アプリケーションが使用するユニキャスト・ポートの開始範囲。 | 50000 |

生成されたYAMLファイル内のKubernetesリソースの名前は、create-domain-inputs.yamlファイルで指定されたプロパティ(adminServerName、clusterNameおよびmanagedServerNameBase)の値を使用して構成できます。Kubernetesサービス名で無効な文字は、生成されたYAMLファイルで有効な値に変換されます。たとえば、大文字は小文字に変換され、アンダースコア(_)はハイフン(-)に変換されます。

サンプルでは、1つのクラスタのみを持つドメインに対して、WebCenter Portalドメイン・ホームおよび関連するKubernetesリソースを作成する方法を示します。また、このサンプルでは、他のユース・ケース用にドメイン・ホームを作成するためのユーザー独自のスクリプトを提供する機能も示します。他のユース・ケースを含めるように、生成されたドメインYAMLファイルを変更できます。

WebCenter Portalドメインの作成

入力ファイルと、生成されたアーティファクトを格納する出力ディレクトリを指定して、ドメイン作成スクリプトを実行します:

./create-domain.sh \

-i create-domain-inputs.yaml \

-o /<path to output-directory>このスクリプトは、次のステップを実行します:

このドメイン用に生成されたKubernetes YAMLファイルのディレクトリを作成します(まだ存在しない場合)。パス名は

<path to output-directory>/weblogic-domains/<domainUID>です。ディレクトリがすでに存在する場合は、このスクリプトを使用する前にその内容を削除する必要があります。ユーティリティOracle WebCenter Portalコンテナを起動するKubernetesジョブを作成し、オフラインWLSTスクリプトを実行して共有ストレージにドメインを作成します。

ジョブを実行して、終了するまで待機します。

KubernetesドメインYAMLファイル

domain.yamlを、前に作成した出力ディレクトリ内に作成します。このYAMLファイルを使用すると、

kubectl create -fまたはkubectl apply -fコマンドを使用してKubernetesリソースを作成できます:kubectl apply -f ../<path to output-directory>/weblogic-domains/<domainUID>/domain.yaml便利なユーティリティ・スクリプト

delete-domain-job.yamlを作成して、作成スクリプトによって作成されたドメイン・ホームをクリーンアップします。

create-domain.shサンプル・スクリプトを実行し、次のようにcreate-domain-inputs.yaml入力ファイルおよび出力ディレクトリを指すようにします:cd ${WORKDIR}/create-wcp-domain/ sh create-domain.sh -i create-domain-inputs.yaml -o outputサンプル出力:

Input parameters being used export version="create-weblogic-sample-domain-inputs-v1" export sslEnabled="false" export adminPort="7001" export adminServerSSLPort="7002" export adminServerName="AdminServer" export domainUID="wcp-domain" export domainHome="/u01/oracle/user_projects/domains/$domainUID" export serverStartPolicy="IF_NEEDED" export clusterName="wcp-cluster" export configuredManagedServerCount="5" export initialManagedServerReplicas="2" export managedServerNameBase="wcpserver" export managedServerPort="8888" export managedServerSSLPort="8788" export portletServerPort="8889" export portletServerSSLPort="8789" export image="oracle/wcportal:14.1.2.0" export imagePullPolicy="IfNotPresent" export productionModeEnabled="true" export weblogicCredentialsSecretName="wcp-domain-domain-credentials" export includeServerOutInPodLog="true" export logHome="/u01/oracle/user_projects/domains/logs/$domainUID" export httpAccessLogInLogHome="true" export t3ChannelPort="30012" export exposeAdminT3Channel="false" export adminNodePort="30701" export exposeAdminNodePort="false" export namespace="wcpns" javaOptions=-Dweblogic.StdoutDebugEnabled=false export persistentVolumeClaimName="wcp-domain-domain-pvc" export domainPVMountPath="/u01/oracle/user_projects/domains" export createDomainScriptsMountPath="/u01/weblogic" export createDomainScriptName="create-domain-job.sh" export createDomainFilesDir="wlst" export rcuSchemaPrefix="WCP1" export rcuDatabaseURL="oracle-db.wcpns.svc.cluster.local:1521/devpdb.k8s" export rcuCredentialsSecret="wcp-domain-rcu-credentials" export loadBalancerHostName="abc.def.com" export loadBalancerPortNumber="30305" export loadBalancerProtocol="http" export loadBalancerType="traefik" export unicastPort="50000" Generating output/weblogic-domains/wcp-domain/create-domain-job.yaml Generating output/weblogic-domains/wcp-domain/delete-domain-job.yaml Generating output/weblogic-domains/wcp-domain/domain.yaml Checking to see if the secret wcp-domain-domain-credentials exists in namespace wcpns configmap/wcp-domain-create-wcp-infra-sample-domain-job-cm created Checking the configmap wcp-domain-create-wcp-infra-sample-domain-job-cm was created configmap/wcp-domain-create-wcp-infra-sample-domain-job-cm labeled Checking if object type job with name wcp-domain-create-wcp-infra-sample-domain-job exists Deleting wcp-domain-create-wcp-infra-sample-domain-job using output/weblogic-domains/wcp-domain/create-domain-job.yaml job.batch "wcp-domain-create-wcp-infra-sample-domain-job" deleted $loadBalancerType is NOT empty Creating the domain by creating the job output/weblogic-domains/wcp-domain/create-domain-job.yaml job.batch/wcp-domain-create-wcp-infra-sample-domain-job created Waiting for the job to complete... status on iteration 1 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 2 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 3 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 4 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 5 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 6 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Running status on iteration 7 of 20 pod wcp-domain-create-wcp-infra-sample-domain-job-b5l6c status is Completed Domain wcp-domain was created and will be started by the WebLogic Kubernetes Operator The following files were generated: output/weblogic-domains/wcp-domain/create-domain-inputs.yaml output/weblogic-domains/wcp-domain/create-domain-job.yaml output/weblogic-domains/wcp-domain/domain.yaml Completed前述のドメイン作成ログをモニターするには:

$ kubectl get pods -n wcpns |grep wcp-domain-createサンプル出力:

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 1/1 Running 0 6s$ kubectl get pods -n wcpns | grep wcp-domain-create | awk '{print $1}' | xargs kubectl -n wcpns logs -fサンプル出力:

The domain will be created using the script /u01/weblogic/create-domain-script.sh Initializing WebLogic Scripting Tool (WLST) ... Welcome to WebLogic Server Administration Scripting Shell Type help() for help on available commands ================================================================= WebCenter Portal Weblogic Operator Domain Creation Script 14.1.2.0 ================================================================= Creating Base Domain... Creating Admin Server... Creating cluster... managed server name is wcpserver1 managed server name is wcpserver2 managed server name is wcpserver3 managed server name is wcpserver4 managed server name is wcpserver5 ['wcpserver1', 'wcpserver2', 'wcpserver3', 'wcpserver4', 'wcpserver5'] Creating porlet cluster... managed server name is wcportletserver1 managed server name is wcportletserver2 managed server name is wcportletserver3 ['wcportletserver1', 'wcportletserver2', 'wcportletserver3', 'wcportletserver4', 'wcportletserver5'] Managed servers created... Creating Node Manager... Will create Base domain at /u01/oracle/user_projects/domains/wcp-domain Writing base domain... Base domain created at /u01/oracle/user_projects/domains/wcp-domain Extending Domain... Extending domain at /u01/oracle/user_projects/domains/wcp-domain Database oracle-db.wcpns.svc.cluster.local:1521/devpdb.k8s ExposeAdminT3Channel false with 100.111.157.155:30012 Applying JRF templates... Applying WCPortal templates... Extension Templates added... WC_Portal Managed server deleted... Configuring the Service Table DataSource... fmwDatabase jdbc:oracle:thin:@oracle-db.wcpns.svc.cluster.local:1521/devpdb.k8s Getting Database Defaults... Targeting Server Groups... Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcpserver1 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcpserver2 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcpserver3 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcpserver4 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcpserver5 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcportletserver1 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcportletserver2 Set CoherenceClusterSystemResource to defaultCoherenceCluster for server:wcportletserver3 Targeting Cluster ... Set CoherenceClusterSystemResource to defaultCoherenceCluster for cluster:wcp-cluster Set WLS clusters as target of defaultCoherenceCluster:wcp-cluster Set CoherenceClusterSystemResource to defaultCoherenceCluster for cluster:wcportlet-cluster Set WLS clusters as target of defaultCoherenceCluster:wcportlet-cluster Preparing to update domain... Jan 12, 2021 10:30:09 AM oracle.security.jps.az.internal.runtime.policy.AbstractPolicyImpl initializeReadStore INFO: Property for read store in parallel: oracle.security.jps.az.runtime.readstore.threads = null Domain updated successfully Domain Creation is done... Successfully Completed

WebCenter Portalドメインの初期化

ドメインを起動するには、前述のdomain.yamlを適用します:

kubectl apply -f output/weblogic-domains/wcp-domain/domain.yamlサンプル出力:

domain.weblogic.oracle/wcp-domain createdWebCenter Portalドメインの検証

ドメインおよびサーバーのポッドとサービスが作成され、READY状態であることを検証します:

サンプル実行は次のとおりです:

kubectl get pods -n wcpns -wサンプル出力:

NAME READY STATUS RESTARTS AGE

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 15m

wcp-domain-adminserver 1/1 Running 0 8m9s

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 3h6m

wcp-domain-wcp-server1 0/1 Running 0 6m5s

wcp-domain-wcp-server2 0/1 Running 0 6m4s

wcp-domain-wcp-server2 1/1 Running 0 6m18s

wcp-domain-wcp-server1 1/1 Running 0 6m54skubectl get all -n wcpnsサンプル出力:

NAME READY STATUS RESTARTS AGE

pod/wcp-domain-adminserver 1/1 Running 0 13m

pod/wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 3h12m

pod/wcp-domain-wcp-server1 1/1 Running 0 11m

pod/wcp-domain-wcp-server2 1/1 Running 0 11m

pod/wcp-domain-wcportletserver1 1/1 Running 1 21h

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/wcp-domain-adminserver ClusterIP None <none> 7001/TCP 13m

service/wcp-domain-cluster-wcp-cluster ClusterIP 10.98.145.173 <none> 8888/TCP 11m

service/wcp-domain-wcp-server1 ClusterIP None <none> 8888/TCP 11m

service/wcp-domain-wcp-server2 ClusterIP None <none> 8888/TCP 11m

service/wcp-domain-cluster-wcportlet-cluster ClusterIP 10.98.145.173 <none> 8889/TCP 11m

service/wcp-domain-wcportletserver1 ClusterIP None <none> 8889/TCP 11m

NAME COMPLETIONS DURATION AGE

job.batch/wcp-domain-create-fmw-infra-sample-domain-job 1/1 16m 3h12m管理サーバーおよび管理対象サーバーのログを参照するには、ポッド・ログを確認します:

$ kubectl logs -f wcp-domain-adminserver -n wcpns$ kubectl logs -f wcp-domain-wcp-server1 -n wcpnsポッドの検証

次のコマンドを使用して、サーバーを実行しているポッドを表示します:

$ kubectl get pods -n NAMESPACE次に、このコマンドの出力例を示します:

kubectl get pods -n wcpnsサンプル出力:

NAME READY STATUS RESTARTS AGE

rcu 1/1 Running 1 14d

wcp-domain-adminserver 1/1 Running 0 16m

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 3h14m

wcp-domain-wcp-server1 1/1 Running 0 14m

wcp-domain-wcp-server2 1/1 Running 0 14m

wcp-domain-wcportletserver1 1/1 Running 1 14mサービスの検証

次のコマンドを使用して、ドメインのサービスを表示します:

$ kubectl get services -n NAMESPACE次に、このコマンドの出力例を示します:

kubectl get services -n wcpnsサンプル出力:

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

wcp-domain-adminserver ClusterIP None <none> 7001/TCP 17m

wcp-domain-cluster-wcp-cluster ClusterIP 10.98.145.173 <none> 8888/TCP 14m

wcp-domain-wcp-server1 ClusterIP None <none> 8888/TCP 14m

wcp-domain-wcp-server2 ClusterIP None <none> 8888/TCP 14m

wcp-domain-cluster-wcportlet-cluster ClusterIP 10.98.145.173 <none> 8889/TCP 14m

wcp-domain-wcportletserver1 ClusterIP None <none> 8889/TCP 14mWebCenter Portalの管理

管理対象サーバーを停止するには:

kubectl patch domain wcp-domain -n wcpns --type='json' -p='[{"op": "replace", "path": "/spec/clusters/0/replicas", "value": 0 }]'構成されたすべての管理対象サーバーを起動するには:

kubectl patch domain wcp-domain -n wcpns --type='json' -p='[{"op": "replace", "path": "/spec/clusters/0/replicas", "value": 3 }]' kubectl get pods -n wcpns -wサンプル出力:

NAME READY STATUS RESTARTS AGE

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 15m

wcp-domain-adminserver 1/1 Running 0 8m9s

wcp-domain-create-fmw-infra-sample-domain-job-8jr6k 0/1 Completed 0 3h6m

wcp-domain-wcp-server1 0/1 Running 0 6m5s

wcp-domain-wcp-server2 0/1 Running 0 6m4s

wcp-domain-wcp-server2 1/1 Running 0 6m18s

wcp-domain-wcp-server1 1/1 Running 0 6m54s管理ガイド

様々なユーティリティ・ツールおよび構成を使用して、WebCenter Portalドメインを管理する方法について説明します。

Kubernetes環境でOracle WebCenter Portalドメインを管理します。

ロード・バランサの設定

Oracle WebCenter Portalドメインの様々なロード・バランサを設定します。

WebLogic Kubernetes Operatorは、TraefikやNGINX (kubernetes/ingress-nginx)などのイングレスベースのロード・バランサをサポートしています。また、Apache Web層ロード・バランサでも動作します。

Traefik

Oracle WebCenter PortalドメインのTraefikイングレスベースのロード・バランサを設定します。

Oracle WebCenter Portalドメイン・クラスタをロード・バランシングするには、イングレスベースのTraefikロード・バランサ(本番環境ではバージョン2.6.0以降)をインストールし、アプリケーションURLの非SSL、SSL終端およびエンドツーエンドSSLアクセス用に構成します。次のステップに従って、TraefikをKubernetesクラスタ内のOracle WebCenter Portalドメインのロード・バランサとして構成します:

非SSLおよびSSL終端

Traefik (イングレスベース)ロード・バランサのインストール

Helmを使用して、Traefik (イングレスベース)ロード・バランサをインストールします。次の

values.yamlサンプル・ファイルを使用して、必要に応じてkubernetes.namespacesを設定できます。cd ${WORKDIR} kubectl create namespace traefik helm repo add traefik https://helm.traefik.io/traefik --force-updateサンプル出力:

"traefik" has been added to your repositoriesTraefikをインストールします:

helm install traefik traefik/traefik \ --namespace traefik \ --values charts/traefik/values.yaml \ --set "kubernetes.namespaces={traefik}" \ --set "service.type=NodePort" --waitサンプル出力:

LAST DEPLOYED: Sun Sep 13 21:32:00 2020 NAMESPACE: traefik STATUS: deployed REVISION: 1 TEST SUITE: None次に、Traefikをデプロイするためのサンプル

values.yamlを示します:image: name: traefik pullPolicy: IfNotPresent ingressRoute: dashboard: enabled: true # Additional ingressRoute annotations (e.g. for kubernetes.io/ingress.class) annotations: {} # Additional ingressRoute labels (e.g. for filtering IngressRoute by custom labels) labels: {} providers: kubernetesCRD: enabled: true kubernetesIngress: enabled: true # IP used for Kubernetes Ingress endpoints ports: traefik: port: 9000 # The exposed port for this service exposedPort: 9000 # The port protocol (TCP/UDP) protocol: TCP web: port: 8000 exposedPort: 30305 nodePort: 30305 # The port protocol (TCP/UDP) protocol: TCP # Use nodeport if set. This is useful if you have configured Traefik in a # LoadBalancer # nodePort: 32080 # Port Redirections # Added in 2.2, you can make permanent redirects via entrypoints. # https://docs.traefik.io/routing/entrypoints/#redirection # redirectTo: websecure websecure: port: 8443 exposedPort: 30443 # The port protocol (TCP/UDP) protocol: TCP nodePort: 30443Traefikステータスを確認し、SSLおよび非SSLサービスのポート番号を見つけます:

kubectl get all -n traefikサンプル出力:

NAME READY STATUS RESTARTS AGE pod/traefik-f9cf58697-29dlx 1/1 Running 0 35s NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/traefik NodePort 10.100.113.37 <none> 9000:30070/TCP,30305:30305/TCP,30443:30443/TCP 35s NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/traefik 1/1 1 1 36s NAME DESIRED CURRENT READY AGE replicaset.apps/traefik-f9cf58697 1 1 1 36sHTTPホスト

traefik.example.comを使用してURLhttp://$(hostname -f):30070を介してTraefikダッシュボードにアクセスします:curl -H "host: $(hostname -f)" http://$(hostname -f):30070/dashboard/ノート:

$(hostname -f)には必ず完全修飾ノード名を指定してください

イングレスを管理するためのTraefikの構成

このネームスペースで作成されたイングレスを管理するようにTraefikを構成します。次のサンプルでは、traefikはTraefikネームスペースで、wcpnsはドメインのネームスペースです:

helm upgrade traefik traefik/traefik \

--reuse-values \

--namespace traefik \

--set "kubernetes.namespaces={traefik,wcpns}" \

--waitサンプル出力:

Release "traefik" has been upgraded. Happy Helming!

NAME: traefik

LAST DEPLOYED: Tue Jan 12 04:33:15 2021

NAMESPACE: traefik

STATUS: deployed

REVISION: 2

TEST SUITE: Noneドメインのイングレスの作成

ドメイン・ネームスペース内にドメインのイングレスを作成するには、イングレスのパスベースのルーティングを実装するサンプルのHelmチャートを使用します。デフォルト構成のサンプル値は、${WORKDIR}/charts/ingress-per-domain/values.yamlファイルにあります。

デフォルトでは、typeはTRAEFIKに設定され、tlsはNon-SSLとして構成されます。これらの値をオーバーライドするには、コマンドラインを介してそれらを渡すか、構成タイプ(非SSLまたはSSL)に従ってサンプルvalues.yamlファイルを編集します。

ノート: これは、ルールの完全なリストではありません。外部アクセスが必要なアプリケーションURLを含めるように変更できます。

必要に応じて、イングレスYAMLファイルを更新して、外部アクセスが必要なドメイン・アプリケーションURLに基づいてspec.rules.host.http.pathsセクションに追加のパス・ルールを定義できます。Traefik (イングレスベース)ロード・バランサのテンプレートYAMLファイルは、${WORKDIR}/charts/ingress-per-domain/templates/traefik-ingress.yamlにあります。次に示すとおり、新しいパス・ルールを追加できます。

- path: /NewPathRule

backend:

serviceName: 'Backend Service Name'

servicePort: 'Backend Service Port'非SSL構成用にHelmを使用して

ingress-per-domainをインストールします:cd ${WORKDIR} helm install wcp-traefik-ingress \ charts/ingress-per-domain \ --namespace wcpns \ --values charts/ingress-per-domain/values.yaml \ --set "traefik.hostname=$(hostname -f)"サンプル出力:

NAME: wcp-traefik-ingress LAST DEPLOYED: Mon Jul 20 11:44:13 2020 NAMESPACE: wcpns STATUS: deployed REVISION: 1 TEST SUITE: NoneOracle WebCenter Portalアプリケーションへのセキュア・アクセス(SSL)の場合は、証明書を作成してKubernetesシークレットを生成します:

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /tmp/tls1.key -out /tmp/tls1.crt -subj "/CN=*" kubectl -n wcpns create secret tls wcp-domain-tls-cert --key /tmp/tls1.key --cert /tmp/tls1.crtノート:

CNの値は、このイングレスがデプロイされるホストです。Traefik TLSStoreカスタム・リソースを作成します。

SSL終端の場合は、ユーザー定義のSSL証明書を使用するようにTraefikを構成する必要があります。ユーザー定義のSSL証明書が構成されていない場合、TraefikはデフォルトのSSL証明書を作成します。Traefikのユーザー定義のSSL証明書を構成するには、TLSStoreカスタム・リソースを使用します。SSL証明書を使用して作成されたKubernetesシークレットは、TLSStoreオブジェクトで参照される必要があります。次のコマンドを実行して、TLSStoreを作成します:

cat <<EOF | kubectl apply -f - apiVersion: traefik.containo.us/v1alpha1 kind: TLSStore metadata: name: default namespace: wcpns spec: defaultCertificate: secretName: wcp-domain-tls-cert EOFSSL構成用にHelmを使用して

ingress-per-domainをインストールします。Kubernetesシークレット名は、テンプレート・ファイルで更新する必要があります。

テンプレート・ファイルには、次の注釈も含まれています:

traefik.ingress.kubernetes.io/router.entrypoints: websecure traefik.ingress.kubernetes.io/router.tls: "true" traefik.ingress.kubernetes.io/router.middlewares: wcpns-wls-proxy-ssl@kubernetescrdSSLアクセスのエントリ・ポイントおよびミドルウェア名を注釈で更新する必要があります。ミドルウェア名は、

<namespace>-<middleware name>@kubernetescrdという形式にする必要があります。cd ${WORKDIR} helm install wcp-traefik-ingress \ charts/ingress-per-domain \ --namespace wcpns \ --values charts/ingress-per-domain/values.yaml \ --set "traefik.hostname=$(hostname -f)" \ --set sslType=SSLサンプル出力:

NAME: wcp-traefik-ingress LAST DEPLOYED: Mon Jul 20 11:44:13 2020 NAMESPACE: wcpns STATUS: deployed REVISION: 1 TEST SUITE: NoneOracle WebCenter Portalアプリケーションへの非SSLアクセスの場合は、イングレスによってサービスの詳細を取得します:

kubectl describe ingress wcp-domain-traefik -n wcpns前述のデプロイ済イングレスでサポートされるサンプル・サービス:

Name: wcp-domain-traefik Namespace: wcpns Address: Default backend: default-http-backend:80 (<error: endpoints "default-http-backend" not found>) Rules: Host Path Backends ---- ---- -------- www.example.com /webcenter wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /console wcp-domain-adminserver:7001 (10.244.0.51:7001) /rsscrawl wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /rest wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /webcenterhelp wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /em wcp-domain-adminserver:7001 (10.244.0.51:7001) /wsrp-tools wcp-domain-cluster-wcportlet-cluster:8889 (10.244.0.52:8889,10.244.0.53:8889) Annotations: kubernetes.io/ingress.class: traefik meta.helm.sh/release-name: wcp-traefik-ingress meta.helm.sh/release-namespace: wcpns Events: <none>Oracle WebCenter PortalアプリケーションへのSSLアクセスの場合は、前述のデプロイ済イングレスによってサービスの詳細を取得します:

kubectl describe ingress wcp-domain-traefik -n wcpns前述のデプロイ済イングレスでサポートされるサンプル・サービス:

Name: wcp-domain-traefik Namespace: wcpns Address: Default backend: default-http-backend:80 (<error: endpoints "default-http-backend" not found>) TLS: wcp-domain-tls-cert terminates www.example.com Rules: Host Path Backends ---- ---- -------- www.example.com /webcenter wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /console wcp-domain-adminserver:7001 (10.244.0.51:7001) /rsscrawl wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /rest wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /webcenterhelp wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /em wcp-domain-adminserver:7001 (10.244.0.51:7001) /wsrp-tools wcp-domain-cluster-wcportlet-cluster:8889 (10.244.0.52:8889,10.244.0.53:8889) Annotations: kubernetes.io/ingress.class: traefik meta.helm.sh/release-name: wcp-traefik-ingress meta.helm.sh/release-namespace: wcpns traefik.ingress.kubernetes.io/router.entrypoints: websecure traefik.ingress.kubernetes.io/router.middlewares: wcpns-wls-proxy-ssl@kubernetescrd traefik.ingress.kubernetes.io/router.tls: true Events: <none>ロード・バランサが新しいイングレスを認識し、ドメイン・サーバー・ポッドへのルーティングに成功したことを確認するには、次のようにHTTP 200ステータス・コードを返すWebLogic ReadyAppフレームワークのURLにリクエストを送信します:

curl -v http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER_PORT}/weblogic/readyサンプル出力:

* Trying 149.87.129.203... > GET http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER_PORT}/weblogic/ready HTTP/1.1 > User-Agent: curl/7.29.0 > Accept: */* > Proxy-Connection: Keep-Alive > host: $(hostname -f) > < HTTP/1.1 200 OK < Date: Sat, 14 Mar 2020 08:35:03 GMT < Vary: Accept-Encoding < Content-Length: 0 < Proxy-Connection: Keep-Alive < * Connection #0 to host localhost left intact

ドメイン・アプリケーションURLアクセスの検証

非SSL構成の場合

Traefik (イングレスベース)ロード・バランサを設定した後、HTTPアクセス用の非SSLロード・バランサ・ポート30305を介してドメイン・アプリケーションURLにアクセスできることを検証します。Oracle WebCenter PortalドメインのサンプルURLは、次のとおりです:

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/webcenter

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/console

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/em

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/rsscrawl

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/rest

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/webcenterhelp

http://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/wsrp-toolsSSL構成の場合

Traefik (イングレスベース)ロード・バランサを設定した後、HTTPSアクセス用のSSLロード・バランサ・ポート30443を介してドメイン・アプリケーションにアクセスできることを検証します。Oracle WebCenter PortalドメインのサンプルURLは、次のとおりです:

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenter

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/console

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/em

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/rsscrawl

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/rest

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenterhelp

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/wsrp-toolsTraefikイングレスのアンインストール

イングレス・デプロイメントをアンインストールして削除します:

helm delete wcp-traefik-ingress -n wcpnsエンドツーエンドSSL構成

エンドツーエンドSSLのTraefikロード・バランサのインストール

Helmを使用して、Traefik (イングレスベース)ロード・バランサをインストールします。

values.yamlサンプル・ファイルを使用して、必要に応じてkubernetes.namespacesを設定できます。cd ${WORKDIR} kubectl create namespace traefik helm repo add traefik https://containous.github.io/traefik-helm-chartサンプル出力:

"traefik" has been added to your repositoriesTraefikをインストールします:

helm install traefik traefik/traefik \ --namespace traefik \ --values charts/traefik/values.yaml \ --set "kubernetes.namespaces={traefik}" \ --set "service.type=NodePort" --waitサンプル出力:

LAST DEPLOYED: Sun Sep 13 21:32:00 2020 NAMESPACE: traefik STATUS: deployed REVISION: 1 TEST SUITE: NoneTraefikオペレータ・ステータスを確認し、SSLおよび非SSLサービスのポート番号を見つけます:

kubectl get all -n traefikサンプル出力:

NAME READY STATUS RESTARTS AGE pod/traefik-845f5d6dbb-swb96 1/1 Running 0 32s NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE service/traefik NodePort 10.99.52.249 <none> 9000:31288/TCP,30305:30305/TCP,30443:30443/TCP 32s NAME READY UP-TO-DATE AVAILABLE AGE deployment.apps/traefik 1/1 1 1 33s NAME DESIRED CURRENT READY AGE replicaset.apps/traefik-845f5d6dbb 1 1 1 33sHTTPホスト

traefik.example.comを使用してURLhttp://$(hostname -f):31288を介してTraefikダッシュボードにアクセスします:curl -H "host: $(hostname -f)" http://$(hostname -f):31288/dashboard/ノート:

$(hostname -f)には必ず完全修飾ノード名を指定してください。

ドメインを管理するためのTraefikの構成

このネームスペースで作成されたドメイン・アプリケーション・サービスを管理するようにTraefikを構成します。次のサンプルでは、traefikはTraefikネームスペースで、wcpnsはドメインのネームスペースです:

helm upgrade traefik traefik/traefik --namespace traefik --reuse-values \

--set "kubernetes.namespaces={traefik,wcpns}"サンプル出力:

Release "traefik" has been upgraded. Happy Helming!

NAME: traefik

LAST DEPLOYED: Sun Sep 13 21:32:12 2020

NAMESPACE: traefik

STATUS: deployed

REVISION: 2

TEST SUITE: NoneIngressRouteTCPの作成

Traefikでは、注釈

ssl-passthroughによる複数のパスまたはルールがサポートされていないため、バックエンド・サービスごとに異なるイングレスを作成します。たとえば、wcp-domain-adminserverおよびwcp-domain-cluster-wcp-clusterでは、異なるイングレスを作成する必要があります。TraefikでSSLパススルーを有効にするには、TCPルーターを構成します。

IngressRouteTCPのサンプルYAMLは、${WORKDIR}/charts/ingress-per-domain/tls/traefik-tls.yamlにあります。traefik-tls.yamlで次を更新する必要があります:- サービス名とSSLポートは、

servicesで更新する必要があります。 - ロード・バランサ・ホスト名は、

HostSNIルールで更新する必要があります。

サンプル

traefik-tls.yaml:apiVersion: traefik.containo.us/v1alpha1 kind: IngressRouteTCP metadata: name: wcp-domain-cluster-routetcp namespace: wcpns spec: entryPoints: - websecure routes: - match: HostSNI(`${LOADBALANCER_HOSTNAME}`) services: - name: wcp-domain-cluster-wcp-cluster port: 8888 weight: 3 TerminationDelay: 400 tls: passthrough: true- サービス名とSSLポートは、

IngressRouteTCPを作成します:

kubectl apply -f traefik-tls.yaml

エンドツーエンドSSLアクセスの検証

構成済のサービスを介して公開されたアプリケーションURLへのアクセスを検証します。構成済のWCPクラスタ・サービスによって、次のWCPドメインURLにアクセスできます:

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenter

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/rsscrawl

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/rest

https://${LOADBALANCER_HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenterhelpTraefikのアンインストール

helm delete traefik -n traefik

cd ${WORKDIR}/charts/ingress-per-domain/tls

kubectl delete -f traefik-tls.yamlNGINX

Oracle WebCenter PortalドメインのイングレスベースのNGINXロード・バランサを構成します。

Oracle WebCenter Portalドメイン・クラスタをロード・バランシングするには、イングレスベースのNGINXロード・バランサをインストールし、アプリケーションURLの非SSL、SSL終端およびエンドツーエンドSSLアクセス用にNGINXを構成します。次のステップに従って、NGINXをKubernetesクラスタ内のOracle WebCenter Portalドメインのロード・バランサとして設定します:

前提条件は、公式のインストール・ドキュメントを参照してください。

非SSLおよびSSL終端

リポジトリ情報を取得するには、次のHelmコマンドを入力します:

helm repo add ingress-nginx https://kubernetes.github.io/ingress-nginx

helm repo updateNGINXロード・バランサのインストール

ドメイン・ネームスペースでHelmを使用して、

ingress-nginxコントローラをデプロイします:helm install nginx-ingress ingress-nginx/ingress-nginx -n wcpns \ --set controller.service.type=NodePort \ --set controller.admissionWebhooks.enabled=falseサンプル出力

NAME: nginx-ingress

LAST DEPLOYED: Tue Jan 12 21:13:54 2021

NAMESPACE: wcpns

STATUS: deployed

REVISION: 1

TEST SUITE: None

NOTES:

The ingress-nginx controller has been installed.

Get the application URL by running these commands:

export HTTP_NODE_PORT=30305

export HTTPS_NODE_PORT=$(kubectl --namespace wcpns get services -o jsonpath="{.spec.ports[1].nodePort}" nginx-ingress-ingress-nginx-controller)

export NODE_IP=$(kubectl --namespace wcpns get nodes -o jsonpath="{.items[0].status.addresses[1].address}")

echo "Visit http://$NODE_IP:$HTTP_NODE_PORT to access your application via HTTP."

echo "Visit https://$NODE_IP:$HTTPS_NODE_PORT to access your application via HTTPS."

An example Ingress that makes use of the controller:

apiVersion: networking.k8s.io/v1beta1

kind: Ingress

metadata:

annotations:

kubernetes.io/ingress.class: nginx

name: example

namespace: foo

spec:

rules:

- host: www.example.com

http:

paths:

- backend:

serviceName: exampleService

servicePort: 80

path: /

# This section is only required if TLS is to be enabled for the Ingress

tls:

- hosts:

- www.example.com

secretName: example-tls

If TLS is enabled for the Ingress, a Secret containing the certificate and key must also be provided:

apiVersion: v1

kind: Secret

metadata:

name: example-tls

namespace: foo

data:

tls.crt: <base64 encoded cert>

tls.key: <base64 encoded key>

type: kubernetes.io/tlsデプロイされたイングレス・コントローラのステータスを確認します:

kubectl --namespace wcpns get services | grep ingress-nginx-controllerサンプル出力:

nginx-ingress-ingress-nginx-controller NodePort 10.101.123.106 <none> 80:30305/TCP,443:31856/TCP 2m12s

イングレスを管理するためのNGINXの構成

- サンプルのHelmチャートを使用して、ドメイン・ネームスペースにドメインのイングレスを作成します。ここでは、パスベースのルーティングがイングレスに使用されます。デフォルト構成のサンプル値は、

${WORKDIR}/charts/ingress-per-domain/values.yamlファイルに示されています。デフォルトでは、typeはTRAEFIKで、tlsはNon-SSLです。これらの値をオーバーライドするには、コマンドラインを介して値を渡すか、サンプルvalues.yamlファイルでそれらを編集します。

ノート: これは、ルールの完全なリストではありません。外部からアクセスする必要があるアプリケーションURLに基づいてこれを拡張できます。

必要に応じて、イングレスYAMLファイルを更新して、アクセスが必要なドメイン・アプリケーションURLに基づいて(spec.rules.host.http.pathsセクションに)追加のパス・ルールを定義できます。${WORKDIR}/charts/ingress-per-domain/templates/nginx-ingress.yamlにあるNGINXロード・バランサのテンプレートYAMLファイルを更新します

次に示すような新しいパス・ルールを追加できます。

- path: /NewPathRule

backend:

serviceName: 'Backend Service Name'

servicePort: 'Backend Service Port' cd ${WORKDIR}

helm install wcp-domain-nginx charts/ingress-per-domain \

--namespace wcpns \

--values charts/ingress-per-domain/values.yaml \

--set "nginx.hostname=$(hostname -f)" \

--set type=NGINXサンプル出力:

NAME: wcp-domain-nginx

LAST DEPLOYED: Fri Jul 24 09:34:03 2020

NAMESPACE: wcpns

STATUS: deployed

REVISION: 1

TEST SUITE: NoneOracle WebCenter Portalアプリケーションへのセキュア・アクセス(SSL)の場合は、証明書を作成してKubernetesシークレットを生成します:

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /tmp/tls1.key -out /tmp/tls1.crt -subj "/CN=*" kubectl -n wcpns create secret tls wcp-domain-tls-cert --key /tmp/tls1.key --cert /tmp/tls1.crtSSL構成用にHelmを使用して

ingress-per-domainをインストールします:cd ${WORKDIR} helm install wcp-domain-nginx charts/ingress-per-domain \ --namespace wcpns \ --values charts/ingress-per-domain/values.yaml \ --set "nginx.hostname=$(hostname -f)" \ --set type=NGINX --set sslType=SSLOracle WebCenter Portalアプリケーションへの非SSLアクセスの場合は、イングレスによってサービスの詳細を取得します:

kubectl describe ingress wcp-domain-nginx -n wcpnsサンプル出力:

Name: wcp-domain-nginx Namespace: wcpns Address: 10.101.123.106 Default backend: default-http-backend:80 (<error: endpoints "default-http-backend" not found>) Rules: Host Path Backends ---- ---- -------- * /webcenter wcp-domain-cluster-wcp-cluster:8888 (10.244.0.52:8888,10.244.0.53:8888) /console wcp-domain-adminserver:7001 (10.244.0.51:7001) /rsscrawl wcp-domain-cluster-wcp-cluster:8888 (10.244.0.53:8888) /rest wcp-domain-cluster-wcp-cluster:8888 (10.244.0.53:8888) /webcenterhelp wcp-domain-cluster-wcp-cluster:8888 (10.244.0.53:8888) /wsrp-tools wcp-domain-cluster-wcportlet-cluster:8889 (10.244.0.53:8889) /em wcp-domain-adminserver:7001 (10.244.0.51:7001) Annotations: meta.helm.sh/release-name: wcp-domain-nginx meta.helm.sh/release-namespace: wcpns nginx.com/sticky-cookie-services: serviceName=wcp-domain-cluster-wcp-cluster srv_id expires=1h path=/; nginx.ingress.kubernetes.io/proxy-connect-timeout: 1800 nginx.ingress.kubernetes.io/proxy-read-timeout: 1800 nginx.ingress.kubernetes.io/proxy-send-timeout: 1800 Events: Type Reason Age From Message ---- ------ ---- ---- ------- Normal Sync 48m (x2 over 48m) nginx-ingress-controller Scheduled for syncOracle WebCenter PortalアプリケーションへのSSLアクセスの場合は、前述のデプロイ済イングレスによってサービスの詳細を取得します:

kubectl describe ingress wcp-domain-nginx -n wcpnsサンプル出力:

Name: wcp-domain-nginx Namespace: wcpns Address: 10.106.220.140 Default backend: default-http-backend:80 (<error: endpoints "default-http-backend" not found>) TLS: wcp-domain-tls-cert terminates mydomain.com Rules: Host Path Backends ---- ---- -------- * /webcenter wcp-domain-cluster-wcp-cluster:8888 (10.244.0.43:8888,10.244.0.44:8888) /console wcp-domain-adminserver:7001 (10.244.0.42:7001) /rsscrawl wcp-domain-cluster-wcp-cluster:8888 (10.244.0.43:8888,10.244.0.44:8888) /webcenterhelp wcp-domain-cluster-wcp-cluster:8888 (10.244.0.43:8888,10.244.0.44:8888) /rest wcp-domain-cluster-wcp-cluster:8888 (10.244.0.43:8888,10.244.0.44:8888) /em wcp-domain-adminserver:7001 (10.244.0.42:7001) /wsrp-tools wcp-domain-cluster-wcportlet-cluster:8889 (10.244.0.43:8889,10.244.0.44:8889) Annotations: kubernetes.io/ingress.class: nginx meta.helm.sh/release-name: wcp-domain-nginx meta.helm.sh/release-namespace: wcpns nginx.ingress.kubernetes.io/affinity: cookie nginx.ingress.kubernetes.io/affinity-mode: persistent nginx.ingress.kubernetes.io/configuration-snippet: more_set_input_headers "X-Forwarded-Proto: https"; more_set_input_headers "WL-Proxy-SSL: true"; nginx.ingress.kubernetes.io/ingress.allow-http: false nginx.ingress.kubernetes.io/proxy-connect-timeout: 1800 nginx.ingress.kubernetes.io/proxy-read-timeout: 1800 nginx.ingress.kubernetes.io/proxy-send-timeout: 1800 nginx.ingress.kubernetes.io/session-cookie-expires: 172800 nginx.ingress.kubernetes.io/session-cookie-max-age: 172800 nginx.ingress.kubernetes.io/session-cookie-name: stickyid nginx.ingress.kubernetes.io/ssl-redirect: false Events: <none>

非SSLおよびSSL終端アクセスの検証

Oracle WebCenter Portalドメイン・アプリケーションURLがnginx NodePort LOADBALANCER-NODEPORT 30305を介してアクセス可能であることを検証します:

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/console

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/em

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/webcenter

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/rsscrawl

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/rest

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/webcenterhelp

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-NODEPORT}/wsrp-toolsイングレスのアンインストール

ingress-nginxデプロイメントをアンインストールして削除します:

helm delete wcp-domain-nginx -n wcpns

helm delete nginx-ingress -n wcpnsエンドツーエンドSSL構成

エンドツーエンドSSLのNGINXロード・バランサのインストール

Oracle WebCenter Portalアプリケーションへのセキュア・アクセス(SSL)の場合は、証明書を作成してシークレットを生成します:

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout /tmp/tls1.key -out /tmp/tls1.crt -subj "/CN=domain1.org" kubectl -n wcpns create secret tls wcp-domain-tls-cert --key /tmp/tls1.key --cert /tmp/tls1.crtノート:

CNの値は、このイングレスがデプロイされるホストです。ドメイン・ネームスペースでHelmを使用して、ingress-nginxコントローラをデプロイします:

helm install nginx-ingress -n wcpns \ --set controller.extraArgs.default-ssl-certificate=wcpns/wcp-domain-tls-cert \ --set controller.service.type=NodePort \ --set controller.admissionWebhooks.enabled=false \ --set controller.extraArgs.enable-ssl-passthrough=true \ ingress-nginx/ingress-nginxサンプル出力:

NAME: nginx-ingress LAST DEPLOYED: Tue Sep 15 08:40:47 2020 NAMESPACE: wcpns STATUS: deployed REVISION: 1 TEST SUITE: None NOTES: The ingress-nginx controller has been installed. Get the application URL by running these commands: export HTTP_NODE_PORT=$(kubectl --namespace wcpns get services -o jsonpath="{.spec.ports[0].nodePort}" nginx-ingress-ingress-nginx-controller) export HTTPS_NODE_PORT=$(kubectl --namespace wcpns get services -o jsonpath="{.spec.ports[1].nodePort}" nginx-ingress-ingress-nginx-controller) export NODE_IP=$(kubectl --namespace wcpns get nodes -o jsonpath="{.items[0].status.addresses[1].address}") echo "Visit http://$NODE_IP:$HTTP_NODE_PORT to access your application via HTTP." echo "Visit https://$NODE_IP:$HTTPS_NODE_PORT to access your application via HTTPS." An example Ingress that makes use of the controller: apiVersion: networking.k8s.io/v1beta1 kind: Ingress metadata: annotations: kubernetes.io/ingress.class: nginx name: example namespace: foo spec: rules: - host: www.example.com http: paths: - backend: serviceName: exampleService servicePort: 80 path: / # This section is only required if TLS is to be enabled for the Ingress tls: - hosts: - www.example.com secretName: example-tls If TLS is enabled for the Ingress, a Secret containing the certificate and key must also be provided: apiVersion: v1 kind: Secret metadata: name: example-tls namespace: foo data: tls.crt: <base64 encoded cert> tls.key: <base64 encoded key> type: kubernetes.io/tlsデプロイされたイングレス・コントローラのステータスを確認します:

kubectl --namespace wcpns get services | grep ingress-nginx-controllerサンプル出力:

nginx-ingress-ingress-nginx-controller NodePort 10.96.177.215 <none> 80:32748/TCP,443:31940/TCP 23s

サービスにアクセスするためのtlsのデプロイ

tlsをデプロイしてサービスに安全にアクセスします。

ssl-passthroughで構成できるアプリケーションは1つのみです。サービスwcp-domain-cluster-wcp-clusterおよびポート8889のNGINXのサンプルtlsファイルを次に示します。ポート8889で実行されているすべてのアプリケーションに、このイングレスを介して安全にアクセスできます。NGINXでは、注釈

ssl-passthroughによる複数のパスまたはルールがサポートされていないため、バックエンド・サービスごとに異なるイングレスを作成します。たとえば、wcp-domain-adminserverおよびwcp-domain-cluster-wcp-clusterでは、異なるイングレスを作成する必要があります。NGINXの

ssl-passthroughは、個々のエンドポイントではなくバッキング・サービスのclusterIPで動作するため、clusterIPを使用してオペレータによって作成されたwcp-domain-cluster-wcp-clusterを公開する必要があります。例:

wcp-domainクラスタ・サービスの名前を取得します:

kubectl get svc -n wcpns | grep wcp-domain-cluster-wcp-clusterサンプル出力:

wcp-domain-cluster-wcp-cluster ClusterIP 10.102.128.124 <none> 8888/TCP,8889/TCP 62m

保護されたイングレスをデプロイします:

cd ${WORKDIR}/charts/ingress-per-domain/tls kubectl create -f nginx-tls.yamlノート: デフォルトの

nginx-tls.yamlには、domainUIDwcp-domainとともにWebCenter Portalサービスのバックエンドが含まれます。バックエンド・サービスごとに、同様のtls構成YAMLファイルを個別に作成する必要があります。nginx-tls.yamlファイルの内容:apiVersion: extensions/v1beta1 kind: Ingress metadata: name: wcpns-ingress namespace: wcpns annotations: kubernetes.io/ingress.class: nginx nginx.ingress.kubernetes.io/ssl-passthrough: "true" spec: tls: - hosts: - domain1.org secretName: wcp-domain-tls-cert rules: - host: domain1.org http: paths: - path: backend: serviceName: wcp-domain-cluster-wcp-cluster servicePort: 8889ノート: ホストは、このイングレスがデプロイされるサーバーです。

イングレスでサポートされているサービスを確認します:

kubectl describe ingress wcpns-ingress -n wcpns

エンドツーエンドSSLアクセスの検証

Oracle WebCenter Portalドメイン・アプリケーションURLがLOADBALANCER-SSLPORT 30233を介してアクセス可能であることを検証します:

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenter

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/rsscrawl

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenterhelp

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/rest

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/wsrp-tools ingress-nginx tlsのアンインストール

cd ${WORKDIR}/charts/ingress-per-domain/tls

kubectl delete -f nginx-tls.yaml

helm delete nginx-ingress -n wcpnsApache Web層

Oracle WebCenter PortalドメインのApache Web層ロード・バランサを構成します。

Oracle WebCenter Portalドメイン・クラスタをロード・バランシングするには、Apache Web層をインストールし、アプリケーションURLの非SSLおよびSSL終端アクセス用に構成します。次のステップに従って、Apache Web層をKubernetesクラスタ内のOracle WebCenter Portalドメインのロード・バランサとして設定します:

- Apache Web層イメージのビルド

- Apacheプラグイン構成ファイルの作成

- 証明書と秘密キーの準備

- Apache Web層Helmチャートのインストール

- ドメイン・アプリケーションURLアクセスの検証

- Apache Web層のアンインストール

Apache Web層イメージのビルド

Apache Web層Dockerイメージをビルドするには、サンプルを参照してください。

Apacheプラグイン構成ファイルの作成

custom_mod_wl_apache.confという名前の構成ファイルには、外部からアクセスできる必要があるドメインにデプロイされたOracle WebCenter PortalアプリケーションのすべてのURLルーティング・ルールが必要です。このファイルを環境に基づいた値で更新します。ファイルの内容は次のようになります。wcp-domainドメインの構成ファイル

custom_mod_wl_apache.confのサンプル・コンテンツ:cat ${WORKDIR}/charts/apache-samples/custom-sample/custom_mod_wl_apache.confサンプル出力:

#Copyright (c) 2018 Oracle and/or its affiliates. All rights reserved. # # Licensed under the Universal Permissive License v 1.0 as shown at https://oss.oracle.com/licenses/upl. # <IfModule mod_weblogic.c> WebLogicHost <WEBLOGIC_HOST> WebLogicPort 7001 </IfModule> # Directive for weblogic admin Console deployed on Weblogic Admin Server <Location /console> SetHandler weblogic-handler WebLogicHost wcp-domain-adminserver WebLogicPort 7001 </Location> <Location /em> SetHandler weblogic-handler WebLogicHost wcp-domain-adminserver WebLogicPort 7001 </Location> <Location /webcenter> WLSRequest On WebLogicCluster wcp-domain-cluster-wcp-cluster:8888 PathTrim /weblogic1 </Location> <Location /rsscrawl> WLSRequest On WebLogicCluster wcp-domain-cluster-wcp-cluster:8888 PathTrim /weblogic1 </Location> <Location /rest> WLSRequest On WebLogicCluster wcp-domain-cluster-wcp-cluster:8888 PathTrim /weblogic1 </Location> <Location /webcenterhelp> WLSRequest On WebLogicCluster wcp-domain-cluster-wcp-cluster:8888 PathTrim /weblogic1 </Location> <Location /wsrp-tools> WLSRequest On WebLogicCluster wcp-domain-cluster-wcportlet-cluster:8889 PathTrim /weblogic1 </Location>独自の

custom_mod_wl_apache.confファイルを含む永続ボリュームを使用して、${WORKDIR}/charts/apache-samples/custom-sample/input.yamlのpersistentVolumeClaimNameを更新します。環境の準備時に作成したPV/PVCを使用して、custom_mod_wl_apache.confファイルを既存のPersistantVolumeにコピーします。

証明書と秘密キーの準備

(SSL終端構成の場合のみ)次のコマンドを実行し、

opensslを使用して独自の証明書と秘密キーを生成します。cd ${WORKDIR}/charts/apache-samples/custom-sample export VIRTUAL_HOST_NAME=WEBLOGIC_HOST export SSL_CERT_FILE=WEBLOGIC_HOST.crt export SSL_CERT_KEY_FILE=WEBLOGIC_HOST.key sh certgen.shノート: WEBLOGIC_HOSTは、Apache Web層がインストールされるホストの名前に置き換えます。

証明書生成のサンプル出力:

ls certgen.sh custom_mod_wl_apache.conf custom_mod_wl_apache.conf_orig input.yaml README.md sh certgen.sh Generating certs for WEBLOGIC_HOST Generating a 2048 bit RSA private key ........................+++ .......................................................................+++ unable to write 'random state' writing new private key to 'apache-sample.key' ----- ls certgen.sh custom_mod_wl_apache.conf_orig WEBLOGIC_HOST.info config.txt input.yaml WEBLOGIC_HOST.key custom_mod_wl_apache.conf WEBLOGIC_HOST.crt README.mdApache Web層Helmチャートの入力値を準備します。

次のコマンドを実行して、Apache Web層Helmチャートの入力値ファイルを準備します。

base64 -i ${SSL_CERT_FILE} | tr -d '\n' base64 -i ${SSL_CERT_KEY_FILE} | tr -d '\n' touch input.yamlvirtualHostNameを、${WORKDIR}/charts/apache-samples/custom-sample/input.yamlファイルのWEBLOGIC_HOSTの値で更新しますサンプル

input.yamlファイルのスナップショット:cat apache-samples/custom-sample/input.yaml # Use this to provide your own Apache webtier configuration as needed; simply define this # path and put your own custom_mod_wl_apache.conf file under this path. persistentVolumeClaimName: wcp-domain-domain-pvc # The VirtualHostName of the Apache HTTP server. It is used to enable custom SSL configuration. virtualHostName: <WEBLOGIC_HOST>

Apache Web層Helmチャートのインストール

指定された入力パラメータを使用して、Apache Web層Helmチャートをドメイン

wcpnsネームスペースにインストールします:cd ${WORKDIR}/charts kubectl create namespace apache-webtier helm install apache-webtier --values apache-samples/custom-sample/input.yaml --namespace wcpns apache-webtier --set image=oracle/apache:12.2.1.3Apache Web層のステータスを確認します:

kubectl get all -n wcpns | grep apacheApache Web層のステータスのサンプル出力:

pod/apache-webtier-apache-webtier-65f69dc6bc-zg5pj 1/1 Running 0 22h service/apache-webtier-apache-webtier NodePort 10.108.29.98 <none> 80:30305/TCP,4433:30443/TCP 22h deployment.apps/apache-webtier-apache-webtier 1/1 1 1 22h replicaset.apps/apache-webtier-apache-webtier-65f69dc6bc 1 1 1 22h

ドメイン・アプリケーションURLアクセスの検証

Apache Web層ロード・バランサが起動したら、ロード・バランサ・ポート30305/30443を介してドメイン・アプリケーションにアクセスできることを検証します。タイプwcpのドメインのアプリケーションURLは、次のとおりです:

ノート: ポート

30305はLOADBALANCER-Non-SSLPORTで、ポート30443はLOADBALANCER-SSLPORTです。

非SSL構成

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/console

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/em

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/webcenter

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/webcenterhelp

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/rest

http://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-Non-SSLPORT}/rsscrawlSSL構成

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenter

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/console

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/em

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/rsscrawl

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/webcenterhelp

https://${LOADBALANCER-HOSTNAME}:${LOADBALANCER-SSLPORT}/restApache Web層のアンインストール

helm delete apache-webtier -n wcpnsドメインのモニターとログの公開

Oracle WebCenter Portalをモニターして、Elasticsearchにログを公開します。

ElasticsearchおよびKibanaのインストール

ElasticsearchおよびKibanaをインストールするには、次のコマンドを実行します:

cd ${WORKDIR}/elasticsearch-and-kibana

kubectl create -f elasticsearch_and_kibana.yamlElasticsearchへの公開

診断およびその他のログは、Logstashポッドを使用してElasticsearchサーバーにプッシュできます。Logstashポッドは、共有ドメイン・ホームまたはログの場所にアクセスできる必要があります。Oracle WebCenter Portalドメインの場合、ドメイン・ホームの永続ボリュームをLogstashポッドで使用できます。次のステップに従って、Logstashポッドを作成します:

Oracle WebCenter Portalドメインのドメイン・ホーム永続ボリューム要求の詳細を取得します。次のコマンドは、ネームスペース(

wcpns)の永続ボリューム要求の詳細をリストします。次の例では、永続ボリューム要求はwcp-domain-domain-pvcです。kubectl get pv -n wcpnsサンプル出力:

NAME CAPACITY ACCESS MODES RECLAIM POLICY STATUS CLAIM STORAGECLASS REASON AGE wcp-domain-domain-pv 10Gi RWX Retain Bound wcpns/wcp-domain-domain-pvc wcp-domain-domain-storage-class 175dlogstash.confという名前のLogstash構成ファイルを作成します。サンプルのLogstash構成ファイルは、${WORKDIR}/logging-services/logstashにあります。次の構成では、診断およびすべてのドメイン・ログがプッシュされます。input { file { path => "/u01/oracle/user_projects/domains/wcp-domain/servers/**/logs/*-diagnostic.log" start_position => beginning } file { path => "/u01/oracle/user_projects/domains/logs/wcp-domain/*.log" start_position => beginning } } filter { grok { match => [ "message", "<%{DATA:log_timestamp}> <%{WORD:log_level}> <%{WORD:thread}> <%{HOSTNAME:hostname}> <%{HOSTNAME:servername}> <%{DATA:timer}> <<%{DATA:kernel}>> <> <%{DATA:uuid}> <%{NUMBER:timestamp}> <%{DATA:misc}> <%{DATA:log_number}> <%{DATA:log_message}>" ] } } output { elasticsearch { hosts => ["elasticsearch.default.svc.cluster.local:9200"] } }logstash.confファイルを/u01/oracle/user_projects/domainsにコピーして、Logstashデプロイメントで使用できるようにします。これは、管理サーバー・ポッド(たとえば、wcpnsネームスペースのwcp-domain-adminserverポッド)を使用して実行できます:kubectl cp ${WORKDIR}/logging-services/logstash/logstash.conf wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains -n wcpnsドメイン・ホーム永続ボリューム要求を使用して、Logstashポッドの

logstash.yamlという名前のデプロイメントYAMLファイルを作成します。Logstash構成ファイルが正しい場所を指していることを確認し(たとえば、logstash.confを/u01/oracle/user_projects/domains/logstash.confにコピーします)、適切なドメイン・ホーム永続ボリューム要求を指定します。次に、サンプルのLogstashデプロイメントYAMLを示します:apiVersion: apps/v1 kind: Deployment metadata: name: logstash namespace: wcpns spec: selector: matchLabels: app: logstash template: metadata: labels: app: logstash spec: volumes: - name: domain-storage-volume persistentVolumeClaim: claimName: wcp-domain-domain-pvc - name: shared-logs emptyDir: {} containers: - name: logstash image: logstash:6.6.0 command: ["/bin/sh"] args: ["/usr/share/logstash/bin/logstash", "-f", "/u01/oracle/user_projects/domains/logstash.conf"] imagePullPolicy: IfNotPresent volumeMounts: - mountPath: /u01/oracle/user_projects/domains name: domain-storage-volume - name: shared-logs mountPath: /shared-logs ports: - containerPort: 5044 name: logstashLogstashをデプロイして、Elasticsearchへのログの公開を開始します:

kubectl create -f ${WORKDIR}/logging-services/logstash/logstash.yaml

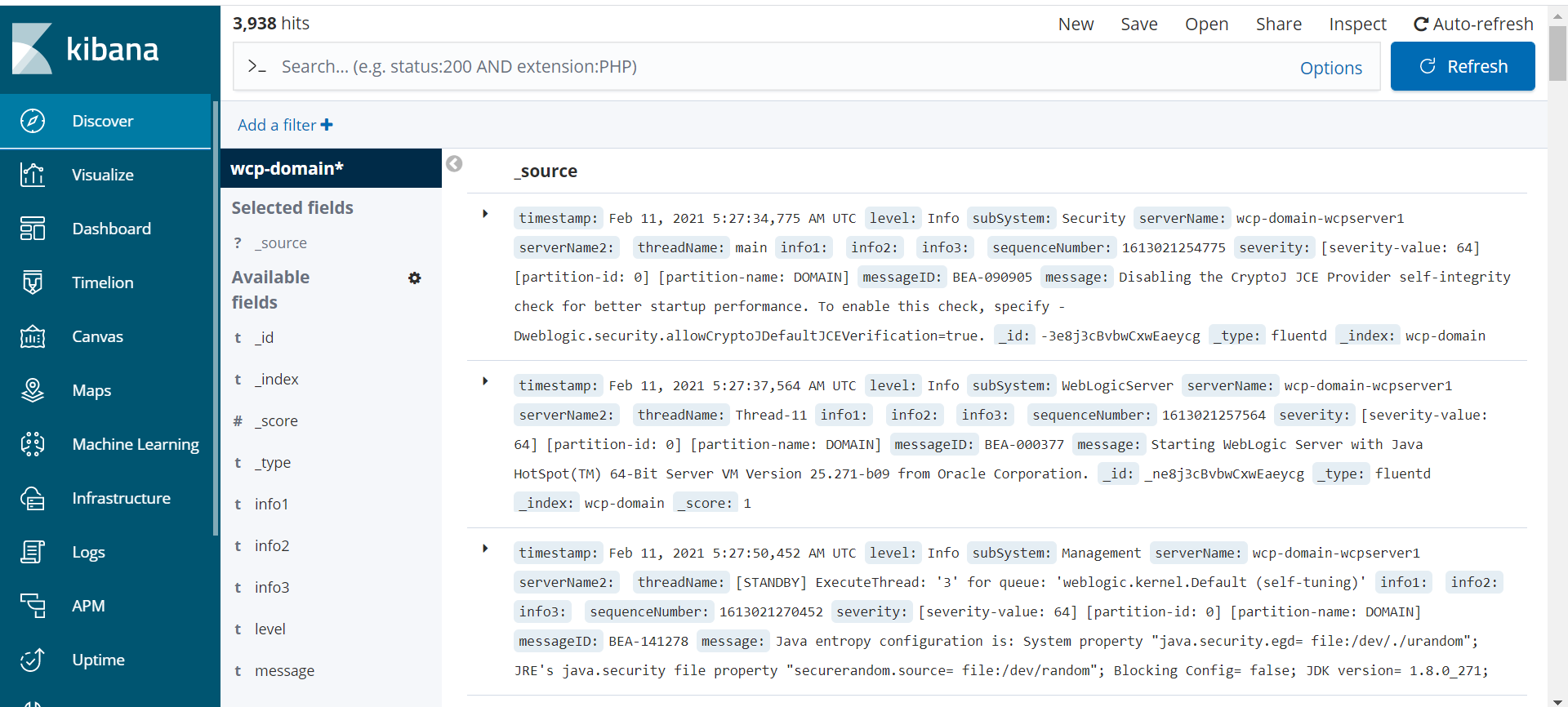

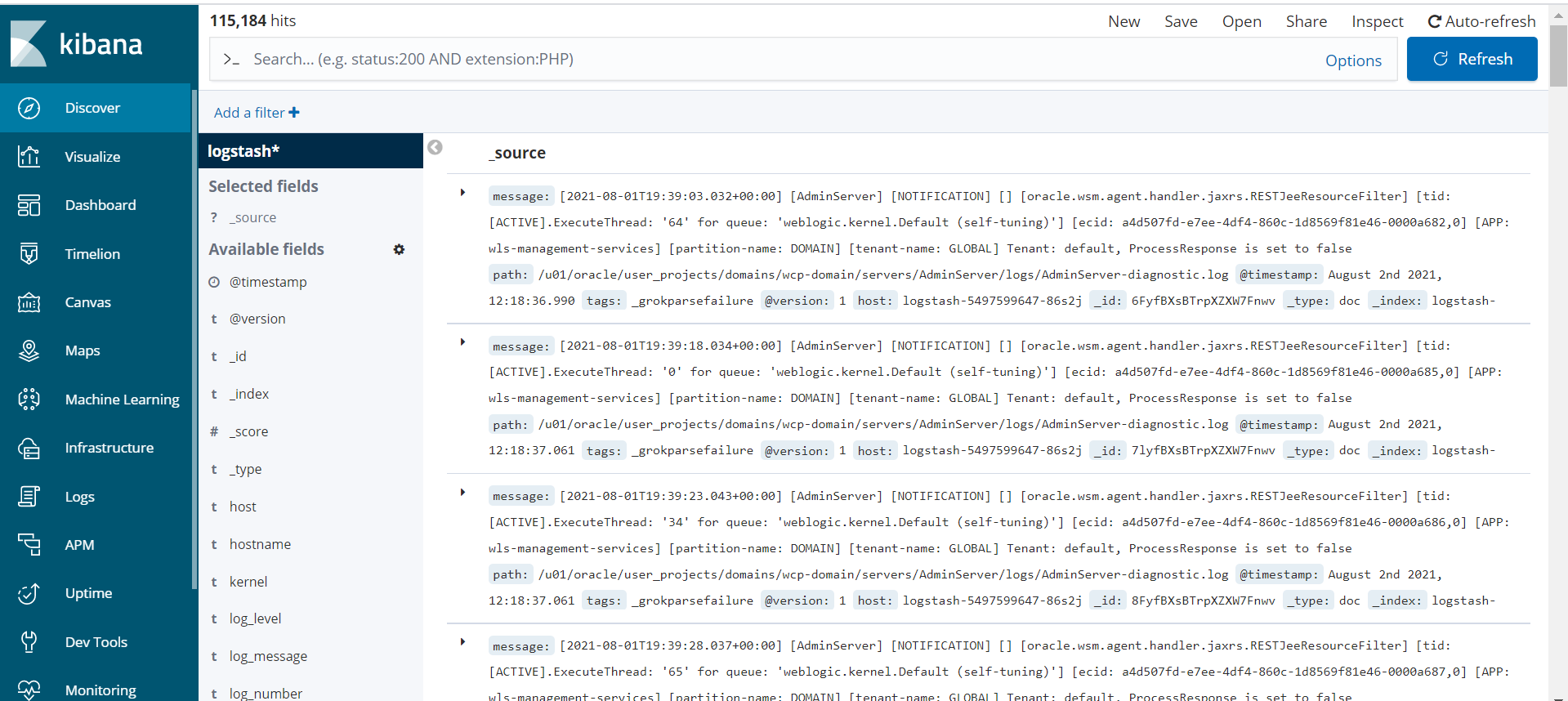

Kibanaでの索引パターンの作成

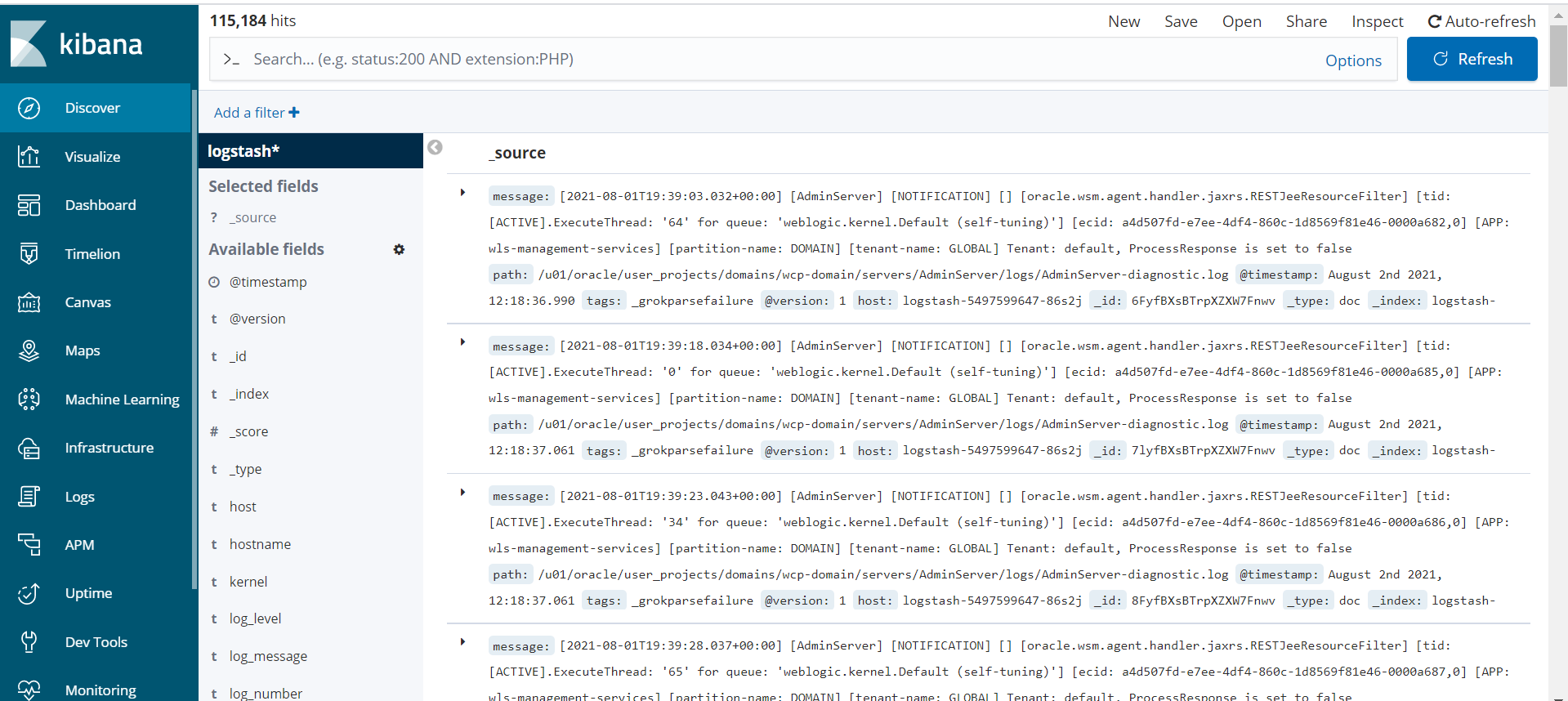

「Kibana」→「Management」で索引パターンlogstash*を作成するには、次のステップに従います。サーバーが起動すると、Kibanaダッシュボードにログ・データが反映されます:

WebLogic Logging Exporterは、ログ・イベント・ハンドラをWebLogic Serverに追加し、Elasticsearch REST APIを使用してKubernetesのElasticsearchにログをプッシュできるようにします。詳細は、WebLogic Logging Exporterプロジェクトを参照してください。

このサンプルでは、WebLogic ServerログをElasticsearchに公開し、Kibanaで表示する方法を示します。オペレータ・ログの公開については、このサンプルを参照してください。

前提条件

このドキュメントでは、ログ収集用にElasticsearchおよびKibanaをすでに設定していることを前提としています。まだ行っていない場合は、このドキュメントを参照してください。

WebLogic Logging Exporterバイナリのダウンロード

事前ビルド済のバイナリは、WebLogic Logging Exporterのリリース・ページで入手できます。

ダウンロード:

- リリース・ページからweblogic-logging-exporter-1.0.0.jar

- Maven Centralからsnakeyaml-1.25.jar

サンプル・コマンドでは次の識別子が使用されます:

* `wcpns`: WebCenter Portal domain namespace

* `wcp-domain`: `domainUID`

* `wcp-domain-adminserver`: Administration Server pod nameWebLogicドメイン・ホームへのJARファイルのコピー

管理サーバー・ポッドのドメイン・ホーム・ディレクトリにweblogic-logging-exporter-1.0.0.jarおよびsnakeyaml-1.25.jarファイルをコピーします。

kubectl cp <file-to-copy> <namespace>/<Administration-Server-pod>:<domainhome> kubectl cp snakeyaml-1.25.jar wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains/wcp-domain/

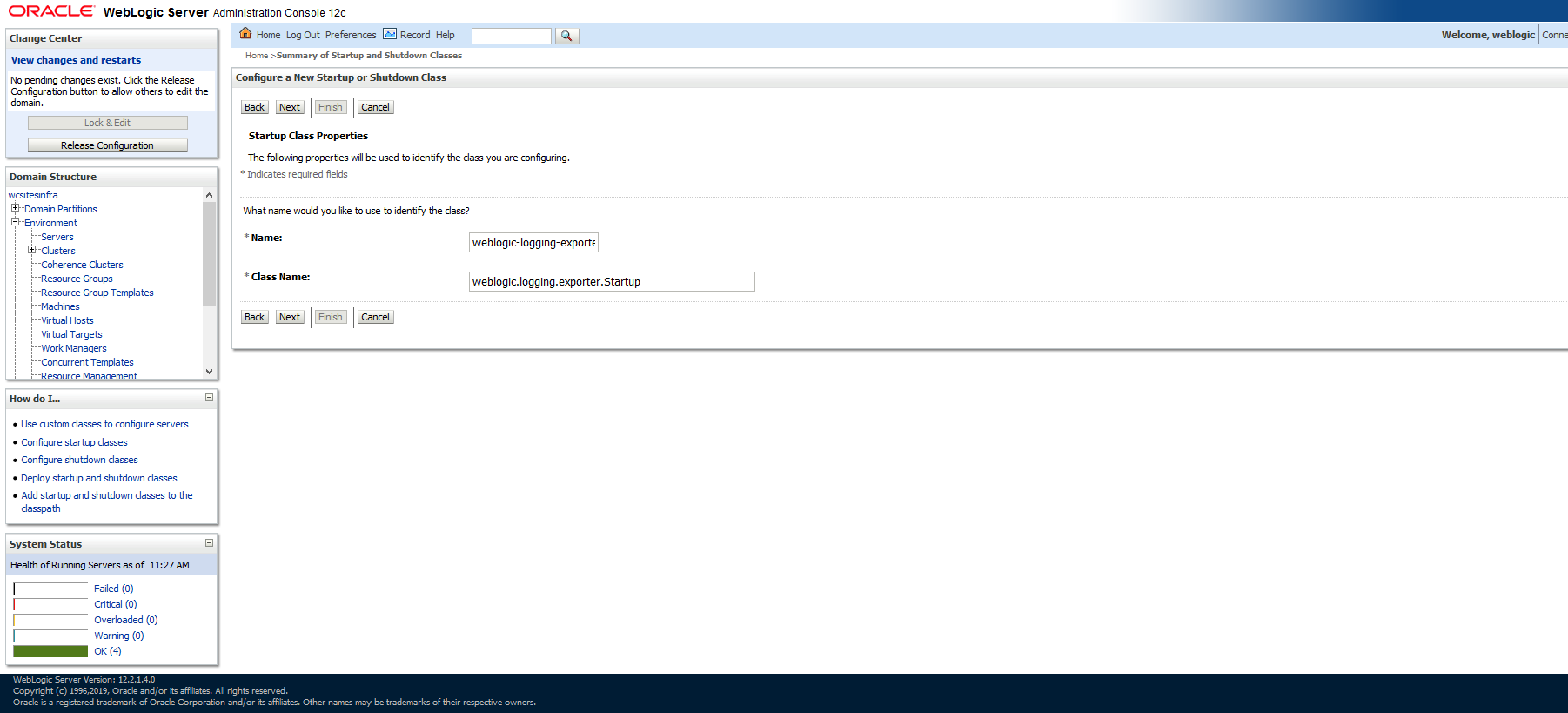

kubectl cp weblogic-logging-exporter-1.0.0.jar wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains/wcp-domain/ドメイン構成への起動クラスの追加

WebLogic Server管理コンソールの左側のナビゲーション・ペインで、「環境」を展開して「起動クラスと停止クラス」を選択します。

新しい起動クラスを追加します。わかりやすい任意の名前を選択できますが、クラス名は

weblogic.logging.exporter.Startupである必要があります。

ログのエクスポート元となる各サーバーに起動クラスをターゲット指定します。

次に示すように、

/u01/oracle/user_projects/domains/wcp-domain/config/config.xmlにあるconfig.xmlに、新しく追加されたstartup-classが存在する必要があります:kubectl exec -it wcp-domain-adminserver -n wcpns cat /u01/oracle/user_projects/domains/wcp-domain/config/config.xml<startup-class> <name>weblogic-logging-exporter</name> <target>AdminServer,wcp_cluster</target> <class-name>weblogic.logging.exporter.Startup</class-name> </startup-class>

WebLogic Server CLASSPATHの更新

setDomainEnv.shファイルをポッドからローカル・フォルダにコピーします:

kubectl cp wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains/wcp-domain/bin/setDomainEnv.sh $PWD/setDomainEnv.sh

tar: Removing leading `/' from member names例外を無視: tar: Removing leading '/' from member names

setDomainEnv.shのサーバー・クラス・パスを更新します:CLASSPATH=/u01/oracle/user_projects/domains/wcp-domain/weblogic-logging-exporter-1.0.0.jar:/u01/oracle/user_projects/domains/wcp-domain/snakeyaml-1.25.jar:${CLASSPATH} export CLASSPATH変更した

setDomainEnv.shファイルをポッドにコピーします:kubectl cp setDomainEnv.sh wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains/wcp-domain/bin/setDomainEnv.sh

WebLogic Logging Exporterの構成ファイルの作成

Elasticsearchサーバーのホストおよびポート番号を次のファイルに指定します:

<$WORKDIR>/logging-services/weblogic-logging-exporter/WebLogicLoggingExporter.yaml例:

weblogicLoggingIndexName: wls publishHost: elasticsearch.default.svc.cluster.local publishPort: 9300 domainUID: wcp-domain weblogicLoggingExporterEnabled: true weblogicLoggingExporterSeverity: TRACE weblogicLoggingExporterBulkSize: 1WebLogicLoggingExporter.yamlファイルをWebLogic管理サーバー・ポッドのドメイン・ホーム・ディレクトリにコピーします:kubectl cp <$WORKDIR>/logging-services/weblogic-logging-exporter/WebLogicLoggingExporter.yaml wcpns/wcp-domain-adminserver:/u01/oracle/user_projects/domains/wcp-domain/config/

ドメイン内のサーバーの再起動

サーバーを再起動するには、次のコマンドを使用してサーバーを停止してから起動します:

サーバーを停止するには:

kubectl patch domain wcp-domain -n wcpns --type='json' -p='[{"op": "replace", "path": "/spec/serverStartPolicy", "value": "NEVER" }]'サーバーを起動するには:

kubectl patch domain wcp-domain -n wcpns --type='json' -p='[{"op": "replace", "path": "/spec/serverStartPolicy", "value": "IF_NEEDED" }]'すべてのサーバーの再起動後、次に示すように、サーバー・ログを参照してweblogic-logging-exporterクラスがコールされていることを確認します:

======================= WebLogic Logging Exporter Startup class called

Reading configuration from file name: /u01/oracle/user_projects/domains/wcp-domain/config/WebLogicLoggingExporter.yaml

Config{weblogicLoggingIndexName='wls', publishHost='domain.host.com', publishPort=9200, weblogicLoggingExporterSeverity='Notice', weblogicLoggingExporterBulkSize='2', enabled=true, weblogicLoggingExporterFilters=FilterConfig{expression='NOT(MSGID = 'BEA-000449')', servers=[]}], domainUID='wcp-domain'}Kibanaでの索引パターンの作成

「Management」オプションを使用してダッシュボードに移動し、Kibanaで索引パターンwls*を作成します。サーバーが起動すると、Kibanaダッシュボードにログ・データが表示されます:

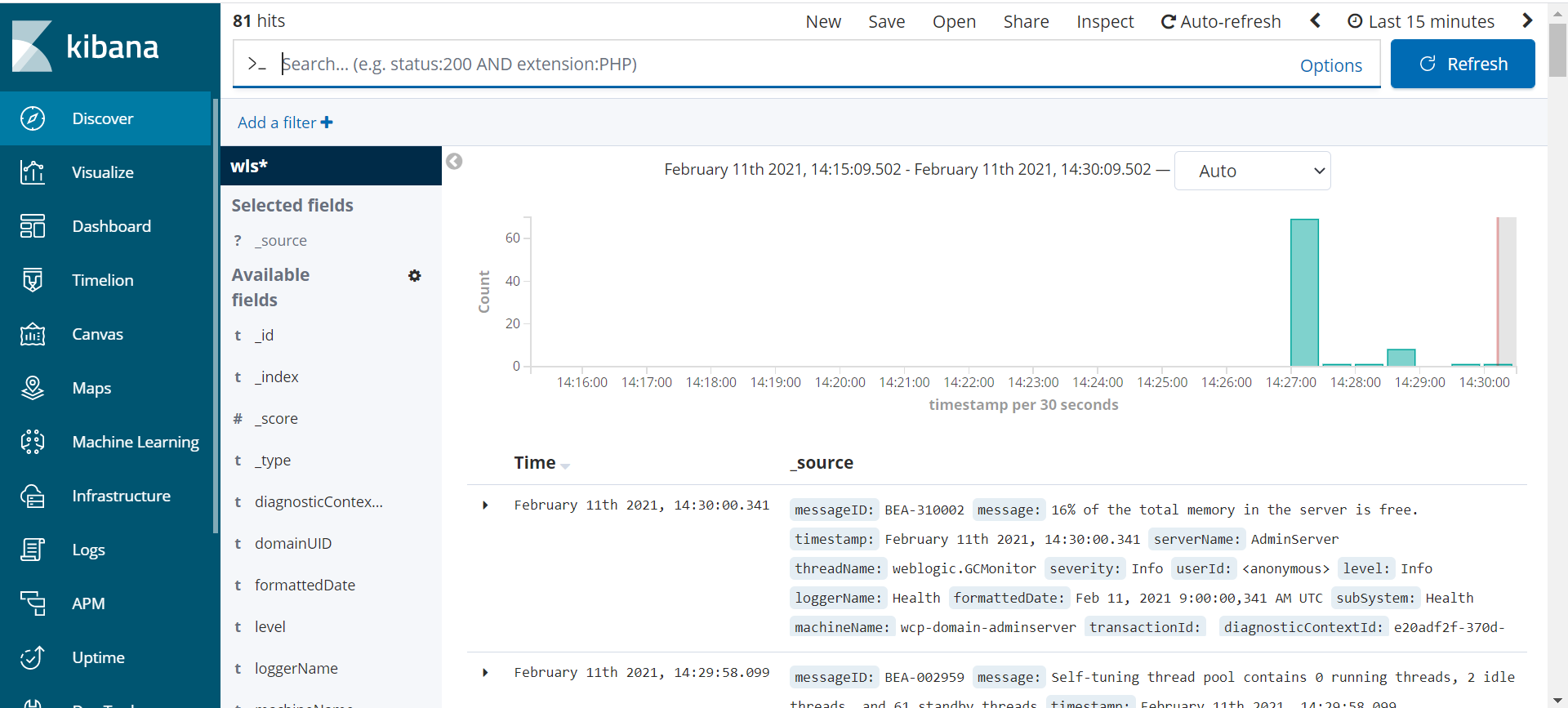

概要

Fluentdを使用するようにWebLogicドメインを構成して、ログ情報をElasticsearchに送信できます。

次に、この仕組みを示します:

fluentdは、管理サーバーおよび管理対象サーバーのポッドで個別のコンテナとして実行されます。- ログ・ファイルは、

weblogic-serverとfluentdのコンテナ間で共有されるボリューム上にあります。 fluentdは、ドメイン・ログ・ファイルを監視し、Elasticsearchにエクスポートします。ConfigMapには、ログ・レコードをエクスポートするためのフィルタおよびフォーマット・ルールが含まれます。

前提条件

既存のWebCenter Portalドメインを編集していることを前提としています。ただし、ドメインを作成する前に、ドメインYAMLに対するすべての変更を行うことができます。Fluentd構成を使用したドメイン定義の完全な例は、このドキュメントの最後にあります。

サンプル・コマンドでは次の識別子が使用されます:

wcpns: WebCenter Portalドメイン・ネームスペースwcp-domain:domainUIDwcp-domain-domain-credentials: Kubernetesシークレット

サンプルのElasticsearch構成は次のとおりです:

elasticsearchhost: elasticsearch.default.svc.cluster.local

elasticsearchport: 9200

elasticsearchuser: username

elasticsearchpassword: passwordElasticsearchホストおよびポートは、ファイル${WORKDIR}/charts/weblogic-operator/values.yamlから参照できます

ElasticsearchおよびKibanaのインストール

ElasticsearchおよびKibanaをインストールするには、次のコマンドを実行します:

cd ${WORKDIR}

kubectl apply -f elasticsearch-and-kibana/elasticsearch_and_kibana.yamlボリュームを使用するためのログ・ファイルの構成

ドメイン・ログ・ファイルは、weblogic-serverとfluentdのコンテナ間で共有できるボリュームに書き込まれる必要があります。これを行うには次の要素が必要です:

logHomeは、コンテナ間で共有できるパスである必要があります。logHomeEnabledは、ログがポッドの外部に書き込まれてポッドの再起動後も保持されるように、trueに設定する必要があります。volumeは、ログ・ファイルが存在する場所に定義する必要があります。この例では、emptyDirはポッドの作成時に作成されるボリュームです。これはポッドの再起動後も保持されますが、ポッドを削除するとemptyDirの内容も削除されます。volumeMountsは、emptyDirで作成された名前付きボリュームをマウントし、ボリュームにアクセスするためのベース・パスを確立します。

ノート: 簡潔にするために、ここでは関連する構成へのパスのみを示します。

たとえば、kubectl edit domain wcp-domain -n wcpnsを実行して、次の編集を行います:

spec:

logHome: /u01/oracle/user_projects/domains/logs/wcp-domain

logHomeEnabled: true

serverPod:

volumes:

- emptyDir: {}

name: weblogic-domain-storage-volume

volumeMounts:

- mountPath: /scratch

name: weblogic-domain-storage-volumeWebLogicドメイン資格証明へのElasticsearchシークレットの追加

fluentdコンテナを構成して、ドメイン資格証明でElasticsearchパラメータを検索します。ドメイン資格証明を編集し、次の例に示すパラメータを追加します。

たとえば、kubectl edit secret wcp-domain-domain-credentials -n wcpnsを実行して、各Elasticsearchパラメータのbase64エンコード値を追加します:

elasticsearchhost: ZWxhc3RpY3NlYXJjaC5kZWZhdWx0LnN2Yy5jbHVzdGVyLmxvY2Fs

elasticsearchport: OTIwMA==

elasticsearchuser: d2NjcmF3bGFkbWlu

elasticsearchpassword: d2VsY29tZTE=Fluentd構成の作成

ドメインのネームスペースにfluentd-configという名前のConfigMapを作成します。ConfigMapには、解析ルールおよびElasticsearch構成が含まれます。

次に、ConfigMapに定義されているいくつかの要素の説明を示します:

@type tailは、tailを使用してログ・ファイルの更新を取得することを示します。pathは、fluentdコンテナに定義されているLOG_PATH環境変数から取得されたログ・ファイルのパスです。tagは、fluentdコンテナに定義されているDOMAIN_UID環境変数から取得されたログ・レコードのタグ値です。<parse>セクションは、ログ・レコードの各要素を解釈およびタグ付けする方法を定義します。<match **>セクションは、Elasticsearchに接続するための構成情報を含んでおり、各レコードの索引名をdomainUIDとして定義します。schemeは、fluentdとElasticsearch間の接続のタイプを示します。

次に、ConfigMapの作成方法の例を示します:

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: ConfigMap

metadata:

labels:

weblogic.domainUID: wcp-domain