6 Erste Schritte mit der Benutzeroberfläche von AutoML

Die AutoML-Benutzeroberfläche (AutoML UI) ist eine Oracle Machine Learning-Schnittstelle, die Ihnen die automatische Modellierung des maschinellen Lernens ohne Code bietet. Wenn Sie ein Experiment in der Benutzeroberfläche von AutoML erstellen und ausführen, werden automatisierte Algorithmenauswahl, Featureauswahl und Modelloptimierung ausgeführt. Dadurch wird die Produktivität erhöht und die Modellgenauigkeit und -performance potenziell erhöht.

Die folgenden Schritte umfassen einen Modellierungsworkflow für maschinelles Lernen und werden von der Benutzeroberfläche AutoML automatisiert:

- Algorithmusauswahl: Sortiert Algorithmen, die wahrscheinlich ein genaueres Modell basierend auf dem Dataset und seinen Eigenschaften und einigen prädiktiven Features des Datasets für jeden Algorithmus erstellen.

- Adaptive Sampling: Findet ein geeignetes Datenbeispiel. Ziel dieser Phase ist es, die Phasen Feature Selection und Model Tuning zu beschleunigen, ohne die Modellqualität zu beeinträchtigen.

- Featureauswahl: Wählt eine Teilmenge von Features aus, die für das Ziel am vorausschauendsten sind. Ziel dieser Phase ist es, die Anzahl der in den späteren Pipelinephasen verwendeten Features zu reduzieren, insbesondere während der Modelloptimierungsphase, um die Pipeline zu beschleunigen, ohne die Vorhersagegenauigkeit zu beeinträchtigen.

- Modelloptimierung: Ziel ist es, die individuelle Algorithmusmodellqualität basierend auf der ausgewählten Metrik für jeden der in der engeren Auswahl stehenden Algorithmen zu erhöhen.

- Auswirkung der Featurevorhersage: Dies ist die letzte Phase in der UI-Pipeline AutoML. Hier wird die Auswirkung jeder Eingabespalte auf die Vorhersagen des endgültigen optimierten Modells berechnet. Die berechnete Vorhersageauswirkung liefert Einblicke in das Verhalten des optimierten AutoML-Modells.

- Modelle für Machine Learning erstellen

- Bereitstellen von ML-Modellen

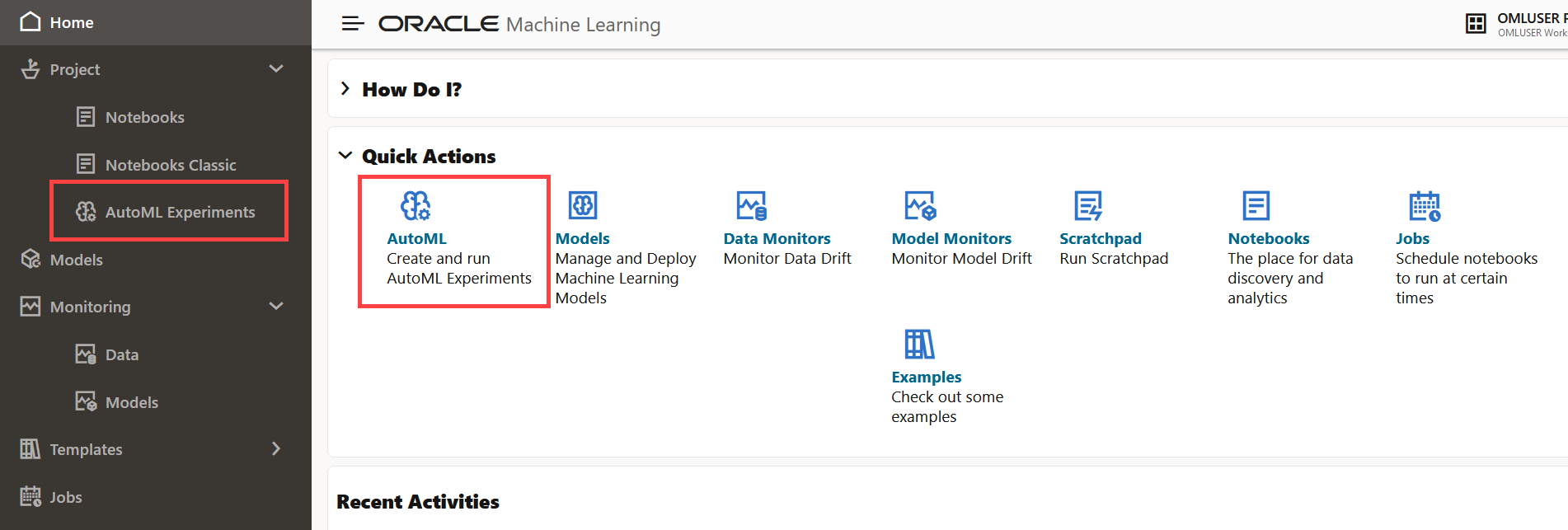

AutoML UI-Experimente

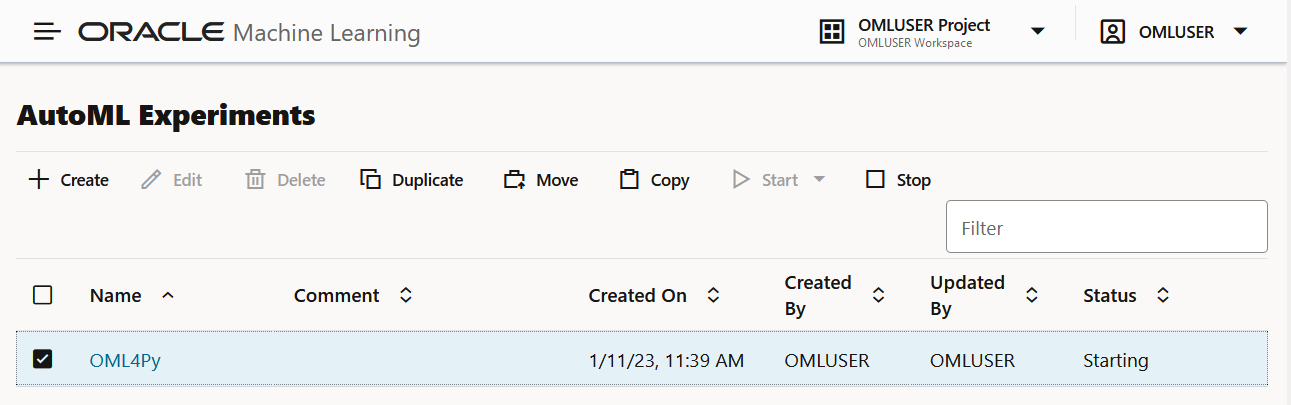

Wenn Sie ein Experiment in der Benutzeroberfläche von AutoML erstellen, werden automatisch alle Schritte im Workflow für maschinelles Lernen ausgeführt. Auf der Seite Experimente werden alle von Ihnen erstellten Experimente aufgeführt. Klicken Sie auf ein Experiment, um Details zum Experiment anzuzeigen. Darüber hinaus haben Sie folgende Möglichkeiten:

Abbildung 6-1 Seite "Experimente"

- Erstellen: Klicken Sie auf Erstellen, um ein neues UI-Experiment für AutoML zu erstellen. Das von Ihnen erstellte UI-Experiment AutoML befindet sich im Projekt, das Sie im Projekt unter dem Workspace ausgewählt haben.

- Bearbeiten: Wählen Sie ein beliebiges Experiment aus, das hier aufgeführt wird, und klicken Sie auf Bearbeiten, um die Experimentdefinition zu bearbeiten.

- Löschen: Wählen Sie ein beliebiges hier aufgeführtes Experiment aus, und klicken Sie auf Löschen, um es zu löschen. Sie können ein laufendes Experiment nicht löschen. Sie müssen das Experiment zuerst stoppen, um es zu löschen.

- Doppeln: Wählen Sie ein Experiment aus, und klicken Sie auf Doppeln, um eine Kopie davon zu erstellen. Das Experiment wird sofort dupliziert und befindet sich im Status "Bereit".

- Verschieben: Wählen Sie ein Experiment aus, und klicken Sie auf Verschieben, um das Experiment in ein anderes Projekt in demselben oder einem anderen Workspace zu verschieben. Sie benötigen entweder die Berechtigung

AdministratoroderDeveloper, um Experimente über Projekte und Workspaces hinweg zu verschieben.Hinweis:

Ein Experiment kann nicht verschoben werden, wenn es den Status RUNNING, STOPPING oder STARTING aufweist oder wenn bereits ein Experiment mit demselben Namen im Zielprojekt vorhanden ist. - Kopieren: Wählen Sie ein Experiment aus, und klicken Sie auf Kopieren, um das Experiment in ein anderes Projekt in demselben oder einem anderen Workspace zu kopieren.

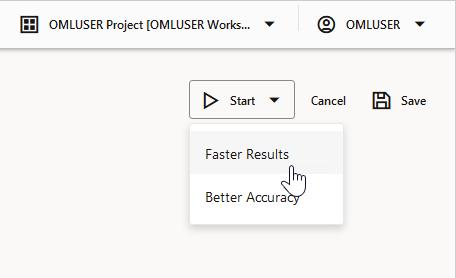

- Starten: Wenn Sie ein Experiment erstellt, es jedoch nicht ausgeführt haben, klicken Sie auf Starten, um das Experiment auszuführen.

- Stoppen: Wählen Sie ein aktives Experiment, und klicken Sie auf Stoppen, um die Ausführung des Experiments zu stoppen.

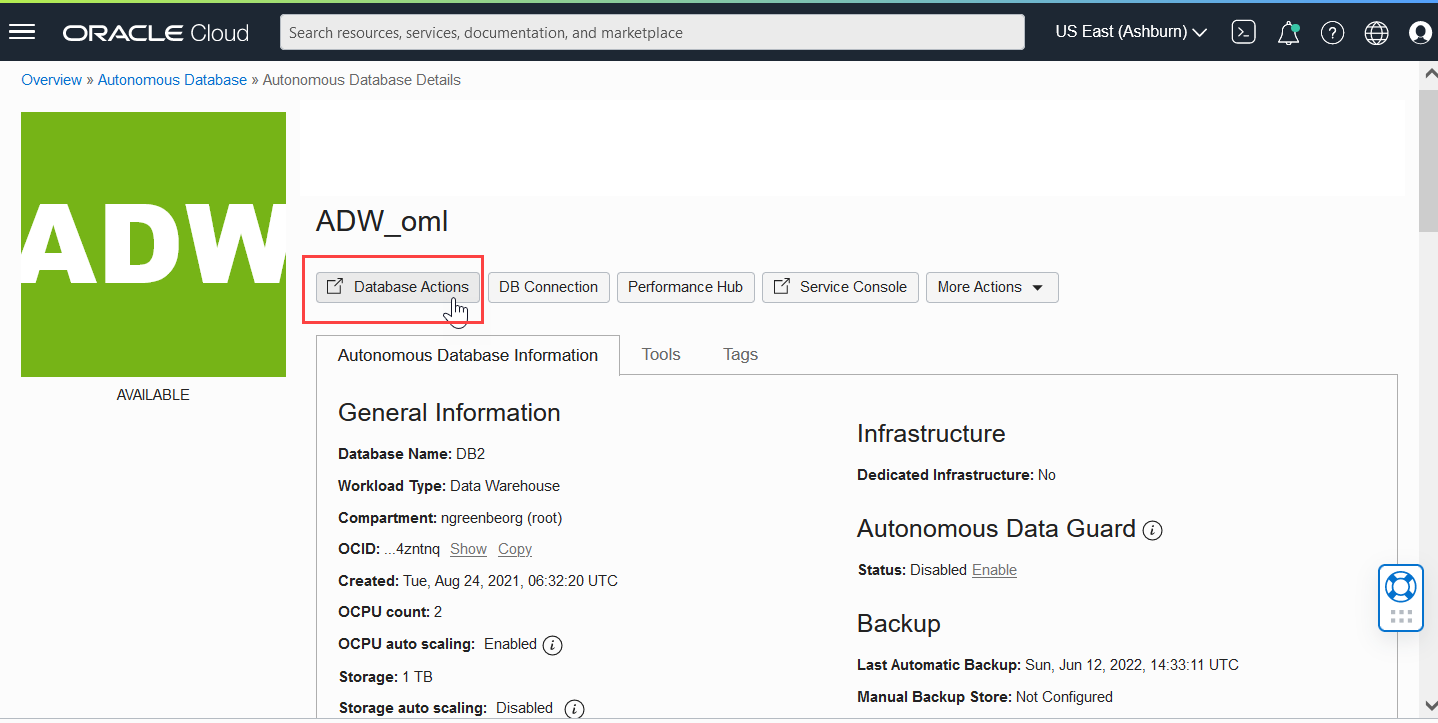

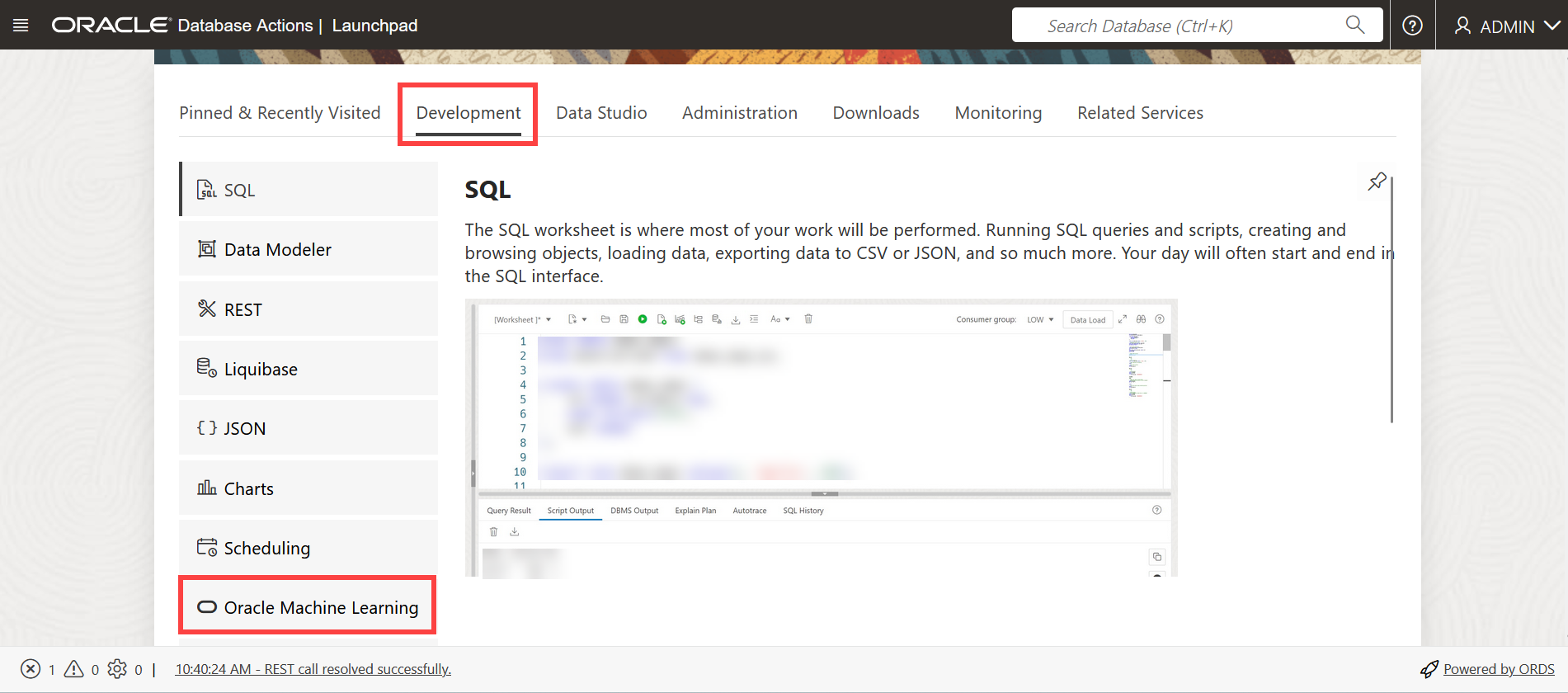

- Zugriff auf die Benutzeroberfläche von AutoML

Sie können über Oracle Machine Learning Notebooks auf die Benutzeroberfläche von AutoML zugreifen. - UI-Experiment AutoML erstellen

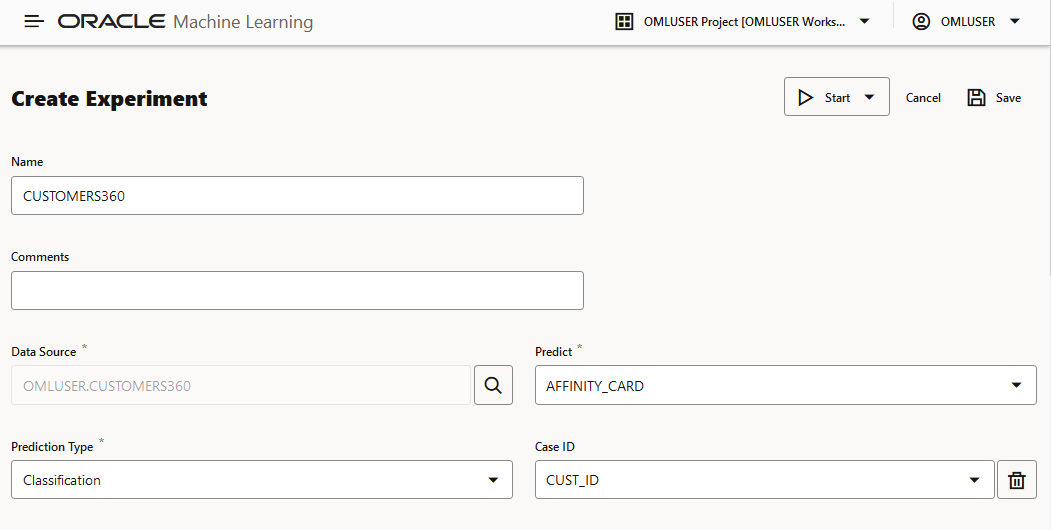

Um die Oracle Machine Learning AutoML UI zu verwenden, erstellen Sie zunächst ein Experiment. Ein Experiment ist eine Arbeitseinheit, die Datenquelle, Vorhersageziel und Vorhersagetyp minimal angibt. Nachdem ein Experiment erfolgreich ausgeführt wurde, wird eine Liste der Modelle für maschinelles Lernen in der Reihenfolge der Modellqualität gemäß der ausgewählten Metrik angezeigt. Sie können eines dieser Modelle für das Deployment auswählen oder ein Notizbuch generieren. Das generierte Notizbuch enthält Python-Code mit OML4Py und die spezifischen Einstellungen AutoML, mit denen das Modell erstellt wird. - Experiment anzeigen

Auf der Seite "UI-Experimente" in AutoML werden alle von Ihnen erstellten Experimente aufgeführt. Jedes Experiment befindet sich in einer der folgenden Phasen: Abgeschlossen, Laufen und Bereit.

Verwandte Themen

6.1 Zugriff auf die Benutzeroberfläche von AutoML

Sie können über Oracle Machine Learning Notebooks auf die Benutzeroberfläche von AutoML zugreifen.

Übergeordnetes Thema: Erste Schritte mit der Benutzeroberfläche von AutoML

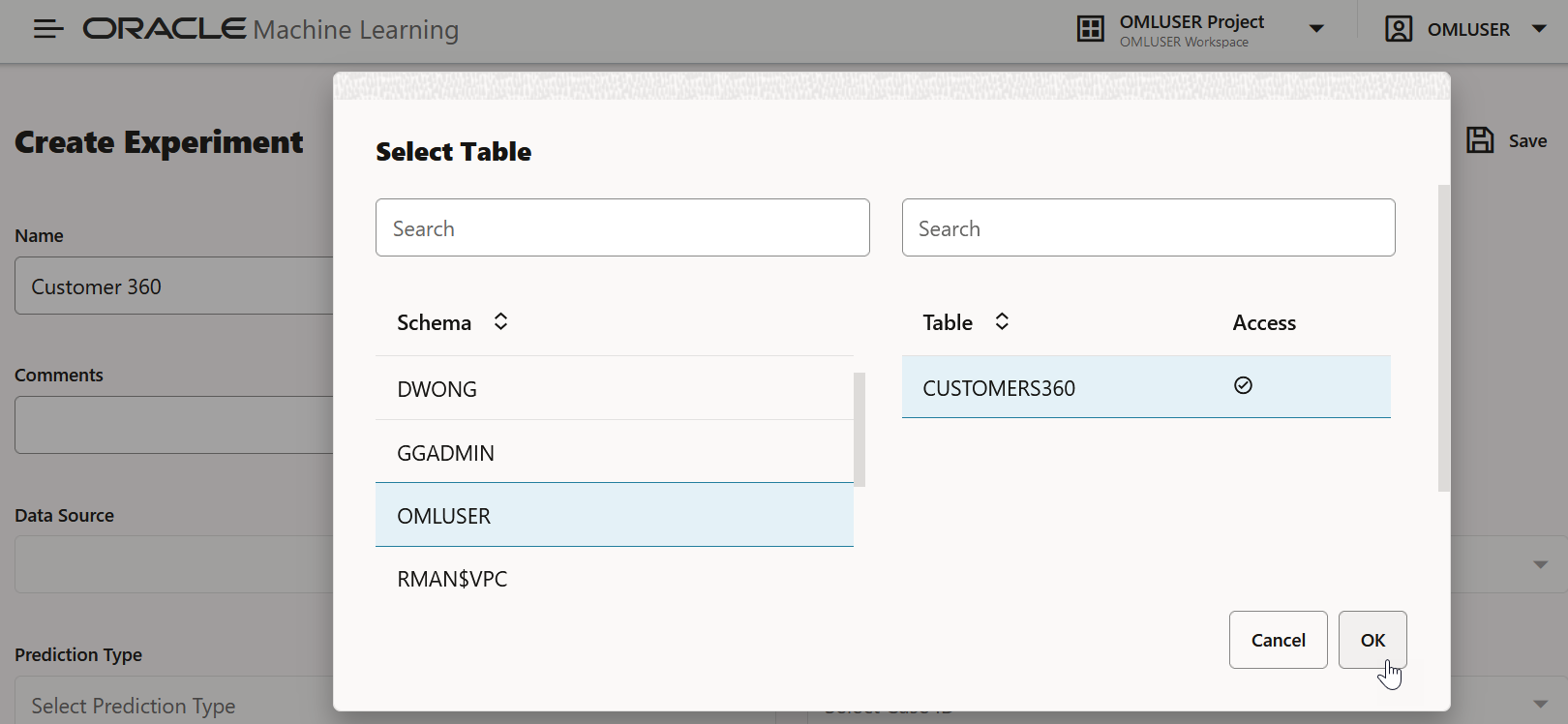

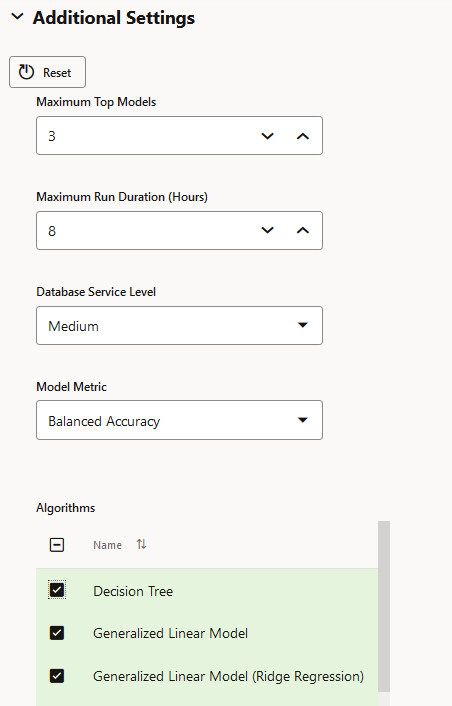

6.2 Benutzeroberflächenexperiment AutoML erstellen

Um die Oracle Machine Learning AutoML UI zu verwenden, erstellen Sie zunächst ein Experiment. Ein Experiment ist eine Arbeitseinheit, die Datenquelle, Vorhersageziel und Vorhersagetyp minimal angibt. Nachdem ein Experiment erfolgreich ausgeführt wurde, wird eine Liste der Modelle für maschinelles Lernen in der Reihenfolge der Modellqualität gemäß der ausgewählten Metrik angezeigt. Sie können eines dieser Modelle für das Deployment auswählen oder ein Notizbuch generieren. Das generierte Notizbuch enthält Python-Code mit OML4Py und die spezifischen Einstellungen AutoML, mit denen das Modell erstellt wird.

- Unterstützte Datentypen für AutoML-UI-Experimente

Wenn Sie ein AutoML-Experiment erstellen, müssen Sie die Datenquelle und das Ziel des Experiments angeben. In diesem Thema werden die Datentypen für Python und SQL aufgeführt, die von AutoML-Experimenten unterstützt werden.

Übergeordnetes Thema: Erste Schritte mit der Benutzeroberfläche von AutoML

6.2.1 Unterstützte Datentypen für UI-Experimente AutoML

Beim Erstellen eines AutoML-Experiments müssen Sie die Datenquelle und das Ziel des Experiments angeben. In diesem Thema werden die Datentypen für Python und SQL aufgeführt, die von AutoML-Experimenten unterstützt werden.

Tabelle 6-1: Unterstützte Datentypen durch AutoML-Experimente

| Datentypen | SQL-Datentypen | Python-Datentypen |

|---|---|---|

| Numerisch | NUMBER, INTEGER, FLOAT, BINARY_DOUBLE, NUMBER, BINARY_FLOAT, DM_NESTED_NUMERICALS, DM_NESTED_BINARY_DOUBLES, DM_NESTED_BINARY_FLOATS |

|

| Kategorisch |

|

|

| Unstrukturierter Text |

|

|

Übergeordnetes Thema: UI-Experiment AutoML erstellen

6.3 Experiment anzeigen

Auf der Seite "UI-Experimente AutoML" werden alle von Ihnen erstellten Experimente aufgeführt. Jedes Experiment befindet sich in einer der folgenden Phasen: Abgeschlossen, Laufen und Bereit.

Um ein Experiment anzuzeigen, klicken Sie auf den Namen des Experiments. Auf der Seite "Experiment" werden die Details des ausgewählten Experiments angezeigt. Folgende Abschnitte werden angezeigt:

Experiment bearbeiten

Hinweis:

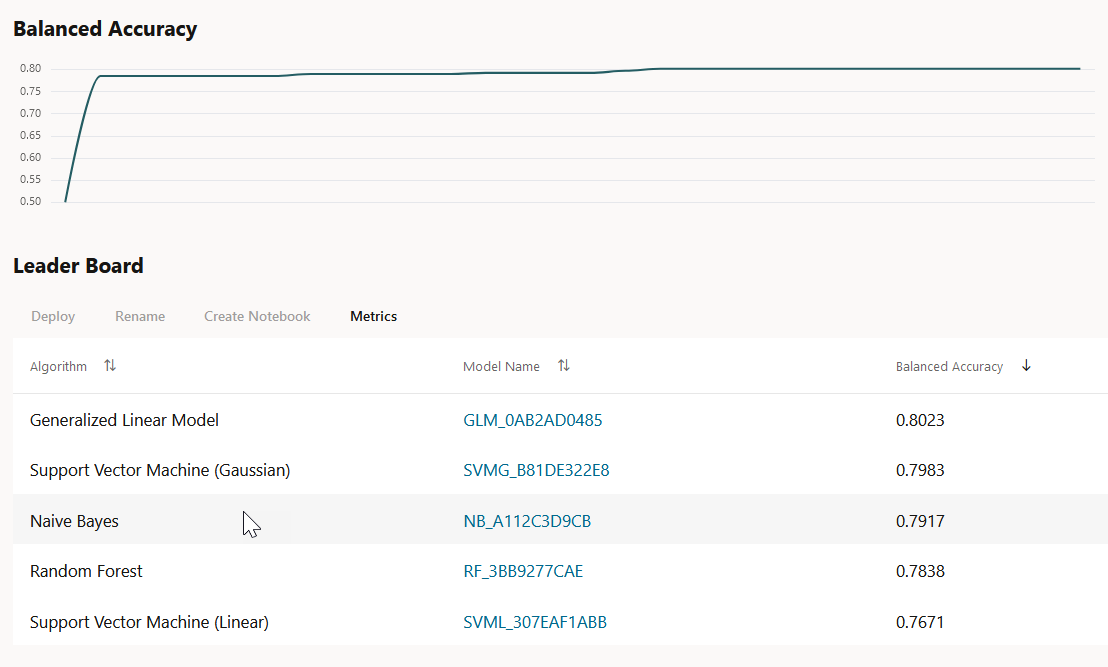

Sie können ein laufendes Experiment nicht bearbeiten.Metrikdiagramm

Das Modellmetrikdiagramm zeigt den besten Metrikwert im Laufe der Zeit, während das Experiment ausgeführt wird. Es zeigt eine Verbesserung der Genauigkeit im Laufe des Experiments. Der Anzeigename hängt von der ausgewählten Modellmetrik ab, wenn Sie das Experiment erstellen.

Leaderboard

Abbildung 6-10 Leaderboard

- Modelldetails anzeigen: Klicken Sie auf den Modellnamen, um die Details anzuzeigen. Die Modelldetails werden im Dialogfeld Modelldetails angezeigt. Sie können in der Leaderboard auf mehrere Modelle klicken und die Modelldetails gleichzeitig anzeigen. Das Fenster Modelldetails zeigt Folgendes:

- Vorhersageauswirkung: Zeigt die Wichtigkeit der Attribute in Bezug auf die Zielvorhersage der Modelle an.

- Konfusionsmatrix: Zeigt die unterschiedliche Kombination aus Ist- und Vorhersagewerten durch den Algorithmus in einer Tabelle an. Die Konfusionsmatrix dient als Leistungsmessung des Algorithmus für maschinelles Lernen.

- Bereitstellen: Wählen Sie ein beliebiges Modell in der Leaderboard aus, und klicken Sie auf Bereitstellen, um das ausgewählte Modell bereitzustellen. Modell bereitstellen.

- Umbenennen: Klicken Sie auf Umbenennen, um den Namen des vom System generierten Modellnamens zu ändern. Der Name muss alphanumerisch sein (maximal 123 Zeichen) und darf keine Leerzeichen enthalten.

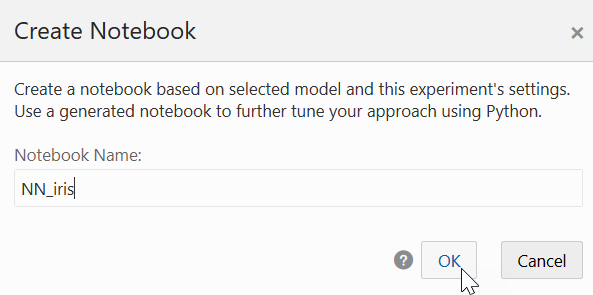

- Notizbuch erstellen: Wählen Sie ein beliebiges Modell in der Rangliste aus, und klicken Sie auf Notizbücher aus AutoML UI-Modellen erstellen, um das ausgewählte Modell aus dem Code neu zu erstellen.

- Metriken: Klicken Sie auf Metriken, um weitere Metriken auszuwählen, die in der Rangliste angezeigt werden sollen. Die zusätzlichen Metriken sind:

- Für Klassifizierung

- Genauigkeit: Berechnet den Anteil der Fälle korrekt klassifiziert - positiv und negativ. Beispiel: Wenn insgesamt TP (True Positives) + TN (True Negatives) korrekt klassifizierte Fälle von TP + TN + FP + FN (True Positives+True Negatives+False Positives+False Negatives) vorliegen, lautet die Formel:

Accuracy = (TP+TN)/(TP+TN+FP+FN) - Ausgewogene Genauigkeit: Bewertet, wie gut ein binärer Klassifikator ist. Es ist besonders nützlich, wenn die Klassen unausgewogen sind, das heißt, wenn eine der beiden Klassen viel häufiger auftritt als die andere. Dies geschieht oft in vielen Einstellungen wie Anomalieerkennung usw.

- Rückruf: Berechnet den Anteil der tatsächlichen Positiven, die korrekt klassifiziert sind.

- Genauigkeit: Berechnet den Anteil der vorhergesagten positiven Ergebnisse, der wahr positiv ist.

- F1 Score: Kombiniert Genauigkeit und Rückruf in einer einzelnen Zahl. F1-Score wird mit harmonischem Mittel berechnet, das durch die Formel berechnet wird:

F1-score = 2 × (precision × recall)/(precision + recall)

- Genauigkeit: Berechnet den Anteil der Fälle korrekt klassifiziert - positiv und negativ. Beispiel: Wenn insgesamt TP (True Positives) + TN (True Negatives) korrekt klassifizierte Fälle von TP + TN + FP + FN (True Positives+True Negatives+False Positives+False Negatives) vorliegen, lautet die Formel:

- Für Regression:

- R2 (Standard): Eine statistische Kennzahl, die berechnet, wie nah die Daten an der angepassten Regressionslinie liegen. Im Allgemeinen, je höher der Wert von R-Quadrat, desto besser passt das Modell zu Ihren Daten. Der Wert von R2 liegt immer zwischen 0 und 1, wobei:

0gibt an, dass das Modell keine Variabilität der Antwortdaten um den Mittelwert erklärt.1gibt an, dass das Modell die gesamte Variabilität der Antwortdaten um den Mittelwert erklärt.

- Negative Mean Squared Error: Dies ist der Mittelwert der quadratischen Differenz von vorhergesagten und wahren Zielen.

- Negativer mittlerer absoluter Fehler: Dies ist der Mittelwert der absoluten Differenz von prognostizierten und wahren Zielen.

- Negativer mittlerer absoluter Fehler: Dies ist der Median der absoluten Differenz zwischen prognostizierten und echten Zielen.

- R2 (Standard): Eine statistische Kennzahl, die berechnet, wie nah die Daten an der angepassten Regressionslinie liegen. Im Allgemeinen, je höher der Wert von R-Quadrat, desto besser passt das Modell zu Ihren Daten. Der Wert von R2 liegt immer zwischen 0 und 1, wobei:

- Für Klassifizierung

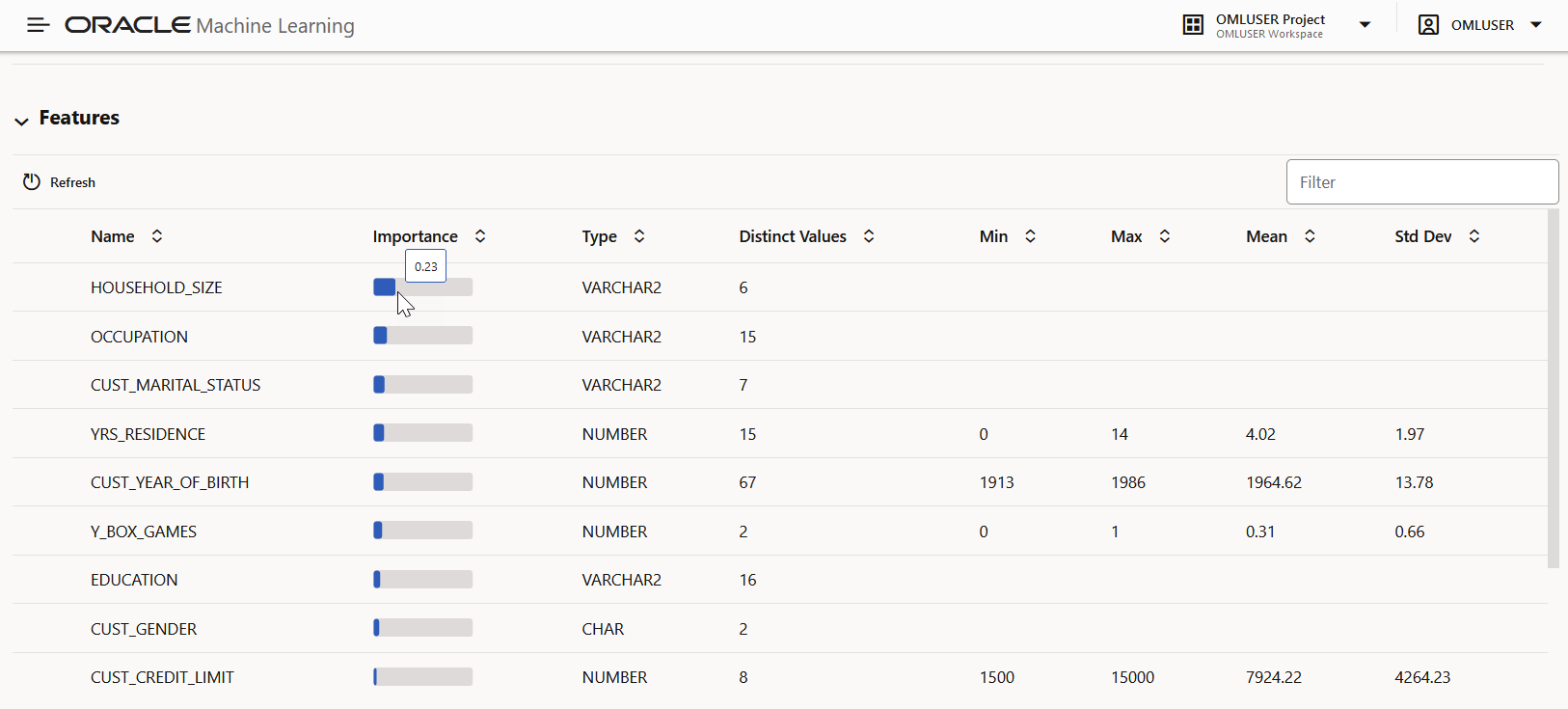

Features

0 bis 1 dargestellt, wobei Werte, die näher an 1 liegen, wichtiger sind.

Abbildung 6-11 Features

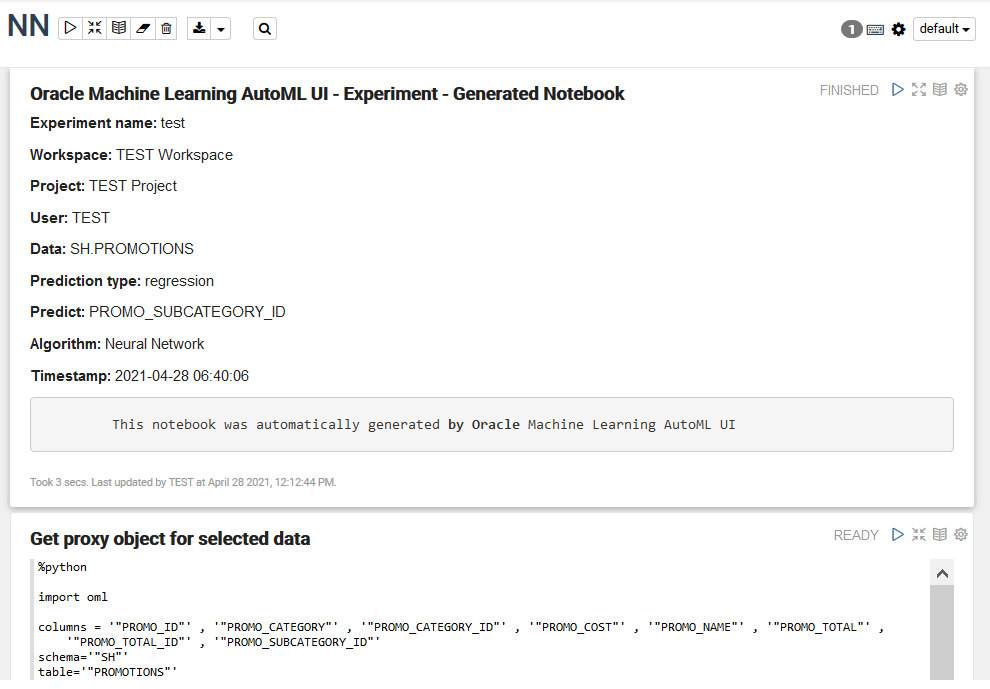

- Notizbücher aus AutoML UI-Modellen erstellen

Sie können Notizbücher mit dem Code OML4Py erstellen, der das ausgewählte Modell mit denselben Einstellungen neu erstellt. Außerdem wird veranschaulicht, wie Daten mit dem Modell bewertet werden. Diese Option ist hilfreich, wenn Sie mit dem Code ein ähnliches Modell für maschinelles Lernen neu erstellen möchten.

Übergeordnetes Thema: Erste Schritte mit der Benutzeroberfläche von AutoML

6.3.1 Notizbücher aus UI-Modellen von AutoML erstellen

Sie können Notizbücher mit dem Code OML4Py erstellen, der das ausgewählte Modell mit denselben Einstellungen neu erstellt. Außerdem wird veranschaulicht, wie Daten mit dem Modell bewertet werden. Diese Option ist hilfreich, wenn Sie mit dem Code ein ähnliches Modell für maschinelles Lernen neu erstellen möchten.

Übergeordnetes Thema: Experiment anzeigen