Hinweis:

- Dieses Tutorial erfordert Zugriff auf Oracle Cloud. Informationen zur Registrierung für einen kostenlosen Account finden Sie unter Erste Schritte mit Oracle Cloud Infrastructure Free Tier.

- Es verwendet Beispielwerte für Oracle Cloud Infrastructure-Zugangsdaten, -Mandanten und -Compartments. Ersetzen Sie diese Werte nach Abschluss der Übung durch Werte, die für Ihre Cloud-Umgebung spezifisch sind.

Bare-Metal-GPU-Knoten mit einem OCI-Stack als selbstverwaltete Knoten in OKE migrieren

Einführung

In diesem Tutorial werden wir den Prozess der Migration von Bare Metal-(BM-)GPU-Knoten zu selbstverwalteten Oracle Cloud Infrastructure Kubernetes Engine-(OKE-)Knoten mit einem Oracle Cloud Infrastructure-(OCI-)Stack durchgehen.

Lassen Sie uns zunächst verstehen, was selbstverwaltete Knoten sind und warum sie ideal für die Ausführung von GPUs auf OKE geeignet sind.

Was sind OKE-Selbstverwaltete Knoten?

Wie der Name schon sagt, werden selbstverwaltete Knoten vollständig vom Kunden kontrolliert und verwaltet. Dazu gehören Provisioning-, Skalierungs-, Konfigurations-, Upgrade- und Wartungsaufgaben wie Betriebssystem-Patching und Knotenersetzung. Dieser Ansatz erfordert zwar mehr manuelle Verwaltung, bietet jedoch maximale Flexibilität und Kontrolle und eignet sich daher für spezialisierte Workloads, wie sie auf GPUs ausgeführt werden.

Wichtige Features von selbstverwalteten Knoten:

-

Vollständige Kontrolle: Der Kunde hat die vollständige Kontrolle über den Knotenlebenszyklus, einschließlich Provisioning, BS-Updates, Skalierung und Beendigung.

-

Benutzerdefinierte Konfigurationen: Der Kunde kann benutzerdefinierte Images verwenden, bestimmte Software installieren, Networking konfigurieren oder alternative Instanztypen verwenden.

-

Manuelle Upgrades: Im Gegensatz zu OKE-verwalteten Knotenpools muss der Kunde Kubernetes-Versionen, Sicherheitspatches und BS-Updates manuell upgraden.

-

Eigene Knoten bereithalten (BYON): Der Kunde kann vorhandene OCI Compute-Instanzen als Worker-Knoten in einem OKE-Cluster verwenden.

-

Kein automatisches Knoten-Cycling: Wenn ein Knoten ausfällt, muss er vom Kunden manuell ersetzt/zykliert werden.

Dieses Tutorial behandelt einen Anwendungsfall, bei dem BM A100-GPU-Workloads derzeit auf einem Slurm-Cluster in OCI ausgeführt werden, mit dem Ziel, sie zu einem OKE-Cluster zu migrieren. Dies kann mit dem OKE-Stack (High Performance Computing, HPC) erreicht werden, um ein leeres OKE-Cluster bereitzustellen und dann die vorhandenen GPU-Knoten hinzuzufügen.

Ziele

- Migrieren Sie BM-A100-GPU-Knoten mit dem HPC-OKE-Stack als selbstverwaltete Knoten zu OKE.

Voraussetzungen

-

Administratorzugriff auf einen ausgeführten OCI-Mandanten und OKE-Cluster.

-

Installieren Sie NVIDIA Run:ai auf BM A100-Knoten, um die Anwendungen zu containerisieren. Weitere Informationen finden Sie unter NVIDIA-Ausführung:ai.

-

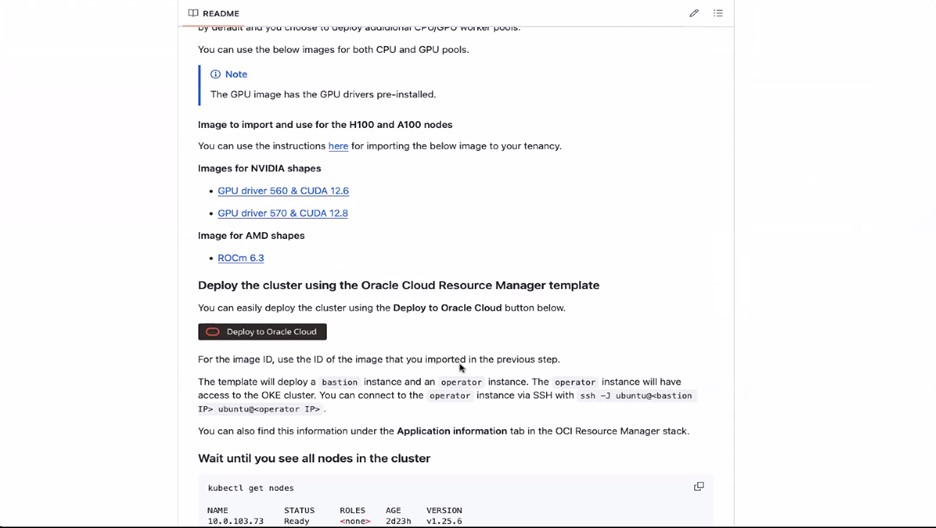

Führen Sie RDMA-(Remote Direct Memory Access-)GPU-Workloads auf OKE aus. Weitere Informationen finden Sie unter Ausführen von RDMA-(Remote Direct Memory Access-)GPU-Workloads auf OKE.

Aufgabe 1: BM-A100-GPU-Knoten mit HPC OKE-Stack in OKE migrieren

-

Melden Sie sich bei der OCI-Konsole an, und erstellen Sie die erforderlichen Policys, wie auf dieser Seite GitHub erwähnt: RDMA-(Remote Direct Memory Access-)GPU-Workloads auf OKE ausführen.

-

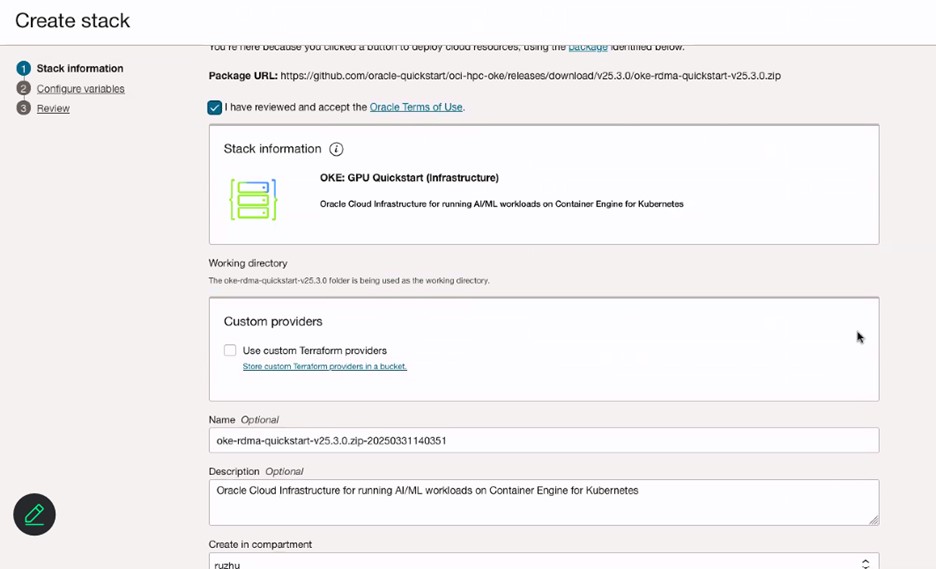

Klicken Sie auf In Oracle Cloud bereitstellen, und prüfen Sie die Vertragsbedingungen.

-

Wählen Sie die Region aus, in der der Stack bereitgestellt werden soll.

-

Geben Sie auf der Seite Stackinformationen den Namen für den Stack ein.

-

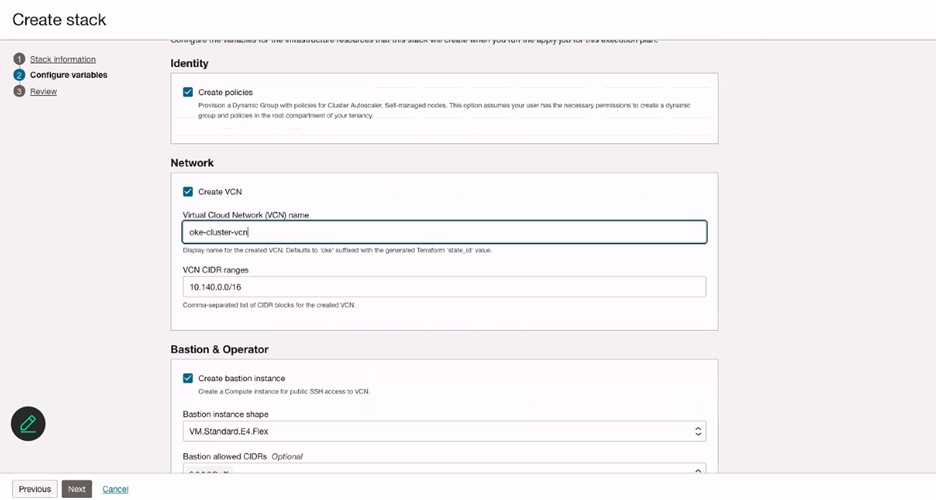

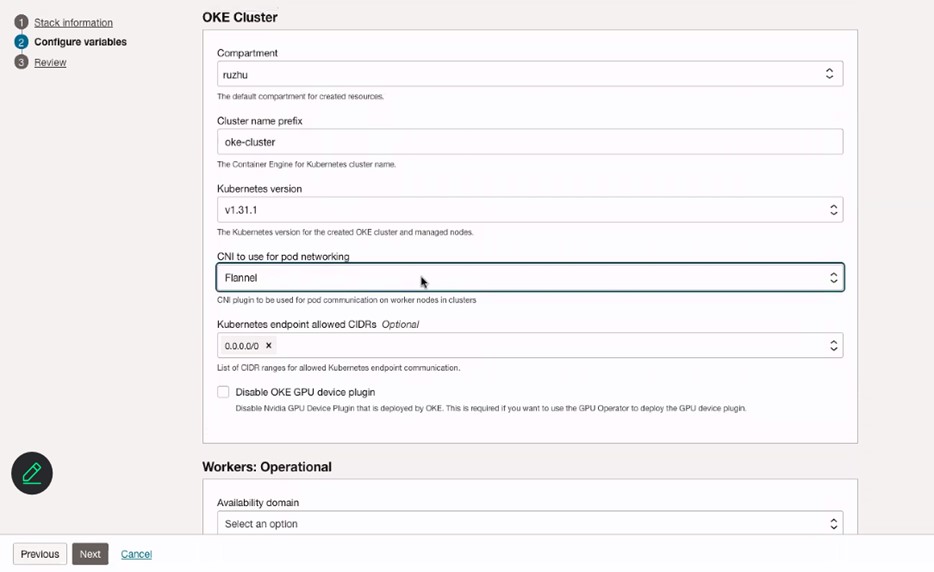

Geben Sie auf der Seite Variable konfigurieren den Namen für das VCN ein.

-

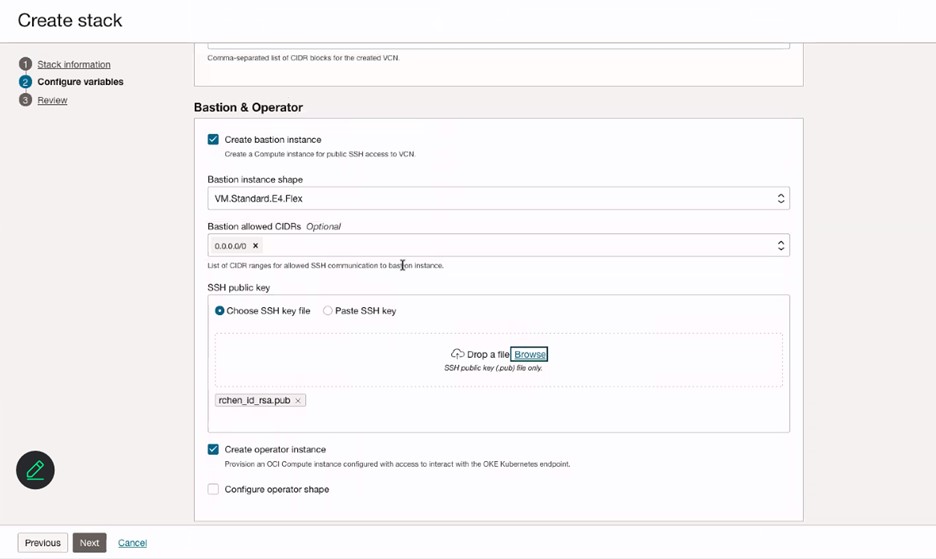

Geben Sie im Abschnitt Bastion und Operator die Informationen der Bastioninstanz ein, und fügen Sie einen SSH-Schlüssel für die Bastioninstanz hinzu.

-

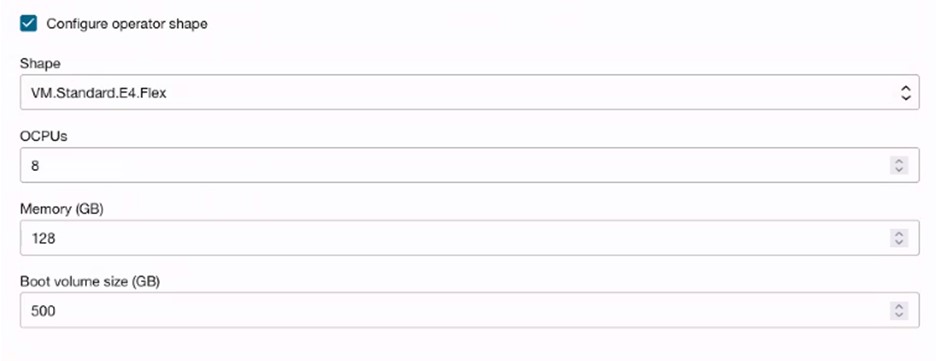

(Optional) Wählen Sie Operatorausprägung konfigurieren aus, um Operatorknoten für die Überwachung oder Ausführung von Jobs zu erstellen.

-

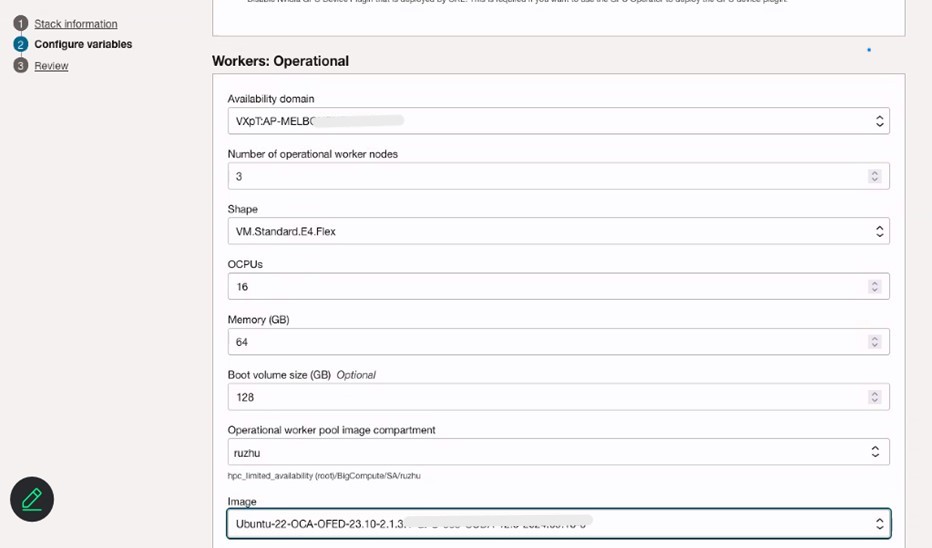

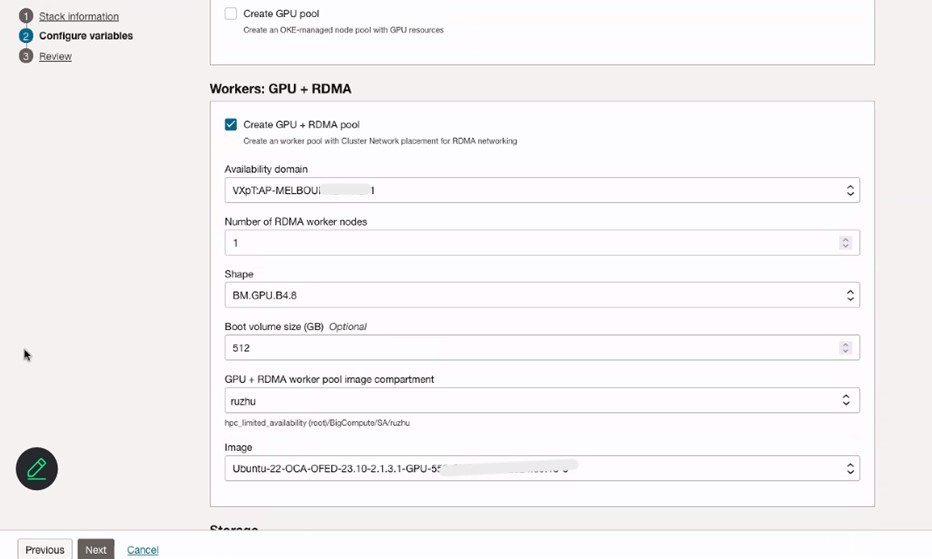

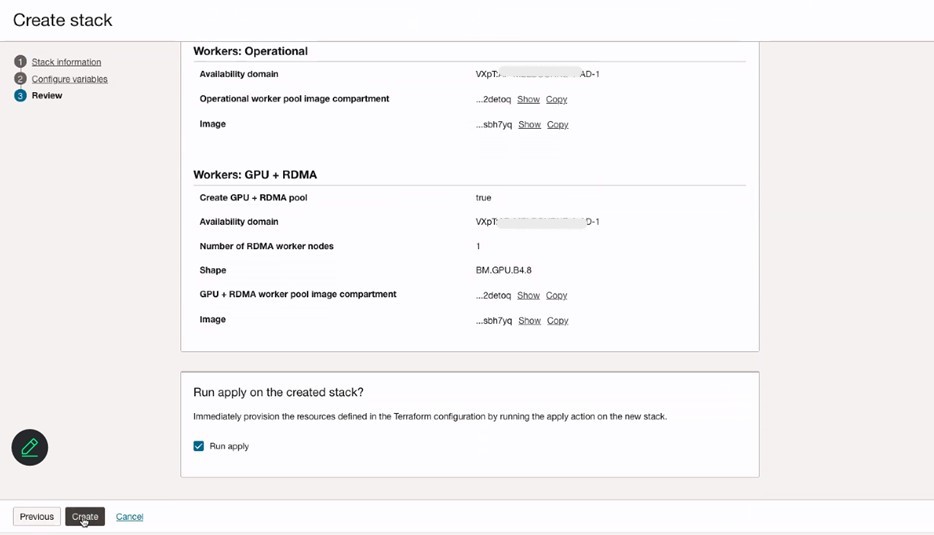

Konfigurieren Sie Variablen von OKE-Cluster, Workers: Operational-Knoten und Workers: GPU + RDMA-Knoten. Stellen Sie sicher, dass Sie Flannel-CNI für Podnetworking auswählen.

-

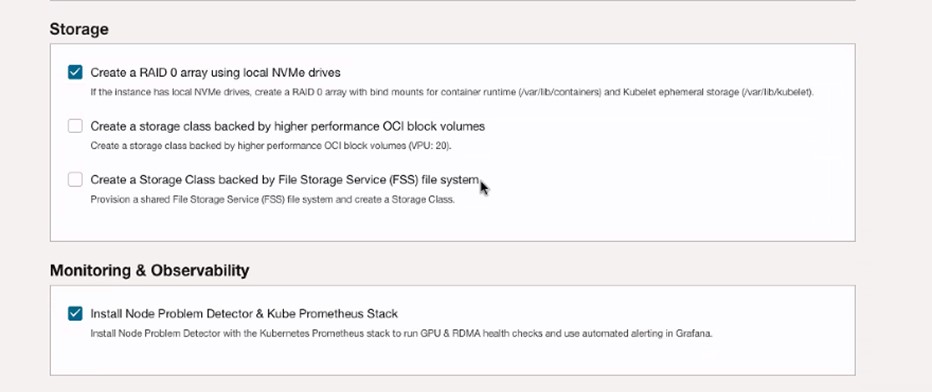

Wählen Sie RAID 0-Array mit lokalen NVMe-Laufwerken erstellen und Knotenproblemdetektor und Kube-Prometheus-Stack installieren aus.

-

Prüfen Sie die Stackinformationen, und klicken Sie auf Erstellen.

-

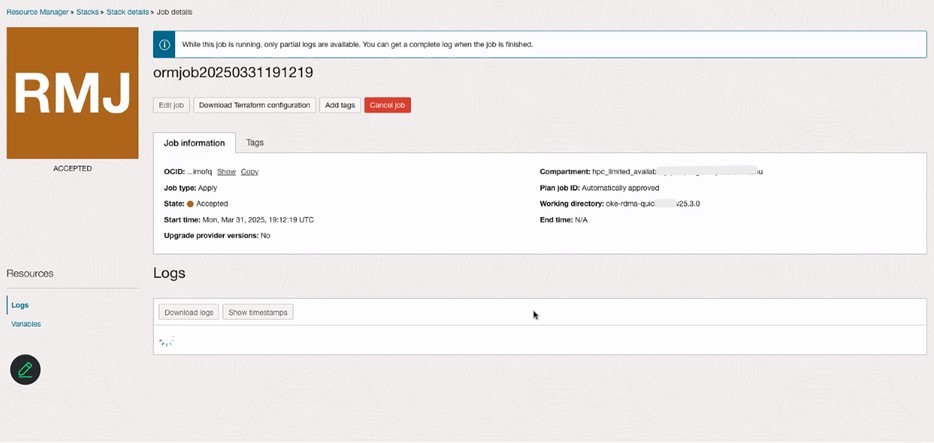

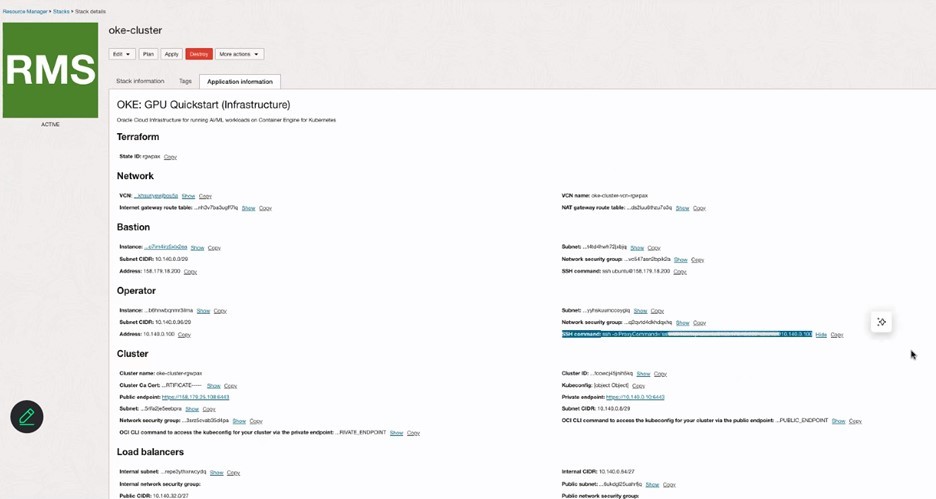

Prüfen Sie die Stackdetails in Resource Manager, und prüfen Sie das OKE-Cluster in der OCI-Konsole im Abschnitt Kubernetes.

-

Melden Sie sich mit dem Zugriffscluster über die OCI-Konsole beim OKE-Cluster an, und fügen Sie neue GPU-Knoten hinzu.

-

Führen Sie alle hier genannten Schritte aus: Dynamische Gruppe und Policy für selbst verwaltete Knoten erstellen.

-

Befolgen Sie die hier genannten Schritte 1 und 2: Cloud-init-Skripte für selbstverwaltete Knoten erstellen.

-

Führen Sie das folgende Skript aus, um die GPU-Knoten zum OKE-Cluster hinzuzufügen.

sudo rm archive_uri-https_objectstorage_ap-osaka-1_oraclecloud_com_p_ltn5w_61bxynnhz4j9g2drkdic3mwpn7vqce4gznmjwqqzdqjamehhuogyuld5ht_n_hpc_limited_availability_b_oke_node_repo_o_ubuntu-jammy.list sudo apt install -y oci-oke-node-all* sudo oke bootstrap --apiserver-host <API SERVER IP> --ca <CA CERT> --manage-gpu-services --crio-extra-args " -

Führen Sie den folgenden Befehl aus, um zu prüfen, ob die Knoten erfolgreich zum OKE-Cluster hinzugefügt wurden.

kubectl get nodes

Verwandte Links

-

Dynamische Gruppe und Policy für selbstverwaltete Knoten erstellen

-

Einführung der besten Plattform für KI-Workloads – OCI Kubernetes Engine (OKE)

Danksagungen

- Autoren – Ruzhu Chen (Master Principal Enterprise Cloud Architect), Payal Sharma (Senior Enterprise Cloud Architect)

Weitere Lernressourcen

Sehen Sie sich andere Übungen zu docs.oracle.com/learn an, oder greifen Sie im Oracle Learning YouTube-Channel auf weitere kostenlose Lerninhalte zu. Besuchen Sie außerdem education.oracle.com/learning-explorer, um Oracle Learning Explorer zu werden.

Die Produktdokumentation finden Sie im Oracle Help Center.

Migrate Bare Metal GPU Nodes to OKE as Self-Managed Nodes using an OCI Stack

G31985-01

Copyright ©2025, Oracle and/or its affiliates.