Informationen zur Erkennung von Streamingbetrug

In diesem Lösungs-Playbook erfahren Sie, wie Sie das NVIDIA Morpheus-Cybersicherheits-Framework verwenden, um KI-gesteuerte Betrugserkennung in Echtzeit mithilfe einer GPU-beschleunigten Morpheus-Pipeline bereitzustellen und die Ergebnisse mit Compute Cloud@Customer zu veröffentlichen. Die Lösung ermöglicht eine sofortige Betrugserkennung, ohne auf Batch-Jobs zu warten, und schützt Ihre Daten, indem sie lokal verarbeitet werden.

Bevor Sie beginnen

- Betriebssystem: Ubuntu 24.04 LTS

- Plattform: NVIDIA AI Enterprise auf einer Oracle Compute Cloud@Customer-Instanz mit einem Knoten, die mit einer NVIDIA L40S-GPU ausgestattet ist.

Stellen Sie vor dem Start sicher, dass die folgenden Tools auf dem Hostrechner installiert sind:

- Docker und Docker Compose (

docker compose V2) - Git und Git LFS (

git-lfs) - Python 3 und

Pip

Workflow

Der Workflow nutzt das Cybersicherheits-Framework NVIDIA Morpheus, um eine GPU-beschleunigte Inferenz für einen Stream von Finanztransaktionsdaten auszuführen.

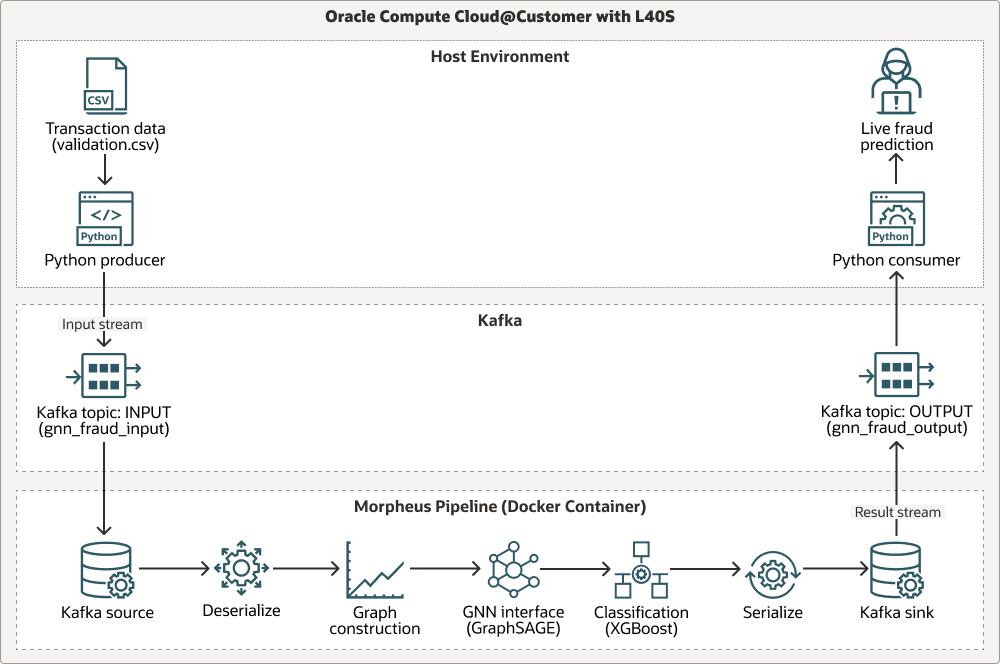

Das folgende Diagramm zeigt einen Workflow über drei Swimlanes: Hostumgebung, Apache Kafka und Morpheus-Pipeline:

Die Pipeline nimmt Live-Transaktionsdaten über Apache Kafka auf, führt eine grafikbasierte kontextbezogene Analyse mit einem vortrainierten Graph Sample and Aggregate-(GraphSAGE-)Modell durch und führt die endgültige Betrugsklassifizierung mit XGBoost aus. Alle Phasen werden mit NVIDIA-RAPIDS-Librarys (cuDF, cuML) beschleunigt, sodass der gesamte Workflow für einen hohen Durchsatz GPU-optimiert ist. Ablauf des Prozesses:

Transaction data (.csv)wird von einem Python-Producer produziert.- Daten werden in den

INPUT-Stream des Kafka-Themas übertragen. - Die Daten werden über die Morpheus-Pipeline in Schritten verarbeitet: Lesen aus der Kafka-Quelle, Deserialisieren, Erstellen eines Diagramms, Schnittstellen zur Graph Neural Network-(GNN-)Schnittstelle (

GraphSAGE), Klassifizieren mitXGBoost, Serialisieren von Ergebnissen und Schreiben in die Kafka-Senke. - Ergebnisse werden an den

OUTPUT-Stream des Kafka-Themas gesendet. - Ein Python-Verbraucher erhält Ausgabe und bietet Live-Betrugsprognosen.

Modellherkunft

Die Inferenzpipeline im Kern dieser Architektur verwendet zwei vortrainierte Modelle für maschinelles Lernen: einen GNN GraphSAGE und einen Classifier XGBoost. Diese Modelle wurden mit einer separaten Trainingspipeline generiert, die als Referenz im Morpheus-Repository enthalten ist.

- Speicherort des Schulungsskripts:

examples/gnn_fraud_detection_pipeline/training.py. - Prozess: Das Skript verarbeitet ein beschriftetes historisches Dataset, um das GNN auf grafikbasierten Features und das

XGBoost-Modell auf den resultierenden Einbettungen zu trainieren.

In dieser Lösung müssen Sie das Trainingsskript nicht ausführen, da die vorab trainierten Modelle bereits bereitgestellt sind. Konzentrieren Sie sich auf die Bereitstellung und Ausführung der Inferenzpipeline in Echtzeit.

Diese Architektur unterstützt die folgenden Komponenten:

- Oracle Compute Cloud@Customer

Oracle Compute Cloud@Customer ist eine vollständig verwaltete Infrastruktur im Rackmaßstab, mit der Sie OCI Compute überall verwenden können. Profitieren Sie von den Vorteilen der Cloud-Automatisierung und -Wirtschaftlichkeit in Ihrem Data Center, indem Sie OCI Compute- und GPU-Ausprägungen mit Speicher- und Netzwerkservices auf Compute Cloud@Customer ausführen. Sie können Anwendungen ausführen und die Leistungsfähigkeit von GenAI auf der Cloud-Infrastruktur in Ihrem Data Center nutzen und gleichzeitig Data Residency-, Sicherheits- und Verbindungen mit geringer Latenz zu lokalen Ressourcen und Echtzeitvorgängen bewältigen.

- RAPIDS CuDF/cuML

RAPIDS cuDF/cuML sind eine Suite von GPU-beschleunigten Bibliotheken für leistungsstarke Datenmanipulations- und Dienstprogramme für maschinelles Lernen innerhalb der Morpheus-Pipeline.

- Docker + Conda

Docker + Conda bietet einen mehrschichtigen Ansatz für das Abhängigkeitsmanagement. Dabei wird Docker für die Isolation auf BS-Ebene und Conda für die Verwaltung der komplexen Python-Umgebung im Container verwendet.

Überlegungen zur Produktion

Berücksichtigen Sie bei der Implementierung dieser Lösung in einer Produktionsumgebung die Skalierbarkeit und Resilienz, die Kubernetes bieten kann. Sie können diese Lösung in OCI Kubernetes Engine (OKE) migrieren, indem Sie:

- Containerisierung der Producer- und Consumer-Helper-Skripts.

- Kafka mit einem Kubernetes-Operator der Produktionsklasse bereitstellen.

- Bereitstellung der Morpheus-Pipeline als Kubernetes-Job oder -Deployment.

Erforderliche Services und Rollen

Für diese Lösung sind die folgenden Services und Rollen erforderlich:

- Oracle Compute Cloud@Customer

- NVIDIA AI Enterprise 6.0

-

Ubuntu Linux (oder eine kompatible Linux-Distribution)

- Docker

- NVIDIA Morpheus 25.02

Dies sind die Rollen, die für jeden Service erforderlich sind.

| Servicename: Rolle | Erforderlich für... |

|---|---|

Oracle Compute Cloud@Customer: administrator |

Konfigurieren und stellen Sie die Virtual-Machine-Instanz NVIDIA AI Enterprise bereit, verwalten Sie Netzwerkressourcen, und stellen Sie den Zugriff auf die NVIDIA L40S-GPU sicher. |

Ubuntu Linux: root oder Benutzer mit sudo-Berechtigungen

|

Installieren Sie Voraussetzungssoftware (Docker, Git), verwalten Sie Systemservices, und führen Sie Docker-Befehle aus. |

| NVIDIA AI Enterprise: Accountbenutzer | Rufen Sie das erforderliche NVIDIA Morpheus-Containerimage aus dem NVIDIA GPU Cloud-(NGC-)Katalog ab. |

Informationen zu Ihren Anforderungen finden Sie unter Produkte, Lösungen und Services von Oracle.