Blueprint bereitstellen

Stellen Sie sicher, dass Sie Zugriff auf einen OCI-Mandanten haben und über Administratorberechtigungen verfügen, um ausreichende CPU-/GPU-Instanzen bereitzustellen.

- Installieren Sie ein OKE-Cluster mit dem unten stehenden Terraform-Modul. Ein OKE-Cluster mit einem einzelnen Knotenpool wird mit 6 Worker-Knoten erstellt.

- Klicken Sie unten auf In Oracle Cloud bereitstellen.

- Geben Sie Ihrem Stack einen Namen (Beispiel: oke-stack).

- Wählen Sie das Compartment aus, in dem OCI AI Blueprints bereitgestellt werden sollen.

- Geben Sie zusätzliche Parameter (wie Knotengröße, Knotenanzahl) entsprechend Ihren Voreinstellungen an.

- Klicken Sie auf Weiter, Erstellen, und klicken Sie schließlich auf Apply ausführen, um das Cluster bereitzustellen.

- Melden Sie sich bei der Oracle Cloud Infrastructure-Konsole an, und klicken Sie auf der Homepage auf Speicher und dann unter Object Storage auf Buckets. Geben Sie einen Bucket-Namen an, den Sie im OCI AI Blueprints-Deployment verwenden.

Klicken Sie auf den Bucket, den Sie erstellt haben, und klicken Sie unter Ressourcen auf den Link Vorab authentifizierte Anforderungen (PAR). Geben Sie einen Namen für PAR an, ändern Sie den Zugriffstyp in Objektlese- und -schreibvorgänge zulassen, und klicken Sie auf Vorab authentifizierte Anforderungen. Wenn der Vorgang abgeschlossen ist, kopieren Sie die PAR-URL, und speichern Sie sie an einer beliebigen Stelle, wenn Sie den Blueprint für CPU-Inferenzierung bereitstellen.

- Installieren Sie OCI AI Blueprints im neuen OKE-Cluster. Nach dem erfolgreichen Deployment erhalten Sie eine URL für den Zugriff auf die OCI AI Blueprints-Konsole.

- Auf der Hauptseite von OCI AI Blueprints stehen unter Blueprint-Binärdatei mehrere Blueprints für das Deployment zur Verfügung. Scrollen Sie nach unten, und klicken Sie unter CPU-Inferenz auf Bereitstellen.

- Wählen Sie CPU-Inferenz mit Mistral und VM-Standard.E4 aus. Flex-Option.

Verwenden Sie die Standardparameter, und ändern Sie die oben erstellte URL für die vorauthentifizierte Anforderung. Ändern Sie keine Werte im Abschnitt Parameter konfigurieren.

Bitte beachten Sie die Parameter:

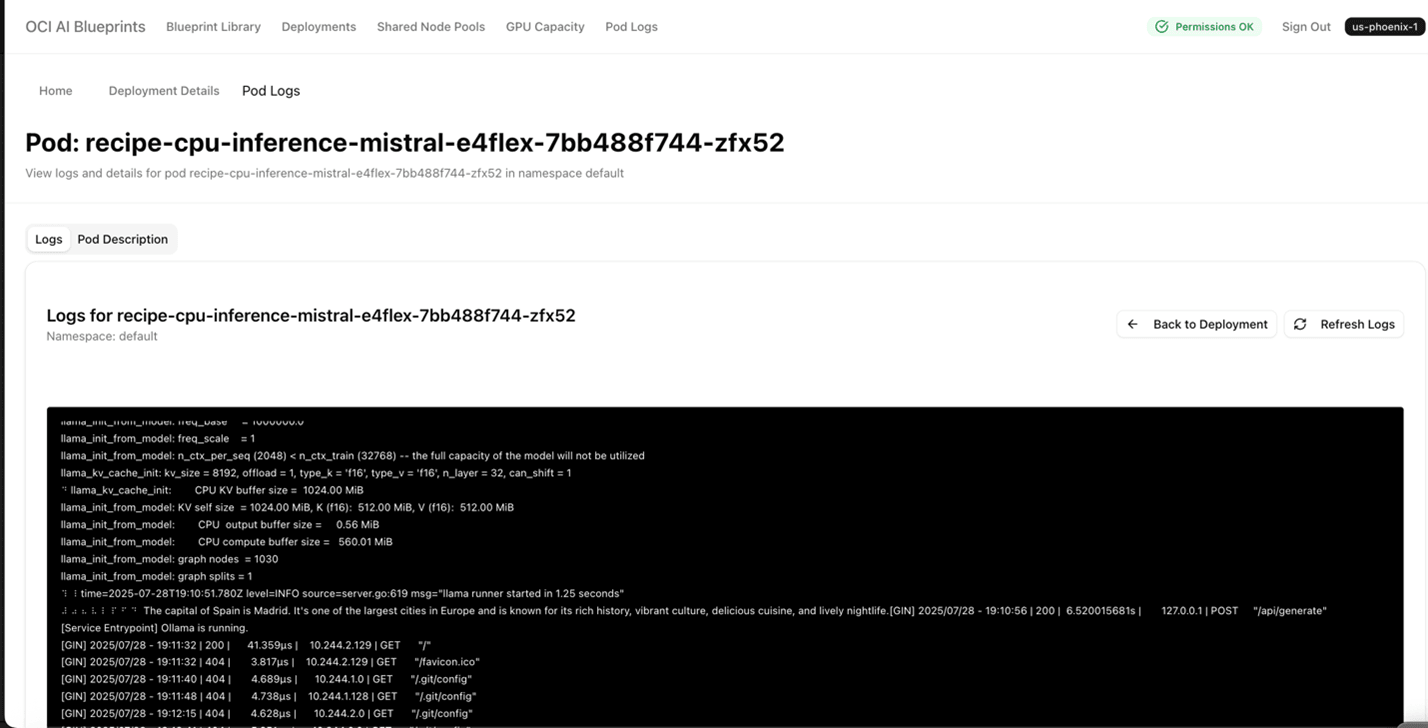

"recipe_container_env": [ { "key": "MODEL_NAME", "value": "mistral" }, { "key": "PROMPT", "value": "What is the capital of Spain?" }Nach dem erfolgreichen Deployment des CPU-Inferenzierungs-Blueprints wird die Ausgabe des oben genannten Prompts im Kubernetes-Podlog angezeigt.

- Klicken Sie auf Blueprint bereitstellen. Nachdem der Blueprint erfolgreich bereitgestellt wurde, wird ein Name wie cpu inference mistral E4Flex angezeigt, in dem der Deployment-Status Monitoring mit dem Erstellungsdatum und der Anzahl der Knoten und E4-Ausprägungen aufgeführt wird.

- Klicken Sie in der Liste Deployment auf den Link CPU-Inferenz-Mistral E4Flex, der Sie zu den Deployment-Details mit dem öffentlichen Endpunkt führt. Klicken Sie auf den öffentlichen Endpunkt, und eine Meldung wie "ollama wird ausgeführt" wird angezeigt.

- Kehren Sie zur Seite cpu inference mistral E4Flex zurück, und scrollen Sie nach unten zu Podlogs. Klicken Sie auf Anzeigen und Logdetails. Eine Seite ähnlich der folgenden wird mit der Ausgabe angezeigt.

- Wählen Sie CPU-Inferenz mit Mistral und VM-Standard.E4 aus. Flex-Option.