Informationen zum CPU-Inferenz-Blueprint

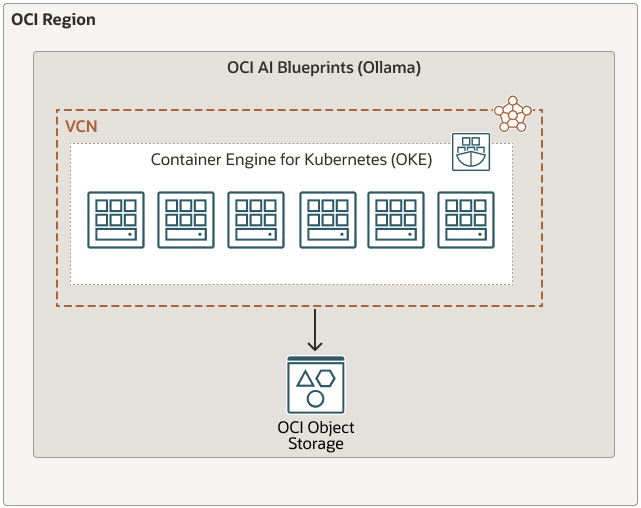

Oracle Cloud Infrastructure AI Blueprints ist eine optimierte No-Code-Lösung für das Deployment und die Verwaltung generativer KI-Workloads auf Oracle Cloud Infrastructure Kubernetes Engine (OKE).

Mit bewerteten Hardwareempfehlungen, vorkonfigurierten Software-Stacks und sofort einsatzbereiten Beobachtbarkeitstools können Sie mit OCI AI Blueprints Ihre KI-Anwendungen schnell und effizient ausführen, ohne sich mit der Komplexität von Infrastrukturentscheidungen, Softwarekompatibilität und Best Practices für ML-Operationen (ML Ops) auseinanderzusetzen.

Dieser CPU-Inferenz-Blueprint bietet ein umfassendes Framework zum Testen von Inferenz auf CPUs mit der Ollama-Plattform mit einer Vielzahl unterstützter Modelle wie Mistral, Gemma und anderen, die über Ollama verfügbar sind. Im Gegensatz zu GPU-abhängigen Lösungen ist dieser Blueprint für Umgebungen konzipiert, in denen CPU-Inferenz bevorzugt oder erforderlich ist.

Der Blueprint bietet klare Richtlinien und Konfigurationseinstellungen, um einen robusten CPU-Inferenzdienst bereitzustellen und damit gründliche Leistungsbewertungen und Zuverlässigkeitstests zu ermöglichen. Die leichte und effiziente Architektur von Ollama macht es zu einer idealen Lösung für Entwickler, die CPU-basierte Inferenz-Workloads vergleichen und optimieren möchten.

In diesem Blueprint wird erläutert, wie Sie CPU-Inferenz für die Ausführung großer Sprachmodelle mit Ollama verwenden. Es umfasst zwei wichtige Bereitstellungsstrategien:

- Vorgespeicherte Modelle direkt aus Oracle Cloud Infrastructure Object Storage bedienen

- Modelle aus Ollama abrufen und in OCI Object Storage speichern