Más información sobre la detección de fraude de transmisión

En este manual de soluciones, aprenderá a utilizar el marco de ciberseguridad de NVIDIA Morpheus para implementar la detección de fraudes basada en IA en tiempo real mediante un pipeline Morpheus acelerado por GPU y publicar los resultados mediante Compute Cloud@Customer. La solución permite la detección instantánea de fraudes sin esperar trabajos por lotes y mantiene sus datos seguros al procesarlos localmente en el perímetro.

Antes de empezar

- Sistema operativo: Ubuntu 24.04 LTS

- Plataforma: NVIDIA AI Enterprise en una instancia de Oracle Compute Cloud@Customer de un solo nodo equipada con una GPU NVIDIA L40S.

Antes de comenzar, asegúrese de que las siguientes herramientas estén instaladas en el equipo host:

- Docker y Docker se componen (

docker compose V2) - Git y Git LFS (

git-lfs) - Python 3 y

Pip

Flujo de trabajo

El flujo de trabajo aprovecha el marco de ciberseguridad de NVIDIA Morpheus para realizar inferencia acelerada por GPU en un flujo de datos de transacciones financieras.

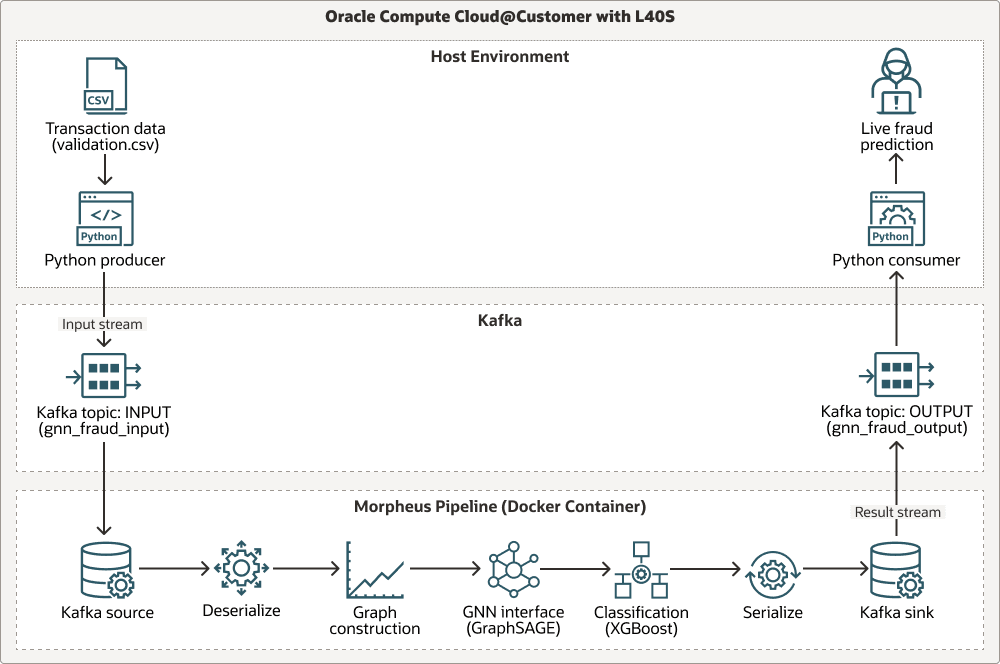

En el siguiente diagrama se muestra un flujo de trabajo a través de tres calles: el entorno de host, Apache Kafka y el pipeline de Morpheus:

El pipeline ingiere datos de transacciones en directo a través de Apache Kafka, realiza un análisis contextual basado en gráficos mediante un modelo de Ejemplo de gráfico y agregado (GraphSAGE) previamente entrenado y ejecuta la clasificación de fraude final mediante XGBoost. Todas las etapas se aceleran mediante las bibliotecas RAPIDS de NVIDIA (cuDF, cuML), lo que hace que todo el flujo de trabajo esté optimizado para GPU para un alto rendimiento. A continuación, se muestra cómo fluye el proceso:

Transaction data (.csv)lo produce un productor de Python.- Los datos entran en el flujo

INPUTdel tema de Kafka. - Los datos se procesan mediante el pipeline de Morpheus en pasos: lectura desde el origen de Kafka, anulación de la serialización, construcción de un gráfico, interfaz con la interfaz de Graph Neural Network (GNN) (

GraphSAGE), clasificación conXGBoost, serialización de resultados y escritura en el receptor de Kafka. - Los resultados se envían al flujo

OUTPUTdel tema de Kafka. - Un consumidor de Python recibe resultados y proporciona predicción de fraude en directo.

Proveniencia del modelo

El pipeline de inferencia en el núcleo de esta arquitectura utiliza dos modelos de aprendizaje automático previamente entrenados: un GNN GraphSAGE y un clasificador XGBoost. Estos modelos se generaron utilizando un pipeline de entrenamiento independiente, que se incluye en el repositorio de Morpheus como referencia.

- Ubicación de secuencia de comandos de entrenamiento:

examples/gnn_fraud_detection_pipeline/training.py. - Proceso: el script procesa un conjunto de datos histórico etiquetado para entrenar a GNN en funciones basadas en gráficos y el modelo

XGBoosten las incrustaciones resultantes.

En esta solución, no tiene que ejecutar el script de entrenamiento porque ya se han proporcionado modelos previamente entrenados. Céntrese en desplegar y ejecutar el pipeline de inferencia en tiempo real.

Esta arquitectura admite los siguientes componentes:

- Oracle Compute Cloud@Customer

Oracle Compute Cloud@Customer es una infraestructura a escala de rack totalmente gestionada que te permite utilizar OCI Compute en cualquier lugar. Obtén las ventajas de la automatización y la economía en la nube en tu centro de datos ejecutando unidades de OCI Compute y GPU con servicios de almacenamiento y redes en Compute Cloud@Customer. Puede ejecutar aplicaciones y aprovechar la potencia de GenAI en la infraestructura en la nube de su centro de datos, al tiempo que ayuda a abordar las conexiones de residencia de datos, seguridad y baja latencia a los recursos locales y las operaciones en tiempo real.

- RAPIDS cuDF/cuML

RAPIDS cuDF/cuML son un conjunto de bibliotecas aceleradas por GPU para las utilidades de manipulación de datos y aprendizaje automático de alto rendimiento dentro del pipeline de Morpheus.

- Docker + Conda

Docker + Conda proporcionan un enfoque en capas para la gestión de dependencias mediante Docker para el aislamiento en el nivel del sistema operativo y Conda para gestionar el complejo entorno de Python dentro del contenedor.

Consideraciones para la producción

Al implantar esta solución en un entorno de producción, tenga en cuenta la escalabilidad y la resiliencia que puede proporcionar Kubernetes. Puede migrar esta solución a OCI Kubernetes Engine (OKE) mediante:

- Contener los scripts de ayuda al productor y al consumidor.

- Despliegue de Kafka mediante un operador de Kubernetes de producción.

- Despliegue del pipeline de Morpheus como un trabajo o despliegue de Kubernetes.

Acerca de los servicios y los roles necesarios

Esta solución requiere los siguientes servicios y roles:

- Oracle Compute Cloud@Customer

- NVIDIA AI Enterprise 6.0

-

Ubuntu Linux (o una distribución de Linux compatible)

- Docker

- NVIDIA Morpheus 25.02

Estos son los roles necesarios para cada servicio.

| Nombre de servicio: Rol | Necesario para... |

|---|---|

Oracle Compute Cloud@Customer: administrator |

Configure e implemente la instancia de máquina virtual de NVIDIA AI Enterprise, gestione los recursos de red y garantice el acceso a la GPU L40S de NVIDIA. |

Ubuntu Linux: root o usuario con privilegios sudo

|

Instale el software necesario (Docker, Git), gestione los servicios del sistema y ejecute los comandos de Docker. |

| NVIDIA AI Enterprise: usuario de la cuenta | Extraiga la imagen de contenedor de NVIDIA Morpheus necesaria del catálogo de NVIDIA GPU Cloud (NGC). |

Consulte Productos, soluciones y servicios de Oracle para obtener lo que necesita.