Despliegue del anteproyecto

Asegúrese de tener acceso a un arrendamiento de OCI y de tener privilegios de administrador para proporcionar suficientes instancias de CPU/GPU.

- Instale un cluster de OKE con el módulo de Terraform que aparece a continuación. Se creará un cluster de OKE con un único pool de nodos con 6 nodos de trabajador.

- Haga clic en Desplegar en Oracle Cloud a continuación.

- Dale a tu pila un nombre (por ejemplo, oke-stack).

- Seleccione el compartimento en el que desea desplegar los planes detallados de OCI AI.

- Proporcione parámetros adicionales (como el tamaño del nodo, el recuento de nodos) según sus preferencias.

- Haga clic en Siguiente, en Crear y, por último, en Ejecutar aplicación para aprovisionar el cluster.

- Conéctese a la consola de Oracle Cloud Infrastructure y, en la página de inicio, haga clic en Almacenamiento y, a continuación, en Object Storage, haga clic en Cubos. Proporcione un nombre de cubo que utilizará en el despliegue de OCI AI Blueprints.

Haga clic en el cubo que ha creado y en el enlace Solicitudes autenticadas previamente (PAR) en Recursos. Proporcione un nombre para PAR, cambie el tipo de acceso a Permitir lecturas y escrituras de objetos y haga clic en Solicitudes autenticadas previamente. Cuando haya terminado, copie la URL de PAR y guárdela en algún lugar, ya que la necesitará cuando despliegue el plan detallado de inferencia de CPU.

- Instale OCI AI Blueprints en el nuevo cluster de OKE. Después de un despliegue correcto, tendrá una URL para acceder a la consola de OCI AI Blueprints.

- En la página principal de OCI AI Blueprints, hay varios planes detallados disponibles para el despliegue en Blueprint Binary, desplácese hacia abajo y haga clic en Deploy en CPU Inference.

- Seleccione Inferencia de CPU con mistral y VM-Standard.E4. Opción flexible.

Utilice los parámetros por defecto y cambie la URL de la solicitud autenticada previamente creada anteriormente. No cambie ningún valor en la sección Configurar parámetros.

Tenga en cuenta los parámetros:

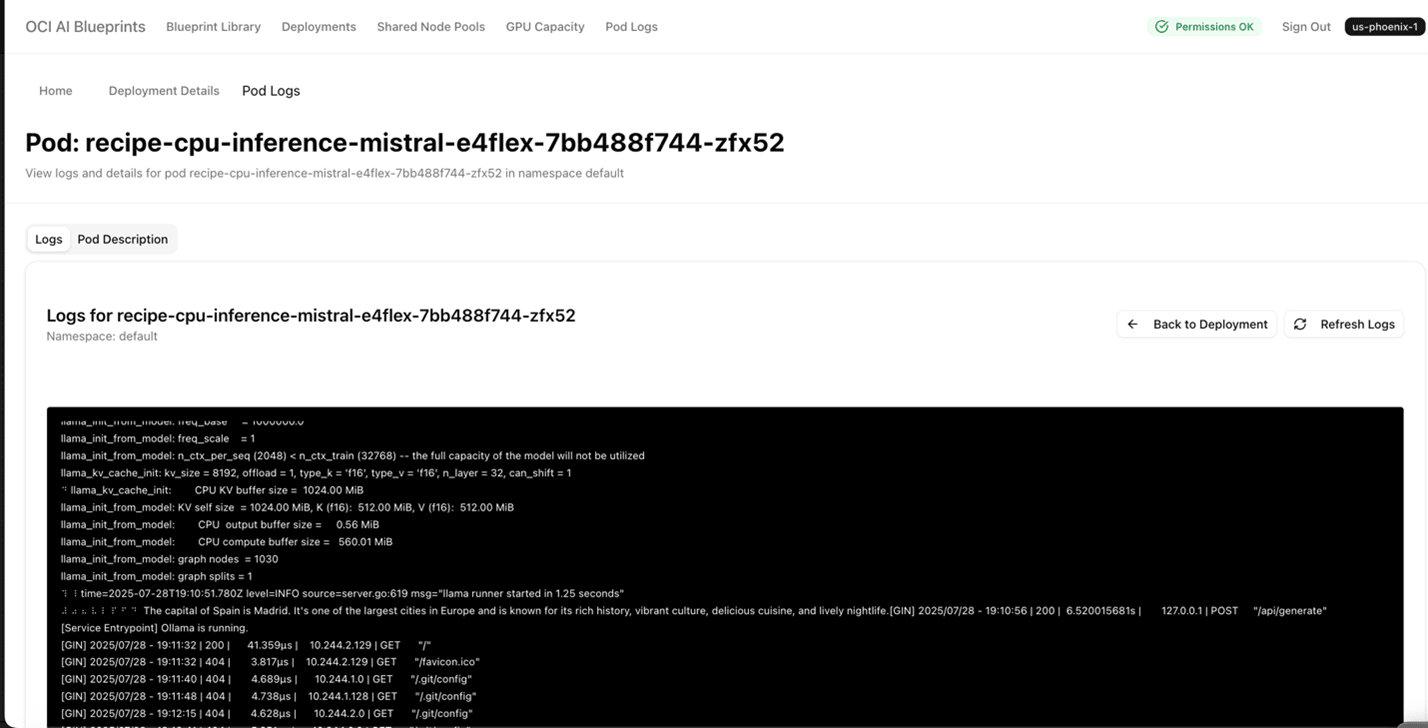

"recipe_container_env": [ { "key": "MODEL_NAME", "value": "mistral" }, { "key": "PROMPT", "value": "What is the capital of Spain?" }Tras el despliegue correcto del plan detallado de inferencia de CPU, la salida de la petición de datos anterior se mostrará en el log de pod de Kubernetes.

- Haga clic en Desplegar plan detallado. Una vez que el plan detallado se haya desplegado correctamente, observará un nombre como cpu inference mistral E4Flex que muestra un estado de despliegue de Monitoringcon la fecha de creación y el número de nodos y unidades E4.

- En la lista Despliegue, haga clic en el enlace E4Flex mistral de inferencia de CPU, que le llevará a los detalles del despliegue con el punto final público. Haga clic en el punto final público y verá un mensaje como "ollama is running".

- Vuelva a la página E4Flex mistral de inferencia de CPU y desplácese hacia abajo hasta Logs de pod. Haga clic en Ver y Detalles de log. Aparecerá una página similar a la siguiente, que le proporcionará la salida.

- Seleccione Inferencia de CPU con mistral y VM-Standard.E4. Opción flexible.