Información sobre el plan detallado de inferencia de CPU

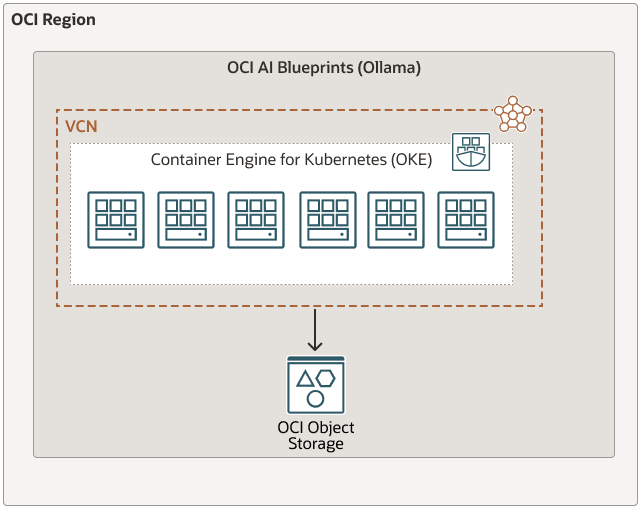

Los planes detallados de IA de Oracle Cloud Infrastructure son una solución optimizada y sin código para desplegar y gestionar cargas de trabajo de IA generativa en Oracle Cloud Infrastructure Kubernetes Engine (OKE).

Al proporcionar recomendaciones de hardware, pilas de software preempaquetadas y herramientas de observación listas para usar, OCI AI Blueprints te ayuda a hacer que tus aplicaciones de IA se ejecuten de manera rápida y eficiente, sin luchar con las complejidades de las decisiones de infraestructura, la compatibilidad de software y las mejores prácticas de operaciones de aprendizaje automático (ML Ops).

Este plan de inferencia de CPU proporciona un marco completo para probar la inferencia en CPU mediante la plataforma Ollama con una variedad de modelos compatibles como Mistral, Gemma y otros disponibles a través de Ollama. A diferencia de las soluciones dependientes de GPU, este plan está diseñado para entornos donde se prefiere o se requiere la inferencia de CPU.

El plan ofrece directrices claras y valores de configuración para implementar un servicio de inferencia de CPU robusto y, por lo tanto, permitir evaluaciones de rendimiento exhaustivas y pruebas de fiabilidad. La arquitectura ligera y eficiente de Ollama la convierte en una solución ideal para desarrolladores que buscan comparar y optimizar las cargas de trabajo de inferencia basadas en CPU.

Este plan explica cómo utilizar la inferencia de CPU para ejecutar grandes modelos de lenguaje con Ollama. Incluye dos estrategias principales de despliegue:

- Servicio de modelos guardados previamente directamente desde Oracle Cloud Infrastructure Object Storage

- Extraer modelos de Ollama y guardarlos en OCI Object Storage