Répliquer des données entre des bases de données en nuage dans la même région

Voyez comment configurer Oracle Cloud Infrastructure GoldenGate pour répliquer des données entre deux bases de données autonomes d'IA.

Aperçu

Le service GoldenGate pour Oracle Cloud Infrastructure vous permet de répliquer des bases de données prises en charge dans la même région. Les étapes suivantes vous guident lors de l'instanciation d'une base de données cible à l'aide d'Oracle Data Pump et la réplication des données de la source vers la cible.

Ce démarrage rapide est également disponible en tant que LiveLab : Voir l'atelier.

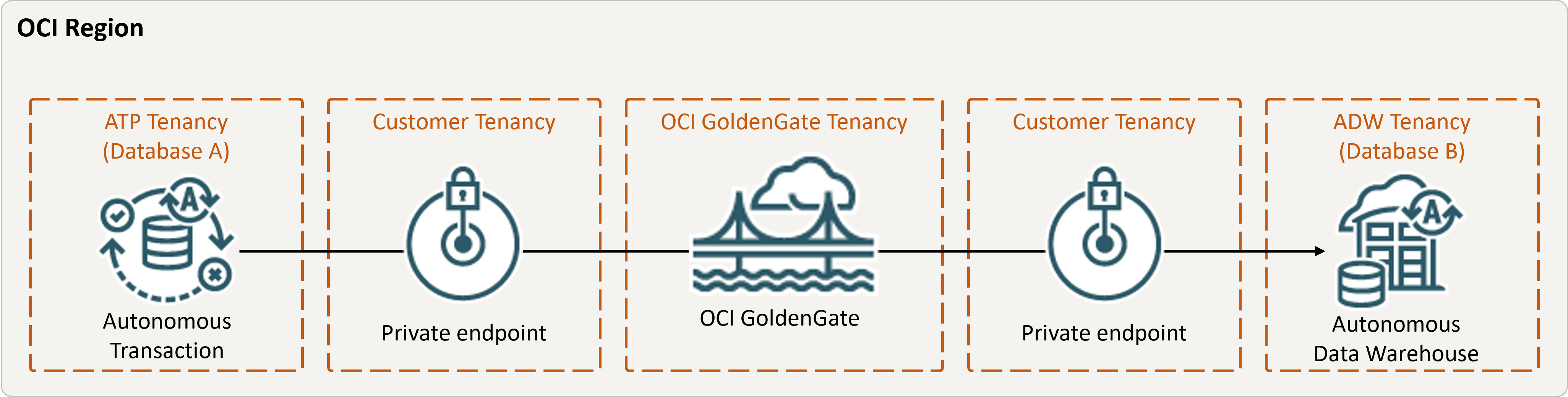

Description de l'illustration same-region.png

Avant de commencer

Pour continuer, vous devez disposer des éléments suivants :

- Une base de données source existante

- Une base de données cible existante

- Les bases de données source et cible doivent se trouver dans une seule location, dans la même région

- Si vous avez besoin de données-échantillons, téléchargez Archive.zip, puis suivez les instructions sous Laboratoire 1, Tâche 3 : Charger le schéma ATP.

Tâche 2 : Créer le processus d'extraction intégrée

Une extraction intégrée saisit les modifications en cours apportées à la base de données source.

Tâche 3 : Exporter des données à l'aide d'Oracle Data Pump (ExpDP)

Utilisez Oracle Data Pump (ExpDP) pour exporter des données de la base de données source vers le magasin d'objets Oracle.

Tâche 4 : Instancier la base de données cible à l'aide d'Oracle Data Pump (ImpDP)

Utilisez Oracle Data Pump (ImpDP) pour importer des données dans la base de données cible à partir du fichier SRC_OCIGGLL.dmp exporté à partir de la base de données source.