En savoir plus sur la détection de fraude en continu

Dans ce livre de jeu de solution, vous apprendrez à utiliser le cadre de cybersécurité NVIDIA Morpheus pour déployer la détection de fraude en temps réel guidée par l'intelligence artificielle à l'aide d'un pipeline Morpheus accéléré par GPU et publier les résultats à l'aide de Compute Cloud@Customer. La solution permet une détection instantanée des fraudes sans attendre les tâches par lots et assure la sécurité de vos données en les traitant localement en périphérie.

Étapes préliminaires

- Système d'exploitation : Ubuntu 24.04 LTS

- Plate-forme : NVIDIA AI Enterprise sur une instance Oracle Compute Cloud@Customer à noeud unique équipée d'un processeur graphique NVIDIA L40S.

Avant de commencer, assurez-vous que les outils suivants sont installés sur l'ordinateur hôte :

- Docker et rédaction Docker (

docker compose V2) - Git et Git LFS (

git-lfs) - Python 3 et

Pip

Flux de travail

Le flux de travail tire parti du cadre de cybersécurité de NVIDIA Morpheus pour effectuer une inférence accélérée par GPU sur un flux de données de transaction financière.

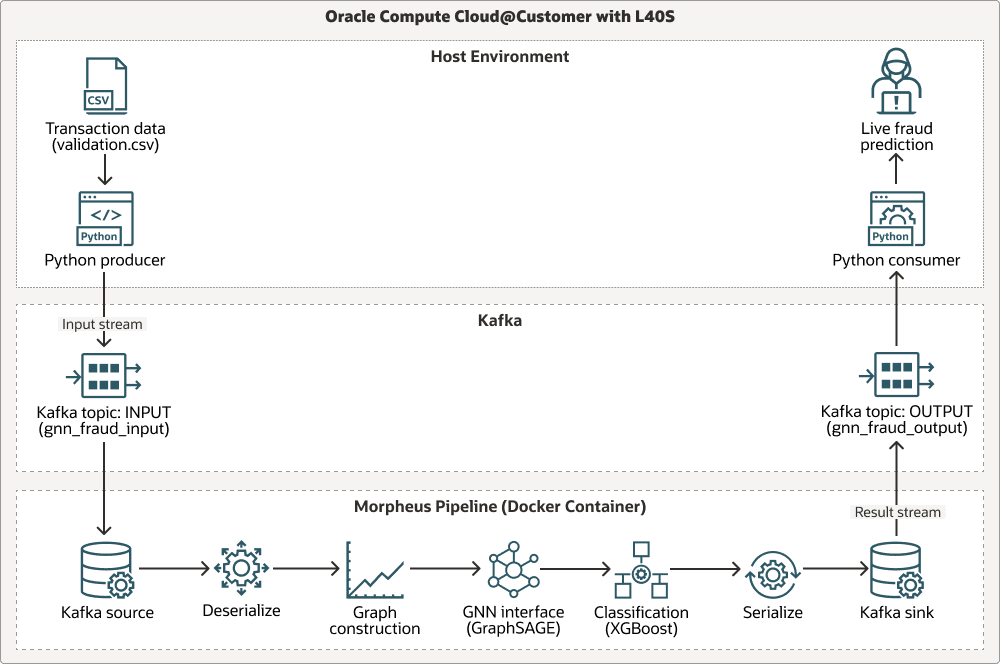

Le diagramme suivant présente un flux de travail au moyen de trois couloirs de navigation : Environnement hôte, Apache Kafka et pipeline Morpheus :

Le pipeline ingère des données de transaction en direct au moyen d'Apache Kafka, effectue une analyse contextuelle basée sur un graphique à l'aide d'un modèle Exemple de graphique et agrégation (GraphSAGE) préentraîné et exécute la classification finale des fraudes à l'aide de XGBoost. Toutes les étapes sont accélérées à l'aide des bibliothèques RAPIDS NVIDIA (cuDF, cuML), ce qui optimise l'ensemble des processeurs graphiques du flux de travail pour un débit élevé. Voici le flux du traitement :

Transaction data (.csv)est produit par un producteur Python.- Les données sont transférées dans le flux

INPUTdu sujet Kafka. - Les données sont traitées au moyen du pipeline Morpheus en plusieurs étapes : lecture à partir de la source Kafka, désérialisation, construction d'un graphique, interface avec l'interface du réseau neuronal de graphique (GNN) (

GraphSAGE), classification avecXGBoost, sérialisation des résultats et écriture dans l'évier Kafka. - Les résultats sont envoyés au flux

OUTPUTde la rubrique Kafka. - Un consommateur Python reçoit une sortie et fournit une prévision de fraude en direct.

Provenance du modèle

Le pipeline d'inférence au cœur de cette architecture utilise deux modèles d'apprentissage automatique préentraînés : un GNN GraphSAGE et un classificateur XGBoost. Ces modèles ont été générés à l'aide d'un pipeline d'entraînement distinct, qui est inclus dans le référentiel Morpheus pour référence.

- Emplacement du script de formation :

examples/gnn_fraud_detection_pipeline/training.py. - Processus : Le script traite un jeu de données historique étiqueté pour entraîner le GNN sur des fonctions basées sur un graphique et le modèle

XGBoostsur les intégrations résultantes.

Dans cette solution, vous n'avez pas besoin d'exécuter le script d'entraînement car les modèles préentraînés sont déjà fournis. Concentrez-vous sur le déploiement et l'exécution du pipeline d'inférence en temps réel.

Cette architecture prend en charge les composants suivants :

- Oracle Compute Cloud@Customer

Oracle Compute Cloud@Customer est une infrastructure entièrement gérée à l'échelle du bâti qui vous permet d'utiliser le service Calcul pour OCI n'importe où. Profitez des avantages de l'automatisation et de l'économie du nuage dans votre centre de données en exécutant des formes de calcul OCI et de GPU avec des services de stockage et de réseau sur Compute Cloud@Customer. Vous pouvez exécuter des applications et exploiter la puissance de GenAI sur l'infrastructure en nuage de votre centre de données tout en répondant aux besoins en matière de résidence, de sécurité et de connexions à faible latence des ressources locales et d'opérations en temps réel.

- RAPIDES cuDF/cuML

Les RAPIDS cuDF/cuML sont une suite de bibliothèques accélérées par GPU pour les utilitaires de manipulation de données et d'apprentissage automatique à haute performance dans le pipeline Morpheus.

- Docker + Conda

Docker + Conda fournissent une approche en couches de la gestion des dépendances, à l'aide de Docker pour l'isolement au niveau du système d'exploitation et de Conda pour gérer l'environnement Python complexe dans le conteneur.

Considérations relatives à la production

Lors de la mise en œuvre de cette solution dans un environnement de production, tenez compte de l'extensibilité et de la résilience que Kubernetes peut offrir. Vous pouvez migrer cette solution vers OCI Kubernetes Engine (OKE) en effectuant les opérations suivantes :

- Mise en conteneur des scripts d'assistant producteur et consommateur.

- Déploiement de Kafka à l'aide d'un opérateur Kubernetes de niveau production.

- Déploiement du pipeline Morpheus en tant que tâche ou déploiement Kubernetes.

À propos des services et des rôles requis

Cette solution nécessite les services et rôles suivants :

- Oracle Compute Cloud@Customer

- NVIDIA AI Enterprise 6.0

-

Ubuntu Linux (ou une distribution Linux compatible)

- Docker

- NVIDIA Morpheus 25.02

Il s'agit des rôles nécessaires pour chaque service.

| Nom du service : Rôle | Requis pour... |

|---|---|

Oracle Compute Cloud@Customer : administrator |

Configurez et déployez l'instance de machine virtuelle NVIDIA AI Enterprise, gérez les ressources de réseau et assurez l'accès au GPU L40S NVIDIA. |

Ubuntu Linux : root ou utilisateur disposant des privilèges sudo

|

Installez le logiciel prérequis (Docker, Git), gérez les services système et exécutez les commandes Docker. |

| NVIDIA AI Enterprise : Utilisateur de compte | Extrayez l'image de conteneur NVIDIA Morpheus requise dans le catalogue NVIDIA GPU Cloud (NGC). |

Voir Produits, solutions et services Oracle pour obtenir ce dont vous avez besoin.