Autres méthodes d'exécution des travaux

Vous pouvez utiliser les travaux d'une multitude de façons, notamment à l'aide d'environnements conda et de fichiers ZIP.

Utilisation de fichiers ZIP ou TAR compressés

Vous pouvez utiliser des travaux pour exécuter un projet Python complet que vous archivez dans un fichier unique.

Les fichiers TAR compressés ou TAR exécutés en tant que travaux peuvent tirer parti des environnements conda du service Data Science et des environnements conda personnalisés.

Pour le traitement de travail, pointez vers le fichier d'entrée principal à l'aide de la variable d'environnement JOB_RUN_ENTRYPOINT. Cette variable est uniquement utilisée avec les travaux qui utilisent des artefacts ZIP ou TAR compressés.

Utilisation d'un environnement conda Data Science

Vous pouvez utiliser l'un des environnements conda Data Science inclus dans le service.

Un environnement conda encapsule toutes les dépendances Python tierces (telles que Numpy, Dask ou XGBoost) requises par le traitement de travail. Les environnements conda Data Science sont inclus et gérés dans le service. Si vous n'indiquez pas d'environnement conda dans les configurations de traitement de travail et de travail, aucun environnement conda n'est utilisé car il n'existe pas d'environnement par défaut.

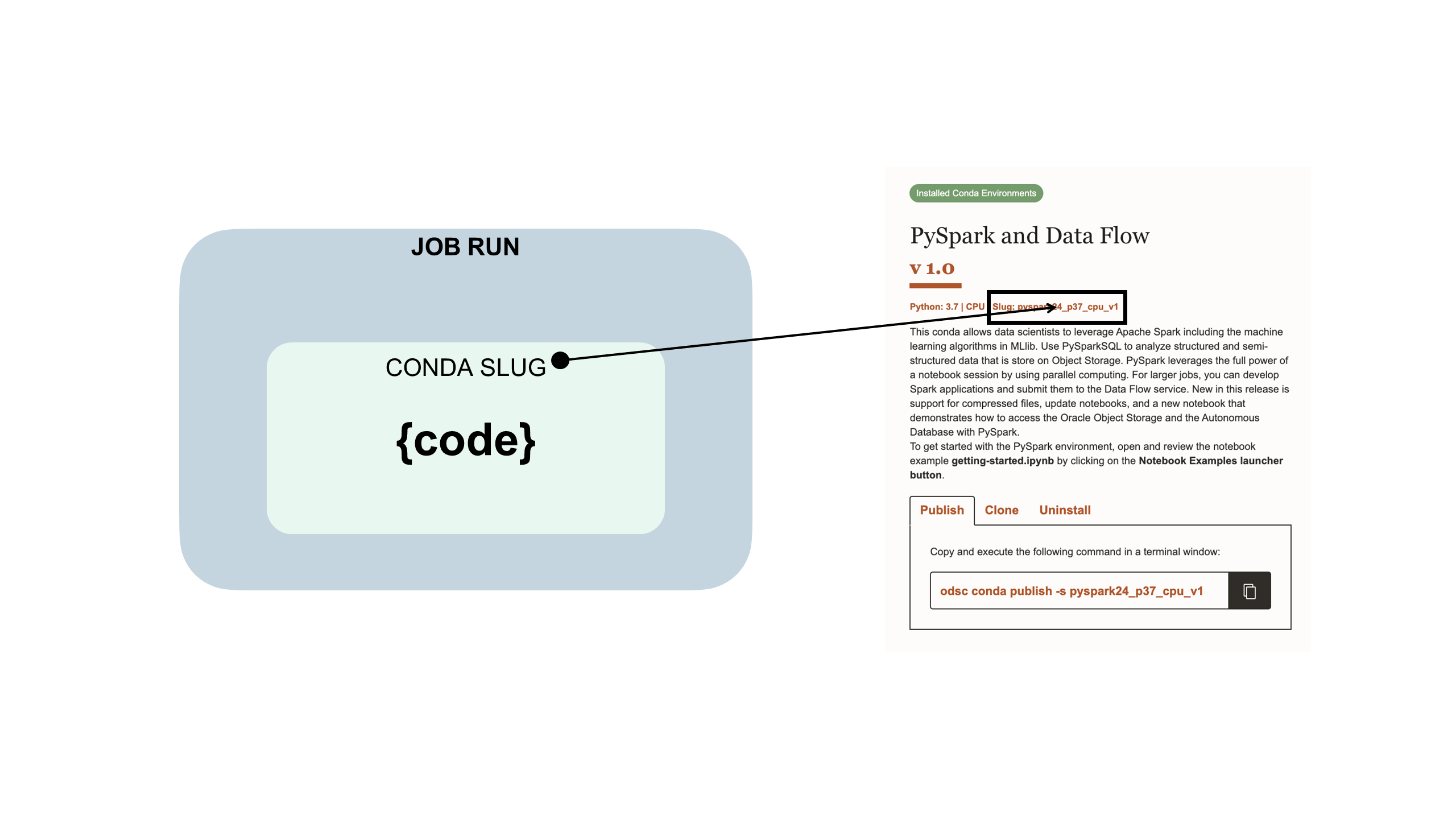

Le code de travail est imbriqué dans un environnement conda Data Science :

Utilisation d'un environnement conda personnalisé

Vous pouvez utiliser des travaux de fichier tar compressé et ZIP avec des environnements conda personnalisés ou des environnements conda Data Science.

Un environnement conda encapsule toutes les dépendances Python tierces (telles que Numpy, Dask ou XGBoost) requises par le traitement de travail. Vous créez, publiez et gérez les environnements conda personnalisés. Si vous n'indiquez pas d'environnement conda dans les configurations de traitement de travail et de travail, aucun environnement conda n'est utilisé car il n'existe pas d'environnement par défaut.

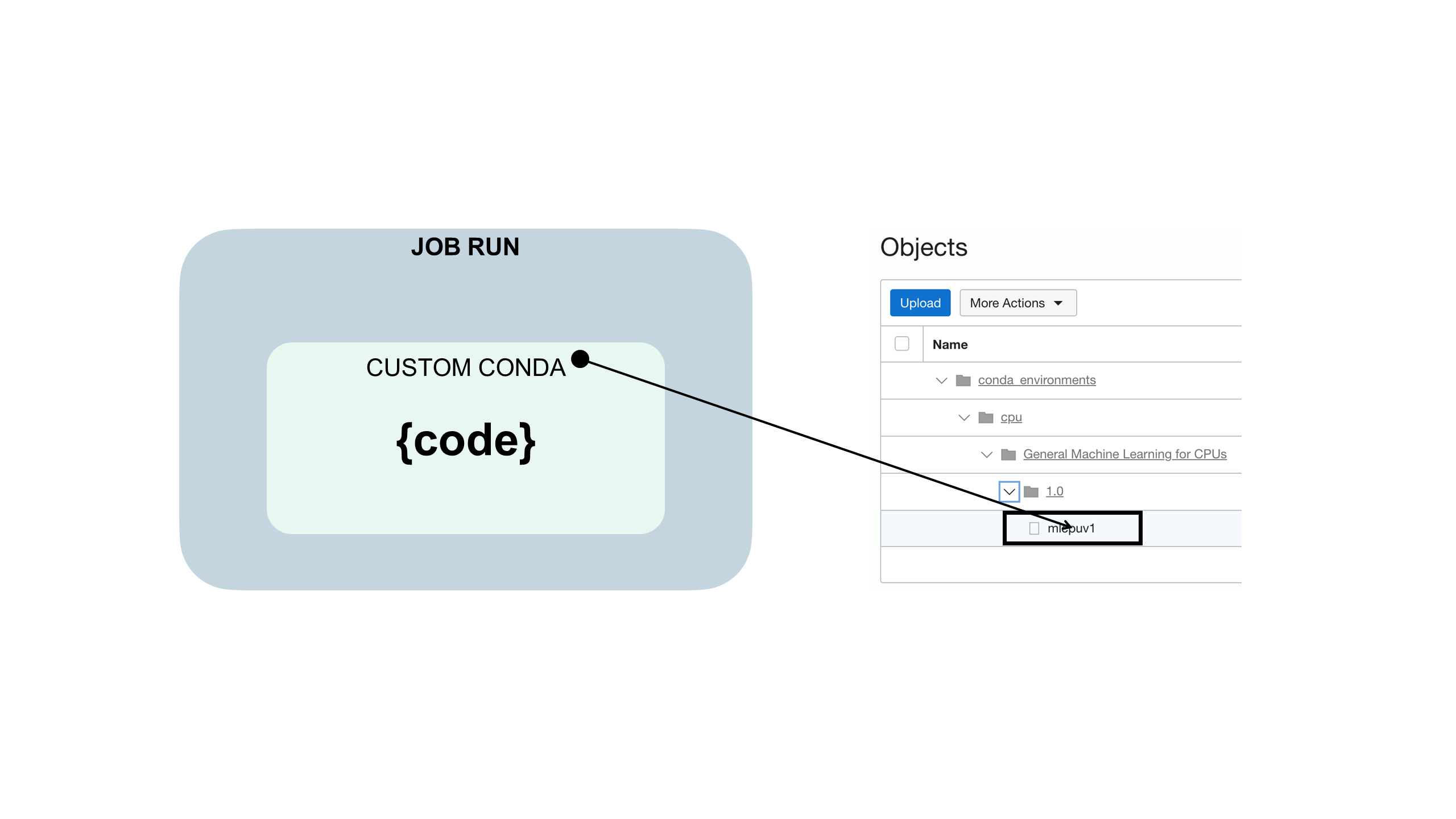

Le code travail est imbriqué dans un environnement conda personnalisé comme suit :

Utilisation d'un fichier YAML d'exécution

Vous pouvez utiliser un fichier YAML d'exécution pour configurer des variables d'environnement de travail plutôt que d'utiliser la console ou le kit SDK.

Avant de commencer :

Téléchargez, décompressez et consultez les exemples de fichier jobruntime.yaml et conda_pack_test.py pour créer et tester votre projet de travail.

L'utilisation d'un fichier jobruntime.yaml facilite la définition de variables d'environnement personnalisées dans le projet.

Utilisation d'un coffre

Vous pouvez intégrer le service OCI Vault aux travaux Data Science à l'aide de principaux de ressource.

Avant de commencer :

-

Pour que le principal de ressource du travail ait accès à un coffre, assurez-vous que vous disposez d'un groupe dynamique dans votre compartiment qui spécifie l'instance ou le principal de ressource. Par exemple, vous pouvez utiliser le principal de ressource et un groupe dynamique avec la règle suivante :

all {resource.type='datasciencejobrun',resource.compartment.id='<compartment_ocid>'} -

Pour que le travail soit exécuté, vous devez vous assurer que vous pouvez au moins gérer secret-family sur le groupe dynamique. Par exemple :

Allow dynamic-group <dynamic_group_name> to manage secret-family in compartment <compartment_name>L'article de blog Utilisation de principaux d'instance OCI et d'un coffre avec Python pour extraire une clé secrète fournit des détails utiles.

-

Téléchargez, décompressez et consultez l'exemple de fichier

zipped_python_job.zipqui présente les éléments suivants :- Initialisation du client de coffre dans le travail à l'aide du kit SDK Python

- Lecture d'une clé secrète à l'aide de son OCID

- Décodage du package de clé secrète et lecture de son contenu

Etant donné que les travaux ont accès au principal de ressource, vous pouvez initialiser tous les clients de coffre disponibles dans le kit SDK Python.

-

Créez un coffre disposant d'une clé maître et une clé secrète, et ajoutez une instruction de stratégie à tous les principaux de ressource de travail pour

manage secret-family.

- A partir de la console, créez un travail.

- Exécutez le travail pour tester son fonctionnement.

- Surveillez le traitement réussi du travail.

- (Facultatif) Si vous avez utilisé la journalisation, vous pouvez consulter les journaux pour connaître les valeurs de traitement de travail.