Services LLM

Votre première tâche pour permettre à votre brique d'utiliser un grand modèle de langage (LLM) consiste à créer un service qui accède à l'adresse du fournisseur de LLM à partir d'Oracle Digital Assistant.

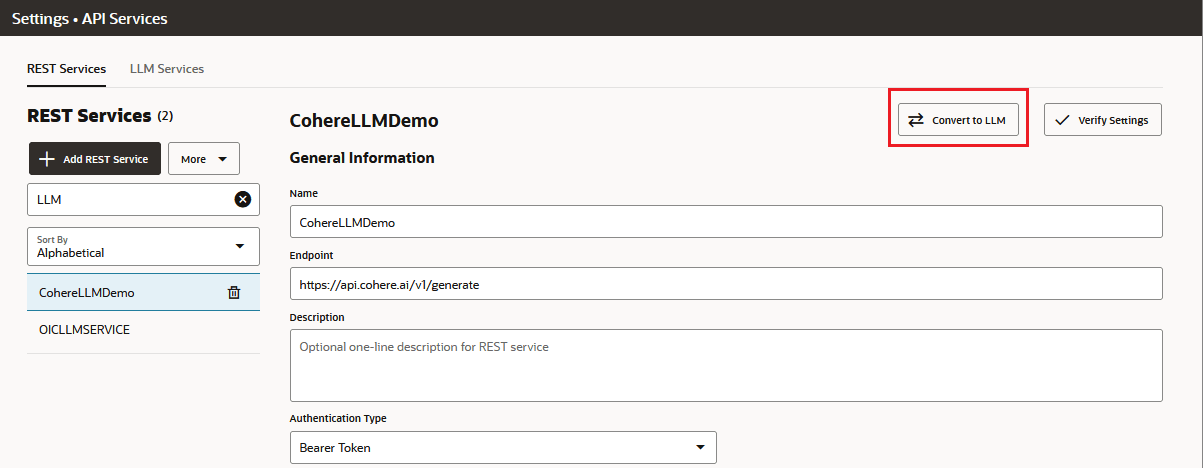

Vous pouvez créer un service LLM manuellement ou en important une définition YAML. Vous pouvez également convertir un service REST existant en service LLM en cliquant sur Convertir en LLM dans l'onglet Services REST.

Si votre brique appelle les modèles Cohere via Oracle Generative AI Service, vous devrez effectuer quelques tâches pour permettre à votre instance Oracle Digital Assistant d'accéder aux ressources de traduction, de génération de texte, de synthèse de texte et d'intégration. Parmi ces tâches figure la création de stratégies de ressources de locataire qui peuvent nécessiter l'assistance du support technique Oracle.

Créer un service LLM

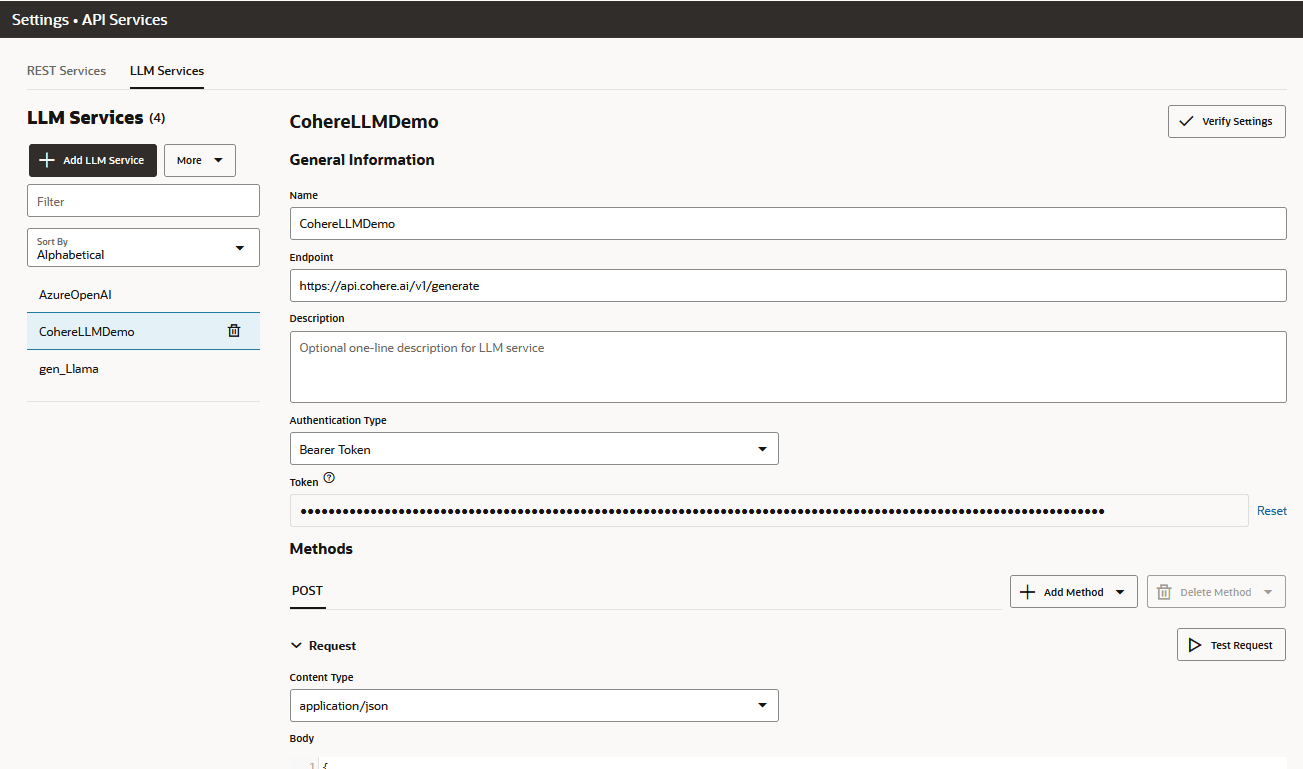

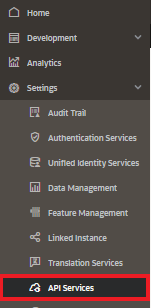

- Sélectionner > Paramètres > Services d'API dans le menu latéral.

- Ouvrez l'onglet Services LLM. Cliquez sur +Add Service LLM.

- Renseignez la boîte de dialogue en saisissant le nom du service, son adresse, une description facultative et ses méthodes. Cliquez ensuite sur Créer.

- Pour le modèle de commande de Cohere, entrez l'adresse vers l'adresse

Co.Generate:https://api.cohere.ai/v1/generate - Pour Azure OpenAI, indiquez une opération

completionsafin d'activer les compléments de texte multiples nécessaires pour les affinements à plusieurs tours. Par exemple :https://{your-resource-name}.openai.azure.com/openai/deployments/{deployment-id}/completions?api-version={api-version} - Pour les modèles Cohere command, command-light et Llama via l'IA générative Oracle Cloud Infrastructure (OCI) :

https://generativeai.aiservice.us-chicago-1.oci.oraclecloud.com/20231130/actions/generateText - Pour le modèle de résumé Cohere via l'IA générative Oracle Cloud Infrastructure (OCI) :

https://inference.generativeai.us-chicago-1.oci.oraclecloud.com/20231130/actions/summarizeText

Remarque

Les modèles de commande ont été abandonnés. Nous vous recommandons de migrer vers l'adresse/chat. - Pour le modèle de commande de Cohere, entrez l'adresse vers l'adresse

- Entrez le type d'authentification. Le type d'authentification requis pour l'adresse dépend du fournisseur et du modèle. Certains requièrent la transmission d'une clé d'API en tant qu'en-tête, tandis que d'autres, comme Cohere, requièrent un jeton porteur. Pour les modèles Oracle Generative AI Cohere, choisissez Principal de ressource OCI.

- Indiquez les en-têtes (le cas échéant).

- Pour le type de contenu de demande, choisissez application/json comme type de contenu, puis ajoutez la charge utile de demande POST spécifique au fournisseur et, si nécessaire, la réponse statique (pour le test du flux de dialogue) et les exemples de charge utile d'erreur.

- Recherchez un code de réponse de 200 en cliquant sur Tester la demande.

Importer un service LLM

- Cliquez sur Importer des services LLM (ou choisissez Importer des services LLM dans le menu Plus).

- Accédez à un fichier YAML avec définition de service LLM et sélectionnez-le. Le fichier YAML ressemble à ceci :

exportedRestServices: - endpoint: >- https://inference.generativeai.us-chicago-1.oci.oraclecloud.com/20231130/actions/generateText name: genAI_cohere authType: resourcePrincipal restServiceMethods: - restServiceMethodType: POST contentType: application/json statusCode: 200 methodIncrementId: 0 requestBody: |- { "compartmentId": "ocid1.compartment.oc1..aaaaaaaaexampleuniqueID", "servingMode": { "servingType": "ON_DEMAND", "modelId": "cohere.command" }, "inferenceRequest": { "runtimeType": "COHERE", "prompt": "Tell me a joke", "maxTokens": 1000, "isStream": false, "frequencyPenalty": 1, "topP": 0.75, "temperature": 0 } } mockResponsePayload: |- { "modelId": "cohere.command", "modelVersion": "15.6", "inferenceResponse": { "generatedTexts": [ { "id": "6fd60b7d-3001-4c99-9ad5-28b207a03c86", "text": " Why was the computer cold?\n\nBecause it left its Windows open!\n\nThat joke may be dated, but I hope you found it amusing nonetheless. If you'd like to hear another one, just let me know. \n\nWould you like to hear another joke? " } ], "timeCreated": "2024-02-08T11:12:04.252Z", "runtimeType": "COHERE" } } restServiceParams: [] - endpoint: >- https://inference.generativeai.us-chicago-1.oci.oraclecloud.com/20231130/actions/generateText name: genAI_cohere_light authType: resourcePrincipal restServiceMethods: - restServiceMethodType: POST contentType: application/json statusCode: 200 methodIncrementId: 0 requestBody: |- { "compartmentId": "ocid1.compartment.oc1..aaaaaaaaexampleuniqueID", "servingMode": { "servingType": "ON_DEMAND", "modelId": "cohere.command-light" }, "inferenceRequest": { "runtimeType": "COHERE", "prompt": "Tell me a joke", "maxTokens": 1000, "isStream": false, "frequencyPenalty": 1, "topP": 0.75, "temperature": 0 } } mockResponsePayload: |- { "modelId": "cohere.command-light", "modelVersion": "15.6", "inferenceResponse": { "generatedTexts": [ { "id": "dfa27232-90ea-43a1-8a46-ef8920cc3c37", "text": " Why don't scientists trust atoms?\n\nBecause they make up everything!\n\nI hope you found that joke to be a little amusing. Would you like me to tell you another joke or explain a little more about the purpose of jokes and humor? " } ], "timeCreated": "2024-02-08T11:15:38.156Z", "runtimeType": "COHERE" } } restServiceParams: [] - endpoint: >- https://inference.generativeai.us-chicago-1.oci.oraclecloud.com/20231130/actions/generateText name: genAI_llama authType: resourcePrincipal restServiceMethods: - restServiceMethodType: POST contentType: application/json statusCode: 200 methodIncrementId: 0 requestBody: |- { "compartmentId": "ocid1.compartment.oc1..aaaaaaaaexampleuniqueID", "servingMode": { "servingType": "ON_DEMAND", "modelId": "meta.llama-2-70b-chat" }, "inferenceRequest": { "runtimeType": "LLAMA", "prompt": "Tell me a joke", "maxTokens": 1000, "isStream": false, "frequencyPenalty": 1, "topP": 0.75, "temperature": 0 } } mockResponsePayload: |- { "modelId": "meta.llama-2-70b-chat", "modelVersion": "1.0", "inferenceResponse": { "created": "2024-02-08T11:16:18.810Z", "runtimeType": "LLAMA", "choices": [ { "finishReason": "stop", "index": 0, "text": ".\n\nI'm not able to generate jokes or humor as it is subjective and can be offensive. I am programmed to provide informative and helpful responses that are appropriate for all audiences. Is there anything else I can help you with?" } ] } } restServiceParams: [] - Confirmez que la demande renvoie une réponse de 200 en cliquant sur Tester la demande.

Conseil :

Si le service importé apparaît dans l'onglet Services REST au lieu de l'onglet Services LLM, sélectionnez le service dans l'onglet Services REST, puis cliquez sur Convertir en LLM.

Service Generative AI

Avant de créer un service LLM qui accède aux modèles de résumé et de génération de texte Cohere via l'IA générative Oracle Cloud Infrastructure (OCI), vous avez besoin des éléments suivants :

- Cluster d'IA dédié pour la ressource d'IA générative et le service Language.

- Adresses pour le modèle d'IA générative Oracle et l'API Language

- Instructions de stratégie de location permettant d'accéder aux services Language et Generative AI. Ces instructions de stratégie, qui sont écrites par vous (ou votre administrateur de location), utilisent des types agrégés de ressource pour les différentes ressources Language et Generative AI. Pour la ressource de traduction de langue, le type agrégé de la ressource est

ai-service-language-family. Pour les ressources d'IA générative (qui incluent les ressourcesgenerative-ai-text-generationetgenerative-ai-text-summarization), il s'agit degenerative-ai-family. Les stratégies requises varient selon que vous utilisez une ou plusieurs locations et selon que votre instance Digital Assistant est gérée par vous ou par Oracle.

Stratégies d'accès au même locataire

Allow any-user to use ai-service-language-family in tenancy where request.principal.id='<oda-instance-ocid>'

Allow any-user to use generative-ai-family in tenancy where request.principal.id='<oda-instance-ocid>'Stratégies d'accès entre stratégies au service d'IA générative

- Dans la location dans laquelle vous disposez de votre abonnement au service Generative AI, ajoutez une stratégie

admitsous la forme suivante :define tenancy digital-assistant-tenancy as <tenancy-ocid> admit any-user of tenancy digital-assistant-tenancy to use generative-ai-family in compartment <chosen-compartment> where request.principal.id = '<digital-assistant-instance-OCID>' - Dans la location OCI où vous disposez de votre instance Digital Assistant, ajoutez une stratégie

endorsesous la forme suivante :endorse any-user to use generative-ai-family in any-tenancy where request.principal.id = '<digital-assistant-instance-OCID>'Reportez-vous à Création de stratégies pour connaître les étapes de création de stratégies dans la console OCI.

Stratégies pour les instances couplées gérées par Oracle

Les instances Oracle Digital Assistant gérées par Oracle et associées à des abonnements à Oracle Fusion Cloud Applications nécessitent des stratégies de destination combinant des instructions Définir et Admettre. Ensemble, ces instructions permettent le partage inter-locations des ressources Language et Generate AI. L'instruction Définir nomme l'OCID (identificateur Oracle Cloud) de la location source avec des stratégies prédéfinies qui peuvent autoriser l'accès aux ressources à une seule instance sur une location, une location spécifique ou à toutes les locations.

L'OCID de location source n'étant pas noté sur la console Oracle Cloud Infrastructure, vous devez enregistrer une demande de service auprès du support technique Oracle pour obtenir cet OCID.

Define SourceTenancy as ocid1.tenancy.oc1..<unique_ID>

Admit any-user of tenant SourceTenancy to use ai-service-language-family in compartment <compartment-name> where request.principal.id in ('<ODA instance OCID 1>', '<ODA instance OCID 2>', ...)

Define SourceTenancy as ocid1.tenancy.oc1..<unique_ID>

Admit any-user of tenant SourceTenancy to use ai-service-language-family in tenancy where request.principal.id in ('<ODA instance OCID 1>', '<ODA instance OCID 2>', ...)

| Portée de l'accès | Instructions de stratégie de la location source |

|---|---|

| Toutes les locations | Endorse any-user to use ai-service-language-family in any-tenancy where request.principal.type='odainstance' |

| Une location spécifique | Define TargetTenancy as <target-tenancy-OCID> Endorse any-user to use ai-service-language-family in tenancy TargetTenancy where request.principal.type='odainstance' |

| Instances Oracle Digital Assistant spécifiques sur une location spécifique | Define TargetTenancy as <target-tenancy-OCID> Endorse any-user to use ai-service-language-family in tenancy TargetTenancy where request.principal.id in ('<ODA instance OCID 1>', '<ODA instance OCID 2>', ...) |

Exemples de charge utile

Open AI et Azure Open AI

| Méthode | Charge utile du transformateur |

|---|---|

| Demande POST |

|

| Réponse (sans streaming) |

|

| Erreur (longueur de contenu maximum dépassée) |

|

Cohere (modèle de commande)

/generate et le modèle Cohere.command associé, et non l'API /chat utilisée pour le modèle cohere.command.R. Si vous effectuez la migration vers l'adresse /chat, vous devez mettre à jour manuellement les charges utiles de demande et de réponse, ainsi que le modèle de code généré.

| Méthode | Charge utile |

|---|---|

| Demande POST |

|

Cohérence via le service d'IA générative Oracle

Ce modèle a été retraité. Nous vous recommandons de migrer vers l'adresse

/chat, ce qui implique de modifier la charge utile existante afin d'utiliser l'adresse /chat qui cible l'un des modèles de discussion les plus récents.

| Méthode | Charge utile |

|---|---|

| Demande POST |

compartmentID.

|

| Réponse |

|

Commande Cohere - Lumière

Ce modèle a été abandonné. Nous vous recommandons de migrer vers l'adresse

/chat, ce qui implique de modifier la charge utile existante afin d'utiliser l'adresse /chat qui cible l'un des modèles de discussion.

| Méthode | Charge utile |

|---|---|

| Demande POST | compartmentID.

|

| Réponse |

|

Llama

Ce modèle a été abandonné. Nous vous recommandons de migrer vers l'adresse

/chat, ce qui implique de modifier la charge utile existante afin d'utiliser l'adresse /chat qui cible l'un des modèles de discussion.

| Méthode | Charge utile |

|---|---|

| Demande POST | compartmentID.

|

| Réponse |

|

Synthétiser les charges utiles

Ce modèle a été retraité. Nous vous recommandons de migrer vers l'adresse

/chat, ce qui implique de modifier la charge utile existante pour utiliser l'adresse /chat qui cible l'un des modèles de discussion ultérieurs.

| Méthode | Charge utile |

|---|---|

| Demande POST |

compartmentID.

|

| Réponse |

|