Modèles recommandés pour les lacs de données basés sur le Cloud

Selon votre cas d'utilisation, les lacs de données peuvent être construits sur Object Storage ou Hadoop. Tous deux peuvent évoluer et s’intégrer de manière transparente aux données et aux outils d’entreprise existants. Examinez les modèles Greenfield ou Migration de votre organisation. Choisissez le modèle Greenfield ou Migration selon que vous planifiez une implémentation complètement nouvelle ou souhaitez migrer votre solution Big Data existante vers Oracle Cloud.

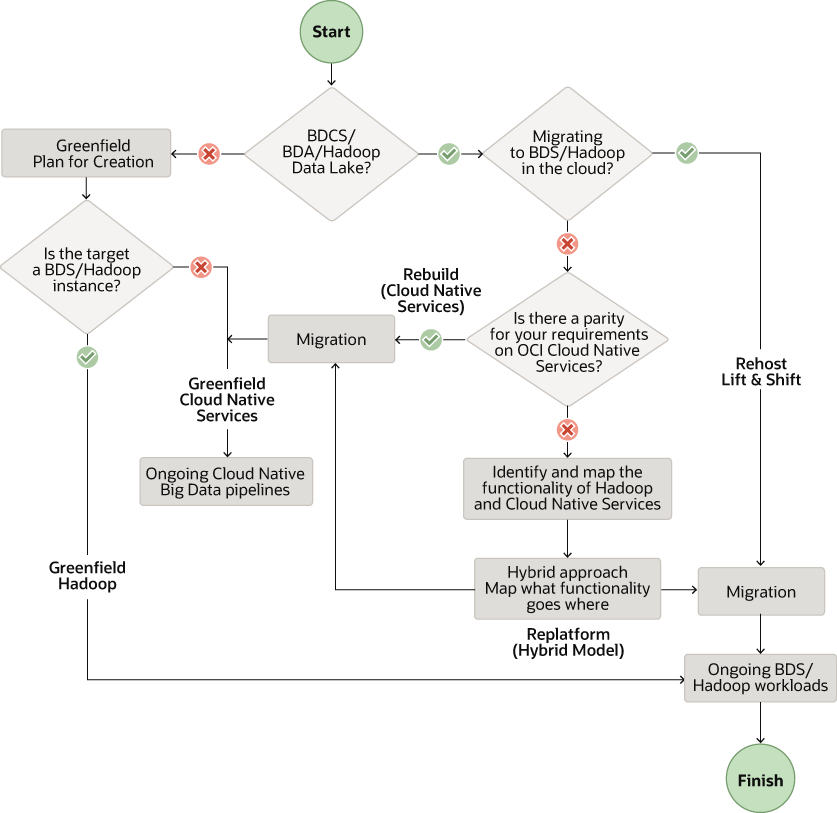

Le workflow suivant présente les modèles recommandés en fonction de vos besoins.

Description de l'illustration data-lake-solution-pattern.png

Remarque :

Dans ce document, nous nous concentrons sur la migration des clusters Big Data Appliance (BDA) et Big Data Cloud Services (BDCS) vers OCI en fonction de la distribution Cloudera de Hadoop (CDH). Toutefois, ces recommandations s'appliquent à d'autres distributions Hadoop sur site et dans le cloud.

Créer une nouvelle plate-forme de données sur Oracle Cloud (Greenfield)

Vous pouvez construire des lacs de données dans les projets Oracle Cloud for Greenfield. Utilisez Big Data Service (BDS) pour les lacs de données basés sur HDFS. Utiliser les services de données natifs cloud OCI pour les lacs de données basés sur Object Storage sans utiliser HDFS.

Services de données natifs cloud

Créez un lac de données dans OCI Object Storage et utilisez les services Cloud Native Data et AI. Ces services incluent Data Flow, Data Integration, Autonomous Data Warehouse, Data Catalog et Data Science, ainsi que quelques autres.

Oracle recommande les services suivants pour construire un nouveau lac de données :

- Object Storage en tant que stockage dans le lac de données pour tous les types de données brutes

- Service Data Flow pour les processus en batch Spark et les clusters Spark éphémères

- Service Data Integration pour l'ingestion de données et pour les travaux ETL

- Autonomous Data Warehouse (ADW) pour servir et présenter les données de couche

- Data Catalog pour le repérage et la gouvernance des données

Oracle recommande les services supplémentaires suivants pour construire un nouveau lac de données :

- Service de transmission en continu pour une ingestion gérée de données en temps réel

- Service Data Transfer Appliance (DTA) pour un transfert de données en masse unique

- Service GoldenGate pour les données Change Data Capture (CDC) et les analyses de diffusion en continu

- Service Data Science pour répondre aux exigences en matière d'apprentissage automatique

- Service Oracle Analytics Cloud (OAC) pour les exigences de BI, d'analyse et de reporting

Big Data Service

Créez votre lac de données dans HDFS à l'aide d'Oracle Big Data Service (BDS). BDS fournit les composants Hadoop les plus couramment utilisés, notamment HDFS, Hive, HBase, Spark et Oozie.

Oracle recommande les services suivants pour créer un lac de données à l’aide de clusters Hadoop :

- Service Data Integration pour l'ingestion de données et pour les travaux ETL

- Service Data Transfer Appliance (DTA) pour un transfert de données en masse unique

- Service GoldenGate pour les données CDC et les analyses de transmission en continu

- Service Data Catalog pour le repérage et la gouvernance des données

- Service Data Science pour répondre aux exigences en matière d'apprentissage automatique

- Service OAC pour les exigences de BI, d’analyse et de reporting

- BDS pour HDFS et d’autres composants Hadoop

Workflow de modèle Greenfield

Lorsque vous créez un lac de données, suivez ce workflow à partir des exigences via des tests et des validations :

- Conditions requises : énumérer les conditions requises pour les nouveaux environnements dans OCI

- Evaluation : évaluez les services et outils OCI requis

- Conception : concevez l'architecture et le dimensionnement de votre solution pour OCI

- Plan : Créez un plan détaillé mappant votre temps et vos ressources

- Provisionnement : provisionnez et configurez les ressources requises dans OCI

- Implémentation : implémentez les charges globales de vos données et applications

- Automatiser le pipeline : orchestrer et planifier des pipelines de workflow pour l'automatisation

- Tester et valider : effectuez des tests de validation, fonctionnels et de performances pour la solution de bout en bout

Migration de la plate-forme de données existante sur Oracle Cloud

Recréer le modèle

Utilisez le modèle de reconstruction si vous ne souhaitez pas utiliser de clusters Hadoop et que vous souhaitez migrer vers des services natifs cloud dans Oracle Cloud Infrastructure (OCI). Commencez par une ardoise propre pour l’architecte et commencez à implémenter entièrement dans OCI. Tirez parti des services natifs Cloud gérés pour tous les composants majeurs de votre pile. Par exemple, créez une pile à l'aide de Data Flow, Data Catalog, Data Integration, Streaming, Data Science, ADW et OAC.

Oracle recommande que ces services migrent vers un lac de données basé sur le cloud sans clusters Hadoop :

- Service Object Storage en tant que magasin de lac de données pour tous les types de données brutes

Remarque :

Vous pouvez utiliser Object Storage avec un connecteur HDFS en tant que magasin HDFS à la place de HDFS dans le cluster Hadoop ou Spark. - Service Data Integration pour l'ingestion de données et pour les travaux ETL

- Service de transmission en continu pour l'ingestion gérée de données en temps réel, qui peut remplacer vos services Kafka ou Flume autogérés

- Appliance de transfert de données pour le transfert en masse unique de données

- GoldenGate pour les données CDC et les analyses de transmission en continu

- Service Data Flow pour les processus en batch Spark et les clusters Spark éphémères

- ADW pour traiter et présenter les données de la couche

- Service Data Catalog pour le repérage et la gouvernance des données

- Service Data Science pour les besoins en apprentissage automatique

- Service OAC pour les exigences de BI, d’analyse et de reporting

Modèle de réapprovisionnement

Utilisez le modèle de migration de réplate-forme si vous souhaitez utiliser des clusters Hadoop sur le cloud et remplacer certains composants par des services cloud natifs. Utilisez Big Data Service pour HDFS et d'autres composants Hadoop, et redéfinissez une partie de votre pile à l'aide de nos services natifs cloud gérés supplémentaires.

Vous devrez peut-être redéfinir votre pile pour utiliser le modèle de réplate-forme.

- Inclusion de services natifs Cloud sans serveur avec BDS dans OCI

- Exploiter les services natifs du cloud géré lorsque cela est possible

Vous pouvez remplacer certains de ces composants en fonction de vos besoins.

- BDS pour HDFS et d'autres composants Hadoop tels que Hive, HBase, Kafka et Oozie

- Service Data Integration pour l'ingestion de données et pour les travaux ETL

- Service Data Transfer Appliance pour un transfert en masse unique de données

- Service GoldenGate pour les données CDC et les analyses de transmission en continu

- Service Data Catalog pour le repérage et la gouvernance des données

- Service Data Science pour les besoins en apprentissage automatique

- Service OAC pour les exigences de BI, d’analyse et de reporting

Modèle de réhôte

Migrez votre BDA, BDCS et d'autres clusters Hadoop pour construire votre lac de données dans HDFS à l'aide de Big Data Service (BDS). Vous pouvez utiliser une approche de transfert et de déplacement lorsque vous utilisez le modèle de réhôte. Tous les composants Hadoop couramment utilisés, y compris HDFS, Hive, HBase, Spark et Oozie, sont disponibles dans les clusters Hadoop gérés fournis par BDS.

Workflow de modèle de migration

Lorsque vous migrez votre lac de données vers Oracle Cloud, suivez ce workflow des besoins jusqu’au nouvel environnement.

- Repérage et exigences : repérez et répertoriez le système actuel afin de répertorier les exigences du nouvel environnement OCI

- Evaluation : évaluez les services et outils OCI requis

- Conception : concevez l'architecture et le dimensionnement de votre solution pour OCI

- Plan : Créez un plan détaillé mappant votre temps et vos ressources

- Provisionnement : provisionnez et configurez les ressources requises dans OCI

- Migrer les données : transférez les données et les métadonnées dans le stockage de données des services OCI sélectionnés.

- Migrer la charge globale : migrez vos charges de travail et vos applications vers les services OCI à l'aide du modèle de migration sélectionné.

- Automatiser le pipeline : orchestrer et planifier des pipelines de workflow pour l'automatisation

- Tester et valider : planifier le test et la validation fonctionnels et des performances pour l'environnement OCI final

- Basculement : désactivez l'environnement source et passez à l'utilisation uniquement à l'aide du nouvel environnement OCI.