En savoir plus sur la conception des lacs de données dans Oracle Cloud

OCI propose un portefeuille robuste et complet de données de plate-forme cloud et d’infrastructure afin d’accéder à, de stocker et de traiter un large éventail de types de données, quelle que soit leur source. OCI vous permet d’implémenter des architectures de bout en bout à l’échelle de l’entreprise et d’IA dans le Cloud. Ce livre de jeux de solutions vous donne un aperçu des services clés qui vous aident à créer et à utiliser des lacs de données sur OCI. Vous en apprendrez également sur les autres services disponibles et pouvez concevoir vos solutions de lac de données en fonction de certains de nos modèles complets et de nos conseils experts.

Architecture

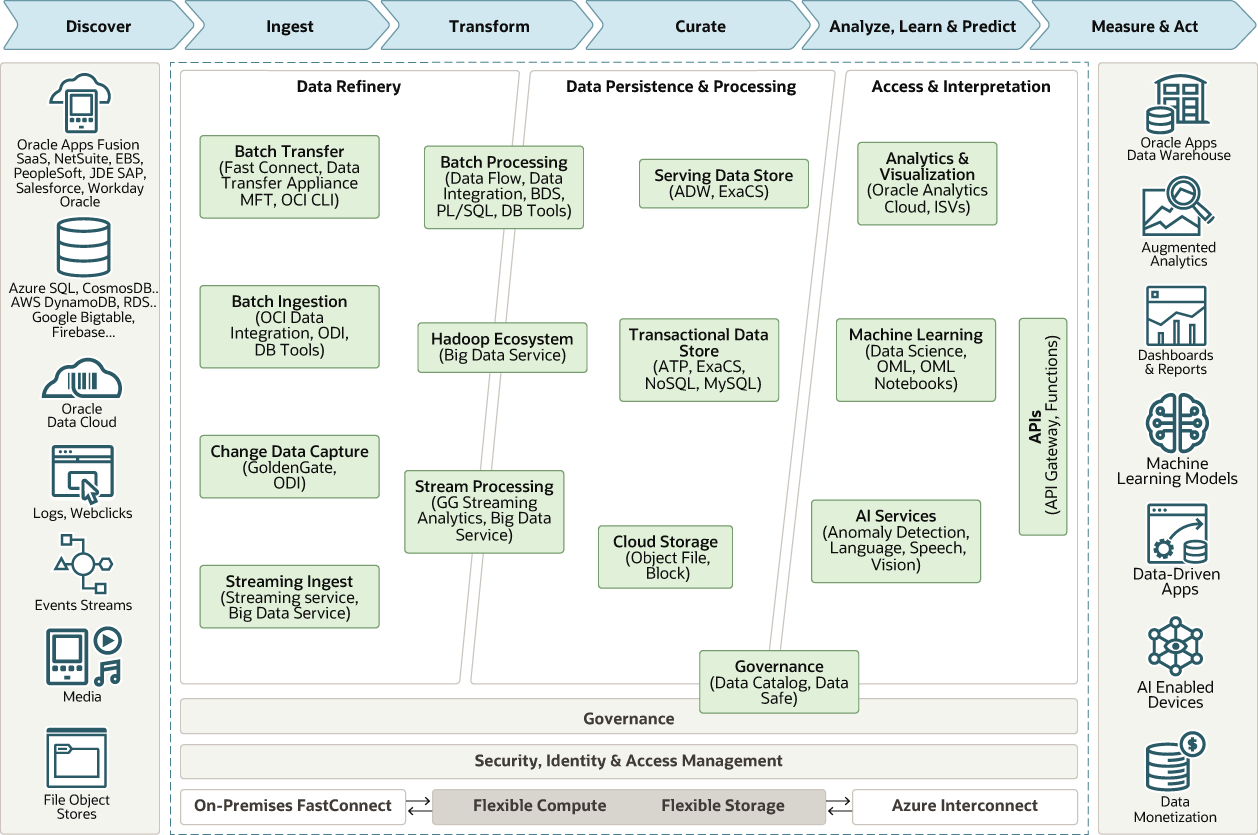

Cette architecture combine les capacités d'un lac de données et d'un data warehouse à traiter différents types de données à partir d'un large éventail de ressources de données d'entreprise. Utilisez cette architecture pour concevoir des architectures de lac de données de bout en bout dans OCI.

Ce diagramme présente une architecture de haut niveau des services de données et d'IA Oracle.

Description de l'illustration data-lakes.png

Dans cette architecture, les données passent par les étapes suivantes :

- Raffinerie de données

Ingère et affine les données à utiliser dans chacune des couches de données de l'architecture.

- Traitement de la persistance des données (couche d'informations saturées)

Facilite l'accès et la navigation des données pour afficher la vue métier actuelle. Pour les technologies relationnelles, les données peuvent être logiquement ou physiquement structurées sous des formes relationnelles, longitudinales, dimensionnelles ou OLAP simples. Pour les données non relationnelles, cette couche contient un ou plusieurs pools de données, issus d'un processus analytique ou optimisés pour une tâche analytique spécifique.

- Accéder à l'interprétation &

Abstrait la vue logique des données pour les consommateurs. Cette abstraction facilite le développement Agile, la migration vers l'architecture cible et la fourniture d'une seule couche de reporting à partir de plusieurs sources fédérées.

Cette architecture comporte les composants suivants :

- Big Data Service

Oracle Big Data Service (BDS) est un service cloud automatisé entièrement géré qui fournit aux clusters un environnement Hadoop. BDS permet aux clients de déployer facilement des clusters Hadoop de toutes tailles et simplifie le processus de mise à disposition et de sécurité des clusters Hadoop. Basé sur les meilleures pratiques d’Oracle, BDS implémente la haute disponibilité et la sécurité et réduit le besoin de compétences Hadoop avancées. BDS propose les composants Hadoop couramment utilisés, ce qui facilite le déplacement des charges de travail vers le cloud et garantit leur compatibilité avec les solutions sur site.

Oracle Cloud SQL est un service complémentaire disponible qui permet aux clients de lancer des requêtes SQL Oracle sur les données dans HDFS, Kafka et Oracle Object Storage. Tout utilisateur, application ou outil d'analyse peut utiliser les banques de données pour minimiser les mouvements de données et accélérer les requêtes. BDS interagit avec les services d’intégration des données, de science des données et d’analyse, tout en permettant aux développeurs d’accéder facilement aux données à l’aide d’Oracle SQL. Les entreprises peuvent éliminer les silos de données et s’assurer que les lacs de données ne sont pas isolés des autres sources de données d’entreprise.

- Catalogue de données

Oracle Cloud Infrastructure Data Catalog est une solution de repérage et de gouvernance de données en libre-service entièrement gérée pour vos données d'entreprise. Les catalogues de données sont essentiels à la capacité d'une organisation à rechercher et à rechercher des données à analyser. Ils aident les professionnels des données à découvrir les données et à prendre en charge la gouvernance des données.

Utilisez Data Catalog en tant qu'environnement collaboratif unique pour gérer les métadonnées métier, techniques et opérationnelles. Vous pouvez collecter des métadonnées techniques à partir d'un grand nombre de sources de données prises en charge accessibles à l'aide d'adresses IP publiques ou privées. Vous pouvez organiser, rechercher, comprendre, enrichir et activer ces métadonnées. Utiliser la collecte automatique sur demande ou planifiée pour garantir que le catalogue de données contient toujours des informations à jour. Vous bénéficiez de la sécurité, de la fiabilité, des performances et de l'évolutivité d'Oracle Cloud.

-

Flux de données

Oracle Cloud Infrastructure Data Flow est un service entièrement géré permettant d'exécuter les applications Apache Spark. Les applications Data Flow sont des modèles réutilisables composés d'une application Spark, de ses dépendances, de paramètres par défaut et d'une spécification de ressource d'exécution par défaut. Vous pouvez gérer tous les aspects de Data Flow et le cycle de vie du développement d'applications, suivre et exécuter des travaux Apache Spark à l'aide des API REST via la passerelle d'API et les fonctions disponibles.

Data Flow prend en charge la livraison rapide des applications en permettant aux développeurs de se concentrer sur le développement de leurs applications. Il fournit la gestion des journaux et un environnement d'exécution pour exécuter des applications. Vous pouvez intégrer les applications, les workflows et accéder aux API via l'interface utilisateur. Il élimine la nécessité de configurer l'infrastructure, le provisionnement de cluster, l'installation logicielle, le stockage et la sécurité.

- Autonomous Data Warehouse

Oracle Autonomous Data Warehouse est un service de base de données autonome, auto-sécurisé et auto-réparateur optimisé pour les charges de travail d'entreposage de données. Vous n'avez pas besoin de configurer ou de gérer du matériel, ni d'installer un logiciel. Oracle Cloud Infrastructure gère la création de la base de données, ainsi que la sauvegarde, l'application de patches, la mise à niveau et le réglage de la base de données.

- Intégration de données

Oracle Cloud Infrastructure Data Integration est un service cloud sans serveur entièrement géré qui permet d'ingérer et de transformer des données pour la science et l'analyse des données. L'intégration des données simplifie vos processus complexes d'extraction, de transformation et de chargement de données (ETL/E-LT) en lacs et entrepôts de données pour la science et l'analyse des données avec le concepteur Data Flow d'Oracle. Elle fournit une protection automatisée contre les dérives de schéma avec un flux d'intégration basé sur des règles qui vous aide à éviter les flux d'intégration interrompus et à réduire la maintenance au fur et à mesure de l'évolution des schémas de données.

-

Science des données

Oracle Cloud Infrastructure Data Science est une plate-forme entièrement gérée et sans serveur qui permet aux analystes de données de créer, d'entraîner et de gérer des modèles d'apprentissage automatique sur Oracle Cloud Infrastructure. Les analystes de données peuvent utiliser la bibliothèque Oracle Accelerated Data Science (ADS) améliorée par Oracle pour le machine learning automatisé (AutoML), l'évaluation de modèle et l'explication de modèle.

ADS est une bibliothèque Python qui contient un ensemble complet de connexions de données, qui permet aux data scientists d’accéder aux données de nombreuses banques de données différentes et de les utiliser pour produire de meilleurs modèles. La bibliothèque ADS prend en charge AutoML d'Oracle, ainsi que des outils open source tels que H2O.ai et Auto-Sklearn.

Les analystes de données et les administrateurs d’infrastructure peuvent facilement déployer des modèles de science des données en tant qu’Oracle Functions, une architecture à la demande et sans serveur hautement évolutive sur OCI. Les membres de l'équipe peuvent utiliser le catalogue de modèles pour conserver et partager les modèles de machine learning terminés et les artefacts nécessaires à leur reproduction, leur test et leur déploiement.

A propos des lacs de données

Un lac de données est un référentiel centralisé et évolutif qui permet de stocker des données brutes et de stocker toutes ses données dans un environnement flexible et économique. Un lac de données fournit un mécanisme de stockage flexible pour le stockage de données brutes. Pour qu’un lac de données soit efficace, une organisation doit examiner ses besoins spécifiques en matière de gouvernance, ses workflows et ses outils. Le développement de ces éléments clés crée un lac de données puissant qui s’intègre de manière transparente aux architectures existantes et connecte facilement les données aux utilisateurs.

- Délai de prise de décisions accéléré grâce à l’analyse et à l’apprentissage automatique

- Collecte et extraction de Big Data pour les data scientists, les analystes et les développeurs

Pour rendre les données non structurées stockées dans un lac de données utiles, vous devez les traiter et les préparer à des fins d'analyse. Cela est souvent difficile si vous ne disposez pas de nombreuses ressources d'ingénierie des données.

Ce qui suit répertorie les défis techniques liés à la gestion des lacs de données sur site.

- Coûts initiaux et manque de flexibilité : lorsque les entreprises créent leur propre infrastructure on-premise, elles doivent planifier, approvisionner et gérer l'infrastructure matérielle, mettre en place des serveurs et gérer les pannes et les temps d'arrêt.

- Coûts de maintenance continus : lorsque vous exploitez un lac de données on-premise, qui se manifeste principalement dans les coûts informatiques et d'ingénierie, les entreprises doivent prendre en compte les coûts de maintenance continus. Cela inclut également les coûts d'application de patches, de maintenance, de mise à niveau et de prise en charge de l'infrastructure matérielle et logicielle sous-jacente.

- Manque de tâches administratives et d'agilité : les services informatiques doivent provisionner des ressources, gérer des charges de travail inégales à grande échelle et suivre le rythme de l'innovation logicielle open source, axée sur la communauté, qui évolue rapidement.

- Complexité de la création de pipelines de données : les ingénieurs de données doivent gérer la complexité de l'intégration d'un large éventail d'outils pour intégrer, organiser, prétraiter, orchestrer des travaux ETL par lots, et interroger les données stockées dans le lac.

-

Evolutivité et utilisation des ressources non optimale : au fur et à mesure de la croissance de votre base d'utilisateurs, votre organisation doit gérer manuellement l'utilisation des ressources et créer des serveurs supplémentaires pour évoluer à la demande. La plupart des déploiements sur site de Hadoop et de Spark lient directement les ressources de calcul et de stockage aux mêmes serveurs, ce qui crée un modèle inflexible.

Vous trouverez ci-dessous les avantages commerciaux liés au déplacement de vos lacs de données vers le cloud.

- Réduction des coûts d'ingénierie et des services gérés : créez des pipelines de données pré-intégrés plus efficacement à l'aide d'outils cloud et réduisez les coûts d'ingénierie des données. Transférez la gestion de la mise à l'échelle à votre fournisseur cloud à l'aide de services cloud tels qu'Object Storage et Autonomous Data Warehouse (ADW) qui fournissent une mise à l'échelle transparente. Il n'est pas nécessaire d'ajouter des machines ni de gérer des clusters sur des lacs de données basés sur le cloud.

- Tirer parti de l'infrastructure agile et des dernières technologies : concevez votre lac de données pour de nouveaux cas d'utilisation avec notre infrastructure cloud flexible, agile et à la demande. Vous pouvez rapidement mettre à niveau les dernières technologies et ajouter de nouveaux services cloud dès qu'ils sont disponibles, sans redéfinir votre architecture.