Déployer le modèle de base

Assurez-vous que vous avez accès à une location OCI et que vous disposez de privilèges d'administration pour fournir suffisamment d'instances de CPU/GPU.

- Installez un cluster OKE à l'aide du module Terraform ci-dessous. Un cluster OKE avec un pool de noeuds unique sera créé avec 6 noeuds de processus actif.

- Cliquez ci-dessous sur Déployer vers Oracle Cloud.

- Attribuez à votre pile un nom (par exemple, oke-stack).

- Sélectionnez le compartiment dans lequel déployer les modèles de base d'IA OCI.

- Indiquez des paramètres supplémentaires (tels que la taille des noeuds, le nombre de noeuds) en fonction de vos préférences.

- Cliquez sur Suivant, puis sur Créer et enfin sur Exécuter l'application pour provisionner le cluster.

- Connectez-vous à la console Oracle Cloud Infrastructure et, sur la page d'accueil, cliquez sur Stockage, puis sous Object Storage, cliquez sur Buckets. Indiquez un nom de bucket que vous utiliserez dans le déploiement OCI AI Blueprints.

Cliquez sur le bucket que vous avez créé, puis sur le lien Demandes pré-authentifiées sous Ressources. Attribuez un nom à la demande pré-authentifiée, remplacez le type d'accès PAR Autoriser les lectures et les écritures d'objet, puis cliquez sur Demandes pré-authentifiées. Une fois l'opération terminée, copiez l'URL de la demande pré-authentifiée et enregistrez-la dans un emplacement tel que vous en aurez besoin lors du déploiement du modèle de base Inférence de la CPU.

- Installez les modèles de base d'IA OCI dans le nouveau cluster OKE. Une fois le déploiement réussi, vous disposez d'une URL permettant d'accéder à la console OCI AI Blueprints.

- Sur la page principale des modèles de base d'IA OCI, plusieurs modèles de base sont disponibles pour déploiement sous Binaire de modèle de base, faites défiler la page vers le bas et cliquez sur Déployer sous Inférence d'UC.

- Sélectionnez Inférence d'UC avec mistral et VM-Standard.E4. Option Flex.

Utilisez les paramètres par défaut et modifiez l'URL de la demande pré-authentifiée créée ci-dessus. Ne modifiez aucune valeur dans la section Configurer les paramètres.

Veuillez noter les paramètres :

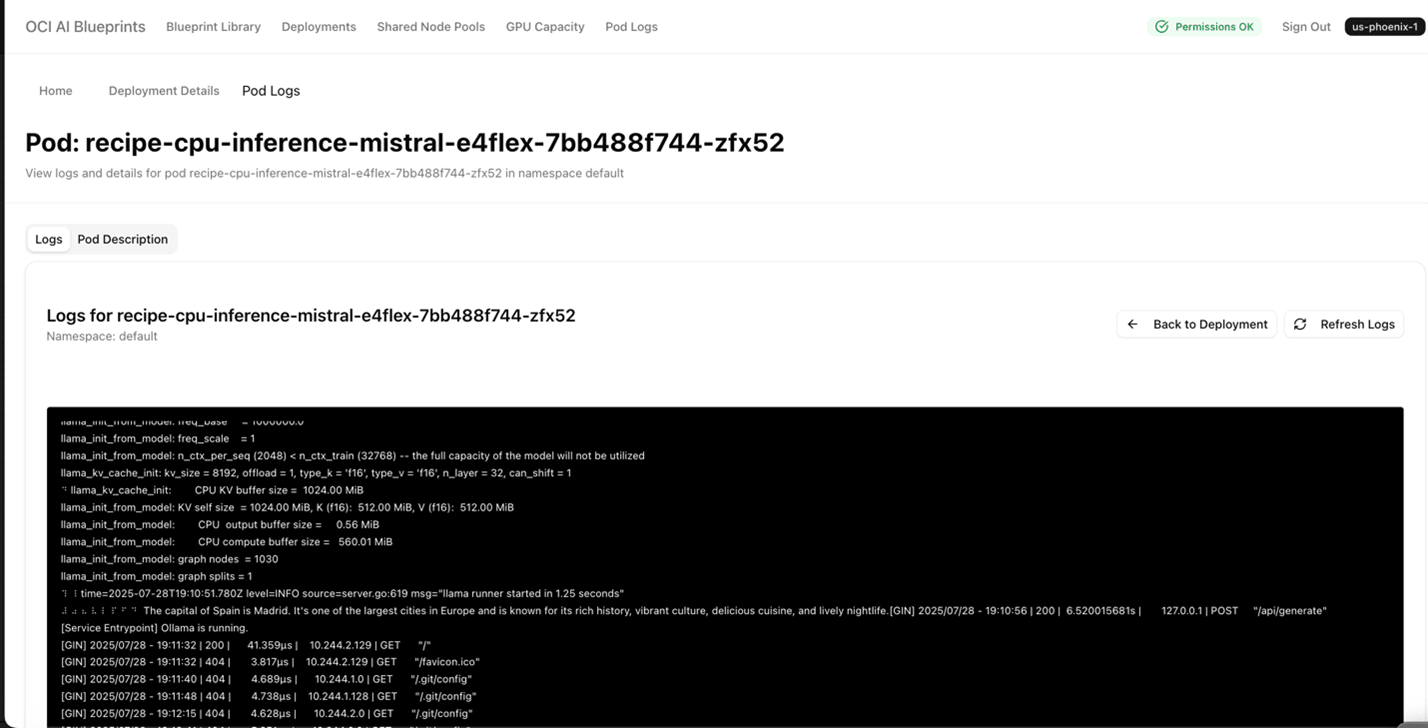

"recipe_container_env": [ { "key": "MODEL_NAME", "value": "mistral" }, { "key": "PROMPT", "value": "What is the capital of Spain?" }Une fois le modèle de base d'inférence d'UC déployé, la sortie de l'invite ci-dessus est affichée dans le journal de pod Kubernetes.

- Cliquez sur Déployer le modèle de base. Une fois le modèle de base déployé, vous remarquerez un nom tel que cpu inference mistral E4Flex qui répertorie le statut de déploiement de Monitoring avec la date de création et le nombre de noeuds et de formes E4.

- Dans la liste Déploiement, cliquez sur le lien mistral d'inférence CPU E4Flex qui vous amènera aux détails du déploiement avec l'adresse publique. Cliquez sur l'adresse publique pour afficher un message tel que "ollama is running".

- Revenez à la page cpu inference mistral E4Flex et faites défiler la page jusqu'à Pod logs. Cliquez sur Visualiser et sur Détails du journal. Une page semblable à la suivante s'affiche pour vous donner la sortie.

- Sélectionnez Inférence d'UC avec mistral et VM-Standard.E4. Option Flex.