En savoir plus sur le modèle de base d'inférence de CPU

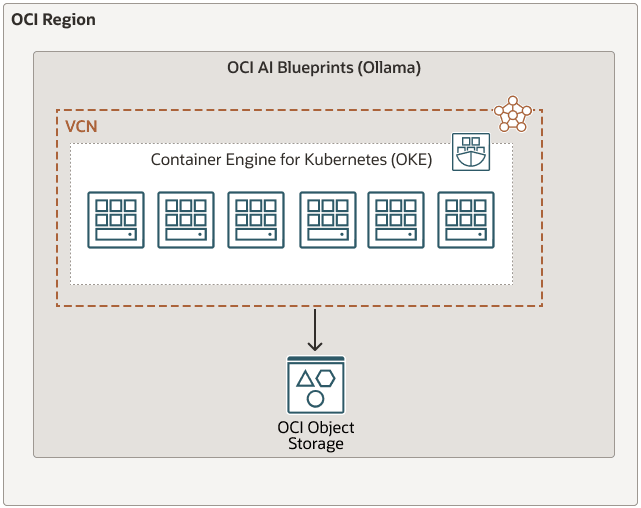

Les modèles d'IA d'Oracle Cloud Infrastructure sont une solution rationalisée et sans code pour le déploiement et la gestion des workloads d'IA générative sur Oracle Cloud Infrastructure Kubernetes Engine (OKE).

En fournissant des recommandations matérielles avisées, des piles logicielles prêtes à l'emploi et des outils d'observabilité prêts à l'emploi, OCI AI Blueprints vous aide à exécuter vos applications d'IA rapidement et efficacement, sans vous soucier des complexités des décisions d'infrastructure, de la compatibilité logicielle et des meilleures pratiques en matière d'opérations de machine learning (ML Ops).

Ce plan d'inférence de CPU fournit un cadre complet pour tester l'inférence sur les CPU à l'aide de la plate-forme Ollama avec une variété de modèles pris en charge tels que Mistral, Gemma et d'autres disponibles via Ollama. Contrairement aux solutions GPU, ce modèle de base est conçu pour les environnements où l'inférence CPU est préférée ou requise.

Le modèle de base offre des directives claires et des paramètres de configuration pour déployer un service d'inférence CPU robuste et permettre ainsi des évaluations approfondies des performances et des tests de fiabilité. L'architecture légère et efficace d'Ollama en fait une solution idéale pour les développeurs qui cherchent à évaluer et à optimiser les charges de travail d'inférence basées sur le processeur.

Ce modèle de base explique comment utiliser l'inférence CPU pour exécuter de grands modèles de langage à l'aide d'Ollama. Il comprend deux stratégies principales de déploiement :

- Servir des modèles préenregistrés directement à partir d'Oracle Cloud Infrastructure Object Storage

- Extraction des modèles à partir d'Ollama et enregistrement dans OCI Object Storage