Uso di Oracle NoSQL Database Migrator

Scopri di più su Oracle NoSQL Database Migrator e su come utilizzarlo per la migrazione dei dati.

Oracle NoSQL Database Migrator è uno strumento che consente di eseguire la migrazione delle tabelle NoSQL di Oracle da un'origine dati a un'altra. Questo strumento può essere utilizzato su tabelle in Oracle NoSQL Database Cloud Service, Oracle NoSQL Database on premise e AWS S3. Lo strumento Migrator supporta diversi formati di dati e tipi di supporti fisici. I formati di dati supportati sono i file JSON, Parquet, JSON in formato MongoDB, JSON in formato DynamoDB e CSV. I tipi di supporto fisici supportati sono file, OCI Object Storage, Oracle NoSQL Database on-premise, Oracle NoSQL Database Cloud Service e AWS S3.

Questo articolo contiene i seguenti argomenti:

Argomenti correlati

Panoramica

Oracle NoSQL Database Migrator consente di spostare le tabelle NoSQL di Oracle da un'origine dati a un'altra, ad esempio Oracle NoSQL Database on-premise o nel cloud o persino un semplice file JSON.

In molti casi è necessario eseguire la migrazione delle tabelle NoSQL da o a un Oracle NoSQL Database. Ad esempio, un team di sviluppatori che migliora un'applicazione NoSQL Database potrebbe voler eseguire il test del codice aggiornato nell'istanza locale di Oracle NoSQL Database Cloud Service (NDCS) utilizzando cloudim. Per verificare tutti i casi di prova possibili, devono impostare i dati di prova simili ai dati effettivi. A tale scopo, devono copiare le tabelle NoSQL dall'ambiente di produzione all'istanza NDCS locale, l'ambiente cloudim. In un'altra situazione, gli sviluppatori di NoSQL potrebbero dover spostare i dati delle applicazioni da on premise al cloud e viceversa, sia per lo sviluppo che per i test.

In tutti questi casi e in molti altri, puoi utilizzare Oracle NoSQL Database Migrator per spostare le tabelle NoSQL da un'origine dati all'altra, ad esempio Oracle NoSQL Database on premise o cloud o anche un semplice file JSON. È inoltre possibile copiare le tabelle NoSQL da un file di input JSON in formato MongoDB, da un file di input JSON in formato DynamoDB (archiviato nell'origine S3 AWS o dai file) oppure da un file CSV nel database NoSQL in locale o nel cloud.

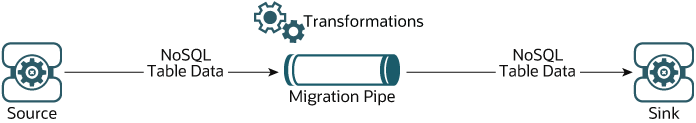

Come illustrato nella figura riportata di seguito, la utility NoSQL Migrator database funge da connettore o pipe tra l'origine dati e la destinazione (definita sink). In sostanza, questa utility esporta i dati dall'origine selezionata e li importa nel sink. Questo strumento è orientato alle tabelle, ovvero è possibile spostare i dati solo a livello di tabella. Un singolo task di migrazione opera su una singola tabella e supporta la migrazione dei dati di tabella dall'origine al sink in vari formati di dati.

Terminologia utilizzata con Oracle NoSQL Database Migrator

Informazioni dettagliate sui diversi termini utilizzati nel diagramma precedente.

- Origine: entità da cui vengono esportate le tabelle NoSQL per la migrazione. Alcuni esempi di origini sono Oracle NoSQL Database in locale o cloud, file JSON, file JSON in formato MongoDB, file JSON in formato DynamoDB e file CSV.

- Sink: entità che importa le tabelle NoSQL da NoSQL Migrator database. Alcuni esempi di sink sono Oracle NoSQL Database on premise o file cloud e JSON.

Lo strumento NoSQL Migrator database supporta diversi tipi di origini e sink (ovvero supporti fisici o repository di dati) e formati di dati (ovvero il modo in cui i dati vengono rappresentati nell'origine o nel sink). I formati di dati supportati sono i file JSON, Parquet, JSON in formato MongoDB, JSON in formato DynamoDB e CSV. I tipi di origine e sink supportati sono file, OCI Object Storage, Oracle NoSQL Database on premise e Oracle NoSQL Database Cloud Service.

- Pipe di migrazione: i dati di un'origine verranno trasferiti al sink da NoSQL Database Migrator. Può essere visualizzata come pipe di migrazione.

- Trasformazioni: è possibile aggiungere regole per modificare i dati della tabella NoSQL nella pipe di migrazione. Queste regole sono chiamate trasformazioni. Oracle NoSQL Database Migrator consente le trasformazioni dei dati solo nei campi o nelle colonne di livello superiore. Non consente di trasformare i dati nei campi nidificati. Alcuni esempi di trasformazioni consentite sono:

- Eliminare o ignorare una o più colonne,

- Rinominare una o più colonne oppure

- Aggrega diverse colonne in un singolo campo, in genere un campo JSON.

- File di configurazione: un file di configurazione consente di definire tutti i parametri necessari per l'attività di migrazione in formato JSON. Successivamente, si passa questo file di configurazione come singolo parametro al comando

runMigratordall'interfaccia CLI. Un tipico formato di file di configurazione è simile a quello mostrato di seguito.{ "source": { "type" : <source type>, //source-configuration for type. See Source Configuration Templates . }, "sink": { "type" : <sink type>, //sink-configuration for type. See Sink Configuration Templates . }, "transforms" : { //transforms configuration. See Transformation Configuration Templates . }, "migratorVersion" : "<migrator version>", "abortOnError" : <true|false> }Raggruppa Parametri Obbligatorio (S/N) Scopo Valori supportati sourcetypeY Rappresenta l'origine da cui eseguire la migrazione dei dati. L'origine fornisce dati e metadati (se presenti) per la migrazione. Per conoscere il valore typeper ogni origine, vedere Origini e lavandini supportati.sourceconfigurazione-origine per il tipo Y Definisce la configurazione per l'origine. Questi parametri di configurazione sono specifici del tipo di origine selezionato in precedenza. Per l'elenco completo dei parametri di configurazione per ciascun tipo di origine, vedere Modelli di configurazione di origine. sinktypeY Rappresenta il sink in cui eseguire la migrazione dei dati. Il sink è la destinazione o la destinazione per la migrazione. Per conoscere il valore typeper ogni origine, vedere Origini e lavandini supportati.sinksink-configuration per il tipo Y Definisce la configurazione per il sink. Questi parametri di configurazione sono specifici del tipo di sink selezionato in precedenza. Per l'elenco completo dei parametri di configurazione per ciascun tipo di sink, vedere Modelli di configurazione del collegamento. transformsconfigurazione trasformazioni N Definisce le trasformazioni da applicare ai dati nella pipe di migrazione. Per l'elenco completo delle trasformazioni supportate da NoSQL Data Migrator, vedere Modelli di configurazione della trasformazione. - migratorVersionN Versione di NoSQL Data Migrator - - abortOnErrorN Specifica se arrestare o meno l'attività di migrazione in caso di errore.

Il valore predefinito è true, che indica che la migrazione si interrompe ogni volta che si verifica un errore di migrazione.

Se si imposta questo valore su false, la migrazione continua anche in caso di record non riusciti o di altri errori di migrazione. I record non riusciti e gli errori di migrazione verranno registrati come WARNINGs sul terminale CLI.

true, false Nota

Poiché il file JSON distingue tra maiuscole e minuscole, tutti i parametri definiti nel file di configurazione fanno distinzione tra maiuscole e minuscole, a meno che non sia specificato diversamente.

Fonti e lavandini supportati

In questo argomento viene fornita la lista delle origini e dei sink supportati dall'Oracle NoSQL Database Migrator.

È possibile utilizzare qualsiasi combinazione di origine e sink valida da questa tabella per l'attività di migrazione. Tuttavia, è necessario assicurarsi che almeno una delle estremità, ovvero l'origine o il sink, debba essere un prodotto Oracle NoSQL. Non è possibile utilizzare NoSQL Migrator database per spostare i dati della tabella NoSQL da un file a un altro.

|

Tipo |

Formato |

Origine valida | Lavello valido |

|---|---|---|---|

|

Oracle NoSQL Database |

ND | Y | Y |

|

Oracle NoSQL Database Cloud Service |

ND | Y | Y |

|

File system |

JSON |

Y | Y |

|

MongoDB JSON |

Y | N | |

|

DynamoDB JSON |

Y | N | |

|

Parquet( |

N | Y | |

|

CSV |

Y | N | |

|

Storage degli oggetti OCI |

JSON |

Y | Y |

|

MongoDB JSON |

Y | N | |

|

Parquet( |

N | Y | |

|

CSV |

Y | N | |

| AWS S3 |

DynamoDB JSON |

Y | N |

Nota

Molti parametri di configurazione sono comuni nella configurazione di origine e sink. Per facilità di riferimento, la descrizione di tali parametri viene ripetuta per ogni sorgente e sink nelle sezioni della documentazione, che spiegano i formati dei file di configurazione per vari tipi di sorgenti e sink. In tutti i casi, la sintassi e la semantica dei parametri con lo stesso nome sono identiche.Sicurezza origine e lavandino

Alcuni tipi di origine e sink dispongono di informazioni di sicurezza facoltative o obbligatorie per l'autenticazione.

Tutte le origini e i sink che utilizzano i servizi in Oracle Cloud Infrastructure (OCI) possono utilizzare determinati parametri per fornire informazioni di sicurezza opzionali. Queste informazioni possono essere fornite utilizzando un file di configurazione o un principal dell'istanza OCI.

Le origini e i sink di Oracle NoSQL Database richiedono informazioni di sicurezza obbligatorie se l'installazione è sicura e utilizza un'autenticazione basata su Oracle Wallet. Queste informazioni possono essere fornite aggiungendo un file jar alla directory <MIGRATOR_HOME>/lib.

Autenticazione con i principal dell'istanza

I principal delle istanze sono una funzione del servizio IAM che consente agli attori o ai principal autorizzati di eseguire azioni sulle risorse del servizio. Ogni istanza di computazione dispone di una propria identità ed esegue l'autenticazione utilizzando i certificati aggiunti.

Oracle NoSQL Database Migrator offre un'opzione per connettersi a origini e sink di storage degli oggetti NoSQL e cloud utilizzando l'autenticazione del principal dell'istanza. È supportato solo quando lo strumento NoSQL Database Migrator viene utilizzato all'interno di un'istanza di computazione OCI, ad esempio lo strumento NoSQL Database Migrator in esecuzione in una VM ospitata su OCI. Per abilitare questa funzione, utilizzare l'attributo useInstancePrincipal del file di configurazione dell'origine cloud e del sink NoSQL. Per ulteriori informazioni sui parametri di configurazione per diversi tipi di origini e sink, vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

Per ulteriori informazioni sui principal delle istanze, vedere Chiamata di servizi da un'istanza.

Autorizzazione nelle origini e negli sink di Oracle NoSQL Database Cloud Service

L'accesso alle risorse in Oracle NoSQL Database Cloud Service, ad esempio tabelle, tablespace e API, viene gestito tramite criteri IAM (Identity and Access Management). Ciò garantisce che solo gli utenti o le applicazioni con le autorizzazioni di ispezione, lettura, uso o gestione delle tabelle appropriate all'interno di un compartimento specifico possano interagire con queste risorse. Per ulteriori informazioni, vedere Gestione dell'accesso alle tabelle NDCS.

Quando si utilizza la utility Migrator per importare o esportare dati dalle tabelle di Oracle NoSQL Database Cloud Service, le autorizzazioni IAM effettive determinano le risorse da cui è possibile leggere o scrivere. Se un utente di un gruppo definito tenta di eseguire un'azione oltre i privilegi autorizzati, la utility Migrator restituisce l'errore di autorizzazione corrispondente fornito da OCI IAM.

[INSUFFICIENT_PERMISSION] Authorization failed or requested resource not foundFlusso di lavoro per Oracle NoSQL Database Migrator

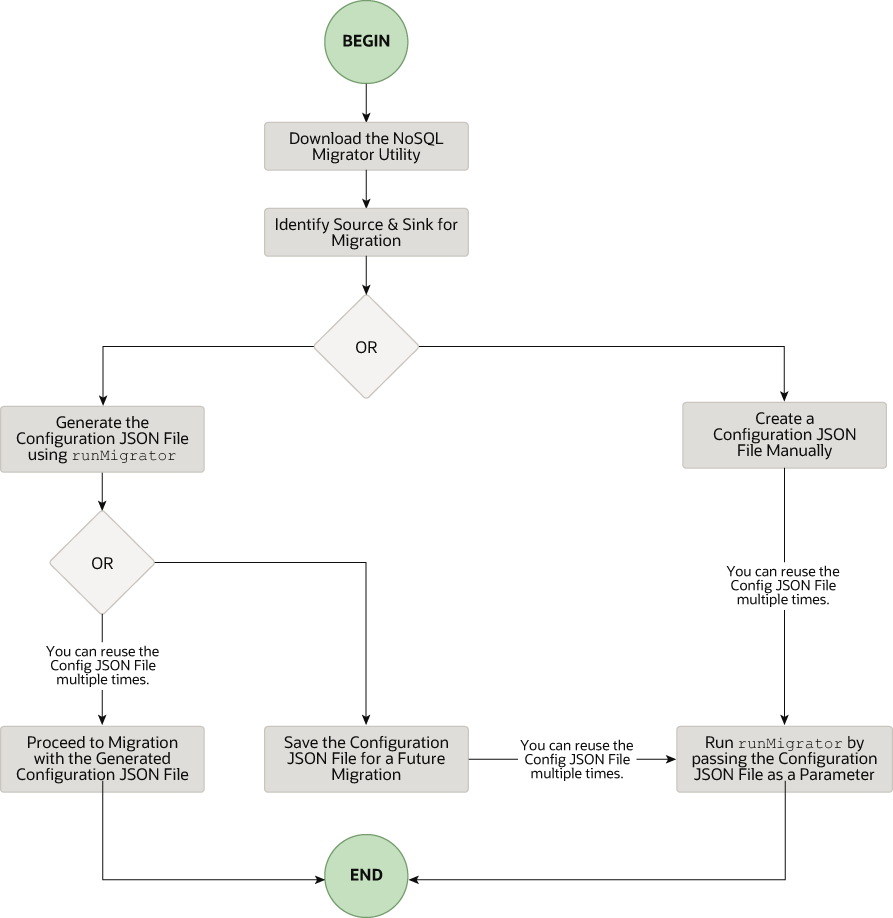

Scopri i vari passi necessari per utilizzare la utility Oracle NoSQL Database Migrator per la migrazione dei dati NoSQL.

Nella figura riportata di seguito viene illustrato il flusso di task di alto livello coinvolti nell'utilizzo di NoSQL Migrator database.

Scarica la utility NoSQL Data Migrator

runMigrator dall'interfaccia della riga di comando.

Nota

La utility Oracle NoSQL Database Migrator richiede l'esecuzione di Java 11 o versioni successive.Identificare l'origine e il lavandino

- Identificare lo schema della tabella sink: se il sink è Oracle NoSQL Database in locale o nel cloud, è necessario identificare lo schema per la tabella sink e assicurarsi che i dati di origine corrispondano allo schema di destinazione. Se necessario, utilizzare le trasformazioni per mappare i dati di origine alla tabella sink.

-

Schema predefinito: NoSQL Database Migrator fornisce un'opzione per creare una tabella sink con lo schema predefinito senza la necessità di predefinire lo schema per la tabella.

JSON in formato MongoDB:

Se l'origine è un file JSON in formato MongoDB, lo schema predefinito per la tabella sarà il seguente:CREATE TABLE IF NOT EXISTS <tablename>(id STRING, document JSON,PRIMARY KEY(SHARD(id))dove:

- tablename = valore fornito per l'attributo tabella nella configurazione.

— id = _id valore da ogni documento del file di origine JSON esportato MongoDB.

— documento = Per ogni documento nel file esportato MongoDB, il contenuto escluso il campo_idviene aggregato nella colonna del documento.Nota

- Se il valore _id non viene fornito come stringa nel file JSON in formato MongoDB, NoSQL Database Migrator lo converte in una stringa prima di inserirlo nello schema predefinito.

- Se la tabella <tablename> esiste già in Oracle NoSQL Database in locale o nel cloud e si desidera eseguire la migrazione dei dati alla tabella utilizzando la configurazione

defaultSchema, è necessario assicurarsi che la tabella esistente abbia la colonna ID in lettere minuscole (ID) e sia di tipo STRING.

JSON in formato DynamoDB:

Se l'origine è un file JSON in formato DynamoDB, lo schema predefinito per la tabella sarà il seguente:CREATE TABLE IF NOT EXISTS <tablename>(DDBPartitionKey_name DDBPartitionKey_type, [DDBSortKey_name DDBSortKey_type],DOCUMENT JSON, PRIMARY KEY(SHARD(DDBPartitionKey_name),[DDBSortKey_name]))dove:

— nome tabella = valore fornito per la tabella sink nella configurazione

- DDBPartitionKey_name = valore fornito per la chiave di partizione nella configurazione

- DDBPartitionKey_type = valore fornito per il tipo di dati della chiave di partizione nella configurazione

- DDBSortKey_name = valore fornito per la chiave di ordinamento nella configurazione, se presente

- DDBSortKey_type = valore fornito per il tipo di dati della chiave di ordinamento nella configurazione, se presente

— DOCUMENT = Tutti gli attributi tranne la partizione e la chiave di ordinamento di un elemento di tabella DynamoDB aggregato in una colonna JSON NoSQL

Se il formato di origine è un file CSV, uno schema predefinito non è supportato per la tabella di destinazione. È possibile creare un file di schema con una definizione di tabella contenente lo stesso numero di colonne e tipi di dati del file CSV di origine. Per ulteriori dettagli sulla creazione del file di schema, vedere Fornitura dello schema tabella.

Altre fonti valide:

Per tutte le altre origini, lo schema predefinito sarà il seguente:CREATE TABLE IF NOT EXISTS <tablename> (id LONG GENERATED ALWAYS AS IDENTITY, document JSON, PRIMARY KEY(id))dove:

- tablename = valore fornito per l'attributo tabella nella configurazione.

— id = un valore LONG generato automaticamente.

- documento = Il record JSON fornito dall'origine viene aggregato nella colonna del documento.

-

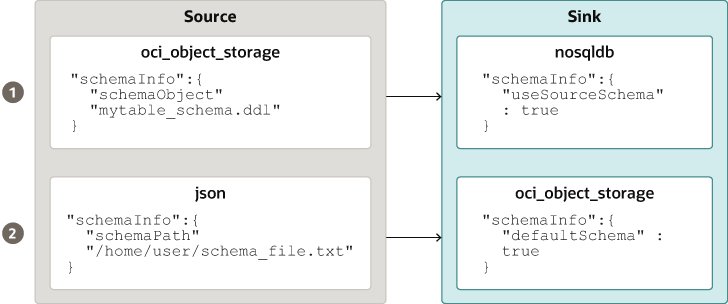

- Fornitura dello schema tabella: NoSQL Migrator database consente all'origine di fornire definizioni di schema per i dati della tabella utilizzando l'attributo schemaInfo. L'attributo schemaInfo è disponibile in tutte le origini dati per le quali non è già stato definito uno schema implicito. I data store del lavandino possono scegliere una delle seguenti opzioni.

- Utilizzare lo schema predefinito definito da NoSQL Migrator database.

- Utilizzare lo schema fornito dall'origine.

- Eseguire l'override dello schema fornito dall'origine definendone il proprio schema. Ad esempio, se si desidera trasformare i dati dallo schema di origine in un altro schema, è necessario sostituire lo schema fornito dall'origine e utilizzare la funzionalità di trasformazione dello strumento NoSQL Migrator database.

Il file di schema della tabella, ad esempiomytable_schema.ddl, può includere le istruzioni DDL della tabella. Lo strumento NoSQL Migrator database esegue questo file di schema tabella prima di avviare la migrazione. Lo strumento di migrazione supporta non più di un'istruzione DDL per riga nel file di schema. Di seguito sono riportati alcuni esempi.CREATE TABLE IF NOT EXISTS(id INTEGER, name STRING, age INTEGER, PRIMARY KEY(SHARD(ID)))Nota

La migrazione non riuscirà se la tabella è presente nel sink e la DDL inschemaPathè diversa dalla tabella. - Crea tabella lavandino: una volta identificato lo schema della tabella sink, creare la tabella sink tramite l'interfaccia CLI di amministrazione oppure utilizzando l'attributo

schemaInfodel file di configurazione sink. Vedere Modelli di configurazione del collegamento.Nota

Se l'origine è un file CSV, creare un file con i comandi DDL per lo schema della tabella di destinazione. Fornire il percorso del file nel parametro schemaInfo.schemaPath del file di configurazione del sink.

Eseguire il comando runMigrator

Il file eseguibile runMigrator è disponibile nei file estratti di NoSQL Database Migrator. Per eseguire correttamente il comando runMigrator è necessario installare Java 11 o versione successiva e bash sul sistema.

runMigrator in due modi:

- Creando il file di configurazione utilizzando le opzioni di runtime del comando

runMigratorcome mostrato di seguito.[~]$ ./runMigrator configuration file is not provided. Do you want to generate configuration? (y/n) [n]: y ... ...- Quando si richiama la utility

runMigrator, vengono fornite una serie di opzioni di runtime e viene creato il file di configurazione in base alle scelte effettuate per ciascuna opzione. - Dopo che la utility ha creato il file di configurazione, è possibile scegliere se procedere con l'attività di migrazione nella stessa esecuzione o salvare il file di configurazione per una migrazione futura.

- Indipendentemente dalla decisione di procedere o differire l'attività di migrazione con il file di configurazione generato, il file sarà disponibile per le modifiche o la personalizzazione per soddisfare i requisiti futuri. È possibile utilizzare il file di configurazione personalizzato per la migrazione in un secondo momento.

- Quando si richiama la utility

- Passando un file di configurazione creato manualmente (in formato JSON) come parametro di runtime utilizzando l'opzione

-co--config. È necessario creare il file di configurazione manualmente prima di eseguire il comandorunMigratorcon l'opzione-co--config. Per informazioni sui parametri di configurazione di origine e sink, vedere Oracle NoSQL Database Migrator Reference.[~]$ ./runMigrator -c </path/to/the/configuration/json/file>

Nota

NoSQL Migrator del database utilizza unità di lettura durante l'esecuzione dell'esportazione dei dati dalla tabella Oracle NoSQL Cloud Service a qualsiasi sink valido.Avanzamento migrazione log

Lo strumento NoSQL Migrator di database fornisce opzioni che consentono di stampare messaggi di trace, debug e avanzamento su un output standard o su un file. Questa opzione può essere utile per tenere traccia dell'avanzamento dell'operazione di migrazione, in particolare per tabelle o data set di grandi dimensioni.

- Livelli di log

Per controllare il funzionamento del log mediante lo strumento NoSQL Migrator database, passare il parametro --log-level o -l run time al comando

runMigrator. È possibile specificare la quantità di informazioni di log da scrivere passando il valore del livello di log appropriato.$./runMigrator --log-level <loglevel>Esempio:$./runMigrator --log-level debugTabella - Livelli di log supportati per NoSQL Migrator del database

Livello di log Descrizione avvertenza Stampa errori e avvisi. informazioni (predefinite) Stampa lo stato di avanzamento della migrazione dei dati, ad esempio la convalida dell'origine, la convalida del sink, la creazione di tabelle e il conteggio del numero di record di dati migrati. debug Visualizza ulteriori informazioni di debug. all Stampa tutto. Questo livello attiva tutti i livelli di registrazione. - File di log:

È possibile specificare il nome del file di log utilizzando il parametro --log-file o -f. Se --log-file viene passato come parametro di runtime al comando

runMigrator, NoSQL Database Migrator scrive tutti i messaggi di log nel file e nell'output standard.$./runMigrator --log-file <log file name>Esempio:$./runMigrator --log-file nosql_migrator.log

Limitazione

Oracle NoSQL Database Migrator non blocca il database durante il backup e blocca altri utenti. Pertanto, è consigliabile non eseguire le seguenti attività quando è in esecuzione un task di migrazione:

- Qualsiasi operazione DML/DDL nella tabella di origine.

- Qualsiasi modifica correlata alla topologia nel data store.

Migrazione dei metadati TTL per le righe tabella

Scopri come migrare i dati TTL dall'origine al sink.

Time to Live (TTL) è un meccanismo che consente di far scadere automaticamente le righe delle tabelle. TTL è espresso come la quantità di tempo, i dati sono autorizzati a vivere nel negozio. I dati che hanno raggiunto il valore di timeout di scadenza non possono più essere recuperati e non verranno visualizzati in alcuna statistica di memorizzazione.

Tabella - Migrazione dei metadati TTL

| Tipi di origine | Parametro di configurazione origine | Parametro di configurazione del lavandino |

|---|---|---|

| Oracle NoSQL Database | includeTTL |

includeTTL |

| Oracle NoSQL Database Cloud Service | includeTTL |

includeTTL |

| DynamoDB: file JSON formattato | ttlAttributeName |

includeTTL |

| DynamoDB: file JSON formattato memorizzato in AWS S3 | ttlAttributeName |

includeTTL |

Esportazione dei metadati TTL in Oracle NoSQL Database e Oracle NoSQL Database Cloud Service

NoSQL Migratore database fornisce il parametro di configurazione includeTTL per supportare l'esportazione dei metadati TTL della riga di tabella.

_metadata non viene incluso in modo esplicito nei dati esportati perché il relativo valore di scadenza è sempre 0. NoSQL Migrator database esporta l'ora di scadenza per ogni riga come numero di millisecondi dall'epoca UNIX (1° gennaio 1970). Di seguito sono riportati alcuni esempi.//Row 1

{

"id" : 1,

"name" : "xyz",

"age" : 45,

"_metadata" : {

"expiration" : 1629709200000 //Row Expiration time in milliseconds

}

}

//Row 2

{

"id" : 2,

"name" : "abc",

"age" : 52,

"_metadata" : {

"expiration" : 1629709400000 //Row Expiration time in milliseconds

}

}

//Row 3 No Metadata for below row as it will not expire

{

"id" : 3,

"name" : "def",

"age" : 15

}Importazione dei metadati TTL

Facoltativamente, è possibile importare i metadati TTL utilizzando il parametro di configurazione includeTTL nel modello di configurazione del sink.

L'ora di riferimento predefinita dell'operazione di importazione è l'ora corrente in millisecondi, ottenuta da System.currentTimeMillis(), del computer in cui è in esecuzione lo strumento NoSQL Database Migrator. Tuttavia, è anche possibile impostare un'ora di riferimento personalizzata utilizzando il parametro di configurazione ttlRelativeDate se si desidera estendere l'ora di scadenza e importare le righe che altrimenti scadrebbero immediatamente. L'estensione viene calcolata come segue e aggiunta all'ora di scadenza.

Extended time = expiration time - reference timeL'operazione di importazione gestisce i casi d'uso riportati di seguito durante la migrazione delle righe di tabella contenenti metadati TTL. Questi casi d'uso sono applicabili solo quando il parametro di configurazione includeTTL è impostato su true.

- Caso d'uso 1: nella riga della tabella di importazione non sono presenti informazioni sui metadati TTL.

Se la riga che si desidera importare non contiene informazioni TTL, NoSQL Migrator database imposta il TTL=0 per la riga.

- Caso d'uso 2: il valore TTL della riga della tabella di origine è scaduto rispetto al tempo di riferimento quando la riga della tabella viene importata.

La riga della tabella scaduta viene ignorata e non scritta nell'area di memorizzazione.

- Caso d'uso 3: il valore TTL della riga della tabella di origine non è scaduto rispetto al tempo di riferimento quando la riga della tabella viene importata.

La riga della tabella viene importata con un valore TTL. Tuttavia, il valore TTL importato potrebbe non corrispondere al valore TTL esportato originale a causa dei vincoli della finestra di ore e giorni interi nella classe TimeToLive. Di seguito sono riportati alcuni esempi.

Considera riga tabella esportata:{ "id" : 8, "name" : "xyz", "_metadata" : { "expiration" : 1734566400000 //Thursday, December 19, 2024 12:00:00 AM in UTC } }L'ora di riferimento durante l'importazione è 1734480000000, ovvero mercoledì 18 dicembre 2024 alle 12:00:00.

Riga della tabella importata{ "id" : 8, "name" : "xyz", "_metadata" : { "ttl" : 1734739200000 //Saturday, December 21, 2024 12:00:00 AM } }

Importazione dei metadati TTL in DynamoDB: file JSON formattato e file JSON formattato DynamoDB memorizzato in AWS S3

NoSQL Migrator database fornisce un parametro di configurazione aggiuntivo, ttlAttributeName, per supportare l'importazione dei metadati TTL dagli elementi del file JSON in formato DynamoDB.

I file JSON esportati DynamoDB includono un attributo specifico in ogni elemento per memorizzare l'indicatore orario di scadenza TTL. Per importare facoltativamente i valori TTL dai file JSON esportati DynamoDB, è necessario fornire il nome dell'attributo specifico come valore al parametro di configurazione ttlAttributeName nei file di configurazione di origine DynamoDB-Formatted JSON File o DynamoDB-Formatted JSON File memorizzato in AWS S3. Inoltre, è necessario impostare il parametro di configurazione includeTTL nel modello di configurazione sink. I lavandini validi sono Oracle NoSQL Database e Oracle NoSQL Database Cloud Service. NoSQL Database Migrator memorizza le informazioni TTL nell'oggetto JSON _metadata per l'elemento importato.

-

Caso d'uso 1: il valore del parametro di configurazione ttlAttributeName è impostato sul nome dell'attributo TTL specificato nel file JSON esportato DynamoDB.

NoSQL Migrator database importa l'ora di scadenza per questo elemento come numero di millisecondi dall'epoca UNIX (1° gennaio 1970).

Ad esempio, si consideri un elemento nel file JSON esportato DynamoDB:{ "Item": { "DeptId": { "N": "1" }, "DeptName": { "S": "Engineering" }, "ttl": { "N": "1734616800" } } }In questo caso, l'attributottlspecifica il valore Time To Live per l'elemento. Se si imposta il parametro di configurazione ttlAttributeName comettlnel file JSON in formato DynamoDB o nel file JSON in formato DynamoDB memorizzato nel file di configurazione di origine S3 AWS, NoSQL Database Migrator importa l'ora di scadenza per l'elemento come indicato di seguito.{ "DeptId": 1, "document": { "DeptName": "Engineering" } "_metadata": { "expiration": 1734616800000 } }Nota

È possibile fornire il parametro di configurazione ttlRelativeDate nel modello di configurazione del sink come ora di riferimento per il calcolo dell'ora di scadenza. - Caso d'uso 2: il valore del parametro di configurazione ttlAttributeName è impostato, ma il valore non esiste come attributo nell'elemento del file JSON esportato DynamoDB.

NoSQL Migrator database non importa le informazioni sui metadati TTL per l'elemento specificato.

- Caso d'uso 3: il valore del parametro di configurazione ttlAttributeName non corrisponde al nome dell'attributo nell'elemento del file JSON esportato DynamoDB.

NoSQL Migrator database gestisce l'importazione in uno dei modi riportati di seguito in base alla configurazione del sink.

- Copia l'attributo come campo normale se configurato per l'importazione utilizzando lo schema predefinito.

- Salta l'attributo se configurato per l'importazione utilizzando uno schema definito dall'utente.

Importazione dei dati in un sink con una colonna IDENTITY

Informazioni su come importare i dati in un sink che include una colonna IDENTITY.

È possibile importare i dati da un'origine valida in una tabella sink (On premise/Cloud Services) con una colonna IDENTITY. La colonna IDENTITÀ viene creata come GENERATA SEMPRE COME IDENTITÀ o GENERATA DA IDENTITÀ PREDEFINITA. Per ulteriori informazioni sulla creazione di tabelle con una colonna IDENTITY, vedere Creazione di tabelle con una colonna IDENTITY nel manuale SQL Reference Guide (in lingua inglese).

Prima di importare i dati, assicurarsi che la tabella Oracle NoSQL Database nel sink sia vuota se esiste. Se nella tabella sink sono presenti dati preesistenti, la migrazione può causare problemi quali la sovrascrittura dei dati esistenti nella tabella sink o l'omissione dei dati di origine durante l'importazione.

Tavola lavabo con colonna IDENTITY come GENERATA SEMPRE AS IDENTITY

Considerare una tabella sink con la colonna IDENTITY creata come GENERATA SEMPRE COME IDENTITÀ. L'importazione dei dati dipende dal fatto che l'origine fornisca o meno i valori alla colonna IDENTITY e al parametro di trasformazione ignoreFields nel file di configurazione.

Ad esempio, si desidera importare i dati da un'origine file JSON nella tabella Oracle NoSQL Database come sink. Lo schema della tabella sink è:

CREATE TABLE IF NOT EXISTS migrateID(ID INTEGER GENERATED ALWAYS AS IDENTITY, name STRING, course STRING, PRIMARY KEY

(ID))| Condizione di origine | Azione utente | Risultato migrazione |

|---|---|---|

|

CASO 1: i dati di origine non forniscono un valore per il campo IDENTITY della tabella sink. Esempio: file di origine JSON |

Creare/generare il file di configurazione. |

Impossibile eseguire la migrazione dei dati. I valori delle colonne IDENTITY vengono generati automaticamente. Dati migrati nella tabella sink di Oracle NoSQL Database |

|

CASO 2: i dati di origine forniscono valori per il campo IDENTITY della tabella sink. Esempio: file di origine JSON |

Creare/generare il file di configurazione. Fornire una trasformazione ignoreFields per la colonna ID nel modello di configurazione sink.

|

Impossibile eseguire la migrazione dei dati. I valori ID forniti vengono ignorati e i valori della colonna IDENTITY vengono generati automaticamente. Dati migrati nella tabella sink di Oracle NoSQL Database

migrateID: |

|

Il file di configurazione viene creato o generato senza la trasformazione ignoreFields per la colonna IDENTITY. |

Migrazione dei dati non riuscita con il seguente messaggio di errore: "Cannot set value for a generated always identity column". |

Per ulteriori dettagli sui parametri di configurazione della trasformazione, vedere l'argomento Modelli di configurazione della trasformazione.

Tabella lavello con colonna IDENTITY generata da IDENTITY predefinito

Considerare una tabella sink con la colonna IDENTITY creata come GENERATA DA PREDEFINITO COME IDENTITÀ. L'importazione dei dati dipende dal fatto che l'origine fornisca o meno i valori alla colonna IDENTITY e al parametro di trasformazione ignoreFields.

Ad esempio, si desidera importare i dati da un'origine file JSON nella tabella Oracle NoSQL Database come sink. Lo schema della tabella sink è:

CREATE TABLE IF NOT EXISTS migrateID(ID INTEGER GENERATED BY DEFAULT AS IDENTITY, name STRING, course STRING, PRIMARY KEY

(ID))| Condizione di origine | Azione utente | Risultato migrazione |

|---|---|---|

|

CASO 1: i dati di origine non forniscono un valore per il campo IDENTITY della tabella sink. Esempio: file di origine JSON |

Creare/generare il file di configurazione. |

Impossibile eseguire la migrazione dei dati. I valori delle colonne IDENTITY vengono generati automaticamente. Dati migrati nella tabella sink di Oracle NoSQL Database

migrateID: |

|

CASO 2: i dati di origine forniscono valori per il campo IDENTITY della tabella sink ed è un campo Chiave primaria. Esempio: file di origine JSON |

Creare/generare il file di configurazione. Fornire una trasformazione ignoreFields per la colonna ID nel modello di configurazione sink (consigliato).

|

Impossibile eseguire la migrazione dei dati. I valori ID forniti vengono ignorati e i valori della colonna IDENTITY vengono generati automaticamente. Dati migrati nella tabella sink di Oracle NoSQL Database

migrateID: |

|

Il file di configurazione viene creato o generato senza la trasformazione ignoreFields per la colonna IDENTITY. |

Impossibile eseguire la migrazione dei dati. I valori Quando si tenta di inserire una riga aggiuntiva nella tabella senza fornire un valore ID, il generatore di sequenze tenta di generare automaticamente il valore ID. Il valore di partenza del generatore di sequenze è 1. Di conseguenza, il valore ID generato può potenzialmente duplicare uno dei valori ID esistenti nella tabella sink. Poiché si tratta di una violazione del vincolo della chiave primaria, viene restituito un errore e la riga non viene inserita. Per ulteriori informazioni, vedere Generatore di sequenze. Per evitare la violazione del vincolo della chiave primaria, il generatore di sequenze deve avviare la sequenza con un valore che non sia in conflitto con i valori ID esistenti nella tabella sink. Per utilizzare l'attributo START WITH per apportare questa modifica, vedere l'esempio riportato di seguito. Esempio: dati migrati nella tabella sink di Oracle NoSQL Database

migrateID:Per trovare il valore appropriato per il generatore di sequenze da inserire nella colonna ID, recuperare il valore massimo del campo

ID utilizzando la seguente query:Output:

Il valore massimo della colonna

ID nella tabella sink è 3. Si desidera che il generatore di sequenze inizi a generare i valori ID oltre 3 per evitare la duplicazione. L'attributo START WITH del generatore di sequenze viene aggiornato su 4 utilizzando la seguente istruzione:La sequenza inizierà a 4. Quando si inseriscono righe nella tabella sink senza fornire i valori ID, il generatore di sequenze genera automaticamente i valori ID da 4 in poi evitando la duplicazione degli ID. |

Per ulteriori dettagli sui parametri di configurazione della trasformazione, vedere l'argomento Modelli di configurazione della trasformazione.

Filtro dei dati mediante i predicati query

Informazioni su come specificare i predicati query per esportare solo le righe della tabella che corrispondono ai criteri di filtro.

Predicato query

NoSQL Migrator database fornisce un'opzione per filtrare i dati durante l'esportazione specificando un predicato query. Il predicato query specifica le condizioni che devono essere soddisfatte affinché una riga venga esportata. La utility Migrator converte il predicato query in una clausola SQL WHERE e lo applica alla tabella specificata per fornire una condizione di filtro per esportare solo le righe corrispondenti alla condizione specificata. Per creare opzioni di filtro avanzate, è possibile utilizzare le funzioni incorporate (modification_time(), expiration_time(), creation_time()) nel predicato query.

È possibile utilizzare i predicati query solo sulle origini di Oracle NoSQL Database e Oracle NoSQL Database Cloud Service per tutti gli sink supportati. Per ulteriori dettagli, consulta Oracle NoSQL Database e Oracle NoSQL Database Cloud Service.

Per una dimostrazione del caso d'uso, consulta la sezione relativa alla migrazione da Oracle NoSQL Database Cloud Service a un file JSON.

Filtro di dump

La utility Migrator fornisce un'opzione per eseguire l'eco della query SQL eseguita sul backend. Questa funzione consente di verificare la query generata e, se necessario, perfezionare il filtro prima di eseguire il task di migrazione.

[~/nosqlMigrator]$./runMigrator --dump-filter|df [optional-config-file]-

Con il file di configurazione: la utility Migrator visualizza il file di configurazione fornito e la query generata, come mostrato nell'esempio riportato di seguito.

[~/nosqlMigrator]./runMigrator --dump-filter migrator-config.json[INFO] Configuration for migration: { "source" : { "type" : "nosqldb", "storeName" : "kvstore", "helperHosts" : ["<hostname>:5000"], "table" : "users", "queryFilter" : "$row.address.city='Houston'", "includeTTL" : true, "requestTimeoutMs" : 5000 }, "sink" : { "type" : "file", "format" : "json", "useMultiFiles" : false, "schemaPath" : "<complete/path/to/the/JSON/file/with/DDL/commands/for/the/schema/definition>", "pretty" : true, "dataPath" : "<complete/path/to/directory>" }, "abortOnError" : true, "migratorVersion" : "1.8.0" } [INFO] Query for the migration: 'select $row, expiration_time($row) from users $row where $row.address.city='Houston'' - Senza il file di configurazione: la utility Migrator raccoglie in modo interattivo tutti gli input necessari per generare il file di configurazione, incluso il predicato query. Visualizza quindi il file di configurazione e la query generati.

Nota

L'opzione di filtro di dump visualizza solo il file di configurazione e la query. Non avvia la migrazione dei dati. Dopo la revisione, per eseguire la migrazione, eseguire la utility Migrator con il file di configurazione utilizzando l'opzione--c o --config come indicato di seguito.$./runMigrator --config <complete/path/to/the/JSON/config/file>Dimostrazioni sui casi d'uso per Oracle NoSQL Database Migrator

Scopri come eseguire la migrazione dei dati utilizzando Oracle NoSQL Database Migrator per casi d'uso specifici. È possibile trovare istruzioni sistematiche dettagliate con esempi di codice per eseguire la migrazione in ciascuno dei casi d'uso.

Questo articolo contiene i seguenti argomenti:

Eseguire la migrazione da Oracle NoSQL Database Cloud Service a un file JSON

Questo esempio mostra come utilizzare Oracle NoSQL Database Migrator per copiare i dati e la definizione dello schema di una tabella NoSQL da Oracle NoSQL Database Cloud Service (NDCS) a un file JSON.

Caso d'uso

Un'organizzazione decide di addestrare un modello utilizzando i dati Oracle NoSQL Database Cloud Service (NDCS) per prevedere comportamenti futuri e fornire consigli personalizzati. Possono prendere una copia periodica dei dati delle tabelle NDCS in un file JSON e applicarlo al motore di analisi per analizzare e addestrare il modello. In questo modo è possibile separare le query analitiche dai percorsi critici a bassa latenza.

Esempio

Per la dimostrazione, esaminiamo come eseguire la migrazione dei dati e della definizione dello schema di una tabella NoSQL denominatamyTable da NDCS a un file JSON.- Identifica l'origine e il sink per la migrazione.

- Origine: Oracle NoSQL Database Cloud Service

- Lavello: file JSON

- Identificare le credenziali cloud OCI e acquisirle nel file di configurazione OCI. Salvare il file di configurazione in

/home/.oci/config. Vedere Acquisizione delle credenziali.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identificare l'endpoint dell'area e il nome del compartimento per Oracle NoSQL Database Cloud Service.

- endpoint:

us-ashburn-1 - compartimento:

ocid1.compartment.oc1..aa..rhsmq

- endpoint:

- Aprire il prompt dei comandi e andare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

- Per generare il file di configurazione utilizzando NoSQL Database Migrator, eseguire il comando

runMigratorsenza alcun parametro di runtime.[~/nosqlMigrator]$./runMigrator - Poiché il file di configurazione non è stato fornito come parametro di runtime, l'utility richiede se si desidera generare la configurazione ora. Digitare

y.Configuration file is not provided. Do you want to generate configuration? (y/n) [n]: y Generating a configuration file interactively. - In base ai prompt della utility, scegliere le opzioni per la configurazione di origine.

Enter a location for your config [./migrator-config.json]: /home/<user>/nosqlMigrator/NDCS2JSON Select the source: 1) nosqldb 2) nosqldb_cloud 3) file 4) object_storage_oci 5) aws_s3 #? 2 Configuration for source type=nosqldb_cloud Enter endpoint URL or region ID of the Oracle NoSQL Database Cloud: us-phoenix-1 Select the authentication type: 1) credentials_file 2) instance_principal 3) delegation_token 4) session_token 5) oke_workload_identity #? 1 Enter path to the file containing OCI credentials [/home/<user>/.oci/config]: Enter the profile name in OCI credentials file [DEFAULT]: Enter the compartment name or id of the table []: developers Enter table name: myTable Include TTL data? If you select 'yes' TTL of rows will also be included in the exported data.(y/n) [n]: Enter percentage of table read units to be used for migration operation. (1-100) [90]: Enter store operation timeout in milliseconds. (1-30000) [5000]: - In base ai prompt dell'utility, scegliere le opzioni per la configurazione del lavandino.

Select the sink: 1) nosqldb 2) nosqldb_cloud 3) file #? 3 Configuration for sink type=file Enter path to a directory to store JSON data: /home/<user>/nosqlMigrator would you like to export data to multiple files for each source?(y/n) [y]: n Would you like to store JSON in pretty format? (y/n) [n]: y Would you like to migrate the table schema also? (y/n) [y]: y Enter path to a file to store table schema: /home/<user>/nosqlMigrator/myTableSchema - In base ai prompt della utility, scegliere le opzioni per le trasformazioni dei dati di origine. Il valore predefinito è

n.Would you like to add transformations to source data? (y/n) [n]: - Immettere la scelta per determinare se procedere con la migrazione nel caso in cui la migrazione di un record non riesca.

Would you like to continue migration in case of any record/row is failed to migrate?: (y/n) [n]: - La utility visualizza la configurazione generata sullo schermo.

generated configuration is: { "source": { "type": "nosqldb_cloud", "endpoint": "us-ashburn-1", "table": "myTable", "compartment": "ocid1.compartment.oc1..aa..rhsmq", "credentials": "/home/<user>/.oci/config", "credentialsProfile": "DEFAULT", "readUnitsPercent": 90, "requestTimeoutMs": 5000 }, "sink": { "type": "file", "format": "json", "useMultiFiles" : false, "schemaPath": "/home/<user>/nosqlMigrator/myTableSchema", "pretty": true, "dataPath": "/home/<user>/nosqlMigrator" }, "abortOnError": true, "migratorVersion": "1.8.0" } - L'utility richiede la scelta dell'utente per decidere se procedere o meno con la migrazione con il file di configurazione generato. L'opzione predefinita è

y.Nota

Se si selezionan, è possibile utilizzare il file di configurazione generato per eseguire la migrazione utilizzando l'opzione./runMigrator -co./runMigrator --config.would you like to run the migration with above configuration? If you select no, you can use the generated configuration file to run the migration using ./runMigrator --config /home/<user>/nosqlMigrator/NDCS2JSON (y/n) [y]: - NoSQL Database Migrator esegue la migrazione dei dati e dello schema da NDCS al file JSON.

Records provided by source=10,Records written to sink=10,Records failed=0,Records skipped=0. Elapsed time: 0min 1sec 277ms Migration completed.

Per convalidare la migrazione, è possibile passare alla directory sink specificata e visualizzare lo schema e i dati.

-- Exported myTable Data. JSON files are created in the supplied data path

[~/nosqlMigrator]$cat myTable_1_5.json

{

"id" : 10,

"document" : {

"course" : "Computer Science",

"name" : "Neena",

"studentid" : 105

}

}

{

"id" : 3,

"document" : {

"course" : "Computer Science",

"name" : "John",

"studentid" : 107

}

}

{

"id" : 4,

"document" : {

"course" : "Computer Science",

"name" : "Ruby",

"studentid" : 100

}

}

{

"id" : 6,

"document" : {

"course" : "Bio-Technology",

"name" : "Rekha",

"studentid" : 104

}

}

{

"id" : 7,

"document" : {

"course" : "Computer Science",

"name" : "Ruby",

"studentid" : 100

}

}

{

"id" : 5,

"document" : {

"course" : "Journalism",

"name" : "Rani",

"studentid" : 106

}

}

{

"id" : 8,

"document" : {

"course" : "Computer Science",

"name" : "Tom",

"studentid" : 103

}

}

{

"id" : 9,

"document" : {

"course" : "Computer Science",

"name" : "Peter",

"studentid" : 109

}

}

{

"id" : 1,

"document" : {

"course" : "Journalism",

"name" : "Tracy",

"studentid" : 110

}

}

{

"id" : 2,

"document" : {

"course" : "Bio-Technology",

"name" : "Raja",

"studentid" : 108

}

}-- Exported myTable Schema

[~/nosqlMigrator]$cat myTableSchema

CREATE TABLE IF NOT EXISTS myTable (id INTEGER, document JSON, PRIMARY KEY(SHARD(id)))-

Preparare il file di configurazione (in formato JSON) con l'origine Oracle NoSQL Database Cloud Service (NDCS) e i dettagli dell' sink JSON. Vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

In questo esempio viene utilizzata una tabellauserscon i dati seguenti:{"id":10,"firstName":"John","lastName":"Smith","age":22,"income":45000,"address":{"city":"Santa Cruz","number":101,"phones":[{"area":408,"kind":"work","number":4538955},{"area":831,"kind":"home","number":7533341},{"area":831,"kind":"mobile","number":7533382}],"state":"CA","street":"Pacific Ave","zip":95008}} {"id":20,"firstName":"Jane","lastName":"Smith","age":22,"income":55000,"address":{"city":"San Jose","number":201,"phones":[{"area":608,"kind":"work","number":6538955},{"area":931,"kind":"home","number":9533341},{"area":931,"kind":"mobile","number":9533382}],"state":"CA","street":"Atlantic Ave","zip":95005}} {"id":30,"firstName":"Adam","lastName":"Smith","age":45,"income":75000,"address":{"city":"Houston","number":301,"phones":[{"area":618,"kind":"work","number":6618955},{"area":951,"kind":"home","number":9613341},{"area":981,"kind":"mobile","number":9613382}],"state":"TX","street":"Indian Ave","zip":95075}} {"id":40,"firstName":"Joanna","lastName":"Smith","age":null,"income":75000,"address":{"city":"Houston","number":401,"phones":[{"area":null,"kind":"work","number":1618955},{"area":451,"kind":"home","number":4613341},{"area":481,"kind":"mobile","number":4613382}],"state":"TX","street":"Tex Ave","zip":95085}}Assicurarsi di includere il parametro

queryFiltercon il predicato query appropriato nel modello di configurazione di origine per esportare solo le righe richieste dalla tabella. Per informazioni dettagliate sulla creazione dei predicati query, vedere la tabella Previsioni query di esempio nell'argomento Origine servizio NoSQL Database Cloud.In questo esempio, il predicato query esporta le righe con il campo

citynella colonna JSONaddress= 'Houston' dalla tabellausers.{ "source" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "users", "queryFilter" : "$row.address.city='Houston'", "compartment" : "ocid1.compartment.oc1..aa..rhsmq", "credentials" : "/home/<user>/.oci/config", "credentialsProfile" : "DEFAULT", "readUnitsPercent" : 90, "includeTTL" : true, "requestTimeoutMs" : 5000 }, "sink" : { "type" : "file", "format" : "json", "useMultiFiles" : true, "chunkSize" : 32, "schemaPath" : "/scratch/<user>/nosqlMigrator/tableschema.ddl", "pretty" : false, "dataPath" : "/scratch/<user>/nosqlMigrator" }, "abortOnError" : true, "migratorVersion" : "1.8.0" } - Aprire il prompt dei comandi e andare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

-

Eseguire il comando

runMigratorpassando il file di configurazione. Utilizzare l'opzione--configo-c.[~/nosqlMigrator]$./runMigrator --config <complete/path/to/the/JSON/config/file>Nota

È inoltre possibile eseguire il comando con l'opzione--dump-filter|dfper visualizzare e verificare la query generata prima di eseguire il task di migrazione come indicato di seguito. Per ulteriori informazioni, vedere Filtro di dump.[~/nosqlMigrator]$./runMigrator --dump-filter <complete/path/to/the/JSON/config/file>La utility procede con la migrazione dei dati come indicato di seguito.[INFO] creating source from given configuration: [INFO] [cloud source] : query = 'SELECT $row,expiration_time_millis($row) AS expiration FROM users $row where $row.address.city='Houston'' [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [json file sink] : writing table schema to /scratch/raumesh/nosqlMigrator/tableschema.ddl [INFO] migration started [INFO] Migration success for source users. read=2,written=2,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=2, Records written to sink=2, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 182ms Migration completed.

Verifica

address con il valore del campo city 'Houston'.-- Exported users data. Schema and JSON files are created in the supplied data paths.

[~/nosqlMigrator]: cat tableschema.ddl

CREATE TABLE IF NOT EXISTS users (id INTEGER, firstName STRING, lastName STRING, age INTEGER, income INTEGER, address JSON, PRIMARY KEY(SHARD(id)))

[~/nosqlMigrator]: cat users_6_10.json

{"id":30,"firstName":"Adam","lastName":"Smith","age":45,"income":75000,"address":{"city":"Houston","number":301,"phones":[{"area":618,"kind":"work","number":6618955},{"area":951,"kind":"home","number":9613341},{"area":981,"kind":"mobile","number":9613382}],"state":"TX","street":"Indian Ave","zip":95075}}

{"id":40,"firstName":"Joanna","lastName":"Smith","age":null,"income":75000,"address":{"city":"Houston","number":401,"phones":[{"area":null,"kind":"work","number":1618955},{"area":451,"kind":"home","number":4613341},{"area":481,"kind":"mobile","number":4613382}],"state":"TX","street":"Tex Ave","zip":95085}}

bash-4.4$Eseguire la migrazione da Oracle NoSQL Database in locale a Oracle NoSQL Database Cloud Service

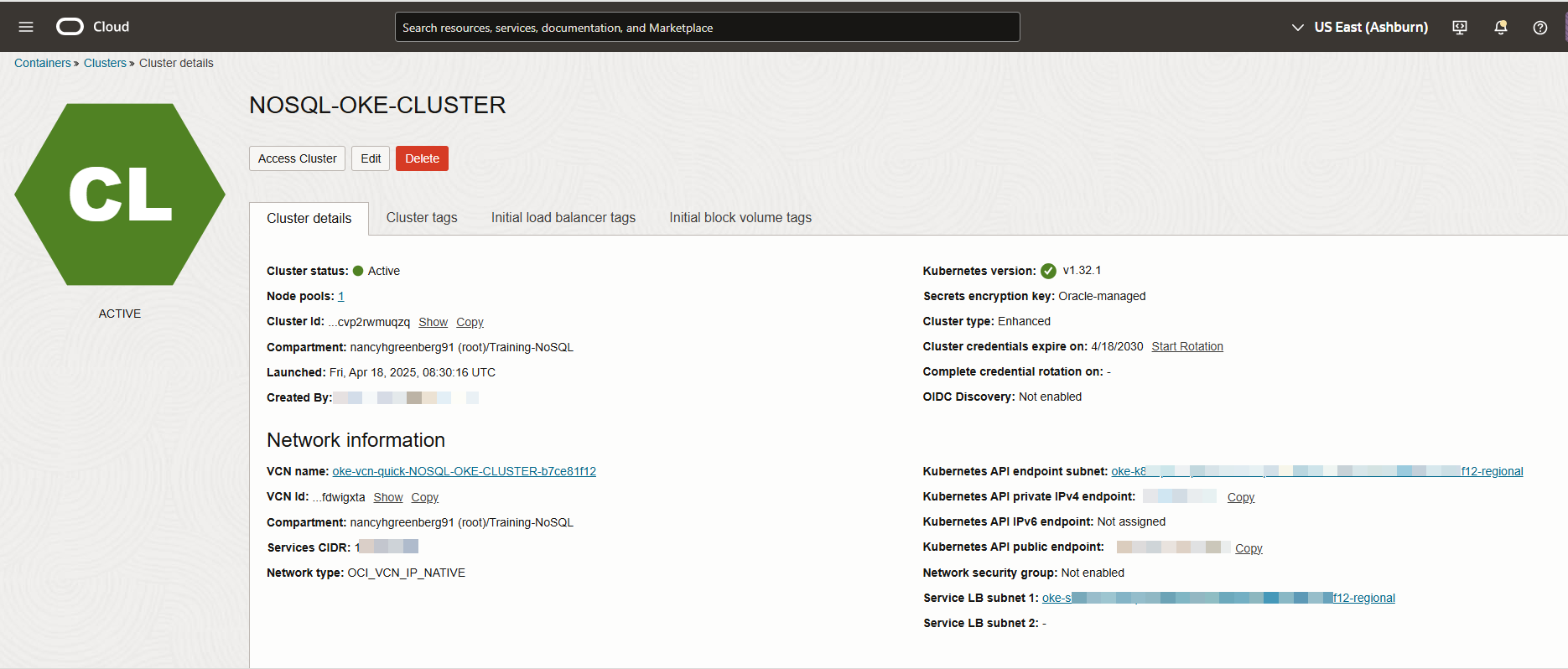

Questo esempio mostra come utilizzare Oracle NoSQL Database Migrator per copiare i dati e la definizione dello schema di una tabella NoSQL da Oracle NoSQL Database a Oracle NoSQL Database Cloud Service (NDCS).

Caso d'uso

Gli sviluppatori stanno esplorando le opzioni per evitare il sovraccarico della gestione delle risorse, dei cluster e della garbage collection per i carichi di lavoro NoSQL Database KVStore esistenti. Come soluzione, decidi di eseguire la migrazione dei carichi di lavoro KVStore on-premise esistenti in Oracle NoSQL Database Cloud Service perché NDCS li gestisce automaticamente.

Esempio

Per la dimostrazione, esaminiamo come eseguire la migrazione dei dati e della definizione dello schema di una tabella NoSQL denominatamyTable dal database NoSQL KVStore a NDCS. Questo caso d'uso verrà inoltre utilizzato per mostrare come eseguire la utility runMigrator passando un file di configurazione precreato.- Identifica l'origine e il sink per la migrazione.

- Origine: Oracle NoSQL Database

- Lavello: Oracle NoSQL Database Cloud Service

- Identificare le credenziali cloud OCI e acquisirle nel file di configurazione OCI. Salvare il file di configurazione in

/home/.oci/config. Vedere Acquisizione delle credenziali in Utilizzo di Oracle NoSQL Database Cloud Service.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identificare l'endpoint dell'area e il nome del compartimento per Oracle NoSQL Database Cloud Service.

- endpoint:

us-phoenix-1 - compartimento:

developers

- endpoint:

- Identificare i seguenti dettagli per KVStore in locale:

- storeName:

kvstore - helperHosts:

<hostname>:5000 - tabella:

myTable

- storeName:

myTable dal database NoSQL KVStore a NDCS:

Per convalidare la migrazione, è possibile eseguire il login alla console NDCS e verificare che myTable sia stato creato con i dati di origine.

Eseguire la migrazione dall'origine file JSON a Oracle NoSQL Database Cloud Service

Questo esempio mostra l'uso di Oracle NoSQL Database Migrator per copiare i dati da un'origine file JSON a Oracle NoSQL Database Cloud Service.

Dopo aver valutato più opzioni, un'organizzazione finalizza Oracle NoSQL Database Cloud Service come piattaforma di database NoSQL. Poiché i contenuti di origine sono in formato file JSON, stanno cercando un modo per eseguirne la migrazione a Oracle NoSQL Database Cloud Service.

In questo esempio verrà descritto come eseguire la migrazione dei dati da un file JSON denominato SampleData.json. Per eseguire la utility runMigrator, passare un file di configurazione già creato. Se il file di configurazione non viene fornito come parametro runtime, la utility runMigrator richiede di generare la configurazione mediante una procedura interattiva.

- Identifica l'origine e il sink per la migrazione.

- Origine: file di origine JSON.

SampleData.jsonè il file di origine. Contiene più documenti JSON con un documento per riga, delimitati da un nuovo carattere di riga.{"id":6,"val_json":{"array":["q","r","s"],"date":"2023-02-04T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-03-04T02:38:57.520Z","numfield":30,"strfield":"foo54"},{"datefield":"2023-02-04T02:38:57.520Z","numfield":56,"strfield":"bar23"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":3,"val_json":{"array":["g","h","i"],"date":"2023-02-02T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-02-02T02:38:57.520Z","numfield":28,"strfield":"foo3"},{"datefield":"2023-02-02T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":7,"val_json":{"array":["a","b","c"],"date":"2023-02-20T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-01-20T02:38:57.520Z","numfield":28,"strfield":"foo"},{"datefield":"2023-01-22T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":4,"val_json":{"array":["j","k","l"],"date":"2023-02-03T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-02-03T02:38:57.520Z","numfield":28,"strfield":"foo"},{"datefield":"2023-02-03T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} - Lavandino: Oracle NoSQL Database Cloud Service.

- Origine: file di origine JSON.

- Identificare le credenziali cloud OCI e acquisirle nel file di configurazione. Salvare il file di configurazione in

/home/user/.oci/config. Per ulteriori dettagli, vedere Acquisizione delle credenziali in Uso di Oracle NoSQL Database Cloud Service.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... region=us-ashburn-1 key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identificare l'endpoint dell'area e il nome del compartimento per Oracle NoSQL Database Cloud Service.

- endpoint:

us-ashburn-1 - compartimento:

Training-NoSQL

- endpoint:

- Identificare i seguenti dettagli per il file di origine JSON:

-

schemaPath:

<absolute path to the schema definition file containing DDL statements for the NoSQL table at the sink>.In questo esempio, il file DDL èschema_json.ddl.create table Migrate_JSON (id INTEGER, val_json JSON, PRIMARY KEY(id));In Oracle NoSQL Database Migrator è disponibile un'opzione per creare una tabella con lo schema predefinito se

schemaPathnon viene fornito. Per ulteriori dettagli, vedere l'argomento Identificare l'origine e ilink in Workflow per Oracle NoSQL Database Migrator. - Percorso dati:

<absolute path to a file or directory containing the JSON data for migration>.

-

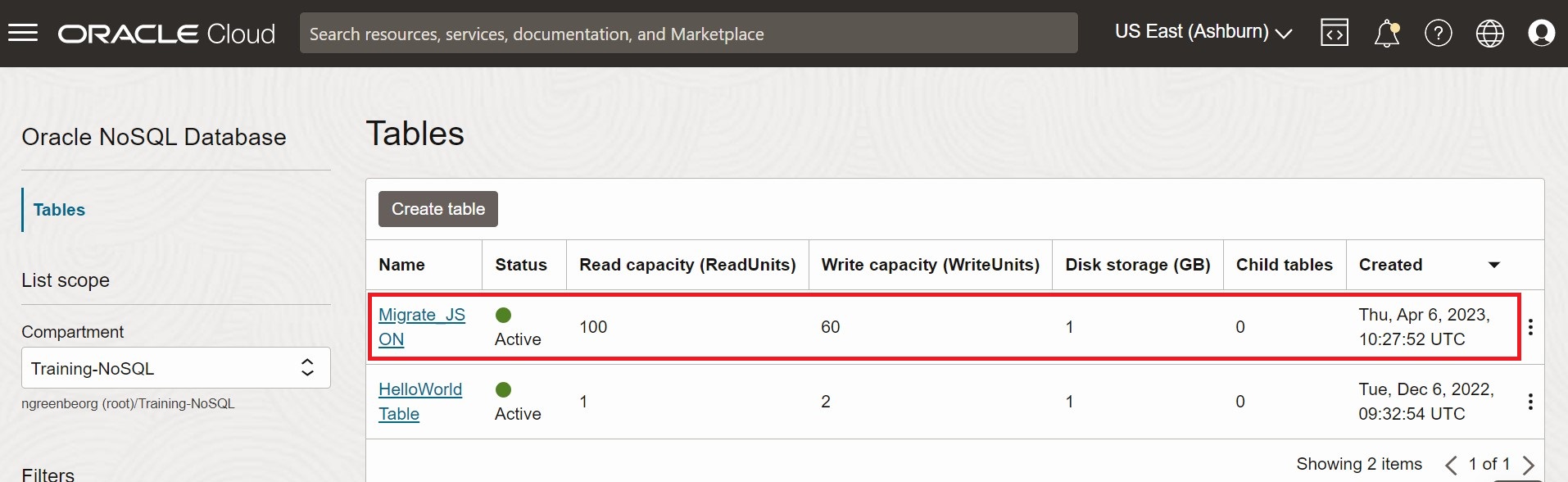

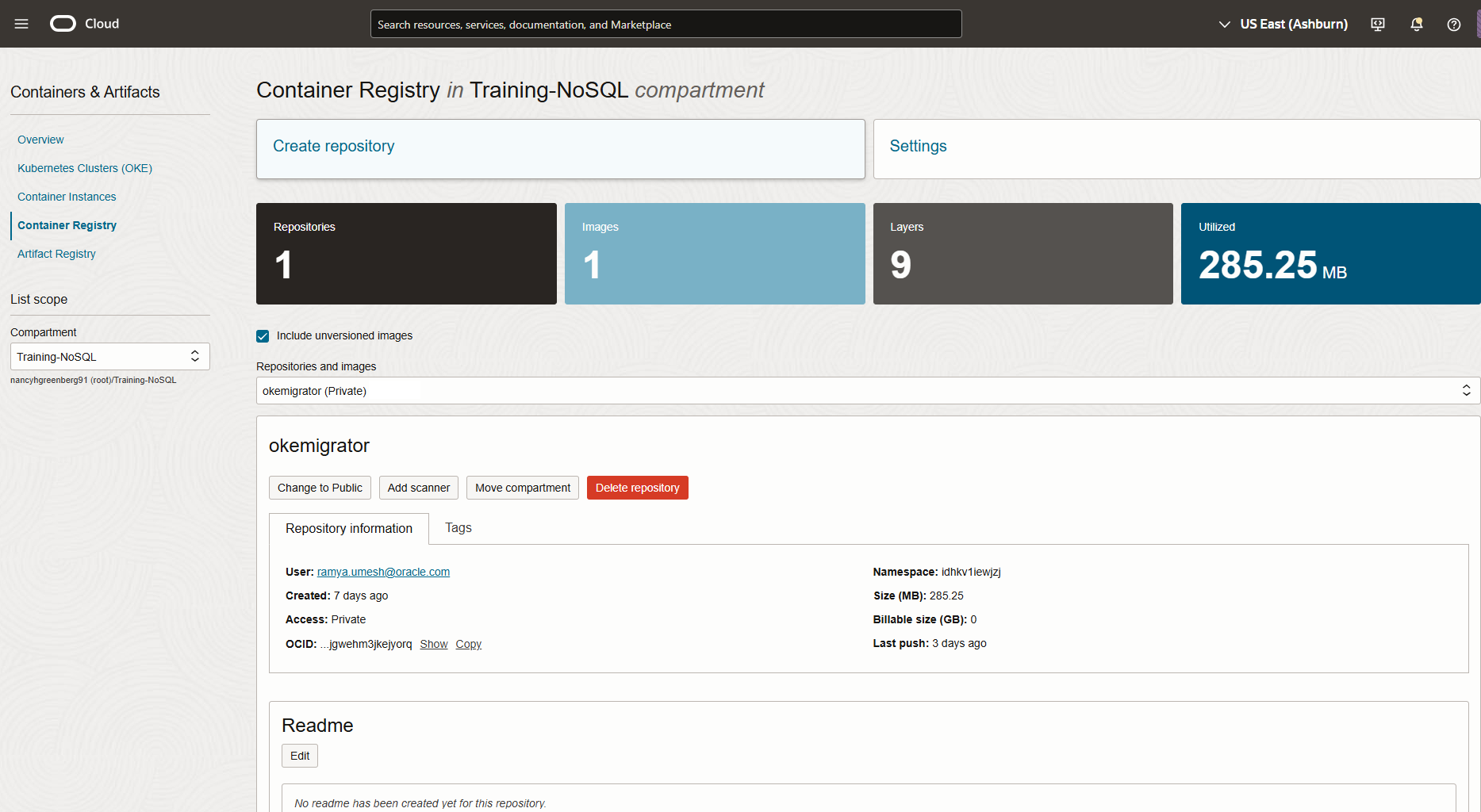

SampleData.json a Oracle NoSQL Database Cloud Service, effettuare le operazioni riportate di seguito.

Migrate_JSON venga creata con i dati di origine. Per la procedura di accesso alla console, vedere l'articolo Accesso al servizio dalla console dell'infrastruttura nel documento Oracle NoSQL Database Cloud Service.

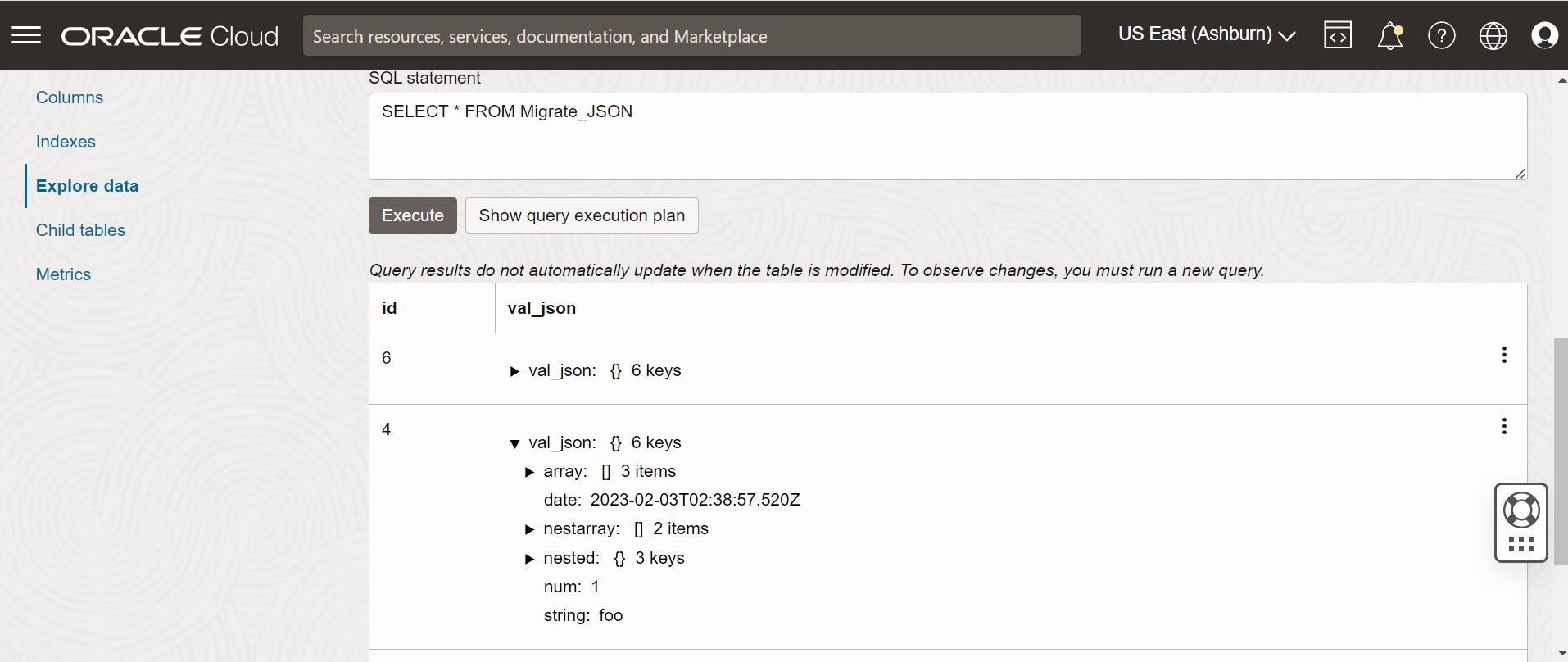

Figura - Tabelle della console di Oracle NoSQL Database Cloud Service

Figura - Dati tabella console di Oracle NoSQL Database Cloud Service

Esegui la migrazione dal file JSON MongoDB a Oracle NoSQL Database Cloud Service

Questo esempio mostra come utilizzare Oracle NoSQL Database Migrator per copiare i dati in formato MongoDB in Oracle NoSQL Database Cloud Service (NDCS).

Caso d'uso

Dopo aver valutato più opzioni, un'organizzazione finalizza Oracle NoSQL Database Cloud Service come piattaforma di database NoSQL. Le tabelle e i dati si trovano in MongoDB e l'organizzazione desidera eseguire la migrazione a Oracle NDCS.

È possibile copiare un file o una directory contenente i dati JSON esportati MongoDB per la migrazione specificando il file o la directory nel modello di configurazione di origine.

Consideriamo i seguenti due file JSON di esempio esportati da MongoDB per dimostrare il nostro caso d'uso.

{"_id":0,"name":"Aimee Zank","scores":[{"score":1.463179736705023,"type":"exam"},{"score":11.78273309957772,"type":"quiz"},{"score":35.8740349954354,"type":"homework"}]}

{"_id":1,"name":"Aurelia Menendez","scores":[{"score":60.06045071030959,"type":"exam"},{"score":52.79790691903873,"type":"quiz"},{"score":71.76133439165544,"type":"homework"}]}

{"_id":2,"name":"Corliss Zuk","scores":[{"score":67.03077096065002,"type":"exam"},{"score":6.301851677835235,"type":"quiz"},{"score":66.28344683278382,"type":"homework"}]}

{"_id":3,"name":"Bao Ziglar","scores":[{"score":71.64343899778332,"type":"exam"},{"score":24.80221293650313,"type":"quiz"},{"score":42.26147058804812,"type":"homework"}]}

{"_id":4,"name":"Zachary Langlais","scores":[{"score":78.68385091304332,"type":"exam"},{"score":90.2963101368042,"type":"quiz"},{"score":34.41620148042529,"type":"homework"}]}

{"_id":{"$oid":"63d3a87cf564fc21dac3838d"},"firstName":"John","lastName":"Smith","address":{"Country":"France"},"_class":"com.example.demo.Customer"}

{"_id":{"$oid":"63d3a87cf564fc21dac3838e"},"firstName":"Sam","lastName":"David","address":{"Country":"USA"},"_class":"com.example.demo.Customer"}

{"_id":"3","firstName":"Dona","lastName":"William","address":{"Country":"England"},"_class":"com.example.demo.Customer"}MongoDB supporta due tipi di estensioni per i file JSON formattati, Modalità canonica e Modalità rilassata. È possibile fornire il file JSON in formato MongoDB generato utilizzando lo strumento mongoexport in modalità Canonica o Rilassata. NoSQL Migrator database supporta entrambe le modalità.

Per ulteriori informazioni sul file MongoDB Extended JSON (v2), vedere mongoexport_formats.

Per ulteriori informazioni sulla generazione del file JSON in formato MongoDB, vedere mongoexport.

Esempio

Per la dimostrazione, esaminiamo come migrare un file JSON in formato MongoDB in NDCS. Per questo esempio verrà utilizzato un file di configurazione creato manualmente.- Identifica l'origine e il sink per la migrazione.

- Origine: file JSON in formato MongoDB

- Lavello: Oracle NoSQL Database Cloud Service

- Estrarre i dati da MongoDB utilizzando la utility mongoexport. Per ulteriori informazioni, vedere mongoexport.

- Identificare le credenziali cloud OCI e acquisirle nel file di configurazione OCI. Salvare il file di configurazione nella directory

/home/<user>/.oci/config. Per i dettagli, vedere Acquisizione delle credenziali.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identificare l'endpoint dell'area e il nome del compartimento per Oracle NoSQL Database Cloud Service.

- endpoint:

us-ashburn-1 - compartimento:

ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza

- endpoint:

Per eseguire la migrazione dei dati JSON in formato MongoDB a Oracle NoSQL Database Cloud Service, è possibile scegliere una delle opzioni riportate di seguito.

-

Preparare il file di configurazione (in formato JSON) con i dettagli di origine e collegamento identificati. Vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

Qui è possibile impostare il parametro di configurazionedefaultSchemasu true. Pertanto, NoSQL Database Migrator crea una tabella con lo schema predefinito nel sink.{ "source" : { "type" : "file", "format" : "mongodb_json", "dataPath" : "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "mongoImport", "compartment" : "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL" : false, "schemaInfo" : { "readUnits" : 100, "writeUnits" : 60, "storageSize" : 1, "defaultSchema" : true }, "credentials" : "<complete/path/to/the/oci/config/file>", "credentialsProfile" : "DEFAULT", "writeUnitsPercent" : 90, "overwrite" : true, "requestTimeoutMs" : 5000 }, "abortOnError" : true, "migratorVersion" : "1.8.0" }Lo schema predefinito per l'origine file JSON in formato MongoDB è il seguente:CREATE TABLE IF NOT EXISTS <tablename>(id STRING, document JSON,PRIMARY KEY(SHARD(id));dove:tablename= valore fornito per l'attributotablenella configurazione.id= Il valore_iddi ogni documento del file di origine JSON esportato MongoDB.document= Per ogni documento nel file esportato MongoDB, il contenuto escluso il campo_idviene aggregato nella colonnadocument.

Nota

Se la tabella <nome tabella> esiste già in Oracle NoSQL Database Cloud Service e si desidera eseguire la migrazione dei dati alla tabella utilizzando la configurazionedefaultSchema, è necessario assicurarsi che la tabella esistente disponga della colonna ID in lettere minuscole (ID) e sia di tipo STRING. -

Aprire il prompt dei comandi e passare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

-

Eseguire il comando

runMigratorpassando il file di configurazione. Utilizzare l'opzione--configo-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

La utility procede con la migrazione dei dati, come mostrato di seguito.

[INFO] creating source from given configuration: [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [cloud sink] : start loading DDLs [INFO] [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS mongoImport (id STRING, document JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [INFO] [cloud sink] : completed loading DDLs [INFO] migration started [INFO] [mongo file source] : start parsing MongoDB JSON records from file: mongoDBSample.json [INFO] Migration success for source mongoDBSample. read=5,written=5,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=5, Records written to sink=5, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 448ms Migration completed.

Verifica

Per verificare la migrazione, è possibile eseguire il login alla console di Oracle NoSQL Database Cloud Service e verificare che la tabella mongoImport venga creata con i dati di origine. Per la procedura di accesso alla console, vedere l'articolo Accesso al servizio dalla console dell'infrastruttura.

-

Preparare il file di configurazione (in formato JSON) con i dettagli di origine e collegamento identificati. Vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

Qui è possibile specificare il file contenente l'istruzione DDL della tabella sink nel parametro

schemaPathdel modello di configurazione di origine. Impostare il parametro di configurazioneuseSourceSchemasu true nel modello di configurazione sink.È possibile generare uno schema personalizzato come indicato di seguito.

- Prendere nota dei nomi e dei tipi di dati per ogni colonna dai dati JSON in formato MongoDB. Utilizzare queste informazioni per creare un file DDL di schema per la tabella di Oracle NoSQL Database Cloud Service.

- Nel file dello schema, denominare la prima colonna (chiave primaria) come

iddi tipo STRING. Includere gli stessi nomi e tipi per le colonne rimanenti registrati nel file JSON in formato MongoDB. - Salvare il file di schema e annotare il percorso completo.

In questo esempio viene utilizzato il seguente schema definito dall'utente:CREATE TABLE IF NOT EXISTS sampleMongoDBImp (id STRING, name STRING, scores JSON, PRIMARY KEY(SHARD(id)));È necessario includere una trasformazionerenameFieldsche indichi a NoSQL Database Migrator di convertire la colonna_idiniddurante la creazione della tabella. Per i dettagli dei parametri, vedere Modelli di configurazione della trasformazione. NoSQL Database Migrator crea una tabella con lo schema personalizzato nel sink.{ "source" : { "type" : "file", "format" : "mongodb_json", "schemaInfo" : { "schemaPath" : "<complete/path/to/the/schema/file>" }, "dataPath" : "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "sampleMongoDBImp", "compartment" : "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL" : true, "schemaInfo" : { "readUnits" : 100, "writeUnits" : 60, "storageSize" : 1, "useSourceSchema" : true }, "credentials" : "<complete/path/to/the/oci/config/file>", "credentialsProfile" : "DEFAULT", "writeUnitsPercent" : 90, "overwrite" : false, "requestTimeoutMs" : 5000 }, "transforms": { "renameFields" : { "_id":"id" } }, "abortOnError" : true, "migratorVersion" : "1.8.0" } -

Aprire il prompt dei comandi e passare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

-

Eseguire il comando

runMigratorpassando il file di configurazione. Utilizzare l'opzione--configo-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

La utility procede con la migrazione dei dati, come mostrato di seguito.

[INFO] creating source from given configuration: [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [cloud sink] : start loading DDLs [INFO] [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS sampleMongoDBImp (id INTEGER, name STRING, scores JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [INFO] [cloud sink] : completed loading DDLs [INFO] migration started [INFO] [mongo file source] : start parsing MongoDB JSON records from file: mongoDBSample.json [INFO] Migration success for source mongoDBSample. read=5,written=5,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=5, Records written to sink=5, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 438ms Migration completed.

Verifica

Per verificare la migrazione, è possibile eseguire il login alla console di Oracle NoSQL Database Cloud Service e verificare che la tabella sampleMongoDBImp venga creata con i dati di origine. Per la procedura di accesso alla console, vedere l'articolo Accesso al servizio dalla console dell'infrastruttura.

- Per questo caso d'uso, come origine verrà utilizzato il file JSON di esempio in formato MongoDB esportato da un'applicazione Spring. Per ulteriori dettagli su questo formato, vedere Dati sorgente.

-

Preparare il file di configurazione (in formato JSON) con i dettagli di origine e collegamento identificati. Vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

Qui è possibile specificare il file contenente l'istruzione DDL della tabella sink nel parametro

schemaPathdel modello di configurazione di origine. Impostare il parametro di configurazioneuseSourceSchemasu true nel modello di configurazione sink.È possibile generare uno schema personalizzato come indicato di seguito.

- Prendere nota dei nomi e dei tipi di dati per ogni colonna dai dati JSON in formato MongoDB.

- Nel file dello schema, denominare la prima colonna (chiave primaria) come

iddi tipo STRING. Aggrega i campi rimanenti a un campo denominatokv_json_di tipo JSON, aderendo al formato dati Spring. Per ulteriori dettagli, vedere Modello di persistenza del framework Spring Data. - Salvare il file di schema e annotare il percorso completo.

In questo esempio viene utilizzato lo schema definito dall'utente riportato di seguito.CREATE TABLE IF NOT EXISTS sampleMongoDBSpringImp(id STRING, kv_json_ JSON, PRIMARY KEY(SHARD(id)))Per l'esempio di dati Spring sopra riportato, è necessario includere le seguenti trasformazioni:- Trasformazione

renameFieldsper convertire la colonna_idinid - Trasformazione

ignoreFieldsper ignorare la colonna_classe non includerla nella tabella sink - Trasformazione

aggregateFieldsper aggregare i campi rimanenti (diversi daid) in un campo di tipo JSON

Per i dettagli dei parametri, vedere Modelli di configurazione della trasformazione. NoSQL Database Migrator crea una tabella con lo schema personalizzato nel sink.{ "source": { "type": "file", "format": "mongodb_json", "schemaInfo": { "schemaPath": "<complete/path/to/the/schema/file>" }, "dataPath": "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink": { "type": "nosqldb_cloud", "endpoint": "us-ashburn-1", "table": "sampleMongoDBSpringImp", "compartment": "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL": true, "schemaInfo": { "readUnits": 100, "writeUnits": 60, "storageSize": 1, "useSourceSchema": true }, "credentials": "<complete/path/to/the/oci/config/file>", "credentialsProfile": "DEFAULT", "writeUnitsPercent": 90, "overwrite": false, "requestTimeoutMs": 5000 }, "transforms": { "renameFields": { "_id": "id" }, "ignoreFields": ["_class"], "aggregateFields": { "fieldName": "kv_json_", "skipFields": ["id"] } }, "abortOnError" : true, "migratorVersion" : "1.8.0" } -

Aprire il prompt dei comandi e passare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

-

Eseguire il comando

runMigratorpassando il file di configurazione. Utilizzare l'opzione--configo-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

La utility procede con la migrazione dei dati, come mostrato di seguito.

creating source from given configuration: source creation completed creating sink from given configuration: sink creation completed creating migrator pipeline [cloud sink] : start loading DDLs [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS sampleMongoDBSpringImp (id STRING, kv_json_ JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [cloud sink] : completed loading DDLs migration started [mongo file source] : start parsing MongoDB JSON records from file: mongodbspring.json Migration success for source mongodbspring. read=3,written=3,failed=0 Migration is successful for all the sources. migration completed. Records provided by source=3, Records written to sink=3, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 393ms Migration completed.

Verifica

Per verificare la migrazione, è possibile eseguire il login alla console di Oracle NoSQL Database Cloud Service e verificare che la tabella sampleMongoDBImp venga creata con i dati di origine. Per la procedura di accesso alla console, vedere l'articolo Accesso al servizio dalla console dell'infrastruttura.

Esegui la migrazione dal file JSON DynamoDB a Oracle NoSQL Database Cloud Service

Questo esempio mostra come utilizzare Oracle NoSQL Database Migrator per copiare il file JSON DynamoDB in NoSQL Database Cloud Service.

Caso d'uso

Dopo aver valutato più opzioni, un'organizzazione completa Oracle NoSQL Database Cloud Service tramite il database DynamoDB. L'organizzazione desidera eseguire la migrazione delle tabelle e dei dati da DynamoDB a Oracle NoSQL Database Cloud Service.

Per ulteriori dettagli, vedere Mapping della tabella DynamoDB alla tabella NoSQL di Oracle.

È possibile eseguire la migrazione da un file system di un file o di una directory contenente i dati JSON esportati DynamoDB specificando il percorso nel modello di configurazione di origine.

{"Item":{"Id":{"N":"101"},"Phones":{"L":[{"L":[{"S":"555-222"},{"S":"123-567"}]}]},"PremierCustomer":{"BOOL":false},"Address":{"M":{"Zip":{"N":"570004"},"Street":{"S":"21 main"},"DoorNum":{"N":"201"},"City":{"S":"London"}}},"FirstName":{"S":"Fred"},"FavNumbers":{"NS":["10"]},"LastName":{"S":"Smith"},"FavColors":{"SS":["Red","Green"]},"Age":{"N":"22"},"ttl": {"N": "1734616800"}}}

{"Item":{"Id":{"N":"102"},"Phones":{"L":[{"L":[{"S":"222-222"}]}]},"PremierCustomer":{"BOOL":false},"Address":{"M":{"Zip":{"N":"560014"},"Street":{"S":"32 main"},"DoorNum":{"N":"1024"},"City":{"S":"Wales"}}},"FirstName":{"S":"John"},"FavNumbers":{"NS":["10"]},"LastName":{"S":"White"},"FavColors":{"SS":["Blue"]},"Age":{"N":"48"},"ttl": {"N": "1734616800"}}}Copiare i dati della tabella DynamoDB esportati dallo storage AWS S3 in un file system attivato locale.

Eaxmple

Per questa dimostrazione, imparerai come eseguire la migrazione di un file JSON DynamoDB a Oracle NoSQL Database Cloud Service. Per questo esempio verrà utilizzato un file di configurazione creato manualmente.

Prerequisiti

- Identifica l'origine e il sink per la migrazione.

- Origine: file JSON DynamoDB

- Lavello: Oracle NoSQL Database Cloud Service

- Per importare i dati della tabella DynamoDB in Oracle NoSQL Database, è necessario prima esportare la tabella DynamoDB in S3. Per esportare la tabella, vedere la procedura descritta in Esportazione dei dati della tabella DynamoDB in Amazon S3. Durante l'esportazione, selezionare il formato JSON DynamoDB. I dati esportati contengono i dati della tabella DynamoDB in più file

gzip, come mostrato di seguito./ 01639372501551-bb4dd8c3 |-- 01639372501551-bb4dd8c3 ==> exported data prefix |----data |------sxz3hjr3re2dzn2ymgd2gi4iku.json.gz ==>table data |----manifest-files.json |----manifest-files.md5 |----manifest-summary.json |----manifest-summary.md5 |----_started

- È necessario scaricare i file da AWS S3. La struttura dei file dopo il download sarà come mostrato di seguito.

download-dir/01639372501551-bb4dd8c3 |----data |------sxz3hjr3re2dzn2ymgd2gi4iku.json.gz ==>table data |----manifest-files.json |----manifest-files.md5 |----manifest-summary.json |----manifest-summary.md5 |----_started

- Identificare le credenziali cloud OCI e acquisirle nel file di configurazione. Salvare il file di configurazione in

/home/user/.oci/config. Per ulteriori dettagli, vedere Acquisizione delle credenziali in Uso di Oracle NoSQL Database Cloud Service.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... region=us-ashburn-1 key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase>

- Identificare l'endpoint dell'area e il nome del compartimento per Oracle NoSQL Database Cloud Service.

- endpoint:

us-ashburn-1 - compartimento:

Training-NoSQL

- endpoint:

Procedura

Per eseguire la migrazione dei dati JSON DynamoDB in Oracle NoSQL Database, effettuare le operazioni riportate di seguito.

- Preparare il file di configurazione (in formato JSON) con i dettagli di origine e sink identificati. Per informazioni dettagliate, vedere Modelli di configurazione di origine e Modelli di configurazione del collegamento.

Nota

Se gli elementi della tabella JSON esportati DynamoDB contengono un attributo TTL, per importare facoltativamente i valori TTL, specificare l'attributo nel parametro di configurazionettlAttributeNamedel modello di configurazione di origine e impostare il parametro di configurazioneincludeTTLsu true nel modello di configurazione sink. Per ulteriori dettagli, vedere Migrazione dei metadati TTL per le righe tabella.Qui è possibile impostare il parametro di configurazione

defaultSchemasu true. Pertanto, NoSQL Database Migrator crea lo schema predefinito nel sink. È necessario specificareDDBPartitionKeye il tipo di colonna NoSQL corrispondente. In caso contrario, viene visualizzato un errore.Per i dettagli sullo schema predefinito per un'origine JSON esportata DynamoDB, vedere l'argomento Identifica origine e collegamento in Workflow per Oracle NoSQL Data Migrator.

{ "source" : { "type" : "file", "format" : "dynamodb_json", "ttlAttributeName" : "ttl", "dataPath" : "complete/path/to/the/DynamoDB/Formatted/JSON/file" }, "sink" : { "type" : "nosqldb_cloud", "endpoint" : "us-sanjose-1", "table" : "sampledynDBImp", "compartment" : "ocid1.compartment.oc1..aaaaaaaa......smq", "includeTTL" : true, "schemaInfo" : { "readUnits" : 10, "writeUnits" : 10, "storageSize" : 1, "schemaPath" : "complete/path/to/the/DDl/file" }, "credentials" : "/home/<username>/.oci/config", "credentialsProfile" : "DEFAULT", "writeUnitsPercent" : 90, "overwrite" : true, "requestTimeoutMs" : 5000 }, "abortOnError" : true, "migratorVersion" : "1.8.0" }In questo esempio viene utilizzato il seguente schema predefinito:CREATE TABLE IF NOT EXISTS sampledynDBImp (Id INTEGER, document JSON, PRIMARY KEY(SHARD(Id))) - Aprire il prompt dei comandi e andare alla directory in cui è stata estratta la utility NoSQL Database Migrator.

- Eseguire il comando

runMigratorpassando file di configurazione separati. Utilizzare l'opzione--configo-c../runMigrator --config <complete/path/to/the/JSON/config/file> - La utility procede con la migrazione dei dati come illustrato nel seguente esempio: