Nota

- Questa esercitazione richiede l'accesso a Oracle Cloud. Per iscriverti a un account gratuito, consulta Inizia a utilizzare Oracle Cloud Infrastructure Free Tier.

- Utilizza valori di esempio per le credenziali, la tenancy e i compartimenti di Oracle Cloud Infrastructure. Al termine del laboratorio, sostituisci questi valori con quelli specifici del tuo ambiente cloud.

Eseguire la migrazione dei nodi GPU Bare Metal in OKE come nodi autogestiti utilizzando uno stack OCI

Introduzione

In questa esercitazione verrà illustrato il processo di migrazione dei nodi GPU Bare Metal (BM) ai nodi autogestiti OKE (Oracle Cloud Infrastructure Kubernetes Engine) utilizzando uno stack OCI (Oracle Cloud Infrastructure).

Prima di tutto, capiamo quali sono i nodi autogestiti e perché sono la soluzione ideale per eseguire GPU su OKE.

Che cosa sono i nodi gestiti automaticamente OKE?

Come suggerisce il nome, i nodi autogestiti sono completamente controllati e gestiti dal cliente. Sono incluse le attività di provisioning, ridimensionamento, configurazione, upgrade e manutenzione, come l'applicazione di patch al sistema operativo e la sostituzione dei nodi. Sebbene questo approccio richieda una maggiore gestione manuale, offre la massima flessibilità e controllo, rendendolo adatto a carichi di lavoro specializzati come quelli in esecuzione sulle GPU.

Funzioni principali dei nodi autogestiti:

-

Controllo completo: il cliente ha il controllo completo sul ciclo di vita del nodo, inclusi provisioning, aggiornamenti del sistema operativo, ridimensionamento e interruzione.

-

Configurazioni personalizzate: il cliente può utilizzare immagini personalizzate, installare software specifici, configurare la rete o utilizzare tipi di istanza alternativi.

-

Aggiornamenti manuali: a differenza dei pool di nodi gestiti da OKE, il cliente deve eseguire manualmente l'upgrade delle versioni Kubernetes, delle patch di sicurezza e degli aggiornamenti del sistema operativo.

-

Modello BYON (Bring Your Own Nodes): il cliente può utilizzare le istanze di OCI Compute esistenti come nodi di lavoro in un cluster OKE.

-

Nessun riciclaggio automatico dei nodi: se un nodo non riesce, il cliente deve sostituirlo/ciclo manualmente.

Questa esercitazione descrive un caso d'uso in cui i carichi di lavoro BM A100 GPU sono attualmente in esecuzione su un cluster Slurm in OCI, con l'obiettivo di migrarli in un cluster OKE. Ciò può essere ottenuto utilizzando lo stack OKE HPC (High Performance Computing) per distribuire un cluster OKE vuoto e quindi aggiungervi i nodi GPU esistenti.

Obiettivi

- Eseguire la migrazione dei nodi GPU BM A100 in OKE come nodi autogestiti utilizzando lo stack OKE HPC.

Prerequisiti

-

Accesso amministratore a una tenancy OCI e a un cluster OKE in esecuzione.

-

Installare NVIDIA Run:ai sui nodi BM A100 per containerizzare le applicazioni. Per ulteriori informazioni, vedere NVIDIA Run:ai.

-

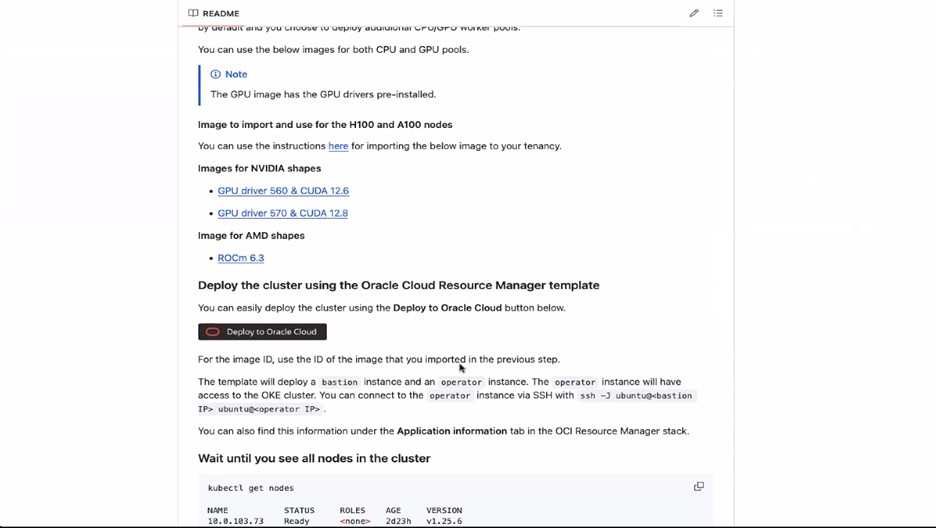

Eseguire carichi di lavoro GPU RDMA (Remote Direct Memory Access) su OKE. Per ulteriori informazioni, vedere Esecuzione dei carichi di lavoro GPU RDMA (accesso diretto remoto alla memoria) su OKE.

Task 1: eseguire la migrazione dei nodi GPU BM A100 in OKE utilizzando lo stack OKE HPC

-

Eseguire il login a OCI Console e creare i criteri necessari come indicato in questa pagina GitHub: esecuzione dei carichi di lavoro GPU RDMA (accesso diretto remoto alla memoria) su OKE.

-

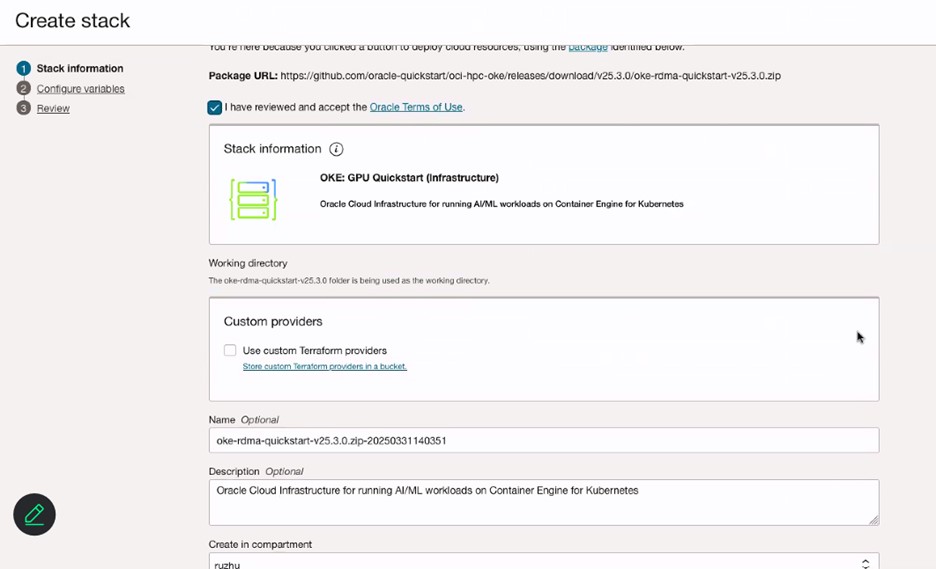

Fare clic su Distribuisci in Oracle Cloud ed esaminare i termini e le condizioni.

-

Selezionare l'area in cui distribuire lo stack.

-

Nella pagina Informazioni sullo stack, immettere Nome per lo stack.

-

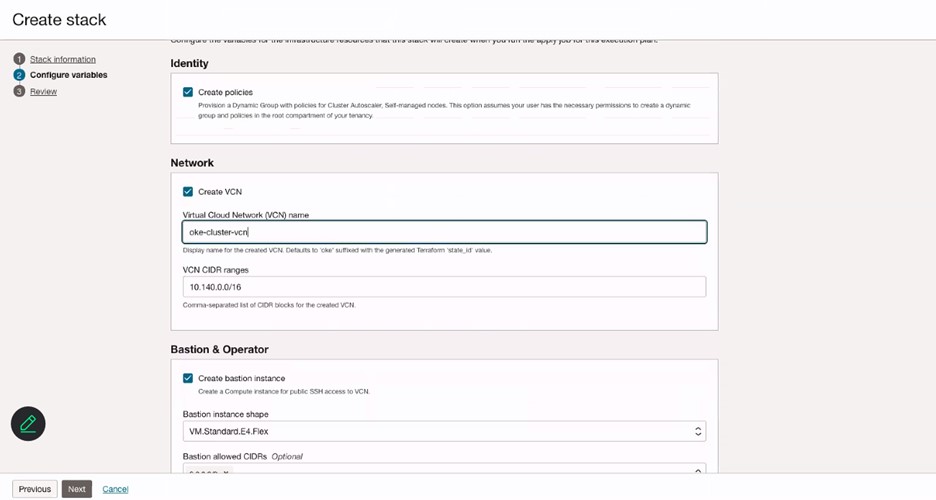

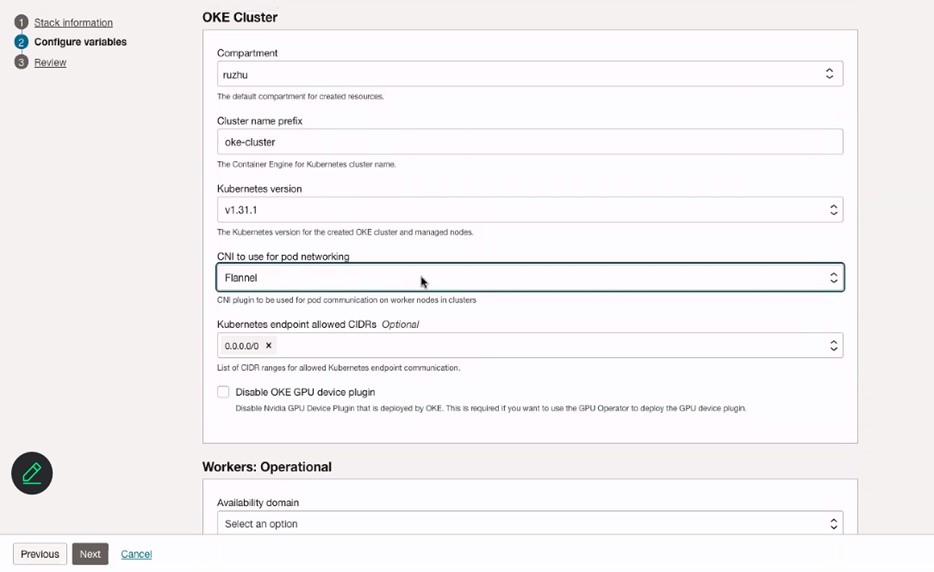

Nella pagina Configura variabile, immettere Nome per la VCN.

-

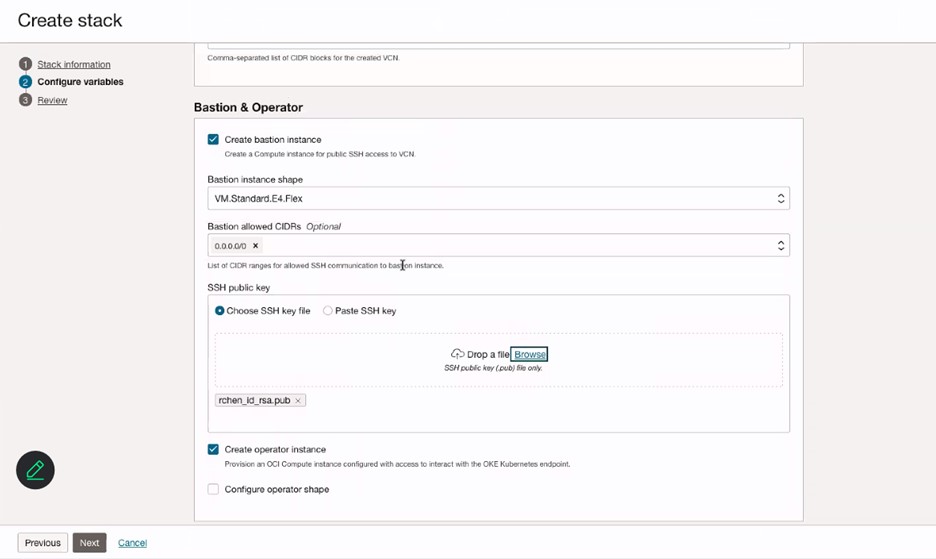

Nella sezione Bastion e operatore, immettere le informazioni dell'istanza Bastion e aggiungere la chiave SSH per l'istanza Bastion.

-

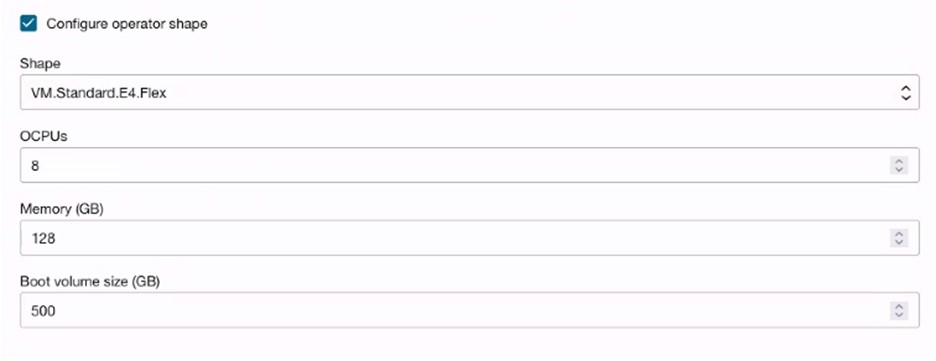

(Facoltativo) Selezionare Configura forma operatore per creare il nodo operatore per i job di monitoraggio o di esecuzione.

-

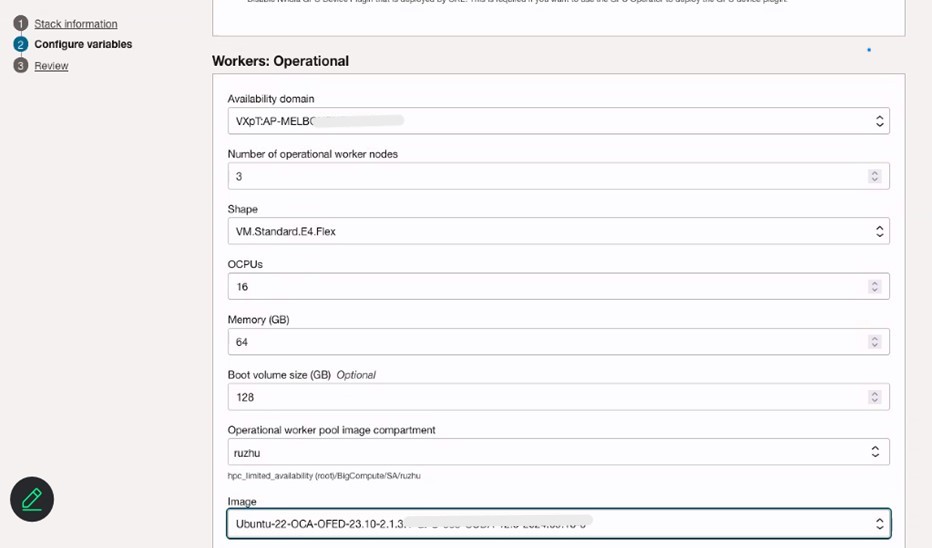

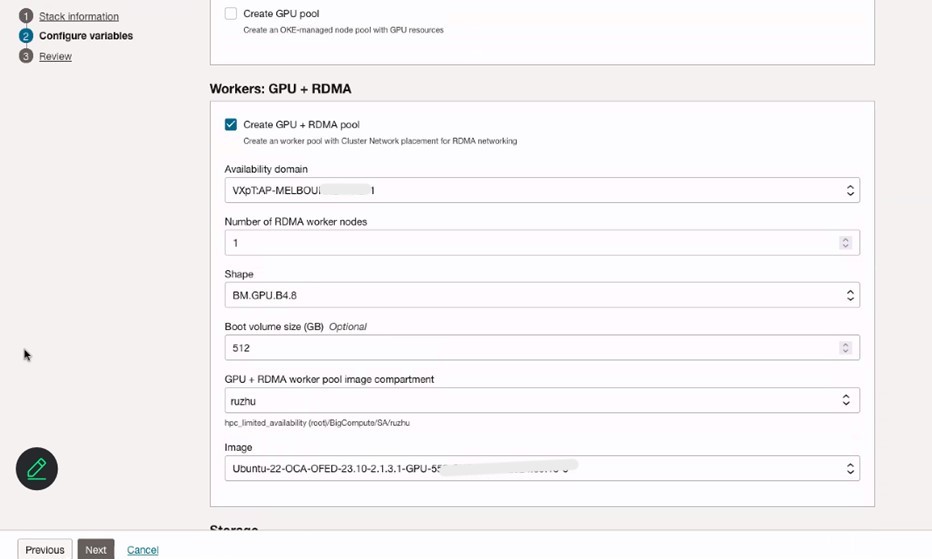

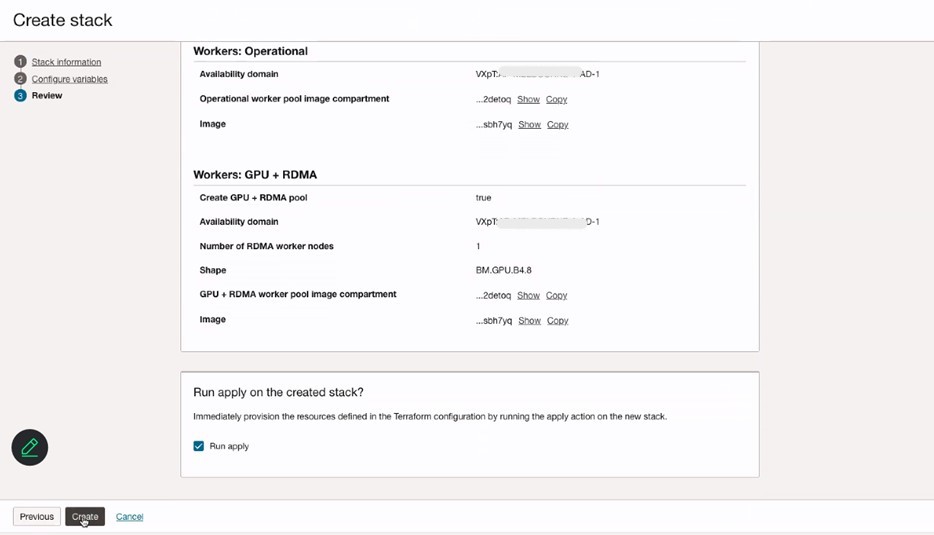

Configurare le variabili dei nodi cluster OKE, Workers: Operational e Workers: GPU + RDMA. Assicurarsi di selezionare il CNI Flannel da utilizzare per il networking pod.

-

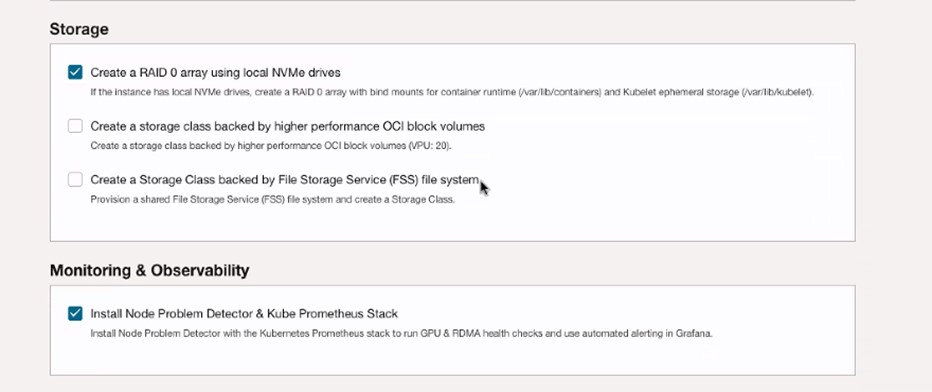

Selezionare Crea un array RAID 0 utilizzando le unità NVMe locali e Installa rilevatore problemi nodo e stack Kube Prometheus.

-

Rivedere le informazioni sullo stack e fare clic su Crea.

-

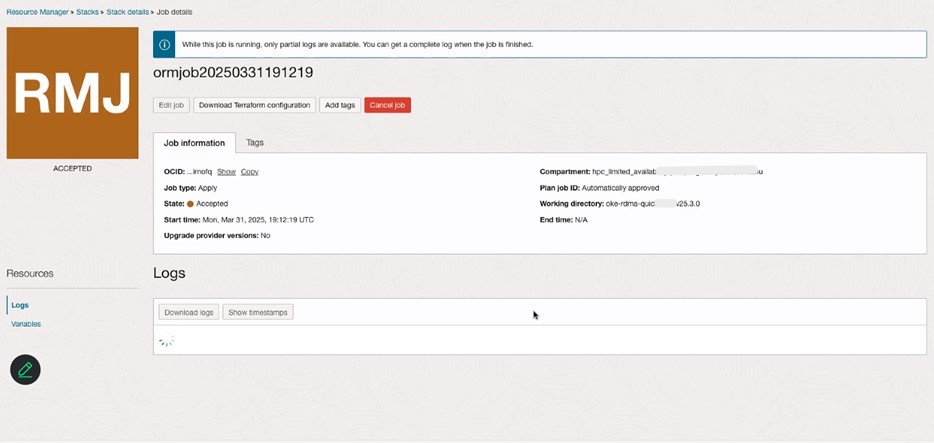

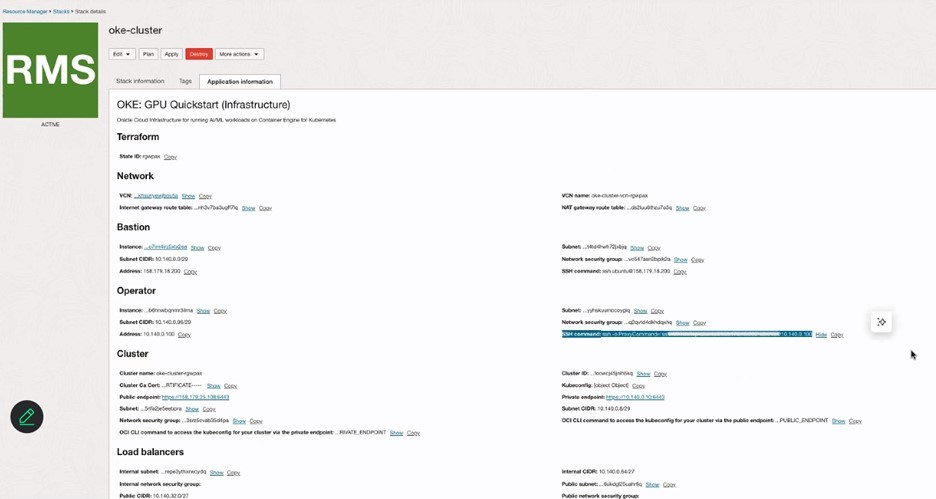

Rivedere i dettagli dello stack in Resource Manager e verificare il cluster OKE nella sezione Kubernetes nella console OCI.

-

Eseguire il login al cluster OKE utilizzando il cluster di accesso tramite OCI Console e continuare ad aggiungere nuovi nodi GPU.

-

Attenersi a tutti i passi descritti qui: Creazione di un gruppo dinamico e di un criterio per i nodi autogestiti.

-

Seguire i passi 1 e 2 indicati qui: Creazione di script cloud-init per nodi autogestiti.

-

Eseguire lo script seguente per aggiungere i nodi GPU al cluster OKE.

sudo rm archive_uri-https_objectstorage_ap-osaka-1_oraclecloud_com_p_ltn5w_61bxynnhz4j9g2drkdic3mwpn7vqce4gznmjwqqzdqjamehhuogyuld5ht_n_hpc_limited_availability_b_oke_node_repo_o_ubuntu-jammy.list sudo apt install -y oci-oke-node-all* sudo oke bootstrap --apiserver-host <API SERVER IP> --ca <CA CERT> --manage-gpu-services --crio-extra-args " -

Eseguire il comando seguente per verificare che i nodi siano stati aggiunti correttamente al cluster OKE.

kubectl get nodes

Collegamenti correlati

-

Creazione di un gruppo dinamico e di un criterio per i nodi autogestiti

-

Presentazione della migliore piattaforma per i carichi di lavoro AI - OCI Kubernetes Engine (OKE)

Conferme

- Autori - Ruzhu Chen (Master Principal Enterprise Cloud Architect), Payal Sharma (Senior Enterprise Cloud Architect)

Altre risorse di apprendimento

Esplora altri laboratori su docs.oracle.com/learn o accedi a più contenuti gratuiti sulla formazione su Oracle Learning YouTube channel. Inoltre, visita education.oracle.com/learning-explorer per diventare un Oracle Learning Explorer.

Per la documentazione del prodotto, visita l'Oracle Help Center.

Migrate Bare Metal GPU Nodes to OKE as Self-Managed Nodes using an OCI Stack

G31989-01

Copyright ©2025, Oracle and/or its affiliates.