Pattern consigliati per i data lake basati sul cloud

A seconda del tuo caso d'uso, i data lake possono essere costruiti sullo storage degli oggetti o su Hadoop. Entrambe possono scalare e integrare perfettamente dati e strumenti aziendali esistenti. Prendere in considerazione i pattern Greenfield o Migrazione per l'organizzazione. Scegli il Greenfield o il pattern di migrazione in base alla pianificazione di un'implementazione completamente nuova o desideri eseguire la migrazione della soluzione Big Data esistente in Oracle Cloud.

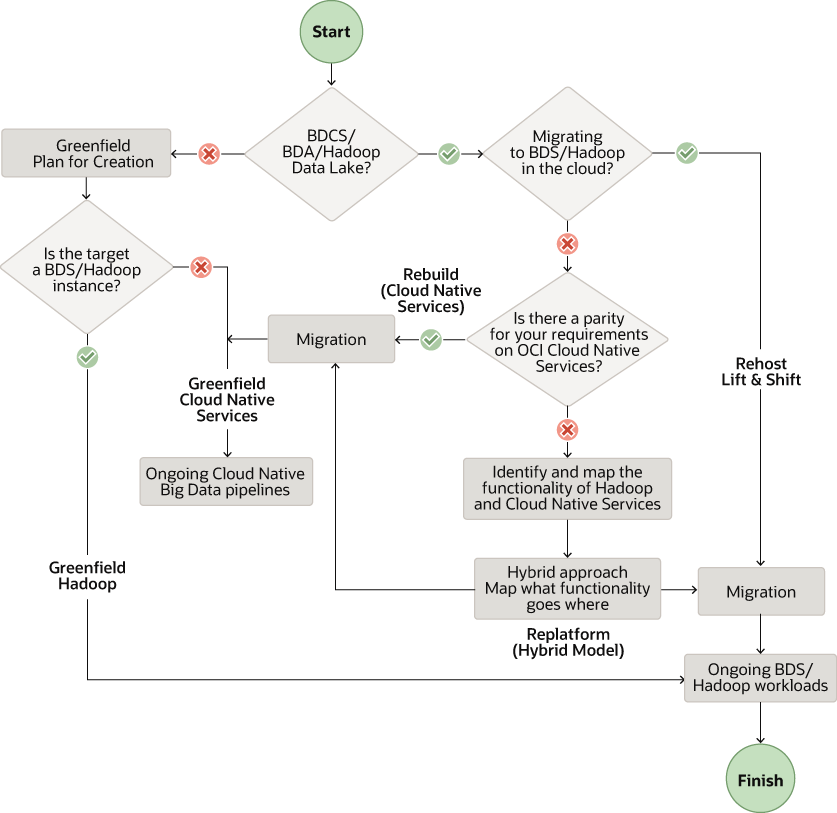

Il flusso di lavoro riportato di seguito mostra i pattern consigliati in base ai requisiti.

Descrizione dell'illustrazione data-lake-solution-pattern.png

Nota:

In questo documento ci concentriamo sulla migrazione dei cluster Big Data Appliance (BDA) e Big Data Cloud Services (BDCS) a OCI, in base alla distribuzione Cloudera di Hadoop (CDH). Tuttavia, i suggerimenti in questa sezione sono applicabili alle altre distribuzioni Hadoop on premise e cloud.

Crea una nuova piattaforma di dati su Oracle Cloud (Greenfield)

Hai due opzioni per creare data lake in Oracle Cloud per i progetti Greenfield. Utilizza il servizio Big Data (BDS) per data lake basati su HDFS. Utilizza i servizi di dati nativi nel cloud OCI per i data lake basati sullo storage degli oggetti senza usare HDFS.

Cloud Native Data Services

Crea un data lake nello storage degli oggetti OCI e utilizza i servizi cloud nativi e di intelligenza artificiale. Questi servizi includono Flusso di dati, Integrazione dei dati, Autonomous Data Warehouse, Catalogo dati e Data Science insieme ad altri.

Oracle consiglia questi servizi di creare un nuovo data lake:

- Storage degli oggetti come area di memorizzazione del data lake per tutti i tipi di dati grezzi

- Servizio flusso di dati per processi batch Spark e per cluster Spark effimeri

- Servizio Integrazione dei dati per l'inclusione dei dati e per i job ETL

- Autonomous Data Warehouse (ADW) per servire e presentare i dati del livello

- Data Catalog per la ricerca e la gestione del controllo dei dati

Oracle consiglia questi servizi aggiuntivi per creare un nuovo data lake:

- Servizio di streaming per un'inclusione gestita di dati in tempo reale

- Servizio Data Transfer Appliance (DTA) per il trasferimento in blocco dei dati

- Servizio GoldenGate per i dati CDC (Change Data Capture) e per l'analitica in streaming

- Servizio Data Science per i requisiti di machine learning

- Servizio Oracle Analytics Cloud (OAC) per i requisiti di BI, analisi e reporting

Big Data Service

Creare un data lake in HDFS utilizzando Oracle Big Data Service (BDS). BDS fornisce componenti Hadoop utilizzati più di frequente, inclusi HDFS, Hive, HBase, Spark e Oozie.

Oracle consiglia questi servizi di creare un nuovo data lake utilizzando i cluster Hadoop:

- Servizio Integrazione dei dati per l'inclusione dei dati e per i job ETL

- Servizio Data Transfer Appliance (DTA) per il trasferimento in blocco dei dati

- Servizio GoldenGate per i dati CDC e per l'analitica in streaming

- Servizio Data Catalog per la ricerca e la gestione del controllo dei dati

- Servizio Data Science per i requisiti di machine learning

- Servizio OAC per i requisiti di BI, analitica e generazione di report

- BDS per HDFS e altri componenti Hadoop

Flusso di lavoro pattern campo verde

Quando crei un nuovo data lake, segui questo flusso di lavoro dai requisiti attraverso la verifica e la convalida:

- Requisiti: elenca i requisiti per i nuovi ambienti in OCI.

- Valutazione: valuta i servizi e gli strumenti OCI necessari

- Progettazione: progetta l'architettura e il dimensionamento della soluzione per OCI

- Piano: crea un piano dettagliato mappando tempo e risorse

- Provisioning: esegue il provisioning e configura le risorse necessarie in OCI.

- Implementazione: implementa i carichi di lavoro dei dati e delle applicazioni

- Automatizzazione della pipeline: organizza e pianifica le pipeline di flusso di lavoro per l'automazione

- Test e convalida: esegue test di convalida, funzionalità e prestazioni per la soluzione end-to-end

Migrazione della piattaforma di dati esistente in Oracle Cloud

Rigenera pattern

Utilizzare il pattern di rigenerazione se non si desidera utilizzare i cluster Hadoop e si desidera eseguire la migrazione ai servizi cloud nativi in Oracle Cloud Infrastructure (OCI). Inizia con un'ardesia pulita per progettare e iniziare l'implementazione da zero nell'infrastruttura OCI. Sfrutta i servizi cloud nativi gestiti per tutti i componenti principali del tuo stack. Ad esempio, creare uno stack utilizzando Flusso di dati, Catalogo dati, Integrazione dati, Streaming, Data Science, ADW e OAC.

Oracle consiglia questi servizi di eseguire la migrazione a un data lake basato sul cloud senza cluster Hadoop:

- Servizio di storage degli oggetti, in quanto data lake store per tutti i tipi di dati grezzi

Nota:

È possibile utilizzare lo storage degli oggetti con un connettore HDFS come area di memorizzazione HDFS al posto di HDFS nel cluster Hadoop o Spark. - Servizio Integrazione dei dati per l'inclusione dei dati e per i job ETL

- Servizio di streaming per l'inclusione gestita di dati in tempo reale che può sostituire i servizi Kafka o Flume autogestiti

- Data Transfer Appliance per il trasferimento in blocco dei dati

- GoldenGate per i dati CDC e per l'analitica in streaming

- Servizio flusso di dati per processi batch Spark e per cluster Spark effimeri

- ADW per servire e presentare i dati dei livelli

- Servizio Data Catalog per la ricerca e la gestione del controllo dei dati

- Servizio Data Science per i requisiti di machine learning

- Servizio OAC per i requisiti di BI, analitica e generazione di report

Pattern di piattaforma

Utilizzare il pattern di migrazione Replatform se si desidera utilizzare i cluster Hadoop nel cloud e sostituire alcuni componenti con i servizi nativi cloud. Utilizzare il servizio Big Data per HDFS e altri componenti Hadoop, nonché riprogettare parte del proprio stack utilizzando i nostri servizi nativi cloud gestiti aggiuntivi.

Potrebbe essere necessario riprogettare lo stack per utilizzare il pattern di replica.

- Includi servizi cloud nativi serverless insieme a BDS in OCI

- Utilizza i servizi cloud nativi gestiti dove possibile

È possibile sostituire alcuni di questi componenti in base alle proprie esigenze.

- BDS per HDFS e altri componenti Hadoop come Hive, HBase, Kafka e Oozie

- Servizio Integrazione dei dati per l'inclusione dei dati e per i job ETL

- Servizio Data Transfer Appliance per il trasferimento in blocco dei dati

- Servizio GoldenGate per i dati CDC e per l'analitica in streaming

- Servizio Data Catalog per la ricerca e la gestione del controllo dei dati

- Servizio Data Science per i requisiti di machine learning

- Servizio OAC per i requisiti di BI, analitica e generazione di report

Riproduci pattern

Eseguire la migrazione di BDA, BDCS e altri cluster Hadoop per creare un data lake in HDFS utilizzando il servizio Big Data (BDS). È possibile utilizzare un approccio di sollevamento e spostamento quando si utilizza il modello Rehost. Tutti i componenti Hadoop utilizzati comunemente, inclusi HDFS, Hive, HBase, Spark e Oozie, sono disponibili nei cluster Hadoop gestiti forniti da BDS.

Flusso di lavoro pattern migrazione

Quando migra il tuo data lake in Oracle Cloud, segui questo flusso di lavoro dai requisiti attraverso il taglio al nuovo ambiente.

- Sconto e requisiti: individua e cataloga il sistema corrente per elencare i requisiti del nuovo ambiente OCI.

- Valutazione: valuta i servizi e gli strumenti OCI necessari

- Progettazione: progetta l'architettura e il dimensionamento della soluzione per OCI

- Piano: crea un piano dettagliato mappando tempo e risorse

- Provisioning: esegue il provisioning e configura le risorse necessarie in OCI.

- Esegui migrazione dati: trasferisci dati e metadati nello storage dei dati dei servizi OCI selezionati

- Migrazione del carico di lavoro: eseguire la migrazione dei carichi di lavoro e delle applicazioni ai servizi OCI utilizzando il pattern di migrazione selezionato.

- Automatizzazione della pipeline: organizza e pianifica le pipeline di flusso di lavoro per l'automazione

- Test e convalida: pianifica il test funzionale e le prestazioni e la convalida per l'ambiente OCI finale

- Taglia: disattiva l'ambiente di origine e utilizza solo il nuovo ambiente basato su OCI.