Informazioni sulla progettazione dei data lake in Oracle Cloud

OCI offre un portfolio completo di dati dell'infrastruttura e della piattaforma cloud e di servizi AI per accedere, memorizzare ed elaborare una vasta gamma di tipi di dati da qualsiasi origine. OCI consente di implementare i dati di livello Enterprise end-to-end e le architetture AI sul cloud. Questa soluzione offre una panoramica dei servizi chiave che ti aiutano a costruire e a lavorare con i data lake nell'infrastruttura OCI. Scopri anche altri servizi disponibili e puoi progettare le tue soluzioni data lake in base ad alcuni dei nostri modelli vettati e linee guida di esperti.

Architettura

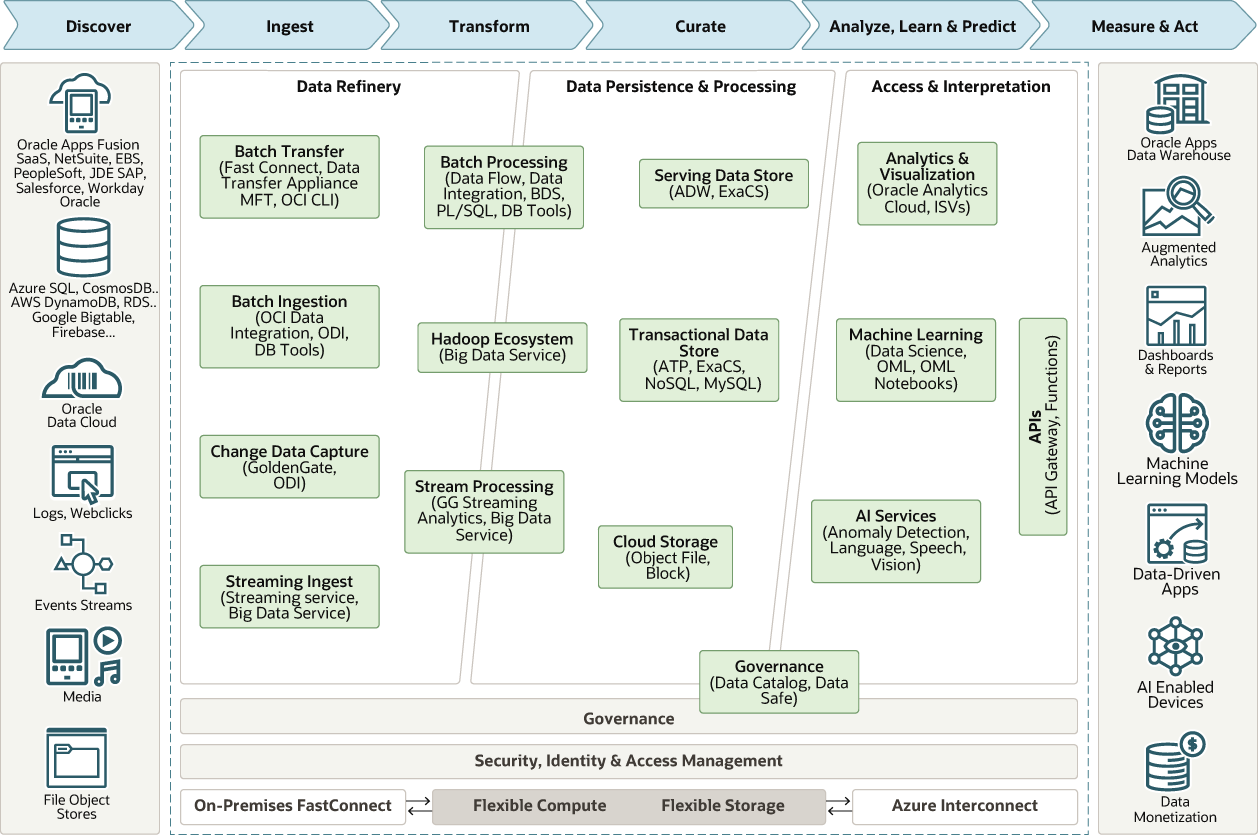

Questa architettura combina le capacità di un data lake e di un data warehouse di elaborare diversi tipi di dati da un'ampia gamma di risorse di dati aziendali. Utilizza questa architettura per progettare architetture data lake end-to-end in OCI.

Questo diagramma mostra un'architettura di alto livello di dati e servizi AI di Oracle.

Descrizione dell'illustrazione data-lakes.png

In questa architettura, i dati passano attraverso queste fasi:

- Raffinazione dei dati

Ingestisce e perfeziona i dati da utilizzare in ciascun layer di dati dell'architettura.

- Persistenza e elaborazione dei dati (livello di informazioni protette)

Facilita l'accesso e la navigazione dei dati per visualizzare la vista aziendale corrente. Per le tecnologie relazionali, i dati possono essere strutturati logicamente o fisicamente in forme relazionali, longitudinali, dimensionali o OLAP semplici. Per i dati non relazionali, questo livello contiene uno o più pool di dati, output da un processo analitico o dati ottimizzati per un task analitico specifico.

- Interpretazione di accesso e &

Estrae la vista logica aziendale dei dati relativi ai consumatori. Questa astrazione facilita lo sviluppo agile, la migrazione all'architettura di destinazione e la fornitura di un singolo livello di reporting da più fonti federate.

Questa architettura dispone dei componenti riportati di seguito.

- Big Data Service

Oracle Big Data Service (BDS) è un servizio cloud completamente gestito e automatizzato che fornisce cluster con un ambiente Hadoop. BDS semplifica la distribuzione di cluster Hadoop di tutte le dimensioni e semplifica il processo di rendere i cluster Hadoop altamente disponibili e sicuri. Basandosi sulle migliori prassi di Oracle, BDS implementa l'alta disponibilità e la sicurezza e riduce la necessità di competenze Hadoop avanzate. BDS offre i componenti Hadoop comunemente utilizzati che consentono alle aziende di spostare i carichi di lavoro nel cloud e garantisce la compatibilità con le soluzioni on-premise.

Oracle Cloud SQL è un servizio aggiuntivo disponibile che consente ai clienti di avviare query Oracle SQL sui dati in HDFS, Kafka e Oracle Object Storage. Qualsiasi utente, applicazione o strumento di analitica può utilizzare i data store per ridurre al minimo lo spostamento dei dati e velocizzare le query. BDS interagisce con i servizi di integrazione dei dati, data science e analisi e consente agli sviluppatori di accedere facilmente ai dati mediante Oracle SQL. Le aziende possono eliminare i silos di dati e garantire che i data lake non siano isolati da altre fonti di dati aziendali.

- Data Catalog

Oracle Cloud Infrastructure Data Catalog è una soluzione di ricerca automatica e gestione del controllo dei dati della tua azienda completamente gestita e self-service. Le soluzioni Data Catalog sono fondamentali per consentire a un'organizzazione di cercare e trovare i dati da analizzare. Consentono ai professionisti dei dati di scoprire dati e supportare la governance dei dati.

Utilizza Data Catalog come singolo ambiente collaborativo per gestire i metadati tecnici, aziendali e operativi. È possibile raccogliere metadati tecnici da una vasta gamma di origini dati supportate accessibili mediante indirizzi IP pubblici o privati. È possibile organizzare, trovare, accedere, comprendere, arricchire e attivare questi metadati. Utilizza la raccolta automatica su richiesta o basata su pianificazione per garantire che il Data Catalog abbia sempre informazioni aggiornate. Sfrutta tutti i vantaggi offerti da sicurezza, affidabilità, performance e scalabilità di Oracle Cloud.

-

Flusso di dati

Oracle Cloud Infrastructure Data Flow è un servizio completamente gestito per l'esecuzione delle applicazioni Apache Spark. Le applicazioni di flusso di dati sono modelli riutilizzabili costituiti da un'applicazione Spark, dalle relative dipendenze, dai parametri predefiniti e da una specifica di risorsa runtime predefinita. Puoi gestire tutti gli aspetti del flusso di dati e del ciclo di vita di sviluppo delle applicazioni, tracciando ed eseguendo i job Apache Spark utilizzando le API REST tramite il gateway API e le funzioni disponibili.

Il flusso di dati supporta la rapida distribuzione delle applicazioni, consentendo agli sviluppatori di concentrarsi sullo sviluppo delle applicazioni. Fornisce la gestione dei log e un ambiente runtime per eseguire le applicazioni. Puoi integrare applicazioni, workflow e accedere alle API tramite l'interfaccia utente. Elimina la necessità di impostare l'infrastruttura, il provisioning dei cluster, l'installazione del software, lo storage e la sicurezza.

- Autonomous Data Warehouse

Oracle Autonomous Data Warehouse è un servizio di database a gestione autonoma, protezione automatica e funzionalità di autoriparazione che viene ottimizzato per i carichi di lavoro di data warehousing. Non è necessario configurare né gestire alcun hardware o installare software. Oracle Cloud Infrastructure gestisce la creazione del database e il backup, l'applicazione di patch, l'aggiornamento e il tuning del database.

- Integrazione dei dati

Oracle Cloud Infrastructure Data Integration è un servizio cloud completamente gestito e serverless che include e trasforma i dati per la data science e l'analitica. L'integrazione dei dati consente di semplificare i processi complessi di estrazione, trasformazione e caricamento dei dati (ETL/E-LT) in data lake e warehouse per il data science e l'analitica con il progettista di flusso di dati di Oracle. Fornisce protezione deriva automatica dello schema mediante un flusso di integrazione basato su regole che consente di evitare flussi di integrazione interrotti e ridurre la manutenzione con l'evoluzione degli schemi di dati.

-

Scienza dei dati

Oracle Cloud Infrastructure Data Science è una piattaforma completamente gestita e serverless che consente ai data scientist di creare, formare e gestire modelli di machine learning su Oracle Cloud Infrastructure. I data scientist possono utilizzare la libreria Accelerated Data Science di Oracle (ADS) migliorata da Oracle per il machine learning automatico (AutoML), la valutazione dei modelli e la spiegazione dei modelli.

ADS è una libreria Python contenente un set completo di connessioni dati che consente ai data scientist di accedere e utilizzare i dati di molti data store diversi per produrre modelli migliori. La libreria ADS supporta il proprio AutoML Oracle e gli strumenti open source quali H2O.ai e Auto-Sklearn.

I data scientist e gli amministratori dell'infrastruttura possono implementare facilmente modelli di data science come Oracle Functions, un'architettura altamente scalabile, su richiesta e serverless su OCI. I membri del team possono utilizzare il catalogo modelli per conservare e condividere i modelli di apprendimento automatico completati e gli artifact necessari per riprodurli, testarli e distribuirli.

Informazioni sui data lake

Un data lake è un repository scalabile e centralizzato in grado di archiviare i dati grezzi e consentire a un'azienda di memorizzare tutti i suoi dati in un ambiente elastico ed economico. Un data lake offre un meccanismo di archiviazione flessibile per la memorizzazione dei dati grezzi. Affinché un data lake sia efficace, un'organizzazione deve esaminare le sue specifiche esigenze di governance, i flussi di lavoro e gli strumenti. Costruire intorno a questi elementi core crea un potente data lake che si integra perfettamente nelle architetture esistenti e collega facilmente i dati agli utenti.

- Tempi di decisione più rapidi sfruttando l'analisi dei dati e il machine learning

- Raccolta e estrazione di big data per data scientist, analisti e sviluppatori

Per rendere utili i dati non strutturati memorizzati in un data lake, è necessario elaborarli e prepararli per l'analisi. Questa situazione è spesso difficile se non si dispone di risorse estese di data engineering.

Di seguito sono elencate le problematiche tecniche relative alla gestione dei data lake on premise.

- Costi iniziali e mancanza di flessibilità: quando le organizzazioni creano la propria infrastruttura on-premise, devono pianificare, acquistare e gestire l'infrastruttura hardware, avviare i server e gestire anche le interruzioni e i tempi di inattività.

- Costi di manutenzione continui: quando si gestisce un data lake on-premise, che si manifesta principalmente nei costi IT e ingegneristici, le organizzazioni devono tenere conto dei costi di manutenzione continui. Sono inclusi anche i costi di applicazione di patch, manutenzione, upgrade e supporto dell'infrastruttura hardware e software di base.

- Nessuna agilità e attività amministrative: le organizzazioni IT devono fornire risorse, gestire carichi di lavoro irregolari su larga scala e tenere il passo con l'innovazione software open source, basata sulla community e in rapida evoluzione.

- Complessità nella creazione di pipeline di dati: gli ingegneri devono gestire la complessità dell'integrazione di una vasta gamma di strumenti per includere, organizzare, pre-elaborare, orchestrare processi ETL batch ed eseguire query sui dati memorizzati nel lago.

-

Scalabilità e utilizzo non ottimale delle risorse: man mano che la base utenti cresce, l'organizzazione deve gestire manualmente l'utilizzo delle risorse e creare server aggiuntivi per lo scale-up su richiesta. La maggior parte delle distribuzioni locali di Hadoop e Spark associa direttamente le risorse di computazione e storage agli stessi server, creando un modello poco flessibile.

Di seguito sono elencati i vantaggi aziendali derivanti dallo spostamento dei data lake nel cloud.

- Minori costi di progettazione e servizi gestiti: crea pipeline di dati preintegrate in modo più efficiente con strumenti basati sul cloud e riduci i costi legati all'ingegneria dei dati. Trasferisci la gestione del ridimensionamento al provider cloud utilizzando servizi cloud come lo storage degli oggetti e Autonomous Data Warehouse (ADW) che forniscono un ridimensionamento trasparente. Non è necessario aggiungere computer o gestire cluster in data lake basati sul cloud.

- Sfrutta l'infrastruttura agile e le tecnologie più recenti: progetta il tuo data lake in nuovi casi d'uso con la nostra infrastruttura cloud flessibile, agile e on-demand. Puoi eseguire rapidamente l'upgrade alla tecnologia più recente e aggiungere nuovi servizi cloud quando diventano disponibili, senza riprogettare l'architettura.