Distribuire il progetto

Assicurarsi di avere accesso a una tenancy OCI e di disporre dei privilegi di amministrazione per fornire istanze CPU/GPU sufficienti.

- Installare un cluster OKE utilizzando il modulo Terraform sottostante. Verrà creato un cluster OKE con un singolo pool di nodi con 6 nodi di lavoro.

- Fai clic su Distribuisci su Oracle Cloud di seguito.

- Dare allo stack un nome (ad esempio, oke-stack).

- Selezionare il compartimento in cui si desidera distribuire i progetti AI OCI.

- Fornire eventuali parametri aggiuntivi (ad esempio la dimensione del nodo, il conteggio dei nodi) in base alle preferenze.

- Fare clic su Successivo, quindi su Crea e infine su Esegui applicazione per eseguire il provisioning del cluster.

- Accedere alla console di Oracle Cloud Infrastructure e fare clic su Memorizzazione nella home page, quindi in Storage degli oggetti fare clic su Bucket. Fornire un nome bucket che verrà utilizzato nella distribuzione di OCI AI Blueprints.

Fare clic sul bucket creato e sul collegamento Richieste preautenticate (PAR, Pre-Authenticated Request) in Risorse. Assegnare un nome per la richiesta PAR, modificare il tipo di accesso in Consenti letture e scritture degli oggetti e fare clic su Richieste preautenticate. Al termine, copiare l'URL PAR e salvarlo da qualche parte in quanto sarà necessario quando si distribuisce il progetto Inferenza CPU.

- Installa i progetti AI OCI nel nuovo cluster OKE. Dopo una distribuzione riuscita, avrai un URL per accedere alla console di OCI AI Blueprints.

- Nella pagina principale dei progetti AI OCI sono disponibili diversi progetti per la distribuzione in Binario Blueprint, scorrere verso il basso e fare clic su Distribuisci in Inferenza CPU.

- Selezionare Inferenza CPU con mistral e VM-Standard.E4. Opzione .

Utilizzare i parametri predefiniti e modificare l'URL della richiesta preautenticata creato in precedenza. Non modificare alcun valore nella sezione Configura parametri.

Si prega di notare i parametri:

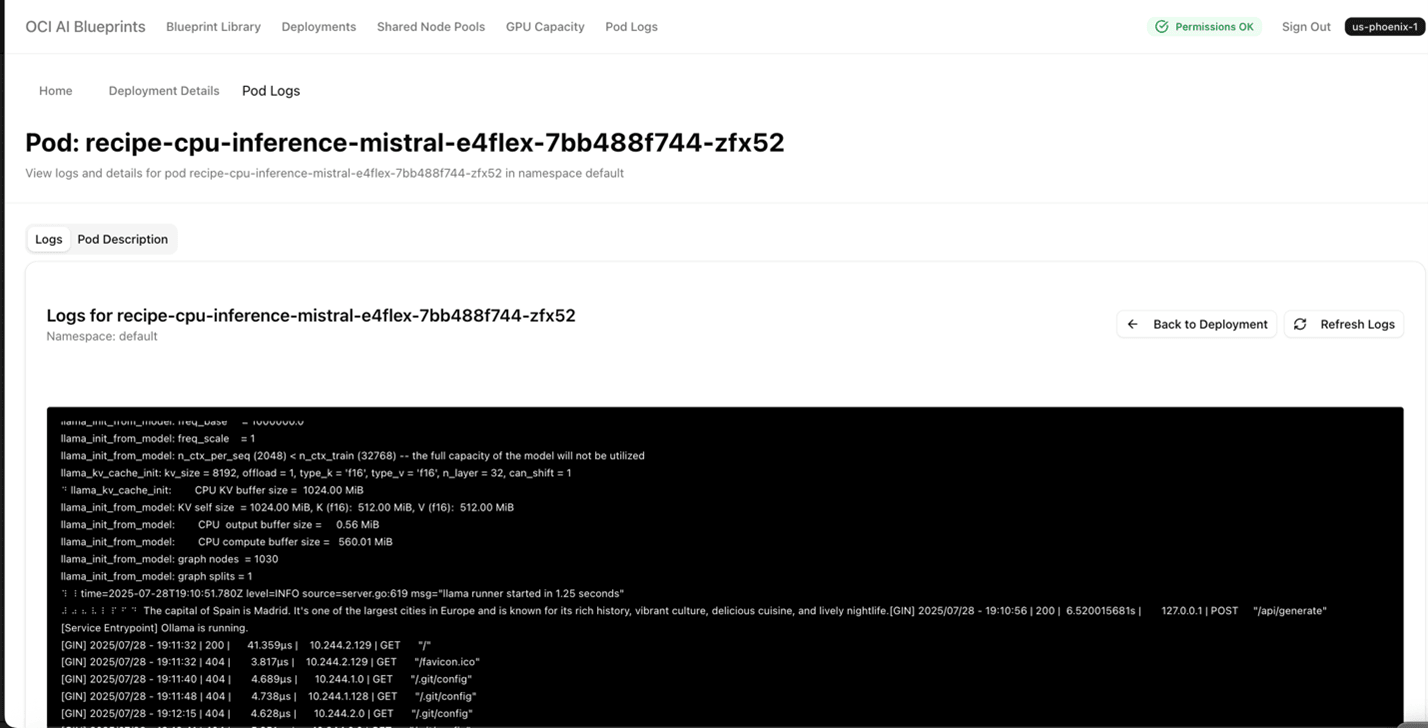

"recipe_container_env": [ { "key": "MODEL_NAME", "value": "mistral" }, { "key": "PROMPT", "value": "What is the capital of Spain?" }Dopo la distribuzione riuscita del progetto di derivazione della CPU, l'output del prompt precedente verrà visualizzato nel pod log Kubernetes.

- Fare clic su Distribuisci progetto. Una volta che il progetto è stato distribuito correttamente, si noterà un nome come cpu inference mistral E4Flex che elenca uno stato di distribuzione di Monitoraggio con la data di creazione e il numero di nodi e forme E4.

- Nella lista Distribuzione fare clic sul collegamento Endpoint pubblico di inferenza CPU E4Flex che consente di accedere ai dettagli della distribuzione con l'endpoint pubblico. Fare clic sull'endpoint pubblico e verrà visualizzato un messaggio come "ollama è in esecuzione".

- Tornare alla pagina Cpu inference mistral E4Flex e scorrere fino ai log Pod. Fare clic su Visualizza e Dettagli log. Verrà visualizzata una pagina simile alla seguente che fornisce l'output.

- Selezionare Inferenza CPU con mistral e VM-Standard.E4. Opzione .