Informazioni sul progetto di inferenza CPU

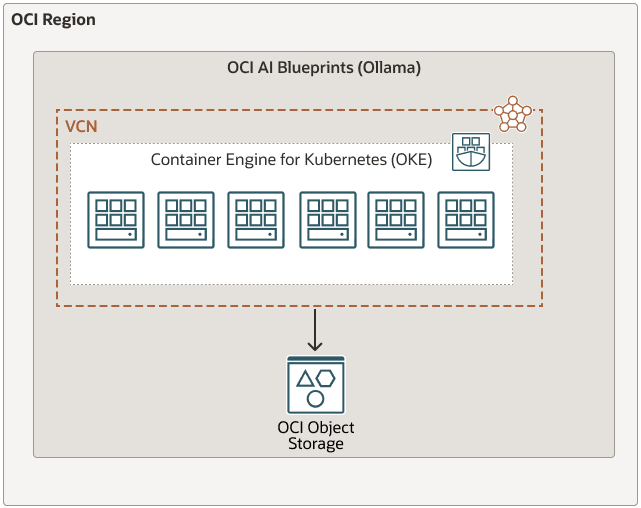

Oracle Cloud Infrastructure AI Blueprints è una soluzione semplificata e senza codice per l'implementazione e la gestione dei carichi di lavoro di AI generativa su Oracle Cloud Infrastructure Kubernetes Engine (OKE).

Fornendo consigli hardware ponderati, stack software preconfezionati e strumenti di osservabilità pronti all'uso, OCI AI Blueprints ti aiuta a far funzionare le tue applicazioni AI in modo rapido ed efficiente, senza lottare con le complessità delle decisioni sull'infrastruttura, della compatibilità del software e delle best practice delle operazioni di machine learning (ML Ops).

Questo progetto CPU Inference fornisce un framework completo per testare l'inferenza sulle CPU utilizzando la piattaforma Ollama con una varietà di modelli supportati come Mistral, Gemma e altri disponibili tramite Ollama. A differenza delle soluzioni dipendenti dalla GPU, questo progetto è progettato per ambienti in cui l'inferenza della CPU è preferita o richiesta.

Il progetto offre linee guida chiare e impostazioni di configurazione per distribuire un solido servizio di inferenza della CPU e consentire così valutazioni accurate delle prestazioni e test dell'affidabilità. L'architettura leggera ed efficiente di Ollama lo rende una soluzione ideale per gli sviluppatori che desiderano confrontare e ottimizzare i carichi di lavoro di inferenza basati sulla CPU.

Questo progetto spiega come utilizzare l'inferenza CPU per l'esecuzione di modelli linguistici di grandi dimensioni utilizzando Ollama. Include due principali strategie di implementazione:

- Servire modelli pre-salvati direttamente da Oracle Cloud Infrastructure Object Storage

- Estrarre i modelli da Ollama e salvarli nello storage degli oggetti OCI