Pianificare il Data Lakehouse

Durante la pianificazione della data lakehouse, considerare i seguenti casi d'uso rilevanti per banche, broker e servizi finanziari che dispongono di miliardi di record di dati:

- Crea un hub di dati a livello aziendale composto da un data warehouse per dati strutturati e un data lake per dati semi-strutturati e non strutturati. Questo data lakehouse diventa la singola fonte di dati per i tuoi dati.

- Integra le origini dati relazionali con altri data set non strutturati utilizzando le tecnologie di elaborazione dei big data.

- Utilizza la modellazione semantica e potenti strumenti di visualizzazione per semplificare l'analisi dei dati.

Comprendere il caso d'uso aziendale

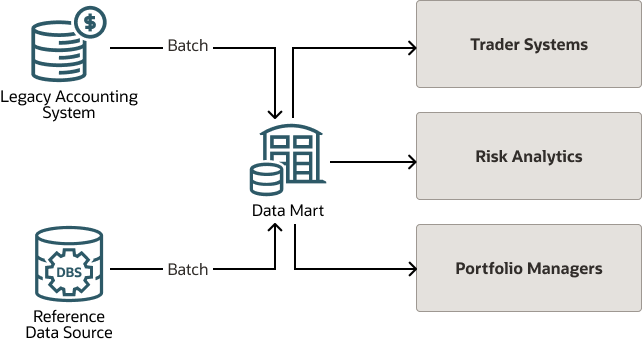

Di seguito è riportata la vista di alto livello di un sistema di valutazione dei fondi che utilizza un sistema contabile precedente per fornire i dati di valutazione in batch a un data mart.

Il data mart recupera anche i dati di riferimento batch da altre origini dati di riferimento. Il data mart trasferisce i dati di valutazione dei fondi in batch ai sistemi a valle nel flusso di lavoro.

Poiché la determinazione dei prezzi viene effettuata in modo statico, in genere alla fine della giornata, il sistema legacy, anche quando tutti i sistemi funzionano correttamente, non è così reattivo come gli utenti ne hanno bisogno.

Ad esempio, nel secondo trimestre del 2022, quando c'era un'estrema volatilità del mercato, tutti i gruppi di utenti erano in forte allerta e tutti volevano conoscere il prezzo e il valore di mercato più recenti in modo che potessero identificare le posizioni di partecipazione durante il giorno. Acquisire il prezzo più recente e ottenere il valore di mercato in tempo reale è stata una grande richiesta per il sistema tradizionale di valutazione dei fondi.

Per acquisire il prezzo più recente e ottenere il valore di mercato in tempo reale, il sistema contabile legacy deve acquisire il prezzo più recente, spingere i dati al data mart e ripetere i flussi di lavoro batch più volte al giorno, che non è abbastanza reattivo né sostenibile.

Comprendere la soluzione

La soluzione non richiede modifiche al sistema legacy che continua a pubblicare dati di valutazione batch come sempre.

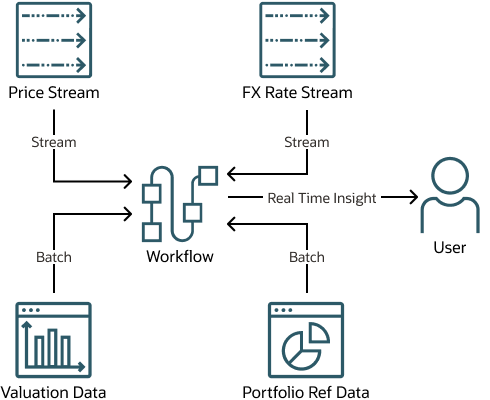

I prezzi in tempo reale e i tassi di cambio vengono acquisiti dai rispettivi flussi e applicati ai prezzi per trovare il valore di mercato in valute diverse.

Un'architettura serverless di Oracle Cloud Infrastructure offre supporto sia per i dati in batch che in tempo reale. I dati batch includono un flusso di snapshot per i dati di riferimento portafoglio, il delta incrementale e il flusso CDC (Modifica acquisizione dati) per i dati di valutazione. I dati in tempo reale includono flussi di prezzi e tassi di cambio. L'architettura include un processo per combinare i dati batch e in tempo reale per ottenere il prezzo in tempo reale, il valore di mercato nella valuta base e il valore di mercato nelle valute estere.

Architettura di esempio

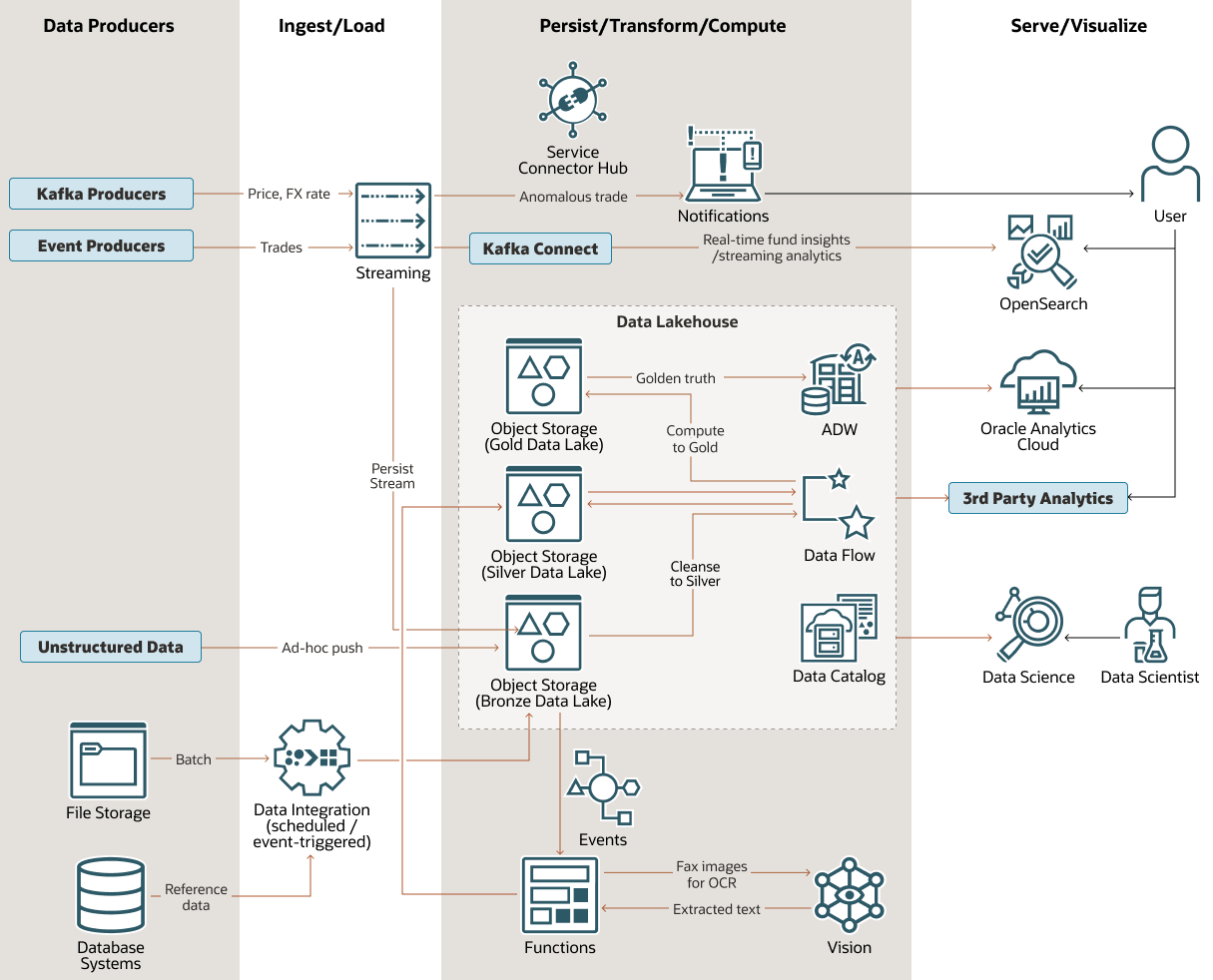

Il diagramma riportato di seguito mostra un'architettura di piattaforma dati moderna, ispirata al cliente su Oracle Cloud Infrastructure (OCI).

Questa architettura può essere utilizzata per i casi d'uso finanziari, ad esempio per acquisire informazioni dettagliate sui fondi in tempo reale, rilevare transazioni anomale e per la pulizia, l'aggregazione e la visualizzazione dei dati finanziari generali.

oci-fund-lakehouse-arch-oracle.zip

Una delle caratteristiche centrali di questa architettura è la sua data lakehouse a più livelli. È composto da tre livelli ben distinti di trattamento dei dati nel data lake, Oracle Autonomous Data Warehouse (ADW) per il warehouse strutturato, Data Catalog Oracle Cloud Infrastructure per metadati e governance e Data Flow per l'elaborazione e la trasformazione dei big data mediante i job di Spark.

Il data lake in bronzo è la prima destinazione per i dati in un formato spesso grezzo, o vicino ad esso. Sono inclusi i dati che risiedono in OCI e i dati di piattaforme terze parti. Oracle Data Integration (ODI) è uno degli strumenti utilizzati per questa integrazione.

L'applicazione Data Flow gestisce la maggior parte della trasformazione e della pulizia dei dati da bronzo a argento. Oracle Cloud Infrastructure Vision estrae testo da immagini fax con la tecnologia di riconoscimento ottico dei caratteri (OCR). I dati di output Vision (testo) vengono inviati dal lago di bronzo al lago d'argento con l'aiuto di Oracle Functions.

Data Flow esegue ulteriori trasformazioni dei dati dal livello del lago d'argento al data lake d'oro, dove i dati vengono caricati in ADW, che a sua volta fornisce Oracle Analytics Cloud e strumenti di visualizzazione e di analisi dei dati di terze parti.

L'architettura include le funzioni aggiuntive riportate di seguito.

- Le notifiche di trading anomale vengono fornite mediante il servizio di streaming OCI e le notifiche OCI, integrate mediante l'uso dell'hub connettore servizio OCI.

- L'analitica di streaming viene fornita per informazioni approfondite sui fondi in tempo reale mediante l'invio di dati di streaming OCI al servizio di ricerca OCI con OpenSearch utilizzando Kafka Connect. OpenSearch I dashboard, un componente integrato del servizio di ricerca OCI, possono fornire una visualizzazione diretta dei dati OpenSearch.

- I data scientist possono esplorare il data lakehouse utilizzando Data Science di OCI, una piattaforma completamente gestita e serverless che si può utilizzare per eseguire query su ADW, storage degli oggetti, cloud di terze parti e sistemi on-premise connessi in modo appropriato.