주:

- 이 자습서에서는 Oracle Cloud에 액세스해야 합니다. 무료 계정에 등록하려면 Oracle Cloud Infrastructure Free Tier 시작하기를 참조하십시오.

- Oracle Cloud Infrastructure 자격 증명, 테넌시 및 구획에 예제 값을 사용합니다. 실습을 완료했으면 이러한 값을 자신의 클라우드 환경과 관련된 값으로 대체하십시오.

OCI 스택을 사용하여 베어메탈 GPU 노드를 자체 관리 노드로 OKE로 이전

소개

이 사용지침서에서는 Oracle Cloud Infrastructure(OCI) 스택을 사용하여 베어메탈(BM) GPU 노드를 Oracle Cloud Infrastructure Kubernetes Engine(OKE) 자체 관리 노드로 마이그레이션하는 프로세스를 안내합니다.

먼저 자체 관리형 노드가 무엇인지, 그리고 OKE에서 GPU를 실행하는 데 이상적인 이유를 이해해 보겠습니다.

OKE 자체 관리 노드란?

이름에서 알 수 있듯이 자체 관리 노드는 고객이 완전히 제어하고 유지 관리합니다. 여기에는 프로비저닝, 확장, 구성, 업그레이드, OS(운영 체제) 패치 및 노드 교체와 같은 유지 관리 작업이 포함됩니다. 이 접근 방식은 더 많은 수동 관리가 필요하지만 최대의 유연성과 제어 기능을 제공하므로 GPU에서 실행되는 것과 같은 특수 워크로드에 적합합니다.

자체 관리 노드의 주요 기능:

-

전체 제어: 고객은 프로비저닝, OS 업데이트, 확장 및 종료를 포함하여 노드 수명 주기를 완벽하게 제어할 수 있습니다.

-

사용자 정의 구성: 고객은 사용자 정의 이미지를 사용하거나, 특정 소프트웨어를 설치하거나, 네트워킹을 구성하거나, 대체 인스턴스 유형을 사용할 수 있습니다.

-

수동 업그레이드: OKE 관리형 노드 풀과 달리 고객은 Kubernetes 버전, 보안 패치 및 OS 업데이트를 수동으로 업그레이드해야 합니다.

-

BYON(자체 노드 가져오기): 고객은 OKE 클러스터에서 기존 OCI 컴퓨트 인스턴스를 작업자 노드로 사용할 수 있습니다.

-

자동 노드 순환 없음: 노드가 실패하면 고객이 수동으로 노드를 바꾸거나 순환해야 합니다.

이 사용지침서에서는 BM A100 GPU 워크로드가 현재 OCI의 Slurm 클러스터에서 실행되고 있으며 이를 OKE 클러스터로 마이그레이션하는 것을 목표로 하는 사용 사례를 다룹니다. HPC(고성능 컴퓨팅) OKE 스택을 사용하여 빈 OKE 클러스터를 배치한 다음 기존 GPU 노드를 추가할 수 있습니다.

목표

- HPC OKE 스택을 사용하여 BM A100 GPU 노드를 자체 관리 노드로 OKE로 마이그레이션합니다.

필요 조건

-

실행 중인 OCI 테넌시 및 OKE 클러스터에 대한 관리자 액세스 권한입니다.

-

BM A100 노드에 NVIDIA Run:ai를 설치하여 애플리케이션을 컨테이너화합니다. 자세한 내용은 NVIDIA Run:ai를 참조하십시오.

-

OKE에서 RDMA(Remote Direct Memory Access) GPU 워크로드를 실행합니다. 자세한 내용은 OKE에서 RDMA(원격 직접 메모리 액세스) GPU 워크로드 실행을 참조하십시오.

작업 1: HPC OKE 스택을 사용하여 BM A100 GPU 노드를 OKE로 마이그레이션

-

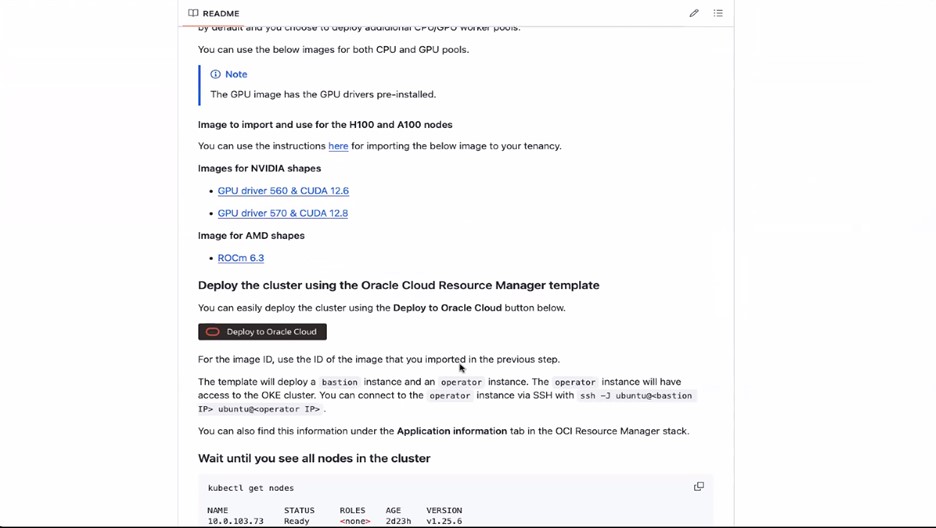

GitHub 페이지에서 언급한 대로 OCI 콘솔에 로그인하여 필요한 정책을 생성합니다. Running RDMA (remote direct memory access) GPU workloads on OKE

-

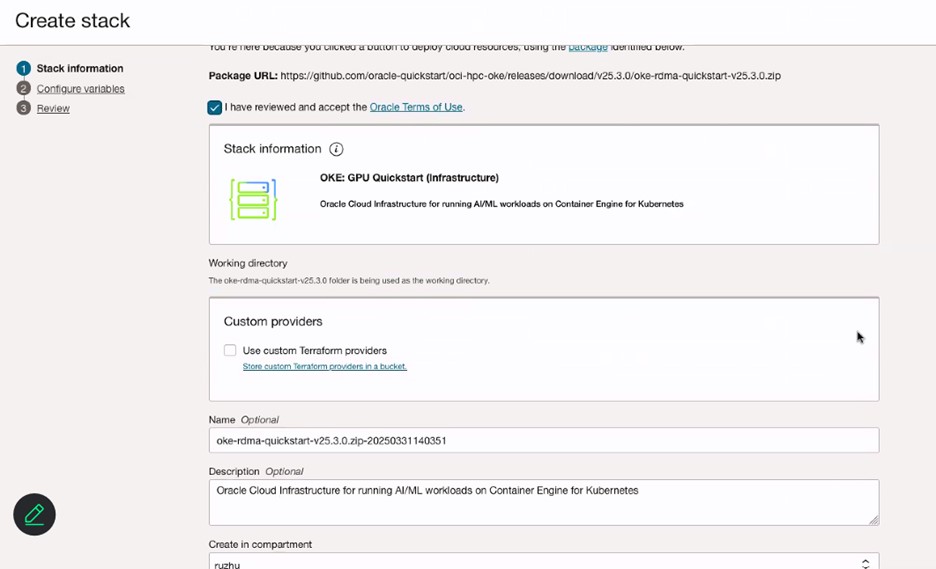

Oracle Cloud에 배치를 누르고 조항 및 조건을 검토합니다.

-

스택을 배치할 영역을 선택합니다.

-

스택 정보 페이지에서 스택에 대한 이름을 입력합니다.

-

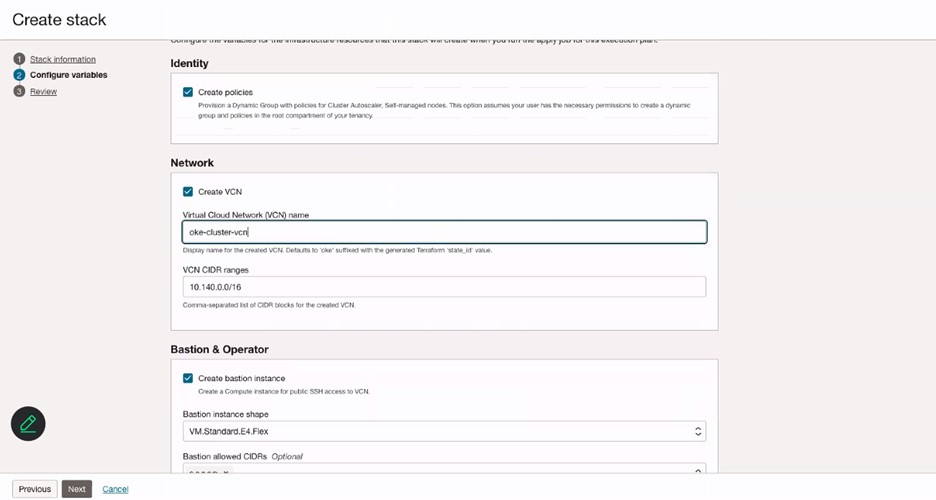

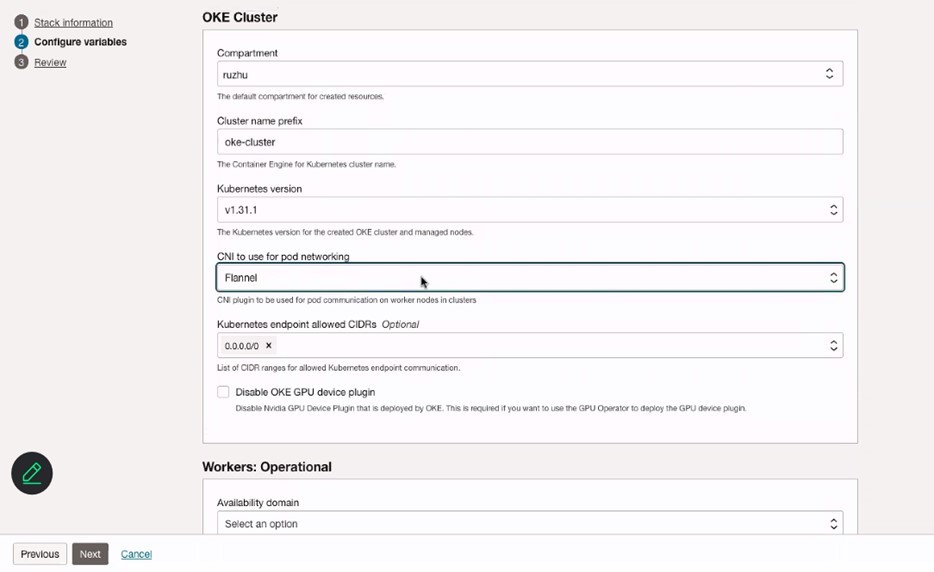

변수 구성 페이지에서 VCN에 대한 이름을 입력합니다.

-

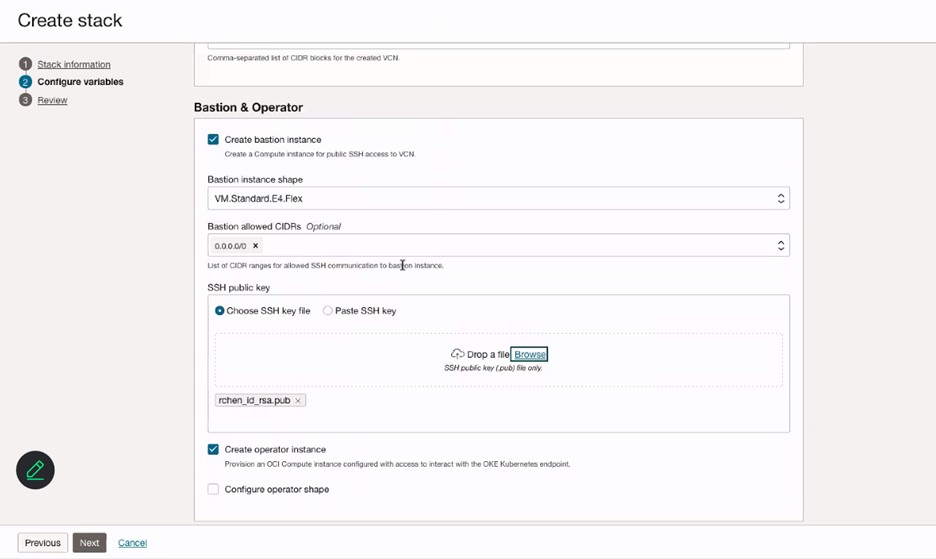

배스천 및 연산자 섹션에서 배스천 인스턴스의 정보를 입력하고 배스천 인스턴스에 대한 SSH 키를 추가합니다.

-

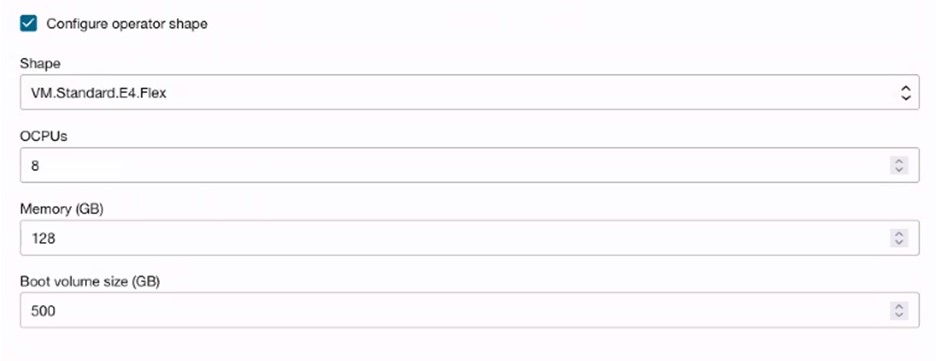

(선택 사항) 운영자 구성 구성을 선택하여 작업 모니터링 또는 실행을 위한 운영자 노드를 생성합니다.

-

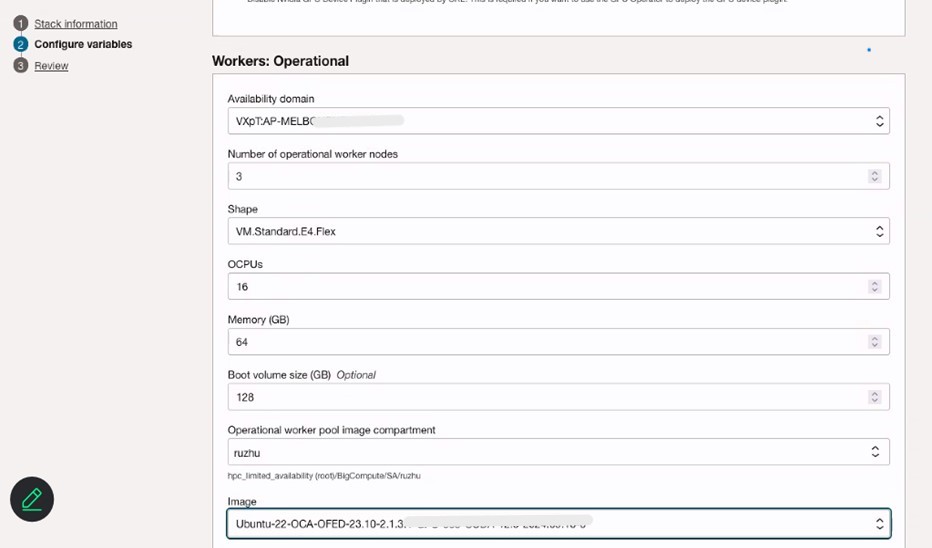

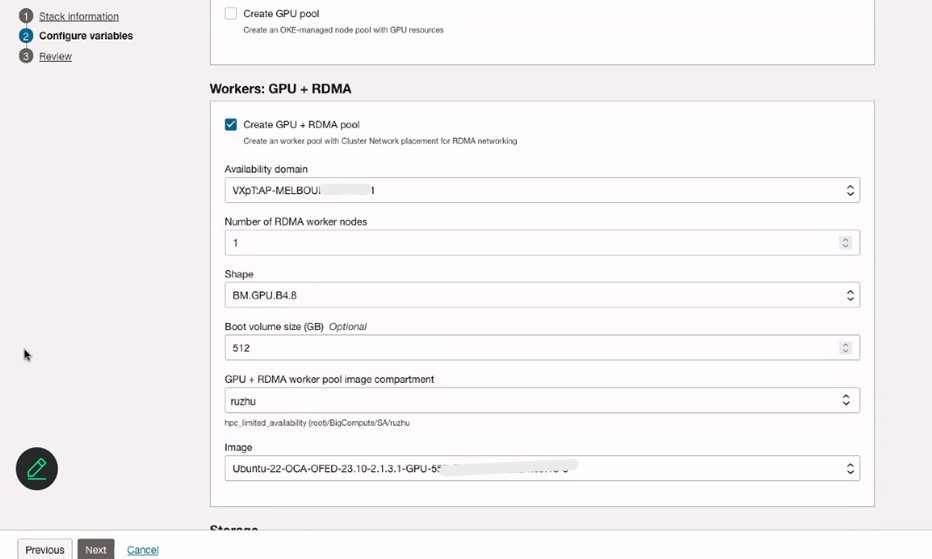

OKE Cluster, Workers: Operational 노드 및 Workers: GPU + RDMA 노드의 변수를 구성합니다. Pod 네트워킹에 사용할 플 채널 CNI를 선택해야 합니다.

-

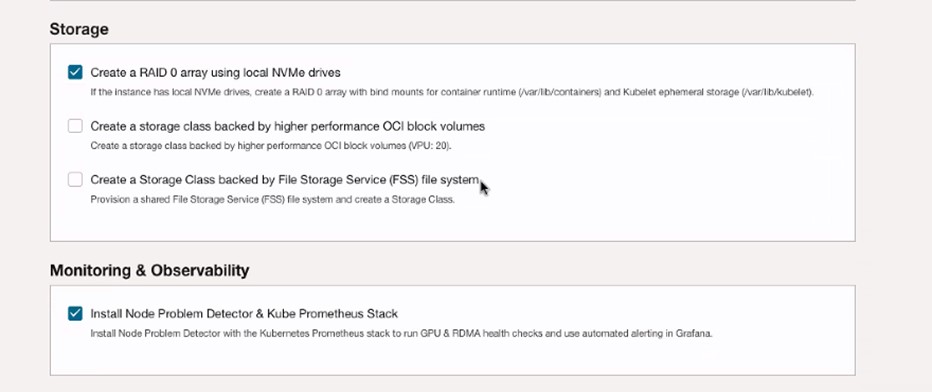

로컬 NVMe 드라이브를 사용하여 RAID 0 배열 만들기 및 Install Node Problem Detector & Kube Prometheus Stack을 선택합니다.

-

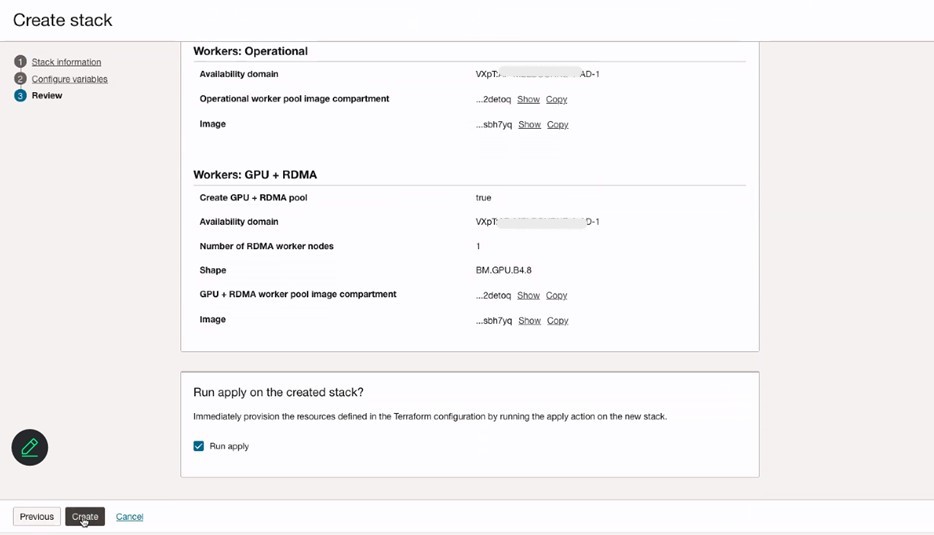

스택 정보를 검토하고 생성을 누릅니다.

-

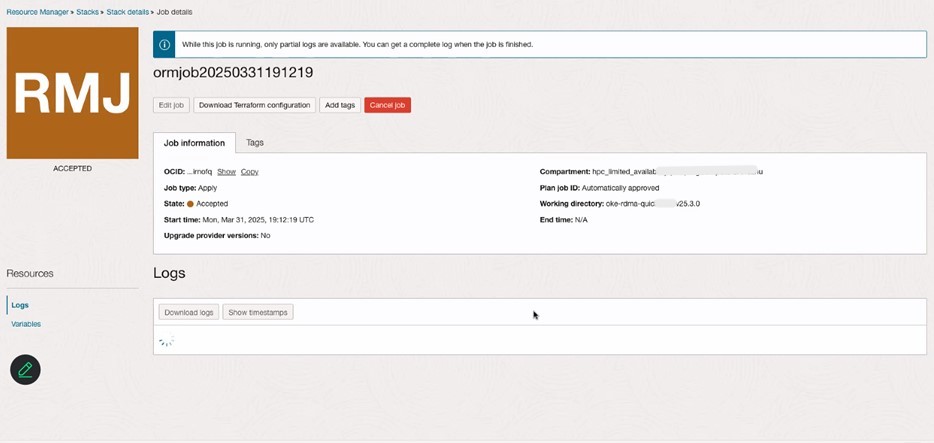

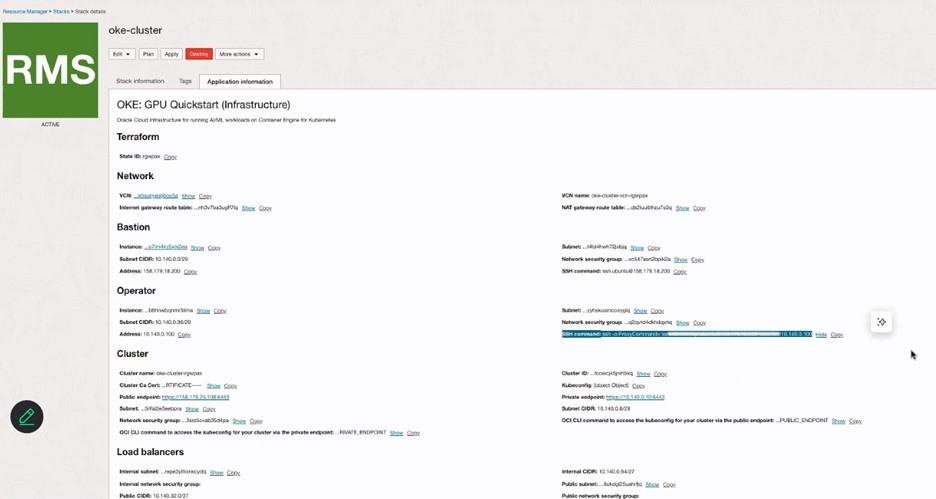

리소스 관리자의 스택 세부정보를 검토하고 OCI 콘솔의 Kubernetes 섹션에서 OKE 클러스터를 확인합니다.

-

OCI 콘솔을 통해 액세스 클러스터를 사용하여 OKE 클러스터에 로그인하고 계속해서 새 GPU 노드를 추가합니다.

-

여기에 언급된 모든 단계(Creating a Dynamic Group and a Policy for Self-Managed Nodes)를 따릅니다.

-

여기에 언급된 1단계 및 2단계를 따릅니다. 자체 관리 노드에 대한 Cloud-init 스크립트 생성.

-

다음 스크립트를 실행하여 GPU 노드를 OKE 클러스터에 추가합니다.

sudo rm archive_uri-https_objectstorage_ap-osaka-1_oraclecloud_com_p_ltn5w_61bxynnhz4j9g2drkdic3mwpn7vqce4gznmjwqqzdqjamehhuogyuld5ht_n_hpc_limited_availability_b_oke_node_repo_o_ubuntu-jammy.list sudo apt install -y oci-oke-node-all* sudo oke bootstrap --apiserver-host <API SERVER IP> --ca <CA CERT> --manage-gpu-services --crio-extra-args " -

다음 명령을 실행하여 노드가 OKE 클러스터에 성공적으로 추가되었는지 확인합니다.

kubectl get nodes

관련 링크

확인

- Authors - Ruzhu Chen(Master Principal Enterprise Cloud Architect), Payal Sharma(Senior Enterprise Cloud Architect)

추가 학습 자원

docs.oracle.com/learn에서 다른 실습을 탐색하거나 Oracle Learning YouTube 채널에서 더 많은 무료 학습 콘텐츠에 액세스하세요. 또한 Oracle Learning Explorer가 되려면 education.oracle.com/learning-explorer을 방문하십시오.

제품 설명서는 Oracle Help Center를 참조하십시오.

Migrate Bare Metal GPU Nodes to OKE as Self-Managed Nodes using an OCI Stack

G31990-01

Copyright ©2025, Oracle and/or its affiliates.