클라우드 기반 데이터 레이크에 대한 권장 패턴

사용 사례에 따라 데이터 레이크는 오브젝트 스토리지 또는 Hadoop에 구축될 수 있습니다. 이 둘 모두 기존 엔터프라이즈 데이터 및 툴과 원활하게 확장 및 통합될 수 있습니다. 조직의 녹색 필드 또는 마이그레이션 패턴을 고려합니다. 완전히 새로운 구현을 계획할지 아니면 기존 Big Data 솔루션을 Oracle Cloud로 마이그레이션할지에 따라 Greenfield 또는 마이그레이션 패턴을 선택하십시오.

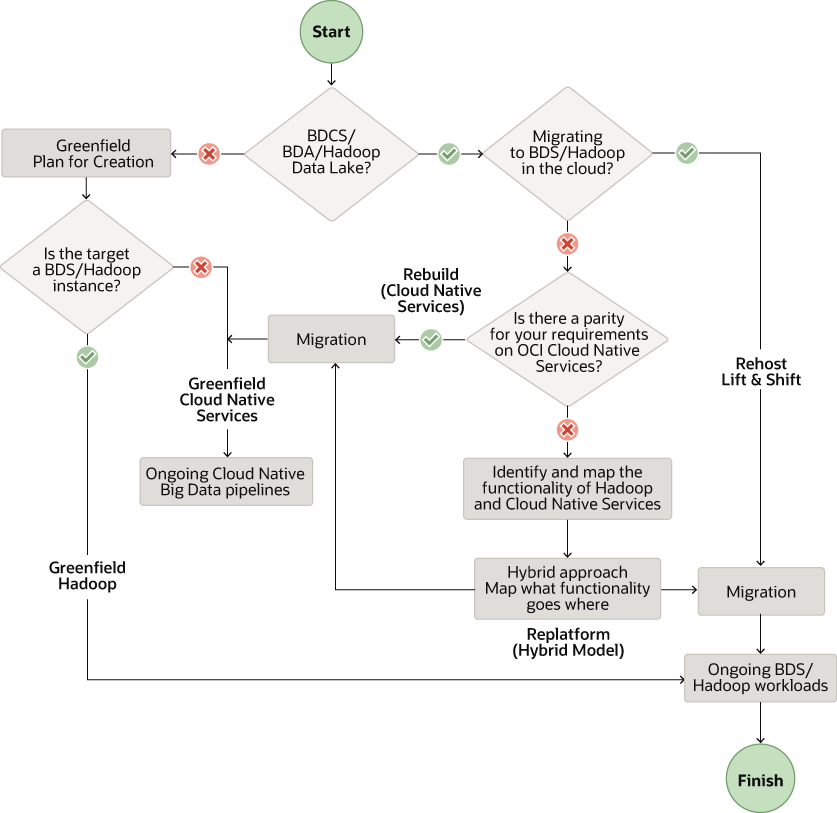

다음 워크플로우에서는 요구 사항에 따라 권장되는 패턴을 보여줍니다.

그림 data-lake-solution-pattern.png에 대한 설명

참고:

이 문서에서는 CDH(Cloudera Distribution of Hadoop)를 기반으로 하는 Big Data Appliance(BDA) 및 Big Data Cloud Services(BDCS) 클러스터를 OCI로 마이그레이션하는 데 중점을 둡니다. 하지만 여기에 나와 있는 권장 사항은 다른 온프레미스 및 클라우드 Hadoop 배포판에 적용할 수 있습니다.

Oracle Cloud에서 새 데이터 플랫폼 구축(Greenfield)

Greenfield 프로젝트에 대해 Oracle Cloud에서 데이터 레이크를 구축하는 두 가지 옵션을 사용할 수 있습니다. HDFS 기반 데이터 레이크는 빅데이터 서비스(BDS)를 사용합니다. HDFS를 사용하지 않고 오브젝트 스토리지 기반 데이터 레이크에 OCI 클라우드 네이티브 데이터 서비스를 사용할 수 있습니다.

클라우드 네이티브 데이터 서비스

OCI Object Storage에서 데이터 레이크를 구축하고 클라우드 네이티브 데이터 및 AI 서비스를 사용합니다. 이러한 서비스에는 데이터 플로우, 데이터 통합, Autonomous Data Warehouse, 데이터 카탈로그 및 데이터 과학이 몇 가지 다른 서비스와 함께 포함됩니다.

Oracle은 다음 서비스를 통해 새로운 데이터 레이크를 구축할 것을 권장합니다.

- 모든 원시 데이터를 위한 데이터 레이크 스토어(Object Storage)로

- Spark 일괄 처리 프로세스 및 임시 Spark 클러스터용 데이터 플로우 서비스

- 데이터 수집 및 ETL 작업에 대한 데이터 통합 서비스

- 계층 데이터 서비스 및 제공을 위한 ADW(Autonomous Data Warehouse)

- 데이터 검색 및 거버넌스를 위한 데이터 카탈로그

Oracle은 새 데이터 레이크를 구축하기 위해 다음과 같은 추가 서비스를 권장합니다.

- 실시간 데이터 관리를 위한 스트리밍 서비스

- 일회성 대량 데이터 전송을 위한 DTA(Data Transfer Appliance) 서비스

- CDC(Change Data Capture) 데이터 및 스트리밍 애널리틱스를 위한 GoldenGate 서비스

- 머신 러닝 요구사항을 위한 데이터 과학 서비스

- BI, 분석 및 보고 요구사항을 위한 Oracle Analytics Cloud(OAC) 서비스

Big Data Service

Oracle Big Data Service(BDS)를 사용하여 HDFS에서 데이터 레이크를 구축합니다. BDS는 HDFS, Hive, HBase, Spark, Oozie를 비롯한 가장 일반적으로 사용되는 Hadoop 구성요소를 제공합니다.

Oracle은 다음 서비스를 통해 Hadoop 클러스터를 사용하여 새 데이터 레이크를 구축할 것을 권장합니다.

- 데이터 수집 및 ETL 작업에 대한 데이터 통합 서비스

- 일회성 대량 데이터 전송을 위한 DTA(Data Transfer Appliance) 서비스

- CDC 데이터 및 스트리밍 분석을 위한 GoldenGate 서비스

- 데이터 검색 및 거버넌스를 위한 데이터 카탈로그 서비스

- 머신 러닝 요구사항을 위한 데이터 과학 서비스

- BI, 분석 및 보고 요구사항을 위한 OAC 서비스

- HDFS 및 기타 Hadoop 구성요소용 BDS

그린필드 패턴 워크플로우

새로운 데이터 레이크를 구축하는 경우 요구 사항에서 테스트 및 검증까지 이 워크플로우를 따르십시오.

- 요구 사항: OCI의 새 환경에 대한 요구 사항 나열

- 평가: 필요한 OCI 서비스 및 툴 평가

- 설계: OCI에 대한 솔루션 아키텍처 및 크기 조정 설계

- 계획: 시간과 자원을 매핑하는 상세한 계획 생성

- 프로비저닝: OCI에서 필요한 리소스를 프로비전하고 구성합니다.

- 구현: 데이터 및 애플리케이션 작업 로드 구현

- 파이프라인 자동화: 자동화를 위한 워크플로우 파이프라인을 통합관리 및 스케줄링합니다.

- 테스트 및 검증: 엔드 투 엔드 솔루션에 대한 검증, 기능 및 성능 테스트를 수행합니다.

Oracle Cloud에서 기존 데이터 플랫폼 마이그레이션

재구성 패턴

Hadoop 클러스터를 사용하지 않고 OCI(Oracle Cloud Infrastructure)의 클라우드 네이티브 서비스로 마이그레이션하려는 경우 재구축 패턴을 사용합니다. 먼저 건축가에게 명확한 작은 것부터 시작하여 OCI에 처음부터 구현을 시작하십시오. 스택의 모든 주요 구성요소에 대해 관리되는 클라우드 네이티브 서비스를 활용할 수 있습니다. 예를 들어 데이터 플로우, 데이터 카탈로그, 데이터 통합, 스트리밍, 데이터 과학, ADW 및 OAC를 사용하여 스택을 구축합니다.

Oracle은 다음 서비스를 통해 Hadoop 클러스터 없이 클라우드 기반 데이터 레이크로 마이그레이션할 것을 권장합니다.

- 모든 원시 데이터를 위한 데이터 레이크 저장소로 사용되는 오브젝트 스토리지 서비스

참고:

HDFS 커넥터가 있는 오브젝트 스토리지를 Hadoop 또는 Spark 클러스터 내에서 HDFS 대신 HDFS 저장소로 사용할 수 있습니다. - 데이터 수집 및 ETL 작업에 대한 데이터 통합 서비스

- 실시간 데이터 관리를 위한 스트리밍 서비스로, 자율 관리형 Kafka 또는 Flume 서비스를 대체할 수 있습니다.

- 일회성 대량 데이터 전송을 위한 데이터 전송 어플라이언스

- GoldenGate - CDC 데이터 및 스트리밍 애널리틱스용

- Spark 일괄 처리 프로세스 및 임시 Spark 클러스터용 데이터 플로우 서비스

- ADW - 프레젠테이션 계층 데이터 제공

- 데이터 검색 및 거버넌스를 위한 데이터 카탈로그 서비스

- 머신 러닝 요구사항을 위한 데이터 과학 서비스

- BI, 분석 및 보고 요구사항을 위한 OAC 서비스

재구성 패턴

클라우드에서 Hadoop 클러스터를 사용하고 일부 구성요소를 클라우드 네이티브 서비스로 교체하려는 경우 리플랫폼 마이그레이션 패턴을 사용합니다. HDFS 및 기타 Hadoop 구성요소에는 빅데이터 서비스를 사용하고, 오라클의 추가 관리 클라우드 네이티브 서비스를 사용하여 스택의 일부를 재설계할 수 있습니다.

리플랫폼 패턴을 사용하도록 스택을 다시 설계해야 할 수도 있습니다.

- OCI에서 BDS와 함께 서버리스 클라우드 네이티브 서비스 포함

- 가능한 경우 관리되는 클라우드 네이티브 서비스 활용

필요에 따라 이러한 구성 요소 중 일부를 교체할 수 있습니다.

- HDFS 및 Hive, HBase, Kafka, Oozie와 같은 기타 Hadoop 구성요소용 BDS

- 데이터 수집 및 ETL 작업에 대한 데이터 통합 서비스

- 일회성 대량 데이터 전송을 위한 데이터 전송 어플라이언스 서비스

- CDC 데이터 및 스트리밍 분석을 위한 GoldenGate 서비스

- 데이터 검색 및 거버넌스를 위한 데이터 카탈로그 서비스

- 머신 러닝 요구사항을 위한 데이터 과학 서비스

- BI, 분석 및 보고 요구사항을 위한 OAC 서비스

재호스트 패턴

빅 데이터 서비스(BDS)를 사용하여 BDA, BDCS 및 기타 Hadoop 클러스터를 마이그레이션하여 HDFS에서 데이터 레이크를 구축하십시오. 호스트 재지정 패턴을 사용하는 경우 리프트 및 시프트 방식을 사용할 수 있습니다. HDFS, Hive, HBase, Spark 및 Oozie를 비롯한 일반적으로 사용되는 모든 Hadoop 구성요소는 BDS에서 제공하는 관리형 Hadoop 클러스터에서 사용할 수 있습니다.

마이그레이션 패턴 워크플로우

데이터 레이크를 Oracle Cloud로 마이그레이션하는 경우 요구 사항부터 새 환경까지 이 워크플로우를 따릅니다.

- 검색 및 요구사항: 새 OCI 환경에 대한 요구사항을 나열하는 현재 시스템을 검색하고 카탈로그화합니다.

- 평가: 필요한 OCI 서비스 및 툴 평가

- 설계: OCI에 대한 솔루션 아키텍처 및 크기 조정 설계

- 계획: 시간과 자원을 매핑하는 상세한 계획 생성

- 프로비저닝: OCI에서 필요한 리소스를 프로비전하고 구성합니다.

- 데이터 이전: 데이터 및 메타데이터를 선택한 OCI 서비스 데이터 저장소로 전송합니다.

- 작업 로드 이전: 선택한 이전 패턴을 사용하여 작업 로드 및 응용 프로그램을 OCI 서비스로 이전

- 파이프라인 자동화: 자동화를 위한 워크플로우 파이프라인을 통합관리 및 스케줄링합니다.

- 테스트 및 검증: 최종 OCI 환경에 대한 기능 및 성능 테스트와 검증을 계획합니다.

- 잘라내기: 소스 환경을 해제하고 새 OCI 기반 환경만 사용하도록 잘라냅니다.