스트리밍 사기 감지에 대해 알아보기

이 솔루션 플레이북에서는 NVIDIA Morpheus 사이버 보안 프레임워크를 사용하여 GPU 가속 Morpheus 파이프라인을 사용하여 실시간 AI 기반 사기 탐지를 배포하고 Compute Cloud@Customer를 사용하여 결과를 게시하는 방법을 알아봅니다. 이 솔루션은 배치 작업을 기다리지 않고 즉각적인 사기 감지가 가능하며 로컬에서 에지에서 처리하여 데이터를 안전하게 보호합니다.

시작하기 전에

- 운영 체제: Ubuntu 24.04 LTS

- 플랫폼: NVIDIA L40S GPU가 장착된 단일 노드 Oracle Compute Cloud@Customer 인스턴스의 NVIDIA AI Enterprise.

시작하기 전에 호스트 시스템에 다음 도구가 설치되어 있는지 확인합니다.

- Docker 및 Docker 작성(

docker compose V2) - Git 및 Git LFS(

git-lfs) - Python 3 및

Pip

워크플로우

이 워크플로는 NVIDIA Morpheus 사이버 보안 프레임워크를 활용하여 금융 거래 데이터 스트림에 대한 GPU 가속 추론을 수행합니다.

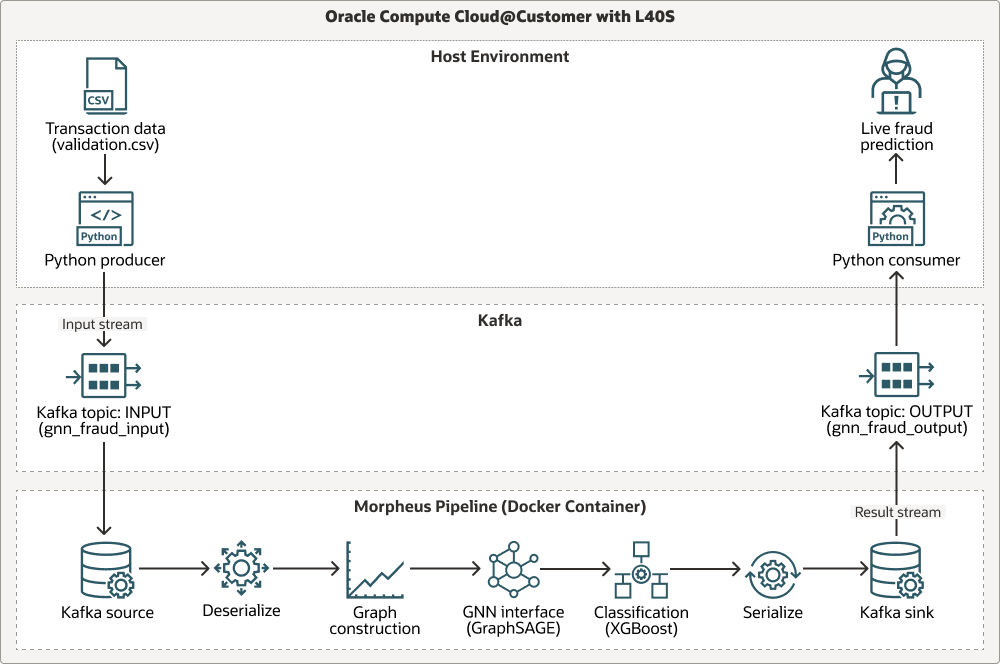

다음 다이어그램은 호스트 환경, Apache Kafka 및 Morpheus 파이프라인의 세 가지 스윔레인을 통한 워크플로우를 보여줍니다.

이 파이프라인은 Apache Kafka를 통해 실시간 트랜잭션 데이터를 수집하고, 사전 학습된 그래프 샘플 및 집계(GraphSAGE) 모델을 사용하여 그래프 기반 컨텍스트 분석을 수행하고, XGBoost를 사용하여 최종 사기 분류를 실행합니다. 모든 단계는 NVIDIA RAPIDS 라이브러리(cuDF, cuML)를 사용하여 가속화되므로 전체 워크플로 GPU가 높은 처리량을 위해 최적화됩니다. 다음은 프로세스가 진행되는 방법입니다.

Transaction data (.csv)는 Python 제작자가 제작합니다.- 데이터는 Kafka 토픽

INPUT스트림으로 이동합니다. - 데이터는 Kafka 소스에서 읽기, 역직렬화, 그래프 생성, GNN(Graph Neural Network) 인터페이스(

GraphSAGE),XGBoost로 분류, 결과 직렬화 및 Kafka 싱크에 쓰기 등의 단계에서 Morpheus 파이프라인을 통해 처리됩니다. - 결과는 Kafka 토픽

OUTPUT스트림으로 전송됩니다. - Python 소비자는 결과를 수신하고 실시간 사기 예측을 제공합니다.

모델 출처

이 아키텍처의 핵심에 있는 추론 파이프라인은 두 가지 사전 학습 머신 러닝 모델(GraphSAGE GNN 및 XGBoost 분류기)을 사용합니다. 이러한 모델은 참조를 위해 Morpheus 저장소에 포함된 별도의 교육 파이프라인을 사용하여 생성되었습니다.

- 교육 스크립트 위치:

examples/gnn_fraud_detection_pipeline/training.py. - 프로세스: 스크립트는 레이블이 있는 과거 데이터 세트를 처리하여 그래프 기반 기능 및 결과 임베딩의

XGBoost모델에 대해 GNN을 교육합니다.

이 솔루션에서는 사전 학습된 모델이 이미 제공되어 있으므로 교육 스크립트를 실행할 필요가 없습니다. 실시간 추론 파이프라인의 배포 및 실행에 중점을 둡니다.

이 아키텍처는 다음 구성 요소를 지원합니다.

- Oracle Compute Cloud@Customer

Oracle Compute Cloud@Customer는 어디서나 OCI Compute를 사용할 수 있는 완전 관리형 랙 스케일 인프라입니다. Compute Cloud@Customer에서 스토리지 및 네트워킹 서비스와 함께 OCI Compute 및 GPU 구성을 실행하여 데이터 센터에서 클라우드 자동화 및 경제성의 이점을 얻을 수 있습니다. 데이터 센터의 클라우드 인프라에서 애플리케이션을 실행하고 GenAI의 기능을 활용하는 동시에 로컬 리소스 및 실시간 운영에 대한 데이터 레지던시, 보안 및 짧은 대기 시간 연결을 해결할 수 있습니다.

- RAPIDS cuDF/cuML

RAPIDS cuDF/cuML는 Morpheus 파이프라인 내에서 고성능 데이터 조작 및 머신 러닝 유틸리티를 위한 GPU 가속 라이브러리 제품군입니다.

- Docker + 콘다

Docker + Conda는 OS 레벨 격리를 위해 Docker를 사용하고 컨테이너 내부의 복잡한 Python 환경을 관리하기 위해 Conda를 사용하여 종속성 관리에 대한 계층화된 접근 방식을 제공합니다.

생산에 대한 고려 사항

프로덕션 환경에서 이 솔루션을 구현할 때는 Kubernetes가 제공할 수 있는 확장성과 복원성을 고려해 보십시오. 다음 방법으로 이 솔루션을 OCI Kubernetes Engine(OKE)으로 마이그레이션할 수 있습니다.

- 생산자 및 소비자 도우미 스크립트 컨테이너화

- 프로덕션급 Kubernetes 연산자를 사용하여 Kafka를 배포합니다.

- Morpheus 파이프라인을 Kubernetes 작업 또는 배치로 배치합니다.

필수 서비스 및 역할 정보

이 솔루션에는 다음 서비스 및 역할이 필요합니다.

- Oracle Compute Cloud@Customer

- NVIDIA AI 엔터프라이즈 6.0

-

Ubuntu Linux(또는 호환되는 Linux 배포판)

- 도커

- 엔비디아 모르페우스 25.02

각 서비스에 필요한 역할입니다.

| 서비스 이름: 역할 | 필수 항목... |

|---|---|

Oracle Compute Cloud@Customer: administrator |

NVIDIA AI Enterprise 가상 머신 인스턴스를 구성 및 배포하고, 네트워크 리소스를 관리하고, NVIDIA L40S GPU에 대한 액세스를 보장합니다. |

Ubuntu Linux: root 또는 sudo 권한을 가진 사용자

|

필요 조건 소프트웨어(Docker, Git)를 설치하고, 시스템 서비스를 관리하고, Docker 명령을 실행합니다. |

| NVIDIA AI Enterprise: 계정 사용자 | NVIDIA GPU Cloud(NGC) 카탈로그에서 필요한 NVIDIA Morpheus 컨테이너 이미지를 가져옵니다. |

필요한 정보를 얻으려면 Oracle 제품, 솔루션 및 서비스를 참조하십시오.