Replicar dados entre bancos de dados na nuvem na mesma região

Saiba como configurar o Oracle Cloud Infrastructure GoldenGate para replicar dados entre dois Autonomous AI Databases.

Visão geral

O Oracle Cloud Infrastructure GoldenGate permite que você replique bancos de dados suportados, na mesma região. As etapas a seguir orientam você sobre como instanciar um banco de dados de destino usando o Oracle Data Pump e replicar dados da origem para o destino.

Esse início rápido também está disponível como LiveLab: Veja o workshop.

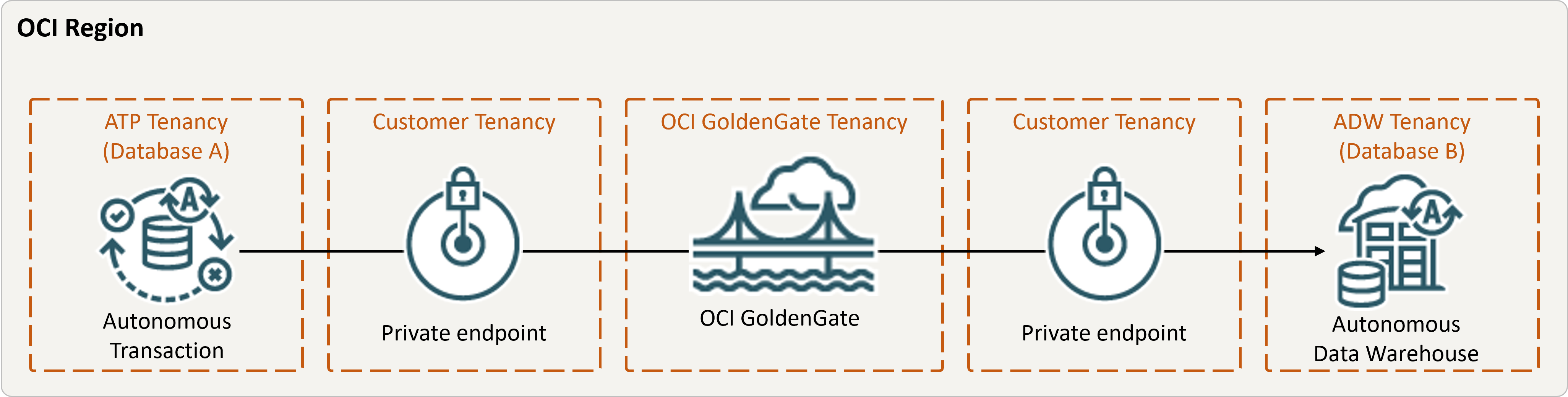

Descrição da ilustração equal-region.png

Antes de começar

Para continuar, você deve ter o seguinte:

- Um banco de dados de origem existente

- Um banco de dados de destino existente

- O banco de dados de origem e de destino deve estar em uma única tenancy, na mesma região

- Se precisar de dados de amostra, faça download de Archive.zip e siga as instruções em Lab 1, Tarefa 3: Carregar o esquema ATP

Tarefa 2: Criar o Extract Integrado

Um Extract Integrado captura alterações contínuas no banco de dados de origem.

Tarefa 3: Exportar dados usando o Oracle Data Pump (ExpDP)

Use o Oracle Data Pump (ExpDP) para exportar dados do banco de dados de origem para o Oracle Object Store.

Tarefa 4: Instanciar o banco de dados de destino usando o Oracle Data Pump (ImpDP)

Use o Oracle Data Pump (ImpDP) para importar dados para o banco de dados de destino do SRC_OCIGGLL.dmp que foi exportado do banco de dados de origem.