Observação:

- Este tutorial requer acesso ao Oracle Cloud. Para se inscrever em uma conta gratuita, consulte Conceitos Básicos do Oracle Cloud Infrastructure Free Tier.

- Ele usa valores de exemplo para credenciais, tenancy e compartimentos do Oracle Cloud Infrastructure. Ao concluir seu laboratório, substitua esses valores por valores específicos do seu ambiente de nuvem.

Configurar um Failover de IP Virtual do Linux no Oracle Cloud Infrastructure gerenciado pelo Pacemaker

Introdução

Em muitos ambientes, ainda é essencial usar infraestruturas com um cluster Linux ativo ou passivo, que exigem o uso de IPs flutuantes. Na infraestrutura de nuvem, o endereço IP secundário deve ser gerenciado não apenas pelo sistema operacional, mas também pela infraestrutura de nuvem.

Neste tutorial, veremos como o IP flutuante de um cluster Linux pode ser gerenciado como um recurso integrado pelo Pacemaker, de maneira simples e sem código personalizado. Para obter mais informações, consulte Tarefa 3: Configurar o Cluster Samba e Failover Automático de IP Virtual no Oracle Cloud Infrastructure.

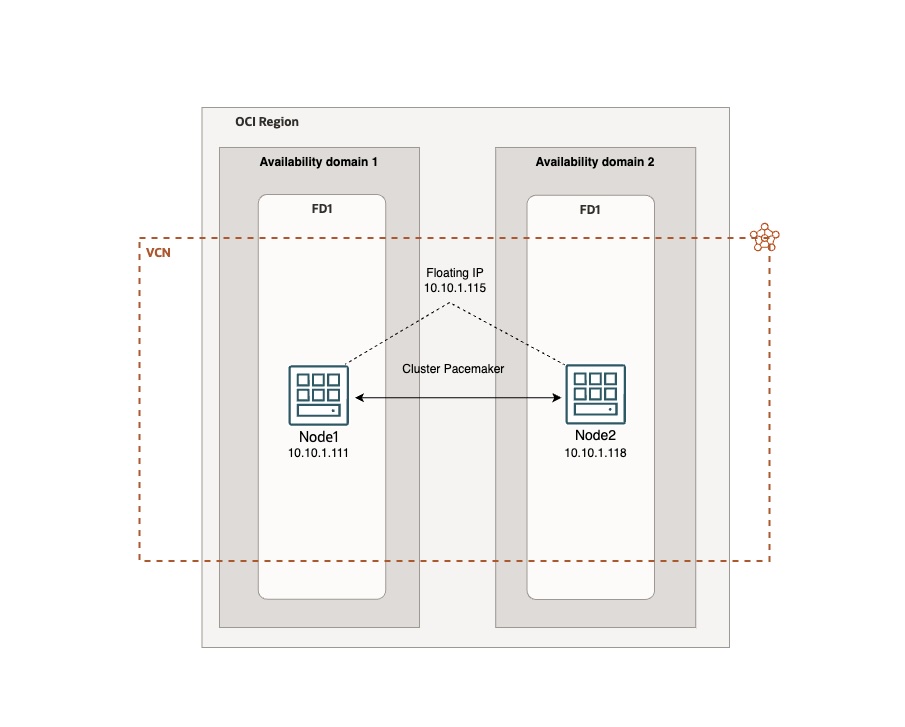

Design de Arquitetura

Objetivos

- Implante um cluster Linux Ubuntu ativo ou passivo confiável em alta disponibilidade (HA) com o IP flutuante da Oracle Cloud Infrastructure (OCI) gerenciado diretamente pelo Pacemaker.

Pré-requisitos

-

Acesso a uma tenancy do OCI.

-

Duas instâncias do OCI Compute com imagem do Linux instalada (Ubuntu).

-

Instalar a Interface de Linha de Comando (CLI) do OCI. Para obter mais informações, consulte Instalando a CLI.

-

Instale o

jq. -

Endereço IP privado secundário nas instâncias de computação configuradas em node1. Para obter mais informações, consulte Designando um Novo IP Privado Secundário a uma VNIC.

-

Grupo dinâmico do OCI com uma política anexada. Para obter mais informações, consulte Gerenciando Grupos Dinâmicos. A política deve incluir a seguinte instrução:

allow dynamic-group <GROUP_NAME> to use virtual-network-family in compartment id <COMPARTMENT_ID>. -

Recurso

OCIVIPadicional para Pacemaker. Para obter mais informações, consulte agente de recurso ocivip em GitHub.

Tarefa 1: Configurar Ambiente

-

Inicie duas instâncias de computação, selecione o Ubuntu 22 como o sistema operacional de cada instância.

-

Designe um endereço IP privado secundário à VNIC (Placa de Interface de Rede Virtual) para node1. Para obter mais informações, consulte Designando um Novo IP Privado Secundário a uma VNIC. Este será o IP flutuante. Por exemplo:

10.10.1.115. -

Criar um grupo dinâmico.

-

Faça log-in na console do OCI, navegue até Identidade e Segurança, Grupos Dinâmicos e clique em Criar Grupo Dinâmico.

-

Digite as seguintes informações.

- Nome: Informe

OCIVIP. -

Adicione a regra a seguir para incluir instâncias no compartimento especificado.

All {instance.compartment.id = 'Your compartment OCI ID'}

- Nome: Informe

-

-

Adicione uma política ao grupo dinâmico.

-

Navegue até Identidade e Segurança, Políticas e clique em Criar Política.

-

Digite as seguintes informações.

-

Nome: Informe

OCIVIP_policy. -

Adicione a seguinte instrução para permitir que o grupo dinâmico use a família de rede virtual:

allow dynamic-group OracleIdentityCloudService/OCIVIP to use virtual-network-family in compartment id 'Your compartment OCI ID'

-

-

Tarefa 2: Configurar o Cluster e o IP Flutuante

Depois que o ambiente for configurado, poderemos continuar configurando o Pacemaker e integrando o agente de recursos OCIVIP. Conecte-se às instâncias usando SSH e execute as operações de instalação do cluster nos dois nós até a etapa 10, inclusive.

-

Atualize o Sistema Operacional.

sudo apt update sudo apt upgrade -

Instalar a CLI do OCI e verificar sua funcionalidade.

bash -c "$(curl -L https://raw.githubusercontent.com/oracle/oci-cli/master/scripts/install/install.sh)"Configurar a CLI do OCI.

oci setup configVerifique a instalação da CLI do OCI.

oci os ns get -

Para um ambiente de teste, você pode remover a regra reject na linha 6 na seção INPUT do iptables e, em seguida, torná-la persistente para permitir a comunicação da instância. Lembre-se de configurar o iptables de forma segura e apropriada nos ambientes de produção.

sudo iptables -D INPUT 6 sudo su sudo iptables-save > /etc/iptables/rules.v4 sudo ip6tables-save > /etc/iptables/rules.v6 -

Atualize o arquivo

/etc/hostscom os endereços IP privados designados às suas duas instâncias: node1 e node2.Execute o comando a seguir para editar o arquivo.

sudo nano /etc/hostsAdicione seus nomes de nó e endereços IP.

10.10.1.111 node1 10.10.1.118 node2 -

Instale os pacotes relacionados ao cluster, incluindo jq.

sudo apt install -y pacemaker corosync pcs jq -

Faça backup do arquivo

corosync.conf.sudo cp /etc/corosync/corosync.conf /etc/corosync/corosync.conf.bkEdite o arquivo

corosync.conf.sudo nano /etc/corosync/corosync.confCopie o conteúdo a seguir para o arquivo

corosync.conf.# Please read the corosync.conf.5 manual page system { # This is required to use transport=knet in an unprivileged # environment, such as a container. See man page for details. allow_knet_handle_fallback: yes } totem { version: 2 # Corosync itself works without a cluster name, but DLM needs one. # The cluster name is also written into the VG metadata of newly # created shared LVM volume groups, if lvmlockd uses DLM locking. cluster_name: ha_cluster transport: udpu secauth: off # crypto_cipher and crypto_hash: Used for mutual node authentication. # If you choose to enable this, then do remember to create a shared # secret with "corosync-keygen". # enabling crypto_cipher, requires also enabling of crypto_hash. # crypto works only with knet transport crypto_cipher: none crypto_hash: none } logging { # Log the source file and line where messages are being # generated. When in doubt, leave off. Potentially useful for # debugging. fileline: off # Log to standard error. When in doubt, set to yes. Useful when # running in the foreground (when invoking "corosync -f") to_stderr: yes # Log to a log file. When set to "no", the "logfile" option # must not be set. to_logfile: yes logfile: /var/log/corosync/corosync.log # Log to the system log daemon. When in doubt, set to yes. to_syslog: yes # Log debug messages (very verbose). When in doubt, leave off. debug: off # Log messages with time stamps. When in doubt, set to hires (or on) #timestamp: hires logger_subsys { subsys: QUORUM debug: off } } quorum { # Enable and configure quorum subsystem (default: off) # see also corosync.conf.5 and votequorum.5 provider: corosync_votequorum two_node: 1 wait_for_all: 1 last_man_standing: 1 auto_tie_breaker: 0 } nodelist { # Change/uncomment/add node sections to match cluster configuration node { # Hostname of the node. # name: node1 # Cluster membership node identifier nodeid: 101 # Address of first link ring0_addr: node1 # When knet transport is used it's possible to define up to 8 links #ring1_addr: 192.168.1.1 } # ... node { ring0_addr: node2 nodeid: 102 } } -

Adicione o recurso que o Pacemaker usará para gerenciar o IP flutuante do OCI nativamente no diretório

/usr/lib/ocf/resource.d/heartbeat/. Faça download do conteúdo do arquivo aqui: ocivip.txt.Observação: Este recurso não é desenvolvido pela Oracle, mas por desenvolvedores terceirizados.

Este é o conteúdo do arquivo

ocivip.#!/bin/sh # # # Manage Secondary Private IP in Oracle Cloud Infrastructure with Pacemaker # # # Copyright 2016-2018 Lorenzo Garuti <garuti.lorenzo@gmail.com> # # Licensed under the Apache License, Version 2.0 (the "License"); # you may not use this file except in compliance with the License. # You may obtain a copy of the License at # # http://www.apache.org/licenses/LICENSE-2.0 # # Unless required by applicable law or agreed to in writing, software # distributed under the License is distributed on an "AS IS" BASIS, # WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied. # See the License for the specific language governing permissions and # limitations under the License. # # # # Prerequisites: # # - OCI CLI installed (https://docs.oracle.com/en-us/iaas/Content/API/SDKDocs/climanualinst.htm) # - jq installed # - dynamic group with a policy attached # - the policy must have this statement: # allow dynamic-group <GROUP_NAME> to use virtual-network-family in compartment id <COMPARTMENT_ID> # - a reserved secondary private IP address for Compute Instances high availability # ####################################################################### # Initialization: : ${OCF_FUNCTIONS_DIR=${OCF_ROOT}/lib/heartbeat} . ${OCF_FUNCTIONS_DIR}/ocf-shellfuncs ####################################################################### # # Defaults # OCF_RESKEY_ocicli_default="/usr/local/bin/oci" OCF_RESKEY_api_delay_default="3" OCF_RESKEY_cidr_netmask_default="24" OCF_RESKEY_interface_alias_default="0" export OCI_CLI_AUTH=instance_principal : ${OCF_RESKEY_ocicli=${OCF_RESKEY_ocicli_default}} : ${OCF_RESKEY_api_delay=${OCF_RESKEY_api_delay_default}} : ${OCF_RESKEY_cidr_netmask=${OCF_RESKEY_cidr_netmask_default}} : ${OCF_RESKEY_interface_alias=${OCF_RESKEY_interface_alias_default}} meta_data() { cat <<END <?xml version="1.0"?> <!DOCTYPE resource-agent SYSTEM "ra-api-1.dtd"> <resource-agent name="ocivip"> <version>1.0</version> <longdesc lang="en"> Resource Agent for OCI Compute instance Secondary Private IP Addresses. It manages OCI Secondary Private IP Addresses for Compute instances with oci cli. See https://docs.oracle.com/en-us/iaas/Content/API/Concepts/cliconcepts.htm for more information about oci cli. Prerequisites: - OCI CLI installed (https://docs.oracle.com/en-us/iaas/Content/API/SDKDocs/climanualinst.htm) - jq installed - dynamic group with a policy attached - the policy must have this statement: allow dynamic-group GROUP_NAME to use virtual-network-family in compartment id COMPARTMENT_ID - a reserved secondary private IP address for Compute Instances high availability </longdesc> <shortdesc lang="en">OCI Secondary Private IP Address for Compute instances Resource Agent</shortdesc> <parameters> <parameter name="ocicli" unique="0"> <longdesc lang="en"> OCI Command line interface (CLI) tools </longdesc> <shortdesc lang="en">OCI cli tools</shortdesc> <content type="string" default="${OCF_RESKEY_ocicli_default}" /> </parameter> <parameter name="secondary_private_ip" unique="1" required="1"> <longdesc lang="en"> reserved secondary private ip for compute instance </longdesc> <shortdesc lang="en">reserved secondary private ip for compute instance</shortdesc> <content type="string" default="" /> </parameter> <parameter name="cidr_netmask" unique="0"> <longdesc lang="en"> netmask for the secondary_private_ip </longdesc> <shortdesc lang="en">netmask for the secondary_private_ip</shortdesc> <content type="integer" default="${OCF_RESKEY_cidr_netmask_default}" /> </parameter> <parameter name="interface_alias" unique="0"> <longdesc lang="en"> numeric alias for the interface </longdesc> <shortdesc lang="en">numeric alias for the interface</shortdesc> <content type="integer" default="${OCF_RESKEY_interface_alias_default}" /> </parameter> <parameter name="api_delay" unique="0"> <longdesc lang="en"> a short delay between API calls, to avoid sending API too quick </longdesc> <shortdesc lang="en">a short delay between API calls</shortdesc> <content type="integer" default="${OCF_RESKEY_api_delay_default}" /> </parameter> </parameters> <actions> <action name="start" timeout="30s" /> <action name="stop" timeout="30s" /> <action name="monitor" timeout="30s" interval="20s" depth="0" /> <action name="migrate_to" timeout="30s" /> <action name="migrate_from" timeout="30s" /> <action name="meta-data" timeout="5s" /> <action name="validate" timeout="10s" /> <action name="validate-all" timeout="10s" /> </actions> </resource-agent> END } ####################################################################### ocivip_usage() { cat <<END usage: $0 {start|stop|monitor|migrate_to|migrate_from|validate|validate-all|meta-data} Expects to have a fully populated OCF RA-compliant environment set. END } ocivip_start() { ocivip_monitor && return $OCF_SUCCESS $OCICLI network vnic assign-private-ip --vnic-id $VNIC_ID \ --unassign-if-already-assigned \ --ip-address ${SECONDARY_PRIVATE_IP} RETOCI=$? ip addr add ${SECONDARY_PRIVATE_IP}/${CIDR_NETMASK} dev ${PRIMARY_IFACE} label ${PRIMARY_IFACE}:${INTERFACE_ALIAS} RETIP=$? # delay to avoid sending request too fast sleep ${OCF_RESKEY_api_delay} if [ $RETOCI -ne 0 ] || [ $RETIP -ne 0 ]; then return $OCF_NOT_RUNNING fi ocf_log info "secondary_private_ip has been successfully brought up (${SECONDARY_PRIVATE_IP})" return $OCF_SUCCESS } ocivip_stop() { ocivip_monitor || return $OCF_SUCCESS $OCICLI network vnic unassign-private-ip --vnic-id $VNIC_ID \ --ip-address ${SECONDARY_PRIVATE_IP} RETOCI=$? ip addr del ${SECONDARY_PRIVATE_IP}/${CIDR_NETMASK} dev ${PRIMARY_IFACE}:${INTERFACE_ALIAS} RETIP=$? # delay to avoid sending request too fast sleep ${OCF_RESKEY_api_delay} if [ $RETOCI -ne 0 ] || [ $RETIP -ne 0 ]; then return $OCF_NOT_RUNNING fi ocf_log info "secondary_private_ip has been successfully brought down (${SECONDARY_PRIVATE_IP})" return $OCF_SUCCESS } ocivip_monitor() { $OCICLI network private-ip list --vnic-id $VNIC_ID | grep -q "${SECONDARY_PRIVATE_IP}" RETOCI=$? if [ $RETOCI -ne 0 ]; then return $OCF_NOT_RUNNING fi return $OCF_SUCCESS } ocivip_validate() { check_binary ${OCICLI} check_binary jq if [ -z "${VNIC_ID}" ]; then ocf_exit_reason "vnic_id not found. Is this a Compute instance?" return $OCF_ERR_GENERIC fi return $OCF_SUCCESS } case $__OCF_ACTION in meta-data) meta_data exit $OCF_SUCCESS ;; esac OCICLI="${OCF_RESKEY_ocicli}" SECONDARY_PRIVATE_IP="${OCF_RESKEY_secondary_private_ip}" CIDR_NETMASK="${OCF_RESKEY_cidr_netmask}" INTERFACE_ALIAS="${OCF_RESKEY_interface_alias}" VNIC_ID="$(curl -s -H "Authorization: Bearer Oracle" -L http://169.254.169.254/opc/v2/vnics/ | jq -r '.[0].vnicId')" PRIMARY_IFACE=$(ip -4 route ls | grep default | grep -Po '(?<=dev )(\S+)' | head -n1) case $__OCF_ACTION in start) ocivip_validate || exit $? ocivip_start ;; stop) ocivip_stop ;; monitor) ocivip_monitor ;; migrate_to) ocf_log info "Migrating ${OCF_RESOURCE_INSTANCE} to ${OCF_RESKEY_CRM_meta_migrate_target}." ocivip_stop ;; migrate_from) ocf_log info "Migrating ${OCF_RESOURCE_INSTANCE} from ${OCF_RESKEY_CRM_meta_migrate_source}." ocivip_start ;; reload) ocf_log info "Reloading ${OCF_RESOURCE_INSTANCE} ..." ;; validate|validate-all) ocivip_validate ;; usage|help) ocivip_usage exit $OCF_SUCCESS ;; *) ocivip_usage exit $OCF_ERR_UNIMPLEMENTED ;; esac rc=$? ocf_log debug "${OCF_RESOURCE_INSTANCE} $__OCF_ACTION : $rc" exit $rc -

Edite o arquivo

ocivipe altere o caminho do executável da CLI do OCI na variávelOCF_RESKEY_ocicli_defaultcom o caminho da CLI do OCI.Se você manteve o caminho padrão durante a instalação da CLI do OCI no Ubuntu, a variável será

/home/ubuntu/bin/oci.OCF_RESKEY_ocicli_default="/home/ubuntu/bin/oci"Crie o arquivo e copie o código baixado da etapa 7 com a variável atualizada.

sudo nano /usr/lib/ocf/resource.d/heartbeat/ocivipAltere a permissão e o proprietário do arquivo.

sudo chown root /usr/lib/ocf/resource.d/heartbeat/ocivip sudo chmod 755 /usr/lib/ocf/resource.d/heartbeat/ocivip -

Ative na inicialização e reinicie os serviços, bem como verifique se eles estão funcionando corretamente.

sudo systemctl enable corosync sudo systemctl enable pacemaker sudo systemctl enable pcsd sudo systemctl restart pcsd sudo systemctl restart corosync sudo systemctl restart pacemaker sudo systemctl status pcsd sudo systemctl status corosync sudo systemctl status pacemaker -

Defina a senha do usuário

ocicluster.sudo passwd ocicluster -

Execute o comando a seguir para autenticar os nós.

sudo pcs cluster auth node1 node2 -u ocicluster -p YOUR_PASSWORD -

Crie o cluster.

sudo pcs cluster setup ha_cluster node1 node2 -

Inicie e ative o cluster na inicialização em todos os nós.

sudo pcs cluster start --all sudo pcs cluster enable --all -

Verifique se o cluster está ativo e funcionando.

sudo pcs status -

Adicione o recurso

OCIVIPpara gerenciar o IP flutuante.Observação: Altere o endereço IP virtual para aquele designado como secundário à sua VNIC na etapa 2 deste tutorial.

sudo pcs resource create OCIVIP ocf:heartbeat:ocivip secondary_private_ip="10.10.1.115" cidr_netmask="24" op monitor timeout="30s" interval="20s" OCF_CHECK_LEVEL="0" -

Verifique se o recurso foi adicionado corretamente e está funcionando corretamente.

sudo pcs status -

Verifique se o endereço IP secundário pode migrar entre instâncias, por exemplo, reiniciando node1, e verifique a Console do OCI que está designada à outra instância e vice-versa.

Antes de reiniciar node1, você também pode fazer ping no endereço flutuante de uma terceira máquina virtual e verificar se ele continua respondendo após o shutdown de node1. Uma breve interrupção de alguns saltos é normal.

Seu cluster ativo e passivo está ativo e em execução. Agora você pode adicionar os serviços que exigem continuidade dos negócios.

Links Relacionados

Reconhecimentos

-

Autor - Marco Santucci (Arquiteto de Soluções em Nuvem Empresarial EMEA)

-

Colaborador - Lorenzo Garuti (Desenvolvedor do arquivo de recursos do ocivip)

Mais Recursos de Aprendizagem

Explore outros laboratórios em docs.oracle.com/learn ou acesse mais conteúdo de aprendizado gratuito no canal Oracle Learning YouTube. Além disso, visite education.oracle.com/learning-explorer para se tornar um Oracle Learning Explorer.

Para obter a documentação do produto, visite o Oracle Help Center.

Set up a Linux Virtual IP Failover on Oracle Cloud Infrastructure managed by Pacemaker

G13032-01

August 2024