Observação:

- Este tutorial requer acesso ao Oracle Cloud. Para se inscrever em uma conta gratuita, consulte Conceitos Básicos do Oracle Cloud Infrastructure Free Tier.

- Ele usa valores de exemplo para credenciais, tenancy e compartimentos do Oracle Cloud Infrastructure. Ao concluir seu laboratório, substitua esses valores por valores específicos do seu ambiente de nuvem.

Migrar Nós de GPU Bare Metal para o OKE como Nós Autogerenciados usando uma Pilha do OCI

Introdução

Neste tutorial, percorreremos o processo de migração de nós de GPU bare metal (BM) para nós autogerenciados do Oracle Cloud Infrastructure Kubernetes Engine (OKE) usando uma pilha da Oracle Cloud Infrastructure (OCI).

Vamos primeiro entender o que são nós autogerenciados e por que eles são ideais para executar GPUs no OKE.

O que são Nós Autogerenciados do OKE?

Como o nome indica, os nós autogerenciados são totalmente controlados e mantidos pelo cliente. Isso inclui tarefas de provisionamento, dimensionamento, configuração, upgrades e manutenção, como aplicação de patches do Sistema Operacional (SO) e substituição de nós. Embora essa abordagem exija um gerenciamento mais manual, ela fornece máxima flexibilidade e controle, tornando-a adequada para cargas de trabalho especializadas, como as executadas em GPUs.

Principais Recursos dos Nós Autogerenciados:

-

Controle Total: O cliente tem controle total sobre o ciclo de vida do nó, incluindo provisionamento, atualizações do SO, dimensionamento e encerramento.

-

Configurações Personalizadas: o cliente pode usar imagens personalizadas, instalar software específico, configurar rede ou usar tipos de instância alternativos.

-

Upgrades Manuais: Ao contrário dos pools de nós gerenciados pelo OKE, o cliente deve fazer upgrade manualmente das versões do Kubernetes, dos patches de segurança e das atualizações do SO.

-

BYON (Bring Your Own Nodes): O cliente pode usar instâncias existentes do OCI Compute como nós de trabalho em um cluster do OKE.

-

Sem Ciclo Automático de Nós: Se um nó falhar, o cliente precisará substituí-lo/ciclo manualmente.

Este tutorial aborda um caso de uso em que as cargas de trabalho da GPU A100 do BM estão sendo executadas atualmente em um cluster Slurm na OCI, com o objetivo de migrá-las para um cluster do OKE. Isso pode ser feito usando a pilha do OKE HPC (High Performance Computing) para implantar um cluster do OKE vazio e, em seguida, adicionar os nós de GPU existentes a ele.

Objetivos

- Migre nós de GPU BM A100 para o OKE como nós autogerenciados usando a pilha HPC OKE.

Pré-requisitos

-

Acesso do administrador a uma tenancy do OCI e a um cluster do OKE em execução.

-

Instale NVIDIA Run:ai nos nós BM A100 para conteinerizar os aplicativos. Para obter mais informações, consulte NVIDIA Run:ai.

-

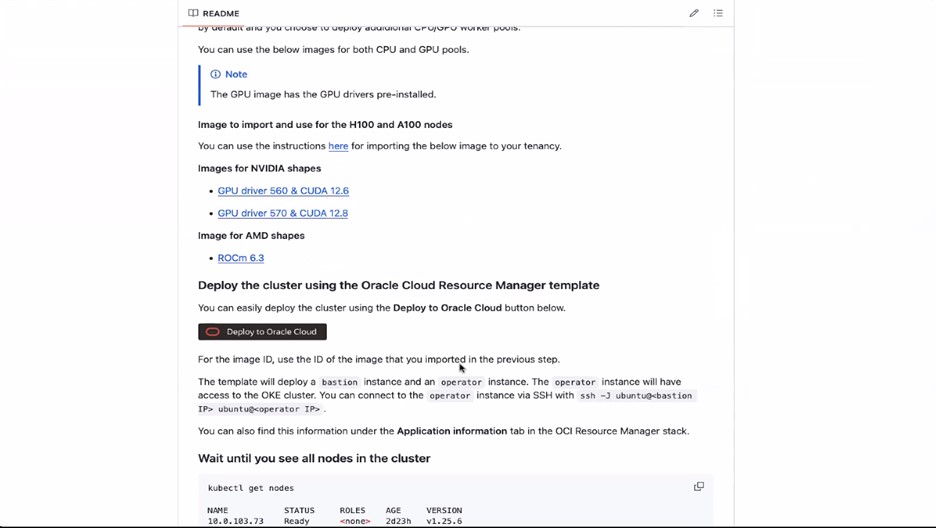

Execute cargas de trabalho de GPU RDMA (Remote Direct Memory Access) no OKE. Para obter mais informações, consulte Executando cargas de trabalho da GPU RDMA (acesso direto à memória remota) no OKE.

Tarefa 1: Migrar Nós de GPU BM A100 para OKE usando a Pilha HPC OKE

-

Faça log-in na Console do OCI e crie as políticas necessárias conforme mencionado nesta página GitHub: Executando cargas de trabalho de GPU RDMA (acesso direto à memória remota) no OKE.

-

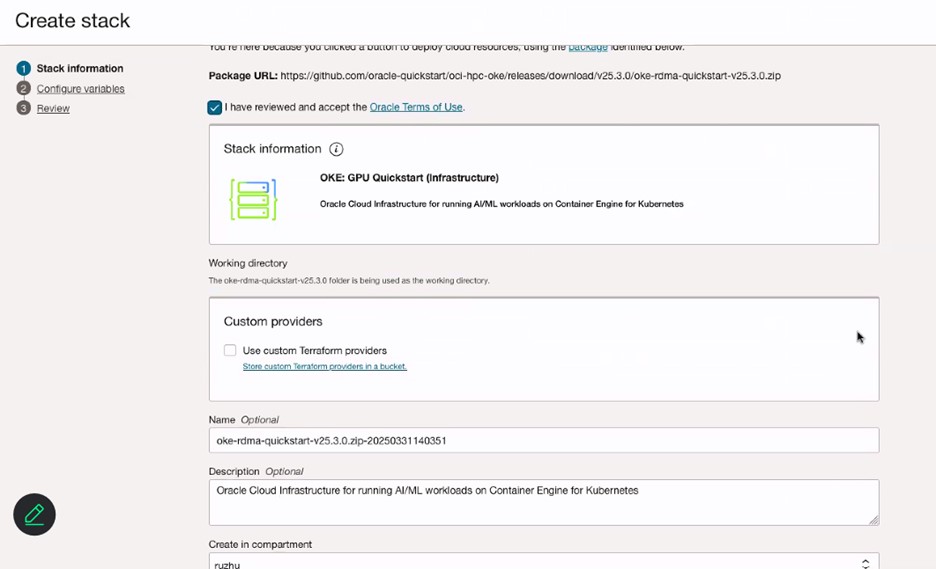

Clique em Implantar no Oracle Cloud e revise os termos e condições.

-

Selecione a região na qual você deseja implantar a pilha.

-

Na página Informações da pilha, digite Nome para sua pilha.

-

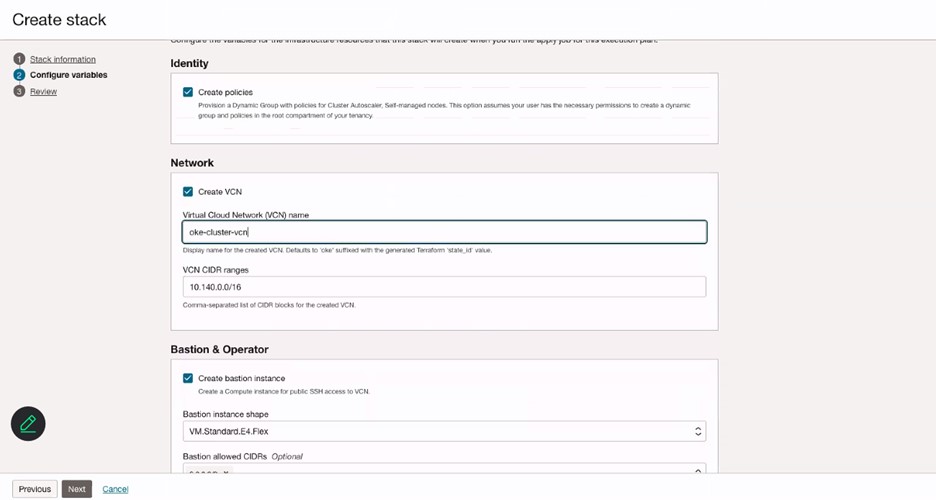

Na página Configurar variável, digite o Nome da sua VCN.

-

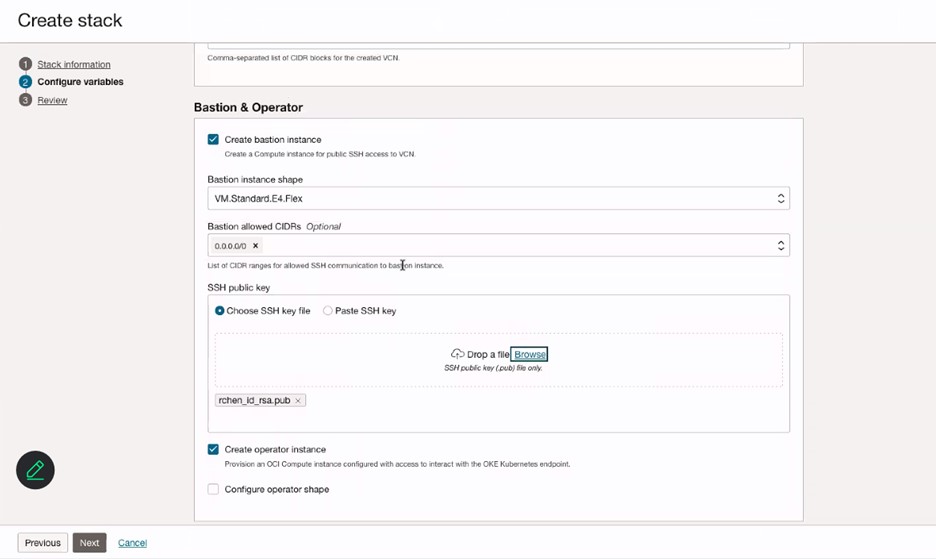

Na seção Bastion e Operador, especifique as informações da instância Bastion e adicione a chave SSH para a instância do Bastion.

-

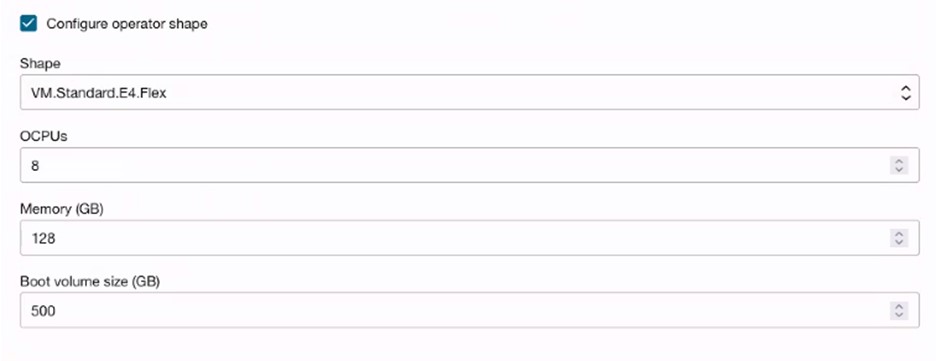

(Opcional) Selecione Configurar forma de operador para criar um nó de operador para monitorar ou executar jobs.

-

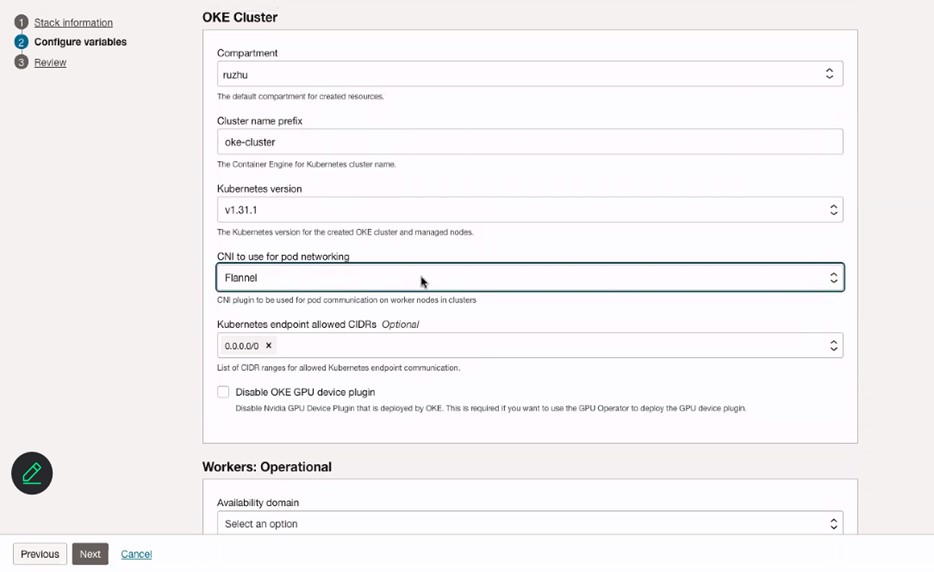

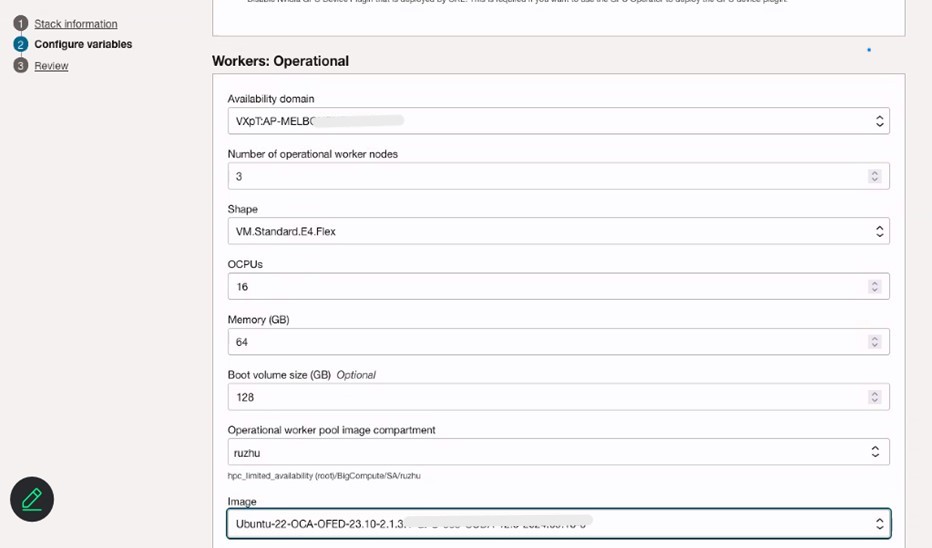

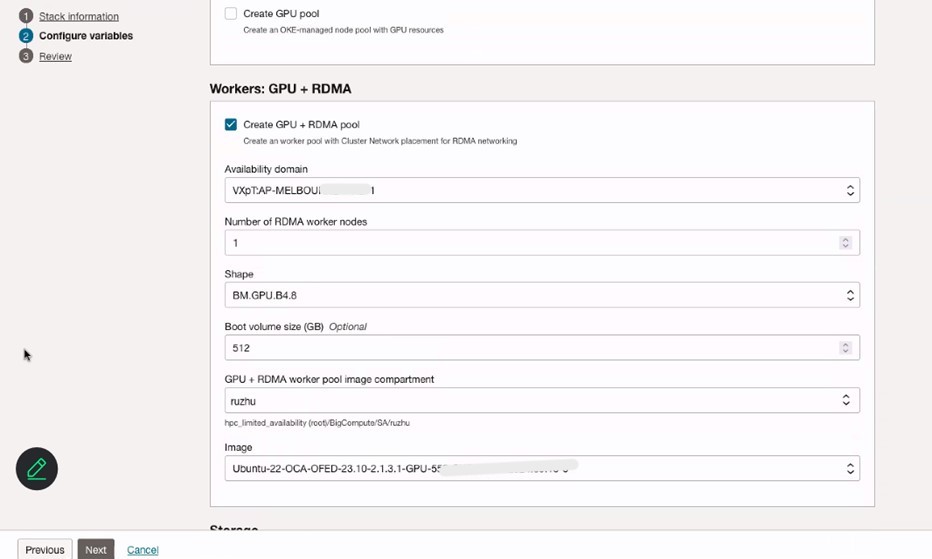

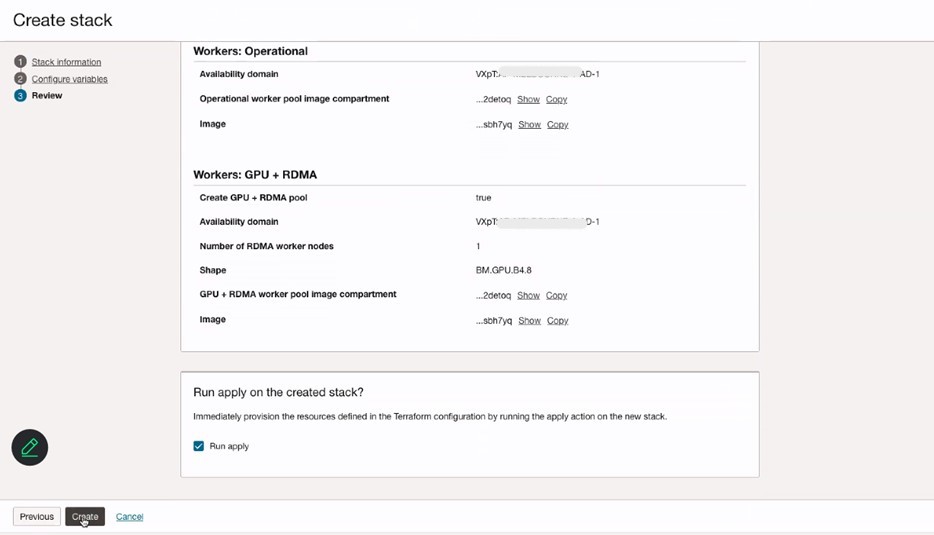

Configure variáveis de Cluster OKE, nós Workers: Operacionais e nós Workers: GPU + RDMA. Certifique-se de selecionar o CNI do Flannel a ser usado para rede de pod.

-

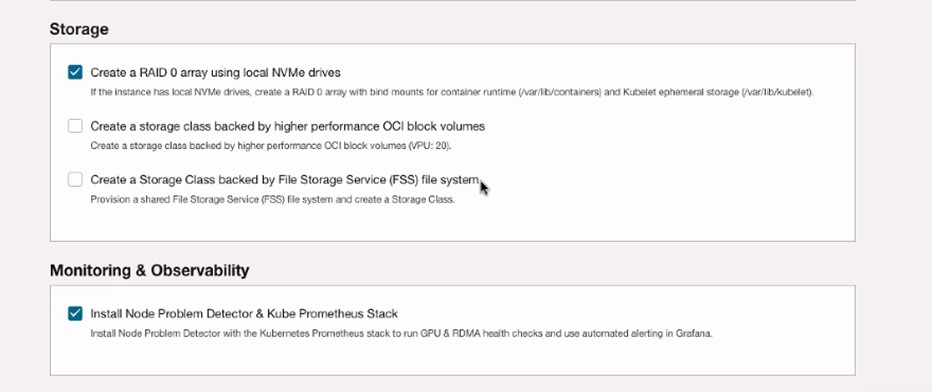

Selecione Criar um array RAID 0 usando unidades NVMe locais e Instalar Detector de Problemas de Nó e Pilha Kube Prometheus.

-

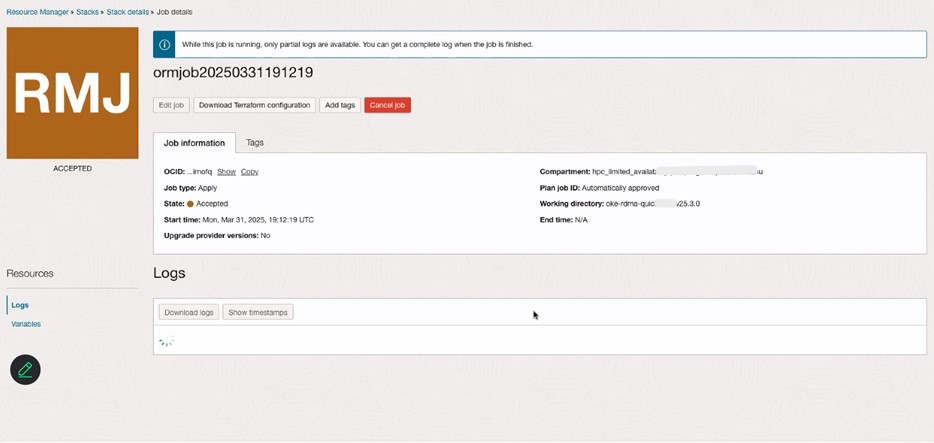

Verifique as informações da pilha e clique em Criar.

-

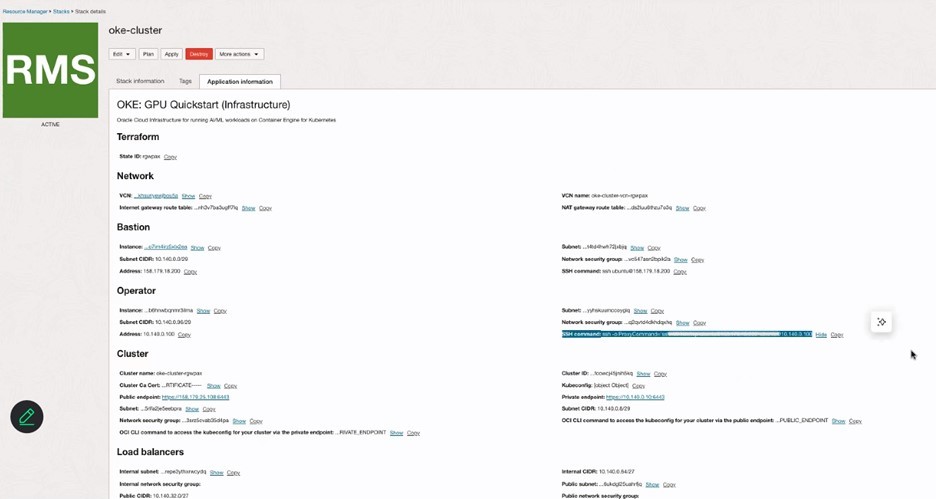

Revise os Detalhes da pilha no Resource Manager e verifique o cluster do OKE na seção Kubernetes na Console do OCI.

-

Faça log-in no cluster do OKE usando o cluster de acesso por meio da Console do OCI e continue a adicionar novos nós de GPU a ele.

-

Siga todas as etapas mencionadas aqui: Criando um Grupo Dinâmico e uma Política para Nós Gerenciados Automaticamente.

-

Siga as etapas 1 e 2 mencionadas aqui: Criando Scripts Cloud-init para Nós Autogerenciados.

-

Execute o script a seguir para adicionar os nós de GPU ao cluster do OKE.

sudo rm archive_uri-https_objectstorage_ap-osaka-1_oraclecloud_com_p_ltn5w_61bxynnhz4j9g2drkdic3mwpn7vqce4gznmjwqqzdqjamehhuogyuld5ht_n_hpc_limited_availability_b_oke_node_repo_o_ubuntu-jammy.list sudo apt install -y oci-oke-node-all* sudo oke bootstrap --apiserver-host <API SERVER IP> --ca <CA CERT> --manage-gpu-services --crio-extra-args " -

Execute o comando a seguir para verificar se os nós foram adicionados com sucesso ao cluster do OKE.

kubectl get nodes

Links Relacionados

-

Criando um Grupo Dinâmico e uma Política para Nós Autogerenciados

-

Apresentando a melhor plataforma para cargas de trabalho de IA - OCI Kubernetes Engine (OKE)

Confirmações

- Autors - Ruzhu Chen (Master Principal Arquiteto de Nuvem Empresarial), Payal Sharma (Arquiteto de Nuvem Empresarial Sênior)

Mais Recursos de Aprendizagem

Explore outros laboratórios em docs.oracle.com/learn ou acesse mais conteúdo de aprendizado gratuito no canal Oracle Learning YouTube. Além disso, visite education.oracle.com/learning-explorer para se tornar um Oracle Learning Explorer.

Para obter a documentação do produto, visite o Oracle Help Center.

Migrate Bare Metal GPU Nodes to OKE as Self-Managed Nodes using an OCI Stack

G31991-01

Copyright ©2025, Oracle and/or its affiliates.