Sobre a Implantação de Grandes Modelos de Linguagem no OCI

PagedAttention, que é central para o vLLM, aumenta a eficiência do mecanismo de atenção gerenciando-o como memória virtual. Ele melhora a utilização da memória GPU, permite o processamento de sequências mais longas e suporta o trabalho dentro das restrições de recursos de hardware. Além disso, o vLLM permite que o batching contínuo melhore o throughput e reduza a latência.

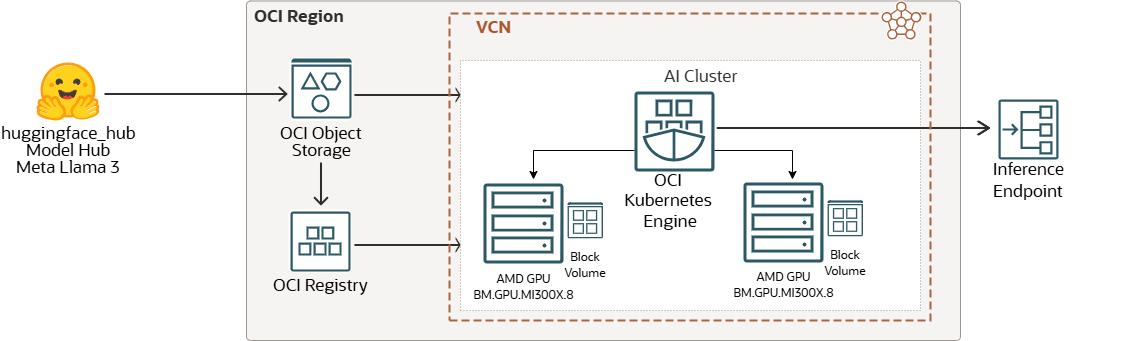

Nesta solução playbook, você aprende a implementar um LLM usando GPU AMD Instinct™ MI300Xs na OCI.

Workflow da Solução

O Hugging Face é uma plataforma colaborativa e um hub para machine learning que fornece modelos de IA pré-treinados, ferramentas de desenvolvimento e infraestrutura de hospedagem para aplicações de IA, tornando o machine learning avançado acessível a desenvolvedores em todo o mundo.

As imagens criadas com base no modelo podem ser armazenadas no OCI Registry para gerenciamento de imagem de modelo, controle de versão e gerenciamento de acesso seguro. O cluster aprimorado do Oracle Cloud Infrastructure Kubernetes Engine na instância de GPU OCI com AMD BM pode ser iniciado usando uma CLI ou na console. Por fim, um ponto final de inferência de modelo pode ser servido protegido pela rede ou pela internet.

A seguir, estão listados os componentes de terceiros:

- GPUs AMD Instinct™

GPU AMD Instinct™ MI300X com software aberto AMD ROCm™ potencializa instâncias do Supercluster OCI Compute chamadas BM.GPU.MI300X.8. As GPUs AMD Instinct MI300X e o software ROCm alimentam as cargas de trabalho de IA da OCI mais críticas.

Os recursos de inferência das GPUs AMD Instinct MI300X são adicionados à ampla seleção de instâncias bare metal de alto desempenho da OCI para remover a sobrecarga da computação virtualizada comumente usada para infraestrutura de IA.

- Pontos Finais de Inferência

A Inference Endpoints oferece uma solução de produção segura para implementar facilmente qualquer modelo de Transformadores, Transformadores de Sentenças e Difusores do Hub em uma infraestrutura dedicada e de dimensionamento automático gerenciada pela Inference Endpoints.

A seguir, estão listados os componentes do OCI:

- Região da OCI

Uma região do OCI é uma área geográfica localizada que contém um ou mais data centers, hospedando domínios de disponibilidade. Regiões são independentes de outras regiões, e grandes distâncias podem separá-las (entre países ou mesmo continentes).

- Rede e sub-rede virtual na nuvem da OCI

VCN (rede virtual na nuvem) é uma rede personalizável definida por software que você configura em uma região do OCI. Assim como as redes tradicionais do data center, as VCNs dão a você controle sobre seu ambiente de rede. Uma VCN pode ter vários blocos de CIDR (Classless Inter-domain Routing) não sobrepostos que você pode alterar após criar a VCN. Você pode segmentar uma VCN em sub-redes, com escopo definido para uma região ou para um domínio de disponibilidade. Cada sub-rede consiste em um intervalo contíguo de endereços que não se sobrepõem a outras sub-redes da VCN. Você pode alterar o tamanho de uma sub-rede após a criação. Uma sub-rede pode ser pública ou privada.

- Volumes em Blocos do OCI

Com o Oracle Cloud Infrastructure Block Volumes, você pode criar, anexar, conectar e mover volumes de armazenamento e alterar o desempenho do volume para atender aos seus requisitos de armazenamento, desempenho e aplicativo. Depois de anexar e conectar um volume a uma instância, você pode usar o volume como disco rígido comum. Você também pode desconectar um volume e anexá-lo a outra instância sem perder dados.

- Mecanismo do Kubernetes do OCI

O Oracle Cloud Infrastructure Kubernetes Engine (OCI Kubernetes Engine ou OKE) é um serviço totalmente gerenciado, escalável e altamente disponível que você pode usar para implantar seus aplicativos conteinerizados na nuvem. Você especifica os recursos de computação necessários aos seus aplicativos e o OKE os provisiona no OCI em uma tenancy existente. O OKE usa o Kubernetes para automatizar a implantação, o dimensionamento e o gerenciamento de aplicativos em contêineres em clusters de hosts.

- OCI Object Storage

O OCI Object Storage oferece acesso a grandes quantidades de dados estruturados e não estruturados de qualquer tipo de conteúdo, incluindo backups de banco de dados, dados analíticos e conteúdo avançado como imagens e vídeos. Você pode armazenar dados com segurança diretamente de aplicativos ou de dentro da plataforma de nuvem. Você pode dimensionar o armazenamento sem sofrer qualquer degradação no desempenho ou na confiabilidade de serviço.

Use armazenamento padrão para armazenamento "quente" que você precisa acessar com rapidez, rapidez e frequência. Use armazenamento de arquivo compactado para armazenamento "frio" que você retém por longos períodos de tempo e acesso raro.

- OCI Registry

O Oracle Cloud Infrastructure Registry é um serviço gerenciado pelo sistema Oracle que permite simplificar seu workflow de desenvolvimento para produção. O Registry facilita o armazenamento, o compartilhamento e o gerenciamento de artefatos do desenvolvimento, como imagens Docker.

Antes de Começar

- Blog: LLM Inicial que fornece resultados de experiência e desempenho com GPUs AMD Instinct MI300X

- Aprenda sobre VLLM.

- Para iniciar uma instância do

BM.GPU.MI300X.8, verifique a capacidade de computação em sua tenancy executando a Criação de Capacidade de Computação. Siga estas etapas, se precisar reservar uma instânciaBM.GPU.MI300X.8. - Para iniciar uma instância de GPU em uma VCN, você pode escolher uma VCN existente em sua tenancy e região ou pode criar uma. Consulte a documentação do Oracle Cloud Infrastructure Networking.

- Se você quiser usar sua própria chave SSH para estabelecer conexão com a instância usando SSH, precisará da chave pública no par SSH que você planeja usar. A chave deve estar no formato

OpenSSH. Consulte Gerenciando o Par de Chaves na Instância do Linux. - Para obter autorização para iniciar e trabalhar com instâncias, consulte a documentação Política do IAM Obrigatória para trabalhar com a instância.

Sobre Produtos e Funções Obrigatórios

Esta solução requer os seguintes produtos:

- Oracle Cloud Infrastructure Compute Bare Metal com GPU AMD

- Oracle Cloud Infrastructure Object Storage

- Oracle Cloud Infrastructure Block Volumes

- Oracle Cloud Infrastructure Kubernetes Engine

- Oracle Cloud Infrastructure Registry

Essas são as funções necessárias para cada produto.

| Nome do Serviço: Função | Obrigatório para... |

|---|---|

Política Oracle Cloud Instance Launch Using Custom Image

|

|

Política Oracle Cloud Manage Kubernetes Cluster

|

Administrators da tenancy ou pertencer a uma empresa à qual uma política concede a permissão CLUSTER_MANAGE.

Consulte a Configuração da Política para Criação e Implantação de Cluster. |

Política Oracle Cloud working with Images from Registry

|

|

Consulte Produtos, Soluções e Serviços Oracle para obter o que você precisa.