Saiba mais sobre o Streaming de Detecção de Fraudes

Neste manual de soluções, você aprende a usar a estrutura de segurança cibernética da NVIDIA Morpheus para implementar detecção de fraude orientada por IA em tempo real usando um pipeline Morpheus acelerado por GPU e publicar os resultados usando o Compute Cloud@Customer. A solução permite a detecção instantânea de fraudes sem esperar por tarefas em lote e mantém seus dados seguros, processando-os localmente na borda.

Antes de Começar

- Sistema Operacional: Ubuntu 24.04 LTS

- Plataforma: NVIDIA AI Enterprise em uma instância do Oracle Compute Cloud@Customer de nó único equipada com uma GPU L40S da NVIDIA.

Antes de começar, verifique se as seguintes ferramentas estão instaladas na máquina host:

- Docker e Docker Compose (

docker compose V2) - Git e Git LFS (

git-lfs) - Python 3 e

Pip

Fluxo de Trabalho

O fluxo de trabalho aproveita a estrutura de segurança cibernética da NVIDIA Morpheus para realizar inferência acelerada por GPU em um fluxo de dados de transações financeiras.

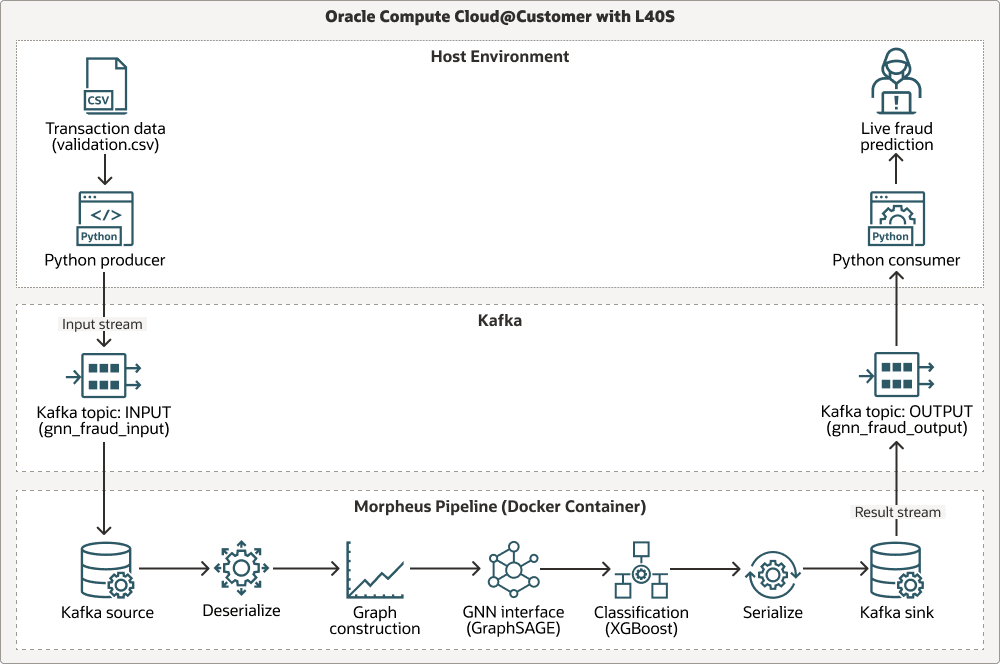

O diagrama a seguir mostra um workflow por meio de três raias; ambiente Host, Apache Kafka e o pipeline Morpheus:

O pipeline ingere dados de transações ao vivo por meio do Apache Kafka, executa análise contextual baseada em gráfico usando um modelo pré-treinado de Amostra e Agregação de Gráficos (GraphSAGE) e executa a classificação final de fraude usando XGBoost. Todos os estágios são acelerados usando bibliotecas RAPIDS NVIDIA (cuDF, cuML), tornando todo o fluxo de trabalho otimizado para GPU para alto throughput. Veja a seguir como o processo flui:

Transaction data (.csv)é produzido por um produtor de Python.- Os dados vão para o stream do tópico

INPUTdo Kafka. - Os dados são processados por meio do pipeline Morpheus em etapas: leitura da origem do Kafka, desserialização, construção de um gráfico, interface com a interface Graph Neural Network (GNN) (

GraphSAGE), classificação comXGBoost, serialização de resultados e gravação no dissipador do Kafka. - Os resultados são enviados para o stream do tópico

OUTPUTdo Kafka. - Um consumidor do Python recebe saída e fornece previsão de fraude ao vivo.

Proveniência de Modelo

O pipeline de inferência no núcleo dessa arquitetura usa dois modelos de machine learning pré-treinados: uma GNN GraphSAGE e um classificador XGBoost. Esses modelos foram gerados usando um pipeline de treinamento separado, que é incluído no repositório Morpheus para referência.

- Local do Script de Treinamento:

examples/gnn_fraud_detection_pipeline/training.py. - Processo: O script processa um conjunto de dados históricos rotulados para treinar a GNN em recursos baseados em gráfico e o modelo

XGBoostnas incorporações resultantes.

Nesta solução, você não precisa executar o script de treinamento porque os modelos pré-treinados já foram fornecidos. Concentre-se na implantação e na execução do pipeline de inferência em tempo real.

Essa arquitetura suporta os seguintes componentes:

- Oracle Compute Cloud@Customer

O Oracle Compute Cloud@Customer é uma infraestrutura totalmente gerenciada em escala de rack que permite usar o OCI Compute em qualquer lugar. Obtenha os benefícios da automação e da economia da nuvem em seu data center executando formas OCI Compute e GPU com serviços de armazenamento e rede no Compute Cloud@Customer. Você pode executar aplicativos e aproveitar o poder do GenAI na infraestrutura de nuvem em seu data center, ajudando a tratar a residência, a segurança e as conexões de baixa latência de dados com recursos locais e operações em tempo real.

- RAPIDS cuDF/cuML

O RAPIDS cuDF/cuML é um conjunto de bibliotecas aceleradas por GPU para manipulação de dados de alto desempenho e utilitários de machine learning dentro do pipeline Morpheus.

- Docker + Conda

Docker + Conda fornecem uma abordagem em camadas para gerenciamento de dependência, usando o Docker para isolamento no nível do sistema operacional e o Conda para gerenciar o ambiente Python complexo dentro do contêiner.

Considerações para Produção

Ao implementar essa solução em um ambiente de produção, considere a escalabilidade e a resiliência que o Kubernetes pode fornecer. Você pode migrar esta solução para o OCI Kubernetes Engine (OKE) por meio de:

- Contêinerização dos scripts auxiliares do produtor e do consumidor.

- Implantação do Kafka usando um operador do Kubernetes de nível de produção.

- Implantando o pipeline Morpheus como um job ou implantação do Kubernetes.

Sobre Serviços e Atribuições Obrigatórios

Esta solução requer os seguintes serviços e funções:

- Oracle Compute Cloud@Customer

- NVIDIA AI Enterprise 6.0

-

Ubuntu Linux (ou uma distribuição Linux compatível)

- Docker

- NVIDIA Morpheus 25.02

Essas são as funções necessárias para cada serviço.

| Nome do Serviço: Função | Obrigatório para... |

|---|---|

Oracle Compute Cloud@Customer: administrator |

Configure e implante a instância de máquina virtual do NVIDIA AI Enterprise, gerencie recursos de rede e garanta o acesso à GPU L40S do NVIDIA. |

Ubuntu Linux: root ou usuário com privilégios sudo

|

Instale software de pré-requisito (Docker, Git), gerencie serviços do sistema e execute comandos do Docker. |

| NVIDIA AI Enterprise: Usuário da Conta | Obtenha a imagem de contêiner necessária da NVIDIA Morpheus no catálogo da NVIDIA GPU Cloud (NGC). |

Consulte Produtos, Soluções e Serviços Oracle para obter o que você precisa.