Saiba mais sobre o Plano de Inferência de CPU

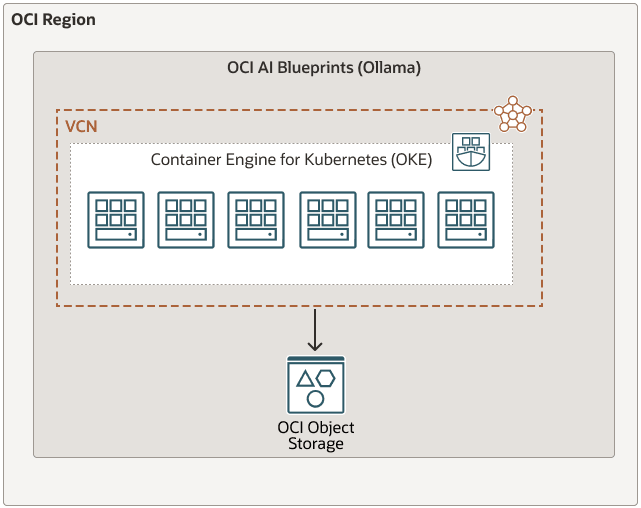

O Oracle Cloud Infrastructure AI Blueprints é uma solução simplificada e no-code para implementar e gerenciar cargas de trabalho de IA generativa no Oracle Cloud Infrastructure Kubernetes Engine (OKE).

Ao fornecer recomendações de hardware opinativas, pilhas de software pré-empacotadas e ferramentas de observabilidade prontas para uso, o OCI AI Blueprints ajuda você a executar suas aplicações de IA de forma rápida e eficiente, sem se preocupar com as complexidades das decisões de infraestrutura, compatibilidade de software e melhores práticas de operações de machine learning (ML Ops).

Este modelo de Inferência de CPU fornece uma estrutura abrangente para testar a inferência em CPUs usando a plataforma Ollama com uma variedade de modelos suportados, como Mistral, Gemma e outros disponíveis por meio do Ollama. Ao contrário das soluções dependentes de GPU, este projeto é projetado para ambientes em que a inferência de CPU é preferida ou necessária.

O projeto oferece diretrizes claras e definições de configuração para implantar um serviço robusto de inferência de CPU e, assim, permitir avaliações completas de desempenho e testes de confiabilidade. A arquitetura leve e eficiente da Ollama a torna uma solução ideal para desenvolvedores que buscam comparar e otimizar cargas de trabalho de inferência baseadas em CPU.

Este blueprint explica como usar a inferência de CPU para executar grandes modelos de linguagem usando o Ollama. Ela inclui duas estratégias principais de implantação:

- Atendendo a modelos pré-salvos diretamente do Oracle Cloud Infrastructure Object Storage

- Como extrair modelos do Ollama e salvá-los no OCI Object Storage