附註:

- 此教學課程需要存取 Oracle Cloud。若要註冊免費帳戶,請參閱 Oracle Cloud Infrastructure Free Tier 入門。

- 它使用 Oracle Cloud Infrastructure 證明資料、租用戶及區間的範例值。完成實驗室時,請將這些值取代為您雲端環境特定的值。

使用 OCI 堆疊將裸機 GPU 節點移轉至 OKE 作為自行管理的節點

簡介

在本教學課程中,我們將逐步介紹如何使用 Oracle Cloud Infrastructure (OCI) 堆疊將裸機 (BM) GPU 節點移轉至 Oracle Cloud Infrastructure Kubernetes Engine (OKE) 自我管理節點的流程。

讓我們先瞭解自我管理的節點,以及為什麼這些節點非常適合在 OKE 上執行 GPU。

什麼是 OKE 自行管理節點?

由於名稱意味著,自行管理節點由客戶完全控制和維護。這包括佈建、調整規模、組態、升級和維護工作,例如作業系統 (OS) 修補和節點更換。雖然此方法需要更多的手動管理,但它可提供最大的彈性和控制,使其適用於像在 GPU 上執行的工作負載。

自行管理節點的主要功能:

-

完全控制:客戶可以完全控制節點生命週期,包括佈建、作業系統更新、調整規模及終止。

-

自訂組態:客戶可以使用自訂映像檔、安裝特定軟體、設定網路,或使用替代執行處理類型。

-

手動升級:與 OKE 管理的節點集區不同,客戶必須手動升級 Kubernetes 版本、安全修正程式以及作業系統更新。

-

自備節點 (BYON):客戶可以使用現有的 OCI Compute 執行處理作為 OKE 叢集中的工作節點。

-

無自動節點循環:如果節點失敗,客戶必須手動取代 / 循環節點。

本教學課程涵蓋 BM A100 GPU 工作負載目前在 OCI 的 Slurm 叢集上執行的使用案例,目標是將其移轉至 OKE 叢集。使用高效能運算 (HPC) OKE 堆疊部署空的 OKE 叢集,然後在其中新增現有的 GPU 節點,即可達到此目的。

目標

- 使用 HPC OKE 堆疊,將 BM A100 GPU 節點移轉至 OKE 作為自行管理的節點。

必要條件

-

執行中 OCI 租用戶和 OKE 叢集的管理員存取權。

-

在 BM A100 節點上安裝 NVIDIA Run:ai 以容器化應用程式。如需詳細資訊,請參閱 NVIDIA Run:ai 。

-

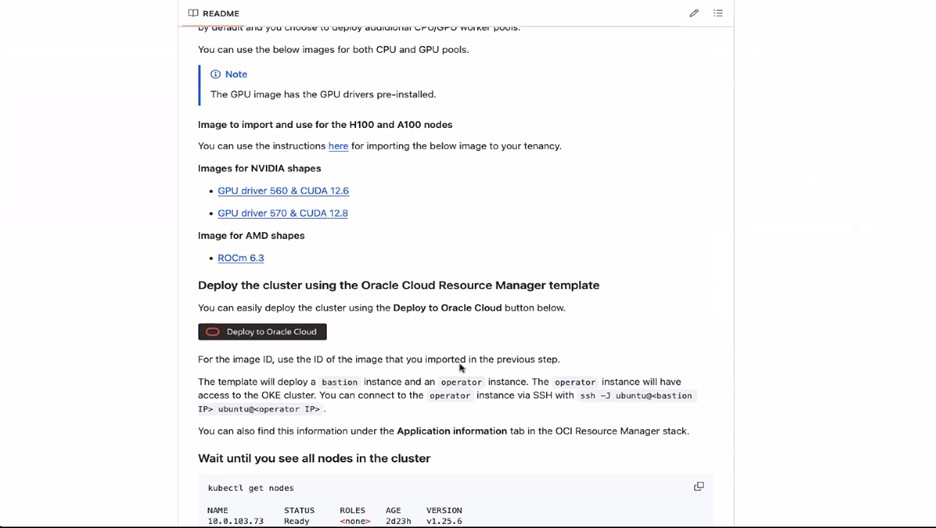

在 OKE 上執行遠端直接記憶體存取 (RDMA) GPU 工作負載。如需詳細資訊,請參閱在 OKE 上執行 RDMA (遠端直接記憶體存取) GPU 工作負載。

作業 1:使用 HPC OKE 堆疊將 BM A100 GPU 節點移轉至 OKE

-

登入 OCI 主控台並建立此 GitHub 頁面中所述的必要原則:在 OKE 上執行 RDMA (遠端直接記憶體存取) GPU 工作負載。

-

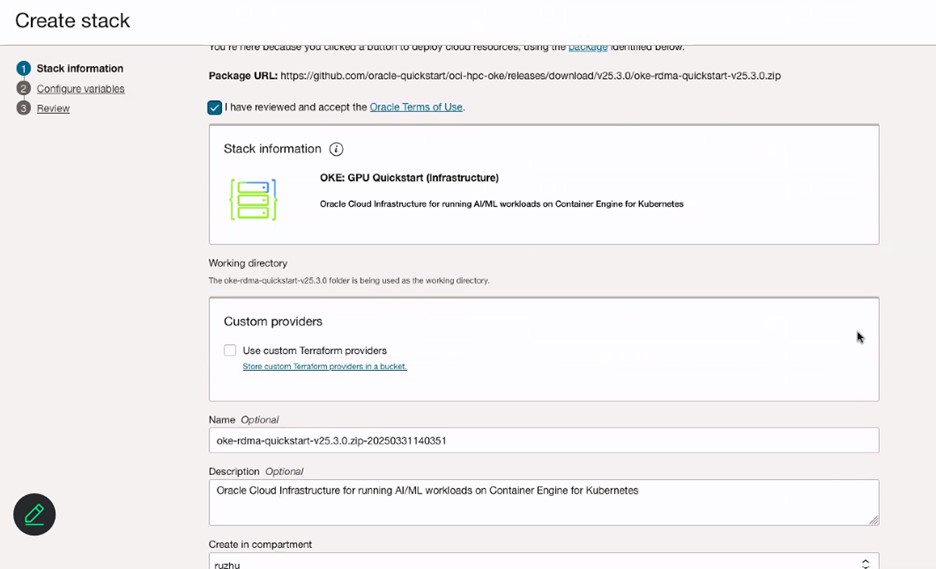

按一下部署至 Oracle Cloud ,然後檢閱條款與條件。

-

選取要在其中部署堆疊的區域。

-

在堆疊資訊頁面中,輸入堆疊的名稱。

-

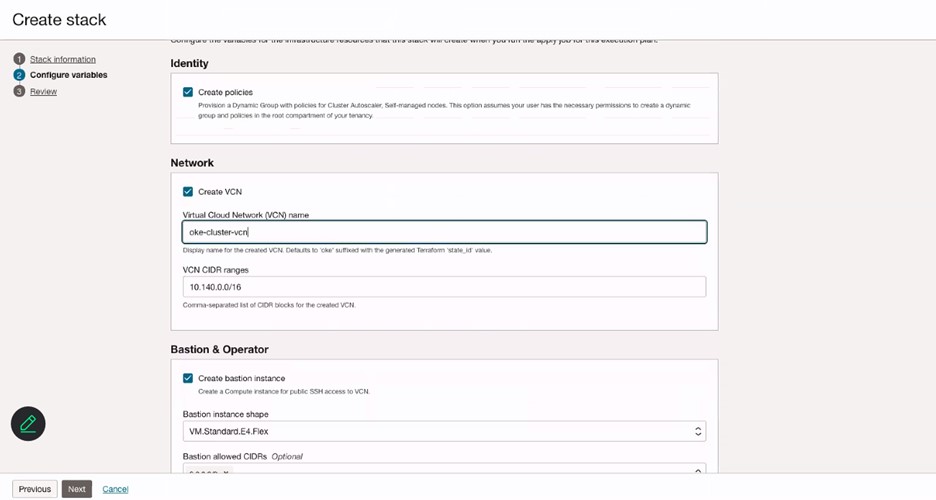

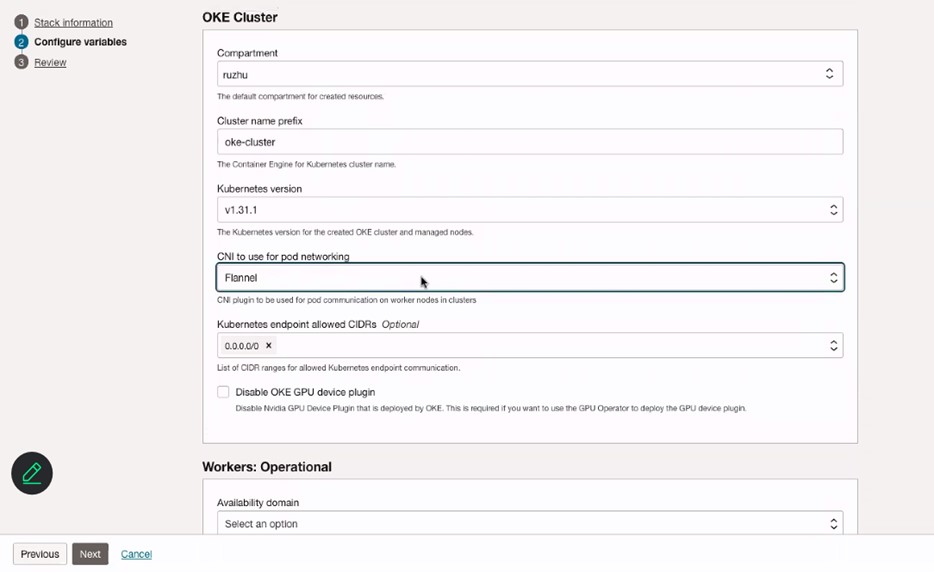

在設定變數頁面中,輸入 VCN 的名稱。

-

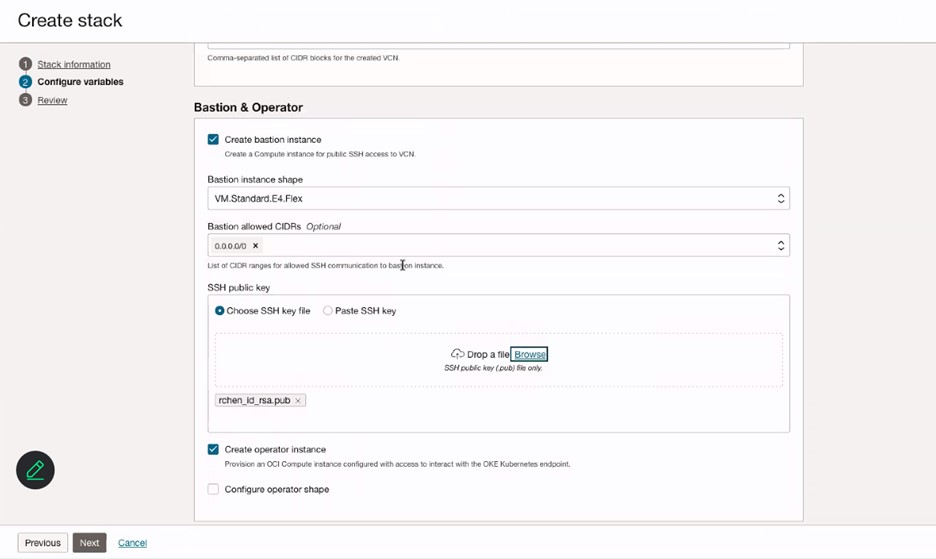

在堡壘主機和運算子段落中,輸入堡壘主機執行處理的資訊,並新增堡壘主機執行處理的 SSH 金鑰。

-

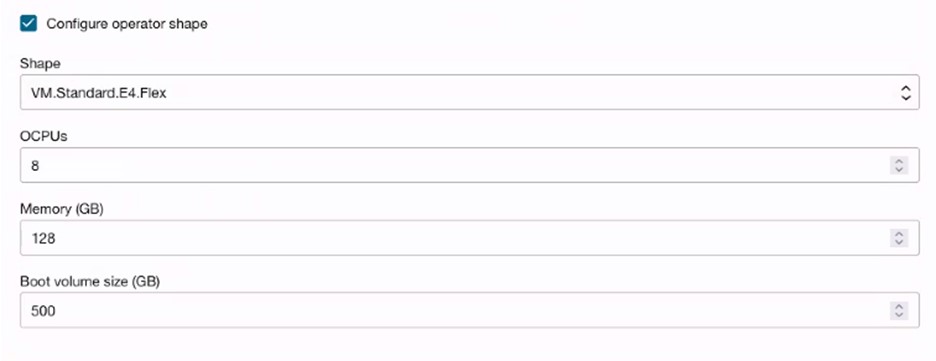

( 選擇性 ) 選取設定運算子形狀,以建立用於監視或執行工作的運算子節點。

-

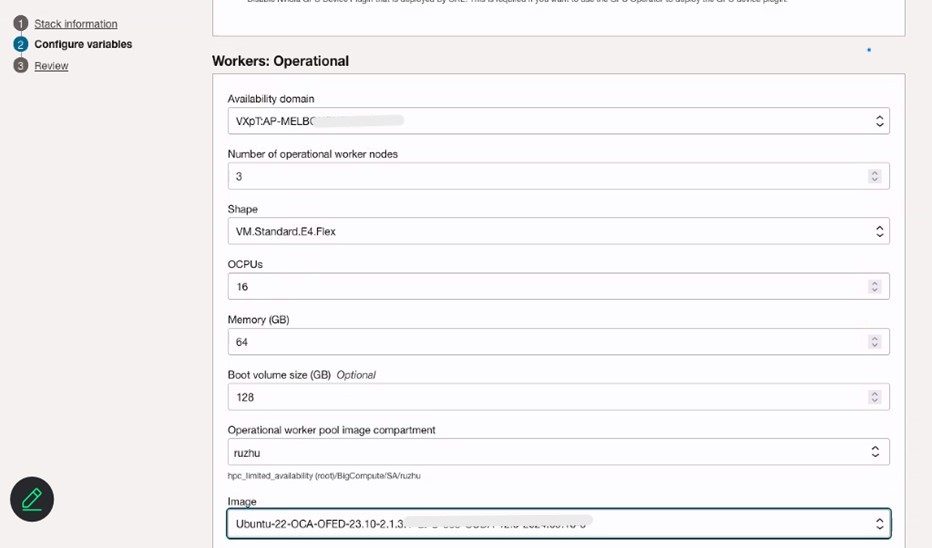

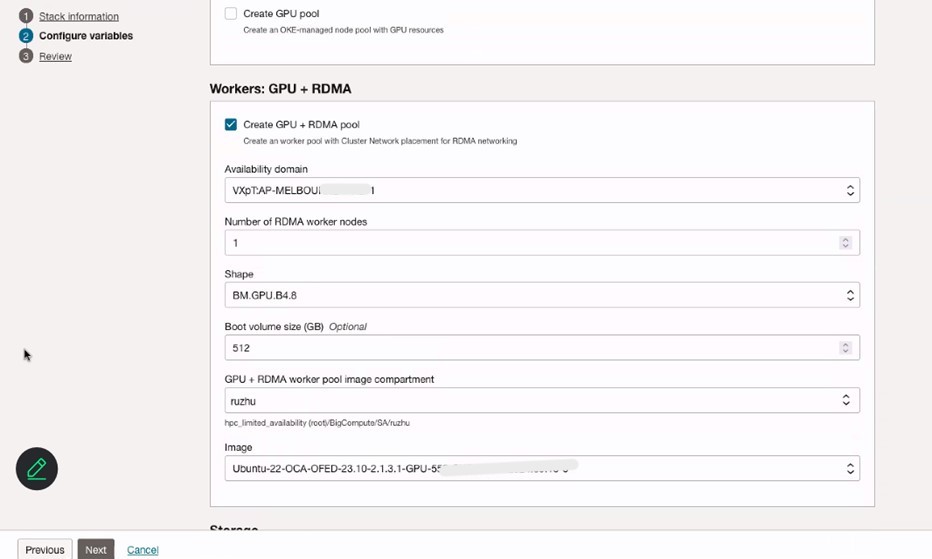

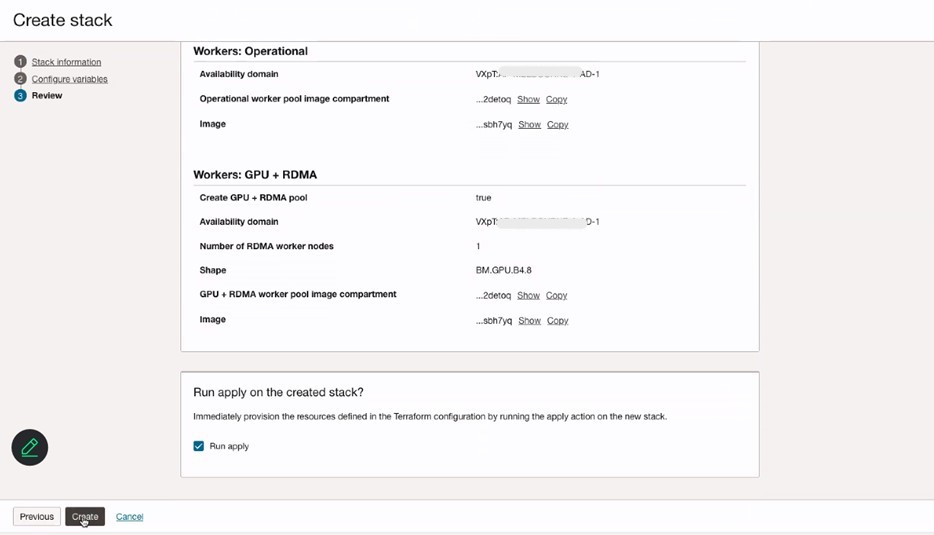

設定 OKE 叢集、工作:作業節點和工作:GPU + RDMA 節點的變數。請務必選取用於 Pod 網路的 Flannel CNI。

-

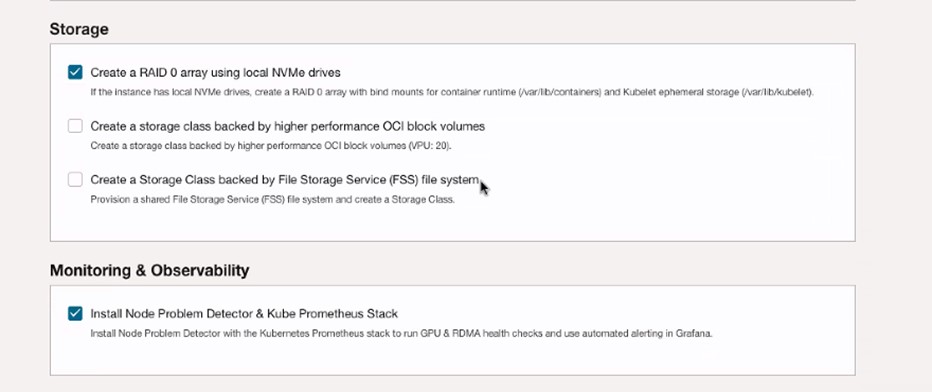

選取使用本機 NVMe 磁碟機建立 RAID 0 陣列和安裝節點問題偵測器與 Kube Prometheus Stack 。

-

複查堆疊資訊,然後按一下建立。

-

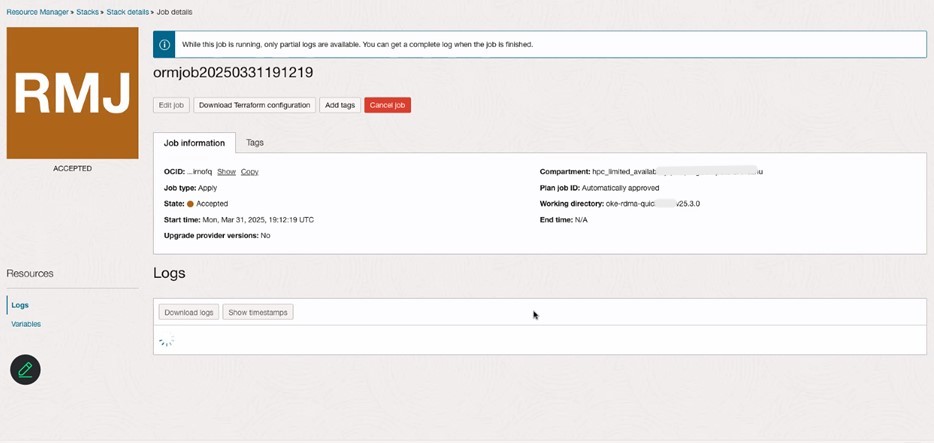

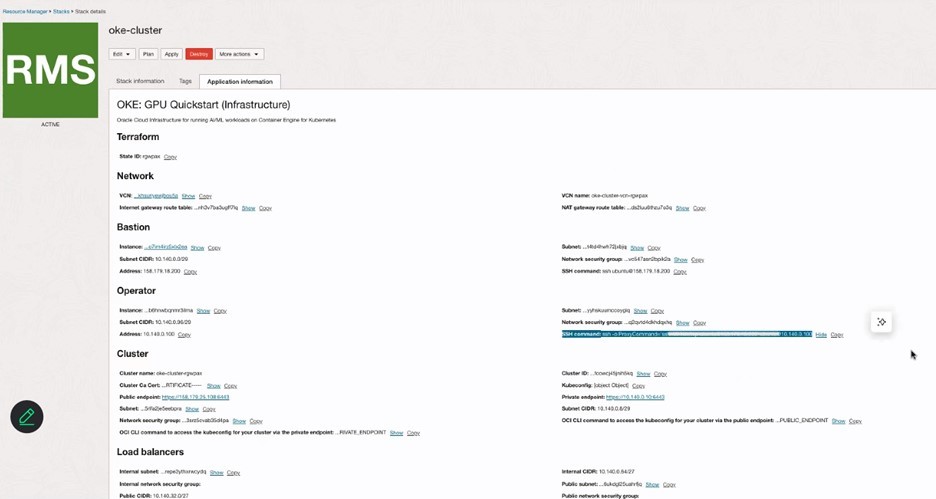

複查資源管理程式中的堆疊詳細資訊,然後在 OCI 主控台的 Kubernetes 區段底下驗證 OKE 叢集。

-

使用透過 OCI 主控台的存取叢集登入 OKE 叢集,並繼續新增 GPU 節點至此叢集。

-

請依照此處提及的所有步驟進行:建立動態群組和自行管理節點的原則。

-

依照此處所述的步驟 1 和步驟 2:建立自行管理節點的 Cloud-init 命令檔。

-

執行下列命令檔,將 GPU 節點新增至 OKE 叢集。

sudo rm archive_uri-https_objectstorage_ap-osaka-1_oraclecloud_com_p_ltn5w_61bxynnhz4j9g2drkdic3mwpn7vqce4gznmjwqqzdqjamehhuogyuld5ht_n_hpc_limited_availability_b_oke_node_repo_o_ubuntu-jammy.list sudo apt install -y oci-oke-node-all* sudo oke bootstrap --apiserver-host <API SERVER IP> --ca <CA CERT> --manage-gpu-services --crio-extra-args " -

執行下列命令以確認已順利將節點新增至 OKE 叢集。

kubectl get nodes

相關連結

認可

- 作者 - Ruzhu Chen (Payal Sharma 資深企業雲端架構師)

其他學習資源

探索 docs.oracle.com/learn 上的其他實驗室,或存取 Oracle Learning YouTube 頻道上的更多免費學習內容。此外,請造訪 education.oracle.com/learning-explorer 以成為 Oracle Learning Explorer。

如需產品文件,請造訪 Oracle Help Center 。

Migrate Bare Metal GPU Nodes to OKE as Self-Managed Nodes using an OCI Stack

G31993-01

Copyright ©2025, Oracle and/or its affiliates.