導入 Oracle Modern Data Platform 以進行業務報告和預測

本節描述如何佈建 OCI 服務、實作使用案例、將資料視覺化,以及建立預測。

導入 Oracle Modern Data Platform 使用案例

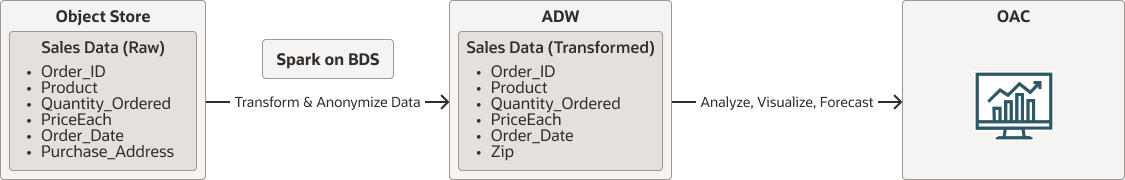

進入導入明細之前,請讓我們查看整體流程。

- 原始資料將位於 OCI 物件儲存中。

- 在 Oracle Big Data Service 上原生執行的 Spark 將會從 OCI Object Storage 讀取資料。它會清理、轉換資料並將其匿名化,最後將資料保存至 Autonomous Data Warehouse 。

- 使用者將利用 Oracle Analytics Cloud 將資料視覺化並進行預測。

oci-modern-data-reporting-flow-oracle.zip

附註:

選擇的資料流程是一個簡單範例,實際的業務使用案例可能更涉及。以下小節描述如何上傳範例資料、設定 OCI Object Storage 、Oracle Big Data Service ,以及呼叫簡單的 Spark scala 工作來轉換資料並將資料移至 Autonomous Data Warehouse

資料轉換工作完成後,請確認您可以在 Autonomous Data Warehouse 中查看資料。