| Oracle® Fusion Middleware WebCenter Sitesインストレーション・ガイド 11g リリース1 (11.1.1.8.0) E49672-02 |

|

前 |

次 |

| Oracle® Fusion Middleware WebCenter Sitesインストレーション・ガイド 11g リリース1 (11.1.1.8.0) E49672-02 |

|

前 |

次 |

この章では、新しくインストールされたAnalyticsアプリケーションおよびそのコンポーネントの動作を検証する手順を説明します。

この章の内容は、次のとおりです。

この項では、Hadoop、HDFSエージェントおよびHadoopジョブを起動し、次の手順を完了します。

Analyticsインストールを検証する手順は、次のとおりです。

Hadoopを起動します。

HDFSエージェントを起動します(binフォルダにあるrun.shを実行します)。

cd ${ANALYTICS_HOME}/hdfsagent/binchmod +x run.sh./run.sh

ANALYTICS_HOMEは、Analyticsインストール・ディレクトリです。

Hadoopジョブを起動する前に、次のように実行して、Hadoopジョブの動作が中断されないようにします。

ファイル/etc/security/limits.confを編集します。

soft nofileおよびhard nofileの値を65536に変更します。

Hadoopが実行される新しいシェルを開きます。ulimit -nが少なくとも1024であることを確認します。

Hadoopジョブを起動します(binフォルダにあるrun.shを実行します)。

|

注意: Hadoopの起動時にHadoopジョブ・スケジューラが実行されるようにするためには、JVMに少なくとも512MBのメモリーがあることが必要です。メモリーが不十分な場合は、メモリー・パラメータ Hadoopジョブ・スケジューラはHDFSのマスターであるため、そのスケジューラを再起動するときはすべてのHDFSエージェントを再起動する必要があります。 |

cd ${ANALYTICS_HOME}/hadoop-jobs/binchmod +x run.sh./run.sh

データ取得が機能していることを検証します。

アプリケーション・サーバーが、Analytics Sensorがインストールされているサーバー上で実行されていることを確認します。

verify_installユーティリティを実行し、Analytics SensorのURLにアクセスします。複数サーバーのインストールの場合、すべてのデータ取得サーバー上でverify_installユーティリティを実行します。(verify_installユーティリティには、Hadoopジョブをテストするためのサンプル・オブジェクト・インプレッションが含まれています。)

UNIX:

./analytics_install.sh verify_install

Windows:

analytics_install.bat verify_install

システムによって、プレビュー・サムネイルが(1x1ピクセルのgifファイルとして)返されます。受信RAWデータが、Analytics Sensorによってdata.txt.tmpファイルに書き込まれます(図30-1を参照)。

data.txt.tmpファイルは、ローカル・ファイル・システムのフォルダに格納されます。そのフォルダは、global.xmlのlogwriterエレメント(rootpath属性)で指定されます(表28-3を参照)。しきい値の間隔に到達するか(表28-1のsensor.thresholdプロパティを参照)、アプリケーション・サーバーが再起動したときに、センサーによってdata.txt.tmpファイルがdata.txtにローテーションされます。

たとえば、フォルダが<logwriter type="LFS" name="LFS" rootpath="C:/analytics/data" />として指定されている場合、RAW取得データは図30-1に示す、/analytics/data/フォルダから開始するフォルダ構造に書き込まれます。RAWデータは、data.txt.tmpに収集され、ローテーション後に、data.txtに格納されます。oirawdataおよびsesrawdataというフォルダは、システム・デフォルトです。

HDFSエージェントを検証します。

HDFSエージェントがdata.txt (およびそのディレクトリ構造)をローカル・ファイル・システムからHDFSに正常のコピーしたことを確認します。HDFSエージェントは、data.txtを次のように処理します。

ローカル・ファイルシステムからHDFSのフォルダにdata.txtファイルをコピーします。そのHDFSフォルダは、global.xmlのhadoop.hdfs.defaultfsパラメータによって指定されています(表28-1を参照)。

data.txtが正常にコピーされると、それはローカル・ファイル・システムから削除されます。

HDFSエージェントのアクションを検証し、ファイル・システムを調査するには、マスター・ノード上で実行されているHadoop HDFS Webインタフェース(http://<hostname_MasterNode>:50070/)を開き、そのフォルダを参照します。

Hadoopジョブを検証します。

Hadoopジョブは、HDFSエージェントによってローカル・ファイル・システムからHDFSにコピーされたデータを処理します。そのジョブのステータスを表示するには、次のJobTracker WebインタフェースURLを開きます。

http://<hostname_MasterNode>:50030/

JobTracker Webインタフェースの「RUNNING Jobs」セクションにOIProcessorジョブが表示されます。OIProcessorジョブが完了すると、OIInjectionジョブが開始され、そのデータがAnalyticsデータベースに挿入されます。

|

注意: 一連のセッションおよびビジター・ジョブも実行されます。ジョブが完了したら、それらのステータスがAnalytics管理者アプリケーションの「ステータス・サマリー」パネルに表示されます。管理者アプリケーションにログインするときに、9のジョブを検証します。 |

Analyticsレポート作成インタフェースを表示可能であることを検証します。

次のURLにあるAnalyticsレポート作成アプリケーションに、ユーザー名csuserおよびパスワードcsuserでログインします。

http://<hostname:port>/analytics

ここで、<hostname>は、レポート作成アプリケーションがインストールされているサーバーのホスト名です。

|

注意:

データベース接続に失敗した場合は、その事実を示すメッセージが表示されます。 |

Analytics管理者インタフェースを表示可能であることを検証します。

次のURLにあるAnalytics管理者アプリケーションに、ユーザー名csuserおよびパスワードcsuserでログインします。

http://<hostname:port>/analyticsadmin

ここで、<hostname>は、管理者アプリケーションがインストールされているサーバーのホスト名です。

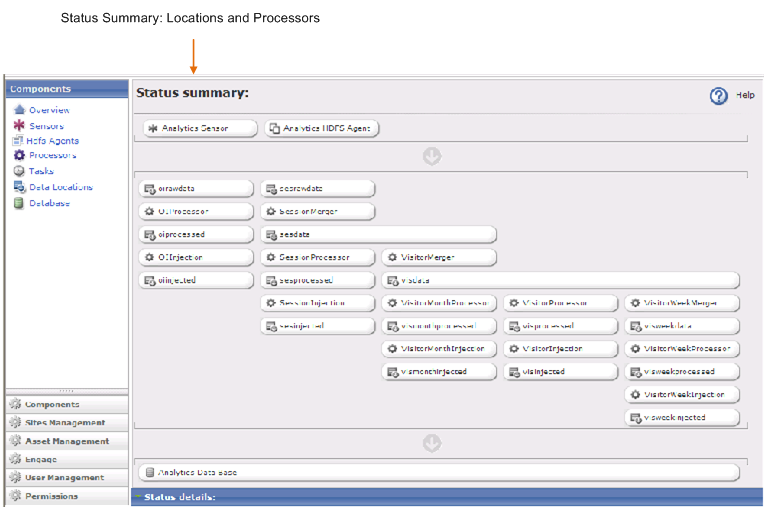

開く画面(図30-2)には、場所とプロセッサの「ステータス・サマリー」パネルが表示されます。

図30-2 Analytics管理者インタフェース(「コンポーネント」タブの「概要」オプション)

ここで、様々なコンポーネントのステータスを監視できます。例:

Analytics Sensorを監視して、それが機能しており、サイト・トラフィックに適切にレスポンスしていることを確認できます。(センサーの監視とアラートへの反応の詳細は、「センサーの過負荷アラート」を参照してください。)

Analytics Sensorを停止できます。

場所またはプロセッサをクリックしてそのステータスを表示することで、Hadoopジョブを検証できます。(Hadoopジョブおよび「ステータス・サマリー」パネルの詳細は、『Oracle Fusion Middleware WebCenter Sites: Analytics管理者ガイド』の「リファレンス: Hadoopジョブのプロセッサと場所」の章を参照してください。)

Analyticsインストールを検証したら、インストーラ・ファイルをそれぞれのホストに保持します。後で、運用パラメータの変更が必要になった場合に、そのインストーラを再実行できます。運用パラメータの手動による変更はお薦めいたしません。

インストーラ・ファイルは次のとおりです。

libは、サイレント・インストーラを実行するときにそれをサポートするために必要な追加のjarファイルがすべて含まれているフォルダです。

analytics-build.propertiesには、Analytics製品をシステムにどのようにインストールするのかを定義するすべてのプロパティが含まれています。

analytics-build.xmlは、サイレント・インストールを実行するためのAntでビルドされたスクリプトです。

analytics_install.batは、Windowsコマンド・ウィンドウでサイレント・インストーラを実行するバッチ・ファイルです。

analytics_install.shは、サイレント・インストーラを実行するUNIX/Linuxシェル・スクリプトです。

analytics-silent-install.jarには、サイレント・インストーラに必要なカスタムJavaクラスがすべて含まれています。

log4j.propertiesは、実行時の出力ターゲット、メッセージのタイプおよびレベル、メッセージの書式などのロギング動作を構成するために使用されます。

大量のサイト・トラフィックにより、Analytics Sensorは、受信データで過負荷になり、正常に反応しなくなることがあります。Analytics Sensorは、ファイル・システムへの書込みを停止し、メモリー不足状態になるまで、かわりにメモリーに受信データを格納します。

Analytics管理者インタフェース(図30-2)で、Analytics Sensorボタンが黄色または赤で表示され、過負荷状態がアラートされます。黄色は、WARNING状態を示します。赤は、CRITICAL状態を示します(センサーが実行されていると想定)。

|

注意: 停止または機能していないAnalytics Sensorも、赤で表示されます。 |

global.xmlのプロパティによって、WARNINGまたはCRITICAL状態をトリガーするしきい値が決まります。そのプロパティはsensor.requestqueue.warnsizeおよびsensor.requestqueue.maxsizeです。これらのプロパティを、Analyticsインストールの構成およびサイト・トラフィックの量に適したしきい値に設定します。これらのプロパティの詳細は、表28-1を参照してください。

「ステータス・サマリー」(管理インタフェース、図30-2)を監視していて、Analytics Sensorボタンが赤く表示されていることに気づいた場合、センサーが停止しているのか、障害が発生しているのか、過負荷になっているのかを判別する必要があります。過負荷の場合、システムをリセットして正常な動作を再開するには、メモリーをクリアする必要があります。メモリーからクリアされたデータは、取得できなくなり、失われます。

赤の状態に対処する手順は、次のとおりです。

Analytics Sensorボタンをクリックし、メイン・パネルに注意します。

"No data available"と表示されていたら、Analytics Sensorは停止しているか障害が発生しています。

「センサーの詳細」パネルが表示されていたら、Analytics Sensorは実行中ですが過負荷になっています。「リテンション・ポンドのクリア」というラベルが付いたアイコンをクリックし、メモリーをクリアします(図30-3)。

GeoLite Cityは、MaxMindによって提供されている高度に最適化された地理位置情報データベースです。GeoLite Cityは、高速検索を実行するためにバイナリ形式になっています。これは、Analyticsによって、それに含まれている情報(国、地域、地域コード、メトロ・コード、市区町村および郵便番号)のために使用されます。GeoLite Cityデータベースは毎月、月の初めにMaxMindによって更新されます。

最新のGeoLite Cityデータベースをインストールする手順は、次のとおりです。

次の場所から、バイナリ形式のGeoLite Cityデータベースをダウンロードします。

http://geolite.maxmind.com/download/geoip/database/GeoLiteCity.dat.gz

次のようにファイルを解凍します。

Windowsの場合: winzipまたはzipプログラムを使用して、ファイルを解凍します。

UNIXの場合: tarコマンドを使用してファイルを解凍します。

tar xvzf GeoLiteCity.dat.gz

GeoLiteCity.datファイルを、Hadoopジョブ・アプリケーションがインストールされているサーバー上のAnalyticsインストール・フォルダの下のCACHEフォルダにコピーします。

UNIXの場合:

cp GeoLiteCity.dat <ANALYTICS_INSTALL_DIR>/CACHE

この章のすべての手順を正常に完了すると、AnalyticsをWebCenter Sitesと統合してデータ取得およびレポート生成を有効化する準備が整います。

Analyticsの統合および有効化は、管理者と開発者の共同作業です。

管理者は、Analyticsにページおよびその他のアセット・タイプを登録し、それらが認識されてレポートに含まれるようにします。また、管理者は、レポートを生成する権限をユーザーに付与します。

開発者は、パブリッシュされたページでのデータ取得を有効化し、デフォルトHadoopジョブのセットによってRAWデータが処理されて、取得結果がレポートに格納されることを検証することで、レポートにデータが必ず埋め込まれるようにします。

統合、データ取得およびデータ処理の詳細は、『Oracle Fusion Middleware WebCenter Sites管理者ガイド』および『Oracle Fusion Middleware WebCenter Sites開発者ガイド』を参照してください。