| Oracle® Exadata Database Machineメンテナンス・ガイド 12c リリース2 (12.2) E84907-03 |

|

前 |

次 |

この章のトピックは、次のとおりです:

注意:

読みやすさを考慮して、Oracle Exadata Database MachineとOracle Exadata Storage拡張ラックの両方に言及する場合、「Oracle Exadataラック」という名前を使用します。

データベース・サーバー上で実行される管理サーバー(MS)は監視やアラートなどの管理機能を提供します。DBMCLIコマンドライン管理ツールも提供します。

関連項目:

Oracle Exadata Database Machineシステム概要ガイドのデータベース・サーバー上の管理サーバー

物理ディスクを修理する際には、Oracle Exadata Database Machineのデータベース・サーバーをシャットダウンする必要はありません。ラックの停止時間は必要ありませんが、個別のサーバーが停止して、一時的にクラスタの外部で処理される場合があります。

この項の内容は次のとおりです。

関連項目:

修理手順は、「Oracle Database Serverの部品」を参照してください。

LEDの詳細は、「LEDステータスの説明」を参照してください

各データベース・サーバーのディスク・ドライブは、LSI MegaRAID SAS 9261-8iまたは9361-8iディスク・コントローラによって管理されます。

ディスクの構成はRAID-5構成です。Oracle Exadata Database Machine X6-2、Oracle Exadata Database Machine X5-2、Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X2-2の各データベース・サーバーには4つのディスク・ドライブがあります。各Oracle Exadata Database Machine X4-8フル・ラック・データベース・サーバーには、7つのドライブがあります。デフォルトでは、1つのグローバル・ホット・スペア・ドライブを搭載した1つの6ディスクRAID-5として構成されます。Oracle Exadata Database Machine X5-8およびOracle Exadata Database Machine X3-8にはそれぞれ8つのディスク・ドライブがあります。RAIDセットには、仮想ドライブが1つ作成されています。

データベース・サーバーRAIDデバイスのステータスを確認して、パフォーマンスへの影響がないか、または停止しないようにすることをお薦めします。RAIDデバイスの検証による影響は最小です。是正処置による影響は未対応の特定の問題によって異なり、単純な再構成から停止が必要になる場合があります。

次のコマンドを使用して、データベース・サーバーのディスク・コントローラ構成を確認します。

/opt/MegaRAID/MegaCli/MegaCli64 -AdpAllInfo -aALL | grep "Device Present" -A 8

次に、Oracle Exadata Database Machine X3-2またはOracle Exadata Database Machine X2-2の場合のコマンドの出力例を示します。

Device Present

================

Virtual Drives : 1

Degraded : 0

Offline : 0

Physical Devices : 5

Disks : 4

Critical Disks : 0

Failed Disks : 0

次に、Oracle Exadata Database Machine X4-8フル・ラックのコマンドの出力例を示します。

Device Present

================

Virtual Drives : 1

Degraded : 0

Offline : 0

Physical Devices : 8

Disks : 7

Critical Disks : 0

Failed Disks : 0

次に、Oracle Exadata Database Machine X5-8フル・ラックのコマンドの出力例を示します。

Device Present

================

Virtual Drives : 1

Degraded : 0

Offline : 0

Physical Devices : 9

Disks : 8

Critical Disks : 0

Failed Disks : 0

Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X2-2の場合、予想される出力は仮想ドライブ1、パフォーマンス低下0、オフライン0、物理デバイス5 (1つのコントローラ + 4つのディスク)、ディスク4、クリティカル・ディスク0、障害が発生したディスク0です。

Oracle Exadata Database Machine X3-8フル・ラックおよびOracle Exadata Database Machine X2-8フル・ラックの場合、予想される出力は仮想ドライブ1、パフォーマンス低下0、オフライン0、物理デバイス11 (1つのコントローラ1 + 2つのSAS2拡張ポート + 8つのディスク)、ディスク8、クリティカル・ディスク0、障害が発生したディスク0です。

出力が異なる場合は、問題点を調査して修正します。パフォーマンスが低下した仮想ドライブは、通常は存在しない物理ディスクまたは障害が発生したディスクです。ノードで障害が発生したディスクの数が、システムの動作を維持するのに必要な数を超えた場合は、データ損失のリスクを回避するために、クリティカル・ディスクをすぐに交換してください。障害が発生したディスクもすぐに交換してください。

注意:

その他の仮想ドライブまたはホット・スペアが存在する場合は、デプロイ時にディスク再利用手順が実行されなかったか、dualboot=no修飾子を使用せずにベア・メタル・リストア手順が実行された可能性があります。詳細または是正処置は、My Oracle Supportノート1323309.1を参照してください。

ホット・スペアがあるデータベース・サーバーをOracle Exadata Storage Server Softwareリリース11.2.3.2.0以上にアップグレードする場合、ホット・スペアは削除され、アクティブ・ドライブとしてRAID構成に追加されます。データベース・サーバーはRAID 5冗長性の観点では同じ可用性で稼働し続け、ドライブが1つ失われても存続できます。ドライブで障害が発生した場合は、自動サービス・リクエストにより、そのドライブをできるだけ早く交換するように求める通知が送信されます。

仮想ドライブの構成を検証するには、次のコマンドを使用して、仮想ドライブの構成を検証します。

/opt/MegaRAID/MegaCli/MegaCli64 CfgDsply -aALL | grep "Virtual Drive:"; \ /opt/MegaRAID/MegaCli/MegaCli64 CfgDsply -aALL | grep "Number Of Drives"; \ /opt/MegaRAID/MegaCli/MegaCli64 CfgDsply -aALL | grep "^State"

次に、Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X2-2の場合の出力例を示します。仮想デバイス0は4つのドライブを持ち、状態はOptimalです。

Virtual Drive : 0 (Target Id: 0) Number Of Drives : 4 State : Optimal

Oracle Exadata Database Machine X3-8フル・ラックおよびOracle Exadata Database Machine X2-8フル・ラックの場合は、仮想デバイスが8つのドライブを持ち、状態がOptimalであることを示す出力が表示されると予想されます。

注意:

データベース・サーバーでdualboot=noオプションを使用しないでディスク交換がされた場合、データベース・サーバーには3つの仮想デバイスがある可能性があります。詳細または是正処置は、My Oracle Supportノート1323309.1を参照してください。

物理ドライブの構成を検証するには、次のコマンドを使用して、データベース・サーバーの物理ドライブの構成を検証します。

Linuxの場合は、次のコマンドを使用して、データベース・サーバーの物理ドライブの構成を検証します。

/opt/MegaRAID/MegaCli/MegaCli64 -PDList -aALL | grep "Firmware state"

次に、Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X2-2の場合の出力例を示します。ドライブはOnline, Spun Upです。出力順序は重要ではありません。Oracle Exadata Database Machine X3-8フル・ラックまたはOracle Exadata Database Machine X2-8フル・ラックの場合は、Online, Spun Upの状態を示す出力が8行になります。

Firmware state: Online, Spun Up Firmware state: Online, Spun Up Firmware state: Online, Spun Up Firmware state: Online, Spun Up

出力が異なる場合は、問題点を調査して修正します。

パフォーマンスが低下した仮想ドライブは、通常は存在しない物理ディスクまたは障害が発生したディスクです。ノードで障害が発生したディスクの数が、システムの動作を維持するのに必要な数を超えた場合は、データ損失のリスクを回避するために、クリティカル・ディスクをすぐに交換してください。障害が発生したディスクもすぐに交換してください。

データベース・サーバーのRAIDセットのドライブを交換した場合は、RAIDセットの再構築の進捗状況を監視する必要があります。

ディスクを交換したデータベース・サーバーで次のコマンドを使用します。コマンドはrootユーザーとして実行します。

/opt/MegaRAID/MegaCli/MegaCli64 -pdrbld -showprog -physdrv \ [disk_enclosure:slot_number] -a0

前述のコマンドで、disk_enclosureおよびslot_numberは、MegaCli64 -PDListコマンドによって識別された交換ディスクを示します。次に、コマンドの出力例を示します。

Rebuild Progress on Device at Enclosure 252, Slot 2 Completed 41% in 13 Minutes.

Oracle Exadata Storage Server Softwareリリース12.1.2.1.0以上にアップグレードしたホット・スペア・ドライブがあるOracle Exadata Database Machinesは、reclaimdisks.shスクリプトを使用してドライブをリクレイムできません。手動でドライブをリクレイムする手順は、次のとおりです。

注意:

この手順の実行中に、データベース・サーバーが2度再起動されます。この項の手順では、サーバーの再起動の後、Grid Infrastructureの再起動が無効であることを前提としています。

ディスクが4つあるOracle Exadata Database Machine X2-2データベース・サーバーの出力例を、次に示します。エンクロージャ識別子、スロット番号などは、使用するシステムにより異なる場合があります。

Management Server (MS)には、データベース・サーバー内の/ (root)ディレクトリからファイルを削除するポリシーがあり、ファイル・システムの使用率が高い場合にトリガーされます。ファイルの削除はファイル使用率が80パーセントの場合にトリガーされ、削除開始前にアラートが送信されます。アラートには、ディレクトリの名前と、サブディレクトリの領域の使用率が含まれます。削除ポリシーは次のとおりです。

次に示すディレクトリ内のファイルは、ファイル変更のタイム・スタンプに基づいたポリシーを使用して削除されます。

/opt/oracle/dbserver/log

/opt/oracle/dbserver/dbms/deploy/config/metrics

/opt/oracle/dbserver/dbms/deploy/log

metricHistoryDays属性によって設定された日数より古いファイルが最初に削除され、続けて古いファイルから変更タイムスタンプが10分以前のファイル、またはファイル・システムの使用率が75パーセントまでのファイルが削除されます。metricHistoryDays属性は/opt/oracle/dbserver/dbms/deploy/config/metrics内のファイルに適用されます。その他のログ・ファイルとトレース・ファイルには、diagHistoryDays属性を使用します。

12.1.2.2.0以上では、ms-odl.trcファイルとms-odl.logファイルの領域の最大容量は、trcファイル用が100MB (20個の5MBファイル)、logファイル用が100MB (20個の5MBファイル)です。以前は、trcファイルとlogファイルの両方とも、50MB (10個の5MBファイル)でした。

ms-odl生成ファイルは5MBに達すると名前が変更され、100MBの領域を使い切ると、最も古いファイルが削除されます。

ディスクの追加手順は、次のとおりです。

注意:

ディスク拡張キットはOracle Exadata Database Machine X5-2およびX6-2システムでのみサポートされています。

Oracle Exadataソフトウェア12.1.2.3.0以上が必要です。

データベース・サーバーにはメモリーを追加できます。メモリーの追加手順は、次のとおりです。

注意:

Sun Server X4-2 Oracle Database ServerおよびSun Server X3-2 Oracle Database Server用のメモリーは、メモリー拡張キットを使用して最大512GBに拡張できます。

Sun Fire X4170 Oracle Database Serverのメモリーは、既存のメモリーを取り外して、3個のX2-2メモリー拡張キットと交換することで、最大144GBに拡張できます。

Sun Fire X4170 M2 Oracle Database Serverは、8GB DIMMを使用した18個のDIMMスロットのうち12個が搭載された96GBのメモリーで工場から出荷されます。オプションのX2-2メモリー拡張キットを使用すると、残りの6つの空スロットに16GB DIMMを使用して合計メモリーを192GB (12 x 8GBおよび6 x 16GB)に拡張できます。

メモリー拡張キットは、主に各データベース・サーバー上で多くのデータベースを実行する場合のワークロード統合用です。このシナリオでは、メモリー使用率が非常に高くても、CPU使用率が低いことがよくあります。

ただし、DIMMメモリーの周波数が1333MHzから800MHzに落ちるため、すべてのメモリー・スロットの使用量は減ります。メモリーのパフォーマンス効果が遅いので、CPU使用率が高くなったように感じます。CPU使用率を測定すると、通常、増加率は平均して5%から10%です。増加量はワークロードによって大きく異なります。テスト用ワークロードでは、複数ワークロードの場合、増加率はほぼゼロでしたが、1つのワークロードの場合の増加率は約20%でした。

Oracle Linuxを実行しているOracle Exadata Database Machineにメモリーを追加する場合、次の値を使用して/etc/security/limits.confファイルを更新することをお薦めします。

oracle soft memlock 75% oracle hard memlock 75%

Oracle Exadataデータベース・サーバーX6-2では、マザーボードで高可用性の銅線10Gネットワークが提供され、スロット2のPCIカードを介して光学10Gネットワークが提供されます。オラクル社では、追加の接続を必要とするお客様のために追加のイーサネット・カードを用意しています。追加のカードにより、デュアル・ポートの10GEの銅線接続(部品番号7100488)またはデュアル・ポートの10GEの光学接続(部品番号X1109A-Z)が提供されます。Oracle Exadata X6-2データベース・サーバーのPCIeスロット1にこのカードを設置します。

設置してネットワークに接続すると、Exadataソフトウェア12.2.1.1.0は自動的に新しいカードを認識し、データベース・サーバーのeth6およびeth7インタフェースとして2つのポートを構成します。これらの追加のポートを使用して追加のクライアント・ネットワークを提供することも、個別のバックアップまたはデータ・リカバリ・ネットワークを作成することもできます。仮想マシンを実行するデータベース・サーバーでは、これを使用して2つの仮想マシンからトラフィックを分離できます。

データベース・サーバーにカードを追加した後、カードを構成する必要があります。次の項を参照してください。

ネットワーク・インタフェースを表示するには、ipconf.plコマンドを実行します。次に、ネットワーク・カードを追加していないX6-2データベース・サーバーの出力例を示します。

# cd /opt/oracle.cellos/ # ./ipconf.pl Logging started to /var/log/cellos/ipconf.log Interface ib0 is Linked. hca: mlx4_0 Interface ib1 is Linked. hca: mlx4_0 Interface eth0 is Linked. driver/mac: ixgbe/00:10:e0:8b:24:b6 Interface eth1 is ..... Linked. driver/mac: ixgbe/00:10:e0:8b:24:b7 Interface eth2 is ..... Linked. driver/mac: ixgbe/00:10:e0:8b:24:b8 Interface eth3 is ..... Linked. driver/mac: ixgbe/00:10:e0:8b:24:b9 Interface eth4 is Linked. driver/mac: ixgbe/90:e2:ba:ac:20:ec (slave of bondeth0) Interface eth5 is Linked. driver/mac: ixgbe/90:e2:ba:ac:20:ec (slave of bondeth0)

出力には2つのネットワーク・カードが示されます。

eth0からeth3のクアッド・ポート10Gbカード

eth4およびeth5のデュアル・ポート10Gbカード

キャパシティ・オンデマンドを使用して、Oracle Exadata Database Machineのアクティブ・コア数を増やすことができます。

Oracle Exadata Database Machine X4-2以降のシステムで実行されるデータベース・サーバー上のアクティブ・コア数を、インストール中に減らすことができます。追加の容量が必要な場合は、アクティブ・コア数を増やすことができます。これは、キャパシティ・オンデマンドと呼ばれます。

追加のコアは、Oracle Exadata Database Machine X4-2およびそれ以降のシステムでは2コア増分で、Oracle Exadata Database Machine X4-8フル・ラックおよびそれ以降のシステムでは8コア増分で増やします。次の表に、キャパシティ・オンデマンドのコア・プロセッサの構成を示します。

表2-1 キャパシティ・オンデマンドのコア・プロセッサの構成

| Oracle Exadata Database Machine | 対象となるシステム | サーバー当たりの最小コア数 | サーバー当たりの最大コア数 | コアの増分 |

|---|---|---|---|---|

Oracle Exadata Database Machine X6-2 |

エイス・ラック以外の構成 |

14 |

44 |

14から44、2の倍数。 14, 16, 18, ..., 42, 44 |

Oracle Exadata Database Machine X6-2 |

エイス・ラック |

8 |

22 |

8から22、2の倍数。 8, 10, 12, ..., 20, 22 |

Oracle Exadata Database Machine X5-2 |

エイス・ラック以外の構成 |

14 |

36 |

14から36、2の倍数。 14, 16, 18, ..., 34, 36 |

Oracle Exadata Database Machine X5-2 |

エイス・ラック |

8 |

18 |

8から18、2の倍数。 8, 10, 12, ..., 16, 18 |

Oracle Exadata Database Machine X6-8およびX5-8 |

任意の構成 |

56 |

144 |

56から144、8の倍数。 56, 64, 72, ..., 136, 144 |

Oracle Exadata Database Machine X4-2 |

フル・ラック ハーフ・ラック クオータ・ラック |

12 |

24 |

12から24、2の倍数。 12, 14, 16, ..., 22, 24 |

Oracle Exadata Database Machine X4-8 |

フル・ラック |

48 |

120 |

48から120、8の倍数。 48, 56, 64, ..., 112, 120 |

注意:

フェイルオーバーに備えて、各サーバーに同数のコアをライセンスすることをお薦めします。

追加できるデータベース・サーバーは一度に1つずつで、キャパシティ・オンデマンドは個別のデータベース・サーバーに適用されます。このオプションはOracle Exadata Database Machine X5-2エイス・ラックでも使用できます。

追加したコアを有効化してから、データベース・サーバーを再起動する必要があります。データベース・サーバーがクラスタの一部の場合、ローリング方式で有効化されます。

関連トピック

注意:

この項は、2ソケットのx86サーバーにのみ適用されます。8ソケット・サーバーおよびSPARCサーバーには適用されません。

ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタへの移行は次の方法で実行できます。

既存のベア・メタルOracle RACクラスタを使用して、Oracle VMにOracle RACクラスタを移行します。ダウンタイムは発生しません

Oracle VMに新しいOracle RACクラスタを作成して、Oracle VMにOracle RACクラスタを移行します。多少のダウンタイムが発生します

Oracle Data Guardを使用してOracle VMにOracle RACクラスタに移行します。多少のダウンタイムが発生します

RMANバックアップとリストアを使用してOracle VMのOracle RACクラスタに移行します。ダウンタイムが発生します

ベア・メタルOracle RACクラスタからOracle VMのOracle RACクラスタに変換することは、次のことを示唆します。

各データベース・サーバーがOracle Virtual Serverに変更されます。Oracle Virtual Serverには管理ドメインと、デプロイされるOracle RACクラスタの数に応じて1つ以上のユーザー・ドメインが作成されます。データベース・サーバー上の各ユーザー・ドメインは特定のOracle RACクラスタに所属します。

変換手順の一環として、ベア・メタルOracle RACクラスタが、Oracle VM内の1つのOracle RACクラスタに変換されます。データベース・サーバーごとに1つのユーザー・ドメインがあります。

変換が終わった後のストレージ・セルのセル・ディスクとグリッド・ディスクの構成は、変換の開始時の構成と同じになります。

各データベース・サーバー上で管理ドメインによって使用されるシステム・リソースの量は同じになります。通常、管理ドメインでは8GBのメモリーと4つの仮想CPUが使用されます。この点を考慮してOracle VMのOracle RACクラスタで実行するデータベースのSGAのサイズを決定してください。

Oracle Exadata Database Machine上のOracle VMユーザー・ドメインを管理するには、管理ドメイン(domain-0またはdom0)からxm(1)コマンドを実行します。xm helpを実行すると、すべてのOracle VM管理コマンドの一覧が表示されます。

注意:

次に示すxmサブコマンドは、Oracle Exadata Database Machineではサポートされていません。

mem-set mem-max migrate restore resume save suspend sched-* cpupool-* tmem-*

この項では、次の項目について説明します。

Oracle Grid InfrastructureおよびOracle Databaseの存在しないユーザー・ドメインの作成

Oracle ExadataでのOracle VM Oracle RACクラスタ間のInfiniBandパーティションの実装

注意:

特に明記された場合を除き、前述の手順で実行するすべてのコマンドはrootユーザーとして実行します。

Oracle VMユーザー・ドメインでのOracleデータベースのバックアップとリストアは、物理ノードでのOracleデータベースのバックアップとリストアと同じです。

次の手順では、ユーザー・ドメインに割り当てられたメモリーを変更する方法について説明します。

注意:

ユーザー・ドメインに割り当てられるメモリーの量を減らす場合は、ユーザー・ドメインで実行中のデータベースのSGAサイズおよび対応するヒュージ・ページ・オペレーティング・システム構成を最初に確認して調整する必要があります。そうしない場合、Linuxオペレーティング・システムのブート中に、多すぎるメモリーがヒュージ・ページに予約されるため、ユーザー・ドメインを起動できなくなることがあります。詳細は、My Oracle Supportノート361468.1を参照してください。

注意:

この手順では、ユーザー・ドメインを再起動する必要があります。メモリー割当てを変更する場合、xm mem-setコマンドはサポートされていません。

ユーザー・ドメインに割り当てられた仮想CPU数を変更するためのすべてのアクションは、管理ドメインで実行されます。

ユーザー・ドメインに可能な仮想CPU数は、ユーザー・ドメインのmaxvcpusパラメータで設定される値の範囲内で、動的に増減します。

仮想CPUをオーバーコミットすると、すべてのドメインに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。ただし、CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

次の手順では、ユーザー・ドメインに割り当てられた仮想CPU数を変更する方法について説明します。

次の手順に従い、物理CPU数を判別します。

管理ドメインで、次のコマンドを実行します。

# xm info | grep -A3 nr_cpus nr_cpus : 24 nr_nodes : 2 cores_per_socket : 6 threads_per_core : 2

出力で、nr_nodes行はソケットの数を示しています。コマンドが実行されるExadataデータベース・サーバーのプロセッサは2ソケットで、ソケット当たり6コアであるため、物理CPUスレッドは24個(2ソケット x 6コア/ソケット = 12コア。12コア x 2スレッド/コア = 24 CPUスレッド)です。

次のコマンドを実行して、ユーザー・ドメインに構成されオンラインである仮想CPUの現在の設定を判別します。

# xm list DomainName -l | grep vcpus

(vcpus 4)

(online_vcpus 2)

前述のコマンドで、DomainNameはユーザー・ドメインの名前です。コマンドの出力例では、ユーザー・ドメインの仮想CPUの最大数は4で、現在のオンライン仮想CPUは2です。このユーザー・ドメインのオンラインの仮想CPUの数は、ユーザー・ドメインがオンラインの間に、vcpusパラメータよりも大きくない数に調整されます。オンラインの仮想CPUの数をvcpusパラメータよりも大きい値に増やすには、ユーザー・ドメインをオフラインにする必要があります。

次の手順に従い、仮想CPU数を小さくするまたは大きくします。

仮想CPU数を減らす手順は、次の通りです。

次のコマンドを使用して、ユーザー・ドメインに現在割り当てられている仮想CPUの数を判別します。

# xm list DomainName

次のコマンドを使用して、現在割り当てられている仮想CPU数を減らします。

# xm vcpu-setDomainNamevCPUs_preferred

前述のコマンドで、vCPUs_preferredは、推奨される仮想CPU数の値です

仮想CPU数を増やす手順は、次の通りです。

次のコマンドを使用して、vcpusパラメータの現在の設定を判別します。

# xm list DomainName -l | grep vcpus

(vcpus 4)

(online_vcpus 2)

推奨される仮想CPU数が、vcpusパラメータの値より小さいか等しい場合、次のコマンドを実行して、オンライン仮想CPU数を増やします。

# xm vcpu-set DomainName vCPUs_preferred

前述のコマンドで、vCPUs_preferredは、推奨される仮想CPU数の値です

推奨される仮想CPU数が、vcpusパラメータの値より大きい場合、オンラインの仮想CPUの数をvcpusパラメータよりも大きい値に増やすには、ユーザー・ドメインをオフラインする必要があります。次の手順を実行します。

i.ユーザー・ドメインをシャットダウンします。

ii./EXAVMIMAGES/GuestImages/DomainName/vm.cfgファイルのバックアップ・コピーを作成します。

iii./EXAVMIMAGES/GuestImages/DomainName/vm.cfgファイルを編集し、vcpusパラメータを推奨される仮想vCPUの数に設定します。

注意: デフォルトでは、ユーザー・ドメインは、vcpusパラメータで構成された仮想CPUの数をオンラインにします。一部の仮想CPUをオフラインにしてユーザー・ドメインを起動する場合は、maxvcpusパラメータをvm.cfgに追加し、ユーザー・ドメインでオンラインにできる仮想CPUの最大数に設定します。vcpusパラメータを仮想CPUの数に設定し、ユーザー・ドメインの起動時にオンラインにします。たとえば、2つの仮想CPUがオンラインのユーザー・ドメインを起動し、そのユーザー・ドメインがオンラインの間に、さらに6つの仮想CPUをユーザー・ドメインに追加する場合は、次の設定をvm.cfgに使用します。

maxvcpus=8 vcpus=2

iv.ユーザー・ドメインを開始します。

次の手順では、新LVMディスクをユーザー・ドメインに追加して、ユーザー・ドメイン内で使用できるLVMディスク領域の量を増やす方法について説明します。この手順を実行すると、ファイル・システムまたはスワップLVMパーティションのサイズを増やすことができます。これはシステムがオンラインの場合に実行できます。

注意:

この手順は、管理ドメイン(Domain-0)およびユーザー・ドメイン内で実行する必要があります。

すべての手順を、rootユーザーとして実行してください。

この手順では、システム・パーティションおよび/ (ルート)ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

注意:

2種類のシステム・パーティション、LVDbSys1およびLVDbSys2が使用できます。片方のパーティションがアクティブでマウントされます。もう一方のパーティションは非アクティブで、アップグレード中、バックアップする場所として使用します。この2つのシステム・パーティションは、サイズが等しい必要があります。

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

関連トピック

この手順では、/u01ファイル・システムのサイズを増やす方法について説明します。

これはファイル・システムがオンラインの場合に実行できます。

注意:

VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。空き領域は、ソフトウェア保守の際に、dbnodeupdate.shユーティリティで作成したLVMスナップショットで使用します。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

関連トピック

Oracle Grid InfrastructureホームおよびOracle Databaseソフトウェア・ホームのために、それぞれのディスク・イメージ・ファイルが管理ドメインに作成されます。ディスク・イメージ・ファイルの場所は、/EXAVMIMAGES/GuestImages/DomainName/ディレクトリです。ディスク・イメージ・ファイルは、仮想マシンの起動中に自動的にユーザー・ドメインに関連付けられ、別個にLVMではないファイル・システムとしてユーザー・ドメインにマウントされます。

次の手順では、ユーザー・ドメインにおけるデータベース・ホーム・ファイル・システムのサイズを増やす方法について説明します。グリッド・ホームのサイズを増やすには、同様の手順を使用します。

データベース・サーバーにディスク拡張キットを追加するときには、適切な手順に従って、新しい領域を/EXAVMIMAGESファイル・システムに追加することが重要です。

デプロイメント中、データベース・サーバー上の使用可能なディスク領域はすべてdom0に割り当てられ、その領域のほとんどがユーザー・ドメイン・ストレージ用の/EXAVMIMAGESに割り当てられます。

次の例では、dm01db01がdom0管理ドメインの名前で、dm01db01vm01がゲスト・ユーザー・ドメインです。

この手順では、Oracle Exadata Deployment Assistant構成ツールおよびデプロイメント・ツールを使用して、Oracle VM Oracle RACクラスタを作成します。

Oracle VM Oracle RACクラスタを追加する要件は、次のとおりです。

システムが、1つ以上のOracle VM Oracle RACクラスタにデプロイ済である。

メモリー、CPU、ローカル・ディスク領域およびOracle Exadata Storage Serverディスク領域などのリソースが、システムで使用可能である。

最初のシステム構成で使用したOracle Exadata Deployment Assistantデプロイメント・ファイルが、使用可能である。

Oracle Exadata Deployment Assistant (OEDA)を使用しゲスト・ドメインを追加して、Oracle VM上の既存のOracle RACクラスタを拡張できます。

注意:

この手順の実行中、既存のOracle RACクラスタ・ノードとそのデータベース・インスタンスでは、停止時間は発生しません。

この手順のユースケースは次のとおりです。

Exadataラックのデータベース・サーバーのサブセットのみを使用する既存のOracle RACクラスタがあり、現在クラスタによって使用されていないノードが使用候補になった場合。

新しいOracle Virtual Serverノードまたは個別のExadataラックと最近相互ラック接続された既存のOracle RACクラスタがExadata上にある場合。

ユーザー・ドメインは、システムにOracle Grid InfrastructureおよびOracle Databaseをインストールせずに作成することができます。新しいユーザー・ドメインの要素は、次の通りです。

オペレーティング・システム・イメージがOracle Linuxである。

管理ネットワーク、クライアント・ネットワークおよびInfiniBandネットワークへアクセスできる。

Oracle Grid InfrastructureおよびOracle Databaseがインストールされていない。

Oracle Grid InfrastructureおよびOracle Databaseの存在しないユーザー・ドメインを作成する手順は、次の通りです。

未使用の新規IPアドレスおよびホスト名を新しいユーザー・ドメインに割り当てます。IPアドレスおよびホスト名は、管理ネットワーク、クライアント(SCAN)ネットワークおよびプライベートInfiniBandネットワークで必要です。

注意:

アドレスごとにpingコマンドを使用して、該当のInfiniBandネットワークのIPアドレスが使用されていないことを確認します。ibhostsコマンドには、ユーザー・ドメインのエントリが含まれていないため、このコマンドを使用して、すべてのInfiniBandネットワークのIPアドレスが使用されていることを確認することはできません。

必要に応じて、更新されたユーザー・ドメイン(domU)システム・イメージ・ファイルを取得します。

ユーザー・ドメインを作成するために、この手順の後で実行するexadata.img.domu_makerコマンドには、ユーザー・ドメイン(domU)システム・イメージ・ファイルSystem.first.boot.version.imgが/EXAVMIMAGESに必要です(versionは、管理ドメインのExadataソフトウェアのバージョンに一致し、管理ドメインで"imageinfo -ver"コマンドを実行することで確認できます)。

たとえば、exadata.img.domu_makerを実行して、新しいユーザー・ドメインを作成し、管理ドメインのExadataソフトウェアのバージョンが12.1.2.1.1.150316.2の場合、ユーザー・ドメイン(domU)システム・イメージ・ファイル/EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.imgが存在する必要があります。

# imageinfo -ver 12.1.2.1.1.150316.2 # ls -l /EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.img -rw-r--r-- 1 root root 13958643712 Mar 23 12:25 /EXAVMIMAGES/System.first.boot.12.1.2.1.1.150316.2.img

ユーザー・ドメイン(domU)システム・イメージ・ファイルが存在しない場合は、My Oracle Supportから取得し、管理ドメインの/EXAVMIMAGESに配置する必要があります。詳細は、My Oracle Supportノート888828.1を参照してください。

次のコマンドを使用して、管理ドメインで、既存のXML構成ファイルをデプロイ済ユーザー・ドメインからコピーして、新しい名前のファイルにコピーします。

# cp /EXAVMIMAGES/conf/existingDomainName-vm.xml /EXAVMIMAGES/conf/newDomainName-vm.xml

前述のコマンドで、existingDomainName-vm.xmlは、デプロイされたユーザー・ドメインのXML構成ファイルで、newDomainName-vm.xmlは新しいファイルの名前です。

次の例では、ユーザー・ドメイン"dm01db01vm01"の構成ファイルを、nondbdomain-vm.xmlにコピーします。

# cp /EXAVMIMAGES/conf/dm01db01vm01-vm.xml /EXAVMIMAGES/conf/nondbdomain-vm.xml

管理ドメインで、次のようにして、新しいXMLファイルを編集します。

すべての<Hostname>タグを変更して、対応するネットワークの新しいホスト名に一致させます。

すべての<IP_address>タグを変更して、対応するネットワークの新しいIPアドレスに一致させます。

<virtualMachine>タグを変更して、新しいホスト名を含めます。

<hostName>タグを変更して、新しいホスト名を含めます。

すべてのサブ要素を含む、<disk id="disk_2">および<disk id="disk_3">要素全体を削除します。開始<disk>タグから対応する終了</disk>の間のエントリ全体を削除する必要があります。

管理ドメインで、/opt/exadata_ovm/exadata.img.domu_makerコマンドを使用して、InfiniBandネットワークGUIDを新しいユーザー・ドメインに割り当てます。

# /opt/exadata_ovm/exadata.img.domu_maker allocate-guids \

/EXAVMIMAGES/conf/newDomainName-vm.xml \

/EXAVMIMAGES/conf/final-newDomainName-vm.xml

管理ドメインで、/opt/exadata_ovm/exadata.img.domu_makerコマンドを使用して、新しいユーザー・ドメインを作成します。

# /opt/exadata_ovm/exadata.img.domu_maker start-domain \ /EXAVMIMAGES/conf/final-newDomainName-vm.xml

ターゲット・データベース・サーバーに、同一リリースのOracle Exadata Storage Server SoftwareおよびOracle VMがインストールされている。

ターゲット・データベース・サーバーに、同一のネットワークが表示されている。

ターゲット・データベース・サーバーは、同一のExadata Storage Serversにアクセスできる。

ターゲット・データベース・サーバーで、ユーザー・ドメインの操作に必要な十分な空きリソース(メモリー、CPUおよびローカル・ディスク領域)が使用可能である。

仮想CPUをオーバーコミットすると、すべてのドメインに割り当てられた仮想CPUを、システム上の物理CPU数より多く割り当てることができます。CPUのオーバーコミットは、過剰に収容されたリソースへの競合するワークロードが十分理解され、同時に発生する要求が物理能力を超えない場合にのみ、実行する必要があります。

メモリーをオーバーコミットすることはできません。

ディスク・イメージをターゲット・データベース・サーバーにコピーすると、ディスク・イメージ・ファイルの領域の割当てが増加する場合があります。これは、コピーされたファイルは、OCFS2 reflinkを利用してディスク領域を省略できないためです。

ユーザー・ドメイン名は、ターゲット・データベース・サーバーで未使用の名前にする必要があります。

次の手順に従い、ユーザー・ドメインを同一のOracle Exadata Storage Server Software構成内の新しいデータベース・サーバーに移動します。すべての手順は、管理ドメインで実行してください。

クラスタ内で実行中のデータベースおよびこのデータベースで使用中のOracle Exadata Storage Serverで保存するすべてのデータを含む、Oracle VMクラスタのすべてのOracle RACノードを削除します。

Oracle VMクラスタの一部のユーザー・ドメインを削除する場合、次の項を参照してください。

Oracle VMクラスタを削除する手順は、主に2つあります。

ユーザー・ドメイン・ファイルを管理ドメインから削除する。

使用していないOracle Exadataグリッド・ディスクを削除する。

注意:

Oracle Exadata Deployment Assistant xml構成ファイルを後で再び使用する場合、削除されたユーザー・ドメインの定義がOracle Exadata Deployment Assistantファイル内に残っているため、それらの構成ファイルは同期できません。

Oracle VMクラスタから1つのOracle RACノードを削除できます。

Oracle Exadataグリッド・ディスクは、クラスタ内に残っているノードで使用中のため、削除しないでください。

注意:

Oracle Exadata Deployment Assistant xml構成ファイルを後で再び使用する場合、削除されたユーザー・ドメインの定義がOracle Exadata Deployment Assistantファイル内に残っているため、それらの構成ファイルは同期できません。

関連トピック

このトピックでは、Exadata上のOracle VM環境でのタグVLANインタフェースの実装について説明します。

Oracle Exadata Database Machine上のOracle VMゲストで稼働しているOracleデータベースは、Oracle Exadata Deployment Assistant (OEDA)構成ツールで定義されたクライアントEthernetネットワークを介してアクセスされます。管理ドメイン(dom0)およびユーザー・ドメイン(domU's)の両方で、クライアント・ネットワーク構成は、初回のデプロイメント中にOEDAインストール・ツールが最初のユーザー・ドメインを作成すると、自動的に実行されます。

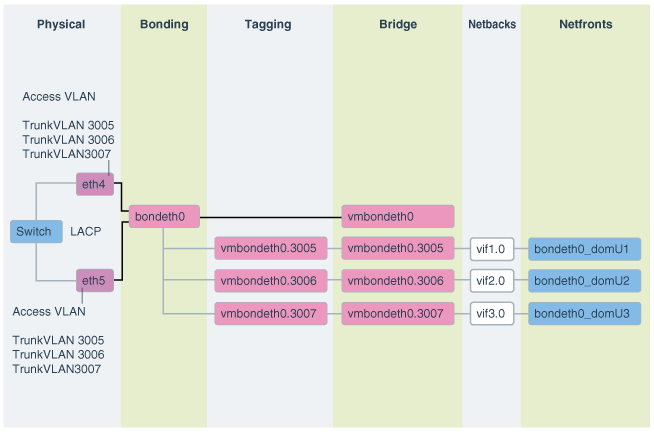

次の図に、デフォルトの結合クライアント・ネットワーク構成を示します。

ネットワークは、次のように構成されます:

dom0では、OEDAで定義されて、domUクライアントへのアクセスが許可されているethスレーブ・インタフェース(たとえば、eth1とeth2またはeth4とeth5)が、検出、構成されて、起動しますが、IPは割り当てられません。

dom0では、bondeth0マスター・インタフェースが構成され、起動しますが、IPは割り当てられません。

dom0では、ブリッジ・インタフェースvmbondeth0が構成されますが、IPは割り当てられません。

dom0では、特定のdomU's bondeth0インタフェースにマッピングされる仮想バックエンド・インタフェース(vif)がdomUごとに1つずつ構成され、起動しますが、IPは割り当てられません。これらのvifsは、ブリッジ・インタフェースvmbondeth0の上に構成されます。dom0 vifインタフェースと、これに対応するユーザー・ドメイン・インタフェース、bondeth0の間のマッピングは、/EXAVMIMAGES/GuestImages/user domain nameにあるvm.cfgと呼ばれるユーザー・ドメイン構成ファイルで定義されます。

デフォルトのインストールでは、単一のbondeth0と対応するvmbondeth0ブリッジ・インタフェースは、前述で説明するようにdom0内で構成されます。このbondeth0インタフェースは、デフォルトのAccess Virtual Local Area Network (Access VLAN)に基づいています。Access VLANに対して、bondeth0を構築するスレーブ・インタフェースで使用されるスイッチ上のポートが構成されます。

VLANタグ付けの使用

Exadataの仮想デプロイメントで、ユーザー・ドメインをまたいでネットワーク分離を有効にするなど、クライアント・ネットワーク上の他のVLANにアクセスする必要がある場合、802.1QベースのVLANタグ付けにより解決できます。次の図に、VLANタグ付けをしたクライアント・ネットワーク構成を示します。

図2-4 VLANタグ付けをしたOracle Virtual EnvironmentのNICレイアウト

このようなクライアント・ネットワーク上の追加のタグ付けされたVLANインタフェースの構成方法および使用方法の手順は、My Oracle Supportノート2018550.1を参照してください。これらの手順の実行の前後に、Access VLANが継続して稼働および構成されている必要があります。Access VLANが無効にされることはありません。

セキュリティの見地から、結合システムの重要な要件の1つは、結合システム内の複数の環境間のネットワーク分離です。Oracle Exadata上でOracle VM Oracle RACクラスタを使用した結合では、これは、1つのOracle RACクラスタのネットワーク・トラフィックが別のOracle RACクラスタにアクセスできないようするなどの、異なるOracle RACクラスタ同士の分離を意味します。Ethernetネットワークでは、これは、My Oracle Support DocID 2018550.1で説明するように、VLANタグ付けを使用して完成します。InfiniBandネットワークでは、これは、カスタムInfiniBandパーティション、専用パーティション鍵およびパーティション化表を使用して完成します。

InfiniBandパーティションは、相互の通信を許可されるInfiniBandノードまたはメンバーのグループを定義します。InfiniBandパーティションでは、一意のパーティション鍵で識別されるパーティションが作成され、マスター・サブネット・マネージャで管理されます。メンバーは、これらのカスタム・パーティションに割り当てられます。パーティション内のメンバーは、メンバー自身同士でのみ通信できます(My Oracle Support DocID 2018550.1の付録1で説明するように、メンバーシップにより異なります)。1つのパーティションのメンバーは、別のパーティションのメンバーとは、メンバーシップにかかわらず、通信できません。これらのラインを継続して、特定の1つのクラスタのOracle VM Oracle RACノードが、クラスタウェア通信用の1つの専用パーティションに割り当てられ、ストレージ・セルとの通信用の1つのパーティションに割り当てられます。このようにして、1つのOracle RACクラスタのノードは、異なるパーティションに属する別のRACクラスタのノードと通信できます。それぞれのOracle RACクラスタのノードには、それらに割り当てられた異なるパーティション鍵があります。

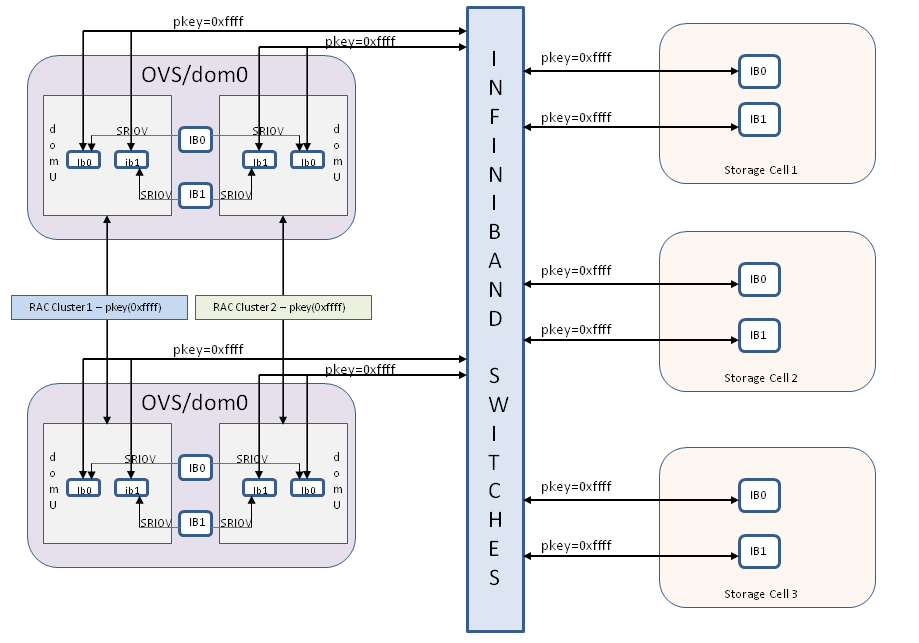

デフォルトで、InfiniBandサブネット・マネージャは、パーティション鍵0x7FFF (制限されたメンバーシップ)または0xFFFF (完全なメンバーシップ)により識別される単一パーティションを提供します。カスタムのInfiniBandパーティションを使用していないOracle Exadata上のOracle VMデプロイメントでは、すべてのユーザー・ドメイン間で、パーティション鍵0xFFFFが使用されます。

図2-5 クラスタ間でInfiniBandネットワーク分離がないOracle Exadata上のOracle VM Oracle RACクラスタ

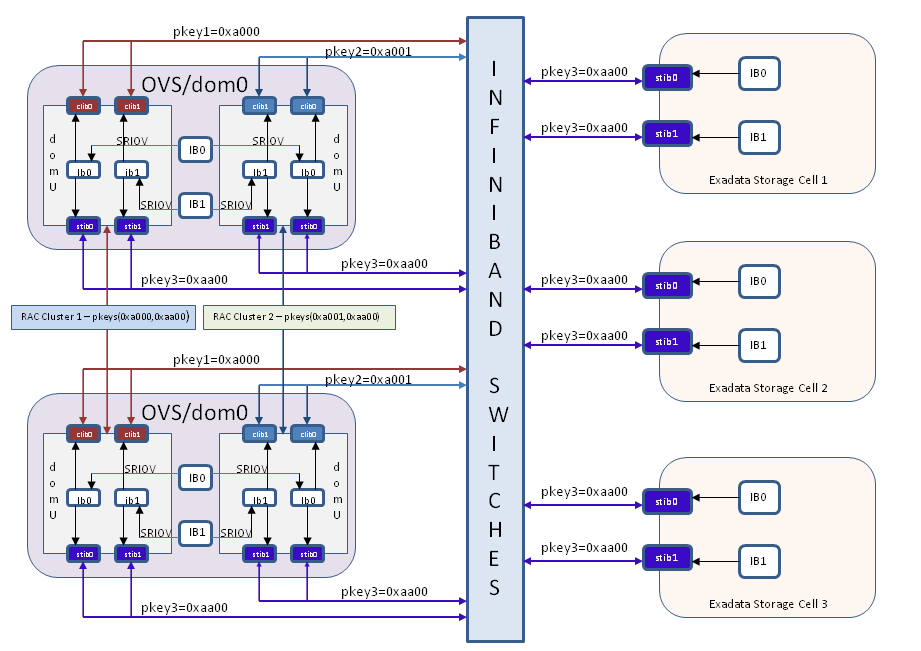

Oracle VM Oracle RACクラスタ間の分離の実装のかわりのデフォルトではないカスタム・パーティションを使用すると、構成は、図2-6に示すように変更されます。新しいインタフェースclib0、clib1 (クラスタpkey用)およびstib0、stib1 (ストレージpkey用)が、それぞれのユーザー・ドメイン(domU's)に存在します。

管理ドメイン(dom0)では、InfiniBandインタフェースの変更はありません。

図2-6 InfiniBandパーティションを使用してクラスタ間でInfiniBandネットワーク分離があるOracle Exadata上のOracle VM Oracle RACクラスタ

InfiniBandパーティションの構成前に、次のことを確認します。

ExadataシステムでOVMを構成しました。

すべてのユーザー・ドメインとストレージ・セルで、デフォルトのパーティション鍵0xFFFFを使用しています。

rootユーザー用に、いずれかの管理ドメイン(dom0ノード)からすべてのOVM RACクラスタ・ノード、ストレージ・セルおよびInfiniBandスイッチへの、パスワードなしのセキュア・シェル(SSH)・アクセスを設定しました。

InfiniBandスイッチがファームウェア・バージョン2.0.4以上で設置されています。

InfiniBandパーティションについて理解しています。

InfiniBandパーティションを実装するには、次の大まかな手順を実行します。

InfiniBandスイッチで、クラスタウェアで使用されるそれぞれのOVM RACクラスタに対して、専用パーティション(クラスタpkey)を作成します。

InfiniBandスイッチで、RACクラスタ・ノードとストレージ・セルとの通信のために、すべてのOVM RACクラスタおよびストレージ・セルで使用される1つのパーティション(ストレージpkey)を作成します。

パーティションごとに、新しいIPoIBネットワーク・インタフェースが必要です。OVM RACノードとストレージ・セルで、新しいIPoIBインタフェースのすべての関連するネットワーク構成ファイルを生成します(前の図のclib0、clib1、stib0、stib1)。

新しく作成したIPoIBインタフェースを使用するように、すべてのOVM RACクラスタのOVM RACクラスタ・ノードとグリッド・インフラストラクチャ構成を変更します。

管理ドメイン(dom0)で、各ユーザー・ドメインのユーザー・ドメイン構成ファイルを、そのユーザー・ドメインに該当するパーティション鍵を使用するように変更します。

新しく作成したIPoIBインタフェースを使用するようにストレージ・セルを変更します。

ストレージ・セルとRACクラスタを再起動して、グリッド・インフラストラクチャとデータベースが機能することを確認します。この一連の手順では、RACクラスタで多少のダウンタイムが発生します。この手順のときにダウンタイムが発生します。

この項では、各手順について詳しく説明します。

pkeyインタフェースによって使用されるIPアドレスを割り当てます。

クラスタにInfiniBandパーティションが実装されたときに、クラスタpkeyインタフェースおよびストレージpkeyインタフェースで使用される各OVM RACクラスタのIPアドレスとネットマスクのセットを計画して割り当てます。

OVM RACクラスタ内では、クラスタpkey IPアドレスおよびネットマスクは、ストレージpkey IPアドレスおよびネットマスクとは別のサブネット上に存在する必要があります。

参考として、次の表に、ある特定のRACクラスタのものを示します。

表2-2 既存の構成

| インタフェース名 | IPアドレス | ネットマスク |

|---|---|---|

ib0 |

192.168.12.153 |

255.255.248.0 |

ib1 |

192.168.12.154 |

255.255.248.0 |

次の表に、この1つのRACクラスタに対してこのドキュメントの手順を実行したときにpkeyインタフェースによって要求される新しいIPアドレスとネットマスクを示します。

表2-3 pkeyインタフェースによって要求される新しいIPアドレスとネットマスク

| インタフェース名 | IPアドレス | ネットマスク |

|---|---|---|

clib0 |

192.168.112.1 |

255.255.248.0 |

clib1 |

192.168.112.2 |

255.255.248.0 |

stib0 |

192.168.114.1 |

255.255.240.0 |

stib1 |

192.168.114.2 |

255.255.240.0 |

InfiniBandスイッチでパーティション鍵を作成して構成します。

rootユーザー用に、いずれかのdom0ノードからInfiniBandファブリックのすべてのスイッチへのパスワードなしのSSH等価を有効化します。これは、この手順のすべてのスクリプトを実行するために使用するノードです。この手順では、このノードをドライバdom0と呼びます。

これを行うには、スクリプトを実行するために使用されるdom0ノードから、次のdcliコマンドを実行します。

# dcli –g <ib_switch_list> -l root –k

<ib_switch_list>は、ファブリックのすべてのInfiniBandスイッチが1つずつ個々の行に記載されたリストが含まれるファイルを示します。

My Oracle Supportノート2075398.1から、create_pkeys.tarをドライバdom0ノードにダウンロードして解凍します。tarファイルを解凍すると、3つのファイルが表示されます。

create_pkeys_on_switch.sh

run_create_pkeys.sh

create_pkey_files.sh

ドライバdom0からスクリプトcreate_pkeys_on_switch.shを実行して、InfiniBandスイッチでパーティション鍵を作成して構成します。

注意:

create_pkeys_on_switch.shを1回実行すると、1つのパーティションが作成されます。作成するパーティションごとにスクリプトを1回実行する必要があります。たとえば、2つのOVM RACクラスタを含む環境に、1つのストレージ・パーティションと2つのクラスタ・パーティション(RACクラスタごとに1つ)の合計3つのパーティションを作成するとします。この例では、create_pkeys_on_switch.shを3回実行する必要があります。

このスクリプトは、1つのみのノード(ドライバdom0)から実行する必要があります。これにより、スクリプトの実行中に入力として指定されたすべてのスイッチにパーティションが作成されます。

スクリプトの完了後に、すべてのスイッチでパーティションが作成されたことを確認します。

# /usr/local/sbin/smpartition list active no-page

この段階で、すべての必要なパーティションを作成したことを確認します。

パーティション鍵を使用するために、OVM RACクラスタ・ノードを構成します。

注意:

この手順では、OVM RACクラスタ・ノードに次の変更を加えます。

次のファイルを変更します。

/etc/sysconfig/network-scripts/ifcfg-ib0

/etc/sysconfig/network-scripts/ifcfg-ib1

次のファイルを削除します。

/etc/sysconfig/network-scripts/rule-ib0

/etc/sysconfig/network-scripts/rule-ib1

/etc/sysconfig/network-scripts/route-ib0

/etc/sysconfig/network-scripts/route-ib1

前述のファイルを変更または削除する前に、スクリプトでこれらを/etc/sysconfig/network-scripts/backup-for-pkeysディレクトリにバックアップします。この手順が失敗した場合は、この手順を再実行する前に、/etc/sysconfig/network-scripts/backup-for-pkeysから/etc/sysconfig/network-scriptsにすべてのファイルをリストアします。

/etc/sysconfig/network-scriptsに次の新しいファイルを作成します。

ifcfg-clib0

ifcfg-clib1

rule-clib0

rule-clib1

route-clib0

route-clib1

ifcfg-stib0

ifcfg-stib1

rule-stib0

rule-stib1

route-stib0

route-stib1

この手順が失敗し、前述のファイルが作成された場合は、この手順を再実行する前にこれらのファイルを削除する必要があります。

手順1で使用したドライバdom0ノードからの、パーティション鍵に対して構成する必要があるすべてのRACクラスタ・ノードおよびストレージ・セルへのパスワードなしのSSHが設定されていることを確認します。

run_create_pkeys.shおよびcreate_pkey_files.shが実行可能で、これらがドライバdom0ノードの同じディレクトリに存在することを確認します。

run_create_pkeys.shを実行します。このスクリプトの構文は次のとおりです。

run_create_pkeys.sh <node_name> <interface_name> <pkey_id> <node_type> <pkey_ipaddr> <pkey_netmask> <pkey_interfaceType>

<node_name>にノード名を指定します。

<interface_name>はib0またはib1のいずれかです。

<pkey_id>に、0xの接頭辞を除いたpkeyを指定します。

<node_type>はcomputeまたはcellのいずれかです。

<pkey_ipaddr>にIPアドレスを指定します。

<pkey_netmask>に、/21などのCIDR形式のネットマスクを指定します。

<pkey_interfaceType>は、computeノード・タイプの場合はclusterまたはstorage、cellノード・タイプの場合はstorageです。

注意:

クラスタpkeyインタフェースのpkey_ipaddrおよびpkey_netmaskは、ストレージpkeyインタフェースのpkey_ipaddrおよびpkey_netmaskとは異なるサブネット上に存在する必要があります。

クラスタ・ノードの場合は、computeのノード・タイプ値を使用して、それぞれのクラスタ・ノードに対して合計4回スクリプトを実行する必要があります。

<pkey_id>は、手順2で入力したクラスタのpkey_idの値から導出されたクラスタのパーティション鍵です。

次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述のコマンドに入力するパーティション鍵の値を導出できます。

FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])

FinalHexValueはここでコマンドに入力される値で、HexValueは手順2で入力したpkey_idの値です。

次の表で、4回の実行について説明します。

表2-4 クラスタ・ノードに対する4回の実行

| 実行 | インタフェース名 | pkey_id | node_type | pkey_ipaddress | pkey_netmask | pkey_interfaceType |

|---|---|---|---|---|---|---|

1 |

ib0 |

クラスタpkey ID |

compute |

ib0のクラスタpkey IPアドレス |

ib0のクラスタpkeyネットマスク |

cluster |

2 |

ib1 |

クラスタpkey ID |

compute |

ib1のクラスタpkey IPアドレス |

ib1のクラスタpkeyネットマスク |

cluster |

3 |

ib0 |

ストレージpkey ID |

compute |

ib0のストレージpkey IPアドレス |

ib0のストレージpkeyネットマスク |

storage |

4 |

ib1 |

ストレージpkey ID |

compute |

ib1のストレージpkey IPアドレス |

ib1のストレージpkeyネットマスク |

storage |

次に例を示します。

# ./run_create_pkeys.sh vm-guest-1 ib0 a000 compute 192.168.12.153 /21 cluster # ./run_create_pkeys.sh vm-guest-1 ib1 a000 compute 192.168.12.154 /21 cluster # ./run_create_pkeys.sh vm-guest-1 ib0 aa00 compute 192.168.114.15 /20 storage # ./run_create_pkeys.sh vm-guest-1 ib1 aa00 compute 192.168.114.16 /20 storage

この段階で、OVM RACクラスタ・ノードの新しいpkey対応ネットワーク・インタフェースに対して、次に示す、すべての必要なネットワーク・ファイルが作成されています。

/etc/sysconfig/network-scripts/ifcfg-clib0

/etc/sysconfig/network-scripts/ifcfg-clib1

/etc/sysconfig/network-scripts/ifcfg-stib0

/etc/sysconfig/network-scripts/ifcfg-stib1

/etc/sysconfig/network-scripts/rule-clib0

/etc/sysconfig/network-scripts/rule-clib1

/etc/sysconfig/network-scripts/rule-stib0

/etc/sysconfig/network-scripts/rule-stib1

/etc/sysconfig/network-scripts/route-clib0

/etc/sysconfig/network-scripts/route-clib1

/etc/sysconfig/network-scripts/route-stib0

/etc/sysconfig/network-scripts/route-stib1

グリッド・インフラストラクチャも変更され、再起動時に新しいネットワーク・インタフェースを使用するようになりました。$GI_HOME/bin/oifcfg getifで、cluster_interconnectに使用されるインタフェースのリストにclib0とclib1が表示されます。

ASMとRDBMSのcluster_interconnectsパラメータを変更します。

SYSとしてsqlplusを使用してRACクラスタの各ASMインスタンスにログインし、次のコマンドを実行します。

alter system set cluster_interconnects='<cluster pkey IP address of ib0>:<cluster pkey IP address of ib1>' scope=spfile sid='<name of the current ASM instance>';

次に例を示します。

alter system set cluster_interconnects='192.168.12.153:192.168.12.154' scope=spfile sid='<name of the current ASM instance>';

sqlplusを使用してRACクラスタの各RDBMSインスタンスにログインし、次のコマンドを実行します。

alter system set cluster_interconnects='<cluster pkey IP address of ib0>:<cluster pkey IP address of ib1>' scope=spfile sid='<name of the current RDBMS instance>';

次に例を示します。

alter system set cluster_interconnects='192.168.12.153:192.168.12.154' scope=spfile sid='<name of the current RDBMS instance>';

すべてのRACクラスタ・ノードでCRS自動起動を停止して無効化します。

# $GI_HOME/bin/crsctl stop crs # $GI_HOME/bin/crsctl disable crs

この段階で、グリッド・インフラストラクチャ、ASMインスタンスおよびRDBMSインスタンスが、新しく作成したネットワーク・インタフェースを使用するように変更されました。

すべてのクラスタ・ノード(ユーザー・ドメイン)のcellip.oraとcellinit.oraを変更します。

すべてのRACクラスタ・ノードの/etc/oracle/cell/network-config/cellip.oraを手動で編集して、既存のIPアドレスを、手順6で設定するすべてのストレージ・セルの2つのストレージpkey IPアドレスに置き換えます。;を使用して2つのIPアドレスを区切ります。

次に、/etc/oracle/cell/network-config/cellip.oraファイルの例を示します。

cell="192.168.114.1;192.168.114.2" cell="192.168.114.3;192.168.114.4" cell="192.168.114.5;192.168.114.6" cell="192.168.114.7;192.168.114.8" cell="192.168.114.9;192.168.114.10" cell="192.168.114.11;192.168.114.12" cell="192.168.114.13;192.168.114.14"

この手順の目的を達成するために、次の手順をお薦めします。クラスタのいずれかのデータベース・サーバー・ノード(OVM RACクラスタのユーザー・ドメイン)で、次の手順を実行します。

次のコマンドを実行します。

# cd /etc/oracle/cell/network-config # cp cellip.ora cellip.ora-bak

cellip.ora-bakを変更します。

rootユーザー用にすべてのクラスタ・ノードからこのクラスタ・ノードへのSSH等価が設定されていることを確認します。

次のコマンドを実行します。<cluster_nodes>は、OVM RACクラスタのすべてのRACクラスタ・ノードの名前が含まれるファイルで、個々の行で各ノードを示します。

# /usr/local/bin/dcli -g <cluster_nodes> –l root "/bin/cp /etc/oracle/cell/network-config/cellip.ora /etc/oracle/cell/network-config/cellip-orig.ora" # /usr/local/bin/dcli -g <cluster_nodes> –l root –f cellip.ora-bak –d /etc/oracle/cell/network-config/cellip.ora

/etc/oracle/cell/network-config/cellinit.oraを/etc/oracle/cell/network-config/cellinit.ora-bakにバックアップします。

/etc/oracle/cell/network-config/cellinit.oraを手動で編集して、既存のIPアドレスおよびネットマスクを、手順3で使用したクラスタ・ノードの2つのストレージpkey IPアドレスおよびネットマスクに置き換えます。このIPアドレスとネットマスクは、手順3の3回目と4回目の実行で使用されています。

dom0のすべての関連するvm.cfgファイルを変更します。この手順はOVM環境にのみ適用できます。

すべてのdom0にログインして、手順2で作成したパーティション鍵を含めるように/EXAVMIMAGES/GuestImages/<user domain name>/vm.cfgを手動で編集します。次の例を参照してください。

次の行を変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':['0xffff',]},{'pf':'40:00.0','port':'2','pkey':['0xffff',]},]

変更後:

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':['0xa000','0xaa00',]},{'pf':'40:00.0','port':'2','pkey':['0xa000','0xaa00',]},]

前述の例では、0xa000が手順2で入力したクラスタpkey_id値から導出されたクラスタのパーティション鍵で、0xaa00がストレージpkey_id値から導出されたストレージのパーティション鍵です。

次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述のvm.cfgに入力するパーティション鍵の値を導出できます。

FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])

FinalHexValueはvm.cfgに入力される値で、HexValueは手順2で入力したpkey_idの値です。

注意:

環境内に複数のOVM RACクラスタがある場合は、すべてのOVM RACクラスタに対して手順3から6が実行された後で、手順7と手順8を1回のみ実行する必要があります。

パーティション鍵を使用するために、ストレージ・セルを構成します。

手順2でrun_create_pkeys.shおよびcreate_pkey_files.shを使用可能にしてあり、かつ、これらが手順2で使用した同じdom0ノードの同じディレクトリに存在することを確認します。

手順2で使用したdom0ノードからの、パーティション鍵に対して構成する必要があるすべてのストレージ・セルへのパスワードなしのSSHが設定されていることを確認します。

そのdom0ノードからrun_create_pkeys.shを実行します。ストレージ・セルのこのスクリプトの構文は次のとおりです。

run_create_pkeys.sh <node_name> <interfaceName> <pkey_id> <node_type> <pkey_ipaddr> <pkey_netmask> <pkey_interfaceType>

<node_name>にノード名を指定します。

<interface_name>はib0またはib1のいずれかです。

<pkey_id>に、0xの接頭辞を除いたpkeyを指定します。

<node_type>はcomputeまたはcellのいずれかです。

<pkey_ipaddr>にIPアドレスを指定します。

<pkey_netmask>に、/21などのCIDR形式のネットマスクを指定します。

<pkey_interfaceType>は、computeノード・タイプの場合はclusterまたはstorage、cellノード・タイプの場合はstorageです。

注意:

前述のコマンドの<pkey_id>は、手順2で入力したストレージのpkey_idの値から導出されたストレージのパーティション鍵です。

次のコマンドを使用すると、手順2で入力したpkey_idの値から、前述のコマンドに入力するパーティション鍵の値を導出できます。

FinalHexValue=$(echo "obase=16;ibase=2;$(expr 1000000000000000 + $(echo "obase=2;ibase=16;$(echo $HexValue|tr [:lower:] [:upper:])"|bc))"|bc|tr [:upper:] [:lower:])

FinalHexValueはコマンドに入力される値で、HexValueは手順2で入力したpkey_idの値です。

ストレージ・セルの場合は、次の表に示すように、cellのnode_typeを使用して、それぞれのストレージ・セルに対して2回スクリプトを実行する必要があります。

表2-5 ストレージ・セルに対する2回の実行

| 実行 | インタフェース名 | pkey_id | node_type | pkey_ipaddress | pkey_netmask | pkey_interfaceType |

|---|---|---|---|---|---|---|

1 |

ib0 |

ストレージpkey ID |

cell |

ib0のストレージpkey IPアドレス |

ib0のストレージpkeyネットマスク |

storage |

2 |

ib1 |

ストレージpkey ID |

cell |

ib1のストレージpkey IPアドレス |

ib1のストレージpkeyネットマスク |

storage |

次に例を示します。

# ./run_create_pkeys.sh cell-1 ib0 aa00 cell 192.168.114.1 /20 storage # ./run_create_pkeys.sh cell-1 ib1 aa00 cell 192.168.114.2 /20 storage

注意:

スクリプトからの次のメッセージは無視できます。手順9のストレージ・セルの再起動でこれらの項目が考慮されます。

Network configuration altered. Please issue the following commands as root to restart the network and open IB stack:

service openibd restart

service network restart

A restart of all services is required to put new network configuration into effect. MS-CELLSRV communication may be hampered until restart.

この段階で、ストレージ・セルが、再起動時に新しいネットワーク・インタフェースを使用するように変更されました。

ストレージ・セルの/opt/oracle.cellos/cell.confを変更して、ストレージ・セルを再起動します。

/opt/oracle.cellos/cell.confをバックアップします。

# cp /opt/oracle.cellos/cell.conf /opt/oracle.cellos/cell.conf-prepkey

/opt/oracle.cellos/cell.confの次の行を変更します。

次の行を変更します。

<Pkeyconfigured>no</Pkeyconfigured>

変更後:

<Pkeyconfigured>yes</Pkeyconfigured>

2つのプライベート・インタフェース、ib0とib1について、次の行を変更します。

<IP_enabled>yes</IP_enabled>

変更後:

<IP_enabled>no</IP_enabled>

すべてのOVM RACノードでグリッド・インフラストラクチャが停止していることを確認します。

すべてのストレージ・セル・サーバーを再起動します。

ストレージ・セルが再度稼働したら、新しいpkey対応ネットワーク・インタフェースが使用中であることを確認します。

# cellcli -e list cell detail | egrep 'interconnect|ipaddress'

これにより、新しいpkey対応インタフェース(stib0およびstib1)が新しいIPアドレスのセットとともに表示されます。

クラスタ・ノードを再起動します。

各ユーザー・ドメイン・ノードの対応するdom0にログインします。

次のコマンドを実行します。

# xm shutdown <user domain name> # xm create /EXAVMIMAGES/GuestImages/<user domain name>/vm.cfg

すべてのクラスタ・ノードで、Grid Infrastructureスタックを起動し、完全に稼働していることを確認します。

すべてのRACクラスタ・ノードで、Grid Infrastructureスタックを起動し、自動起動を有効化します。

# $GI_HOME/bin/crsctl start crs # $GI_HOME/bin/crsctl enable crs

すべてのノードでグリッド・インフラストラクチャが完全に稼働したら、新しく構成したpkeyインタフェースを使用するようにcluster_interconnectsパラメータが設定されていることを確認します。

SQL> select inst_id, value from gv$parameter where name = 'cluster_interconnects'

OCRから、古いクラスタ相互接続インタフェースを削除します。

# $GI_HOME/bin/oifcfg delif –global ib0/<old subnet> # $GI_HOME/bin/oifcfg delif –global ib1/<old subnet>

2016年10月の12.1.0.2データベース・バンドル・パッチでセキュリティ拡張機能が導入され、2016年10月の12.1.0.2バンドル・パッチより前に使用されていた完全なメンバーシップのかわりに、制限されたメンバーシップを使用して、データベース・ノードのGUIDをストレージpkeyに割り当てることができます。これは、ストレージpkeyインタフェースを使用するとあるRACクラスタのあるRACノードが別のRACクラスタのRACノードと通信できるセキュリティ上の問題の対策になります。

完全なメンバーシップと制限されたメンバーシップ

InfiniBandパーティションは、相互の通信を許可されるInfiniBandノードのグループを定義します。InfiniBandパーティションで、マスター・サブネット・マネージャによって管理されるカスタムまたは一意のパーティション鍵を定義して、カスタムのパーティション鍵にメンバーを割り当てます。同じパーティション鍵を持つメンバーのみが相互に通信できます。1つのパーティション鍵のメンバーは、別のパーティション鍵を持つメンバーとは、メンバーシップのタイプにかかわらず、通信できません。1つのクラスタのOVM RACクラスタ・ノードには、クラスタウェア通信用の1つのパーティション鍵と、ストレージ・セルとの通信用の別のパーティション鍵が割り当てられます。このように、RACクラスタのノードは、異なるパーティション鍵が割り当てられた別のRACクラスタのノードとは通信できません。このことは、イーサネットの分野のタグ付けされたVLANと概念的に非常に似ています。

パーティション鍵(pkey)は15ビットの整数で、0x1から0x7FFFの値を持ちます。追加のビットであるメンバーシップ・ビットによって、パーティションのメンバーのメンバーシップが識別されます。メンバーシップは次のとおりです。

完全: メンバーシップ・ビットは1に設定されます。完全なメンバーシップを持つメンバーは、相互に通信できることに加えて、同じパーティション鍵内の制限されたメンバーシップを持つメンバーと通信できます。

制限: メンバーシップ・ビットは0に設定されます。パーティション内の制限されたメンバーシップを持つメンバーは、相互に通信できません。ただし、同じパーティション内の完全なメンバーシップを持つ他のメンバーと通信できます。

pkeyとメンバーシップ・ビットが組み合されて16ビットの整数を構成します。最も重要なビットはメンバーシップ・ビットです。

デフォルトで、InfiniBandサブネット・マネージャは、パーティション鍵0x7FFF (制限されたメンバーシップ)または0xFFFF (完全なメンバーシップ)により識別される単一パーティションを提供します。

HCAポートは、最大で128個のパーティションに参加できます。それぞれのパーティション鍵で新しいIPoIBネットワーク・インタフェースが提供されます。たとえば、パーティション鍵0xa001を持つInfiniBandポート1が新しいネットワーク・インタフェースになります。これらのインタフェースには、ifcfg-<interface>ファイル・パラメータによって意味のある名前が付けられます。

1つのInfiniBandノードを複数のパーティションのメンバーにできます。パケットがデータベース・ノードに到着すると、パケットのパーティション鍵(pkey)がサブネット・マネージャ構成と照合されます。この検証により、データベース・ノードが、それがメンバーになっているパーティションの外部の別のデータベース・ノードと通信できなくなります。

InfiniBandファブリック内のすべてのノードには、/sys/class/infiniband/mlx4_0/ports/[1-2]/pkeysで確認できるパーティション鍵の表があります。ノードのそれぞれのキュー・ペア(QP)には、その表の1つのエントリにマッピングされる索引(pkey)が関連付けられています。QPの送信キューからパケットが送信される場合は、索引付きのpkeyが添付されます。QPの受信キューでパケットを受信した場合は、索引付きのpkeyが受信パケットのものと比較されます。一致しない場合、パケットは警告なしで破棄されます。受信チャネル・アダプタはその到着を認識せず、同様に送信チャネル・アダプタも受信確認を取得しません。送信済パケットは単に失われたパケットとして示されます。受信パケットのpkeyがQPの受信キューの索引付きのpkeyと一致した場合にのみ、ハンドシェイクが行われてパケットが受け入れられ、送信チャネル・アダプタに確認が送信されます。このようにして、同じパーティションのメンバーのみが相互に通信でき、そのパーティションのメンバーではないホスト(つまり、パーティション表にそのpkeyを持たないホスト)とは通信できないようになっています。

次の手順で、2016年10月の12.1.0.2データベース・バンドル・パッチが適用されたpkey対応環境でこの拡張機能を設定する方法について説明します。次で説明するように、考えられるシナリオは2つあります。

ケース1.ローリング形式によるpkey対応環境での機能の実装

このケースでは、すでに2016年10月の12.1.0.2データベース・バンドル・パッチを適用しています。

次の手順を、1回に1つのノードに実行します。

ノードでグリッド・インフラストラクチャを停止します。

# $GI_HOME/bin/crsctl stop crs

このユーザー・ドメインのOVM RACクラスタ・ノードを管理するdom0 (制御ドメイン)の2つのポートのGUIDを特定します。

# /usr/sbin/ibstat | grep Port

SMマスターがrootとして実行されているInfiniBandスイッチにログインします。

InfiniBandスイッチで次のコマンドを実行します。

# /usr/local/sbin/smpartition start # /usr/local/sbin/smpartition modify -n <storage pkey name> -port <Port GUID1 of the dom0 from step 2> -m limited # /usr/local/sbin/smpartition modify -n <storage pkey name> -port <Port GUID2 of the dom0 from step 2> -m limited # /usr/local/sbin/smpartition commit

dom0のこのOVM RACユーザー・ドメイン・ノードのvm.cfgファイルを変更します。

rootとしてdom0にログインします。

/EXAVMIMAGES/GuestImages/<user domain name>/vm.cfgを編集して、次の例に示すようにパーティション鍵を変更します。

次の行を変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':[ '0xclpkey','0x<stpkey>',]},{'pf':'40:00.0','port':'2','pkey':[ '0xclpkey','0x<stpkey>',]},]

次のように変更します。

ib_pkeys = [{'pf':'40:00.0','port':'1','pkey':[ '0xclpkey','0x<mod_stpkey>',]},{'pf':'40:00.0','port':'2','pkey':[ '0xclpkey','0x<mod_stpkey>',]},]

<mod_stpkey>は、次の式を使用して<stpkey>から導出されます。

mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])

前述の式の<stpkey>と<mod_stpkey>は、0xの接頭辞なしで指定されています。

ユーザー・ドメインのRACノードの/etc/sysconfig/network-scripts/ifcfg-stib*ファイルを変更します。

次の式を使用して、これらのファイルのPKEY_IDを編集します。

mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])

mod_stpkeyが新しいPKEY_IDで、stpkeyが古いPKEY_IDです。

前述の式の<stpkey>と<mod_stpkey>は、0xの接頭辞なしで指定されています。

ユーザー・ドメインのRACノードの/opt/oracle.cellos/pkey.confを変更します。

ストレージ・ネットワークpkeyインタフェース(stib*)のPkeyを編集します。

変更前:

<Pkey>0xstpkey</Pkey>

変更後:

<Pkey>0xmod_stpkey</Pkey>

mod_stpkeyは、次の式を使用してstpkeyから導出されます。

mod_stpkey=$(echo "obase=16;ibase=2;$(expr $(echo "obase=2;ibase=16;$(echo $stpkey|tr [:lower:] [:upper:])"|bc) - 1000000000000000)"|bc|tr [:upper:] [:lower:])

前述の式で使用されているstpkeyとmod_stpkeyは、0xの接頭辞なしで指定されています。

OVM RACユーザー・ドメイン・ノードを再起動します。

rootとしてdom0にログインします。

次のコマンドを実行します。

# xm shutdown <user domain name> # xm create /EXAVMIMAGES/GuestImages/<user domain name>/vm.cfg

クラスタ・ノードでGrid Infrastructureスタックが完全に稼働していることを確認します。

残りのクラスタ・ノードに対して、1回に1つのノードでこの手順を繰り返します。

ケース2.ローリング形式による2016年10月の12.1.0.2データベース・バンドル・パッチの適用中のpkey対応環境での機能の実装

次の手順を、1回に1つのノードに実行します。

クラスタ・ノードで2016年10月の12.1.0.2データベース・バンドル・パッチを適用します。

パッチが適用されたノードで前述のケース1の手順1から10を繰り返します。

次のクラスタ・ノードに進み、前述の手順1および2を繰り返します。

注意:

dom0のGUIDが制限されたメンバーシップに変換された後、すべての新しいクラスタのデプロイメントには、2016年10月のデータベース・バンドル・パッチが前提条件として含められるようになります。

Exadataでの仮想化は、Oracle EXAchkバージョン12.1.0.2.2以上でサポートされています。

Oracle Exadata Oracle VM環境でOracle EXAchk監査チェックの完全なセットを実行するには、Oracle EXAchkをインストールして、次のように複数の場所から実行する必要があります。

1つの管理ドメイン(dom0)から

Oracle VM Oracle RACクラスタごとに1つのユーザー・ドメイン(domU)から

たとえば、4つのOracle VM Oracle RACクラスタを含む2つのデータベース・サーバー(両方のデータベース・サーバーで合計8つのdomU、クラスタごとに2つのノード)を使用したOracle Exadata Database Machineクオータ・ラックでは、次のようにOracle EXAchkを5回実行する必要があります。

クラスタ#1の最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

クラスタ#2の最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

クラスタ#3の最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

クラスタ#4の最初のユーザー・ドメイン(domU)でOracle EXAchkを実行します。

最初の管理ドメイン(dom0)でOracle EXAchkを実行します。

Oracle EXAchkによって実行される監査チェックは、次の表に指定されています。

表2-6 Oracle EXAchkによって実行される監査チェック

| Oracle EXAchkのインストールおよび実行先 | 実行される監査チェック |

|---|---|

管理ドメイン(dom0) |

ハードウェアおよびオペレーティング・システム・レベルのチェック対象:

|

ユーザー・ドメイン(domU) |

ユーザー・ドメインのオペレーティング・システム・レベル・チェックおよびOracle Grid InfrastructureおよびOracle Databaseのチェック |

Oracle EXAchkコマンドラインのオプション

Oracle EXAchkには、専用のコマンドライン・オプションが不要です。Oracle Exadata Oracle VM環境で実行されていること、および管理ドメインまたはユーザー・ドメインで実行されているかどうかを自動的に検出し、適用可能な監査チェックを実行します。たとえば、最も簡単なケースとして、コマンドライン・オプションなしでOracle EXAchkを実行できます。

./exachk

Oracle EXAchkが管理ドメインで実行されると、すべてのデータベース・サーバー、ストレージ・サーバー、およびInfiniBandネットワーク経由でアクセス可能なInfiniBandスイッチで監査チェックを実行します。

サーバーまたはスイッチのサブセットでOracle EXAchkを実行するには、次のコマンドライン・オプションを使用します。

表2-7 Oracle EXAchkのコマンドライン・オプション

| オプション | 説明 |

|---|---|

|

データベース・サーバーのカンマ区切りリストを指定します。 |

|

ストレージ・サーバーのカンマ区切りリストを指定します。 |

|

InfiniBandスイッチのカンマ区切りリストを指定します。 |

たとえば、最初のクオータ・ラックのみが仮想化用に構成されているが、InfiniBandネットワーク経由ですべてのコンポーネントにアクセス可能なOracle Exadata Database Machineのフル・ラックの場合、データベース・サーバーdm01adm01から次のようなコマンドを実行できます。

./exachk -clusternodes dm01adm01,dm01adm02 -cells dm01celadm01,dm01celadm02,dm01celadm03 -ibswitches dm01swibs0,dm01sw-iba0,dm01sw-ibb0

関連トピック

この項では、データベース・サーバー内の論理ボリューム・マネージャ(LVM)パーティションについて説明します。LVMにはパーティションを再編成する柔軟性があります。

注意:

ソフトウェア保守の際にdbnodeupdate.shユーティリティで作成されるLVMスナップショットのために、VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

この項では、次の項目について説明します。

ルートLVMパーティションを拡張する手順は、Oracle Exadata Storage Server Softwareのリリースにより異なります。次の各項では、手順をリリースごとに説明します。

次の手順では、Oracle Exadata Storage Server Softwareリリース11.2.3.2.1以上を実行するシステム上で、ルート(/)パーティションのサイズを拡大する方法について説明します。

注意:

この手順では、サーバーを停止する必要はありません。

dom0システムの場合、アクティブのSys LVMと非アクティブのSys LVMは、LVDbSys1とLVDbSys2ではなく、LVDbSys2とLVDbSys3です。

LVDbSys1およびLVDbSys2のサイズが同じに設定されていることを確認します。

次のように、現在の環境に関する情報を収集します。

次のように、dfコマンドを使用して、rootパーティション(/)内の空き領域および使用済領域の容量を確認します。

# df -h /

次に、コマンドの出力例を示します。

Filesystem Size Used Avail Use% Mounted on

/dev/mapper/VGExaDb-LVDbSys1

30G 22G 6.2G 79% /

注意:

アクティブなrootパーティションは、それ以前の保守アクティビティによりLVDbSys1またはLVDbSys2のいずれかに決定されます。

lvsコマンドを使用して、現在のボリューム構成を表示します。

# lvs -o lv_name,lv_path,vg_name,lv_size

次に、コマンドの出力例を示します。

LV Path VG LSize LVDbOra1 /dev/VGExaDb/LVDbOra1 VGExaDb 100.00g LVDbSwap1 /dev/VGExaDb/LVDbSwap1 VGExaDb 24.00g LVDbSys1 /dev/VGExaDb/LVDbSys1 VGExaDb 30.00g LVDbSys2 /dev/VGExaDb/LVDbSys2 VGExaDb 30.00g LVDoNotRemoveOrUse /dev/VGExaDb/LVDoNotRemoveOrUse VGExaDb 1.00g

tune2fsコマンドを使用して、オンラインのサイズ変更オプションを確認します。

tune2fs -l /dev/mapper/vg_name-lv_name | grep resize_inode

次に例を示します。

tune2fs -l /dev/mapper/VGExaDb-LVDbSys1 | grep resize_inode

resize_inodeオプションが、コマンド出力に表示されます。オプションが表示されない場合、パーティションのサイズ変更の操作をする以前に、ファイル・システムがアンマウントしています。「Oracle Exadata Storage Server Softwareリリース11.2.3.2.1より前のリリースを実行するシステムでの、ルートLVMパーティションの拡張」を参照して、パーティションのサイズを変更してください。

ボリューム・グループVGExaDbの使用可能な領域を確認するには、次のように、vgdisplayコマンドを使用します。

# vgdisplay -s

次に、コマンドの出力例を示します。

"VGExaDb" 834.89 GB [184.00 GB used / 650.89 GB free]

ボリューム・グループは、二つのシステム・パーティションのサイズを増やすことができる空き領域を持ち、アップグレードの際にdbnodeupdate.shユーティリティで作成されるLVMスナップショットで使用するために、少なくとも1GBの空き領域を維持する必要があります。

十分な空き領域がない場合、reclaimdisks.shユーティリティが実行中であるかどうか確認してください。ユーティリティが実行されていない場合、次のコマンドを実行して、ディスク領域をリクレイムします。

# /opt/oracle.SupportTools/reclaimdisks.sh -free -reclaim

ユーティリティが実行中で、十分な空き領域がない場合、LVMはサイズ変更できません。

注意:

reclaimdisks.shは、RAID再構築(ディスクの置換えまたは拡張)と同時に実行できません。RAID再構築が完了するまで待機してから、reclaimdisks.shを実行してください。

LVDbSys1およびLVDbSys2論理ボリュームのサイズを変更するには、次のように、lvextendコマンドを使用します。

# lvextend -L +XG --verbose /dev/VGExaDb/LVDbSys1 # lvextend -L +XG --verbose /dev/VGExaDb/LVDbSys2

前述のコマンドのXGは、拡大される論理ボリュームの量(GB)です。いずれのシステム・パーティションにも、等しい容量の領域を追加します。

次の例では、拡大する論理ボリュームは10GBです。

# lvextend -L +10G /dev/VGExaDb/LVDbSys1 # lvextend -L +10G /dev/VGExaDb/LVDbSys2

論理ボリューム内のファイル・システムのサイズを変更するには、次のように、resize2fsコマンドを使用します。

# resize2fs /dev/VGExaDb/LVDbSys1 # resize2fs /dev/VGExaDb/LVDbSys2

dfコマンドを使用して、アクティブなシステム・パーティションで領域が拡大されたことを確認します。

# df -h /

次の手順では、Oracle Exadata Storage Server Softwareリリース11.2.3.2.1より前のリリースを実行するシステム上で、ルート(/)パーティションのサイズを拡大する方法について説明します。

注意:

この手順では、システムをオフラインにしてから再起動する必要があります。

ソフトウェア保守の際にdbnodeupdate.shユーティリティで作成されるLVMスナップショットのために、VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

dom0システムの場合、アクティブのSys LVMと非アクティブのSys LVMは、LVDbSys1とLVDbSys2ではなく、LVDbSys2とLVDbSys3です。

LVDbSys1およびLVDbSys2のサイズが同じに設定されていることを確認します。

次のように、現在の環境に関する情報を収集します。

dfコマンドを使用して、ルート・パーティション(/)およびルート以外のパーティション(/u01)のマウント・ポイント、およびそれぞれのLVMを確認します。次に、コマンドの出力例を示します。

# df Filesystem 1K-blocks Used Available Use% Mounted on /dev/mapper/VGExaDb-LVDbSys1 30963708 21867152 7523692 75% / /dev/sda1 126427 16355 103648 14% /boot /dev/mapper/VGExaDb-LVDbOra1 103212320 67404336 30565104 69% /u01 tmpfs 84132864 3294608 80838256 4% /dev/shm

dfコマンド出力のファイル・システム名は次のような形式になります。

/dev/mapper/VolumeGroup-LogicalVolune

前述の例のルート・ファイル・システムの完全論理ボリューム名は/dev/VGExaDb/LVDbSys1になります。

次のように、lvscanコマンドを使用して、論理ボリュームを表示します。

#lvm lvscan ACTIVE '/dev/VGExaDb/LVDbSys1' [30.00 GB] inherit ACTIVE '/dev/VGExaDb/LVDbSwap1' [24.00 GB] inherit ACTIVE '/dev/VGExaDb/LVDbOra1' [100.00 GB] inherit

lvdisplayコマンドを使用して、現在の論理ボリュームおよびボリューム・グループ構成を表示します。

#lvm lvdisplay /dev/VGExaDb/LVDbSys1 --- Logical volume --- LV Name /dev/VGExaDb/LVDbSys1 VG Name VGExaDb LV UUID GScpD7-lKa8-gLg9-oBo2-uWaM-ZZ4W-Keazih LV Write Access read/write LV Status available # open 1 LV Size 30.00 GB Current LE 7680 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 256 Block device 253:0

論理ボリュームを拡大できるように、ボリューム・グループVGExaDbに使用可能な領域があることを確認します。コマンドで空き領域がゼロと表示された場合は、論理ボリュームまたはファイル・システムは拡大できません。

# lvm vgdisplay VGExaDb -s "VGExaDb" 556.80 GB [154.00 GB used / 402.80 GB free]

次のように、システムを診断モードで再起動します。

ILOMインタフェースを使用して、/opt/oracle.SupportTools/diagnostics.isoファイルをマシンのディレクトリにコピーします。

ILOM Webインタフェースにログインします。

リモート制御タブを選択します。

リダイレクトタブを選択します。

リモート・コンソールの起動をクリックします。ILOMリモート・コンソールウィンドウが表示されます。

ILOMリモート・コンソールウィンドウで、「デバイス」メニューを選択します。

CD-ROMイメージをクリックします。

ファイルのオープンダイアログ・ボックスで、ローカル・マシンのdiagnostics.isoファイルの場所に移動します。

diagnostics.isoファイルを選択します。

「開く」をクリックします。次のようなメッセージがコンソールに表示されます。

リモート制御タブからホスト制御を選択します。

次の起動デバイスとしてCDROMを値リストから選択します。

「保存」をクリックします。システムがブートすると、diagnostics.isoイメージが使用されます。システムは次の再起動後にデフォルトに戻ります。

ILOMリモート・コンソールウィンドウで、rootユーザーとしてログインします。

次のコマンドを使用して、サーバーを再起動します。

# shutdown -r now

システムはdiagnostics.isoイメージを使用し始めます。

次のように、eを入力して、診断シェルに入ります。

Choose from following by typing letter in '()': (e)nter interactive diagnostics shell. Must use credentials from Oracle support to login (reboot or power cycle to exit the shell), (r)estore system from NFS backup archive, Select:e

rootユーザーとしてシステムにログインします。パスワードを要求されます。

localhost login: root Password: ********* -sh-3.1#

次のコマンドを使用して、rootファイル・システムをアンマウントします。

# cd / # umount /mnt/cell

次のコマンドを使用して、論理ボリューム名を確認します。

# lvm lvscan ACTIVE '/dev/VGExaDb/LVDbSys1' [30.00 GB] inherit ACTIVE '/dev/VGExaDb/LVDbSwap1' [24.00 GB] inherit ACTIVE '/dev/VGExaDb/LVDbOra1' [100.00 GB] inherit

次のコマンドを使用して、現在のルート・ファイル・システムとバックアップ・ルート・ファイル・システムを保持するLVDbSys1とLVDbSys2のサイズを変更します。

# lvm lvextend -L+XG --verbose /dev/VGExaDb/LVDbSys1 # lvm lvextend -L+XG --verbose /dev/VGExaDb/LVDbSys2

前述のコマンドのXGは、拡大される論理ボリュームの量(GB)です。たとえば、論理ボリュームを5 GB拡大する場合、コマンドは次のようになります。

# lvm lvextend -L+5G --verbose /dev/VGExaDb/LVDbSys1 # lvm lvextend -L+5G --verbose /dev/VGExaDb/LVDbSys2

fsck.ext3またはfsck.ext4を使用して、ファイル・システムが有効であることを確認します。使用するコマンドはファイル・システムのタイプによって異なります。

# fsck.ext3 -f /dev/VGExaDb/LVDbSys1 # fsck.ext3 -f /dev/VGExaDb/LVDbSys2

または

# fsck.ext4 -f /dev/VGExaDb/LVDbSys1 # fsck.ext4 -f /dev/VGExaDb/LVDbSys2

次のコマンドを使用して、ファイル・システムのサイズを変更します。

# resize2fs -p /dev/VGExaDb/LVDbSys1 # resize2fs -p /dev/VGExaDb/LVDbSys2

システムを通常のモードで再起動します。

# reboot

システムにログインします。

ルート・ファイル・システム・マウントが新しいサイズで問題なくマウントされていることを確認します。

ルート以外のLVMパーティションのサイズを変更する手順は、Oracle Exadata Storage Server Softwareのリリースにより異なります。次の各項では、手順をリリースごとに説明します。

この手順では、Oracle Exadata Storage Server Softwareリリース11.2.3.2.1以降を実行するシステム上で、非ルート(/u01)パーティションのサイズを拡大する方法について説明します。

この手順では、サーバーを停止する必要はありません。

この手順では、Oracle Exadata Storage Server Softwareリリース11.2.3.2.1より前のリリースを実行するシステム上で、非ルート(/u01)パーティションのサイズを拡大する方法について説明します。

ここでは、/dev/VGExaDb/LVDbOra1が/u01でマウントされます。

注意:

ソフトウェア保守の際にdbnodeupdate.shユーティリティで作成されるLVMスナップショットのために、VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

この手順では、スワップ(/swap)パーティションのサイズを拡大する方法について説明します。

注意:

この手順では、システムをオフラインにしてから再起動する必要があります。

ソフトウェア保守の際にdbnodeupdate.shユーティリティで作成されるLogical Volume Manager (LVM)スナップショットのために、VGExaDbボリューム・グループ内に、少なくとも1GBの空き領域が必要です。「Oracle Linuxデータベース・サーバーのスナップショット・ベースのバックアップの作成」の手順に従い、/ (root)および/u01ディレクトリのバックアップをスナップショット・ベースで作成する場合、VGExaDbボリューム・グループに少なくとも6GBの空き領域が必要です。

データベース・サーバーのソフトウェアの重要な変更の前後にバックアップを行う必要があります。たとえば、次の手順の前後にバックアップを作成する必要があります。

オペレーティング・システム・パッチの適用

Oracleパッチの適用

重要な操作パラメータの再構成

重要なOracle以外のソフトウェアのインストールまたは再構成

この項では、次の項目について説明します。

この手順は、スナップショット・ベースのバックアップを取得する方法を示しています。手順で示す値は、例です。

元の出荷時の構成からデータベース・サーバー・パーティションをカスタマイズしていない場合、この項の手順を使用してバックアップを作成し、そのバックアップを使用してデータベース・サーバーをリストアします。

注意:

リカバリ手順により、出荷時の名前およびサイズを含む正確なパーティションがリストアされます。パーティションを少しでも変更した場合、この手順は使用できません。変更には、サイズや名前の変更、パーティションの追加または削除が含まれます。

rootユーザーとして、すべての手順を実行する必要があります。

Oracle Virtual Serverデプロイメントで、管理ドメイン(dom0)とユーザー・ドメイン(domU)をバックアップする必要があります。

次の手順は、管理ドメインdom0のスナップショット・ベースのバックアップを取得する方法を示しています。次の手順で示す値は、例です。

rootユーザーとして、すべての手順を実行する必要があります。

バックアップの保存先を準備します。

バックアップ先は、書込み可能なNFSの場所など、ローカル・マシンの外部に存在するようにし、バックアップtarファイルを保持できる十分な大きさにする必要があります。カスタマイズされていないパーティションの場合、バックアップを保持するのに必要な領域は約60 GBです。

次のコマンドを使用してバックアップ先を準備できます。

# mkdir -p /remote_FS # mount -t nfs -o rw,intr,soft,proto=tcp,nolock ip_address:/nfs_location/ /remote_FS

ip_addressは、NFSサーバーのIPアドレスで、nfs_locationは、バックアップを保持するNFSの場所です。

/ (ルート)ディレクトリをホストするファイル・システムのスナップショット・ベースのバックアップを取得します。

/ (ルート)ディレクトリをホストするファイル・システムに、LVDbSys3_snapという名前のスナップショットを作成します。このコマンドでは、LVDbSys3がアクティブ・パーティションであることを前提とします。

# lvcreate -L1G -s -n LVDbSys3_snap /dev/VGExaDb/LVDbSys3

スナップショットにラベルを付けます。

# e4label /dev/VGExaDb/LVDbSys3_snap DBSYSOVS_SNAP

スナップショットをマウントします。

# mkdir /root/mnt # mount /dev/VGExaDb/LVDbSys3_snap /root/mnt -t ext4

バックアップのディレクトリに変更します。

# cd /root/mnt

バックアップ・ファイルを作成します。

# tar -pjcvf /remote_FS/mybackup.tar.bz2 * /boot > /tmp/backup_tar.stdout 2> /tmp/backup_tar.stderr

/tmp/backup_tar.stderrファイルをチェックして、重大なエラーがないかを確認します。tarオープン・ソケットの障害に関するエラーおよび他の同様のエラーは無視できます。

スナップショットをアンマウントして、ルート・ディレクトリのスナップショットを削除します。

# cd / # umount /root/mnt # /bin/rmdir /root/mnt # lvremove /dev/VGExaDb/LVDbSys3_snap

次のコマンドを使用して、NFS共有をアンマウントします。

# umount /remote_FS

ユーザー・ドメインのバックアップ方法は2つあります。

方法1: Oracle Cluster File System (OCFS) reflinkを使用して記憶域リポジトリをバックアップし、一貫性のあるバックアップを取得する

この方法では、/EXAVMIMAGES ocfs2ファイル・システムである記憶域リポジトリをバックアップします。

dom0によって管理されるすべてのユーザー・ドメインをバックアップする、/EXAVMIMAGES全体をバックアップしたり、バックアップするユーザー・ドメインを選択したりできます。ユーザー・ドメインは、/EXAVMIMAGES/GuestImages/userディレクトリにあります。

この方法では、方法2よりもより堅牢で包括的なバックアップが可能です。方法2は、特にロール別に分離された環境で、迅速で簡単なバックアップ方法が提供されます。

方法1は、dom0管理者がユーザー・ドメインのバックアップを担当している場合に最適です。

方法2: スナップショット・ベースのバックアップを使用してユーザー・ドメインをバックアップする

この方法では、ユーザー・ドメイン内部からスナップショット・ベースのバックアップを作成することで、単一のユーザー・ドメインをバックアップします。

方法2は、ユーザー・ドメイン管理者がユーザー・ドメインのバックアップを担当している場合に最適です。

/EXAVMIMAGES OCFS2ファイル・システムである記憶域リポジトリをバックアップすることができます

次に示す手順ではすべてのユーザー・ドメインがバックアップされます。

次のサンプル・コマンドは、前述の手順2から6にリストされている操作の参照として使用できます。

## Create the Backup Directory

find /EXAVMIMAGES -type d|grep -v 'lost+found'|awk '{print "mkdir -p /EXAVMIMAGES/Backup"$1}'|sh

## Pause user domains

xm list|egrep -v '^Domain-0|^Name'|awk '{print "xm pause",$2}'|sh

## Create Reflinks for all the files to be backed up

find /EXAVMIMAGES/ -type f|awk '{print "reflink",$0,"/EXAVMIMAGES/Backup"$0}'|sh

## Unpause user domains

xm list|egrep -v '^Domain-0|^Name'|awk '{print "xm unpause",$2}'|sh;

## Backup from the reflinks

pushd /EXAVMIMAGES/Backup/EXAVMIMAGES

tar -Spcvf /remote_FS/exavmimages-sparse.tar * 1> /tmp/Backup.log 2> /tmp/Backup.err

popd

rm -rf /EXAVMIMAGES/Backup/*

次の手順は、ユーザー・ドメイン内からユーザー・ドメインのスナップショット・ベースのバックアップを取得する方法を示しています。

注意:

LVMスナップショットを使用してユーザー・ドメイン内からユーザー・ドメインをバックアップする方法では、リカバリ時の使用に関して制限があります。このようなバックアップは、ユーザー・ドメインがまだブート可能で、rootユーザーとしてログインできる場合のリカバリ用にのみ使用できます。これは、一部のファイルに損失または損傷が発生したが、ユーザー・ドメインがブートされ、/ (ルート)パーティションがマウントされた後に、tarバックアップからリストアできるような損傷です。そのような状況ではなくユーザー・ドメインをブートできない損傷の場合は、上述の方法1で作成したバックアップを使用してユーザー・ドメインをリカバリする必要があります。この場合は次の手順を実行して、ユーザー・ドメイン・レベルでリカバリ手順を実行する必要があります。

すべての手順はユーザー・ドメイン内から実行します。

この手順では、次がバックアップされます。

LVDbSys1 lvm

LVDbOra1 lvm

/bootパーティション

Grid Infrastructureホーム

RDBMSホーム

rootユーザーとして、すべての手順を実行する必要があります。

バックアップの保存先を準備します。

# mkdir -p /remote_FS # mount -t nfs -o rw,intr,soft,proto=tcp,nolock ip_address:/nfs_location/ /remote_FS

ip_addressは、NFSサーバーのIPアドレスで、nfs_locationは、バックアップを保持するNFSの場所です。

次のように、/ (ルート)および/u01ディレクトリを含むファイル・システムのスナップショット・ベースのバックアップを取得します。

ルート・ディレクトリを含むファイル・システムに、LVDbSys1_snapと言う名前のスナップショットを作成します。ボリューム・グループには、コマンドを正常に実行するのに少なくとも1 GBの空き領域が必要です。

# lvcreate -L1G -s -n LVDbSys1_snap /dev/VGExaDb/LVDbSys1

スナップショットにラベルを付けます。

# e2label /dev/VGExaDb/LVDbSys1_snap DBSYS_SNAP

スナップショットをマウントします。

# mkdir /root/mnt # mount /dev/VGExaDb/LVDbSys1_snap /root/mnt -t ext4

/u01ディレクトリにu01_snapという名前のスナップショットを作成します。

# lvcreate -L256M -s -n u01_snap /dev/VGExaDb/LVDbOra1

スナップショットにラベルを付けます。

# e2label /dev/VGExaDb/u01_snap DBORA_SNAP

スナップショットをマウントします。

# mkdir -p /root/mnt/u01 # mount /dev/VGExaDb/u01_snap /root/mnt/u01 -t ext4

バックアップのディレクトリに変更します。

# cd /root/mnt

バックアップ・ファイルを作成して、前述で取得した2つのスナップショット、/bootパーティション、RDBMSホームおよびグリッド・インフラストラクチャのホームをバックアップします。

# tar -pjcvf /remote_FS/mybackup.tar.bz2 * /boot /u01/app/12.1.0.2/grid /u01/app/oracle/product/12.1.0.2/dbhome_1 > /tmp/backup_tar.stdout 2> /tmp/backup_tar.stderr

/tmp/backup_tar.stderrファイルをチェックして、重大なエラーがないかを確認します。tarオープン・ソケットの障害に関するエラーおよび他の同様のエラーは無視できます。

ルート・ディレクトリを含むファイル・システムのスナップショットをアンマウントおよび削除します。

# cd / # umount /root/mnt/u01 # umount /root/mnt # /bin/rmdir /root/mnt # lvremove /dev/VGExaDb/u01_snap # lvremove /dev/VGExaDb/LVDbSys1_snap

NFS共有をアンマウントします。

# umount /remote_FS

この項では、データベース・サーバーで重大な障害が発生した後またはサーバー・ハードウェアを新しいハードウェアに交換する必要がある場合に、スナップショット・ベースのバックアップを使用して、Oracle Linuxを実行するデータベース・サーバー・ファイル・システムをリカバリする方法について説明します。たとえば、すべてのハード・ディスクを交換すると、システムの元のソフトウェアはトレースできません。これは、ソフトウェアの完全なシステムの交換と似ています。さらに、障害状態になる前にデータベース・サーバーが正常であったときに取得したLVMスナップショット・ベースのバックアップを使用するデータベース・サーバーの障害リカバリ方法を提供します。

リカバリ手順では、diagnostics.isoイメージを仮想CD-ROMとして使用し、ILOMを使用してレスキュー・モードでデータベース・サーバーを再起動します。一般的なワークフローには次の作業があります。

次のものを再作成します。

ブート・パーティション

物理ボリューム

ボリューム・グループ

論理ボリューム

ファイル・システム

スワップ・パーティション

スワップ・パーティションをアクティブ化します。

/bootパーティションがアクティブなブート・パーティションであることを確認します。

データをリストアします。

GRUBを再構成します。

サーバーを再起動します。

この項で説明するリカバリ手順には、Exadata Storage Serverまたはデータベース・データのバックアップまたはリカバリは含まれません。バックアップとリカバリ手順は定期的にテストすることをお薦めします。この項では、次の項目について説明します。

注意:

テープからリストアする場合は、追加のドライブをロードする必要がありますが、この章では扱いません。ファイルはNFSの場所にバックアップし、既存のテープ・オプションを使用して、NFSホストとの間でバックアップとリカバリを行うことをお薦めします。

パーティションをカスタマイズしていない場合にスナップショット・ベースのバックアップを使用してOracle Linuxデータベース・サーバーをリカバリできます。

この手順は、パーティション、論理ボリューム、ファイル・システム、およびそれらのサイズの配置がデータベース・サーバーの最初のデプロイ時の配置と等しい場合に適用されます。

注意:

ディスクの既存のすべてのデータは、この手順の実行中に失われます。

次の手順では、パーティションをカスタマイズしている場合にスナップショット・ベースのバックアップを使用してOracle Linuxデータベース・サーバーをリカバリする方法について説明します。diagnostics.isoを使用してデータベース・サーバーを起動した後にenter interactive diagnostics shellおよびrestore system from NFS backup archiveオプションの選択を要求されるまで、カスタマイズされていないパーティションのリストア手順と同じです。

診断シェルの入力を選択して、rootユーザーとしてログインします。rootユーザーのパスワードがない場合は、Oracleサポート・サービスにお問い合せください。

必要に応じて、/opt/MegaRAID/MegaCli/MegaCli64を使用して、ディスク・コントローラを構成してディスクを設定します。

/bootにマウントする少なくとも128MBのプライマリ・ブート・パーティションが作成されていることを確認します。ブート領域にLVMパーティションは指定できません。

次のコマンドを使用して、ブート・パーティションを作成します。

umount /mnt/cell parted /dev/sda

インタラクティブ・シェルが表示されます。次の手順では、システム・プロンプトに応答する方法について説明します。

次のようにディスク・ラベルを割り当てます。

バージョン11.2.3.3.0以上を実行している場合は、mklabel gptを実行します。

11.2.3.3.0より前のバージョンを実行している場合は、mklabel msdosを実行します。

ユニット・サイズをセクターとして設定するには、「unit s」と入力します。

「print」と入力して既存のパーティションを表示して、パーティション表を確認します。

「rm <part#>」と入力して、再作成されるパーティションを削除します。

新しい最初のパーティションを作成するには、「mkpart primary 63 1048639」と入力します。

ブート・パーティションのブート可能フラグを設定するには、「set 1 boot on」と入力します。

次のように、2番目のプライマリ(lvm)・パーティションを作成します。

新しい2番目のパーティションを作成するには、「mkpart primary 1048640 -1」と入力します。

LVMを選択するには、「set 2 lvm on」と入力します。

ディスクに情報を書き込んだ後に終了するには、「quit」と入力します。

次のように、/sbin/lvmコマンドを使用して、カスタマイズされたLVMパーティションを再作成し、mkfsを使用してファイル・システムを作成します。

次のコマンドを使用して、物理ボリューム、ボリューム・グループおよび論理ボリュームを作成します。

lvm pvcreate /dev/sda2 lvm vgcreate VGExaDb /dev/sda2

次のコマンドを使用して、/(ルート)ディレクトリの論理ボリュームおよびファイル・システムを作成し、ラベルを付けます。

論理ボリュームを作成します。

lvm lvcreate -n LVDbSys1 -L40G VGExaDb

予約パーティション用の論理ボリュームを作成します。この手順は、リリース12.1.2.2.0以上のExadataソフトウェアを実行している場合にのみ必要となります。

# lvm lvcreate -n LVDoNotRemoveOrUse –L1G VGExaDb

この論理ボリュームにファイル・システムは作成しません。

ファイル・システムを作成します。

ext4ファイル・システムがすでにある場合は、次のようにmkfs.ext4コマンドを使用します。

mkfs.ext4 /dev/VGExaDb/LVDbSys1

ext3ファイル・システムがすでにある場合は、次のようにmkfs.ext3コマンドを使用します。

mkfs.ext3 /dev/VGExaDb/LVDbSys1

ラベルを付けます。

e2label /dev/VGExaDb/LVDbSys1 DBSYS

次のコマンドを使用して、swapディレクトリの論理ボリュームを作成し、ラベルを付けます。

lvm lvcreate -n LVDbSwap1 -L24G VGExaDb mkswap -L SWAP /dev/VGExaDb/LVDbSwap1

次のコマンドを使用して、root/u01ディレクトリの論理ボリュームを作成し、ラベルを付けます。

論理ボリュームを作成します。

lvm lvcreate -n LVDbOra1 -L100G VGExaDb

ファイル・システムを作成します。

ext4ファイル・システムがすでにある場合は、次のようにmkfs.ext4コマンドを使用します。

mkfs.ext4 /dev/VGExaDb/LVDbOra1

ext3ファイル・システムがすでにある場合は、次のようにmkfs.ext3コマンドを使用します。

mkfs.ext3 /dev/VGExaDb/LVDbOra1

ラベルを付けます。

e2label /dev/VGExaDb/LVDbOra1 DBORA

次のコマンドを使用して、/bootパーティションにファイル・システムを作成し、ラベルを付けます。

ファイル・システムを作成します。

ext4ファイル・システムがすでにある場合は、次のようにmkfs.ext4コマンドを使用します。

mkfs.ext4 /dev/sda1

ext3ファイル・システムがすでにある場合は、次のようにmkfs.ext3コマンドを使用します。

mkfs.ext3 /dev/sda1

ラベルを付けます。

e2label /dev/sda1 BOOT

注意:

カスタマイズされたファイル・システム配置の場合は、ここで追加の論理ボリュームを作成できます。カスタマイズされた配置では、異なるサイズが使用される場合があります。

すべてのパーティションのマウント・ポイントを作成して元のシステムをミラー化し、各パーティションをマウントします。たとえば、/mntがこの最上位ディレクトリとして使用されると、マウントされるパーティションのリストは次のようになります。

/dev/VGExaDb/LVDbSys1 on /mnt /dev/VGExaDb/LVDbOra1 on /mnt/u01 /dev/sda1 on /mnt/boot

次に、ルート・ファイル・システムのマウント方法および2つのマウント・ポイントの作成方法の例を示します。次のコマンドのfilesystem_type_of_/_directoryは、/ (ルート)ディレクトリのファイル・システム(ext3またはext4のいずれか)を指定します。

mount /dev/VGExaDb/LVDbSys1 /mnt -t filesystem_type_of_/_directory mkdir /mnt/u01 /mnt/boot mount /dev/VGExaDb/LVDbOra1 /mnt/u01 -t filesystem_type_of_/u01_directory mount /dev/sda1 /mnt/boot -t filesystem_type_of_/boot_directory

注意:

カスタマイズされたファイル・システム配置で追加の論理ボリュームがある場合は、この手順で追加のマウント・ポイントを作成する必要があります。

次のように、ネットワークを起動し、バックアップが存在するNFSサーバーをマウントします。

次のコマンドを実行して、ネットワークを起動します。

オペレーティング・システムがOracle Linux 6以上の場合:

ip address add ip_address_for_eth0/netmask_for_eth0 dev eth0 ip link set up eth0 ip route add default via gateway_address dev eth0

オペレーティング・システムがOracle Linux 5の場合:

ifconfig eth0 ip_address_for_eth0 netmask netmask_for_eth0 up

NFSサーバーをIPアドレスnfs_ipでマウントし、次のコマンドを使用して/exportとしてバックアップする場所にエクスポートします。

mkdir -p /root/mnt mount -t nfs -o ro,intr,soft,proto=tcp,nolock nfs_ip:/export /root/mnt

次のコマンドを使用して、バックアップからリストアします。

tar -pjxvf /root/mnt/mybackup.tar.bz2 -C /mnt

次のコマンドを使用して、リストアしたファイル・システムをアンマウントし、/bootパーティションを再マウントします。

umount /mnt/u01

umount /mnt/boot

umount /mnt

mkdir /boot

mount /dev/sda1 /mnt/boot -t filesystem_type_of_/boot_directory

ブート・ローダーを設定します。次の場合、/dev/sda1が/boot領域です。

grub find /I_am_hd_boot (1) root (hdX,0) setup (hdX) quit

前述のコマンドの(1)により、(hd0,0)などのI_am_hd_bootファイルを含むハード・ディスクhdXが検索されます。

diagnostics.isoファイルを切り離します。

次のコマンドを使用して、/bootパーティションをアンマウントします。

umount /boot

システムを再起動します。これで、サーバーのリストア手順が完了です。

reboot

リカバリをOracle Exadata Database Machineエイス・ラックで実行した場合は、「Oracle Exadata Database Machineエイス・ラックのOracle Linuxデータベース・サーバーのリカバリ後の構成」の手順を実行します。

Oracle Exadata Database Machineエイス・ラックのOracle Linuxデータベース・サーバーを再イメージ化、リストアまたはレスキューした場合は、次の手順を実行する必要があります。

Oracle Exadata Storage Serverリリース12.1.2.2.3以前を実行するX3-2マシン

別のデータベース・サーバーにある/opt/oracle.SupportTools/resourcecontrolユーティリティを、リカバリしたサーバーの/opt/oracle.SupportTools/resourcecontrolディレクトリにコピーします。

次のコマンドを使用して、ユーティリティに対して適切な権限が設定されていることを確認します。

# chmod 740 /opt/oracle.SupportTools/resourcecontrol

次のコマンドを使用して、現在の構成を検証します。コマンドの出力が表示されます。

# /opt/oracle.SupportTools/resourcecontrol -show Validated hardware and OS. Proceed. Number of cores active: 8

エイス・ラック構成の場合、8個のコアが有効になっている必要があります。その値が表示された場合、構成の変更は不要です。その値が表示されなかった場合は、手順4に進みます。

注意:

ユーティリティの実行後に次のようなエラーが発生した場合は、通常、サーバーを1回以上再起動すると、エラーが解消されます。

Validated hardware and OS. Proceed. Cannot get ubisconfig export. Cannot Proceed. Exit.

次のコマンドを使用して、構成を変更します。

# /opt/oracle.SupportTools/resourcecontrol -cores 8

次のコマンドを使用して、サーバーを再起動します。

# reboot

次のコマンドを使用して、構成の変更を検証します。

# /opt/oracle.SupportTools/resourcecontrol -show

コマンドを実行すると、データベース・サーバーについて次のような出力が表示されると予想されます。

This is a Linux database server. Validated hardware and OS. Proceed. Number of cores active per socket: 4

X6-8、X5-8、X4-8、X6-2、X5-2、X4-2およびX3-2マシン

X3–2システムでは、Oracle Exadata Storage Serverリリース12.1.2.3.0以上を実行している場合のみこの方法を使用します。

次の手順では、重大な障害が発生してOVSが損傷を受けた場合、またはサーバー・ハードウェアを新しいハードウェアに交換する必要がある場合に、スナップショット・ベースのバックアップからOracle Virtual Server (OVS)をリカバリする方法について説明します。たとえば、すべてのハード・ディスクを交換すると、システムの元のソフトウェアはトレースできません。これは、ソフトウェアの完全なシステムの交換と似ています。さらに、障害状態になる前にデータベース・サーバーが正常であったときに取得したLVMスナップショット・ベースのバックアップを使用するデータベース・サーバーの障害リカバリ方法を提供します。

リカバリ手順では、diagnostics.isoイメージを仮想CD-ROMとして使用し、ILOMを使用してレスキュー・モードでOracle Virtual Serverを再起動します。この手順の概要は、次のようになります。

次のものを再作成します。

ブート・パーティション

物理ボリューム

ボリューム・グループ

論理ボリューム

ファイル・システム

スワップ・パーティション

スワップ・パーティションをアクティブ化します。

/bootパーティションがアクティブなブート・パーティションであることを確認します。

データをリストアします。

GRUBを再構成します。

サーバーを再起動します。

この項で説明するリカバリ手順には、Exadata Storage Serverまたはデータベース・データのバックアップまたはリカバリは含まれません。バックアップとリカバリ手順は定期的にテストすることをお薦めします。

注意:

ディスクの既存のすべてのデータは、この手順の実行中に失われます。

NFSサーバーを準備して、バックアップ・アーカイブmybackup.tar.bz2をホストします。

IPアドレスを使用して、NFSサーバーにアクセスできる必要があります。たとえば、IPアドレスnfs_ipを使用するNFSサーバーで/exportディレクトリがNSFマウントからエクスポートされる場合は、/exportディレクトリにmybackup.tar.bz2ファイルを置きます。

正常なデータベース・サーバーにある/opt/oracle.SupportTools/diagnostics.isoファイルをリストア対象のOracle Virtual ServerのILOMに仮想メディアとして接続します。

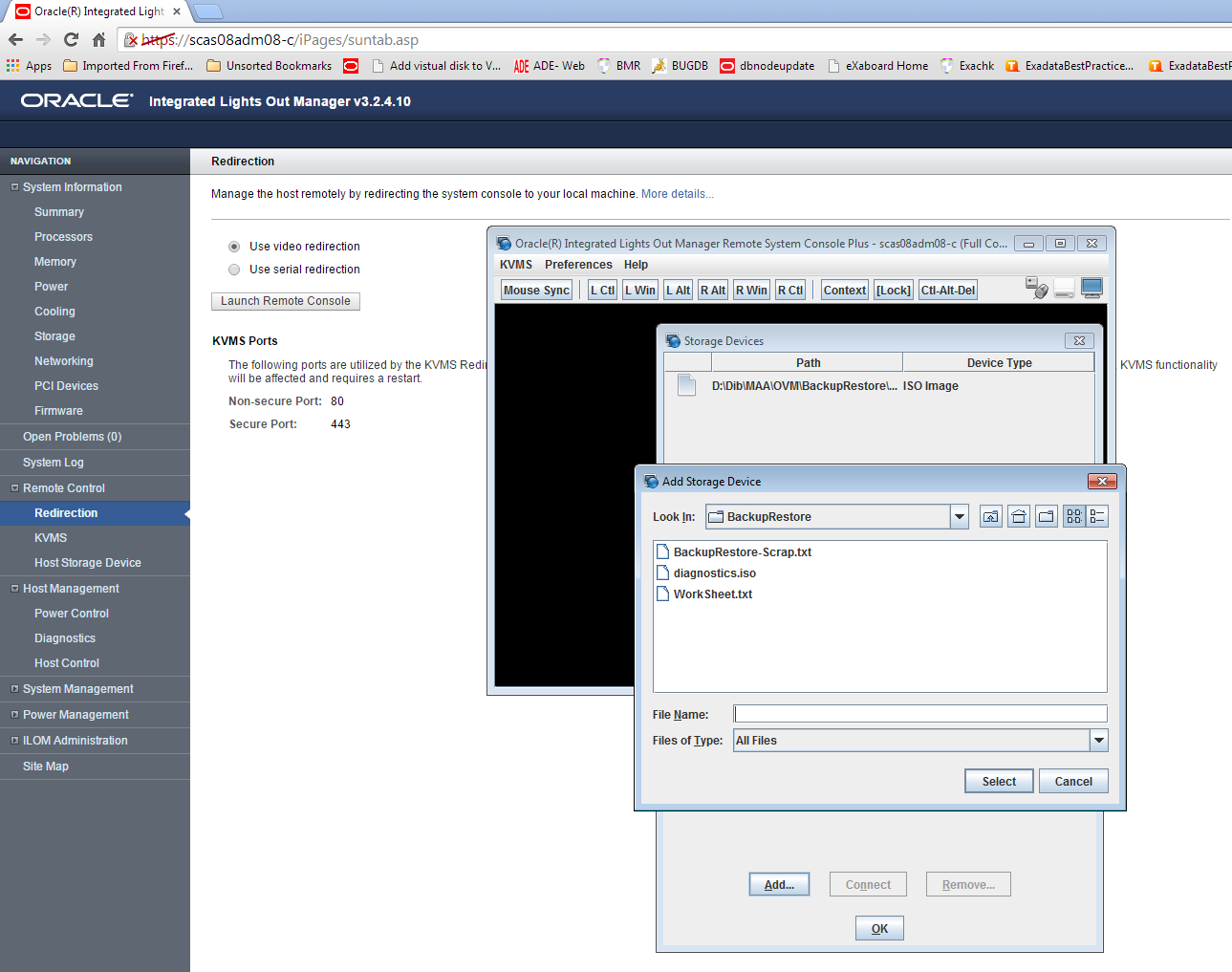

次に、ILOMインタフェースを使用した仮想CD-ROMの設定方法の例を示します。

ILOMインタフェースを使用するマシンのディレクトリに、diagnostics.isoファイルをコピーします。

ILOM Webインタフェースにログインします。

Oracle ILOM Webインタフェースで、リモート制御→リダイレクトをクリックします。

ビデオのリダイレクトを使用するを選択します。

コンソールが起動したら、KVMSメニューのストレージをクリックします。

DVDイメージなどのストレージ・イメージを追加するには、ストレージ・デバイス・ダイアログ・ボックスで、「追加」をクリックします。

diagnostics.isoファイルを開きます。

図2-7 diagnostics.isoファイルを選択するための「ストレージ・デバイスの追加」ダイアログを表示するILOM Webインタフェース

ストレージ・デバイス・ダイアログ・ボックスからストレージ・メディアをリダイレクトするには、ストレージ・メディアを選択して、「接続」をクリックします。

デバイスとの接続が確立されると、ストレージ・デバイス・ダイアログ・ボックスの「接続」ボタンのラベルが「切断」に変わります。

「ホスト管理」タブからホスト制御を選択します。

次の起動デバイスとしてCDROMを値リストから選択します。

「保存」をクリックします。システムがブートすると、diagnostics.isoイメージが使用されます。

isoファイルからシステムを再起動します。

これは、次のいずれかの方法を使用して実行できます。

起動中に、CD-ROMを起動デバイスとして選択するか、または

リストア対象のOVSのILOMにアクセスできる他のマシンから、ipmitoolコマンドを実行して、起動デバイスを事前に設定します。

# ipmitool -H ILOM_ip_address_or_hostname -U root chassis bootdev cdrom # ipmitool -H ILOM_ip_address_or_hostname -U root chassis power cycle

システムに次が表示された場合:

Choose from following by typing letter in '()': (e)nter interactive diagnostics shell. Must use credentials from Oracle support to login (reboot or power cycle to exit the shell), (r)estore system from NFS backup archive,

"e"と入力して、診断シェルに入り、rootユーザーとしてログインします。rootユーザーのパスワードがない場合は、Oracleサポート・サービスに連絡してください。

必要に応じて、/opt/MegaRAID/MegaCli/MegaCli64を使用して、ディスク・コントローラを構成してディスクを設定します。

障害の発生後に論理ボリューム、ボリューム・グループおよび物理ボリュームが存在する場合は、それらを削除します。

# lvm vgremove VGExaDb # lvm pvremove /dev/sda2

既存のパーティションを削除し、ドライブをクリーン・アップします。

# parted GNU Parted 2.1 Using /dev/sda Welcome to GNU Parted! Type 'help' to view a list of commands. (parted) rm 1 sda: sda2 sda3 (parted) rm 2 sda: sda3 (parted) rm 3 sda: (parted) q # dd if=/dev/zero of=/dev/sda bs=64M count=2

3つのパーティションを/dev/sdaに作成します。

ディスク/dev/sdaの終了セクタを取得し、変数に保存します。

# end_sector=$(parted -s /dev/sda unit s print|perl -ne '/^Disk\s+\S+:\s+(\d+)s/ and print $1')

次のコマンドの開始および終了セクタの値は、残りのdom0から取得されています。これらの値は時間とともに変更される場合があるため、次のコマンドを使用して、これらの値を残りのdom0から確認することをお薦めします。

# parted -s /dev/sda unit S print

/bootパーティション/dev/sda1を作成します。

# parted -s /dev/sda mklabel gpt mkpart primary 64s 1048639s set 1 boot on

LVMを保持するパーティション/dev/sda2を作成します。

# parted -s /dev/sda mkpart primary 1048640s 240132159s set 2 lvm on

ocfs2記憶域リポジトリ・パーティション/dev/sda3を作成します。

# parted -s /dev/sda mkpart primary 240132160s ${end_sector}s set 3

/sbin/lvmコマンドを使用して論理ボリュームを再作成し、mkfsを使用してファイル・システムを作成します。

物理ボリュームおよびボリューム・グループを作成します。

# lvm pvcreate /dev/sda2 # lvm vgcreate VGExaDb /dev/sda2

/ (ルート)ディレクトリを含むファイル・システムの論理ボリュームを作成して、ラベルを付けます。

# lvm lvcreate -n LVDbSys3 -L30G VGExaDb # mkfs.ext4 /dev/VGExaDb/LVDbSys3 # e2label /dev/VGExaDb/LVDbSys3 DBSYSOVS

スワップ・ディレクトリの論理ボリュームを作成して、ラベルを付けます。

# lvm lvcreate -n LVDbSwap1 -L24G VGExaDb # mkswap -L SWAP /dev/VGExaDb/LVDbSwap1

バックアップ・パーティションの論理ボリュームを作成して、その上部にファイル・システムを構築します。

# lvm lvcreate -n LVDbSys2 -L30G VGExaDb # mkfs.ext4 /dev/VGExaDb/LVDbSys2

予約パーティション用の論理ボリュームを作成します。

# lvm lvcreate -n LVDoNotRemoveOrUse –L1G VGExaDb

この論理ボリュームにファイル・システムは作成しません。

/dev/sda1パーティションにファイル・システムを作成し、ラベルを付けます。

次のmkfs.ext3コマンドで、inodeサイズを128に設定するには"-I 128"オプションが必要です。

# mkfs.ext3 -I 128 /dev/sda1 # tune2fs -c 0 -i 0 /dev/sda1 # e2label /dev/sda1 BOOT

すべてのパーティションのマウント・ポイントを作成して、各パーティションをマウントします。

たとえば、/mntが最上位ディレクトリとして使用されると、マウントされるパーティションのリストは次のようになります。

/dev/VGExaDb/LVDbSys3 on /mnt

/dev/sda1 on /mnt/boot

次の例では、ルート・ファイル・システムをマウントし、2つのマウント・ポイントを作成します。

# mount /dev/VGExaDb/LVDbSys3 /mnt -t ext4 # mkdir /mnt/boot # mount /dev/sda1 /mnt/boot -t ext3

eth0でネットワークを起動し、ホストのIPアドレス/ネットマスクを割り当てます。

# ifconfig eth0 ip_address_for_eth0 netmask netmask_for_eth0 up # route add -net 0.0.0.0 netmask 0.0.0.0 gw gateway_ip_address

バックアップを保持するNFSサーバーをマウントします。

# mkdir -p /root/mnt # mount -t nfs -o ro,intr,soft,proto=tcp,nolock nfs_ip:/location_of_backup /root/mnt

「スナップショット・ベースのバックアップを使用した管理ドメインdom0のバックアップ」で作成したバックアップ、/およびブート・ファイル・システムからリストアします。

# tar -pjxvf /root/mnt/backup-of-root-and-boot.tar -C /mnt

リストアした/dev/sda1パーティションをアンマウントし、/bootに再マウントします。

# umount /mnt/boot # mkdir /boot # mount /dev/sda1 /boot -t ext3

GRUBブート・ローダーを設定します。次の場合、/dev/sda1が/boot領域です。

# grub root (hd0,0) setup (hd0) quit

/bootパーティションをアンマウントします。

# umount /boot

diagnostics.isoファイルを切り離します。

これを行うには、手順2で「接続」をクリックしてDVD .isoイメージを割り当てたときに表示された、ILOM Webインタフェース・コンソールの「切断」をクリックします。

リストアした/etc/fstabファイルを確認し、/EXAVMIMAGESおよび/dev/sda3への参照を削除します。

# cd /mnt/etc

/EXAVMIMAGESまたは/dev/sda3を参照する行をすべてコメント・アウトします。

システムを再起動します。これで、OVS/dom0のリストア手順が完了です。

# reboot

必要であれば、エイス・ラックに変換します。

リカバリをOracle Exadata Database Machineエイス・ラックで実行する場合は、「Oracle Exadata Database Machineエイス・ラックのOracle Linuxデータベース・サーバーのリカバリ後の構成」の手順を実行します。

サーバーが再起動されたら、ocfs2ファイル・システムを/dev/sda3パーティションに構築します。

# mkfs -t ocfs2 -L ocfs2 -T vmstore --fs-features=local /dev/sda3 --force

ocfs2パーティション/dev/sda3を/EXAVMIMAGESにマウントします。

# mount -t ocfs2 /dev/sda3 /EXAVMIMAGES

/etc/fstabで、手順18でコメント・アウトした/EXAVMIMAGESおよび/dev/sda3への参照を非コメント化します。

記憶域リポジトリ(/EXAVMIMAGES)バックアップを保持するバックアップNFSサーバーをマウントし、すべてのユーザー・ドメイン・イメージを保持する/EXAVMIMAGESファイル・システムをリストアします。

# mkdir -p /root/mnt # mount -t nfs -o ro,intr,soft,proto=tcp,nolock nfs_ip:/location_of_backup /root/mnt

/EXAVMIMAGESファイル・システムをリストアします。

# tar -Spxvf /root/mnt/backup-of-exavmimages.tar -C /EXAVMIMAGES

各ユーザー・ドメインを起動します。

# xm create /EXAVMIMAGES/GuestImages/user_domain_hostname/vm.cfg

この時点で、すべてのユーザー・ドメインと、それらの中のGIおよびデータベース・インスタンスが起動し、残りの他のOVSノードによって形成されたOracle RACクラスタに参加します。

次の手順は、修復できないほどの損傷がOVS/dom0で発生し、バックアップがdom0に存在しないが、すべてのユーザー・ドメインを格納する記憶域リポジトリ(/EXAVMIMAGESファイル・システム)の中に利用可能なバックアップが存在する場合に使用できます。この手順では、dom0を再イメージ化し、すべてのユーザー・ドメインを再構築します。

「Oracle Linuxデータベース・サーバーの再イメージ化」の手順を使用して、ラック内のその他のOVS/dom0で使用されるイメージでOVSを再イメージ化します。

次のコマンドを実行します。

# /opt/oracle.SupportTools/switch_to_ovm.sh # /opt/oracle.SupportTools/reclaimdisks.sh –free –reclaim

リカバリをOracle Exadata Database Machineエイス・ラックで実行する場合は、「Oracle Exadata Database Machineエイス・ラックのOracle Linuxデータベース・サーバーのリカバリ後の構成」の手順を実行します。

ocfs2ファイル・システムを/dev/sda3パーティションに再構築します。

# umount /EXAVMIMAGES # mkfs -t ocfs2 -L ocfs2 -T vmstore --fs-features=local /dev/sda3 --force

ocfs2パーティション/dev/sda3を/EXAVMIMAGESにマウントします。

# mount -t ocfs2 /dev/sda3 /EXAVMIMAGES

バックアップNFSサーバーをマウントし、ユーザー・ドメイン・イメージを保持する/EXAVMIMAGESファイル・システムをリストアします。

# mkdir -p /remote_FS # mount -t nfs -o ro,intr,soft,proto=tcp,nolock nfs_ip:/location_of_backup /remote_FS

/EXAVMIMAGESファイル・システムをリストアします。

# tar -Spxvf /remote_FS/backup-of-exavmimages.tar -C /EXAVMIMAGES

注意:

記憶域リポジトリのリストア処理では、ユーザー・ドメイン固有のファイル(/EXAVMINAGES/GuestImages/<user_domain>/下のファイル)が通常のファイルとしてリストアされ、ユーザー・ドメインの作成時にこれらのファイルが記憶域リポジトリに最初に作成されたocfs2 reflinkとしてはリストアされません。したがって、/EXAVMINAGES内の領域の使用量は、バックアップ時の元の領域の使用量に比べて、リストア処理後に増加することがあります。

ネットワーク・ブリッジを手動で設定します。

ovmutils rpmのバージョンを確認します。

# rpm -qa|grep ovmutils

ovmutils rpmのバージョンが12.1.2.2.0より前の場合は、次の手順を実行します。

/opt/exadata_ovm/exadata.img.domu_makerをバックアップします。このバックアップ・コピーは後ほど必要になります。

# cp /opt/exadata_ovm/exadata.img.domu_maker /opt/exadata_ovm/exadata.img.domu_maker-orig

viなどのテキスト・エディタで/opt/exadata_ovm/exadata.img.domu_makerファイルを開き、"g_do_not_set_bridge=yes"を検索します。これは、CASE文オプション"network-discovery"の数行下にあります。

これを"g_do_not_set_bridge=no"に変更します。

/opt/exadata_ovm/exadata.img.domu_makerを保存して終了します。

/EXAVMIMAGES/confディレクトリのすべてのxmlファイルで/opt/exadata_ovm/exadata.img.domu_makerを手動で実行します。

# cd /EXAVMIMAGES/conf # ls -1|while read file; do /opt/exadata_ovm/exadata.img.domu_maker network-discovery $file /tmp/netdisc-$file; done

バックアップ・コピーから/opt/exadata_ovm/exadata.img.domu_makerをリストアします。

# cp /opt/exadata_ovm/exadata.img.domu_maker-orig /opt/exadata_ovm/exadata.img.domu_maker

ovmutils rpmのバージョンが12.1.2.2.0以降の場合、次のコマンドを実行します。

# /opt/exadata_ovm/exadata.img.domu_maker add-bonded-bridge-dom0 vmbondeth0 eth4 eth5

/EXAVMIMAGES/GuestImagesディレクトリ内のユーザー・ドメイン・ディレクトリごとに、次の手順を実行します。

ユーザー・ドメインのUUIDを取得します。

# grep ^uuid /EXAVMIMAGES/GuestImages/<user domain hostname>/vm.cfg|awk -F"=" '{print $2}'|sed s/"'"//g|sed s/" "//g

コマンドを実行すると、uuid値が返され、これは次のコマンドで使用されます。

# mkdir -p /OVS/Repositories/uuid

# ln -s /EXAVMIMAGES/GuestImages/user_domain_hostname/vm.cfg /OVS/Repositories/uuid/vm.cfg

# ln -s /OVS/Repositories/uuid/vm.cfg /etc/xen/auto/user_domain_hostname.cfg

# mkdir VirtualDisks

# cd VirtualDisks

vm.cfgファイ内にある4つのディスク・イメージ名を使用して、このディレクトリに4つのシンボリック・リンクを作成します(/EXAVMIMAGES/GuestImages/user_domain_hostnameディレクトリ内にある4つの".img"ファイルを指します)。

たとえば、/OVS/Repositories/uuidディレクトリのサンプルvm.cfgファイルのサンプル・ディスク・エントリを次に示します。

disk = ['file:/OVS/Repositories/6e7c7109c1bc4ebba279f84e595e0b27/VirtualDisks/dfd641a1c6a84bd69643da704ff98594.img,xvda,w','file:/OVS/Repositories/6e7c7109c1bc4ebba279f84e595e0b27/VirtualDisks/d349fd420a1e49459118e6a6fcdbc2a4.img,xvdb,w','file:/OVS/Repositories/6e7c7109c1bc4ebba279f84e595e0b27/VirtualDisks/8ac470eeb8704aab9a8b3adedf1c3b04.img,xvdc,w','file:/OVS/Repositories/6e7c7109c1bc4ebba279f84e595e0b27/VirtualDisks/333e7ed2850a441ca4d2461044dd0f7c.img,xvdd,w']

/EXAVMIMAGES/GuestImages/user_domain_hostnameディレクトリ内にある4つの".img"ファイルをリストできます。

ls /EXAVMIMAGES/GuestImages/user_domain_name/*.img

/EXAVMIMAGES/GuestImages/user_domain_name/System.img /EXAVMIMAGES/GuestImages/user_domain_name/grid12.1.0.2.2.img /EXAVMIMAGES/GuestImages/user_domain_name/db12.1.0.2.2-3.img /EXAVMIMAGES/GuestImages/user_domain_name/pv1_vgexadb.img

この場合、次のコマンドを使用して、4つのシンボリック・リンク(dbm01db08vm01はユーザー・ドメインのホスト名)を作成できます。