5 Oracle Stream Analyticsのトラブルシューティング

Oracle Stream Analyticsでは、イベントのストリームをリアルタイムで分析およびモニターする機能が提供されます。ユーザーは、ストリーム処理ソリューションをモデル化するためのパイプラインを作成できます。通常、Oracle Stream Analyticsパイプラインは、明示的に中断されるか障害が発生するまで、長時間継続的に実行されます。このガイドでは、パイプラインの作成、実行またはデプロイメント時に発生する可能性のある様々な問題をトラブルシューティングするステップについて説明します。

パイプラインのモニタリングおよびデバッグ・メトリック

実行されているOracle Stream Analyticsパイプラインごとに、対応するSparkアプリケーションがSparkクラスタにデプロイされています。Oracle Stream Analyticsパイプラインがドラフト・モードまたはパブリッシュ・モードでデプロイおよび実行されている場合、ユーザーは、Oracle Stream Analyticsによって提供されるリアルタイム・メトリックを使用して、対応するSparkアプリケーションをモニターおよび分析できます。これらのメトリックにより、すべてのパイプライン・ステージに対する詳細な実行時インサイトが提供され、ユーザーは、演算子レベルの詳細までドリルダウンできます。これらのメトリックは、Sparkが提供するメトリックに対して追加されています。

Oracle Stream Analyticsでは、アプリケーションごとに、パイプラインが期待どおりに動作しない場合に分析に使用できる詳細なモニタリング・メトリックが提供されます。

モニタリングおよびデバッグ・メトリックにアクセスするには:

一般的な問題および処置

このセクションでは、カタログ項目で分類された問題または質問の包括的なリストを提供します。特定のカタログ項目で作業をしている際に困難に直面した場合、そのカタログ項目に対応する一般的な問題または質問のリストを参照してください。

トピック

-

パイプライン

-

ストリーム

-

参照

-

ジオフェンス

-

接続

-

ターゲット

-

ダッシュボード

-

キューブ

-

ログ

パイプライン

この項では、パイプラインで発生する一般的な問題をリストします。

パイプラインが正常にデプロイされていることを確認する

パイプラインは、任意のSparkクラスタ(バージョン1.6)にデプロイできます。

次の項のステップに従って、Sparkクラスタにパイプラインが正常にデプロイされて実行されていることを確認してください。

Sparkクラスタに基づくOracle Big Data Cloud Service - Compute Editionへのパイプライン・デプロイメントを確認する

Oracle Big Data Cloud Serviceにサブスクライブしている場合、次のステップを実行します。

-

PSMユーザー・インタフェースに移動して、Oracle Big Data Cloud Service (BDCSCE)インスタンスのホームページを開きます。

-

インスタンス名の横にあるハンバーガ・メニューをクリックし、ビッグ・データ・クラスタ・コンソールをクリックします。

-

ログイン資格証明を入力して、ビッグ・データ・クラスタ・コンソールのホームページを開きます。

-

「ジョブ」タブに移動します。

ジョブのリストが表示されます。各ジョブは、BDCSCEクラスタで実行されているSparkパイプラインに対応しています。

-

パイプラインに対応するエントリを見つけて、ステータスを確認します。詳細は、「パイプラインに対応するSparkアプリケーション名を特定する」を参照してください。

ステータスが

「Running」と表示されている場合、パイプラインは、現在正常にデプロイされて実行されています。 -

必要なジョブに対応するハンバーガ・メニューをクリックしてログをフェッチし、「ログ」をクリックしてコンテナ単位のログを取得します。

より詳細なデバッグをするためにこれらのファイルをダウンロードできます。

Sparkクラスタに基づくApache Sparkインストール環境へのパイプライン・デプロイメントを確認する

-

Spark Masterユーザー・インタフェースを開きます。

-

パイプラインに対応するエントリを見つけて、ステータスを確認します。詳細は、「パイプラインに対応するSparkアプリケーション名を特定する」を参照してください。

ステータスが

「Running」と表示されている場合、パイプラインは、現在正常にデプロイされて実行されています。

入力ストリームがパイプラインにイベントの連続的なストリームを供給していることを確認する

入力ストリームからイベントの連続的な供給が行われている必要があります。

-

「カタログ」に移動します。

-

トラブルシューティングするストリームを特定してクリックします。

-

ソース・タイプ・パラメータ・セクションのtopicNameプロパティの値を確認します。

-

パイプラインの入力ストリームが受信されるKafkaトピックをリスニングします。

このトピックはKafka APIを使用して作成されるため、REST APIを使用してこのトピックを消費することはできません。

-

Oracle Event Hub Cloud ServiceでホストされているKafkaトピックをリスニングします。トピックをリスニングするには、Apache Kafkaユーティリティまたは他の関連ツールを使用する必要があります。

次のステップを使用して、Kafkaトピックをリスニングします。

-

Zookeeperアドレスを特定します。Oracle Event Hub Cloud Service Platformのホームページに移動します。ZookeeperのIPアドレスを見つけます。

- 次のコマンドを使用してKafkaトピックをリスニングします。

./kafka-console-consumer.sh --zookeeper IPAddress:2181 --topic nano

-

-

標準のApache Kafkaインストール環境でホストされているKafkaトピックをリスニングします。

Kafkaインストール環境でユーティリティを使用してKafkaトピックをリスニングできます。

kafka-console-consumer.shは、任意のKafkaインストール環境の一部として使用できるユーティリティ・スクリプトです。次のステップを使用して、Kafkaトピックをリスニングします。

-

クラスタに基づくApache Kafkaインストール環境でのZookeeperアドレスを特定します。

- 次のコマンドを使用してKafkaトピックをリスニングします。

./kafka-console-consumer.sh --zookeeper IPAddress:2181 --topic nano

-

-

パイプラインに対応するSparkアプリケーション名を特定する

次のステップを実行して、モニター・トピックで出力ストリームを使用できるかどうかを確認できます。

-

「カタログ」に移動します。

-

必要なパイプラインを開きます。

-

パイプライン・エディタが開いたままであることを確認して、「完了」はクリックしないでください。そうしないと、パイプラインがアンデプロイされます。

-

ブラウザ内の任意の場所を右クリックし、「インスペクト」を選択します。

-

「ネットワーク」タブの下の「WS」タブに移動します。

-

ブラウザをリフレッシュします。

新しいWebsocket接続が作成されます。

-

URLに

topicという名前の入ったパラメータが含まれるWebsocketを見つけます。トピック

paramの値は、このステージの出力(問合せまたはパターン)がプッシュされるKafkaトピックの名前です。トピック名は、

AppName_StageIdです。パイプライン名は、トピック名から_StageIDを削除することで、トピック名から導出できます。前のスナップショットでは、パイプライン名はsx_2_49_12_pipe1_draftです。

パイプラインがストリームと参照を関連付けている場合にキャッシングが動作していることを確認する

次のステップを実行して、キャッシングがパイプラインで使用されていることを確認します。

-

Spark Application Master UIに移動します。

-

「Pipeline」タブをクリックしてから「Pipeline Summary」ページを開きます。「Pipeline Summary」ページには、様々なメトリックとともにステージの表が表示されます。

-

ストリームと参照を関連付けているパイプラインの問合せステージに対応するステージIDをクリックします。

-

「Pipeline Stage Details」ページで、CQLDStreamステージをクリックして「CQL Engine Summary Details」ページを開きます。

-

「CQL Engine Summary Details」ページで、「External Sources」セクションを見つけます。ステージで使用されている参照のソースIDを書き留めてください。

-

「CQL Engine Detailed Query Analysis」ページを開きます。

-

ソースIDと同じ演算子IDを持つ演算子をクリックして、「CQL Engine Detailed Operator Analysis」ページを開きます。演算子に対応するエントリをクリックします。

-

「Cache Statistics」セクションを見つけます。そのようなセクションが存在しない場合、キャッシングはステージで有効化されていません。「Cache Hits」および「Cache Misses」に0 (ゼロ)以外のエントリが表示されている場合、キャッシングは、パイプライン・ステージに対して有効化され、アクティブになっています。

ライブ表で表のイベントがない状態でListening Eventsが表示される

パイプラインのステータスがStarting PipelineからListening Eventsに変更されない理由は、複数考えられます。次に、このシナリオをトラブルシューティングするステップを示します。

-

ライブ表には、現在選択されているただ1つのステージの出力イベントが表示されます。任意の時点で、選択されるステージは1つのみです。別のステージに切り替えてみてください。別のステージのライブ表で出力を確認できる場合、問題は、そのステージのみに関連している可能性があります。さらにデバッグするには、ステップ5に進んでください。

どのステージでも出力が存在しない場合、ステップ2に進んでください。

-

パイプラインが現在もSparkクラスタで実行されていることを確認します。詳細は、「パイプラインが正常にデプロイされていることを確認する」を参照してください。

-

パイプラインのSparkアプリケーションが中断または強制終了した場合、パイプラインがクラッシュしたことが示唆されます。さらにトラブルシューティングを行うには、アプリケーション・ログを調査することが必要な場合があります。

-

アプリケーションは、ACCEPTED、NEWまたはSUBMITTED状態の場合、クラスタ・リソースを待機しており、まだ開始していません。十分なリソースがない場合、Big Data Cloud Service Spark YarnクラスタのVCORESの数を確認してください。パイプラインの場合、Stream Analyticsでは、少なくとも3つのVCORESが必要です。

-

アプリケーションがRUNNING状態の場合、次のステップを使用してさらにトラブルシューティングを行います。

-

入力ストリームがパイプラインで継続的にイベントをプッシュしていることを確認します。

-

入力ストリームがイベントをプッシュしている場合、各パイプライン・ステージがイベントを処理し、出力を発生させていることを確認します。

-

前述の両方のステップの確認に成功した場合、アプリケーションが、その対応するモニター・トピックに各ステージの出力イベントをプッシュできることを確認します。そのために、次の手順を実行します。

-

「パイプライン・ステージの出力が伝播されているトピックの名前を特定する」に記載された指示に従って、ステージの出力のプッシュ先であるステージのモニター・トピックを特定します。

-

モニター・トピックをリスニングして、イベントがトピックに継続的にプッシュされていることを確認します。Kafkaトピックをリスニングするには、トピックが作成されるKafkaクラスタにアクセスできる必要があります。Kafkaインストール環境でユーティリティを使用してKafkaトピックをリスニングできます。

kafka-console-consumer.shは、任意のKafkaインストール環境の一部として使用できるユーティリティ・スクリプトです。 -

トピックにイベントが1つも表示されない場合、この問題は、ステージからモニター・トピックに対する出力イベントの書込みに関連している可能性があります。サーバー・ログを確認して例外を検索し、管理者に報告してください。

-

モニター・トピックに出力イベントが表示される場合、この問題は、Webブラウザでの出力イベントの読取りに関連している可能性があります。

-

-

パイプライン・ステージの出力が伝播されているトピックの名前を特定する

パイプライン・ステージ出力のトピック名のフォーマットは、PipelineID_StageIDです。サンプルのトピック名は、sx_TestPipeline_5226CDCB_2F11_4A46_8987_4BFCE6FED617_K60bGBKF_draft_st040800FD_A5B3_4AC2_90D5_ED85EB528F41です。この文字列で、パイプライン名はsx_TestPipeline_5226CDCB_2F11_4A46_8987_4BFCE6FED617_K60bGBKF_draftで、ステージIDはst040800FD_A5B3_4AC2_90D5_ED85EB528F41です。

次に、ステージのトピック名を見つけるステップを示します。

-

パイプラインの「Pipeline Summary」ページを開きます。このパイプラインの対応するアプリケーション名がわからない場合、手順について「パイプラインに対応するSparkアプリケーション名を特定する」を参照してください。

-

このページでは、パイプライン名と様々なステージIDが提供されます。パイプライン・ステージごとに、表のエントリが表示されます。

-

すべてのステージで、出力トピックIDはPipelineName_StageIDです。

-

パイプライン・エディタで「Done」をクリックし、カタログに戻ってパイプラインを再度開きます。

ライブ表に現在もStarting Pipelineと表示される

パイプラインのステータスがStarting PipelineからListening Eventsに変更されない理由は、複数考えられます。次に、このシナリオをトラブルシューティングするステップを示します。

-

パイプラインがSparkクラスタに正常にデプロイされていることを確認します。詳細は、「パイプラインが正常にデプロイされていることを確認する」を参照してください。Sparkクラスタが停止しておらず、使用できることも確認します。

-

デプロイメントに失敗した場合、Jettyログを確認してデプロイメントの失敗に関連する例外を参照し、問題を修正します。

-

デプロイメントに成功している場合、OSA Web層がSparkからパイプライン・デプロイメントを受信していることを確認します。

-

パイプライン・エディタで「Done」をクリックし、カタログに戻ってパイプラインを再度開きます。

パイプライン・ステージが現在もイベントを処理していることを確認する

次のステップを実行して、特定のパイプライン・ステージが現在もイベントを処理しているかどうかを確認します。

-

Spark Application Master UIに移動します。

-

「Pipeline」タブをクリックしてから「Pipeline Summary」ページを開きます。「Pipeline Summary」ページには、様々なメトリックとともにステージの表が表示されます。

-

合計出力イベントが0 (ゼロ)以外の値であるかどうかを確認します。ページをリフレッシュして、値が増加するか、同じままであるかを確認します。値が同じままで、長時間変化がない場合、ステージの詳細にドリルダウンします。

ストリーム

この項では、ストリームで発生する一般的な問題をリストします。

MapMessageフォーマットを検出できない

このリリースでは、CSVおよびJSONフォーマットのみがファイル・ストリームでサポートされます。Kafkaストリームでは、CSV、JSONおよびAVROフォーマットのみがサポートされます。

AVROフォーマットを検出できない

このリリースでは、CSVおよびJSONフォーマットのみがストリーム(ファイル・ストリーム・タイプ)でサポートされます。そのため、AVROフォーマットは検出できません。

トピックのリストで任意のKafkaトピックまたは特定のトピックを参照できない

次のステップを使用して、トラブルシューティングを行います。

-

カタログに移動して、ストリームの作成に使用しているKafka接続を選択します。

-

「次」をクリックして「接続の詳細」タブに移動します。

-

「接続のテスト」をクリックして、接続が現在もアクティブであることを確認します。

-

Kafkaクラスタに1つ以上のトピックが存在することを確認します。トピックが作成されるKafkaクラスタにアクセスできる必要があります。Kafkaインストール環境でユーティリティを使用してKafkaトピックをリストできます。

kafka-console-consumer.shは、任意のKafkaインストール環境の一部として使用できるユーティリティ・スクリプトです。 -

前述のコマンドを使用してもトピックを参照できない場合、トピックが作成されていることを確認します。

-

テスト接続に失敗し、

「OSA-01266 ZooKeeperサーバーに接続できません」などのエラー・メッセージが表示された場合、Kafkaクラスタは使用不可です。Kafkaクラスタが起動して実行中であることを確認します。

入力Kafkaトピックはデータを送信しているのにライブ表にイベントが表示されない

これは、受信イベントがストリームの予期される形状に準拠していない場合に発生する可能性があります。形状の不一致によってイベントが削除されたかどうかを確認するため、次のステップを使用してトラブルシューティングを行います。

-

ストリームのソース・タイプ・プロパティでlenientパラメータを確認します。これがFALSEの場合、イベントは、形状の不一致によって削除された可能性があります。これを確認するには、実行中のアプリケーションのアプリケーション・ログを確認します。

-

プロパティがTRUEに設定されている場合、さらにデバッグを行います。

-

Kafkaクラスタが起動して実行中であることを確認します。Sparkクラスタは、Kafkaクラスタにアクセスできる必要があります。

-

Kafkaクラスタが起動して実行中である場合、アプリケーション・ログを取得してさらにデバッグを行います。

-

接続

この項では、接続で発生する一般的な問題をリストします。

接続がアクティブであることを確認する

Kafka接続

接続がKafka接続の場合、次のステップを使用します。

-

カタログに移動して、テストするKafka接続を選択します。

-

「次」をクリックして「接続の詳細」タブに移動します。

-

「接続のテスト」をクリックします。テストに成功すると、接続がアクティブであることが示されます。

データベース接続

接続がデータベース接続の場合、次のステップを使用します。

-

カタログに移動して、テストするデータベース接続を選択します。

-

「次」をクリックして「接続の詳細」タブに移動します。

-

「接続のテスト」をクリックします。テストに成功すると、接続がアクティブであることが示されます。

-

テストに失敗すると、データベースに接続できないことを示すエラー・メッセージが表示されます。 この問題を解決するには:

-

OSA-01260 データベースへの接続に失敗しました。IOエラー: ネットワーク・アダプタは接続を確立できませんでした- OSAデザイン・タイムからDBホストに接続できないことを示します -

OSA-01260 データベースへの接続に失敗しました。ORA-01017: ユーザー名/パスワードが無効です; ログインは拒否されました— これは、資格証明が不適切で、それらの資格証明を使用してデータベースにアクセスできないことを示します

-

Coherence接続

接続がCoherence接続の場合、次のステップを使用します。

OSAには、Coherenceクラスタの接続をテストする機能はありません。これを行うには、Oracle Coherenceのドキュメントを参照してユーティリティおよびツールを見つけてください。

Druid接続

接続がdruid接続の場合、次のステップを使用します。

-

カタログに移動して、テストするデータベース接続を選択します。

-

「次」をクリックして「接続の詳細」タブに移動します。

-

「接続のテスト」をクリックします。テストに成功すると、接続がアクティブであることが示されます。

-

「OSA-01460 zooKeeperサーバーのdruidサービスへの接続に失敗しました。」などのエラー・メッセージが表示された場合、druid Zookeeperは使用不可です。druidサービスとZookeeperクラスタが起動して実行中であることを確認します。

JNDI接続

接続がJNDI接続の場合、次のステップを使用します。

-

カタログに移動して、テストするデータベース接続を選択します。

-

「次」をクリックして「接続の詳細」タブに移動します。

-

「接続のテスト」をクリックします。テストに成功すると、接続がアクティブであることが示されます。

-

「OSA-01707 サーバーとの通信に失敗しました。サーバーが起動しており、サーバーURLが適切に指定されていることを確認してください。」などのエラー・メッセージが表示された場合、いずれかのサーバーが停止しているか、サーバーURLが間違って指定されています。サーバーURLは、host1:port1,host2:port2などのフォーマットでのみ指定できます。 -

「OSA-01706 JNDI接続に失敗しました。ユーザー: weblogicの認証に失敗しました」などのエラー・メッセージが表示された場合、ユーザー名とパスワードが正しく指定されていることを確認してください。

ターゲット

この項では、ターゲットで発生する一般的な問題をリストします。

ジオフェンス

この項では、ジオフェンスで発生する一般的な問題をリストします。

キューブ

この項では、キューブで発生する一般的な問題をリストします。

以前動作していたキューブを探索できない

以前動作していたキューブを探索できない場合、次に記載されたステップを実行します。

-

druid Zookeeperまたはインデクサ、ブローカ、中間マネージャ、オーバーロードの関連サービスが停止しているかどうかを確認します。

-

Druid接続をクリックして次のページに移動します。

-

接続をテストします。このステップにより、サービスが停止して調査が必要かどうかがわかります。

キューブに「データソースの準備ができていません」と表示される

キューブの探索時に「データソースの準備ができていません」というメッセージが表示され続ける場合、次に記載されたステップを実行します。

-

druidインデクサ・ログに移動します。通常、これは

http:/DRUID_HOST:3090/console.htmlです。 -

実行中のタスクでindex_kafka_<cube-name>_<somehash>というエントリを検索します。実行中のタスクにエントリがない場合、保留中のタスクまたは完了済タスクで同じエントリを検索します。

-

エントリが保留中のタスクに存在する場合、ワーカーは容量を使いはたし、データソースは索引付けに使用可能になるとすぐに取得されることを意味します。

-

このような場合、待機するかワーカーの容量を増やし、druidサービスを再起動するか、既存のデータソース索引付けタスクのいくつかを中断します(それらはしばらくして再起動されます)。

-

エントリが完了済タスクに「失敗」ステータスで存在する場合、索引付けが不適切な収集指定またはリソースの問題のために失敗したことを意味します。

-

「ログ(すべて)」リンクをクリックして例外に移動すると、正確な理由を確認できます。

-

収集が理由の場合は、タイムスタンプ書式の変更を試行してください。(Druidが索引付けに失敗するのは、タイムスタンプがJODA時間フォーマットではない場合、または指定された時間フォーマットがタイムスタンプ値のフォーマットに一致しない場合です)。

ダッシュボード

この項では、ダッシュボードで発生する一般的な問題をリストします。

以前表示されていたビジュアライゼーションがダッシュボードで使用できなくなる

次のステップを使用して、トラブルシューティングを行います。

-

ストリーミング・ビジュアライゼーションが欠落した場合、次の理由が考えられます。

-

欠落したビジュアライゼーションに対応するパイプライン/ステージがすでに存在しない

-

ビジュアライゼーションそれ自体がカタログまたはパイプライン・エディタから削除された

-

-

(キューブから作成された)探索ビジュアライゼーションが欠落した場合、キューブまたはビジュアライゼーションがすでに削除されている可能性があります。

ライブ出力のトラブルシューティング

パイプラインごとに、Sparkクラスタ上で1つのSparkストリーミング・パイプラインが実行されます。Stream Analyticsパイプラインで1つ以上の問合せステージまたはパターン・ステージを使用する場合、パイプラインでは、それらのステージごとに1つ以上の連続問合せが実行されます。

連続問合せの詳細は、「Oracle CQLの理解」を参照してください。

問合せステージまたはパターン・ステージのライブ出力表に出力イベントが存在しない場合、次のステップを使用して問題を特定するか、絞り込みます。

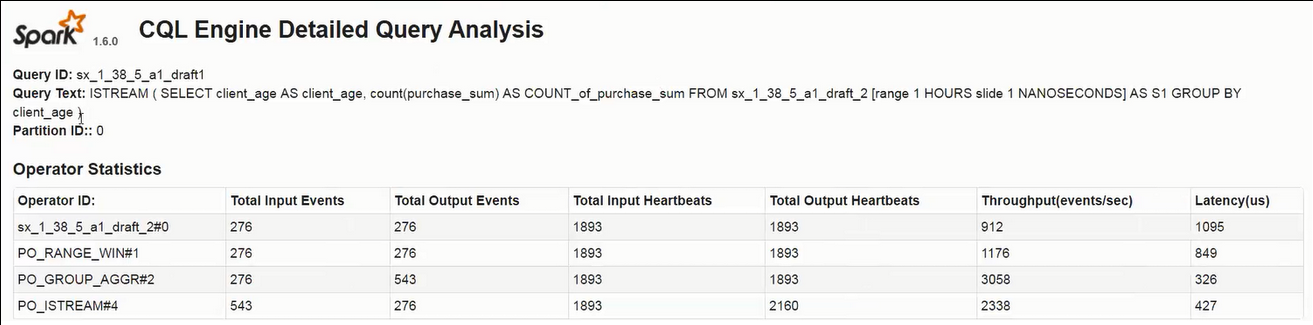

各問合せステージのCQL問合せが出力を発生させていることを確認する

CQL問合せが出力イベントを発生させているかどうかを確認し、CQLエンジン・メトリックを使用してCQL問合せをモニターします。

次のステップを使用して、出力イベントを確認します。

-

「CQL Engine Query Details」ページを開きます。詳細は、「CQLエンジン・メトリックへのアクセス」を参照してください。

-

少なくとも1つのパーティションで、「Execution Statistics」セクションに0 (ゼロ)より大きい「Total Output Events」があることを確認します。

図cql_engine_query_details.pngの説明問合せがエラーなしで実行され、入力データが継続的に受信される場合、「Total Output Events」は増加し続けます。

ステージの出力が使用できることを確認する

パイプラインのトラブルシューティングに必要な重要事項の1つは、ステージの出力がモニター・トピックで使用可能であることを確認することです。

次のステップを使用して、モニター・トピックで出力ストリームを使用できるかどうかを確認します。

-

パイプライン・エディタが開いたままであることを確認して、「完了」はクリックしないでください。そうしないと、パイプラインがアンデプロイされます。

-

ブラウザ内の任意の場所を右クリックし、「インスペクト」をクリックします。

-

最上位タブから「ネットワーク」を選択し、「WS」を選択します。

-

ブラウザをリフレッシュします。

新しいWebsocket接続が作成されます。

-

URLに

topicという名前の入ったパラメータが含まれるWebsocketを見つけます。トピックparamの値は、このステージの出力がプッシュされるKafkaトピックの名前です。

-

ステージの出力がプッシュされるKafkaトピックをリスニングします。

このトピックはKafka APIを使用して作成されるため、REST APIを使用してこのトピックを消費することはできません。次のステップを使用して、Kafkaトピックをリスニングします。

-

Oracle Event Hub Cloud ServiceでホストされているKafkaトピックをリスニングします。トピックをリスニングするには、Apache Kafkaユーティリティまたは他の関連ツールを使用する必要があります。

次のステップを使用して、Kafkaトピックをリスニングします。

-

Zookeeperアドレスを特定します。Oracle Event Hub Cloud Service Platformのホームページに移動します。ZookeeperのIPアドレスを見つけます。

- 次のコマンドを使用してKafkaトピックをリスニングします。

./kafka-console-consumer.sh --zookeeper IPAddress:2181 --topic sx_2_49_12_pipe1_draft_st60

-

-

標準のApache Kafkaインストール環境でホストされているKafkaトピックをリスニングします。

Kafkaインストール環境でユーティリティを使用してKafkaトピックをリスニングできます。

kafka-console-consumer.shは、任意のKafkaインストール環境の一部として使用できるユーティリティ・スクリプトです。次のステップを使用して、Kafkaトピックをリスニングします。

-

クラスタに基づくApache Kafkaインストール環境でのZookeeperアドレスを特定します。

- 次のコマンドを使用してKafkaトピックをリスニングします。

./kafka-console-consumer.sh --zookeeper IPAddress:2181 --topic sx_2_49_12_pipe1_draft_st60

-

-

CQLエンジン・メトリックへのアクセス

問合せまたはパターン・ステージを含むパイプラインがSparkクラスタにデプロイされている場合、Sparkクラスタ内で稼働するCQLエンジン・メトリックのセットを使用して複合イベント処理を実行できます。

CQL問合せを使用すると、イベントのストリームに対して、集計、関連付け、フィルタおよびパターン一致を行うことができます。Sparkでは、ユーザーが実行中のSparkストリーミング・パイプラインをモニターする際に役立つ即時利用可能なパイプラインUI (通常は<host>:4040で実行)を提供しています。CQL問合せは、Sparkストリーミング・パイプラインの一部としても実行されるため、SparkパイプラインUIは、CQL問合せのモニタリング機能を含めるように拡張されています。

CQLエンジン・メトリックにアクセスするには:

-

少なくとも1つの問合せまたはパターン・ステージを含むパイプラインを作成します。

-

Spark Masterユーザー・インタフェースに移動します。

-

「CQL Engine」タブをクリックします。

Spark CQLパイプライン内で実行されているすべての問合せの詳細を参照できます。このページには、パイプラインの一部として登録されている様々なストリーム/リレーションおよび外部リレーションも表示されます。

-

任意の問合せをクリックすると、その問合せの詳細が表示されます。問合せの詳細ページには、特定の実行中の問合せに関するパーティション単位の詳細が表示されます。

-

特定のパーティション・リンクをクリックして、問合せ計画および演算子レベルの詳細をさらに詳しく確認します。このページには、特定のパーティションを処理する問合せの演算子レベルの詳細が表示されます。