Oracle NoSQL Database-Migrator verwenden

Erfahren Sie mehr über Oracle NoSQL Database Migrator und wie Sie ihn für die Datenmigration verwenden.

Oracle NoSQL Database Migrator ist ein Tool, mit dem Sie Oracle NoSQL-Tabellen von einer Datenquelle in eine andere migrieren können. Dieses Tool kann für Tabellen in Oracle NoSQL Database Cloud Service, Oracle NoSQL Database On Premise und AWS S3 verwendet werden. Das Migrator-Tool unterstützt verschiedene Datenformate und physische Medientypen. Unterstützte Datenformate sind JSON-, Parquet-, JSON-formatierte MongoDB-, JSON-formatierte DynamoDB- und CSV-Dateien. Unterstützte physische Medientypen sind Dateien, OCI Object Storage, Oracle NoSQL Database On Premise, Oracle NoSQL Database Cloud Service und AWS S3.

Dieser Artikel enthält die folgenden Themen:

Verwandte Themen

Überblick

Mit dem Oracle NoSQL Database-Migrator können Sie Oracle NoSQL-Tabellen von einer Datenquelle in eine andere verschieben, wie Oracle NoSQL Database On Premise oder Cloud oder sogar eine einfache JSON-Datei.

Es kann viele Situationen geben, in denen Sie NoSQL-Tabellen von oder zu einer Oracle NoSQL Database migrieren müssen. Beispiel: Ein Entwicklerteam, das eine NoSQL-Datenbankanwendung erweitert, möchte möglicherweise seinen aktualisierten Code in der lokalen Oracle NoSQL Database Cloud Service-(NDCS-)Instanz mit cloudim testen. Um alle möglichen Testfälle zu überprüfen, müssen sie die Testdaten ähnlich den tatsächlichen Daten einrichten. Dazu müssen sie die NoSQL-Tabellen aus der Produktionsumgebung in ihre lokale NDCS-Instanz, die cloudim-Umgebung, kopieren. In einer anderen Situation müssen NoSQL-Entwickler ihre Anwendungsdaten möglicherweise für die Entwicklung oder für Tests von On Premise in die Cloud und umgekehrt verschieben.

In all diesen und vielen weiteren Fällen können Sie mit Oracle NoSQL Database Migrator Ihre NoSQL-Tabellen von einer Datenquelle in eine andere verschieben, wie Oracle NoSQL Database On-Premise oder Cloud oder sogar eine einfache JSON-Datei. Sie können auch NoSQL-Tabellen aus einer JSON-Eingabedatei im Format MongoDB, einer DynamoDB-formatierten JSON-Eingabedatei (entweder in der AWS-Quelle S3 oder aus Dateien gespeichert) oder einer CSV-Datei in Ihre NoSQL-Datenbank On-Premise oder Cloud kopieren.

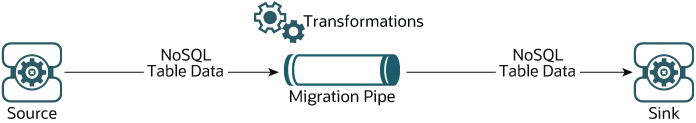

Wie in der folgenden Abbildung dargestellt, fungiert das Utility NoSQL Database Migrator als Connector oder Pipe zwischen der Datenquelle und dem Ziel (als Sink bezeichnet). Im Wesentlichen exportiert dieses Utility Daten aus der ausgewählten Quelle und importiert diese Daten in die Senke. Dieses Tool ist tabellenorientiert, d.h. Sie können die Daten nur auf Tabellenebene verschieben. Eine einzelne Migrationsaufgabe wird für eine einzelne Tabelle ausgeführt und unterstützt die Migration von Tabellendaten von der Quelle zum Senken in verschiedenen Datenformaten.

Mit Oracle NoSQL Database-Migrator verwendete Terminologie

Erfahren Sie mehr über die verschiedenen Begriffe, die im obigen Diagramm verwendet werden, im Detail.

- Quelle: Eine Entity, aus der die NoSQL-Tabellen für die Migration exportiert werden. Beispiele für Quellen sind Oracle NoSQL Database On-Premise oder Cloud, JSON-Datei, MongoDB-formatierte JSON-Datei, DynamoDB-formatierte JSON-Datei und CSV-Dateien.

- Sink: Eine Entity, die NoSQL-Tabellen aus NoSQL Database Migrator importiert. Beispiele für Senken sind Oracle NoSQL Database On Premise oder Cloud- und JSON-Datei.

Das NoSQL Database Migrator-Tool unterstützt verschiedene Typen von Quellen und Senken (d.h. physische Medien oder Repositorys von Daten) und Datenformaten (d.h. die Daten werden in der Quelle oder Senke dargestellt). Unterstützte Datenformate sind JSON-, Parquet-, JSON-formatierte MongoDB-, JSON-formatierte DynamoDB- und CSV-Dateien. Unterstützte Quell- und Sink-Typen sind Dateien, OCI Object Storage, Oracle NoSQL Database On Premise und Oracle NoSQL Database Cloud Service.

- Migrations-Pipe: Die Daten aus einer Quelle werden vom NoSQL Database Migrator an die Senke übertragen. Dies kann als Migration Pipe visualisiert werden.

- Transformationen: Sie können Regeln hinzufügen, um die Tabellendaten in der NoSQL-Pipe zu ändern. Diese Regeln werden Transformationen genannt. Der Oracle NoSQL Database-Migrator ermöglicht Datentransformationen nur in Feldern oder Spalten der obersten Ebene. Sie können die Daten in den verschachtelten Feldern nicht transformieren. Beispiele für zulässige Transformationen:

- Löschen oder ignorieren Sie eine oder mehrere Spalten,

- Benennen Sie eine oder mehrere Spalten um, oder

- Aggregieren Sie mehrere Spalten in einem einzelnen Feld, in der Regel ein JSON-Feld.

- Konfigurationsdatei: In einer Konfigurationsdatei definieren Sie alle für die Migrationsaktivität erforderlichen Parameter im JSON-Format. Später übergeben Sie diese Konfigurationsdatei als einzelnen Parameter über die CLI an den Befehl

runMigrator. Ein typisches Konfigurationsdateiformat sieht wie unten dargestellt aus.{ "source": { "type" : <source type>, //source-configuration for type. See Source Configuration Templates . }, "sink": { "type" : <sink type>, //sink-configuration for type. See Sink Configuration Templates . }, "transforms" : { //transforms configuration. See Transformation Configuration Templates . }, "migratorVersion" : "<migrator version>", "abortOnError" : <true|false> }Gruppieren Parameter Erforderlich (J/N) Zweck Unterstützte Werte sourcetypeY Stellt die Quelle dar, aus der die Daten migriert werden sollen. Die Quelle stellt Daten und Metadaten (sofern vorhanden) für die Migration bereit. Informationen zum Wert typefür jede Quelle finden Sie unter Unterstützte Quellen und Sinks.sourceQuellkonfiguration für Typ Y Definiert die Konfiguration für die Quelle. Diese Konfigurationsparameter sind spezifisch für den oben ausgewählten Quelltyp. Eine vollständige Liste der Konfigurationsparameter für jeden Quelltyp finden Sie unter Quellkonfigurationsvorlagen. sinktypeY Stellt die Senke dar, zu der die Daten migriert werden sollen. Die Sink ist das Ziel oder das Ziel für die Migration. Informationen zum Wert typefür jede Quelle finden Sie unter Unterstützte Quellen und Sinks.sinksink-Konfiguration für Typ Y Definiert die Konfiguration für die Senke. Diese Konfigurationsparameter sind spezifisch für den oben ausgewählten Sinkentyp. Eine vollständige Liste der Konfigurationsparameter für jeden Senktyp finden Sie unter Sink-Konfigurationsvorlagen. transformstransformiert die Konfiguration N Definiert die Transformationen, die auf die Daten in der Migrations-Pipe angewendet werden sollen. Eine vollständige Liste der Transformationen, die vom Datenmigrator NoSQL unterstützt werden, finden Sie unter Vorlagen für die Transformationskonfiguration. - migratorVersionN Version des Datenmigrators NoSQL - - abortOnErrorN Gibt an, ob die Migrationsaktivität bei Fehlern gestoppt werden soll.

Der Standardwert ist true. Dies bedeutet, dass die Migration gestoppt wird, wenn ein Migrationsfehler auftritt.

Wenn Sie diesen Wert auf false setzen, wird die Migration auch bei nicht erfolgreichen Datensätzen oder anderen Migrationsfehlern fortgesetzt. Die nicht erfolgreichen Datensätze und Migrationsfehler werden im CLI-Terminal als WARNINGs protokolliert.

True, False Hinweis:

Da bei der JSON-Datei die Groß-/Kleinschreibung beachtet wird, wird bei allen in der Konfigurationsdatei definierten Parametern die Groß-/Kleinschreibung beachtet, sofern nicht anders angegeben.

Unterstützte Quellen und Sinks

Dieses Thema enthält die Liste der Quellen und Senken, die vom Oracle NoSQL Database-Migrator unterstützt werden.

Sie können eine beliebige Kombination aus einer gültigen Quelle und Sink aus dieser Tabelle für die Migrationsaktivität verwenden. Sie müssen jedoch sicherstellen, dass mindestens eines der Enden, d.h. Quelle oder Sink, ein Oracle NoSQL-Produkt sein muss. Mit dem NoSQL-Datenbankmigrator können Sie die Tabellendaten der Datei NoSQL nicht von einer Datei in eine andere verschieben.

|

Typ |

Format |

Gültige Quelle | Gültiger Sink |

|---|---|---|---|

|

Oracle NoSQL Database |

- | Y | Y |

|

Oracle NoSQL Database Cloud Service |

- | Y | Y |

|

Dateisystem |

JSON |

Y | Y |

|

MongoDB JSON |

Y | N | |

|

DynamoDB JSON |

Y | N | |

|

Parquet( |

N | Y | |

|

CSV |

Y | N | |

|

OCI Object Storage |

JSON |

Y | Y |

|

MongoDB JSON |

Y | N | |

|

Parquet( |

N | Y | |

|

CSV |

Y | N | |

| AWS S3 |

DynamoDB JSON |

Y | N |

Hinweis:

Viele Konfigurationsparameter sind in der Quell- und Sink-Konfiguration gemeinsam. Zur einfacheren Referenzierung wird die Beschreibung solcher Parameter für jede Quelle und Sink in den Dokumentationsabschnitten wiederholt, die Konfigurationsdateiformate für verschiedene Arten von Quellen und Senken erläutern. In allen Fällen sind Syntax und Semantik der Parameter mit demselben Namen identisch.Sicherheit für Quelle und Ziel ("Sink")

Einige Quell- und Sink-Typen verfügen zu Authentifizierungszwecken über optionale oder obligatorische Sicherheitsinformationen.

Alle Quellen und Senken, die Services in Oracle Cloud Infrastructure (OCI) verwenden, können bestimmte Parameter zur Angabe optionaler Sicherheitsinformationen verwenden. Diese Informationen können mit einer OCI-Konfigurationsdatei oder einem Instanz-Principal bereitgestellt werden.

Oracle NoSQL Database-Quellen und -Senken erfordern obligatorische Sicherheitsinformationen, wenn die Installation sicher ist und eine Oracle Wallet-basierte Authentifizierung verwendet. Diese Informationen können durch Hinzufügen einer JAR-Datei zum Verzeichnis <MIGRATOR_HOME>/lib bereitgestellt werden.

Authentifizieren mit Instance Principals

Instanz-Principals ist ein IAM-Servicefeature, mit dem Instanzen als autorisierte Akteure (oder Principals) Aktionen für Dienstressourcen ausführen können. Jede Compute-Instanz hat eine eigene Identität und authentifiziert die Zertifikate, die ihr hinzugefügt wurden.

Oracle NoSQL Database Migrator bietet eine Option zum Herstellen einer Verbindung zu einer NoSQL-Cloud und OCI Object Storage-Quellen und -Senken mit Instanz-Principal-Authentifizierung. Sie wird nur unterstützt, wenn das NoSQL Database Migrator-Tool innerhalb einer OCI-Compute-Instanz verwendet wird. Beispiel: Das NoSQL Database Migrator-Tool, das in einer auf OCI gehosteten VM ausgeführt wird. Um dieses Feature zu aktivieren, verwenden Sie das Attribut useInstancePrincipal der Cloud-Quell- und -Sink-Konfigurationsdatei NoSQL. Weitere Informationen zu Konfigurationsparametern für verschiedene Typen von Quellen und Senken finden Sie unter Quellkonfigurationsvorlagen und Sinkkonfigurationsvorlagen.

Weitere Informationen zu Instance Principals finden Sie unter Services von einer Instanz aufrufen.

Autorisierung in Oracle NoSQL Database Cloud Service-Quellen und -Sinks

Der Zugriff auf Ressourcen in Oracle NoSQL Database Cloud Service, wie Tabellen, Tablespaces und APIs, wird über Identity and Access Management-(IAM-)Policys verwaltet. Dadurch wird sichergestellt, dass nur Benutzer oder Anwendungen mit den entsprechenden Berechtigungen zum Prüfen, Lesen, Verwenden oder Verwalten von Tabellen in einem bestimmten Compartment mit diesen Ressourcen interagieren können. Weitere Informationen finden Sie unter Zugriff auf NDCS-Tabellen verwalten.

Wenn Sie Daten mit dem Migrator-Utility aus Oracle NoSQL Database Cloud Service-Tabellen importieren oder exportieren, bestimmen Ihre effektiven IAM-Berechtigungen die Ressourcen, aus denen Sie lesen oder in die Sie schreiben können. Wenn ein Benutzer aus einer definierten Gruppe eine Aktion über seine autorisierten Berechtigungen hinaus versucht, gibt das Migrator-Utility den entsprechenden Autorisierungsfehler zurück, der von OCI IAM bereitgestellt wird.

[INSUFFICIENT_PERMISSION] Authorization failed or requested resource not foundWorkflow für Oracle NoSQL Database-Migrator

Sie lernen die verschiedenen Schritte kennen, die Sie mit dem Utility Oracle NoSQL Database Migrator für die Migration der NoSQL-Daten ausführen.

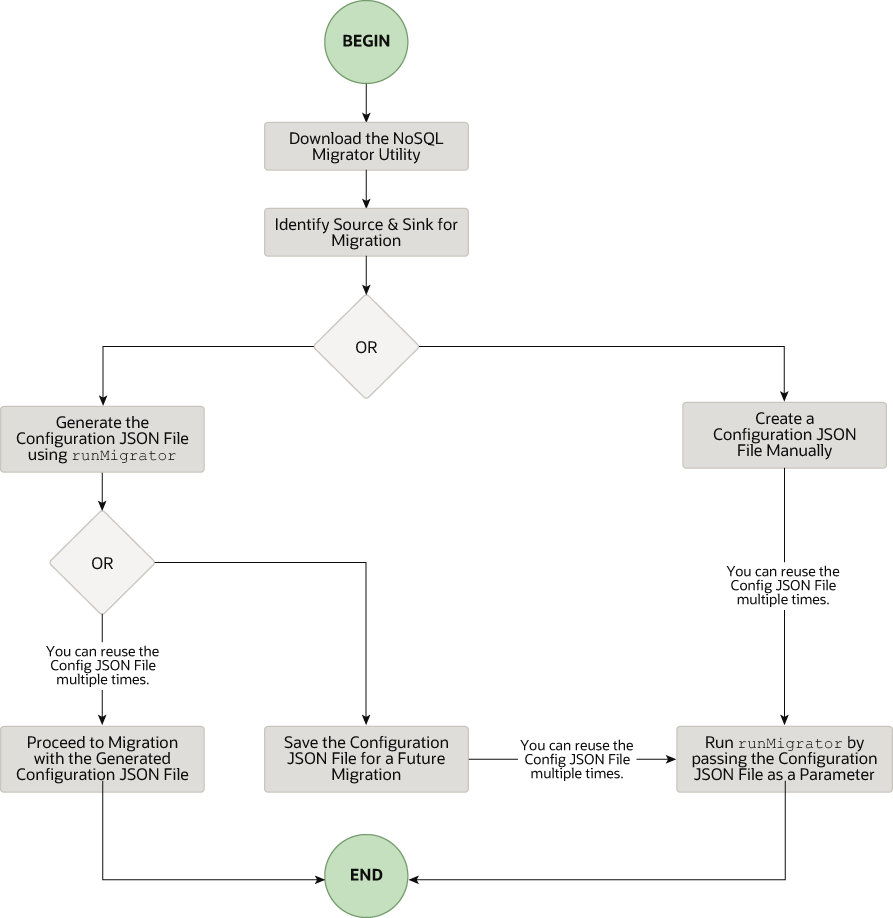

Der allgemeine Ablauf der Aufgaben bei der Verwendung von NoSQL Database Migrator wird in der folgenden Abbildung dargestellt.

Laden Sie das Datenmigrator-Utility NoSQL herunter

runMigrator zugreifen.

Hinweis:

Das Utility Oracle NoSQL Database Migrator erfordert die Ausführung von Java 11 oder höher.Quelle und Sink identifizieren

- Sink-Tabellenschema identifizieren: Wenn die Sink Oracle NoSQL Database On-Premise oder Cloud ist, müssen Sie das Schema für die Sink-Tabelle identifizieren und sicherstellen, dass die Quelldaten mit dem Zielschema übereinstimmen. Verwenden Sie bei Bedarf Transformationen, um die Quelldaten der Sink-Tabelle zuzuordnen.

-

Standardschema: NoSQL Database Migrator bietet eine Option zum Erstellen einer Sink-Tabelle mit dem Standardschema, ohne dass das Schema für die Tabelle vordefiniert werden muss.

MongoDB-formatierte JSON:

Wenn die Quelle eine JSON-Datei im MongoDB-Format ist, lautet das Standardschema für die Tabelle wie folgt:CREATE TABLE IF NOT EXISTS <tablename>(id STRING, document JSON,PRIMARY KEY(SHARD(id))Dabei gilt:

- tablename = Wert, der für das Tabellenattribut in der Konfiguration angegeben wird.

– id = _id Wert aus jedem Dokument der exportierten JSON-Quelldatei MongoDB.

– document = Für jedes Dokument in der exportierten Datei MongoDB werden die Inhalte außer dem Feld_idin der Dokumentspalte aggregiert.Hinweis:

- Wenn der _id-Wert in der MongoDB-formatierten JSON-Datei nicht als Zeichenfolge angegeben wird, konvertiert NoSQL Database Migrator ihn in eine Zeichenfolge, bevor er in das Standardschema eingefügt wird.

- Wenn die Tabelle <tablename> bereits in Oracle NoSQL Database On Premise oder in der Cloud vorhanden ist und Sie Daten mit der Konfiguration

defaultSchemain die Tabelle migrieren möchten, müssen Sie sicherstellen, dass die vorhandene Tabelle die ID-Spalte in Kleinbuchstaben (ID) und den Typ STRING aufweist.

DynamoDB-formatierte JSON:

Wenn die Quelle eine JSON-Datei im DynamoDB-Format ist, lautet das Standardschema für die Tabelle wie folgt:CREATE TABLE IF NOT EXISTS <tablename>(DDBPartitionKey_name DDBPartitionKey_type, [DDBSortKey_name DDBSortKey_type],DOCUMENT JSON, PRIMARY KEY(SHARD(DDBPartitionKey_name),[DDBSortKey_name]))Dabei gilt:

— tablename = Wert für die Sink-Tabelle in der Konfiguration

- DDBPartitionKey_name = Wert, der für den Partitionsschlüssel in der Konfiguration angegeben wird

- DDBPartitionKey_type = für den Datentyp des Partitionsschlüssels in der Konfiguration angegebener Wert

- DDBSortKey_name = Wert, der für den Sortierschlüssel in der Konfiguration angegeben wird, falls vorhanden

- DDBSortKey_type = Wert, der für den Datentyp des Sortierschlüssels in der Konfiguration angegeben wird, falls vorhanden

— DOCUMENT = Alle Attribute außer dem Partitions- und Sortierschlüssel eines DynamoDB-Tabellenelements, aggregiert in eine JSON-Spalte NoSQL

Wenn das Quellformat eine CSV-Datei ist, wird für die Zieltabelle kein Standardschema unterstützt. Sie können eine Schemadatei mit einer Tabellendefinition erstellen, die dieselbe Anzahl von Spalten und Datentypen wie die CSV-Quelldatei enthält. Weitere Informationen zum Erstellen von Schemadateien finden Sie unter Tabellenschema bereitstellen.

Andere gültige Quellen:

Für alle anderen Quellen lautet das Standardschema wie folgt:CREATE TABLE IF NOT EXISTS <tablename> (id LONG GENERATED ALWAYS AS IDENTITY, document JSON, PRIMARY KEY(id))Dabei gilt:

- tablename = Wert, der für das Tabellenattribut in der Konfiguration angegeben wird.

— id = Ein automatisch generierter LONG-Wert.

– document = Der von der Quelle bereitgestellte JSON-Datensatz wird in die Dokumentspalte aggregiert.

-

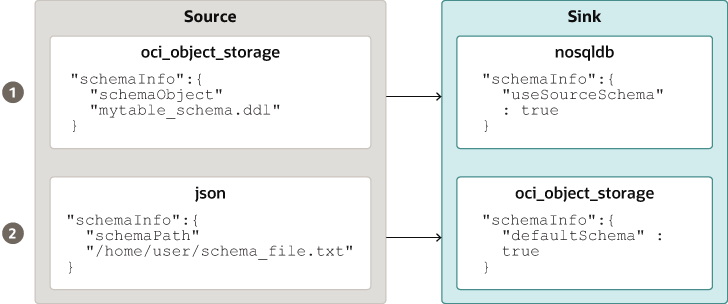

- Tabellenschema angeben: Mit NoSQL Database Migrator kann die Quelle Schemadefinitionen für die Tabellendaten mit dem Attribut schemaInfo angeben. Das Attribut schemaInfo ist in allen Datenquellen verfügbar, für die noch kein implizites Schema definiert ist. Sink-Datenspeicher können eine der folgenden Optionen auswählen:

- Verwenden Sie das vom NoSQL Database Migrator definierte Standardschema.

- Verwenden Sie das von der Quelle bereitgestellte Schema.

- Überschreiben Sie das von der Quelle bereitgestellte Schema, indem Sie ein eigenes Schema definieren. Beispiel: Wenn Sie die Daten aus dem Quellschema in ein anderes Schema transformieren möchten, müssen Sie das von der Quelle bereitgestellte Schema außer Kraft setzen und die Transformationsfunktion des Tools NoSQL Database Migrator verwenden.

Die Tabellenschemadatei, z.B.mytable_schema.DDL, kann Tabellen-DDL-Anweisungen enthalten. Das Tool NoSQL Database Migrator führt diese Tabellenschemadatei aus, bevor die Migration gestartet wird. Das Migrator-Tool unterstützt nicht mehr als eine DDL-Anweisung pro Zeile in der Schemadatei. Beispiel:CREATE TABLE IF NOT EXISTS(id INTEGER, name STRING, age INTEGER, PRIMARY KEY(SHARD(ID)))Hinweis:

Die Migration verläuft nicht erfolgreich, wenn die Tabelle an der Senke vorhanden ist und die DDL inschemaPathsich von der Tabelle unterscheidet. - Sink-Tabelle erstellen: Nachdem Sie das Sink-Tabellenschema identifiziert haben, erstellen Sie die Sink-Tabelle entweder über die Admin-CLI oder mit dem Attribut

schemaInfoder Sink-Konfigurationsdatei. Siehe Sink-Konfigurationsvorlagen.Hinweis:

Wenn die Quelle eine CSV-Datei ist, erstellen Sie eine Datei mit den DDL-Befehlen für das Schema der Zieltabelle. Geben Sie den Dateipfad im Parameter schemaInfo.schemaPath der Sink-Konfigurationsdatei an.

Führen Sie den Befehl runMigrator aus.

Die ausführbare Datei runMigrator ist in den extrahierten NoSQL Database Migrator-Dateien verfügbar. Sie müssen Java 11 oder eine höhere Version und bash auf Ihrem System installieren, um den Befehl runMigrator erfolgreich ausführen zu können.

runMigrator auf zwei Arten ausführen:

- Indem Sie die Konfigurationsdatei mit den Laufzeitoptionen des Befehls

runMigratorerstellen, wie unten gezeigt.[~]$ ./runMigrator configuration file is not provided. Do you want to generate configuration? (y/n) [n]: y ... ...- Wenn Sie das Utility

runMigratoraufrufen, stellt es eine Reihe von Laufzeitoptionen bereit und erstellt die Konfigurationsdatei basierend auf Ihren Auswahlmöglichkeiten für jede Option. - Nachdem das Utility die Konfigurationsdatei erstellt hat, können Sie die Migrationsaktivität in derselben Ausführung fortsetzen oder die Konfigurationsdatei für eine zukünftige Migration speichern.

- Unabhängig davon, ob Sie die Migrationsaktivität mit der generierten Konfigurationsdatei fortsetzen oder verschieben möchten, kann die Datei bearbeitet oder angepasst werden, um Ihre zukünftigen Anforderungen zu erfüllen. Sie können die benutzerdefinierte Konfigurationsdatei später für die Migration verwenden.

- Wenn Sie das Utility

- Durch Übergabe einer manuell erstellten Konfigurationsdatei (im JSON-Format) als Laufzeitparameter mit der Option

-coder--config. Sie müssen die Konfigurationsdatei manuell erstellen, bevor Sie den BefehlrunMigratormit der Option-coder--configausführen. Weitere Informationen zu den Quell- und Sinkkonfigurationsparametern finden Sie in der Oracle NoSQL Database-Migratorreferenz.[~]$ ./runMigrator -c </path/to/the/configuration/json/file>

Hinweis:

NoSQL Database Migrator verbraucht Leseeinheiten beim Datenexport aus der Oracle NoSQL Cloud Service-Tabelle in eine beliebige gültige Sink.Fortschritt des Logging-Migrators

Das Tool NoSQL Database Migrator bietet Optionen, mit denen Trace-, Debugging- und Fortschrittsmeldungen in die Standardausgabe oder in eine Datei gedruckt werden können. Diese Option kann nützlich sein, um den Fortschritt des Migrationsvorgangs zu verfolgen, insbesondere bei sehr großen Tabellen oder Datasets.

- Logebenen

Um das Loggingverhalten über das Tool NoSQL Database Migrator zu steuern, übergeben Sie den Parameter --log-level oder -l Runtime an den Befehl

runMigrator. Sie können die Menge der zu schreibenden Loginformationen angeben, indem Sie den entsprechenden Logebenenwert übergeben.$./runMigrator --log-level <loglevel>Beispiel:$./runMigrator --log-level debugTabelle - Unterstützte Logebenen für NoSQL Database Migrator

Logebene Beschreibung Warnung Druckt Fehler und Warnungen. Informationen (Standard) Druckt den Fortschrittsstatus der Datenmigration, wie die Validierung der Quelle, die Validierung der Senke, das Erstellen von Tabellen und die Anzahl der migrierten Datensätze. debug Druckt zusätzliche Debuginformationen. all Druckt alles. Diese Ebene aktiviert alle Logging-Ebenen. - Logdatei:

Sie können den Namen der Logdatei mit dem Parameter --log-file oder -f angeben. Wenn --log-file als Laufzeitparameter an den Befehl

runMigratorübergeben wird, schreibt der NoSQL Database Migrator alle Logmeldungen in die andere Datei in die Standardausgabe.$./runMigrator --log-file <log file name>Beispiel:$./runMigrator --log-file nosql_migrator.log

Beschränkung

Oracle NoSQL Database Migrator sperrt die Datenbank während des Backups nicht und blockiert andere Benutzer. Daher wird dringend empfohlen, die folgenden Aktivitäten nicht auszuführen, wenn eine Migrationsaufgabe ausgeführt wird:

- Alle DML-/DDL-Vorgänge in der Quelltabelle.

- Jede topologiebezogene Änderung im Datenspeicher.

TTL-Metadaten für Tabellenzeilen migrieren

Erfahren Sie, wie Sie TTL-Daten von der Quelle zur Senke migrieren.

Die Gültigkeitsdauer (TTL) ist ein Verfahren, mit dem Sie den automatischen Ablauf von Tabellenzeilen festlegen können. Die Gültigkeitsdauer gibt an, wie lange Daten im Shop gültig sind. Daten, deren Ablauf-Timeoutwert erreicht wurde, können nicht mehr abgerufen werden und werden in keinen Speicherstatistiken angezeigt.

Tabelle - TTL-Metadaten migrieren

| Quelltypen | Quellkonfigurationsparameter | Sink-Konfigurationsparameter |

|---|---|---|

| Oracle NoSQL Database | includeTTL |

includeTTL |

| Oracle NoSQL Database Cloud Service | includeTTL |

includeTTL |

| DynamoDB-formatierte JSON-Datei | ttlAttributeName |

includeTTL |

| DynamoDB-formatierte JSON-Datei in AWS gespeichert S3 | ttlAttributeName |

includeTTL |

TTL-Metadaten in Oracle NoSQL Database und Oracle NoSQL Database Cloud Service exportieren

NoSQL Database Migrator stellt den Konfigurationsparameter includeTTL bereit, um den Export der TTL-Metadaten der Tabellenzeile zu unterstützen.

_metadata nicht explizit in die exportierten Daten aufgenommen, da der Ablaufwert immer 0 ist. Der NoSQL Database Migrator exportiert die Ablaufzeit für jede Zeile als die Anzahl der Millisekunden seit der UNIX-Epoche (1. Januar 1970). Beispiel: //Row 1

{

"id" : 1,

"name" : "xyz",

"age" : 45,

"_metadata" : {

"expiration" : 1629709200000 //Row Expiration time in milliseconds

}

}

//Row 2

{

"id" : 2,

"name" : "abc",

"age" : 52,

"_metadata" : {

"expiration" : 1629709400000 //Row Expiration time in milliseconds

}

}

//Row 3 No Metadata for below row as it will not expire

{

"id" : 3,

"name" : "def",

"age" : 15

}TTL-Metadaten importieren

Sie können optional TTL-Metadaten mit dem Konfigurationsparameter includeTTL in der Sink-Konfigurationsvorlage importieren.

Die Standardreferenzzeit des Importvorgangs ist die aktuelle Zeit in Millisekunden, die von System.currentTimeMillis() abgerufen wird, auf dem Rechner, auf dem das NoSQL Database Migrator-Tool ausgeführt wird. Sie können jedoch auch eine benutzerdefinierte Referenzzeit mit dem Konfigurationsparameter ttlRelativeDate festlegen, wenn Sie die Ablaufzeit verlängern und Zeilen importieren möchten, die andernfalls sofort ablaufen würden. Die Verlängerung wird wie folgt berechnet und der Ablaufzeit hinzugefügt.

Extended time = expiration time - reference timeDer Importvorgang verarbeitet die folgenden Anwendungsfälle beim Migrieren von Tabellenzeilen mit TTL-Metadaten. Diese Anwendungsfälle sind nur anwendbar, wenn der Konfigurationsparameter includeTTL auf "true" gesetzt ist.

- Anwendungsfall 1: In der Zeile der importierenden Tabelle sind keine TTL-Metadateninformationen vorhanden.

Wenn die Zeile, die Sie importieren möchten, keine TTL-Informationen enthält, legt der NoSQL Database Migrator den TTL=0 für die Zeile fest.

- Anwendungsfall 2: Der TTL-Wert der Quelltabellenzeile ist relativ zur Referenzzeit abgelaufen, wenn die Tabellenzeile importiert wird.

Die abgelaufene Tabellenzeile wird ignoriert und nicht in den Speicher geschrieben.

- Anwendungsfall 3: Der TTL-Wert der Quelltabellenzeile ist im Verhältnis zur Referenzzeit beim Import der Tabellenzeile nicht abgelaufen.

Die Tabellenzeile wird mit einem TTL-Wert importiert. Der importierte TTL-Wert stimmt jedoch aufgrund der Constraints im ganzzahligen Stunden- und Tagesfenster in der Klasse TimeToLive möglicherweise nicht mit dem ursprünglichen exportierten TTL-Wert überein. Beispiel:

Betrachten Sie eine exportierte Tabellenzeile:{ "id" : 8, "name" : "xyz", "_metadata" : { "expiration" : 1734566400000 //Thursday, December 19, 2024 12:00:00 AM in UTC } }Die Referenzzeit beim Import ist 1734480000000, d.h. Mittwoch, 18. Dezember 2024, 12:00:00 Uhr.

Importierte Tabellenzeile{ "id" : 8, "name" : "xyz", "_metadata" : { "ttl" : 1734739200000 //Saturday, December 21, 2024 12:00:00 AM } }

TTL-Metadaten in DynamoDB-formatierte JSON-Datei und in AWS gespeicherte DynamoDB-formatierte JSON-Datei importieren S3

NoSQL Database Migrator stellt einen zusätzlichen Konfigurationsparameter ttlAttributeName bereit, um den Import von TTL-Metadaten aus den DynamoDB-formatierten JSON-Dateielementen zu unterstützen.

DynamoDB exportierte JSON-Dateien enthalten ein bestimmtes Attribut in jedem Element, um den TTL-Ablaufzeitstempel zu speichern. Um optional die TTL-Werte aus exportierten JSON-Dateien von DynamoDB zu importieren, müssen Sie den Namen des spezifischen Attributs als Wert für den Konfigurationsparameter ttlAttributeName in der DynamoDB-formatierten JSON-Datei oder der DynamoDB-formatierten JSON-Datei angeben, die in AWS S3-Quellkonfigurationsdateien gespeichert ist. Außerdem müssen Sie den Konfigurationsparameter includeTTL in der Sink-Konfigurationsvorlage festlegen. Gültige Sinks sind Oracle NoSQL Database und Oracle NoSQL Database Cloud Service. NoSQL Database Migrator speichert TTL-Informationen im JSON-Objekt _metadata für das importierte Element.

-

Anwendungsfall 1: Der Konfigurationsparameterwert ttlAttributeName wird auf den TTL-Attributnamen gesetzt, der in der exportierten JSON-Datei DynamoDB angegeben ist.

NoSQL Database Migrator importiert die Ablaufzeit für dieses Element als die Anzahl der Millisekunden seit der UNIX-Epoche (1. Januar 1970).

Beispiel: Ein Element in der exportierten JSON-Datei DynamoDB:{ "Item": { "DeptId": { "N": "1" }, "DeptName": { "S": "Engineering" }, "ttl": { "N": "1734616800" } } }Hier gibt das Attributttlden Gültigkeitsdauerwert für das Element an. Wenn Sie den Konfigurationsparameter ttlAttributeName in der DynamoDB-formatierten JSON-Datei oder der DynamoDB-formatierten JSON-Datei, die in der AWS-Quellkonfigurationsdatei S3 gespeichert ist, alsttlfestlegen, importiert NoSQL Database Migrator die Ablaufzeit für das Element wie folgt:{ "DeptId": 1, "document": { "DeptName": "Engineering" } "_metadata": { "expiration": 1734616800000 } }Hinweis:

Sie können den Konfigurationsparameter ttlRelativeDate in der Sink-Konfigurationsvorlage als Referenzzeit für die Berechnung der Ablaufzeit angeben. - Anwendungsfall 2: Der Konfigurationsparameterwert ttlAttributeName ist festgelegt. Der Wert ist jedoch nicht als Attribut im Element der exportierten JSON-Datei DynamoDB vorhanden.

NoSQL Database Migrator importiert die TTL-Metadateninformationen für das angegebene Element nicht.

- Anwendungsfall 3: Der Wert des Konfigurationsparameters ttlAttributeName stimmt nicht mit dem Attributnamen im Element der exportierten JSON-Datei DynamoDB überein.

NoSQL Database Migrator verarbeitet den Import auf eine der folgenden Arten basierend auf der Sink-Konfiguration:

- Kopiert das Attribut als normales Feld, wenn es für den Import mit dem Standardschema konfiguriert ist.

- Überspringt das Attribut, wenn es für den Import mit einem benutzerdefinierten Schema konfiguriert ist.

Daten in eine Sink mit einer IDENTITY-Spalte importieren

Erfahren Sie, wie Sie Daten in eine Senke importieren, die eine IDENTITY-Spalte enthält.

Sie können die Daten aus einer gültigen Quelle in eine Sink-Tabelle (On-Premise/Cloud Services) mit einer IDENTITY-Spalte importieren. Sie erstellen die IDENTITY-Spalte entweder als IMMER ALS IDENTITÄT GENERIERT oder durch DEFAULT AS IDENTITÄT GENERIERT. Weitere Informationen zur Tabellenerstellung mit einer IDENTITY-Spalte finden Sie unter Tabellen mit einer IDENTITY-Spalte erstellen im SQL Reference Guide.

Stellen Sie vor dem Import der Daten sicher, dass die Oracle NoSQL Database-Tabelle an der Senke leer ist, sofern vorhanden. Wenn bereits Daten in der Sink-Tabelle vorhanden sind, kann die Migration zu Problemen führen, wie dem Überschreiben vorhandener Daten in der Sink-Tabelle oder dem Überspringen von Quelldaten während des Imports.

Tabelle mit IDENTITY-Spalte als IMMER GENERIERT WIE IDENTITY

Betrachten Sie eine Sink-Tabelle mit der IDENTITY-Spalte, die als GENERATED ALWAYS AS IDENTITY erstellt wurde. Der Datenimport hängt davon ab, ob die Quelle die Werte für die IDENTITY-Spalte und den ignoreFields-Transformationsparameter in der Konfigurationsdatei bereitstellt.

Beispiel: Sie möchten Daten aus einer JSON-Dateiquelle als Sink in die Oracle NoSQL Database-Tabelle importieren. Das Schema der Sink-Tabelle lautet:

CREATE TABLE IF NOT EXISTS migrateID(ID INTEGER GENERATED ALWAYS AS IDENTITY, name STRING, course STRING, PRIMARY KEY

(ID))| Quellbedingung | Benutzeraktion | Migrationsergebnis |

|---|---|---|

|

FALL 1: Quelldaten geben keinen Wert für das IDENTITY-Feld der Sink-Tabelle an. Beispiel: JSON-Quelldatei |

Erstellen/generieren Sie die Konfigurationsdatei. |

Datenmigration erfolgreich. IDENTITY-Spaltenwerte werden automatisch generiert. Migrierte Daten in Oracle NoSQL Database-Sink-Tabelle |

|

FALL 2: Quelldaten liefern Werte für das IDENTITY-Feld der Sink-Tabelle. Beispiel: JSON-Quelldatei |

Erstellen/generieren Sie die Konfigurationsdatei. Sie geben eine ignoreFields-Transformation für die ID-Spalte in der Sink-Konfigurationsvorlage an.

|

Datenmigration erfolgreich. Die angegebenen ID-Werte werden übersprungen, und die IDENTITY-Spaltenwerte werden automatisch generiert. Migrierte Daten in Oracle NoSQL Database-Sink-Tabelle

migrateID: |

|

Sie erstellen/generieren die Konfigurationsdatei ohne die Transformation ignoreFields für die IDENTITY-Spalte. |

Die Datenmigration ist mit der folgenden Fehlermeldung nicht erfolgreich: "Cannot set value for a generated always identity column". |

Weitere Informationen zu den Parametern für die Transformationskonfiguration finden Sie im Thema Vorlagen für die Transformationskonfiguration.

Sink-Tabelle mit IDENTITY-Spalte als GENERIERT VON DEFAULT AS IDENTITY

Betrachten Sie eine Sink-Tabelle mit der IDENTITY-Spalte, die als GENERATED BY DEFAULT AS IDENTITY erstellt wurde. Der Datenimport hängt davon ab, ob die Quelle die Werte für die IDENTITY-Spalte und den Transformationsparameter ignoreFields bereitstellt.

Beispiel: Sie möchten Daten aus einer JSON-Dateiquelle als Sink in die Oracle NoSQL Database-Tabelle importieren. Das Schema der Sink-Tabelle lautet:

CREATE TABLE IF NOT EXISTS migrateID(ID INTEGER GENERATED BY DEFAULT AS IDENTITY, name STRING, course STRING, PRIMARY KEY

(ID))| Quellbedingung | Benutzeraktion | Migrationsergebnis |

|---|---|---|

|

FALL 1: Quelldaten geben keinen Wert für das IDENTITY-Feld der Sink-Tabelle an. Beispiel: JSON-Quelldatei |

Erstellen/generieren Sie die Konfigurationsdatei. |

Datenmigration erfolgreich. IDENTITY-Spaltenwerte werden automatisch generiert. Migrierte Daten in Oracle NoSQL Database-Sink-Tabelle

migrateID: |

|

FALL 2: Quelldaten liefern Werte für das IDENTITY-Feld der Sink-Tabelle und sind ein Primärschlüsselfeld. Beispiel: JSON-Quelldatei |

Erstellen/generieren Sie die Konfigurationsdatei. Sie geben eine ignoreFields-Transformation für die ID-Spalte in der Sinkkonfigurationsvorlage (Empfohlen) an.

|

Datenmigration erfolgreich. Die angegebenen ID-Werte werden übersprungen, und die IDENTITY-Spaltenwerte werden automatisch generiert. Migrierte Daten in Oracle NoSQL Database-Sink-Tabelle

migrateID: |

|

Sie erstellen/generieren die Konfigurationsdatei ohne die Transformation ignoreFields für die IDENTITY-Spalte. |

Datenmigration erfolgreich. Die angegebenen Wenn Sie versuchen, eine zusätzliche Zeile in die Tabelle einzufügen, ohne einen ID-Wert anzugeben, versucht der Sequence-Generator, den ID-Wert automatisch zu generieren. Der Startwert des Sequenzgenerators ist 1. Daher kann der generierte ID-Wert möglicherweise einen der vorhandenen ID-Werte in der Sink-Tabelle duplizieren. Da dies eine Verletzung des Primärschlüssel-Constraints darstellt, wird ein Fehler zurückgegeben, und die Zeile wird nicht eingefügt. Weitere Informationen finden Sie unter Sequence Generator. Um eine Verletzung des Primärschlüssel-Constraints zu vermeiden, muss der Sequence-Generator die Sequence mit einem Wert starten, der nicht mit vorhandenen ID-Werten in der Sink-Tabelle in Konflikt steht. Im folgenden Beispiel wird beschrieben, wie Sie das Attribut START WITH verwenden, um diese Änderung vorzunehmen: Beispiel: Migrierte Daten in der Oracle NoSQL Database-Sink-Tabelle

migrateID:Um den entsprechenden Wert für den Sequence-Generator zu finden, der in die ID-Spalte eingefügt werden soll, rufen Sie den Höchstwert des Feldes

ID mit der folgenden Abfrage ab:Ausgabe:

Der maximale Wert der Spalte

ID in der Sink-Tabelle ist 3. Sie möchten, dass der Sequence-Generator die ID-Werte über 3 hinaus generiert, um eine Duplizierung zu vermeiden. Mit der folgenden Anweisung aktualisieren Sie das START WITH-Attribut des Sequence-Generators auf 4:Dadurch wird die Sequenz bei 4 gestartet. Wenn Sie nun Zeilen in die Sink-Tabelle einfügen, ohne die ID-Werte anzugeben, generiert der Sequence-Generator die ID-Werte ab 4 automatisch und verhindert so die Duplizierung der IDs. |

Weitere Informationen zu den Parametern für die Transformationskonfiguration finden Sie im Thema Vorlagen für die Transformationskonfiguration.

Daten mit Abfrageprädikaten filtern

Erfahren Sie, wie Sie Abfrageprädikate angeben, um nur die Tabellenzeilen zu exportieren, die den Filterkriterien entsprechen.

Abfrageprädikat

NoSQL Database Migrator bietet eine Option zum Filtern von Daten während des Exports, indem ein Abfrageprädikat angegeben wird. Das Abfrageprädikat gibt Bedingungen an, die erfüllt sein müssen, damit eine Zeile exportiert werden kann. Das Migrator-Utility übersetzt das Abfrageprädikat in eine SQL WHERE-Klausel und wendet es auf die angegebene Tabelle an, um eine Filterbedingung bereitzustellen, mit der nur die Zeilen exportiert werden, die mit der angegebenen Bedingung übereinstimmen. Sie können integrierte Funktionen (modification_time(), expiration_time(), creation_time()) im Abfrageprädikat verwenden, um erweiterte Filteroptionen zu erstellen.

Sie können Abfrageprädikate nur für Oracle NoSQL Database- und Oracle NoSQL Database Cloud Service-Quellen für alle unterstützten Sinks verwenden. Weitere Informationen finden Sie unter Oracle NoSQL Database und Oracle NoSQL Database Cloud Service.

Eine Anwendungsfalldemonstration finden Sie unter Von Oracle NoSQL Database Cloud Service in eine JSON-Datei migrieren.

Filter ausgeben

Das Utility Migrator bietet eine Option, um die SQL-Abfrage zu wiederholen, die auf dem Backend ausgeführt wird. Mit diesem Feature können Sie die generierte Abfrage prüfen und bei Bedarf den Filter verfeinern, bevor Sie die Migrationsaufgabe ausführen.

[~/nosqlMigrator]$./runMigrator --dump-filter|df [optional-config-file]-

Mit der Konfigurationsdatei: Das Migrator-Utility zeigt die bereitgestellte Konfigurationsdatei und die generierte Abfrage an, wie im folgenden Beispiel dargestellt:

[~/nosqlMigrator]./runMigrator --dump-filter migrator-config.json[INFO] Configuration for migration: { "source" : { "type" : "nosqldb", "storeName" : "kvstore", "helperHosts" : ["<hostname>:5000"], "table" : "users", "queryFilter" : "$row.address.city='Houston'", "includeTTL" : true, "requestTimeoutMs" : 5000 }, "sink" : { "type" : "file", "format" : "json", "useMultiFiles" : false, "schemaPath" : "<complete/path/to/the/JSON/file/with/DDL/commands/for/the/schema/definition>", "pretty" : true, "dataPath" : "<complete/path/to/directory>" }, "abortOnError" : true, "migratorVersion" : "1.8.0" } [INFO] Query for the migration: 'select $row, expiration_time($row) from users $row where $row.address.city='Houston'' - Ohne Konfigurationsdatei: Das Migrator-Utility erfasst interaktiv alle Eingaben, die zum Generieren der Konfigurationsdatei erforderlich sind, einschließlich des Abfrageprädikats. Anschließend werden die generierte Konfigurationsdatei und Abfrage angezeigt.

Hinweis:

Mit der Dumpfilteroption werden nur die Konfigurationsdatei und die Abfrage angezeigt. Die Datenmigration wird nicht initiiert. Um die Migration auszuführen, führen Sie nach der Prüfung das Migrator-Utility mit der Konfigurationsdatei mit der Option--c oder --config wie folgt aus:$./runMigrator --config <complete/path/to/the/JSON/config/file>Use Case-Demonstrationen für Oracle NoSQL Database-Migrator

Erfahren Sie, wie Sie eine Datenmigration mit dem Oracle NoSQL Database-Migrator für bestimmte Anwendungsfälle durchführen. Detaillierte systematische Anweisungen mit Codebeispielen zur Durchführung der Migration finden Sie in jedem Anwendungsfall.

Dieser Artikel enthält die folgenden Themen:

Von Oracle NoSQL Database Cloud Service in eine JSON-Datei migrieren

In diesem Beispiel wird gezeigt, wie Sie mit dem Oracle NoSQL Database-Migrator Daten und die Schemadefinition einer NoSQL-Tabelle aus Oracle NoSQL Database Cloud Service (NDCS) in eine JSON-Datei kopieren.

Anwendungsfall

Eine Organisation beschließt, ein Modell mit den Oracle NoSQL Database Cloud Service-(NDCS-)Daten zu trainieren, um zukünftiges Verhalten vorherzusagen und personalisierte Empfehlungen bereitzustellen. Sie können die Daten der NDCS-Tabellen regelmäßig in eine JSON-Datei kopieren und auf die Analyse-Engine anwenden, um das Modell zu analysieren und zu trainieren. Auf diese Weise können sie die analytischen Abfragen von den kritischen Pfaden mit geringer Latenz trennen.

Beispiel

In der Demonstration wird beschrieben, wie Sie die Daten- und Schemadefinition einer NoSQL-Tabelle mit dem NamenmyTable von NDCS in eine JSON-Datei migrieren.- Identifizieren Sie die Quelle und den Sink für die Migration.

- Quelle: Oracle NoSQL Database Cloud Service

- Sink: JSON-Datei

- Identifizieren Sie Ihre OCI-Cloud-Zugangsdaten, und erfassen Sie sie in der OCI-Konfigurationsdatei. Speichern Sie die Konfigurationsdatei in

/home/.oci/config. Siehe Zugangsdaten anfordern.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identifizieren Sie den Regionsendpunkt und den Compartment-Namen für Oracle NoSQL Database Cloud Service.

- Endpunkt:

us-ashburn-1 - Compartment:

ocid1.compartment.oc1..aa..rhsmq

- Endpunkt:

- Öffnen Sie die Eingabeaufforderung, und navigieren Sie zu dem Verzeichnis, in das Sie das Utility NoSQL Database Migrator extrahiert haben.

- Um die Konfigurationsdatei mit dem NoSQL Database Migrator zu generieren, führen Sie den Befehl

runMigratorohne Laufzeitparameter aus.[~/nosqlMigrator]$./runMigrator - Da Sie die Konfigurationsdatei nicht als Laufzeitparameter angegeben haben, fordert das Utility Sie auf, die Konfiguration jetzt zu generieren. Geben Sie

yein.Configuration file is not provided. Do you want to generate configuration? (y/n) [n]: y Generating a configuration file interactively. - Wählen Sie basierend auf den Eingabeaufforderungen des Utilitys Ihre Optionen für die Quellkonfiguration aus.

Enter a location for your config [./migrator-config.json]: /home/<user>/nosqlMigrator/NDCS2JSON Select the source: 1) nosqldb 2) nosqldb_cloud 3) file 4) object_storage_oci 5) aws_s3 #? 2 Configuration for source type=nosqldb_cloud Enter endpoint URL or region ID of the Oracle NoSQL Database Cloud: us-phoenix-1 Select the authentication type: 1) credentials_file 2) instance_principal 3) delegation_token 4) session_token 5) oke_workload_identity #? 1 Enter path to the file containing OCI credentials [/home/<user>/.oci/config]: Enter the profile name in OCI credentials file [DEFAULT]: Enter the compartment name or id of the table []: developers Enter table name: myTable Include TTL data? If you select 'yes' TTL of rows will also be included in the exported data.(y/n) [n]: Enter percentage of table read units to be used for migration operation. (1-100) [90]: Enter store operation timeout in milliseconds. (1-30000) [5000]: - Wählen Sie basierend auf den Eingabeaufforderungen des Utilitys Ihre Optionen für die Sink-Konfiguration aus.

Select the sink: 1) nosqldb 2) nosqldb_cloud 3) file #? 3 Configuration for sink type=file Enter path to a directory to store JSON data: /home/<user>/nosqlMigrator would you like to export data to multiple files for each source?(y/n) [y]: n Would you like to store JSON in pretty format? (y/n) [n]: y Would you like to migrate the table schema also? (y/n) [y]: y Enter path to a file to store table schema: /home/<user>/nosqlMigrator/myTableSchema - Wählen Sie basierend auf den Prompts aus dem Utility Ihre Optionen für die Quelldatentransformationen aus. Der Standardwert ist

n.Would you like to add transformations to source data? (y/n) [n]: - Geben Sie an, ob Sie mit der Migration fortfahren möchten, falls ein Datensatz nicht migriert werden kann.

Would you like to continue migration in case of any record/row is failed to migrate?: (y/n) [n]: - Das Utility zeigt die generierte Konfiguration auf dem Bildschirm an.

generated configuration is: { "source": { "type": "nosqldb_cloud", "endpoint": "us-ashburn-1", "table": "myTable", "compartment": "ocid1.compartment.oc1..aa..rhsmq", "credentials": "/home/<user>/.oci/config", "credentialsProfile": "DEFAULT", "readUnitsPercent": 90, "requestTimeoutMs": 5000 }, "sink": { "type": "file", "format": "json", "useMultiFiles" : false, "schemaPath": "/home/<user>/nosqlMigrator/myTableSchema", "pretty": true, "dataPath": "/home/<user>/nosqlMigrator" }, "abortOnError": true, "migratorVersion": "1.8.0" } - Das Utility fordert Sie auf, zu entscheiden, ob Sie mit der Migration mit der generierten Konfigurationsdatei fortfahren möchten oder nicht. Die Standardoption ist

y.Hinweis:

Wenn Sienauswählen, können Sie die Migration mit der Option./runMigrator -coder./runMigrator --configmit der generierten Konfigurationsdatei ausführen.would you like to run the migration with above configuration? If you select no, you can use the generated configuration file to run the migration using ./runMigrator --config /home/<user>/nosqlMigrator/NDCS2JSON (y/n) [y]: - Der NoSQL-Datenbankmigrator migriert Ihre Daten und Ihr Schema von NDCS in die JSON-Datei.

Records provided by source=10,Records written to sink=10,Records failed=0,Records skipped=0. Elapsed time: 0min 1sec 277ms Migration completed.

Um die Migration zu validieren, können Sie zum angegebenen Sink-Verzeichnis navigieren und das Schema und die Daten anzeigen.

-- Exported myTable Data. JSON files are created in the supplied data path

[~/nosqlMigrator]$cat myTable_1_5.json

{

"id" : 10,

"document" : {

"course" : "Computer Science",

"name" : "Neena",

"studentid" : 105

}

}

{

"id" : 3,

"document" : {

"course" : "Computer Science",

"name" : "John",

"studentid" : 107

}

}

{

"id" : 4,

"document" : {

"course" : "Computer Science",

"name" : "Ruby",

"studentid" : 100

}

}

{

"id" : 6,

"document" : {

"course" : "Bio-Technology",

"name" : "Rekha",

"studentid" : 104

}

}

{

"id" : 7,

"document" : {

"course" : "Computer Science",

"name" : "Ruby",

"studentid" : 100

}

}

{

"id" : 5,

"document" : {

"course" : "Journalism",

"name" : "Rani",

"studentid" : 106

}

}

{

"id" : 8,

"document" : {

"course" : "Computer Science",

"name" : "Tom",

"studentid" : 103

}

}

{

"id" : 9,

"document" : {

"course" : "Computer Science",

"name" : "Peter",

"studentid" : 109

}

}

{

"id" : 1,

"document" : {

"course" : "Journalism",

"name" : "Tracy",

"studentid" : 110

}

}

{

"id" : 2,

"document" : {

"course" : "Bio-Technology",

"name" : "Raja",

"studentid" : 108

}

}-- Exported myTable Schema

[~/nosqlMigrator]$cat myTableSchema

CREATE TABLE IF NOT EXISTS myTable (id INTEGER, document JSON, PRIMARY KEY(SHARD(id)))-

Bereiten Sie die Konfigurationsdatei (im JSON-Format) mit Oracle NoSQL Database Cloud Service-(NDCS-)Quell- und JSON-Sink-Details vor. Siehe Quellkonfigurationsvorlagen und Verknüpfungskonfigurationsvorlagen.

In diesem Beispiel wird eine Tabelleusersmit den folgenden Daten verwendet:{"id":10,"firstName":"John","lastName":"Smith","age":22,"income":45000,"address":{"city":"Santa Cruz","number":101,"phones":[{"area":408,"kind":"work","number":4538955},{"area":831,"kind":"home","number":7533341},{"area":831,"kind":"mobile","number":7533382}],"state":"CA","street":"Pacific Ave","zip":95008}} {"id":20,"firstName":"Jane","lastName":"Smith","age":22,"income":55000,"address":{"city":"San Jose","number":201,"phones":[{"area":608,"kind":"work","number":6538955},{"area":931,"kind":"home","number":9533341},{"area":931,"kind":"mobile","number":9533382}],"state":"CA","street":"Atlantic Ave","zip":95005}} {"id":30,"firstName":"Adam","lastName":"Smith","age":45,"income":75000,"address":{"city":"Houston","number":301,"phones":[{"area":618,"kind":"work","number":6618955},{"area":951,"kind":"home","number":9613341},{"area":981,"kind":"mobile","number":9613382}],"state":"TX","street":"Indian Ave","zip":95075}} {"id":40,"firstName":"Joanna","lastName":"Smith","age":null,"income":75000,"address":{"city":"Houston","number":401,"phones":[{"area":null,"kind":"work","number":1618955},{"area":451,"kind":"home","number":4613341},{"area":481,"kind":"mobile","number":4613382}],"state":"TX","street":"Tex Ave","zip":95085}}Stellen Sie sicher, dass Sie den Parameter

queryFiltermit dem entsprechenden Abfrageprädikat in die Quellkonfigurationsvorlage aufnehmen, um nur die erforderlichen Zeilen aus der Tabelle zu exportieren. Einzelheiten zum Erstellen von Abfrageprädikaten finden Sie in der Tabelle Beispielprädikate für Abfragen im Thema NoSQL Database Cloud-Servicequelle.In diesem Beispiel exportiert das Abfrageprädikat Zeilen mit dem Feld

cityin der JSON-Spalteaddress= 'Houston' aus der Tabelleusers.{ "source" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "users", "queryFilter" : "$row.address.city='Houston'", "compartment" : "ocid1.compartment.oc1..aa..rhsmq", "credentials" : "/home/<user>/.oci/config", "credentialsProfile" : "DEFAULT", "readUnitsPercent" : 90, "includeTTL" : true, "requestTimeoutMs" : 5000 }, "sink" : { "type" : "file", "format" : "json", "useMultiFiles" : true, "chunkSize" : 32, "schemaPath" : "/scratch/<user>/nosqlMigrator/tableschema.ddl", "pretty" : false, "dataPath" : "/scratch/<user>/nosqlMigrator" }, "abortOnError" : true, "migratorVersion" : "1.8.0" } - Öffnen Sie die Eingabeaufforderung, und navigieren Sie zu dem Verzeichnis, in das Sie das Datenbankmigrator-Utility NoSQL extrahiert haben.

-

Führen Sie den Befehl

runMigratoraus, indem Sie die Konfigurationsdatei übergeben. Verwenden Sie die Option--configoder-c.[~/nosqlMigrator]$./runMigrator --config <complete/path/to/the/JSON/config/file>Hinweis:

Sie können den Befehl auch mit der Option--dump-filter|dfausführen, um die generierte Abfrage anzuzeigen und zu prüfen, bevor Sie die Migrationsaufgabe wie folgt ausführen. Weitere Informationen finden sie unter Dumpfilter.[~/nosqlMigrator]$./runMigrator --dump-filter <complete/path/to/the/JSON/config/file>Das Utility führt die Datenmigration wie folgt durch:[INFO] creating source from given configuration: [INFO] [cloud source] : query = 'SELECT $row,expiration_time_millis($row) AS expiration FROM users $row where $row.address.city='Houston'' [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [json file sink] : writing table schema to /scratch/raumesh/nosqlMigrator/tableschema.ddl [INFO] migration started [INFO] Migration success for source users. read=2,written=2,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=2, Records written to sink=2, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 182ms Migration completed.

Verifizierung

address mit dem Feldwert city "Houston" werden exportiert.-- Exported users data. Schema and JSON files are created in the supplied data paths.

[~/nosqlMigrator]: cat tableschema.ddl

CREATE TABLE IF NOT EXISTS users (id INTEGER, firstName STRING, lastName STRING, age INTEGER, income INTEGER, address JSON, PRIMARY KEY(SHARD(id)))

[~/nosqlMigrator]: cat users_6_10.json

{"id":30,"firstName":"Adam","lastName":"Smith","age":45,"income":75000,"address":{"city":"Houston","number":301,"phones":[{"area":618,"kind":"work","number":6618955},{"area":951,"kind":"home","number":9613341},{"area":981,"kind":"mobile","number":9613382}],"state":"TX","street":"Indian Ave","zip":95075}}

{"id":40,"firstName":"Joanna","lastName":"Smith","age":null,"income":75000,"address":{"city":"Houston","number":401,"phones":[{"area":null,"kind":"work","number":1618955},{"area":451,"kind":"home","number":4613341},{"area":481,"kind":"mobile","number":4613382}],"state":"TX","street":"Tex Ave","zip":95085}}

bash-4.4$Von Oracle NoSQL Database On-Premise zu Oracle NoSQL Database Cloud Service migrieren

In diesem Beispiel wird gezeigt, wie Sie mit dem Oracle NoSQL Database-Migrator Daten und die Schemadefinition einer NoSQL-Tabelle von Oracle NoSQL Database in Oracle NoSQL Database Cloud Service (NDCS) kopieren.

Anwendungsfall

Als Entwickler untersuchen Sie Optionen, um den Aufwand für die Verwaltung der Ressourcen, Cluster und Garbage Collection für Ihre vorhandenen NoSQL Database KVStore-Workloads zu vermeiden. Als Lösung beschließen Sie, Ihre vorhandenen On-Premise-Workloads KVStore in Oracle NoSQL Database Cloud Service zu migrieren, da NDCS sie automatisch verwaltet.

Beispiel

In der Demonstration erfahren Sie, wie Sie die Daten- und Schemadefinition einer NoSQL-Tabelle mit dem NamenmyTable von der NoSQL-Datenbank KVStore zu NDCS migrieren. In diesem Anwendungsfall wird auch gezeigt, wie Sie das Utility runMigrator ausführen, indem Sie eine vorab erstellte Konfigurationsdatei übergeben.- Identifizieren Sie die Quelle und den Sink für die Migration.

- Quelle: Oracle NoSQL Database

- Sink: Oracle NoSQL Database Cloud Service

- Identifizieren Sie Ihre OCI-Cloud-Zugangsdaten, und erfassen Sie sie in der OCI-Konfigurationsdatei. Speichern Sie die Konfigurationsdatei in

/home/.oci/config. Siehe Zugangsdaten anfordern in Oracle NoSQL Database Cloud Service verwenden.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identifizieren Sie den Regionsendpunkt und den Compartment-Namen für Oracle NoSQL Database Cloud Service.

- Endpunkt:

us-phoenix-1 - Compartment:

developers

- Endpunkt:

- Geben Sie die folgenden Details für die On-Premise-Datei KVStore an:

- storeName:

kvstore - helperHosts:

<hostname>:5000 - Tabelle:

myTable

- storeName:

myTable von der NoSQL-Datenbank KVStore zu NDCS:

Um die Migration zu validieren, können Sie sich bei der NDCS-Konsole anmelden und prüfen, ob myTable mit den Quelldaten erstellt wurde.

Von einer JSON-Dateiquelle zu Oracle NoSQL Database Cloud Service migrieren

Dieses Beispiel zeigt die Verwendung von Oracle NoSQL Database Migrator zum Kopieren von Daten aus einer JSON-Dateiquelle in Oracle NoSQL Database Cloud Service.

Nachdem mehrere Optionen ausgewertet wurden, schließt eine Organisation Oracle NoSQL Database Cloud Service als Datenbankplattform NoSQL ab. Da die Quellinhalte im JSON-Dateiformat vorliegen, suchen sie nach einer Möglichkeit, sie in Oracle NoSQL Database Cloud Service zu migrieren.

In diesem Beispiel lernen Sie, wie Sie die Daten aus einer JSON-Datei mit dem Namen SampleData.JSON migrieren. Sie führen das Utility runMigrator aus, indem Sie eine vorab erstellte Konfigurationsdatei übergeben. Wenn die Konfigurationsdatei nicht als Laufzeitparameter angegeben wird, werden Sie vom Utility runMigrator aufgefordert, die Konfiguration über eine interaktive Prozedur zu generieren.

- Identifizieren Sie die Quelle und den Sink für die Migration.

- Quelle: JSON-Quelldatei.

SampleData.jsonist die Quelldatei. Es enthält mehrere JSON-Dokumente mit einem Dokument pro Zeile, die durch ein neues Zeilenzeichen getrennt sind.{"id":6,"val_json":{"array":["q","r","s"],"date":"2023-02-04T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-03-04T02:38:57.520Z","numfield":30,"strfield":"foo54"},{"datefield":"2023-02-04T02:38:57.520Z","numfield":56,"strfield":"bar23"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":3,"val_json":{"array":["g","h","i"],"date":"2023-02-02T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-02-02T02:38:57.520Z","numfield":28,"strfield":"foo3"},{"datefield":"2023-02-02T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":7,"val_json":{"array":["a","b","c"],"date":"2023-02-20T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-01-20T02:38:57.520Z","numfield":28,"strfield":"foo"},{"datefield":"2023-01-22T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} {"id":4,"val_json":{"array":["j","k","l"],"date":"2023-02-03T02:38:57.520Z","nestarray":[[1,2,3],[10,20,30]],"nested":{"arrayofobjects":[{"datefield":"2023-02-03T02:38:57.520Z","numfield":28,"strfield":"foo"},{"datefield":"2023-02-03T02:38:57.520Z","numfield":38,"strfield":"bar"}],"nestNum":10,"nestString":"bar"},"num":1,"string":"foo"}} - Sink: Oracle NoSQL Database Cloud Service.

- Quelle: JSON-Quelldatei.

- Identifizieren Sie Ihre OCI-Cloud-Zugangsdaten, und erfassen Sie sie in der Konfigurationsdatei. Speichern Sie die Konfigurationsdatei in

/home/user/.oci/config. Weitere Informationen finden Sie unter Zugangsdaten anfordern in Oracle NoSQL Database Cloud Service verwenden.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... region=us-ashburn-1 key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identifizieren Sie den Regionsendpunkt und den Compartment-Namen für Oracle NoSQL Database Cloud Service.

- Endpunkt:

us-ashburn-1 - Compartment:

Training-NoSQL

- Endpunkt:

- Geben Sie die folgenden Details für die JSON-Quelldatei an:

-

schemaPath:

<absolute path to the schema definition file containing DDL statements for the NoSQL table at the sink>.In diesem Beispiel lautet die DDL-Dateischema_json.DDL.create table Migrate_JSON (id INTEGER, val_json JSON, PRIMARY KEY(id));Der Oracle NoSQL Database-Migrator bietet eine Option zum Erstellen einer Tabelle mit dem Standardschema, wenn

schemaPathnicht angegeben ist. Weitere Informationen finden Sie im Thema Quelle und Sink identifizieren im Workflow für Oracle NoSQL Database-Migrator. - Datapath:

<absolute path to a file or directory containing the JSON data for migration>.

-

SampleData.JSON in Oracle NoSQL Database Cloud Service zu migrieren, führen Sie folgende Schritte aus:

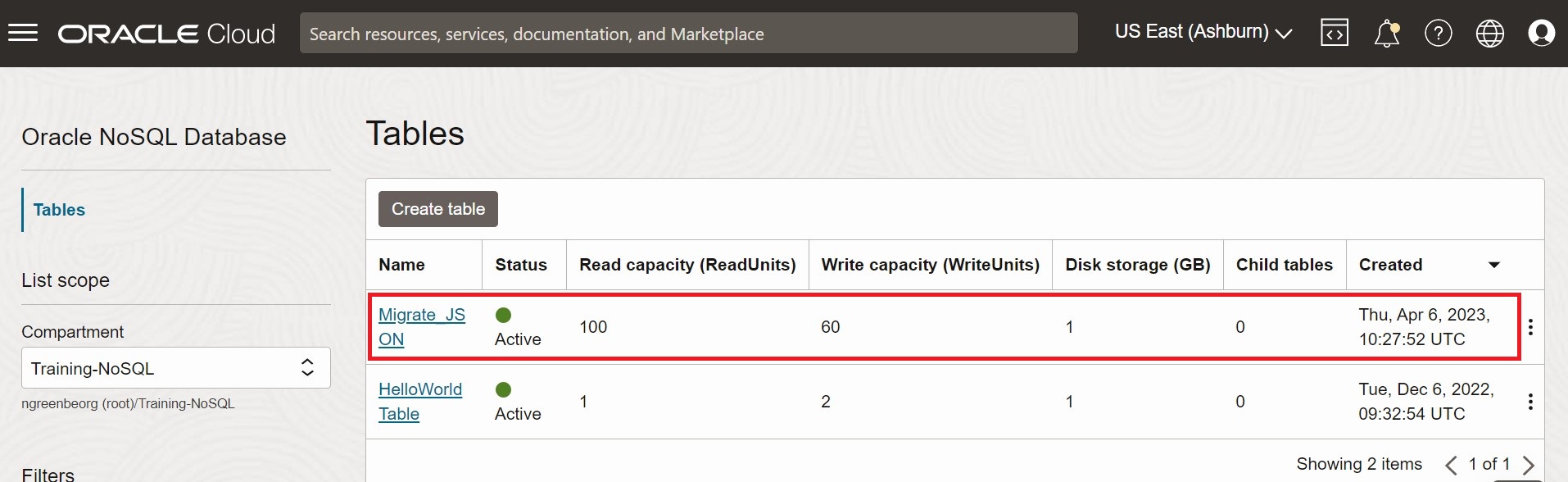

Migrate_JSON mit den Quelldaten erstellt wird. Die Vorgehensweise für den Zugriff auf die Konsole finden Sie im Artikel Über die Infrastructure-Konsole auf den Service zugreifen im Oracle NoSQL Database Cloud Service-Dokument.

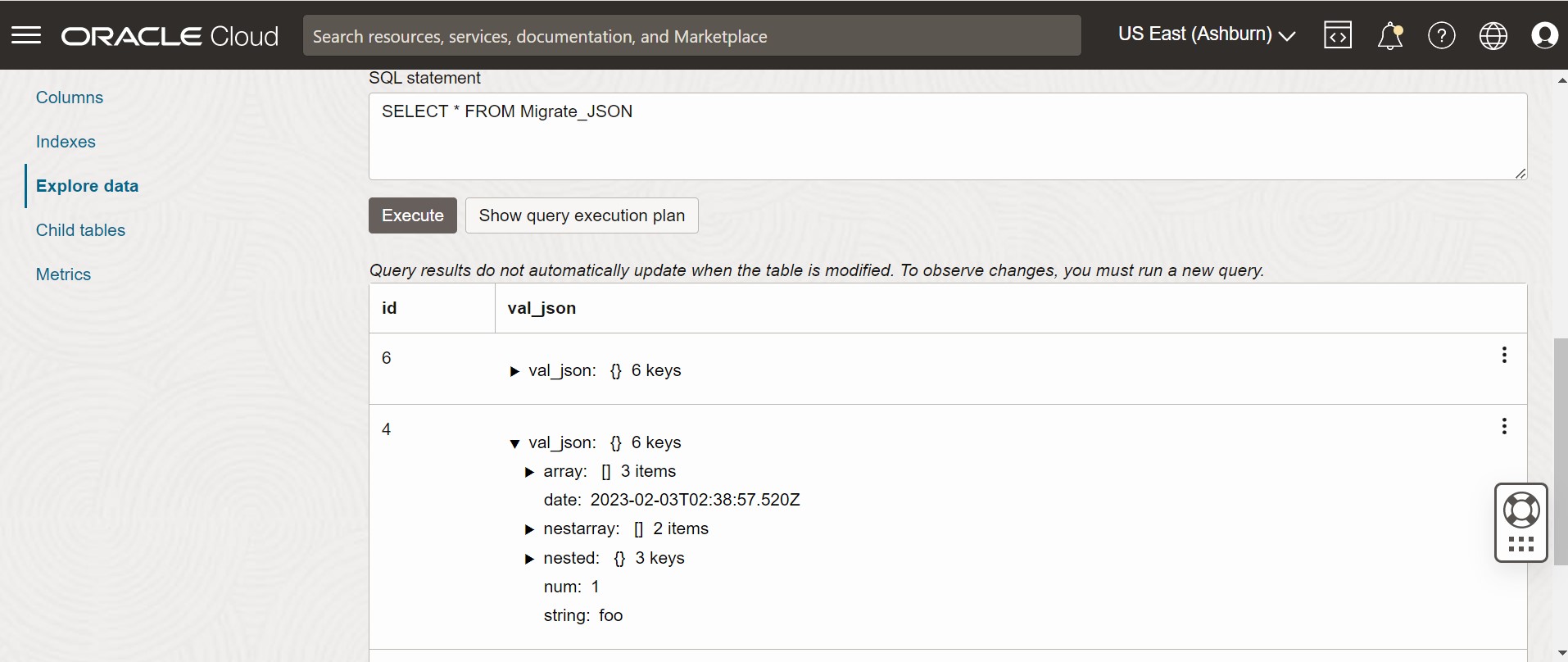

Abbildung - Oracle NoSQL Database Cloud Service-Konsolentabellen

Abbildung - Tabellendaten der Oracle NoSQL Database Cloud Service-Konsole

Von JSON-Datei MongoDB zu Oracle NoSQL Database Cloud Service migrieren

In diesem Beispiel wird gezeigt, wie Sie mit dem Oracle NoSQL Database-Migrator MongoDB-formatierte Daten in Oracle NoSQL Database Cloud Service (NDCS) kopieren.

Anwendungsfall

Nachdem eine Organisation mehrere Optionen ausgewertet hat, schließt sie Oracle NoSQL Database Cloud Service als NoSQL-Datenbankplattform ab. Die Tabellen und Daten befinden sich in MongoDB, und die Organisation möchte beide in Oracle NDCS migrieren.

Sie können eine Datei oder ein Verzeichnis mit den MongoDB-exportierten JSON-Daten für die Migration kopieren, indem Sie die Datei oder das Verzeichnis in der Quellkonfigurationsvorlage angeben.

Betrachten wir die folgenden beiden JSON-Beispieldateien, die aus MongoDB exportiert wurden, um unseren Anwendungsfall zu demonstrieren.

{"_id":0,"name":"Aimee Zank","scores":[{"score":1.463179736705023,"type":"exam"},{"score":11.78273309957772,"type":"quiz"},{"score":35.8740349954354,"type":"homework"}]}

{"_id":1,"name":"Aurelia Menendez","scores":[{"score":60.06045071030959,"type":"exam"},{"score":52.79790691903873,"type":"quiz"},{"score":71.76133439165544,"type":"homework"}]}

{"_id":2,"name":"Corliss Zuk","scores":[{"score":67.03077096065002,"type":"exam"},{"score":6.301851677835235,"type":"quiz"},{"score":66.28344683278382,"type":"homework"}]}

{"_id":3,"name":"Bao Ziglar","scores":[{"score":71.64343899778332,"type":"exam"},{"score":24.80221293650313,"type":"quiz"},{"score":42.26147058804812,"type":"homework"}]}

{"_id":4,"name":"Zachary Langlais","scores":[{"score":78.68385091304332,"type":"exam"},{"score":90.2963101368042,"type":"quiz"},{"score":34.41620148042529,"type":"homework"}]}

{"_id":{"$oid":"63d3a87cf564fc21dac3838d"},"firstName":"John","lastName":"Smith","address":{"Country":"France"},"_class":"com.example.demo.Customer"}

{"_id":{"$oid":"63d3a87cf564fc21dac3838e"},"firstName":"Sam","lastName":"David","address":{"Country":"USA"},"_class":"com.example.demo.Customer"}

{"_id":"3","firstName":"Dona","lastName":"William","address":{"Country":"England"},"_class":"com.example.demo.Customer"}MongoDB unterstützt zwei Typen von Erweiterungen für die formatierten JSON-Dateien, Canonical-Modus und Relaxed-Modus. Sie können die MongoDB-formatierte JSON-Datei angeben, die mit dem Tool mongoexport im Canonical- oder Relaxed-Modus generiert wird. NoSQL Database Migrator unterstützt beide Modi.

Weitere Informationen zur MongoDB Extended JSON-(v2-)Datei finden Sie unter mongoexport_formats.

Weitere Informationen zur Generierung einer JSON-Datei im Format MongoDB finden Sie unter mongoexport.

Beispiel

Die Demonstration zeigt, wie eine MongoDB-formatierte JSON-Datei in NDCS migriert wird. In diesem Beispiel wird eine manuell erstellte Konfigurationsdatei verwendet.- Identifizieren Sie die Quelle und den Sink für die Migration.

- Quelle: MongoDB-formatierte JSON-Datei

- Sink: Oracle NoSQL Database Cloud Service

- Extrahieren Sie die Daten mit dem mongoexport-Utility aus MongoDB. Weitere Informationen finden Sie unter mongoexport.

- Identifizieren Sie Ihre OCI-Cloud-Zugangsdaten, und erfassen Sie sie in der OCI-Konfigurationsdatei. Speichern Sie die Konfigurationsdatei im Verzeichnis

/home/<user>/.oci/config. Weitere Informationen finden Sie unter Zugangsdaten anfordern.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase> - Identifizieren Sie den Regionsendpunkt und den Compartment-Namen für Oracle NoSQL Database Cloud Service.

- Endpunkt:

us-ashburn-1 - Compartment:

ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza

- Endpunkt:

Um die MongoDB-formatierten JSON-Daten in Oracle NoSQL Database Cloud Service zu migrieren, können Sie eine der folgenden Optionen auswählen:

-

Bereiten Sie die Konfigurationsdatei (im JSON-Format) mit den angegebenen Quell- und Sinkdetails vor. Siehe Quellkonfigurationsvorlagen und Konfigurationsvorlagen verknüpfen.

Hier setzen Sie den KonfigurationsparameterdefaultSchemaauf "true". Daher erstellt der NoSQL-Datenbankmigrator eine Tabelle mit dem Standardschema in der Sink.{ "source" : { "type" : "file", "format" : "mongodb_json", "dataPath" : "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "mongoImport", "compartment" : "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL" : false, "schemaInfo" : { "readUnits" : 100, "writeUnits" : 60, "storageSize" : 1, "defaultSchema" : true }, "credentials" : "<complete/path/to/the/oci/config/file>", "credentialsProfile" : "DEFAULT", "writeUnitsPercent" : 90, "overwrite" : true, "requestTimeoutMs" : 5000 }, "abortOnError" : true, "migratorVersion" : "1.8.0" }Das Standardschema für die MongoDB-formatierte JSON-Dateiquelle lautet wie folgt:CREATE TABLE IF NOT EXISTS <tablename>(id STRING, document JSON,PRIMARY KEY(SHARD(id));Dabei gilt:tablename= Wert für das Attributtablein der Konfiguration angegeben.id= Der Wert_idaus jedem Dokument der exportierten JSON-Quelldatei MongoDB.document= Für jedes Dokument in der exportierten Datei MongoDB werden die Inhalte außer dem Feld_idin der Spaltedocumentaggregiert.

Hinweis:

Wenn die Tabelle <tablename> bereits in Oracle NoSQL Database Cloud Service vorhanden ist und Sie Daten mit der KonfigurationdefaultSchemain die Tabelle migrieren möchten, müssen Sie sicherstellen, dass die vorhandene Tabelle die ID-Spalte in Kleinbuchstaben (ID) und den Typ STRING aufweist. -

Öffnen Sie die Eingabeaufforderung, und navigieren Sie zu dem Verzeichnis, in das Sie das Utility NoSQL Database Migrator extrahiert haben.

-

Führen Sie den Befehl

runMigratoraus, indem Sie die Konfigurationsdatei übergeben. Verwenden Sie die Option--configoder-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

Das Utility fährt mit der Datenmigration fort, wie unten dargestellt.

[INFO] creating source from given configuration: [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [cloud sink] : start loading DDLs [INFO] [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS mongoImport (id STRING, document JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [INFO] [cloud sink] : completed loading DDLs [INFO] migration started [INFO] [mongo file source] : start parsing MongoDB JSON records from file: mongoDBSample.json [INFO] Migration success for source mongoDBSample. read=5,written=5,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=5, Records written to sink=5, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 448ms Migration completed.

Verifizierung

Um die Migration zu prüfen, können Sie sich bei der Oracle NoSQL Database Cloud Service-Konsole anmelden und prüfen, ob die Tabelle mongoImport mit den Quelldaten erstellt wird. Informationen zum Zugriff auf die Konsole finden Sie im Artikel Über die Infrastructure-Konsole auf den Service zugreifen.

-

Bereiten Sie die Konfigurationsdatei (im JSON-Format) mit den angegebenen Quell- und Sinkdetails vor. Siehe Quellkonfigurationsvorlagen und Konfigurationsvorlagen verknüpfen.

Hier geben Sie die Datei mit der DDL-Anweisung der Sink-Tabelle im Parameter

schemaPathder Quellkonfigurationsvorlage an. Setzen Sie den KonfigurationsparameteruseSourceSchemain der Sink-Konfigurationsvorlage entsprechend auf "true".Sie können ein benutzerdefiniertes Schema wie folgt generieren:

- Notieren Sie sich die Namen und Datentypen für jede Spalte aus den MongoDB-formatierten JSON-Daten. Mit diesen Informationen können Sie eine Schema-DDL-Datei für die Oracle NoSQL Database Cloud Service-Tabelle erstellen.

- Benennen Sie in der Schemadatei die erste Spalte (Primärschlüssel) als

iddes Typs STRING. Fügen Sie denselben Namen und denselben Typ für die restlichen Spalten ein, wie in der JSON-Datei im Format MongoDB aufgezeichnet. - Speichern Sie die Schemadatei, und notieren Sie sich den vollständigen Pfad.

In diesem Beispiel wird das folgende benutzerdefinierte Schema verwendet:CREATE TABLE IF NOT EXISTS sampleMongoDBImp (id STRING, name STRING, scores JSON, PRIMARY KEY(SHARD(id)));Sie müssen einerenameFields-Transformation einschließen, die NoSQL Database Migrator anweist, die Spalte_idbeim Erstellen der Tabelle inidzu konvertieren. Parameterdetails finden Sie unter Vorlagen für die Transformationskonfiguration. NoSQL Database Migrator erstellt eine Tabelle mit dem benutzerdefinierten Schema in der Sink.{ "source" : { "type" : "file", "format" : "mongodb_json", "schemaInfo" : { "schemaPath" : "<complete/path/to/the/schema/file>" }, "dataPath" : "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink" : { "type" : "nosqldb_cloud", "endpoint" : "us-ashburn-1", "table" : "sampleMongoDBImp", "compartment" : "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL" : true, "schemaInfo" : { "readUnits" : 100, "writeUnits" : 60, "storageSize" : 1, "useSourceSchema" : true }, "credentials" : "<complete/path/to/the/oci/config/file>", "credentialsProfile" : "DEFAULT", "writeUnitsPercent" : 90, "overwrite" : false, "requestTimeoutMs" : 5000 }, "transforms": { "renameFields" : { "_id":"id" } }, "abortOnError" : true, "migratorVersion" : "1.8.0" } -

Öffnen Sie die Eingabeaufforderung, und navigieren Sie zu dem Verzeichnis, in das Sie das Utility NoSQL Database Migrator extrahiert haben.

-

Führen Sie den Befehl

runMigratoraus, indem Sie die Konfigurationsdatei übergeben. Verwenden Sie die Option--configoder-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

Das Utility fährt mit der Datenmigration fort, wie unten dargestellt.

[INFO] creating source from given configuration: [INFO] source creation completed [INFO] creating sink from given configuration: [INFO] sink creation completed [INFO] creating migrator pipeline [INFO] [cloud sink] : start loading DDLs [INFO] [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS sampleMongoDBImp (id INTEGER, name STRING, scores JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [INFO] [cloud sink] : completed loading DDLs [INFO] migration started [INFO] [mongo file source] : start parsing MongoDB JSON records from file: mongoDBSample.json [INFO] Migration success for source mongoDBSample. read=5,written=5,failed=0 [INFO] Migration is successful for all the sources. [INFO] migration completed. Records provided by source=5, Records written to sink=5, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 438ms Migration completed.

Verifizierung

Um die Migration zu prüfen, können Sie sich bei der Oracle NoSQL Database Cloud Service-Konsole anmelden und prüfen, ob die Tabelle sampleMongoDBImp mit den Quelldaten erstellt wird. Informationen zum Zugriff auf die Konsole finden Sie im Artikel Über die Infrastructure-Konsole auf den Service zugreifen.

- Für diesen Anwendungsfall verwenden wir die JSON-Beispieldatei im MongoDB-Format, die aus einer Spring-Anwendung exportiert wurde. Weitere Informationen zu diesem Format finden Sie unter Frühlingsdaten.

-

Bereiten Sie die Konfigurationsdatei (im JSON-Format) mit den angegebenen Quell- und Sinkdetails vor. Siehe Quellkonfigurationsvorlagen und Konfigurationsvorlagen verknüpfen.

Hier geben Sie die Datei mit der DDL-Anweisung der Sink-Tabelle im Parameter

schemaPathder Quellkonfigurationsvorlage an. Setzen Sie den KonfigurationsparameteruseSourceSchemain der Sink-Konfigurationsvorlage entsprechend auf "true".Sie können ein benutzerdefiniertes Schema wie folgt generieren:

- Notieren Sie sich die Namen und Datentypen für jede Spalte aus den MongoDB-formatierten JSON-Daten.

- Benennen Sie in der Schemadatei die erste Spalte (Primärschlüssel) als

iddes Typs STRING. Aggregieren Sie die restlichen Felder in einem Feld mit dem Namenkv_json_vom Typ JSON, das dem Spring-Datenformat entspricht. Weitere Informationen finden Sie unter Persistenzmodell des Spring Data Frameworks. - Speichern Sie die Schemadatei, und notieren Sie sich den vollständigen Pfad.

In diesem Beispiel wird das folgende benutzerdefinierte Schema verwendet:CREATE TABLE IF NOT EXISTS sampleMongoDBSpringImp(id STRING, kv_json_ JSON, PRIMARY KEY(SHARD(id)))Für das oben angegebene Spring-Datenbeispiel müssen Sie die folgenden Transformationen einschließen:- Transformation

renameFields, um die Spalte_idinidzu konvertieren ignoreFields-Transformation, um die Spalte_classzu ignorieren und nicht in die Sink-Tabelle aufzunehmenaggregateFields-Transformation zum Aggregieren der verbleibenden Felder (außerid) in ein Feld vom Typ JSON

Parameterdetails finden Sie unter Vorlagen für die Transformationskonfiguration. NoSQL Database Migrator erstellt eine Tabelle mit dem benutzerdefinierten Schema in der Sink.{ "source": { "type": "file", "format": "mongodb_json", "schemaInfo": { "schemaPath": "<complete/path/to/the/schema/file>" }, "dataPath": "<complete/path/to/the/MongoDB/Formatted/JSON/file>" }, "sink": { "type": "nosqldb_cloud", "endpoint": "us-ashburn-1", "table": "sampleMongoDBSpringImp", "compartment": "ocid1.compartment.oc1..aaaaaaaaadeskhnnfkenws4k2vdyklcc32hfpzzz4z3zum3ubhmpz6zxnoza", "includeTTL": true, "schemaInfo": { "readUnits": 100, "writeUnits": 60, "storageSize": 1, "useSourceSchema": true }, "credentials": "<complete/path/to/the/oci/config/file>", "credentialsProfile": "DEFAULT", "writeUnitsPercent": 90, "overwrite": false, "requestTimeoutMs": 5000 }, "transforms": { "renameFields": { "_id": "id" }, "ignoreFields": ["_class"], "aggregateFields": { "fieldName": "kv_json_", "skipFields": ["id"] } }, "abortOnError" : true, "migratorVersion" : "1.8.0" } -

Öffnen Sie die Eingabeaufforderung, und navigieren Sie zu dem Verzeichnis, in das Sie das Utility NoSQL Database Migrator extrahiert haben.

-

Führen Sie den Befehl

runMigratoraus, indem Sie die Konfigurationsdatei übergeben. Verwenden Sie die Option--configoder-c.$./runMigrator --config <complete/path/to/the/JSON/config/file> -

Das Utility fährt mit der Datenmigration fort, wie unten gezeigt.

creating source from given configuration: source creation completed creating sink from given configuration: sink creation completed creating migrator pipeline [cloud sink] : start loading DDLs [cloud sink] : executing DDL: CREATE TABLE IF NOT EXISTS sampleMongoDBSpringImp (id STRING, kv_json_ JSON, PRIMARY KEY(SHARD(id))),limits: [100, 60, 1] [cloud sink] : completed loading DDLs migration started [mongo file source] : start parsing MongoDB JSON records from file: mongodbspring.json Migration success for source mongodbspring. read=3,written=3,failed=0 Migration is successful for all the sources. migration completed. Records provided by source=3, Records written to sink=3, Records failed=0,Records skipped=0. Elapsed time: 0min 0sec 393ms Migration completed.

Verifizierung

Um die Migration zu prüfen, können Sie sich bei der Oracle NoSQL Database Cloud Service-Konsole anmelden und prüfen, ob die Tabelle sampleMongoDBImp mit den Quelldaten erstellt wird. Informationen zum Zugriff auf die Konsole finden Sie im Artikel Über die Infrastructure-Konsole auf den Service zugreifen.

Von JSON-Datei DynamoDB zu Oracle NoSQL Database Cloud Service migrieren

Dieses Beispiel zeigt, wie Sie mit dem Oracle NoSQL Database-Migrator die JSON-Datei DynamoDB in NoSQL Database Cloud Service kopieren.

Anwendungsfall

Nachdem mehrere Optionen ausgewertet wurden, schließt eine Organisation Oracle NoSQL Database Cloud Service über die Datenbank DynamoDB ab. Die Organisation möchte ihre Tabellen und Daten von DynamoDB zu Oracle NoSQL Database Cloud Service migrieren.

Weitere Informationen finden Sie unter Zuordnung der Tabelle DynamoDB zu der Tabelle Oracle NoSQL.

Sie können eine Datei oder ein Verzeichnis mit den exportierten JSON-Daten von DynamoDB aus einem Dateisystem migrieren, indem Sie den Pfad in der Quellkonfigurationsvorlage angeben.

{"Item":{"Id":{"N":"101"},"Phones":{"L":[{"L":[{"S":"555-222"},{"S":"123-567"}]}]},"PremierCustomer":{"BOOL":false},"Address":{"M":{"Zip":{"N":"570004"},"Street":{"S":"21 main"},"DoorNum":{"N":"201"},"City":{"S":"London"}}},"FirstName":{"S":"Fred"},"FavNumbers":{"NS":["10"]},"LastName":{"S":"Smith"},"FavColors":{"SS":["Red","Green"]},"Age":{"N":"22"},"ttl": {"N": "1734616800"}}}

{"Item":{"Id":{"N":"102"},"Phones":{"L":[{"L":[{"S":"222-222"}]}]},"PremierCustomer":{"BOOL":false},"Address":{"M":{"Zip":{"N":"560014"},"Street":{"S":"32 main"},"DoorNum":{"N":"1024"},"City":{"S":"Wales"}}},"FirstName":{"S":"John"},"FavNumbers":{"NS":["10"]},"LastName":{"S":"White"},"FavColors":{"SS":["Blue"]},"Age":{"N":"48"},"ttl": {"N": "1734616800"}}}Sie kopieren die exportierten DynamoDB-Tabellendaten aus dem AWS S3-Speicher in ein lokales gemountetes Dateisystem.

Eaxmple

In dieser Demonstration lernen Sie, wie Sie eine JSON-Datei DynamoDB in Oracle NoSQL Database Cloud Service migrieren. In diesem Beispiel verwenden Sie eine manuell erstellte Konfigurationsdatei.

Voraussetzungen

- Identifizieren Sie die Quelle und den Sink für die Migration.

- Quelle: DynamoDB JSON-Datei

- Sink: Oracle NoSQL Database Cloud Service

- Um DynamoDB-Tabellendaten in Oracle NoSQL Database zu importieren, müssen Sie zuerst die Tabelle DynamoDB in S3 exportieren. Lesen Sie die Schritte unter Exportieren von DynamoDB-Tabellendaten in Amazon S3, um Ihre Tabelle zu exportieren. Beim Export wählen Sie das Format als JSON DynamoDB aus. Die exportierten Daten enthalten DynamoDB-Tabellendaten in mehreren

gzip-Dateien, wie unten gezeigt./ 01639372501551-bb4dd8c3 |-- 01639372501551-bb4dd8c3 ==> exported data prefix |----data |------sxz3hjr3re2dzn2ymgd2gi4iku.json.gz ==>table data |----manifest-files.json |----manifest-files.md5 |----manifest-summary.json |----manifest-summary.md5 |----_started

- Sie müssen die Dateien von AWS S3 herunterladen. Die Struktur der Dateien nach dem Download wird wie unten gezeigt.

download-dir/01639372501551-bb4dd8c3 |----data |------sxz3hjr3re2dzn2ymgd2gi4iku.json.gz ==>table data |----manifest-files.json |----manifest-files.md5 |----manifest-summary.json |----manifest-summary.md5 |----_started

- Identifizieren Sie Ihre OCI-Cloud-Zugangsdaten, und erfassen Sie sie in der Konfigurationsdatei. Speichern Sie die Konfigurationsdatei in

/home/user/.oci/config. Weitere Informationen finden Sie unter Zugangsdaten anfordern in Oracle NoSQL Database Cloud Service verwenden.[DEFAULT] tenancy=ocid1.tenancy.oc1.... user=ocid1.user.oc1.... fingerprint= 43:d1:.... region=us-ashburn-1 key_file=</fully/qualified/path/to/the/private/key/> pass_phrase=<passphrase>

- Geben Sie den Regionsendpunkt und den Compartment-Namen für Oracle NoSQL Database Cloud Service an.

- Endpunkt:

us-ashburn-1 - Compartment:

Training-NoSQL

- Endpunkt:

Vorgehensweise

So migrieren Sie die JSON-Daten DynamoDB in Oracle NoSQL Database:

- Bereiten Sie die Konfigurationsdatei (im JSON-Format) mit den identifizierten Quell- und Sink-Details vor. Weitere Informationen finden Sie unter Quellkonfigurationsvorlagen und Sinkkonfigurationsvorlagen.

Hinweis:

Wenn die exportierten JSON-Tabellenelemente von DynamoDB ein TTL-Attribut enthalten, geben Sie das Attribut im KonfigurationsparameterttlAttributeNameder Quellkonfigurationsvorlage an, um optional die TTL-Werte zu importieren, und setzen Sie den KonfigurationsparameterincludeTTLin der Sink-Konfigurationsvorlage auf "true". Weitere Informationen finden Sie unter TTL-Metadaten für Tabellenzeilen migrieren.Hier setzen Sie den Konfigurationsparameter

defaultSchemaauf "true". Daher erstellt der Datenbankmigrator NoSQL das Standardschema in der Sink. Sie müssen den SpaltentypDDBPartitionKeyund den entsprechenden Spaltentyp NoSQL angeben. Andernfalls wird ein Fehler angezeigt.Details zum Standardschema für eine exportierte JSON-Quelle von DynamoDB finden Sie im Thema "Quelle und Sink identifizieren" unter Workflow für Oracle NoSQL Data Migrator.