Hinweis:

- Dieses Tutorial erfordert Zugriff auf Oracle Cloud. Informationen zur Registrierung für einen kostenlosen Account finden Sie unter Erste Schritte mit Oracle Cloud Infrastructure Free Tier.

- Es verwendet Beispielwerte für Oracle Cloud Infrastructure-Zugangsdaten, -Mandanten und -Compartments. Ersetzen Sie diese Werte nach Abschluss der Übung durch Werte, die für Ihre Cloud-Umgebung spezifisch sind.

Oracle Cloud Infrastructure-Logs mit Log-Shippern in SIEM-Plattformen von Drittanbietern aufnehmen

Einführung

Oracle Cloud Infrastructure (OCI) ist eine Infrastructure-as-a-Service-(IaaS-, Platform-as-a-Service-(PaaS-) und Software-as-a-Service-(SaaS-)Plattform, der große Unternehmen vertrauen. Es bietet eine umfassende Palette von verwalteten Services, einschließlich Hosting, Speicher, Networking, Datenbanken und mehr.

Die proaktive Darstellung von sicherheitsbezogenen Ereignisprotokollen für die Suche nach geeigneten Ressourcen ist entscheidend, um Cybersicherheitsvorfälle zu erkennen und zu verhindern. Viele Unternehmen verlassen sich auf SIEM-Plattformen (Security Information and Event Management), um Protokolle und Alerts aus relevanten Assets zu korrelieren, zu analysieren. Die richtige Konfiguration der Logerfassung, die Aufbewahrung für die entsprechende Dauer sowie die Überwachung und Alarmierung in nahezu Echtzeit ermöglichen es den Sicherheitsteams, Probleme zu identifizieren, sich auf kritische Informationen basierend auf der Systemoptimierung zu konzentrieren und zeitnahe Maßnahmen zu ergreifen.

Eine Best Practice für die Aufnahme von OCI-Logs besteht darin, sie an OCI Streaming zu senden, das mit Apache Kafka kompatibel ist, sodass SIEM-Plattformen von Drittanbietern die Logs als Kafka-Consumer nutzen können. Dieser Ansatz reduziert Verzögerungen, bietet Resilienz und gewährleistet die Aufbewahrung bei vorübergehenden Problemen mit dem Datenverbrauch auf SIEM-Seite.

Einige SIEM-Plattformen von Drittanbietern verfügen jedoch nicht über Standard-Connectors zum direkten Konsumieren von Logs aus OCI-Streams und unterstützen nicht nativ den Datenverbrauch von Kafka-Themen, der weit verbreiteten Open-Source-Plattform für Ereignisstreaming, was den Integrationsprozess erschwert. In solchen Fällen dienen Log-Sender als Lösung, um diese Lücke zu schließen.

Ein Log-Sender fungiert als eigenständiges Tool, das Logs aus verschiedenen Quellen sammelt und dann an ein oder mehrere angegebene Ziele weiterleitet. Um eine nahtlose Kommunikation mit OCI Streaming- und SIEM-Plattformen von Drittanbietern sicherzustellen, sollte die Log Shipper-Software auf einem Computer mit Internetzugang ausgeführt werden. In diesem Tutorial stellen wir die Log-Sender-Software auf einer Compute-Instanz in OCI bereit.

Der Log-Sender wird:

-

Logs mit Kafka-Quelle aus OCI-Streams abrufen.

-

Leiten Sie die Logs mit einem beliebigen unterstützten Zieltyp oder Plug-in, wie TCP-Port, HTTP oder einer Datei im SIEM-Collector eines Drittanbieters, an die SIEM-Plattform eines Drittanbieters weiter.

Sehen wir uns nun die allgemeine Darstellung der Lösungsarchitektur an, wie in der folgenden Abbildung dargestellt.

Hinweis: Obwohl diese Lösung die Lücke schließen kann, ist es ratsam, sie nur als letzte Option zu betrachten, wenn andere Methoden nicht durchführbar sind. Es ist wichtig, dass Sie sich eng mit Ihrem SIEM-Anbieter abstimmen, um zuerst native oder empfohlene Ansätze zu untersuchen. Wenn Sie sich entscheiden, mit einem Log-Sender fortzufahren, sorgt die Zusammenarbeit mit Ihrem SIEM-Anbieter bei der Auswahl des am besten geeigneten für eine bessere Unterstützung durch Ihren SIEM-Anbieter während und nach der Implementierung und hilft, das Setup an die spezifischen Anforderungen Ihres Unternehmens anzupassen.

Es sind verschiedene Log-Sender verfügbar, und einige davon sind:

- Filebeat

- Fließendes Bit

- Fluentd

- Vektor

- Logstash

Ziele

- In diesem Tutorial wird erläutert, wie Logs mit Filebeat und Fluent Bit der Log-Sender aus OCI-Streams konsumiert werden können. Außerdem werden Beispiele für die Integration mit SIEM-Plattformen von Drittanbietern bereitgestellt.

Voraussetzungen

-

Benutzer in OCI müssen über die erforderlichen Policys für OCI Streaming-, OCI Connector Hub- und OCI Logging-Services verfügen, um die Ressourcen zu verwalten. Weitere Informationen zur Policy-Referenz aller Services finden Sie in der Policy-Referenz.

-

Eine als Log-Sender angegebene Compute-Instanz muss mit Internetzugang für den Zugriff auf OCI-Streams verfügbar sein. Weitere Informationen finden Sie unter Instanzen erstellen.

Hinweis: Die folgenden Aufgaben (Aufgabe 1 bis Aufgabe 4) müssen am OCI-Ende ausgeführt werden, unabhängig von der gewählten Methode oder dem Logversender.

Aufgabe 1: Zu erfassende Logs konfigurieren

Der OCI Logging-Service ist eine hoch skalierbare und vollständig verwaltete zentrale Stelle für alle Logs in Ihrem Mandanten. OCI Logging bietet Zugriff auf Logs von OCI-Ressourcen. Ein Log ist eine erstklassige OCI-Ressource, die Logereignisse speichert und erfasst, die in einem bestimmten Kontext erfasst wurden. Eine Loggruppe ist eine Sammlung von Logs, die in einem Compartment gespeichert sind. Loggruppen sind logische Container für Logs. Mit Loggruppen können Sie die Verwaltung von Logs organisieren und optimieren, indem Sie Oracle Cloud Infrastructure Identity and Access Management-(OCI IAM-)Policys anwenden oder Logs für Analysen gruppieren.

Aktivieren Sie zu Beginn ein Log für eine Ressource. Services bieten Logkategorien für die verschiedenen Logtypen, die für Ressourcen verfügbar sind. Beispiel: Der OCI Object Storage-Service unterstützt die folgenden Logkategorien für Speicher-Buckets: Lese- und Schreibzugriffsereignisse. Lesezugriffsereignisse erfassen Downloadereignisse, während Schreibzugriffsereignisse Schreibereignisse erfassen. Jeder Service kann verschiedene Logkategorien für Ressourcen haben.

-

Melden Sie sich bei der OCI-Konsole an, und navigieren Sie zu Observability & Management, Logging und Loggruppen.

-

Wählen Sie Ihr Compartment aus, klicken Sie auf Loggruppe erstellen, und geben Sie die folgenden Informationen ein.

- Name: Geben Sie

SIEM_log_groupein. - Beschreibung (Optional): Geben Sie die Beschreibung ein.

- Tags (Optional): Geben Sie die Tags ein.

- Name: Geben Sie

-

Klicken Sie auf Erstellen, um eine neue Loggruppe zu erstellen.

-

Klicken Sie unter Ressourcen auf Logs.

-

Klicken Sie nach Bedarf auf Benutzerdefiniertes Log erstellen oder Servicelog aktivieren.

Beispiel: Um Schreiblogs für einen OCI Object Storage-Bucket zu aktivieren, führen Sie die folgenden Schritte aus:

-

Klicken Sie auf Servicelog aktivieren.

-

Wählen Sie Ihr Ressourcen-Compartment aus, und geben Sie Object Storage in die Suchservices ein.

-

Klicken Sie auf Logs aktivieren, und wählen Sie den Namen des OCI Object Storage-Buckets in der Ressource aus.

-

Wählen Sie die Loggruppe (

SIEM_log_group), die in Aufgabe 1.2 erstellt wurde, und Zugriffsereignisse schreiben in der Logkategorie aus. Geben Sie optionalSIEM_bucket_writeals Logname ein. -

Klicken Sie auf Aktivieren, um das neue OCI-Log zu erstellen.

-

Aufgabe 2: Stream mit OCI Streaming erstellen

OCI Streaming Service ist eine serverlose, Apache Kafka-kompatible Ereignis-Streaming-Plattform in Echtzeit für Entwickler und Data Scientists. Es bietet eine vollständig verwaltete, skalierbare und dauerhafte Lösung zum Aufnehmen und Konsumieren hochvolumiger Datenstreams in Echtzeit, wie z.B. Logs. Wir können OCI Streaming für jeden Anwendungsfall verwenden, bei dem Daten kontinuierlich und sequentiell in einem Publish/Subscribe-Messagingmodell erzeugt und verarbeitet werden.

-

Navigieren Sie zur OCI-Konsole zu Analysen und KI, Messaging und Streaming.

-

Klicken Sie auf Stream erstellen, um einen Stream zu erstellen.

-

Geben Sie die folgenden Informationen ein, und klicken Sie auf Erstellen.

- Name: Geben Sie den Streamnamen ein. Für dieses Tutorial ist es

SIEM_Stream. - Streampool: Wählen Sie einen vorhandenen Streampool aus, oder erstellen Sie einen neuen mit öffentlichem Endpunkt.

- Aufbewahrung (in Stunden): Geben Sie an, wie viele Stunden Nachrichten in diesem Stream aufbewahrt werden sollen.

- Anzahl Partitionen: Geben Sie die Anzahl der Partitionen für den Stream ein.

- Gesamte Schreibrate und Gesamte Leserate: Die Eingabe basiert auf der Datenmenge, die Sie verarbeiten müssen.

- Name: Geben Sie den Streamnamen ein. Für dieses Tutorial ist es

Sie können mit Standardwerten für Tests beginnen. Weitere Informationen finden Sie unter Stream partitionieren.

Aufgabe 3: OCI Connector Hub einrichten

OCI Connector Hub orchestriert das Verschieben von Daten zwischen Services in OCI. OCI Connector Hub bietet einen zentralen Ort zum Beschreiben, Ausführen und Überwachen von Datenbewegungen zwischen Services wie OCI Logging, OCI Object Storage, OCI Streaming, OCI Logging Analytics und OCI Monitoring. Es kann auch OCI Functions für die einfache Datenverarbeitung und OCI Notifications zum Einrichten von Alerts auslösen.

-

Gehen Sie zur OCI-Konsole, und navigieren Sie zu Observability and Management, Logging und Connectors.

-

Klicken Sie auf Connector erstellen, um den Connector zu erstellen.

-

Geben Sie folgende Informationen ein.

- Name: Geben Sie

SIEM_SCein. - Beschreibung (Optional): Geben Sie die Beschreibung ein.

- Compartment: Wählen Sie das Compartment aus.

- Quelle: Wählen Sie Logging aus.

- Ziel: Wählen Sie Streaming aus.

- Name: Geben Sie

-

Wählen Sie unter Quellverbindung konfigurieren einen Compartment-Namen, eine Loggruppe und ein Log aus (Loggruppe und Log in Aufgabe 1 erstellt).

-

Wenn Sie auch Auditlogs senden möchten, klicken Sie auf +Another-Log, und wählen Sie dasselbe Compartment aus, während Sie

_Auditals Loggruppe ersetzen. -

Wählen Sie unter Ziel konfigurieren ein Compartment und einen Stream (Stream, der in Aufgabe 2 erstellt wurde) aus.

-

Um Standard-Policys zu akzeptieren, klicken Sie auf den Link Erstellen, der für jede Standard-Policy bereitgestellt wird. Standard-Policys werden für jede Autorisierung angeboten, die für diesen Connector für den Zugriff auf Quell-, Aufgaben- und Zielservices erforderlich ist.

-

Klicken Sie auf Erstellen.

Aufgabe 4: Zugriffskontrolle für Logversender zum Abrufen von Logs einrichten

Damit Log-Sender auf Daten aus einem OCI-Stream zugreifen können, erstellen Sie einen Benutzer, und erteilen Sie Stream-Pull-Berechtigungen zum Abrufen von Logs.

-

Erstellen Sie einen OCI-Benutzer. Weitere Informationen finden Sie unter Benutzer verwalten.

-

Erstellen Sie eine OCI-Gruppe mit dem Namen

SIEM_User_Group, und fügen Sie den OCI-Benutzer der Gruppe hinzu. Weitere Informationen finden Sie unter Gruppen verwalten. -

Erstellen Sie die folgende OCI-IAM-Policy.

Allow group <SIEM_User_Group> to use stream-pull in compartment <compartment_of_stream>

Jetzt werden wir untersuchen, wie Log Shipper installiert werden, und ein paar Beispiele für die Integration mit SIEM-Plattformen bereitstellen.

Fall 1: Filebeat als Log-Versender verwenden

Filebeat ist ein einfacher Versender für die Weiterleitung und Zentralisierung von Logdaten. Filebeat ist sehr erweiterbar durch die Verwendung von Modulen, so dass es Logs von Quellen wie Apache Kafka, Amazon Web Services (AWS) und mehr sammeln kann. In Go geschrieben, bietet Filebeat eine einzelne Binärdatei für eine einfache Bereitstellung. Es zeichnet sich durch den Umgang mit erheblichen Datenmengen und minimalen Ressourcen aus.

-

Filebeat-Eingabetypen: Eingaben bestimmen, wie Filebeat die erfassten Daten sucht und verarbeitet. Eine vollständige Liste der unterstützten Eingabetypen finden Sie unter Filebeat-Eingabetypen.

-

Filebeat-Ausgabetypen: Filebeat ist so konfiguriert, dass Logs an ein bestimmtes Ziel gesendet werden, indem Optionen im Abschnitt Ausgaben der Konfigurationsdatei

filebeat.ymlfestgelegt werden. Beachten Sie, dass jeweils nur eine Ausgabe definiert werden kann. Weitere Informationen zu den verfügbaren Ausgabetypen finden Sie unter Ausgabe konfigurieren.

Filebeat installieren

Filebeat kann auf verschiedenen Betriebssystemen wie Linux und Windows sowie auf Plattformen wie virtuellen Maschinen, Docker-Containern und Kubernetes-Clustern installiert werden. In diesem Tutorial wird es auf einer Oracle Linux 8-Compute-Instanz installiert. Weitere Informationen finden Sie unter Filebeat – Schnellstart: Installation und Konfiguration.

So installieren Sie Filebeat auf der Compute-Instanz, die als Log-Sender angegeben ist:

-

Fügen Sie das Beats-Repository für YUM hinzu. Weitere Informationen finden Sie unter Repositories für APT und YUM.

-

Laden Sie den öffentlichen Signaturschlüssel herunter, und installieren Sie ihn.

sudo rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch -

Erstellen Sie eine Datei mit der Erweiterung

.repo(z.B.elastic.repo) im Verzeichnis/etc/yum.repos.d/, und fügen Sie die folgenden Zeilen hinzu:[elastic-8.x] name=Elastic repository for 8.x packages baseurl=https://artifacts.elastic.co/packages/8.x/yum gpgcheck=1 gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch enabled=1 autorefresh=1 type=rpm-md -

Ihr Repository ist jetzt einsatzbereit. Führen Sie die folgenden Befehle aus, um Filebeat zu installieren.

sudo yum install filebeat -

Führen Sie die folgenden Befehle aus, um Filebeat so zu konfigurieren, dass es beim Booten automatisch gestartet wird.

sudo systemctl enable filebeat

Filebeat konfigurieren

In der folgenden Konfiguration ist Filebeat so eingerichtet, dass Logs aus OCI-Streams aufgenommen und als Dateien im lokalen Dateisystem des Logversenders (Compute-Instanz) gespeichert werden. Auf diese Weise können SIEM-Plattformsammler von Drittanbietern diese Logs aufnehmen, indem sie die Dateien aus dem lokalen Dateisystem lesen.

-

Ersetzen Sie den Inhalt von

/etc/filebeat/filebeat.ymldurch die folgende Beispielkonfiguration (ersetzen Siehosts, topics, username, and passworddurch Ihre Details). Erstellen Sie außerdem einen Ordner zum Speichern der Logs, wie/home/opc/oci_logs.filebeat.inputs: - type: kafka hosts: ["cell-1.streaming.us-ashburn-1.oci.oraclecloud.com:9092"] topics: ["SIEM_Stream"] group_id: "filebeat" username: <username> password: <Auth Token> ssl.enabled: true sasl.mechanism: PLAIN output.file: path: "/home/opc/oci_logs" filename: "oci_logs" rotate_every_kb: 5000 # 5 MB codec.format: string: '%{[@timestamp]} %{[message]}' -

Führen Sie den folgenden Befehl aus, um die Konfiguration zu testen.

filebeat test config -

Starten Sie den Filebeat-Service nach dem Aktualisieren der Konfiguration neu.

sudo systemctl restart Filebeat -

Nach der erfolgreichen Einrichtung sollten OCI-Logs als Dateien im Ordner

/home/opc/oci_logsangezeigt werden.

Beispiel: OCI- und Rapid7-Integration InsightIDR mit Filebeat

In diesem Beispiel ist Rapid7 InsightIDR so konfiguriert, dass die OCI-Logs aufgenommen werden, die im lokalen Dateisystem des Logversenders Filebeat gespeichert sind.

-

Installieren Sie den Collector Rapid7 auf der Logversenderinstanz.

Der Rapid7-Collector erfasst Logs und sendet sie zur Verarbeitung an den Rapid7 InsightIDR-Account. Um Rapid7 Collector zu installieren, laden Sie das Package von Ihrem Rapid7 InsightIDR-Account herunter, und installieren Sie es auf der Compute-Instanz des Logversenders. Weitere Informationen finden Sie unter Rapid7 Collector-Installation und -Deployment.

-

Konfigurieren Sie Rapid7 InsightIDR, um Daten aus der Ereignisquelle zu erfassen. Rapid7 InsightIDR enthält zwar vordefinierte Connectors für verschiedene Cloud-Services, OCI wird jedoch nicht nativ unterstützt. Sie können jedoch Rohdaten wie folgt aufnehmen und verarbeiten:

-

Gehen Sie zu Rapid7 InsightIDR, navigieren Sie zu Datenerfassung, Ereignisquelle einrichten, und klicken Sie auf Ereignisquelle hinzufügen.

-

Klicken Sie auf Raw-Daten hinzufügen und Benutzerdefinierte Logs.

-

Geben Sie Namensereignisquelle ein, und wählen Sie den Collector (Compute-Instanz) aus.

-

Wählen Sie die Zeitzone aus, die dem Speicherort der Ereignisquellenlogs entspricht.

-

Wählen Sie unter Erfassungsmethode die Option Verzeichnis ansehen aus, und verwenden Sie den OCI-Logpfad

/home/opc/oci_logsim lokalen Ordner.

Die Logerfassung wird gestartet, und die Daten können in Rapid7 InsightIDR angezeigt werden.

-

Fall 2: Verwenden Sie Fluent Bit als Log Shipper

Fluent Bit ist ein leichter, leistungsstarker Log-Sender, der als Alternative zu Fluentd dient. Fluent Bit entstand als Reaktion auf den wachsenden Bedarf an einer optimalen Lösung, die in der Lage ist, Protokolle aus zahlreichen Quellen zu sammeln und sie effizient zu verarbeiten und zu filtern. Insbesondere zeichnet sich Fluent Bit durch ressourcenbeschränkte Umgebungen wie Container oder eingebettete Systeme aus.

Um Fluent Bit zu verwenden, definieren wir inputs, filters, outputs und global configurations in einer Konfigurationsdatei unter /etc/fluent-bit/fluent-bit.conf. Lassen Sie uns diese Komponenten im Detail untersuchen:

- Service: Enthält globale Einstellungen für den ausgeführten Service.

- Eingabe: Gibt Quellen von Logdatensätzen für die Erfassung von Fluent Bit an.

- Filter: Wendet Transformationen auf Logdatensätze an.

- Ausgabe: Bestimmt das Ziel, an das Fluent Bit die verarbeiteten Logs sendet.

Fluent Bit Ein- und Ausgänge Plugins:

-

Fluent-Bit-Eingabe-Plug-ins: Fluent Bit bietet eine Vielzahl von Eingabe-Plug-ins, die auf verschiedene Logquellen zugeschnitten sind. Weitere Informationen finden Sie unter Eingaben.

-

Fluent Bit-Ausgabe-Plug-ins: Um Logs effizient an verschiedene Ziele zu verteilen, bietet Fluent Bit ein vielseitiges Array von Ausgabe-Plug-ins. Weitere Informationen finden Sie unter Ausgaben.

Fluent Bit installieren und konfigurieren

Fluent Bit kann auf verschiedenen Betriebssystemen wie Linux und Windows sowie auf Plattformen wie virtuellen Maschinen, Docker-Containern und Kubernetes-Clustern installiert werden. In diesem Tutorial wird es auf einer Oracle Linux 8-Compute-Instanz installiert. So installieren Sie Fluent Bit auf der Compute-Instanz, die als Log-Sender angegeben ist:

-

Erstellen Sie eine Repository-Datei mit der Erweiterung

.repo(z.B.fluentbit.repo) im Verzeichnis/etc/yum.repos.d/, und fügen Sie die folgenden Zeilen hinzu. Weitere Informationen finden Sie unter Yum konfigurieren.[fluent-bit] name = Fluent Bit baseurl = https://packages.fluentbit.io/centos/$releasever/ gpgcheck=1 gpgkey=https://packages.fluentbit.io/fluentbit.key repo_gpgcheck=1 enabled=1 -

Führen Sie nach der Konfiguration des Repositorys den folgenden Befehl aus, um Fluent Bit zu installieren.

sudo yum install fluent-bit -

Die Standardkonfigurationsdatei für Fluent Bit befindet sich unter

/etc/fluent-bit/fluent-bit.conf. Standardmäßig erfasst es CPU-Auslastungsmetriken und sendet die Ausgabe an das Standardlog. Sie können die ausgehenden Daten in der Datei/var/log/messagesanzeigen. -

Um Logs vom OCI Streaming-Service zu erfassen und an die Standardausgabe zu senden, konfigurieren Sie die Eingabe als Kafka und die Ausgabe als stdout. Ersetzen Sie

Brokers,topics,usernameundpassworddurch Ihre Details.[INPUT] Name kafka Brokers cell-1.streaming.us-ashburn-1.oci.oraclecloud.com:9092 Topics SIEM-Stream Format json group_id fluent-bit rdkafka.sasl.username <User Name> rdkafka.sasl.password <Auth token> rdkafka.security.protocol SASL_SSL rdkafka.sasl.mechanism PLAIN [OUTPUT] Name stdout

Beispiel: OCI- und Rapid7-Integration InsightIDR mit Fluent Bit

In diesem Beispiel integrieren wir OCI in Rapid7 InsightIDR, indem wir den Rapid7-Collector auf der Log-Senderinstanz installieren, auf der Fluent Bit ausgeführt wird. Fluent Bit konsumiert Logs aus OCI Streaming mit Kafka als Eingabe und sendet sie an einen lokalen TCP-Port, wo der Rapid7-Collector auf eingehende Daten horcht.

-

Installieren Sie den Rapid7-Collector auf der vorhandenen Logversenderinstanz.

Der Rapid7-Collector erfasst Logs und sendet sie zur Verarbeitung an den Rapid7 InsightIDR-Account. Um den Collector zu installieren, laden Sie das Package von Ihrem Rapid7 InsightIDR-Account herunter, und installieren Sie es auf der Compute-Instanz des Logversenders. Weitere Informationen zu den Installationsschritten finden Sie unter Rapid7 Collector Installation and Deployment.

-

Konfigurieren Sie Rapid7 InsightIDR, um Daten aus der Ereignisquelle zu erfassen. Rapid7 InsightIDR enthält zwar vordefinierte Connectors für verschiedene Cloud-Services, OCI wird jedoch nicht nativ unterstützt. Sie können jedoch Rohdaten wie folgt aufnehmen und verarbeiten:

-

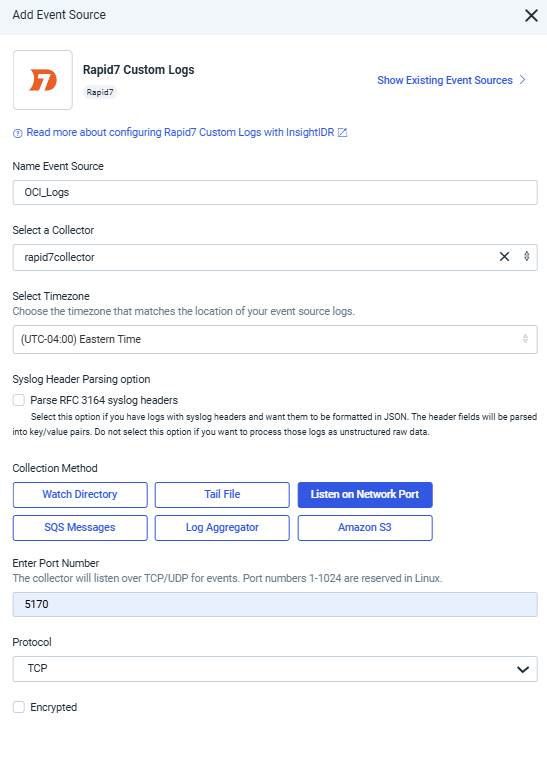

Gehen Sie zu Rapid7 InsightIDR, navigieren Sie zu Datenerfassung, Ereignisquelle einrichten, und klicken Sie auf Ereignisquelle hinzufügen.

-

Klicken Sie auf Raw-Daten hinzufügen und Benutzerdefinierte Logs.

-

Geben Sie eine Namensereignisquelle ein, und wählen Sie den Collector (Compute-Instanz) aus.

-

Wählen Sie die Zeitzone aus, die dem Speicherort der Ereignisquellenlogs entspricht.

-

Wählen Sie unter Erfassungsmethode die Option Auf Netzwerkport horchen aus, und geben Sie eine Portnummer und ein Protokoll ein.

-

-

Beispielkonfiguration für Fluent Bit-Eingabe und -Ausgabe für die Integration von Rapid7 InsightIDR. Ersetzen Sie

Brokers,topics,usernameundpassworddurch Ihre Details.[INPUT] Name kafka Brokers cell-1.streaming.us-ashburn-1.oci.oraclecloud.com:9092 Topics SIEM-Stream Format json group_id fluent-bit rdkafka.sasl.username <User Name> rdkafka.sasl.password <Auth token> rdkafka.security.protocol SASL_SSL rdkafka.sasl.mechanism PLAIN [OUTPUT] Name tcp Match * Host 127.0.0.1 Port 5170 Format json_lines -

Starten Sie Fluent Bit nach dem Ändern der Fluent Bit-Konfiguration mit dem folgenden Befehl neu.

sudo systemctl restart fluent-bitSobald Fluent Bit neu gestartet wurde, sollten OCI-Logs in der Rapid7-Konsole angezeigt werden.

Beispiel: OCI- und Datadog-Integration mit Fluent Bit.

In diesem Beispiel konsumiert Fluent Bit, das auf der Log-Senderinstanz ausgeführt wird, Logs aus OCI-Streams mit Kafka als Eingabe und sendet sie über eine HTTP-Ausgabe an den HTTP-Endpunkt von Datadog.

-

Verwenden Sie Datadog HTTP-Loggingendpunkte, um Logs an Datadog zu senden. Weitere Informationen finden Sie unter Logging-Endpunkte.

-

Ein Datadog-API-Schlüssel ist erforderlich, um Logs an den HTTP-Endpunkt von Datadog zu senden. Weitere Informationen finden Sie unter Datadog-API und Anwendungsschlüssel.

So generieren Sie einen API-Schlüssel:

-

Navigieren Sie in Ihrem Datadog-Account zu Organisationseinstellungen.

-

Klicken Sie auf API-Schlüssel.

-

Klicken Sie auf Neuer Schlüssel, geben Sie einen Namen für Ihren Schlüssel ein, und klicken Sie auf API-Schlüssel erstellen.

-

-

Beispielkonfiguration für Fluent Bit-Eingabe und -Ausgabe für die Datadog-Integration. Ersetzen Sie

Brokers,topics,username,passwordundAPI Keydurch Ihre Details.[INPUT] Name kafka Brokers cell-1.streaming.us-ashburn-1.oci.oraclecloud.com:9092 Topics SIEM-Stream Format json group_id fluent-bit rdkafka.sasl.username <User Name> rdkafka.sasl.password <Auth token> rdkafka.security.protocol SASL_SSL rdkafka.sasl.mechanism PLAIN [OUTPUT] Name http Match * Host http-intake.logs.us5.datadoghq.com Port 443 URI /api/v2/logs Header DD-API-KEY <API-KEY> Format json Json_date_key timestamp Json_date_format iso8601 tls On tls.verify Off -

Nachdem Sie die Fluent Bit-Konfiguration geändert haben, starten Sie Fluent Bit neu.

sudo systemctl restart fluent-bitSie sollten jetzt OCI-Logs in Ihrem Datadog-Account anzeigen.

Nächste Schritte

In diesem Tutorial wurde gezeigt, wie Sie OCI-Logs mit Logversendern in SIEM-Plattformen von Drittanbietern aufnehmen. Es gibt zwar verschiedene Log-Sender und mehrere Möglichkeiten, OCI mit SIEM-Plattformen von Drittanbietern zu integrieren, die sie verwenden, aber es ist wichtig, die richtige Log-Sender- und Integrationsmethode zu wählen, indem die von jedem Log-Sender unterstützten Ein- und Ausgabeoptionen sorgfältig ausgewertet werden. Stellen Sie sicher, dass Sie sich mit Ihrem SIEM-Anbieter abstimmen, um sicherzustellen, dass die Lösung mit Ihrer spezifischen Umgebung und Ihren Anforderungen übereinstimmt.

Verwandte Links

Danksagungen

- Autor - Chaitanya Chintala (Cloud-Sicherheitsberater)

Weitere Lernressourcen

Sehen Sie sich andere Übungen zu docs.oracle.com/learn an, oder greifen Sie im Oracle Learning YouTube-Channel auf weitere kostenlose Lerninhalte zu. Besuchen Sie außerdem education.oracle.com/learning-explorer, um Oracle Learning Explorer zu werden.

Die Produktdokumentation finden Sie im Oracle Help Center.

Ingest Oracle Cloud Infrastructure Logs into Third-Party SIEM Platforms using Log Shippers

G20575-01

November 2024