Empfohlene Muster für cloud-basierte Data Lakes

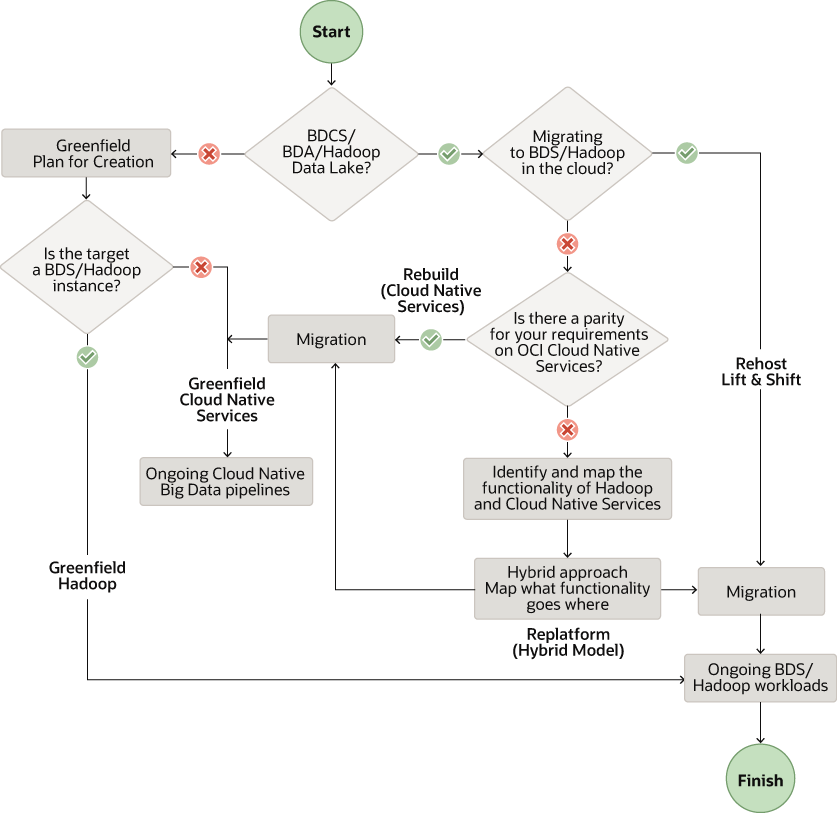

Je nach Anwendungsfall können Data Lakes auf Object Storage oder Hadoop basieren. Beide können skalierbar und nahtlos in vorhandene Unternehmensdaten und -tools integriert werden. Sie sollten entweder die Muster Greenfield oder Migration für Ihre Organisation berücksichtigen. Wählen Sie entweder das Greenfield oder das Migrationsmuster, je nachdem, ob Sie eine völlig neue Implementierung planen oder Ihre vorhandene Big Data-Lösung in Oracle Cloud migrieren möchten.

Im folgenden Workflow werden die empfohlenen Muster entsprechend Ihren Anforderungen angezeigt.

Beschreibung der Abbildung data-lake-solution-pattern.png

Hinweis:

In diesem Dokument konzentrieren wir uns auf die Migration von Big Data Appliance-(BDA-) und Big Data Cloud Services-(BDCS-)Clustern zu OCI basierend auf der Cloudera Distribution of Hadoop (CDH). Die Empfehlungen hier gelten jedoch für andere On-Premise- und Cloud-Hadoop-Distributionen.

Neue Datenplattform in Oracle Cloud (Greenfield)

Sie haben zwei Optionen, um Data Lakes in Oracle Cloud für Greenfield-Projekte zu erstellen. Verwenden Sie Big Data Service (BDS) für HDFS-basierte Data Lakes. Verwenden Sie native OCI-Datenservices für Object Storage-basierte Data Lakes, ohne HDFS zu verwenden.

Cloud Native Datenservices

Erstellen Sie einen Datenspeicher in OCI Object Storage, und verwenden Sie cloud-native Daten- und KI-Services. Diese Services umfassen Data Flow, Data Integration, Autonomous Data Warehouse, Data Catalog und Data Science sowie einige weitere Services.

Oracle empfiehlt diese Services, um einen neuen Datenspeicher zu erstellen:

- Object Storage als Datenspeicher für alle Arten von Rohdaten

- Data Flow-Service für Spark-Batchprozesse und ephemere Spark-Cluster

- Data Integration-Service für die Datenaufnahme und für ETL-Jobs

- Autonomous Data Warehouse (ADW) für das Bereitstellen und Darstellen von Layer-Daten

- Data Catalog für Daten-Discovery und -Governance

Oracle empfiehlt die folgenden zusätzlichen Services, um einen neuen Datenspeicher zu erstellen:

- Streaming-Service für eine verwaltete Aufnahme von Echtzeitdaten

- Data Transfer Appliance-(DTA-)Service für einmalige Massenübertragung von Daten

- GoldenGate Service für Change Data Capture-(CDC-)Daten und für Streaminganalysen

- Data Science-Service für Anforderungen an maschinelles Lernen

- Oracle Analytics Cloud-(OAC-)Service für BI-, Analyse- und Berichtsanforderungen

Big Data Service

Erstellen Sie Ihren Datenspeicher in HDFS mit Oracle Big Data Service (BDS). BDS bietet am häufigsten verwendete Hadoop-Komponenten, wie HDFS, Hive, HBase, Spark und Oozie.

Oracle empfiehlt diese Services, um einen neuen Datenspeicher mit Hadoop-Clustern zu erstellen:

- Data Integration-Service für die Datenaufnahme und für ETL-Jobs

- Data Transfer Appliance-(DTA-)Service für einmalige Massenübertragung von Daten

- GoldenGate Service für CDC-Daten und Streaminganalysen

- Data Catalog-Service für Daten-Discovery und Governance

- Data Science-Service für Anforderungen an maschinelles Lernen

- OAC-Service für BI-, Analyse- und Berichtsanforderungen

- BDS für HDFS und andere Hadoop-Komponenten

Greenfield Pattern Workflow

Wenn Sie einen neuen Data Lake erstellen, folgen Sie diesem Workflow aus Anforderungen bis hin zu Tests und Validierung:

- Anforderungen: Anforderungen für neue Umgebungen in OCI auflisten

- Bewertung: Bewerten Sie die erforderlichen OCI-Services und -Tools

- Design: Entwerfen der Lösungsarchitektur und Skalierung für OCI

- Planen: Erstellen Sie eine detaillierte Planzuordnung für Ihre Zeit und Ressourcen.

- Provisioning: Stellen Sie die erforderlichen Ressourcen in OCI bereit und konfigurieren Sie sie.

- Implementieren: Implementieren Sie Ihre Daten- und Anwendungs-Workloads

- Pipeline automatisieren: Orchestrieren und planen Sie Workflow-Pipelines für die Automatisierung.

- Testen und validieren: Führen Sie Validierungs-, Funktions- und Performancetests für die End-to-End-Lösung aus

Vorhandene Datenplattform in Oracle Cloud migrieren

Muster neu erstellen

Verwenden Sie das Muster für die Neuerstellung, wenn Sie keine Hadoop-Cluster verwenden und in cloud-native Services in Oracle Cloud Infrastructure (OCI) migrieren möchten. Beginnen Sie mit einem sauberen Slate zur Architektur und beginnen Sie mit der Implementierung von Grund auf in OCI. Nutzen Sie verwaltete, cloud-native Services für alle wichtigen Komponenten in Ihrem Stack. Beispiel: Erstellen Sie einen Stack mit Data Flow, Data Catalog, Data Integration, Streaming, Data Science, ADW und OAC.

Oracle empfiehlt diese Services für die Migration in einen cloud-basierten Datenspeicher ohne Hadoop-Cluster:

- Object Storage Service als Datenspeicher für alle Arten von Rohdaten

Hinweis:

Sie können Object Storage mit einem HDFS-Connector als HDFS-Speicher anstelle von HDFS im Hadoop- oder Spark-Cluster verwenden. - Data Integration-Service für die Datenaufnahme und für ETL-Jobs

- Streaming-Service für die verwaltete Erfassung von Echtzeitdaten, mit dem Sie Ihre selbstverwalteten Kafka- oder Flume-Services ersetzen können

- Data Transfer Appliance für einmalige Massenübertragung von Daten

- GoldenGate für CDC-Daten und Streaminganalysen

- Data Flow-Service für Spark-Batchprozesse und ephemere Spark-Cluster

- ADW für Daten der Bereitstellungsschicht

- Data Catalog-Service für Daten-Discovery und Governance

- Data Science-Service für Anforderungen an maschinelles Lernen

- OAC-Service für BI-, Analyse- und Berichtsanforderungen

Replatform Pattern

Verwenden Sie das Replatform-Migrationsmuster, wenn Sie Hadoop-Cluster in der Cloud verwenden und einige Komponenten durch cloud-native Services ersetzen möchten. Verwenden Sie Big Data Service für HDFS und andere Hadoop-Komponenten, und entwerfen Sie einen Teil Ihres Stacks mit unseren zusätzlichen verwalteten cloud-nativen Services.

Möglicherweise müssen Sie den Stack neu entwerfen, um das Replatform-Muster zu verwenden.

- Integration serverloser Cloud Native Services zusammen mit BDS in OCI

- Verwaltete Cloud Native-Services nach Möglichkeit nutzen

Sie können einige dieser Komponenten je nach Bedarf ersetzen.

- BDS für HDFS und andere Hadoop-Komponenten wie Hive, HBase, Kafka und Oozie

- Data Integration-Service für die Datenaufnahme und für ETL-Jobs

- Data Transfer Appliance-Service für einmalige Massenübertragung von Daten

- GoldenGate Service für CDC-Daten und Streaminganalysen

- Data Catalog-Service für Daten-Discovery und Governance

- Data Science-Service für Anforderungen an maschinelles Lernen

- OAC-Service für BI-, Analyse- und Berichtsanforderungen

Rehost-Muster

Migrieren Sie BDA-, BDCS- und andere Hadoop-Cluster, um Ihren Datenspeicher in HDFS mit Big Data Service (BDS) zu erstellen. Bei Verwendung des Rehost-Musters können Sie einen Lift-and-Shift-Ansatz verwenden. Alle allgemein verwendeten Hadoop-Komponenten, einschließlich HDFS, Hive, HBase, Spark und Oozie, sind in den verwalteten Hadoop-Clustern verfügbar, die von BDS bereitgestellt werden.

Migrationsmusterworkflow

Wenn Sie Ihren Data Lake in Oracle Cloud migrieren, befolgen Sie diesen Workflow von Anforderungen bis hin zur neuen Umgebung.

- Discovery und Anforderungen: Ermitteln und katalogisieren Sie das aktuelle System, um die Anforderungen für die neue OCI-Umgebung aufzulisten

- Bewertung: Bewerten Sie die erforderlichen OCI-Services und -Tools

- Design: Entwerfen der Lösungsarchitektur und Skalierung für OCI

- Planen: Erstellen Sie eine detaillierte Planzuordnung für Ihre Zeit und Ressourcen.

- Provisioning: Stellen Sie die erforderlichen Ressourcen in OCI bereit und konfigurieren Sie sie.

- Daten migrieren: Daten und Metadaten in den Datenspeicher der ausgewählten OCI-Services übertragen

- Workload migrieren: Migrieren Sie Ihre Workloads und Anwendungen mit dem ausgewählten Migrationsmuster zu OCI-Services.

- Pipeline automatisieren: Orchestrieren und planen Sie Workflow-Pipelines für die Automatisierung.

- Testen und validieren: Funktions- und Performancetests und Validierung für die endgültige OCI-Umgebung planen

- Cut over: Deaktivieren Sie die Quellumgebung und nutzen Sie sie nur mit der neuen OCI-basierten Umgebung.