Datenplattform - Data Lakehouse

Sie können Ereignisdaten und Streaming-Daten aus dem Internet der Dinge (IoT) und Social-Media-Quellen effektiv sammeln und analysieren, aber wie korrelieren Sie sie mit der breiten Palette von Unternehmensdatenressourcen, um Ihre Investitionen zu nutzen und die gewünschten Erkenntnisse zu gewinnen?

Nutzen Sie ein Cloud-Data Lakehouse, das die Fähigkeiten eines Data Lakes und eines Data Warehouse kombiniert, um eine breite Palette von Unternehmens- und Streamingdaten für Geschäftsanalysen und maschinelles Lernen zu verarbeiten.

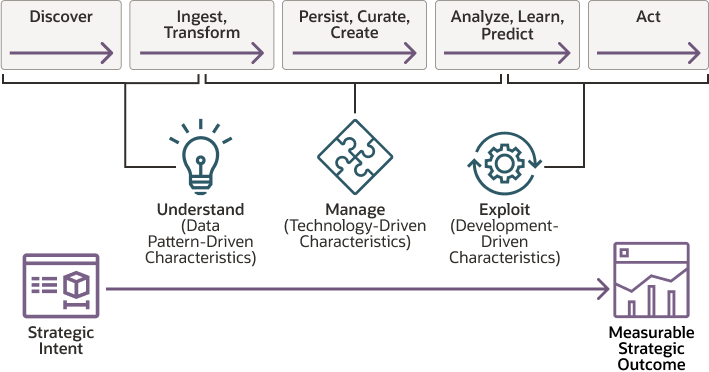

Diese Referenzarchitektur positioniert die Technologielösung im gesamten Geschäftskontext, in dem strategische Absichten die Schaffung messbarer strategischer Ergebnisse fördern. Diese Ergebnisse generieren neue strategische Absichten und liefern kontinuierliche, datengesteuerte Geschäftsverbesserungen.

Ein Data Lake ermöglicht es einem Unternehmen, alle seine Daten in einer kostengünstigen, elastischen Umgebung zu speichern und gleichzeitig die erforderlichen Verarbeitungs-, Persistenz- und Analyseservices bereitzustellen, um neue Geschäftseinblicke zu gewinnen. Ein Data Lake speichert und kuratiert strukturierte und unstrukturierte Daten und bietet Methoden zur Organisation großer Mengen unterschiedlichster Daten aus mehreren Quellen.

Mit einem Data Warehouse führen Sie Datentransformationen und -bereinigungen durch, bevor Sie die Daten im Warehouse festschreiben. Mit einem Data Lake erfassen Sie Daten schnell und bereiten sie im Handumdrehen vor, während Personen darauf zugreifen. Ein Data Lake unterstützt betriebliches Reporting und Geschäftsüberwachung, die sofortigen Zugriff auf Daten und flexible Analysen erfordern, um zu verstehen, was im Unternehmen passiert, während es stattfindet.

Funktionale Architektur

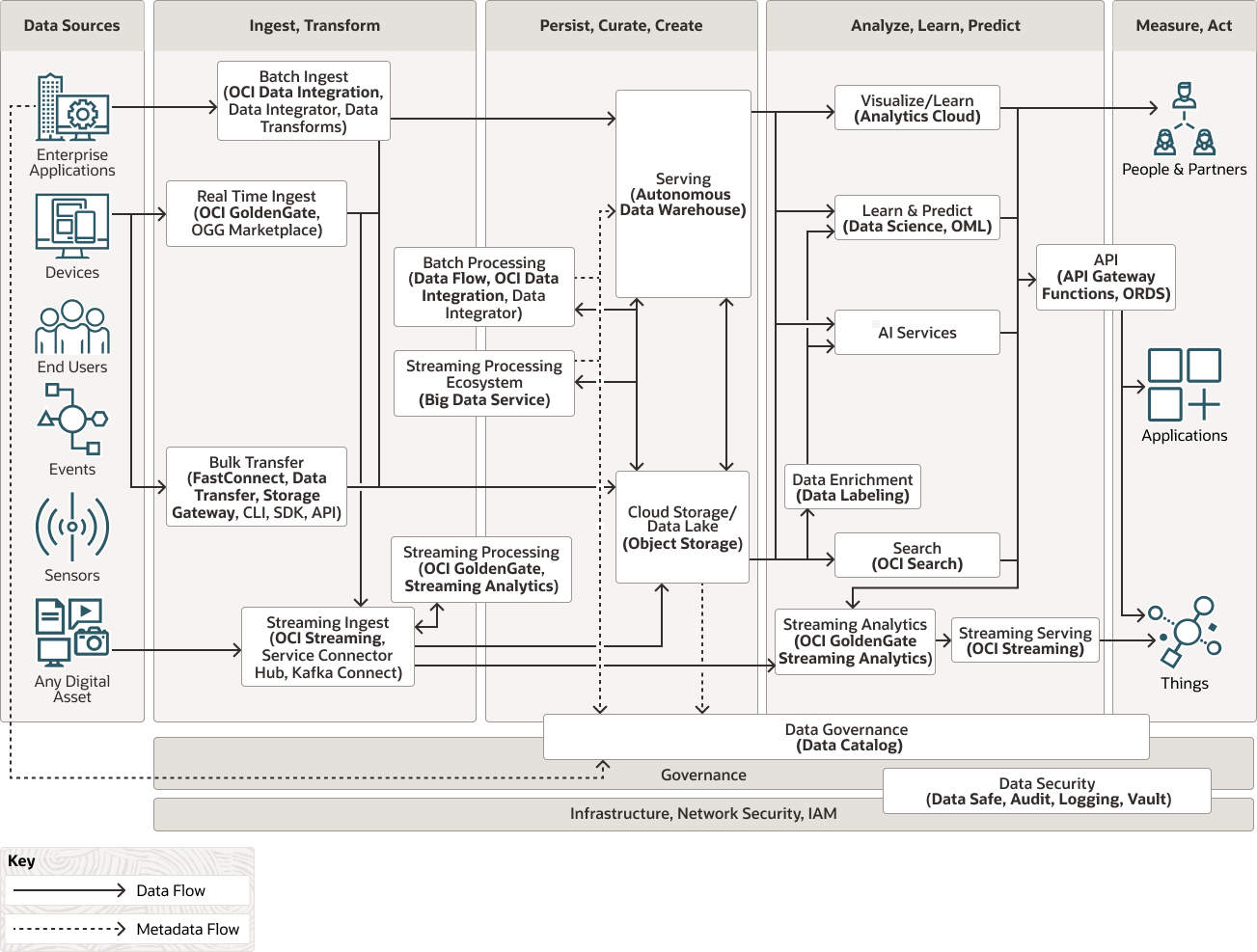

Sie können die Fähigkeiten eines Data Lakes und eines Data Warehouse kombinieren, um eine moderne Data Lakehouse-Plattform bereitzustellen, die Streaming und andere Datentypen aus einer breiten Palette von Unternehmensdatenressourcen verarbeitet, damit Sie die Daten für Geschäftsanalysen, maschinelles Lernen, Datenservices und Datenprodukte nutzen können.

Eine Data Lakehouse-Architektur kombiniert die Funktionen des Data Lake und des Data Warehouse, um die betriebliche Effizienz zu steigern und erweiterte Funktionen bereitzustellen, die Folgendes ermöglichen:

- Nahtlose Daten- und Informationsnutzung, ohne dass sie im Data Lake und Data Warehouse repliziert werden muss

- Diverse Datentypunterstützung in einer erweiterten Multimodell- und Polyglot-Architektur

- Nahtlose Datenaufnahme von jedem Verbraucher mithilfe von Echtzeit-, Streaming-, Batch-, Anwendungsprogrammierschnittstelle (API) und Massenaufnahmeverfahren

- Kontinuierliche Intelligenzextraktion aus Daten mithilfe von Services für künstliche Intelligenz (KI), generative KI und maschinelles Lernen (ML)

- Die Möglichkeit, jeden Datenverbraucher mit API, Benutzeroberfläche, Streaming und Integrationsmechanismen zu infundieren und zu bedienen

- Governance und fein granulierte Datensicherheit, die ein Zero-Trust-Sicherheitsmodell nutzt

- Die Möglichkeit, Speicher- und Rechenressourcen vollständig zu entkoppeln und zu jedem Zeitpunkt nur die benötigten Ressourcen zu verbrauchen

- Die Möglichkeit, mehrere Compute-Engines, einschließlich Open-Source-Engines, zu nutzen, um dieselben Daten für verschiedene Anwendungsfälle zu verarbeiten, um eine maximale Wiederverwendung von Daten, Liquidität und Nutzung zu erreichen

- Die Möglichkeit, Daten mit verschiedenen offenen Datei- und Tabellenformaten im Data Lake zu speichern

- Die Möglichkeit, native Oracle Cloud Infrastructure-(OCI-)Services zu nutzen, die von Oracle verwaltet werden und den Betriebsaufwand reduzieren

- Bessere Cloud-Ökonomie mit automatischer Skalierung, die Cloud-Ressourceninfrastruktur an den tatsächlichen Bedarf anpasst

- Modularität, sodass die Servicenutzung vom Anwendungsfall gesteuert wird

- Interoperabilität mit jedem System oder jeder Cloud, die offene Standards einhält

- Unterstützung für eine Vielzahl von Anwendungsfällen, einschließlich Streaming, Analysen, Data Science und maschinellem Lernen

- Unterstützung verschiedener Architekturansätze, von einem zentralen Lakehouse bis hin zu einem dezentralen Data Mesh

Das folgende Diagramm veranschaulicht die Funktionsarchitektur.

lakehouse-funktional-oracle.zip

Die Architektur konzentriert sich auf die folgenden logischen Geschäftsbereiche:

- Verbinden, aufnehmen, transformieren

Verbindet sich mit Datenquellen, nimmt Daten auf und verfeinert sie für die Verwendung in jeder der Datenschichten in der Architektur.

- Beibehalten, kuratieren, erstellen

Ermöglicht den Zugriff auf und die Navigation der Daten, um die aktuelle Geschäftsansicht anzuzeigen. Bei relationalen Technologien können Daten logisch oder physisch in einfachen relationalen, longitudinalen, dimensionalen oder OLAP-Formularen strukturiert sein. Bei nicht relationalen Daten enthält diese Schicht einen oder mehrere Datenpools, die entweder aus einem Analyseprozess ausgegeben werden oder für eine bestimmte analytische Aufgabe optimiert sind.

- Analysieren, lernen, vorhersagen

Abstrahiert die logische Geschäftsansicht der Daten für Consumer. Diese Abstraktion erleichtert agile Ansätze bei der Entwicklung, Migration zur Zielarchitektur und die Bereitstellung einer einzelnen Reportingschicht aus mehreren föderierten Quellen.

Die Architektur verfügt über die folgenden funktionalen Komponenten:

- Batchaufnahme

Die Batchaufnahme ist nützlich für Daten, die nicht in Echtzeit aufgenommen werden können oder die zu teuer sind, um sich für die Echtzeitaufnahme anzupassen. Es ist auch wichtig, Daten in zuverlässige und vertrauenswürdige Informationen umzuwandeln, die kuratiert und für den regelmäßigen Verbrauch beibehalten werden können. Sie können die folgenden Services gemeinsam oder unabhängig nutzen, um einen hochflexiblen und effektiven Datenintegrations- und Transformationsworkflow zu erreichen.

-

Oracle Cloud Infrastructure Data Integration ist ein vollständig verwalteter, serverloser, Cloud-nativer Service, der Daten aus einer Vielzahl von Datenquellen extrahiert, lädt, transformiert, bereinigt und neu gestaltet in Oracle Cloud Infrastructure-Zielservices wie Autonomous Data Warehouse und Oracle Cloud Infrastructure Object Storage. Benutzer entwerfen Datenintegrationsprozesse mit einer intuitiven, codeless-Benutzeroberfläche, die Integrationsabläufe optimiert, um die effizienteste Engine und Orchestrierung zu generieren und die Ausführungsumgebung automatisch zuzuweisen und zu skalieren.

ETL (Extract Transform Load) nutzt die vollständig verwaltete Scale-Out-Verarbeitung in Spark, und ELT (Extract Load Transform) nutzt die vollständigen SQL-Pushdown-Funktionen von Autonomous Data Warehouse, um die Datenverschiebung zu minimieren und die Amortisierungszeit für neu aufgenommene Daten zu verbessern.

Oracle Cloud Infrastructure Data Integration bietet interaktive Explorationen und Datenvorbereitung und unterstützt Data Engineers beim Schutz vor Schemaabweichungen, indem Regeln zur Verarbeitung von Schemaänderungen definiert werden.

-

Oracle Data Integrator bietet eine umfassende Datenintegration: von Batch-Loads mit hohem Datenvolumen und hoher Performance über ereignisgesteuerte Integrationsprozesse hinweg bis hin zu SOA-fähigen Datenservices. Ein deklarativer Designansatz sorgt für eine schnellere, einfachere Entwicklung und Wartung und bietet einen einzigartigen Ansatz zum Extrahieren von Lasttransformationen (ELT), mit dem ein Höchstmaß an Performance für Datentransformations- und Validierungsprozesse gewährleistet wird. Oracle-Datentransformationen verwenden eine Webschnittstelle, um die Konfiguration und Ausführung von ELT zu vereinfachen und Benutzern beim Erstellen und Planen von Daten und Arbeitsabläufen mit einem deklarativen Designansatz zu helfen.

-

Oracle Data Transforms ermöglichen ELT für ausgewählte unterstützte Technologien und vereinfachen die Konfiguration und Ausführung von Datenpipelines mit einer Webbenutzeroberfläche, mit der Benutzer Datenflüsse und Workflows deklarativ erstellen und planen können. Oracle Data Transforms ist als vollständig verwaltete Umgebung in Oracle Autonomous Data Warehouse (ADW) verfügbar, um Daten aus mehreren Datenquellen zu laden und in eine ADW-Instanz umzuwandeln.

Je nach Anwendungsfall können diese Komponenten unabhängig oder zusammen verwendet werden, um eine hochflexible und leistungsstarke Datenintegration und -transformation zu erreichen.

-

- API-basierte Aufnahme

Mit der API-basierten Erfassung können Anwendungen und Systeme Ereignisdaten mit APIs oder Webhooks übertragen.

-

Oracle Integration ist eine vollständig verwaltete, vorkonfigurierte Umgebung, in der Sie Cloud- und On-Premise-Anwendungen integrieren, Geschäftsprozesse automatisieren und visuelle Anwendungen entwickeln können. Es verwendet einen SFTP-konformen Dateiserver zum Speichern und Abrufen von Dateien und ermöglicht Ihnen den Austausch von Dokumenten mit Geschäftspartnern, indem Sie ein Portfolio aus Hunderten von Adaptern und Rezepten für die Verbindung mit Oracle- und Drittanbieteranwendungen verwenden.

-

Mit Oracle Cloud Infrastructure API Gateway können Sie APIs mit privaten Endpunkten veröffentlichen, auf die Sie über Ihr Netzwerk zugreifen können, und die Sie bei Bedarf im öffentlichen Internet verfügbar machen können. Die Endpunkte unterstützen API-Validierung, Anforderungs- und Antworttransformation, CORS, Authentifizierung und Autorisierung sowie Anforderungsbegrenzung.

Mit OCI API Gateway kann die API-Beobachtbarkeit die Nutzung überwachen und SLAs garantieren. Nutzungspläne können auch verwendet werden, um API-Consumer und -Clients zu überwachen und zu verwalten und verschiedene API-Zugriffsstufen für verschiedene Kunden einzurichten. Nutzungspläne sind ein wichtiges Feature zur Unterstützung der Datenmonetarisierung.

Nutzungspläne unterstützen die Datenmonetarisierung, indem sie gestaffelte Nutzungspläne erstellen, um API-Consumer und -Clients zu verwalten und ihre Datennutzung zu verfolgen.

-

Oracle Cloud Infrastructure Functions ist eine vollständig verwaltete, mehrmandantenfähige, hoch skalierbare, bedarfsgesteuerte Functions-as-a-Service-(FaaS-)Plattform. Es wird von der Open-Source-Engine Fn Project angetrieben. Mit Funktionen können Sie Ihren Code bereitstellen und entweder direkt aufrufen oder als Reaktion auf Ereignisse auslösen. Oracle Functions verwendet Docker-Container, die in Oracle Cloud Infrastructure Registry gehostet werden.

-

Oracle REST Data Services (ORDS) ist eine Java-Anwendung, mit der Entwickler mit SQL- und Datenbankkenntnissen REST-APIs für Oracle Database entwickeln können. Jeder Anwendungsentwickler kann diese APIs aus jeder Sprachumgebung verwenden, ohne Clienttreiber auf die gleiche Weise zu installieren und zu verwalten, wie sie mit REST, der am häufigsten verwendeten API-Technologie, auf andere externe Services zugreifen.

ORDS wird als vollständig verwaltetes Feature in Oracle Autonomous Data Warehouse bereitgestellt und kann verwendet werden, um Lakehouse-Informationen bereitzustellen, indem APIs für Data Consumer verwendet werden.

-

-

Echtzeitaufnahme

Oracle Cloud Infrastructure GoldenGate ist ein vollständig verwalteter Service, mit dem Daten aus Quellen aufgenommen werden können, die sich On Premise oder in einer beliebigen Cloud befinden. Er nutzt die CDC-Technologie GoldenGate für eine nicht aufdringliche und effiziente Datenerfassung und -bereitstellung an Oracle Autonomous Data Warehouse, Oracle Cloud Infrastructure Object Storage oder Oracle Cloud Infrastructure Streaming in Echtzeit und in großem Umfang, um relevante Informationen für Verbraucher so schnell wie möglich verfügbar zu machen.

- Massentransfer

Mit der Massenübertragung können Sie große Datenmengen mit verschiedenen Methoden verschieben. Für große Data Lakehouses empfehlen wir Oracle Cloud Infrastructure FastConnect- und Data Transfer-Services.

-

Mit Oracle Cloud Infrastructure FastConnect können Sie ganz einfach eine dedizierte, private Verbindung zwischen Ihrem Data Center und Oracle Cloud Infrastructure herstellen. FastConnect bietet Optionen mit höherer Bandbreite und ein zuverlässigeres Netzwerk als bei internetbasierten Verbindungen.

- Mit der Oracle Cloud Infrastructure-(OCI-)Befehlszeilenschnittstelle (CLI) können Sie die Datenübertragung von On Premise zu OCI ausführen und automatisieren, indem Sie den privaten Circuit von Oracle Cloud Infrastructure FastConnect nutzen. Mit OCI-SDKs können Sie Code schreiben, um Daten und Dateien aus On Premise oder aus anderen Clouds in Oracle Cloud Infrastructure Object Storage zu kopieren oder zu synchronisieren. Dabei werden verschiedene Programmiersprachen wie Python, Java oder Go verwendet, um nur einige zu nennen. Mit REST-APIs können Sie eine Schnittstelle zu OCI-Services herstellen und diese steuern, z.B. Daten mit der Object Storage-Service-API in den Objektspeicher verschieben.

- Oracle Cloud Infrastructure Data Transfer ist ein Offline-Datenmigrationsservice, mit dem Sie Datasets in Petabyte-Größe sicher von Ihrem Data Center zu Oracle Cloud Infrastructure Object Storage oder Archive Storage verschieben können. Aufgrund von hohen Netzwerkkosten, unzuverlässigen Netzwerkverbindungen, langen Übertragungszeiten und Sicherheitsbedenken ist es nicht immer möglich oder sinnvoll, Daten über das öffentliche Internet in die Cloud zu verschieben. Mit Data Transfer Service können Sie diese Herausforderungen bewältigen und Daten wesentlich schneller in die Cloud migrieren. Data Transfer ist über Datenträger oder Appliance verfügbar. Die Auswahl einer Einheit hängt hauptsächlich von der Datenmenge ab, wobei Data Transfer Appliance größere Datasets für jede Appliance unterstützt.

-

- Streaming-Aufnahme

Die Streamingaufnahme wird durch die Verwendung von OCI-nativen Services unterstützt, die eine Echtzeitaufnahme großer Datasets von einem breiten Satz von Datenproduzenten ermöglichen. Die Streamingaufnahme bleibt bestehen und synchronisiert die Daten im Objektspeicher, der das Herzstück des Data Lakehouse ist. Durch die Synchronisierung von Daten mit dem Objektspeicher können Sie historische Daten speichern, die kuratiert und weiter transformiert werden können, um wertvolle Erkenntnisse zu gewinnen.

-

Oracle Cloud Infrastructure Streaming bietet eine vollständig verwaltete, skalierbare und dauerhafte Speicherlösung zur Aufnahme kontinuierlicher Datenstreams mit hohem Volumen, die Sie in Echtzeit konsumieren und verarbeiten können. Streaming kann für Messaging, großvolumige Anwendungslogs, betriebliche Telemetrie, Clickstream-Webdaten oder andere Anwendungsfälle für das Publish-Subscribe-Messagingmodell verwendet werden, bei denen kontinuierlich und sequenziell Daten erzeugt und verarbeitet werden. Die Daten werden mit Oracle Cloud Infrastructure Object Storage synchronisiert und können kuratiert und weiter transformiert werden, um wertvolle Erkenntnisse zu gewinnen.

-

Oracle Cloud Infrastructure Queue ist ein vollständig verwalteter serverloser Service, mit dem Systeme getrennt und asynchrone Vorgänge aktiviert werden können. Queue verarbeitet Transaktionsdaten mit hohem Volumen, die unabhängig verarbeitete Nachrichten ohne Verlust oder Duplizierung erfordern.

-

Oracle Cloud Infrastructure Service Connector Hub ist eine Cloud-Nachrichtenbusplattform, die einen zentralen Einblick für das Beschreiben, Ausführen und Monitoring der Datenverschiebung zwischen Services in Oracle Cloud Infrastructure bietet. Für diese bestimmte Referenzarchitektur werden Daten aus Oracle Cloud Infrastructure Streaming oder OCI Queue in Oracle Cloud Infrastructure Object Storage verschoben, um die Rohdaten und vorbereiteten Daten in der Data Lakehouse-Persistenzschicht zu persistieren.

-

-

Streaming-Verarbeitung

Die Streaming-Verarbeitung reichert Streamingdaten an, erkennt Ereignismuster und erstellt eine andere Gruppe von Streams, die im Data Lakehouse persistiert werden.

-

Oracle Cloud Infrastructure GoldenGate Stream Analytics verarbeitet und analysiert umfangreiche Echtzeitinformationen mithilfe ausgefeilter Korrelationsmuster, Datenanreicherung und maschinellem Lernen. Benutzer können Echtzeitdaten über Live-Diagramme, Karten und Visualisierungen untersuchen und Streaming-Pipelines grafisch ohne Handcodierung erstellen. Diese Pipelines werden in einem vollständig verwalteten und skalierbaren Service ausgeführt, um kritische Echtzeit-Anwendungsfälle moderner Unternehmen zu bewältigen.

-

Oracle Cloud Infrastructure Data Flow ist ein vollständig verwalteter Big Data-Service, mit dem Sie Apache Spark- und Spark Streaming-Anwendungen ausführen können, ohne die Infrastruktur bereitstellen oder verwalten zu müssen. Sie können damit Big Data- und KI-Anwendungen schneller bereitstellen, da Sie sich auf Ihre Anwendungen konzentrieren können, ohne den Betrieb verwalten zu müssen. Datenflussanwendungen sind wiederverwendbare Vorlagen, die aus einer Spark-Anwendung und deren Abhängigkeiten, Standardparameter und einer Spezifikation von Standardlaufzeitressourcen bestehen.

-

- Open-Source-Ökosystem

Sie können das Open-Source-Ökosystem nutzen:

- Für die Batch- und Stream-Verarbeitung mit mehreren gängigen Open-Source-Engines wie Hadoop, Spark, Flink oder Trino

- Mit Oracle Cloud Infrastructure Streaming sowohl als Produzent als auch als Verbraucher

- Mit Oracle Cloud Infrastructure Object Storage können Sie sowohl Daten persistieren als auch Daten konsumieren

Sie können Oracle Cloud Infrastructure Object Storage als Data Lake verwenden, um Datasets zu persistieren, die Sie zwischen den verschiedenen Oracle Cloud Infrastructure-Services zu unterschiedlichen Zeiten gemeinsam verwenden möchten.

Big Data Service stellt vollständig konfigurierte, sichere, hoch verfügbare und dedizierte Hadoop-, Spark- oder Flink-Cluster unter anderen Technologien auf Anforderung bereit. Skalieren Sie das Cluster entsprechend Ihren Big-Data- und Analyse-Workloads, indem Sie eine Reihe von Oracle Cloud Infrastructure-Compute-Ausprägungen verwenden, die alles unterstützen, von kleinen Test- und Entwicklungsclustern bis zu großen Produktionsclustern. Passen Sie sich schnell an den Geschäftsbedarf an, und optimieren Sie die Kosten, indem Sie Autoscaling-Konfigurationen basierend auf Metriken oder im Zeitplan nutzen. Nutzen Sie Clusterprofile, um optimale Cluster für eine bestimmte Workload oder Technologie zu erstellen. - Batchverarbeitung

Die Batchverarbeitung transformiert groß angelegte Datasets, die im Data Lakehouse gespeichert sind. Die Batchverarbeitung nutzt native Oracle Cloud Infrastructure-Services, die sich nahtlos in Oracle Cloud Infrastructure Object Storage integrieren lassen, und ermöglicht es Ihnen, kuratierte Daten für Anwendungsfälle wie Datenaggregation und -anreicherung, Data Warehouse-Aufnahme sowie skalierbare Nutzung von maschinellem Lernen und KI-Daten zu erstellen.

-

Oracle Cloud Infrastructure Data Integration, oben beschrieben, ist ein vollständig verwalteter, serverloser, Cloud-nativer Service, der Daten aus einer Vielzahl von Datenquellen extrahiert, lädt, transformiert, bereinigt und neu formt in Ziel-Oracle Cloud Infrastructure-Services, wie Autonomous Data Warehouse und Oracle Cloud Infrastructure Object Storage.

-

Oracle Cloud Infrastructure Data Flow ist ein vollständig verwalteter Big Data-Service, mit dem Sie Apache Spark- und Spark Streaming-Anwendungen ausführen können, ohne die Infrastruktur bereitstellen oder verwalten zu müssen. Sie können damit Big Data- und KI-Anwendungen schneller bereitstellen, da Sie sich auf Ihre Anwendungen konzentrieren können, ohne den Betrieb verwalten zu müssen. Datenflussanwendungen sind wiederverwendbare Vorlagen, die aus einer Spark-Anwendung und deren Abhängigkeiten, Standardparameter und einer Spezifikation von Standardlaufzeitressourcen bestehen.

-

Oracle Data Transforms ermöglichen Extract-Load-Transform (ELT) für ausgewählte unterstützte Technologien und vereinfachen die Konfiguration und Ausführung von Datenpipelines mit einer Webbenutzeroberfläche, mit der Benutzer Datenflüsse und Workflows deklarativ erstellen und planen können. Oracle Data Transforms ist als vollständig verwaltete Umgebung in Oracle Autonomous Data Warehouse (ADW) verfügbar, um Daten aus mehreren Datenquellen zu laden und in eine ADW-Instanz umzuwandeln.

Je nach Anwendungsfall können diese Komponenten unabhängig oder gemeinsam eingesetzt werden, um eine hochflexible und performante Datenverarbeitung zu erreichen.

-

- Bedient

Oracle Autonomous Data Warehouse ist ein selbststeuernder, selbstsichernder und selbstreparierender Datenbankservice, der für Data Warehousing-Workloads optimiert ist. Sie müssen keine Hardware konfigurieren oder verwalten oder Software installieren. Mit Oracle Cloud Infrastructure können Sie die Datenbank erstellen, sichern, patchen, aktualisieren und optimieren.

Nach dem Provisioning können Sie die Anzahl der CPU-Cores oder die Speicherkapazität der Datenbank jederzeit skalieren, ohne dass sich dies auf Verfügbarkeit oder Performance auswirkt.

Oracle Autonomous Data Warehouse kann Daten, die sich im Objektspeicher befinden, auch als externe und hybride partitionierte Tabellen virtualisieren, sodass Sie Daten, die aus anderen Quellen abgeleitet wurden, mit den Warehouse-Daten verknüpfen und konsumieren können. Sie können historische Daten auch aus dem Warehouse in den Objektspeicher verschieben und dann mithilfe hybrider partitionierter Tabellen nahtlos nutzen.

Oracle Autonomous Data Warehouse kann zuvor im Data Catalog gespeicherte Metadaten für externe Tabellen verwenden und Metadatenaktualisierungen im Data Catalog automatisch mit der Definition der externen Tabellen synchronisieren, um Konsistenz zu gewährleisten, die Verwaltung zu vereinfachen und den Aufwand zu reduzieren.

Vektoren werden in Autonomous Database unterstützt, da es sich um eine Datenbank mit mehreren Modellen handelt, die mehrere Datentypen unterstützt, nämlich relational, JSON, räumlich und grafisch. Der Datentyp "Vektoren" ermöglicht das Laden und Speichern von Vektoreinbettungen sowie das Erstellen von Vektorindizes, die dann für Retrieval Augmented Generation-(RAG-)Anwendungen in einer einzelnen Cloud-Autonomous Data Warehouse-Instanz verwendet werden können. Diese Multi-Modell-Funktion ermöglicht Analysen mit allen Datentypen, die in einer einzigen Abfrage verknüpft werden können, wodurch die Komplexität und das Risiko von spezialisierten isolierten Datenbanken pro Datentyp reduziert werden und gleichzeitig eine höhere Sicherheit, Zuverlässigkeit, Skalierbarkeit und einfache Analyse aller Daten gewährleistet wird.

Wählen Sie AI aus, ein Autonomous Database-Feature, mit dem Daten in natürlicher Sprache abgefragt werden können. Verwenden Sie LLMs, um den Eingabetext des Benutzers in Oracle SQL zu konvertieren. Wählen Sie AI, um die Eingabeaufforderung in natürlicher Sprache zu verarbeiten, die Eingabeaufforderung mit Metadaten zu ergänzen und dann eine SQL-Abfrage zu generieren und auszuführen.

Die gemeinsame Nutzung von Daten, ein Autonomous Database-Feature, ermöglicht die sichere Bereitstellung und Nutzung von Daten und Metadaten von anderen Parteien, die Autonomous Database oder eine Delta-Sharing-konforme Technologie verwenden. Die gemeinsame Nutzung von Daten erleichtert die nahtlose Nutzung von Daten aus Share Providern, da Ansichten die zugrunde liegenden gemeinsamen Tabellen abstrahieren. Darüber hinaus können Live Shares, mit denen Empfänger Live- und frische Daten konsumieren können, verwendet werden, wenn sowohl der Provider als auch der Empfänger Autonomous Database verwenden.

Analyse-Views, ein Autonomous Database-Feature, bieten eine schnelle und effiziente Möglichkeit, analytische Abfragen von Daten zu erstellen, die in vorhandenen Datenbanktabellen und -Views gespeichert sind. Analytische Views organisieren Daten mit einem Dimensionsmodell. Sie ermöglichen Ihnen das einfache Hinzufügen von Aggregationen und Berechnungen zu Datasets und die Darstellung von Daten in Ansichten, die mit relativ einfacher SQL abgefragt werden können. Mit dieser Funktion können Sie ein Star- oder Snowflake-Schema direkt in ADW semantisch modellieren. Dabei werden intern und extern gespeicherte Daten verwendet. Außerdem können Sie das Modell mit SQL und jedem SQL-konformen Daten-Consumer nutzen.

Darüber hinaus kann Autonomous Data Lake Accelerator, eine Komponente von Autonomous Database, Objektspeicherdaten nahtlos nutzen, die Verarbeitung skalieren, um schnelle Abfragen bereitzustellen, die Datenbank-Compute-Instanz bei Bedarf automatisch zu skalieren und die Auswirkungen auf die Datenbank-Workload zu reduzieren, indem Objektspeicherabfragen von der Datenbank-Compute-Instanz isoliert werden.

- Cloud-Speicher

Oracle Cloud Infrastructure Object Storage ist eine internetbasierte, leistungsstarke Speicherplattform, die zuverlässige und kostengünstige Dauerhaftigkeit von Daten bietet. Oracle Cloud Infrastructure Object Storage kann eine unbegrenzte Menge unstrukturierter Daten eines beliebigen Inhaltstyps speichern, einschließlich analytischer Daten. Sie können Daten sicher speichern oder direkt aus dem Internet oder aus der Cloud-Plattform abrufen. Mit mehreren Verwaltungsschnittstellen können Sie ganz einfach klein anfangen und nahtlos skalieren, ohne dass die Performance oder Servicezuverlässigkeit beeinträchtigt wird.

Oracle Cloud Infrastructure Object Storage kann auch als Cold Storage-Schicht für das Data Warehouse verwendet werden, indem Daten gespeichert werden, die selten verwendet werden, und dann nahtlos mit den neuesten Daten verknüpft werden, indem hybride Tabellen in Oracle Autonomous Data Warehouse verwendet werden.

Die granulare Zugriffskontrolle auf Objektebene kann mit IAM-Policys für Objekte durchgesetzt werden, um die Datensicherheit für direkte Data Lake-Zugriffe zu erhöhen.

- Visualisieren und lernen

Oracle Analytics Cloud ist ein skalierbarer und sicherer Public-Cloud-Service, der umfassende Funktionen bereitstellt, mit denen Sie kollaborative Analysen für sich, Ihre Arbeitsgruppe und Ihr Unternehmen durchführen können. Es unterstützt Citizen Data Scientists, fortgeschrittene Business Analysts-Schulungen und die Ausführung von ML-Modellen. Modelle für maschinelles Lernen können auf dem Analyseservice oder direkt auf Oracle Autonomous Data Warehouse als OML-eingebettete Modelle für groß angelegte Batchvorhersagen ausgeführt werden, die von der Verarbeitungsleistung, Skalierbarkeit und Elastizität der Warehouse- und OCI-KI-Services wie Oracle Cloud Infrastructure Vision profitieren.

Mit Oracle Analytics Cloud erhalten Sie außerdem flexible Serviceverwaltungsfunktionen, darunter schnelles Setup, einfache Skalierung und Patches sowie automatisiertes Lebenszyklusmanagement.

-

Lernen und vorhersagen

-

Data Science bietet Infrastruktur, Open-Source-Technologien, Bibliotheken, Packages und Data-Science-Tools, mit denen Data-Science-Teams Modelle für maschinelles Lernen (ML) in Oracle Cloud Infrastructure erstellen, trainieren und verwalten können. Der kollaborative und projektgesteuerte Workspace bietet eine durchgängig einheitliche Benutzererfahrung und unterstützt den Lebenszyklus von Vorhersagemodellen. Mit Data Science können Data Scientists und Machine Learning-Ingenieure kostenlos Pakete direkt aus dem Anaconda-Repository herunterladen und installieren. So können sie mit einem kuratierten Data Science-Ökosystem aus ML-Bibliotheken Innovationen bei ihren Projekten vorantreiben.

Mit dem Data Science-Jobfeature können Data Scientists wiederholbare Aufgaben für maschinelles Lernen in einer vollständig verwalteten Infrastruktur definieren und ausführen.

Mit der Data Science-Modellbereitstellungsfunktion können Data Scientists trainierte Modelle als vollständig verwaltete HTTP-Endpunkte bereitstellen, die Vorhersagen in Echtzeit liefern, Informationen in Prozesse und Anwendungen einbringen und es dem Unternehmen ermöglichen, auf relevante Ereignisse zu reagieren, während sie auftreten.

-

Oracle Machine Learning bietet leistungsstarke Funktionen für maschinelles Lernen, die eng in Autonomous Database integriert sind und Python und AutoML unterstützen. Es unterstützt Modelle mit Open Source- und skalierbaren datenbankinternen Algorithmen, die Datenvorbereitung und -bewegung reduzieren. Mit AutoML können Data Scientists die Amortisierungszeit der Initiativen des Unternehmens für maschinelles Lernen verkürzen, indem sie die automatische Algorithmusauswahl, das adaptive Daten-Sampling, die automatische Featureauswahl und die automatische Modelloptimierung verwenden. Mit Oracle Machine Learning-Services, die in Oracle Autonomous Data Warehouse verfügbar sind, können Sie nicht nur Modelle verwalten, sondern diese Modelle auch als REST-Endpunkte bereitstellen, um Echtzeitvorhersagen im Unternehmen zu demokratisieren, sodass Unternehmen auf relevante Ereignisse reagieren können, wenn sie auftreten, anstatt danach.

-

- KI- und generative KI-Services

Oracle Cloud Infrastructure-KI-Services stellen eine Reihe konsumfertiger KI-Services bereit, mit denen eine Reihe von Anwendungsfällen von der Textanalyse bis zur vorausschauenden Wartung unterstützt werden können. Diese Services verfügen über vordefinierte, fein abgestimmte Modelle, die Sie mit APIs in Datenpipelines, Analysen und Anwendungen integrieren können.

-

Oracle Cloud Infrastructure Language führt anspruchsvolle Textanalysen und Übersetzungen in großem Maßstab durch. Mit vortrainierten und benutzerdefinierten Modellen können Entwickler unstrukturierten Text verarbeiten und Erkenntnisse ohne Data Science-Kenntnisse extrahieren. Führen Sie Sentimentanalysen, Schlüsselphrasenextraktion, Textklassifizierung, Named Entity Recognition durch und ermitteln Sie PII-Daten im Text. Passen Sie Modelle für domänenspezifische Aufgaben an und übersetzen Sie Texte mühelos in verschiedene Sprachen. Oracle Cloud Infrastructure Language unterstützt auch Dokumentübersetzungen und asynchrone Jobs zur effizienten Verarbeitung von Workloads mit großem Volumen.

- Oracle Cloud Infrastructure Speech nutzt die Leistungsfähigkeit der gesprochenen Sprache, indem Sie Mediendateien, die menschliche Sprache enthalten, einfach in hochgenaue Texttranskriptionen konvertieren können. Mit OCI Speech können Sie Kundenserviceanrufe transkribieren, die Untertitelerstellung automatisieren und Metadaten für Medienassets generieren, um ein vollständig durchsuchbares Archiv zu erstellen. OCI Speech unterstützt Batch- und Live-Transkriptionsjobs.

-

OCI Vision führt Aufgaben zur Bilderkennung und Videoanalyse aus, wie das Klassifizieren von Bildern, das Erkennen von Objekten und Gesichtern und das Extrahieren von Text. Sie können entweder vortrainierte Modelle nutzen oder ganz einfach benutzerdefinierte Vision-Modelle für branchenspezifische und kundenspezifische Szenarios erstellen. OCI Vision ist ein vollständig verwalteter, mehrmandantenfähiger, nativer Cloud-Service, der bei allen gängigen Computer Vision-Aufgaben hilft.

- Oracle Cloud Infrastructure Document Understanding führt Dokumentklassifizierungs- und Dokumentanalyseaufgaben aus, wie das Extrahieren von Text, Schlüsselwerten und Tabellen. Der OCI Document Understanding-Service ist ein vollständig verwalteter, mehrmandantenfähiger, nativer Cloud-Service, der alle gängigen Dokumentanalyseaufgaben unterstützt.

- Oracle Cloud Infrastructure Generative AI ist eine vollständig verwaltete Lösung, die eine Reihe hochmoderner, anpassbarer großer Sprachmodelle (Large Language Models, LLMs) bereitstellt, die eine breite Palette an Anwendungsfällen abdecken, darunter Chat, Textgenerierung, Zusammenfassung und das Erstellen von Texteinbettungen. Mit dem Playground können Sie vortrainierte Modelle sofort verwenden oder eigene optimierte benutzerdefinierte Modelle basierend auf Ihren eigenen Daten auf dedizierten KI-Clustern erstellen und hosten.

-

- Datenanreicherung

Die Datenanreicherung kann die Daten verbessern, mit denen Modelle für maschinelles Lernen trainiert werden, um bessere und genauere Vorhersageergebnisse zu erzielen.

Mit Oracle Cloud Infrastructure Data Labeling können Sie Datasets erstellen und durchsuchen, Datensätze (Text oder Bilder) anzeigen sowie Labels anwenden, um KI-/ML-Modelle zu erstellen. Der Service bietet auch interaktive Benutzeroberflächen, die den Etikettierungsprozess unterstützen. Nachdem Datensätze beschriftet wurden, kann das Dataset als zeilenbegrenztes JSON zur Verwendung in der AI/ML-Modellentwicklung exportiert werden. - Suchen

Suchfunktionen können als ergänzende Funktion verwendet werden, um Endbenutzern Daten zur Verfügung zu stellen, die operative Analysedaten erfordern, die vorindiziert sind und daher mit geringer Latenz bedient werden.

Die Oracle Cloud Infrastructure-Suche mit OpenSearch ist eine verteilte, vollständig verwaltete, wartungsfreie Volltextsuchmaschine. Mit OpenSearch können Sie große Datenmengen mit schnellen Antwortzeiten schnell speichern, suchen und analysieren. Der Service unterstützt Open Source-APIs OpenSearch und die Datenvisualisierung von Dashboards OpenSearch. - Streaminganalysen

Streaming-Analysen bieten Dashboards, die Echtzeitanalysen von gestreamten Daten bereitstellen, die mit kuratierten und im Data Lakehouse gespeicherten Stammdaten kontextualisiert sind, um interessante Muster zu erkennen, die sie dann für Benutzer, Anwendungen und Dinge bereitstellen können.

Oracle Cloud Infrastructure GoldenGate Stream Analytics verarbeitet und analysiert umfangreiche Echtzeitinformationen mithilfe ausgefeilter Korrelationsmuster, Datenanreicherung und maschinellem Lernen. Benutzer können Echtzeitdaten über Live-Diagramme, Karten, Visualisierungen und grafische Erstellung von Streaming-Pipelines ohne Handcodierung untersuchen. Diese Pipelines werden in einem vollständig verwalteten und skalierbaren Service ausgeführt, um kritische Echtzeit-Anwendungsfälle moderner Unternehmen zu bewältigen.

- ETL/Writeback umkehren

Reverse ETL, manchmal auch als Writeback bezeichnet, ermöglicht die Datenaktivierung in Betriebssysteme und Geräte, sodass aus Daten abgeleitete Informationen direkt in Anwendungen und Geräte eingebracht werden können, die zur Unterstützung von Geschäftsprozessen verwendet werden.

Die Daten werden den Verbrauchern über verschiedene Mechanismen zur Verfügung gestellt, nämlich über Streams und Queues, die eine große Anzahl von Verbrauchern unterstützen, die gleichzeitig Informationen abrufen, die sich nahezu in Echtzeit befinden und von diesen entkoppelt sind. das Streaming-Analysesystem, um die Resilienz und Skalierbarkeit zu erhöhen, über die Anwendungs- oder Datenintegration, um Daten über vordefinierte Adapter zu übertragen, oder über serverlose Funktionen, um praktisch jeden Anwendungs- oder Geräteendpunkt aufzurufen.

-

Oracle Cloud Infrastructure Streaming Service bietet eine vollständig verwaltete, skalierbare und dauerhafte Speicherlösung zur Aufnahme kontinuierlicher Datenstreams mit hohem Volumen, die Sie in Echtzeit konsumieren und verarbeiten können. Streaming kann für Messaging, großvolumige Anwendungslogs, betriebliche Telemetrie, Clickstream-Webdaten oder andere Anwendungsfälle für das Publish-Subscribe-Messagingmodell verwendet werden, bei denen kontinuierlich und sequenziell Daten erzeugt und verarbeitet werden.

-

Oracle Cloud Infrastructure Queue ist ein vollständig verwalteter serverloser Service, mit dem Systeme getrennt und asynchrone Vorgänge aktiviert werden können. Queue verarbeitet Transaktionsdaten mit hohem Volumen, die unabhängig verarbeitete Nachrichten ohne Verlust oder Duplizierung erfordern.

-

Oracle Integration Cloud ist eine vollständig verwaltete, vorkonfigurierte Umgebung, die die Integration von Cloud- und On-Premise-Anwendungen, die Automatisierung von Geschäftsprozessen, die Entwicklung visueller Anwendungen, die Verwendung eines SFTP-konformen Dateiservers zum Speichern und Abrufen von Dateien und den Austausch von Geschäftsdokumenten mit einem B2B-Geschäftspartner mit einem Portfolio aus Hunderten von Adaptern und Rezepten für die Verbindung mit Oracle- und Drittanbieteranwendungen ermöglicht.

-

Oracle Data Transforms ermöglichen ELT für ausgewählte unterstützte Technologien und vereinfachen die Konfiguration und Ausführung von Datenpipelines mit einer Webbenutzeroberfläche, mit der Benutzer Datenflüsse und Workflows deklarativ erstellen und planen können. Oracle Data Transforms ist als vollständig verwaltete Umgebung in Oracle Autonomous Data Warehouse (ADW) zum Laden und Transformieren von Daten aus mehreren Datenquellen in eine ADW-Instanz verfügbar.

-

Oracle Cloud Infrastructure Functions ist eine vollständig verwaltete, mehrmandantenfähige, hochskalierbare, bedarfsgesteuerte, Functions-as-a-Service-Plattform. Sie basiert auf Oracle Cloud Infrastructure für Unternehmen und wird von der Open-Source-Engine Fn-Projekt unterstützt.

-

- API

Mit der API-Schicht können Sie die aus Data Science und Oracle Machine Learning abgeleitete Intelligenz in Anwendungen, Geschäftsprozesse und Dinge integrieren, um deren Betrieb und Funktion zu beeinflussen und zu verbessern. Die API-Schicht bietet eine sichere Nutzung der von Data Science bereitgestellten Modelle für Oracle Machine Learning-REST-Endpunkte und die Möglichkeit, das System zu steuern, um die Verfügbarkeit von Laufzeitumgebungen sicherzustellen. Sie können Funktionen auch nutzen, um bei Bedarf zusätzliche Logik auszuführen.

-

Mit dem Oracle Cloud Infrastructure-API-Gateway können Sie APIs mit privaten Endpunkten veröffentlichen, auf die Sie über Ihr Netzwerk zugreifen können. Sie können aber auch öffentliche IP-Adressen angeben, wenn Internettraffic akzeptiert werden soll. Die Endpunkte unterstützen API-Validierung, Anforderungs- und Antworttransformation, CORS, Authentifizierung und Autorisierung sowie Anforderungsbegrenzung. Sie ermöglicht die Überwachung der Nutzung durch die API und garantiert SLAs. Nutzungspläne können auch verwendet werden, um die API-Consumer und API-Clients zu überwachen und zu verwalten, die auf APIs zugreifen, und um verschiedene Zugriffsebenen für verschiedene Kunden einzurichten, um die Datennutzung zu verfolgen, die durch die Verwendung von APIs genutzt wird. Nutzungspläne sind ein wichtiges Feature zur Unterstützung der Datenmonetarisierung.

-

Oracle Cloud Infrastructure Functions ist eine vollständig verwaltete, mehrmandantenfähige, hochskalierbare, bedarfsgesteuerte Funktion-as-a-Service-Plattform. Sie basiert auf Oracle Cloud Infrastructure für Unternehmen und wird von der Open-Source-Engine Fn-Projekt unterstützt.

-

Oracle REST Data Services (ORDS) ist eine Java-Anwendung, mit der Entwickler mit SQL- und Datenbankkenntnissen REST-APIs für Oracle Database entwickeln können. Jeder Anwendungsentwickler kann diese APIs aus jeder Sprachumgebung ohne Installation und Wartung von Clienttreibern auf dieselbe Weise verwenden, wie er mit REST, der am häufigsten verwendeten API-Technologie, auf andere externe Services zugreift. ORDS wird als vollständig verwaltetes Feature in ADW bereitgestellt und kann verwendet werden, um Lakehouse-Informationen bereitzustellen, indem APIs für Data Consumer verwendet werden.

-

- Data Governance

Oracle Cloud Infrastructure Data Catalog bietet einen Überblick darüber, wo sich technische Assets wie Metadaten und zugehörige Attribute befinden, und bietet die Möglichkeit, ein Geschäftsglossar zu verwalten, das diesen technischen Metadaten zugeordnet ist. Data Catalog kann auch Metadaten für Oracle Autonomous Data Warehouse bereitstellen, um die Erstellung externer Tabellen im Data Warehouse zu vereinfachen.

-

Datensicherheit

Datensicherheit ist entscheidend, um Lakehouse-Daten in vollem Umfang zu untersuchen und zu verwenden. Durch die Nutzung eines Zero-Trust-Sicherheitsmodells mit Defense-in-Depth- und RBAC-Funktionen und die Gewährleistung der Einhaltung strengster Vorschriften bietet Datensicherheit vorbeugende, detektive und korrigierende Sicherheitskontrollen, um sicherzustellen, dass Datenexfiltration und -verletzungen verhindert werden.

-

Oracle Data Safe ist ein vollständig integrierter Oracle Cloud-Service, der auf die Datensicherheit abzielt. Er bietet ein vollständiges und integriertes Featureset zum Schutz sensibler und regulierter Daten in Oracle Cloud-Datenbanken wie Oracle Autonomous Data Warehouse. Zu den Features gehören Sicherheitsbewertung, Benutzerbewertung, Datenerkennung, Datenmaskierung und Aktivitätsauditing.

-

Mit Oracle Cloud Infrastructure Audit können Sie Aktivitäten im Zusammenhang mit Oracle Cloud Infrastructure-(OCI-)Ressourcen und -Mandanten anzeigen. Auditlogereignisse können für Sicherheitsaudits verwendet werden, um die Nutzung von und Änderungen an OCI-Ressourcen zu verfolgen und die Einhaltung von Standards und Vorschriften zu gewährleisten.

-

Oracle Cloud Infrastructure Logging bietet eine hochskalierbare und vollständig verwaltete zentrale Schnittstelle für alle Logs im Mandanten, einschließlich Auditlogs. Mit OCI Logging können Sie auf Logs aus allen OCI-Ressourcen zugreifen, damit Sie sie aktivieren, verwalten und durchsuchen können.

-

Oracle Cloud Infrastructure Vault ist ein Verschlüsselungsverwaltungsservice, der Verschlüsselungsschlüssel und Secrets für den sicheren Zugriff auf Ressourcen speichert und verwaltet. Ermöglicht die Verwendung von vom Kunden verwalteten Schlüsseln für Oracle Autonomous Data Warehouse und Data Lake-Verschlüsselung für besseren Datenschutz im Ruhezustand. Ermöglicht es Secrets, Services und Benutzerzugangsdaten sicher zu speichern, um Ihren Sicherheitsstatus zu verbessern und sicherzustellen, dass Zugangsdaten nicht gefährdet und unangemessen verwendet werden.

-

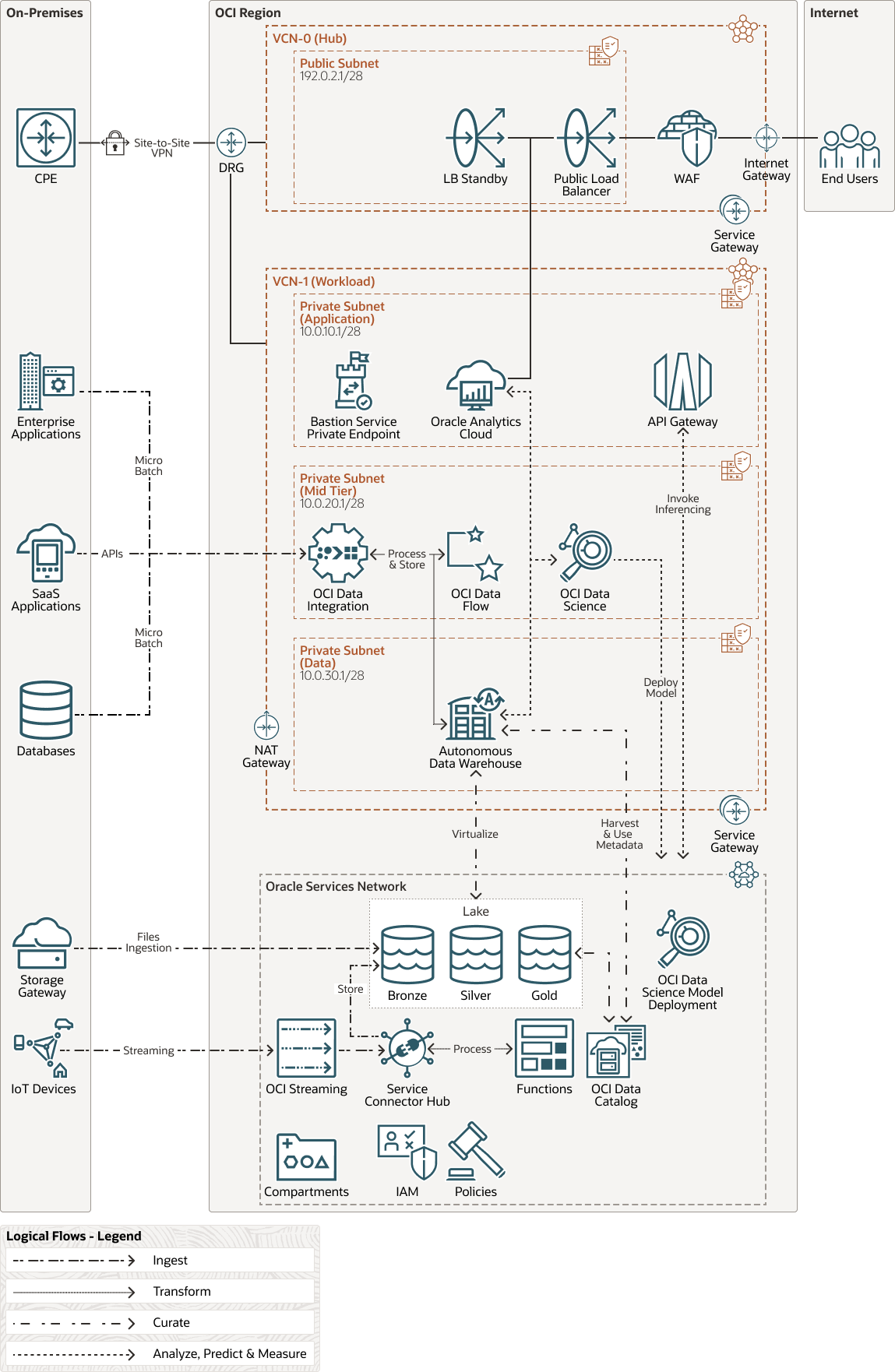

Physische Architektur

Die physische Architektur für dieses Data Lakehouse unterstützt Folgendes:

- Daten werden mithilfe von Microbatches, Streaming, APIs und Dateien aus relationalen und nicht relationalen Datenquellen sicher aufgenommen

- Die Daten werden mit einer Kombination aus Oracle Cloud Infrastructure Data Integration und Oracle Cloud Infrastructure Data Flow verarbeitet

- Die Daten werden in Oracle Autonomous Data Warehouse und Oracle Cloud Infrastructure Object Storage gespeichert und sind nach Qualität und Wert organisiert

- Oracle Autonomous Data Warehouse dient den Verbrauchern sicher für Warehouse- und Lake-Datenservices

- Oracle Analytics Cloud stellt Geschäftsbenutzern Daten mithilfe von Visualisierungen zur Verfügung

- Oracle Analytics Cloud wird mit Oracle Cloud Infrastructure Load Balancing bereitgestellt, das von Oracle Cloud Infrastructure Web Application Firewall (WAF) gesichert wird, um den Zugriff über das Internet zu ermöglichen

- Oracle Cloud Infrastructure Data Science wird zum Erstellen, Trainieren und Bereitstellen von ML-Modellen verwendet

- Mit Oracle Cloud Infrastructure API Gateway können Sie die Data Science-ML-Modell-Deployments steuern

- Oracle Cloud Infrastructure Data Catalog sammelt Metadaten aus Oracle Autonomous Data Warehouse und Objektspeicher

- Oracle Data Safe wertet Risiken für Daten aus, implementiert und überwacht Sicherheitskontrollen, bewertet die Benutzersicherheit, überwacht die Benutzeraktivität und erfüllt die Anforderungen an die Datensicherheitscompliance.

- Oracle Cloud Infrastructure Bastion wird von Administratoren zum Verwalten von Private Cloud-Ressourcen verwendet

Das folgende Diagramm veranschaulicht diese Referenzarchitektur.

Lakehouse-Architektur-oracle.zip

Das Design für die physische Architektur:

- Nutzt 2 VCNs, eines für Hub und eines für die Workload selbst

- On-Premises-Konnektivität nutzt sowohl Oracle Cloud Infrastructure FastConnect als auch Site-to-Site-VPN für Redundanz

- Der gesamte eingehende Traffic von On Premise und aus dem Internet wird zuerst an das Hub-VCN und dann an das Workload-VCN weitergeleitet

- Alle Daten sind während der Übertragung und im Ruhezustand sicher

- Services werden mit privaten Endpunkten bereitgestellt, um den Sicherheitsstatus zu erhöhen

- Das VCN ist in mehrere private Subnetze unterteilt, um den Sicherheitsstatus zu erhöhen

- Lake-Daten werden im Objektspeicher mithilfe einer Medaillonarchitektur in mehrere Buckets getrennt

Potenzielle Designverbesserungen, die in dieser Bereitstellung aus Gründen der Einfachheit nicht dargestellt werden, umfassen:

- Nutzung einer vollständigen CIS-konformen Landezone

- Nutzen Sie eine Netzwerkfirewall, um den allgemeinen Sicherheitsstatus zu verbessern, indem Sie den gesamten Traffic prüfen und Policys durchsetzen

Empfehlungen

Verwenden Sie die folgenden Empfehlungen als Ausgangspunkt für die Verarbeitung von Streamingdaten und eine breite Palette von Unternehmensdatenressourcen für Geschäftsanalysen und maschinelles Lernen.

Ihre Anforderungen können von der hier beschriebenen Architektur abweichen.

- Oracle Autonomous Data Warehouse

Diese Architektur verwendet Oracle Autonomous Data Warehouse auf gemeinsam genutzter Infrastruktur.

- Aktivieren Sie Autoscaling, um den Datenbank-Workloads die dreifache Verarbeitungsleistung zu bieten.

- Ziehen Sie die Verwendung von Oracle Autonomous Data Warehouse auf einer dedizierten Infrastruktur in Betracht, wenn Sie die Selfservice-Datenbankfunktion in einer privaten Datenbank-Cloud-Umgebung wünschen, die in der Public Cloud ausgeführt wird.

- Ziehen Sie die Verwendung des Features für hybride partitionierte Tabellen von Autonomous Data Warehouse in Betracht, um Datenpartitionen in Oracle Cloud Infrastructure Object Storage zu verschieben und sie transparent für Benutzer und Anwendungen bereitzustellen. Wir empfehlen, dieses Feature für Daten zu verwenden, die nicht häufig genutzt werden und für die Sie nicht die gleiche Performance benötigen wie für Daten, die in Autonomous Data Warehouse gespeichert sind.

- Verwenden Sie das Feature für externe Tabellen, um in Oracle Cloud Infrastructure Object Storage gespeicherte Daten in Echtzeit zu nutzen, ohne sie in Autonomous Data Warehouse replizieren zu müssen. Mit dieser Funktion werden Datasets, die außerhalb von Autonomous Data Warehouse kuratiert wurden, unabhängig vom Format (Parquet, Avro, Orc, Json, CSV usw.) transparent und nahtlos mit Daten verknüpft, die sich in Autonomous Data Warehouse befinden.

- Ziehen Sie die Verwendung des Datenbank-In-Memory-Features in Betracht, um die Performance für Echtzeitanalysen und gemischte Workloads erheblich zu verbessern. Laden Sie Lakehouse-Daten in den Speicher, der mit geringer Latenz bedient werden muss und sich in internen, hybriden partitionierten oder externen ADW-Tabellen befindet.

- Ziehen Sie die Verwendung von Autonomous Data Lake Accelerator in Betracht, wenn Sie Objektspeicherdaten verwenden, um Benutzern, die Daten zwischen dem Data Warehouse und dem Data Lake konsumieren und verbinden, eine verbesserte und schnellere Erfahrung zu bieten.

- Ziehen Sie in Betracht, Vektoreinbettungen in Autonomous Data Warehouse zusammen mit anderen Datentypen wie relationalen Daten oder JSON-Daten zu speichern, um das Data Engineering und die Analyse aller Daten zu vereinfachen und RAG-Agents effizient mit allen Daten zu erden.

- Verwenden Sie Select AI als Beschleuniger, um einfaches und komplexes SQL zu erstellen, das in Data Engineering, Business Intelligence, Anwendungsentwicklung oder jeder Aufgabe verwendet werden kann, für die SQL erstellt werden muss.

- Ziehen Sie die Verwendung von Select AI mit Low-Code-Anwendungen in Betracht, um die Anwendungsschicht weiter zu vereinfachen.

- Verwenden Sie Analyse-Views, um das zugrunde liegende DW-Star- oder Snowflake-Schema direkt in ADW semantisch zu modellieren, sodass granulare Daten automatisch aggregiert werden, ohne dass sie vorab aggregiert werden müssen. Das semantische Modell wird konsumiert, indem SQL konsistent mit jedem SQL-konformen Client, einschließlich Oracle Analytics Cloud, verwendet wird, um Fakten und KPIs sicherzustellen werden unabhängig vom Client konsistent bedient, und alle Daten können im semantischen Modell verwendet werden, unabhängig davon, ob sie in ADW oder Object Storage gespeichert sind. Dies macht dieses Feature zu einer perfekten semantischen Modellierungsschicht für eine Lakehouse-Architektur, bei der Fakten und Dimensionen sowohl den DW als auch den Lake durchlaufen können.

- Erwägen Sie, vom Kunden verwaltete Schlüssel zu verwenden, indem Sie den Vault-Service nutzen, wenn aufgrund von Unternehmens- oder Regulierungsrichtlinien eine vollständige Kontrolle über ADW-Verschlüsselungsschlüssel erforderlich ist.

- Ziehen Sie die Verwendung von Database Vault in ADW in Betracht, um zu verhindern, dass nicht autorisierte privilegierte Benutzer auf vertrauliche Daten zugreifen und so Datenexfiltration und Datenschutzverletzungen verhindern.

- Ziehen Sie die Verwendung von Autonomous Data Guard in Betracht, um einen Business Continuity-Plan zu unterstützen, indem Sie Daten auf einer Standbyinstanz entweder in derselben Region oder in einer anderen Region einrichten und replizieren lassen.

- Ziehen Sie die Verwendung der dynamischen Datenmaskierung mit Datenverdeckung in Betracht, um Benutzern maskierte Daten je nach ihrer Rolle bereitzustellen und somit einen angemessenen Datenzugriff zu gewährleisten, ohne dass Datenduplizierung und statische Maskierung erforderlich sind.

- Ziehen Sie die Verwendung von ADW-Klonen in Betracht, um schnell andere transiente oder nicht transiente Umgebungen zu erstellen. Verwenden Sie aktualisierbare Klone, wenn die Zielumgebung über aktuelle Daten verfügen muss. Mit Oracle Data Safe können Sie sensible Daten in den Klonen statisch maskieren, um die Sicherheit zu erhöhen.

- Ziehen Sie die Verwendung von Data Sharing als sichere und einfache Möglichkeit in Betracht, Daten zu konsumieren und bereitzustellen, entweder mit anderen Autonomous Database-Instanzen oder mit jeder Delta Sharing-konformen Technologie.

- Sie sollten Live-Datenfreigabe zwischen Autonomous Database-Instanzen verwenden, um Daten in Echtzeit zu nutzen und bereitzustellen.

- Verwenden Sie die versionierte Datenfreigabe, um Daten mit Verbrauchern zu teilen. Dies vermeidet die Kosten für die Abfrage der Daten, da Daten von Verbrauchern und nicht vom Anbieter verarbeitet werden.

- Verwenden Sie im Voraus authentifizierte Anforderungs-URLs für den schreibgeschützten, zeitgebundenen Datenzugriff auf ADW, um die gemeinsame Nutzung nicht sensibler Daten für Anwendungsfälle zu ermöglichen, in denen der Consumer die Delta-Freigabe nicht unterstützt.

- Objektspeicher/Data Lake

Diese Architektur verwendet Oracle Cloud Infrastructure Object Storage, einen hoch skalierbaren und dauerhaften Cloud-Speicher, als Lake-Speicher.

- Ziehen Sie in Betracht, Ihren See über verschiedene Buckets hinweg zu organisieren, indem Sie eine Medaillonarchitektur (Bronze, Silber, Gold) oder eine andere Partitionierungslogik nutzen, um Daten basierend auf ihrer Qualität und Anreicherung zu trennen, feingranulierte Sicherheit für Verbraucher durchzusetzen, die Daten lesen, und verschiedene Lebenszyklusverwaltungsrichtlinien auf die verschiedenen Ebenen anzuwenden.

- Ziehen Sie die Verwendung verschiedener Objektspeicherebenen und Lebenszyklus-Policys in Betracht, um die Kosten für die skalierbare Speicherung von Lake-Daten zu optimieren.

- Ziehen Sie in Betracht, vom Kunden verwaltete Schlüssel zu verwenden, indem Sie den Vault-Service nutzen, wenn aufgrund von Unternehmens- oder Regulierungsrichtlinien eine vollständige Kontrolle über Object Storage-Verschlüsselungsschlüssel erforderlich ist.

- Ziehen Sie die Verwendung der Objektspeicherreplikation in Betracht, um einen Business Continuity-Plan zu unterstützen, indem Sie die Bucket-Replikation in einer anderen Region einrichten. Da Object Storage extrem langlebig ist und mehrere Kopien desselben Objekts in einer einzelnen Region verwaltet, ist keine Replikation für das Recovery in demselben Regions-Bucket erforderlich.

- Ziehen Sie die Verwendung von Oracle Cloud Infrastructure Identity and Access Management-(IAM-)Policys für Objekte in Betracht, indem Sie Objektnamen oder Muster verwenden, um die Datensicherheit für direkte Data Lake-Zugriffe zu erhöhen.

- Verwenden Sie private Endpunkte in Oracle Cloud Infrastructure Object Storage, um einen sicheren und privaten Zugriff auf den Data Lake vom VCN der Datenplattform sicherzustellen.

- Verwenden Sie Netzwerkquellen und IAM-Policys, um sie zu referenzieren und die IP-Adressen zu verwalten, die für den Zugriff auf die Data Lake-Buckets und -Objekte autorisiert sind.

- Verwenden Sie OCIFS, ein python-basiertes Utility, um Oracle Cloud Infrastructure Object Storage-Buckets als Dateisysteme zu mounten. So können Sie Anwendungen unterstützen, die nur mit NFS funktionieren und Dateien in den Objektspeicher hochladen müssen.

- Oracle Machine Learning und Oracle Cloud Infrastructure Data Science

Diese Architektur nutzt Oracle Machine Learning und Oracle Cloud Infrastructure Data Science, um Vorhersagen für Personen und Anwendungen in Echtzeit auszuführen und bereitzustellen.

- Ziehen Sie in Betracht, AutoML in OCI Data Science oder Oracle Machine Learning zu verwenden, um die ML-Modellentwicklung zu beschleunigen.

- Erwägen Sie die Verwendung von Open Neural Networks Exchange (ONNX) für Interoperabilität. ONNX 3rd-Party-Modelle können entweder in OML bereitgestellt und als REST-Endpunkt oder in OCI Data Science bereitgestellt und als HTTP-Endpunkt angegeben werden.

- Ziehen Sie in Betracht, das Modell in OCI Data Science als ONNX zu speichern und es in OCI GoldenGate Stream Analytics zu importieren, wenn Scoring und Vorhersage in einer Echtzeit-Datenpipeline ausgeführt werden müssen, um zeitnahere Vorhersagen zu erhalten, die Geschäftsergebnisse in Echtzeit fördern können.

- Ziehen Sie die Verwendung von OCI Data Science-Conda-Umgebungen in Betracht, um Python-Abhängigkeiten in Jupyter-Notizbuchsessions besser zu verwalten und zu verpacken. Nutzen Sie das von Anaconda kuratierte Repository von Packages in OCI Data Science, um Ihre bevorzugten Open-Source-Tools zum Erstellen, Trainieren und Bereitstellen von Modellen zu verwenden.

- Ziehen Sie die Verwendung von Oracle Cloud Infrastructure Data Science KI-Schnellaktionen in Betracht, um Basismodelle in OCI Data Science bereitzustellen, zu bewerten und zu optimieren. Arbeiten Sie mit kuratierten Open-Source-LLMs, die im Modell-Explorer verfügbar sind, oder bringen Sie Ihr eigenes Modell mit.

- Ziehen Sie die Verwendung von Data Science-KI-Operatoren mit geringem Code in Betracht, die im Accelerated Data Science-Python-Package verfügbar sind, um Prognosen, Anomalieerkennung oder Empfehlungsfunktionalität schnell und effizient auszuführen.

- Ziehen Sie die Verwendung von OCI Data Flow in der Data Science-Jupyter-Umgebung in Betracht, um eine explorative Datenanalyse, Datenprofilerstellung und Datenvorbereitung in großem Maßstab durchzuführen, indem Sie die Spark-Skalierungsverarbeitung nutzen.

- Ziehen Sie die Verwendung von Data Labeling in Betracht, um Daten wie Bilder, Text oder Dokumente zu labeln, und verwenden Sie sie, um ML-Modelle zu trainieren, die auf OCI Data Science oder OCI AI Services basieren, und damit die Genauigkeit von Vorhersagen zu verbessern.

- Sie sollten ein API-Gateway bereitstellen, um die Nutzung des bereitgestellten Modells zu sichern und zu steuern, wenn Echtzeitvorhersagen von Partnern und externen Entitäten verwendet werden.

- Oracle Cloud Infrastructure Data Integration

Diese Architektur unterstützt mit Oracle Cloud Infrastructure Data Integration deklarative ETL- und Datenpipelineentwicklung ohne Code oder Low-Code.

- Mit Oracle Cloud Infrastructure Data Integration können Sie die Ausführungen der Oracle Cloud Infrastructure Data Flow-Anwendung koordinieren und planen und deklaratives ETL mit benutzerdefinierter Spark-Codelogik mischen und abgleichen. Verwenden Sie Funktionen aus Oracle Cloud Infrastructure Data Integration, um die Funktionen von Datenpipelines weiter zu erweitern.

- Ziehen Sie die Verwendung von SQL-Pushdowns für Transformationen in Betracht, bei denen ADW als Ziel verwendet wird, um einen ELT-Ansatz zu verwenden, der im Vergleich zu ETL effizienter, performanter und sicherer ist.

- Erwägen Sie, OCI Data Integration die Verarbeitung von Datenquellenschemadifferenzen zu ermöglichen, um resilientere und zukunftssichere Datenpipelines zu erhalten, die Datenquellenschemaänderungen aufrechterhalten.

- Oracle Cloud Infrastructure Data Flow

Diese Architektur unterstützt mit Oracle Cloud Infrastructure Data Flow die groß angelegte Spark- und Spark-Streamingverarbeitung, ohne dass permanente Cluster vorhanden und verwaltet werden müssen.

- Ziehen Sie die Verwendung von Oracle Cloud Infrastructure Data Catalog als Hive-Metastore für Oracle Cloud Infrastructure Data Flow in Betracht, um Schemadefinitionen für Objekte in unstrukturierten und halbstrukturierten Datenassets wie Oracle Cloud Infrastructure Object Storage sicher zu speichern und abzurufen.

- Ziehen Sie die Verwendung von Delta Lake in OCI Data Flow in Betracht, wenn ACID-Transaktionen und die Vereinheitlichung von Streaming- und Batchverarbeitung für Lake-Daten erforderlich sind.

- Big Data Service

Diese Architektur nutzt Oracle Cloud Infrastructure Big Data Service, um hochverfügbare und skalierbare Cluster verschiedener Open-Source-Technologien wie Spark, Hadoop, Trino oder Flink bereitzustellen, die Batch- und Streamingdaten verarbeiten können. Big Data Service persistiert Daten in HDFS, persistiert und liest Daten aus Oracle Cloud Infrastructure Object Storage und kann Datasets mit anderen Oracle Cloud Infrastructure-Services wie Oracle Cloud Infrastructure Data Flow und Oracle Autonomous Data Warehouse austauschen.

- Ziehen Sie die Verwendung von Autoscaling in Betracht, um die Worker-Knoten basierend auf Metriken oder Zeitplan automatisch horizontal oder vertikal zu skalieren, um die Kosten basierend auf dem Ressourcenbedarf kontinuierlich zu optimieren.

- Ziehen Sie in Betracht, den OCI-HDFS-Connector für Object Storage zum Lesen und Schreiben von Daten in und aus Object Storage zu verwenden, um so einen Mechanismus zum Erstellen/Verbrauchen von Daten bereitzustellen, die mit anderen OCI-Services gemeinsam verwendet werden, ohne dass sie repliziert und dupliziert werden müssen.

- Ziehen Sie die Verwendung von Delta Lake auf OCI BDS in Betracht, wenn ACID-Transaktionen und die Vereinheitlichung von Streaming- und Batchverarbeitung für Lake-Daten erforderlich sind.

- Wenn Sie andere Open-Source-Software verwenden müssen, sollten Sie Oracle Cloud Infrastructure Registry, Containerinstanzen oder die Oracle Cloud Infrastructure Kubernetes Engine verwenden, um Open-Source-Software bereitzustellen, die containerisiert werden kann.

- Oracle Cloud Infrastructure-Streaming

Diese Architektur nutzt Oracle Cloud Infrastructure Streaming, um Streamingdaten aus Quellen zu konsumieren und Verbrauchern Streamingdaten bereitzustellen.

Nutzen Sie den Oracle Cloud Infrastructure Service Connector Hub, um Daten aus Oracle Cloud Infrastructure Streaming zu verschieben und in Oracle Cloud Infrastructure Object Storage zu persistieren, um weitere historische Datenanalysen zu unterstützen.

- Oracle Analytics Cloud

Diese Architektur nutzt Oracle Analytics Cloud (OAC), um Endbenutzern erweiterte Analysen bereitzustellen.

Ziehen Sie in Betracht, die vordefinierte Integration von OAC mit OCI AI Services (Language and Vision Models) und OML (beliebiges Modell) zu nutzen, um Informationen in Datenflüsse und Visualisierungen einzubetten, die Endbenutzer konsumieren, und um so den KI- und ML-Verbrauch zu demokratisieren.

- Oracle Cloud Infrastructure-KI-Services

Diese Architektur kann Oracle Cloud Infrastructure-KI-Services je nach bereitgestellten Anwendungsfällen nutzen.

Ziehen Sie die Verwendung von Data Labeling in Betracht, um Trainingsdaten zu kennzeichnen, die verwendet werden, um genauere Vorhersagen für KI-Services wie Vision, Document Understanding und Language zu erhalten.

- Oracle Cloud Infrastructure Generative AI-Services

Diese Architektur kann Oracle Cloud Infrastructure Generative AI-Services je nach bereitgestellten Anwendungsfällen nutzen.

- Erwägen Sie die Verwendung des On-Demand-Spielplatzes und der APIs, die vortrainierte LLMs verwenden, um Textgenerierung, Unterhaltung, Datenextraktion, Zusammenfassung, Klassifizierung, Stiltransfer oder semantische Ähnlichkeit zu adressieren und generative KI schnell in Ihre Pipelines und Prozesse einzubetten.

- Ziehen Sie die Verwendung dedizierter KI-Cluster in Betracht, um grundlegende LLMs effizient an Ihre Daten anzupassen und anzupassen, um vollständige Isolation und Datensicherheit zu gewährleisten.

- Ziehen Sie die gemeinsame Nutzung dedizierter KI-Cluster innerhalb verschiedener Teams im gesamten Unternehmen in Betracht, um die Kosteneffizienz zu gewährleisten. Mit einem einzelnen Cluster können mehrere benutzerdefinierte Modelle gehostet werden, die alle mit unabhängigen Endpunkten bedient werden können und mit dedizierten IAM-Policys gesichert werden können.

- API Gateway

Diese Architektur nutzt API Gateway, um Daten-Services und Echtzeit-Inferenzen für Daten-Consumer sicher bereitzustellen.

- Ziehen Sie die Verwendung von Oracle Cloud Infrastructure Functions in Betracht, um eventuell erforderliche Laufzeitlogik hinzuzufügen, um bestimmte API-Verarbeitungen zu unterstützen, die außerhalb des Geltungsbereichs der Datenverarbeitungs-, Zugriffs- und Interpretationsschichten liegen.

- Verwenden Sie Nutzungspläne, um den Abonnentenzugriff auf APIs zu verwalten, die API-Nutzung zu überwachen und zu verwalten, verschiedene Zugriffsebenen für verschiedene Verbraucher einzurichten und die Datenmonetarisierung zu unterstützen, indem Sie Nutzungsmetriken verfolgen, die einem externen Abrechnungssystem bereitgestellt werden können.

- Oracle Cloud Infrastructure Data Catalog

Um eine vollständige und ganzheitliche End-to-End-Ansicht der auf der Plattform gespeicherten und fließenden Daten zu erhalten, sollten Sie das Harvesting nicht nur für Datenspeicher in Betracht ziehen, die den Datenpersistenzlayer unterstützen, sondern auch für die Quelldatenspeicher. Durch die Zuordnung dieser durch Harvesting erstellten technischen Metadaten zum Geschäftsglossar und die Anreicherung mit benutzerdefinierten Eigenschaften können Sie Geschäftskonzepte zuordnen sowie Sicherheits- und Zugriffsdefinitionen dokumentieren und steuern.

- Um die Erstellung externer Oracle Autonomous Data Warehouse-Tabellen zu vereinfachen, in denen Daten virtualisiert werden, die in Oracle Cloud Infrastructure Object Storage gespeichert sind, verwenden Sie die Metadaten, für die zuvor ein Harvesting von Oracle Cloud Infrastructure Data Catalog ausgeführt wurde. Dies vereinfacht die Erstellung externer Tabellen, erzwingt die Konsistenz von Metadaten über Datenspeicher hinweg und ist weniger anfällig für menschliche Fehler.

- Sie sollten das Herkunfts-Tracking für Oracle Cloud Infrastructure Data Integration und Oracle Cloud Infrastructure Data Flow verwenden, um einen Überblick darüber zu erhalten, wie Daten aufgenommen, transformiert und gespeichert wurden. Um die Abdeckung zu erhöhen, verwenden Sie die API-basierte Aufnahme, um das offene Framework OpenLineage zu nutzen und die Herkunft für jede Quelle und jedes System zu verfolgen.

- Oracle Cloud Infrastructure-Datenübertragungsservice

Verwenden Sie Oracle Cloud Infrastructure Data Transfer Service, wenn der Upload von Daten über das öffentliche Internet nicht sinnvoll oder machbar ist. Wir empfehlen, Data Transfer zu verwenden, wenn das Hochladen von Daten über das öffentliche Internet länger als 1-2 Wochen dauert.

- Data Safe und Audit

Die Erhöhung der Sicherheitslage durch den Einsatz von Audit- und Warnfunktionen ermöglicht die Verhinderung der Datenexfiltration und die Durchführung von forensischen Analysen im Falle einer Datenverletzung.

- Sie sollten Oracle Data Safe verwenden, um Aktivitäten im Data Warehouse zu auditieren, und Oracle Cloud Infrastructure Audit verwenden, um den Traffic zu den Lake-Daten zu auditieren.

- Erwägen Sie die Verwendung von Oracle Data Safe für die Discovery sensibler Daten in ADW und die statische Maskierung bei der Erstellung von ADW-Klonen für Nicht-Produktionsumgebungen, um Sicherheitsrisiken zu vermeiden.

- Ziehen Sie in Betracht, die Oracle Data Safe SQL-Firewall mit ADW zu verwenden, um die Datensicherheit zu erhöhen und vor Risiken wie SQL-Injection-Angriffen oder gefährdeten Accounts zu schützen.

- Deployment und Automatisierung

Diese physische Architektur wird mithilfe der Infrastructure-as-Code-(IaC-)Automatisierung bereitgestellt, um die Ressourcen für das Deployment eines Data Lakehouse zu erstellen

Mit Oracle Cloud Infrastructure Resource Manager können Sie Terraform-Stacks mit bereitstellbaren Cloud-Ressourcen erstellen, Infrastrukturkonfigurationen teilen und verwalten sowie Dateien über mehrere Teams und Plattformen hinweg bereitstellen. Verwenden Sie Oracle Cloud Infrastructure Resource Manager, um Deployment-Stacks für die Erstellung von Nicht-Produktionsumgebungen zu erstellen, neue Teams einzubinden, die zusätzliche Services benötigen, und konsistente IAM-Policys und -Sicherheitsleitlinien zu standardisieren und einzubetten, die den Sicherheits- und Governance-definierten Policys des Unternehmens entsprechen.

- Geschäftskontinuität

Diese Architektur beschreibt ein Deployment in einer einzelnen Region und kann zwei Regionen erweitern, um die Disaster Recovery zu unterstützen und einen Business Continuity-Plan zu ermöglichen.

- Oracle Cloud Infrastructure Full Stack Disaster Recovery Service ist ein Disaster-Recovery-Orchestrierungs- und -Managementservice, der umfassende Disaster-Recovery-Funktionen für alle Layer eines Anwendungsstacks bereitstellt, einschließlich Infrastruktur, Middleware, Datenbank und Anwendung.

Ziehen Sie die Verwendung von Full Stack Disaster Recovery in Betracht, um Switchover- und Failover-Pläne für das Data Lakehouse einzurichten, um Disaster Recovery-Aufgaben zu automatisieren und manuelle Schritte bei einem geplanten oder ungeplanten Übergang in die Standbyregion zu reduzieren.

- Kostenoptimierung

Ziehen Sie die Verwendung von Kosten- und Nutzungsverfolgungsfunktionen von Oracle Cloud Infrastructure sowie Kostenoptimierungsfeatures in Betracht, um Ihre Finanzabläufe kontinuierlich zu unterstützen.

- Ziehen Sie in Betracht, Kosten- und Nutzungsberichte zu verwenden, um die Nutzung von Cloud-Ressourcen und die entsprechenden Kosten zu ermitteln und zu verfolgen. Nutzen Sie branchenübliche FOCUS CSV-Kostenberichte, die für die Integration mit 3rd Party Financial Operations-Lösungen erstellt werden.

- Ziehen Sie die Verwendung von Kostenanalysen in Betracht, um Kosten zu verfolgen, die von verschiedenen Teams, Projekten und Umgebungen angefallen sind.

- Ziehen Sie die Verwendung von Kostenverfolgungstags in Betracht, um Cloud-Ressourcen für bestimmte Teams, Projekte oder Umgebungen zu taggen.

- Verwenden Sie Budgets, um flexible Ausgabenlimits festzulegen, und legen Sie Alerts fest, um zu erfahren, wann Sie Ihr Budget für Projekt-, Team- oder Gesamtausgaben überschreiten können.

- Interoperabilität

Diese Architektur nutzt ausgiebige Industriestandards, um mit der breiteren heterogenen IT-Landschaft jedes Unternehmens zu interagieren, sodass sie alle Daten für jede Anwendung, jedes System oder jede Person konsumieren und bereitstellen kann.

Die Architektur unterstützt offene Dateiformate wie Parquet oder Avro, sodass Daten in dem für jeden Anwendungsfall geeigneteren Format gespeichert werden können. Darüber hinaus unterstützt es offene Tabellenformate wie Iceberg und Delta Lake, um die Interoperabilität zwischen Oracle-Technologien und anderen 3rd-Party-Technologien sicherzustellen.- Ziehen Sie in Betracht, die Oracle Autonomous Data Warehouse Iceberg-Unterstützung zu verwenden, um Iceberg-Tabellen zu lesen, die auf dem Data Lake persistiert sind, und sie für Verbraucher zu verwenden. Eisbergtische können entweder als externe Tische serviert oder in ADW geladen werden.

- Ziehen Sie die Verwendung der Data Flow Delta Lake Universal Format-Unterstützung in Betracht, um Daten im Data Lake zu lesen, zu verarbeiten und zu persistieren. Die Verwendung von Delta Lake bei der Generierung von Metadaten für andere offene Tabellenformate wie Iceberg und Hudi ermöglicht es verschiedenen Verarbeitungs-Engines, dieselben Daten zu lesen.

- Organisationsansatz

Diese Architektur ist flexibel und kann verschiedene Arten von Organisationsansätzen unterstützen, die von einem zentralisierten bis hin zu einem vollständig dezentralen Ansatz reichen und somit von jeder Organisation übernommen und verwendet werden können, die Wert aus ihren Daten gewinnen möchte.

Diese Architektur nutzt ausgiebig fein granulierte Steuerelemente für die Authentifizierung und Autorisierung mit OCI Identity and Access Management (IAM).

Ziehen Sie die Verwendung von IAM in Betracht, um die verschiedenen Geschäftsbereiche und Teams zu trennen, indem Sie das Lakehouse verwenden, um das Eigentum an der Erstellung von Datenprodukten zu dezentralisieren und die Trennung von Datendomänen durchzusetzen, wenn Ihr Unternehmen einen dezentralen Organisationsansatz verfolgen möchte.

OCI verfügt über Funktionen für Automatisierung und Infrastructure-as-Code als Schlüssel für ein erfolgreiches Architektur-Deployment und nutzt Frameworks wie Terraform und Ansible.

Wenn Ihr Unternehmen einen dezentralen Ansatz verfolgt und Datendomänen unter diesem Ansatz implementiert, sollten Sie vordefinierte Terraform-Vorlagen und OCI Resource Manager nutzen, um Datendomänen schnell und konsistent in die Datenplattform einzubinden.

Hinweise

Berücksichtigen Sie bei der Erfassung, Verarbeitung und Kuratierung von Anwendungsdaten für Analysen und maschinelles Lernen die folgenden Implementierungsoptionen.

| Hinweise | Empfohlen | Andere Optionen | Begründung |

|---|---|---|---|

| Datenraffinerie |

|

|

Oracle Cloud Infrastructure Data Integration bietet eine Cloud-native, serverlose, vollständig verwaltete ETL-Plattform, die skalierbar und kosteneffizient ist. Oracle Cloud Infrastructure GoldenGate bietet eine Cloud-native, serverlose, vollständig verwaltete, nicht aufdringliche Datenreplikationsplattform, die skalierbar, kosteneffizient ist und in hybriden Umgebungen bereitgestellt werden kann. |

| Datenpersistenz |

|

Oracle Exadata Database Service |

Oracle Autonomous Data Warehouse ist eine einfache, vollständig autonome Datenbank, die elastisch skalierbar ist, schnelle Abfrageperformance liefert und keine Datenbankadministration erfordert. Außerdem bietet es direkten Zugriff auf die Daten aus externen oder hybriden partitionierten Objektspeichertabellen. Oracle Cloud Infrastructure Object Storage speichert unbegrenzte Daten im Raw-Format. |

| Datenverarbeitung |

|

Drittanbietertools |

Oracle Cloud Infrastructure Data Integration bietet eine Cloud-native, serverlose, vollständig verwaltete ETL-Plattform, die skalierbar und kostengünstig ist. Oracle Cloud Infrastructure Data Flow bietet eine serverlose Spark-Umgebung zur skalierbaren Verarbeitung von Daten mit einem nutzungsabhängigen, extrem elastischen Modell. Oracle Cloud Infrastructure Big Data Service stellt Hadoop-as-a-Service der Enterprise-Klasse mit End-to-End-Sicherheit, hoher Performance sowie einfacher Verwaltung und Upgradefähigkeit bereit. |

| Zugriff und Interpretation |

|

Drittanbietertools |

Oracle Analytics Cloud ist vollständig verwaltet und eng in die kuratierten Daten in Oracle Autonomous Data Warehouse integriert. Data Science ist eine vollständig verwaltete Selfservice-Plattform, auf der Data Science-Teams Modelle für maschinelles Lernen (ML) in Oracle Cloud Infrastructure erstellen, trainieren und verwalten können. Der Data Science-Service stellt Infrastruktur- und Data Science-Tools wie AutoML und Modell-Deployment-Funktionen bereit. Oracle Machine Learning ist eine vollständig verwaltete Selfserviceplattform für Data Science, die mit Oracle Autonomous Data Warehouse verfügbar ist und die Verarbeitungsleistung des Warehouse nutzt, um ML-Modelle in großem Maßstab zu erstellen, zu trainieren, zu testen und bereitzustellen, ohne die Daten außerhalb des Warehouse verschieben zu müssen. Oracle Cloud Infrastructure-KI-Services sind eine Reihe von Services, die vordefinierte Modelle bereitstellen, die speziell entwickelt und trainiert wurden, um Aufgaben wie das Inferenzieren potenzieller Anomalien oder das Erkennen von Stimmungen auszuführen. |

Stellen Sie

- Mit Oracle Cloud Infrastructure Resource Manager bereitstellen:

- Klicken Sie auf .

Wenn Sie noch nicht angemeldet sind, geben Sie den Mandanten und die Benutzerzugangsdaten ein.

- Prüfen und akzeptieren Sie die Vertragsbedingungen.

- Wählen Sie die Region aus, in der der Stack bereitgestellt werden soll.

- Befolgen Sie die Anweisungen und Anweisungen zum Erstellen des Stacks auf dem Bildschirm.

- Nachdem Sie den Stack erstellt haben, klicken Sie auf Terraform-Aktionen, und wählen Sie Planen aus.

- Warten Sie, bis der Job abgeschlossen ist, und prüfen Sie den Plan.

Um Änderungen vorzunehmen, kehren Sie zur Seite "Stackdetails" zurück, klicken Sie auf Stack bearbeiten, und nehmen Sie die erforderlichen Änderungen vor. Führen Sie dann die Aktion Planen erneut aus.

- Wenn keine weiteren Änderungen erforderlich sind, kehren Sie zur Seite "Stackdetails" zurück, klicken Sie auf Terraform-Aktionen, und wählen Sie Anwenden aus.

- Klicken Sie auf .

- Mit der Terraform-CLI bereitstellen:

- Gehen Sie zu GitHub.

- Klonen Sie das Repository, oder laden Sie es auf Ihren lokalen Rechner herunter.

- Befolgen Sie die Anweisungen im Dokument

README.

Mehr erfahren

Erfahren Sie mehr über die Features dieser Architektur und die zugehörigen Architekturen.

Danksagungen

- Author: José Cruz

- Contributors: Larry Fumagalli, Ionel Panaitescu, Mike Blackmore, Robert Lies

Änderungslog

In diesem Log werden wichtige Änderungen aufgeführt:

| 28. Oktober 2024 |

|

| Juni 21, 2023 |

|