Fabrication de données

En tant que développeur unique, il peut être difficile, voire impossible, pour vous de créer un ensemble important et diversifié de variations, en particulier lorsque vous devez fournir des données d'entraînement pour plusieurs intentions ou entités d'apprentissage automatique. Plutôt que d'essayer d'obtenir des données d'entraînement par vous-même, vous pouvez utiliser Oracle Digital Assistant pour externaliser cette tâche en crowdsourcing. L'affectation d'une telle tâche à des crowdworkers peut s'avérer particulièrement utile lorsque vous avez besoin de variations que seuls des experts de l'application ou du domaine peuvent fournir.

Qu'est-ce qu'un travail de fabrication de données ?

Les travaux de fabrication de données sont des ensembles de tâches affectées aux crowdworkers. Les tâches elles-mêmes se concentrent sur diverses façons d'améliorer les intentions et les entités d'apprentissage automatique.

Travaux d'annotation

Vous pouvez affecter un travail d'annotation lorsque vous disposez de données de journalisation à classer dans une intention, ou lorsqu'une intention spécifique est trop vaste et doit être divisée en plusieurs intentions distinctes. Vous pouvez également affecter des crowdworkers pour annoter les mots clés et les expressions des données d'entraînement qui se rapportent à une entité ML.

Travaux de validation

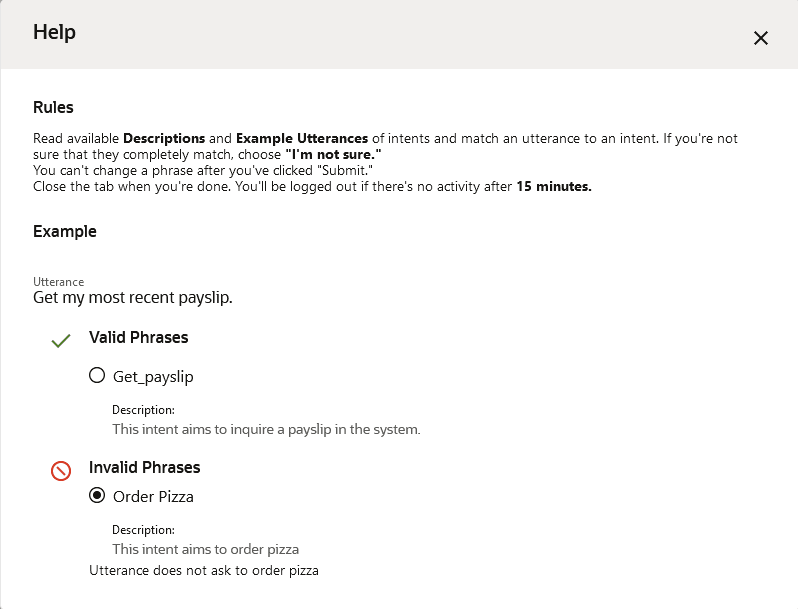

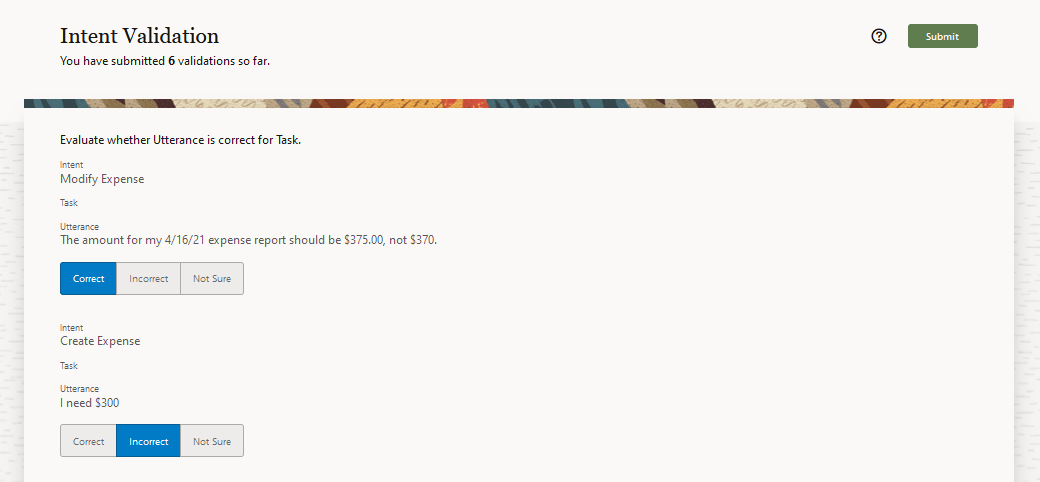

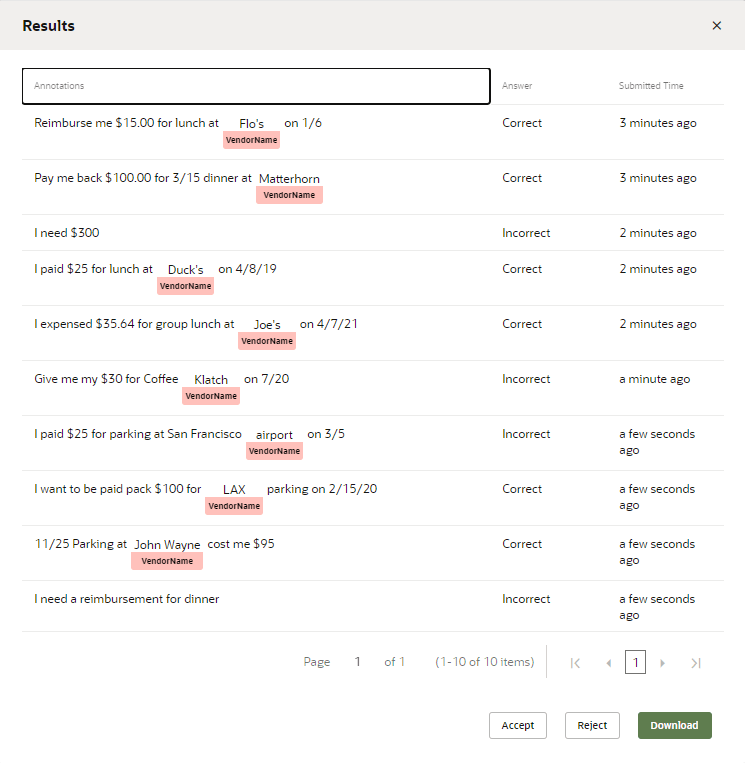

Pour les travaux de validation, les crowdworkers examinent les variations pour déterminer si elles correspondent à la tâche ou à l'action décrite par l'intention, ou si l'entité d'apprentissage automatique correcte a été identifiée. Seules les variations jugées valides par les crowdworkers sont ajoutées aux données d'entraînement.

Workflow du travail de fabrication de données

Pour créer un travail de fabrication de données, vous devez d'abord créer un travail et surveiller sa progression. Si vous voulez accéder aux données avant la fin officielle du travail (par exemple, si les crowdworkers n'interviennent plus sur le travail), vous pouvez annuler le travail. Enfin, examinez les résultats avant de les ajouter aux données d'entraînement en les acceptant, ou de les exclure des données d'entraînement en les rejetant.

Création du travail

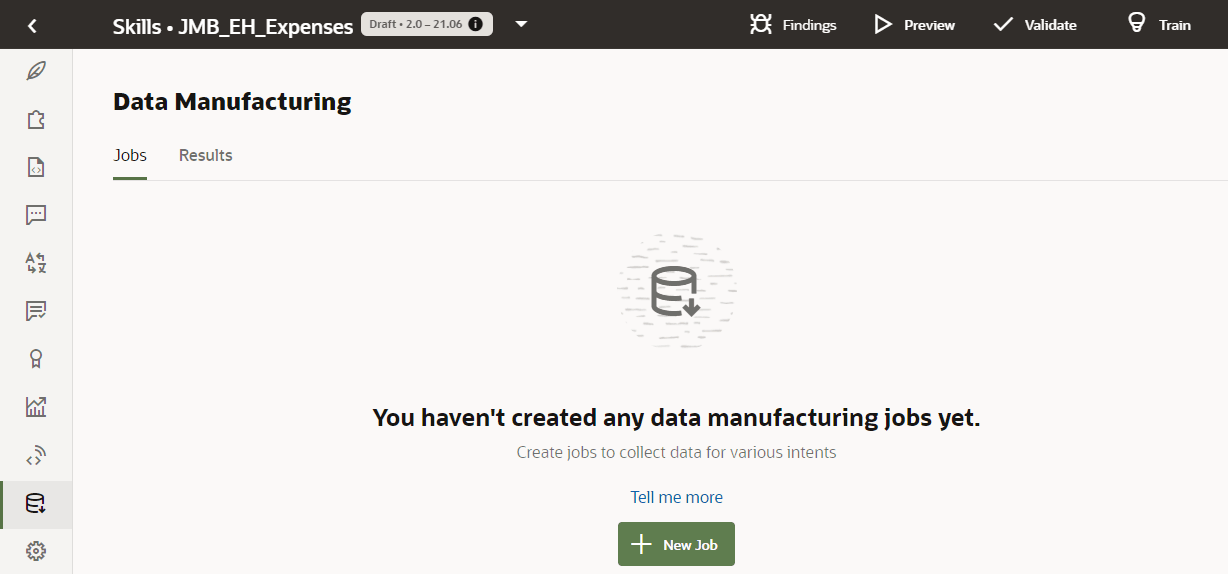

- Cliquez sur Fabrication

dans la barre de navigation de gauche.

dans la barre de navigation de gauche.

- Sur la page Travaux, cliquez sur Ajouter un travail.

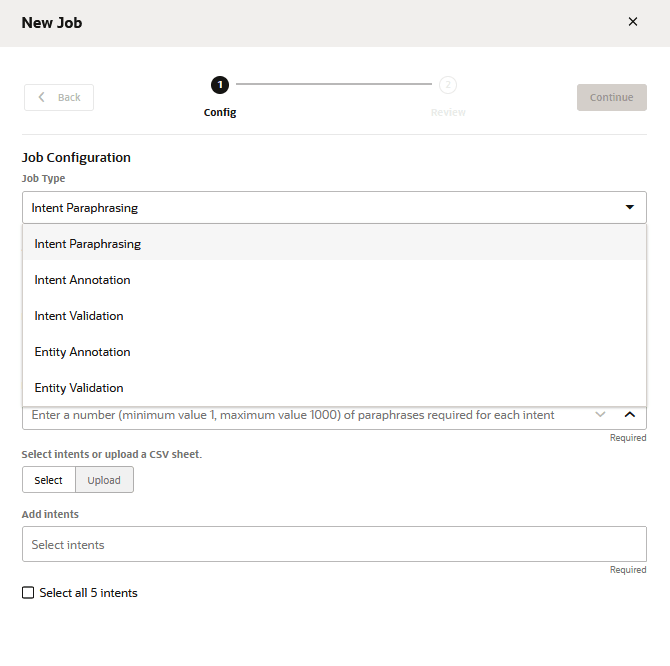

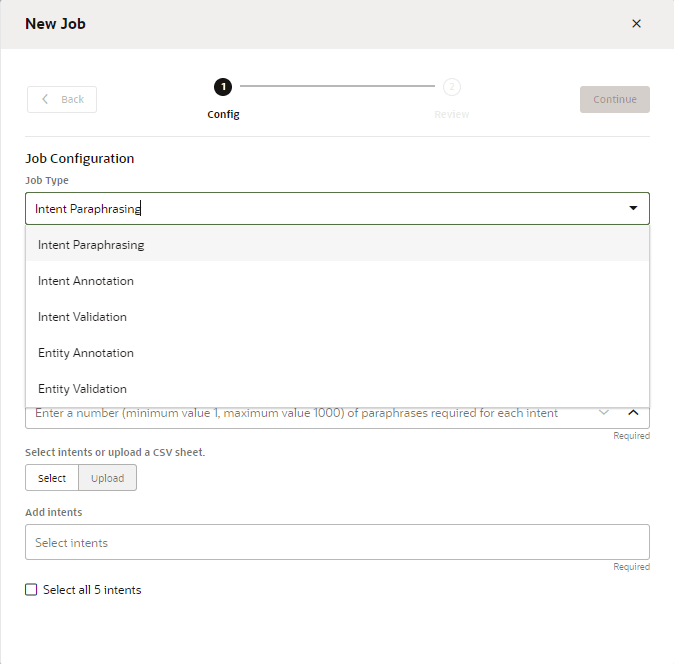

- Sélectionnez le type de travail (Paraphrase, Validation ou Annotation).

- Sélectionnez la langue utilisée par les crowdworkers. La langue par défaut est la langue prédominante de la brique, mais vous pouvez en choisir une parmi les autres langues prises en charge de façon native. Vous ne pouvez toutefois pas choisir une langue activée par un service de traduction.

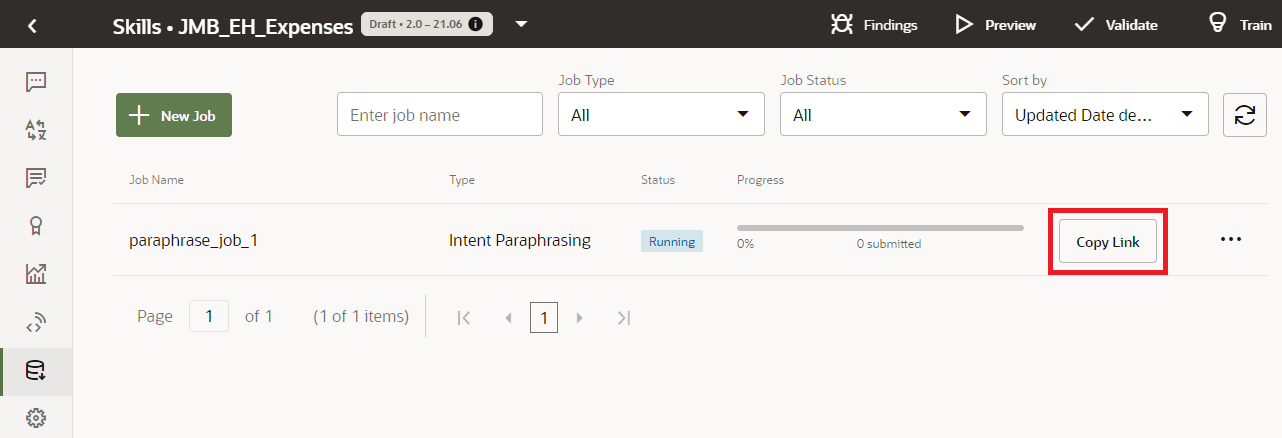

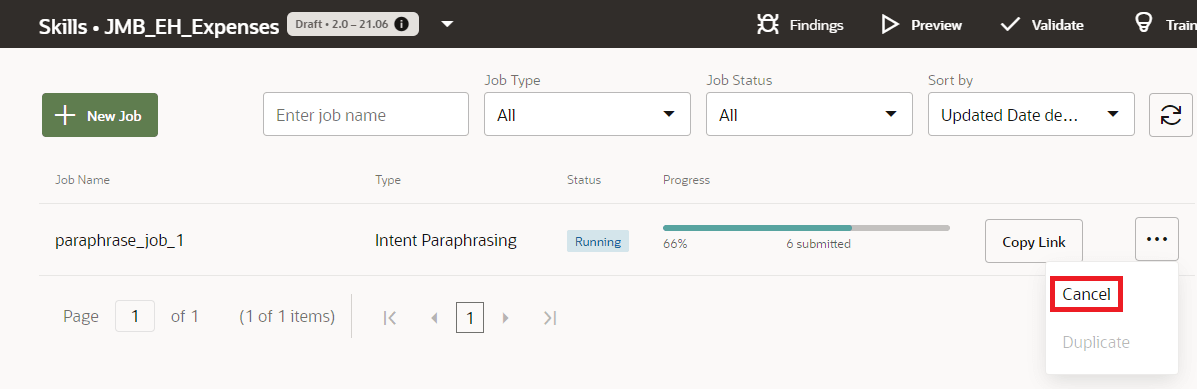

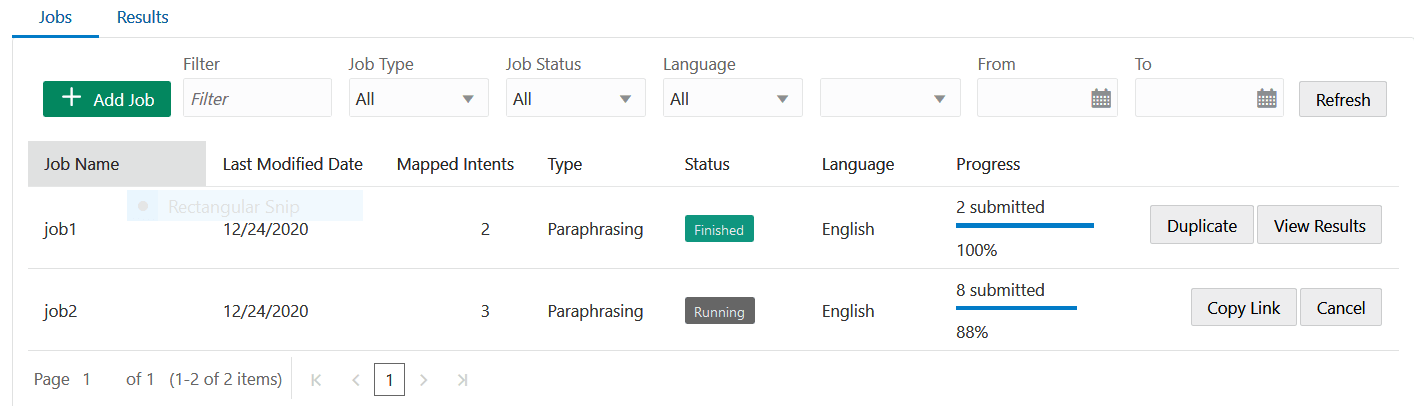

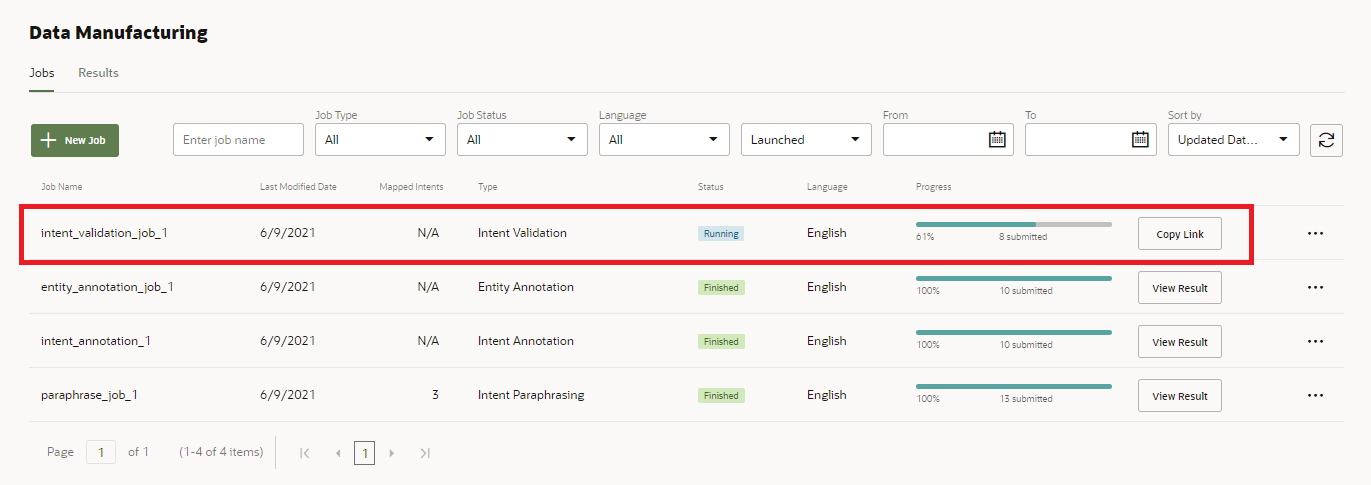

- Cliquez sur Lancer. Une fois le travail lancé, son statut est En cours d'exécution sur la page Travaux. Vous ne pouvez pas modifier un travail lorsqu'il est en cours d'exécution. Si vous devez effectuer une modification, vous devez d'abord annuler le travail, le dupliquer, puis le modifier avant de le relancer.

- Pour envoyer le travail aux crowdworkers, cliquez sur Copier le lien. Collez ensuite le lien dans un courriel qui sera envoyé aux crowdworkers.

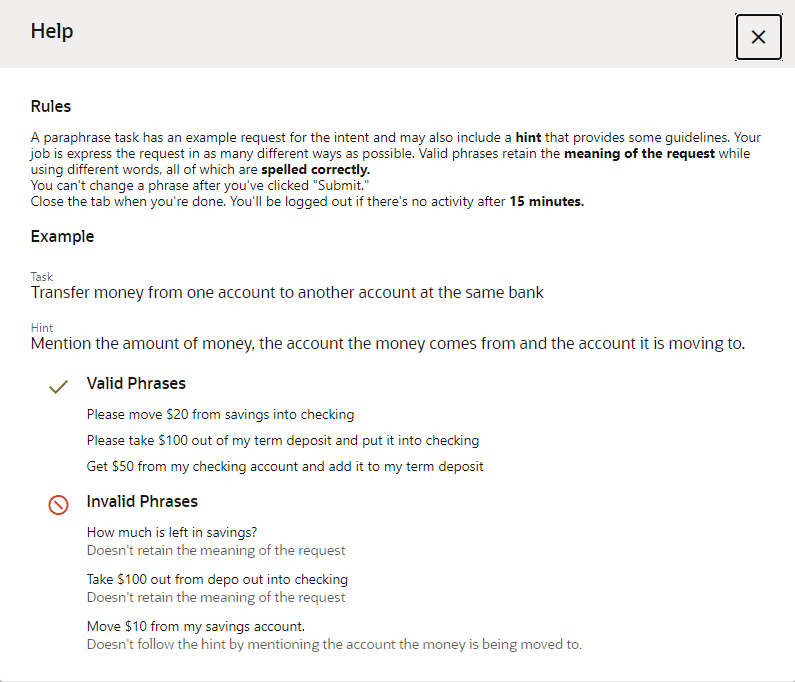

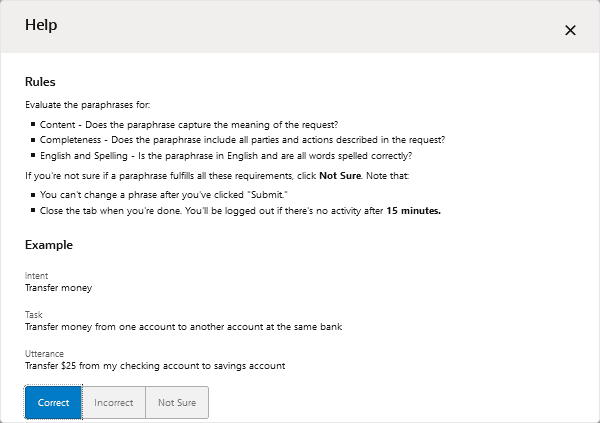

En cliquant sur ce lien, le crowdworker accepte le travail. Une fois qu'un crowdworker a accepté le travail, il consulte les règles générales relatives aux travaux de paraphrase, d'annotation ou de validation.Remarque

Les crowdworkers fournissent leur nom et leur adresse électronique à des fins de suivi. Triez les résultats en fonction de leur nom pour évaluer leur réussite dans l'exécution des tâches.

Surveillance de la progression des crowdworkers

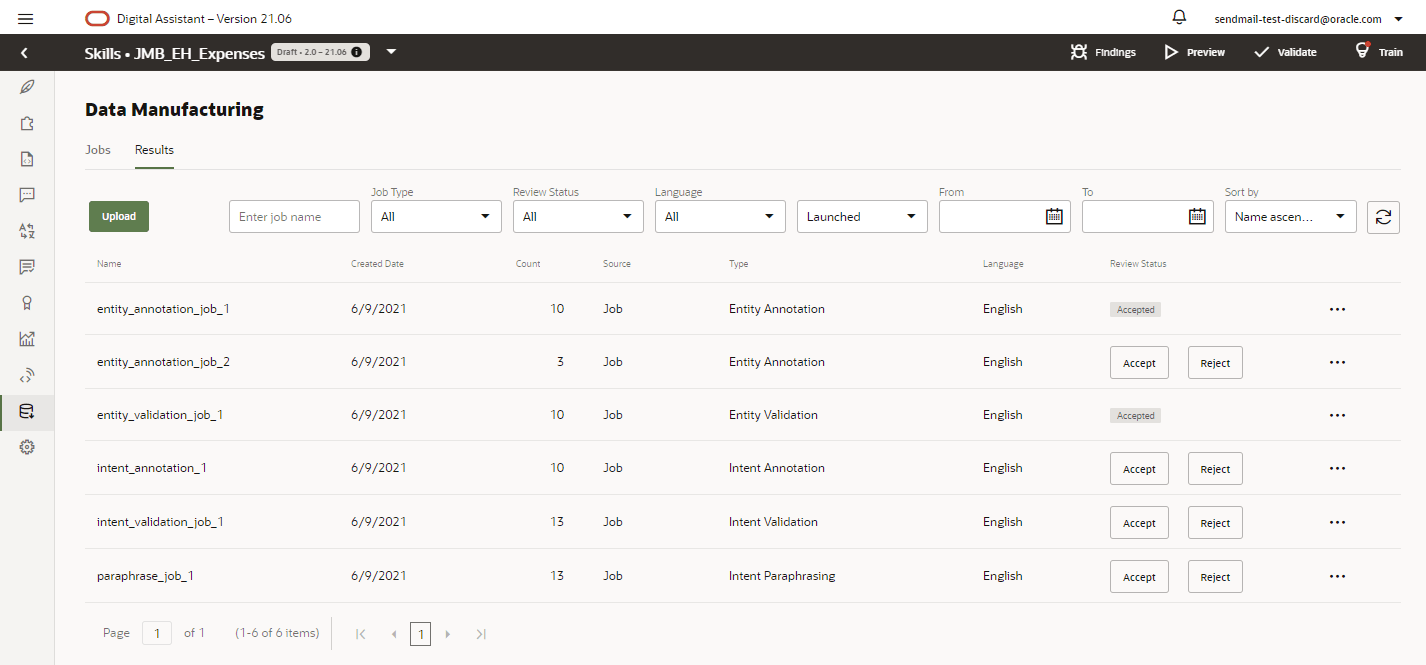

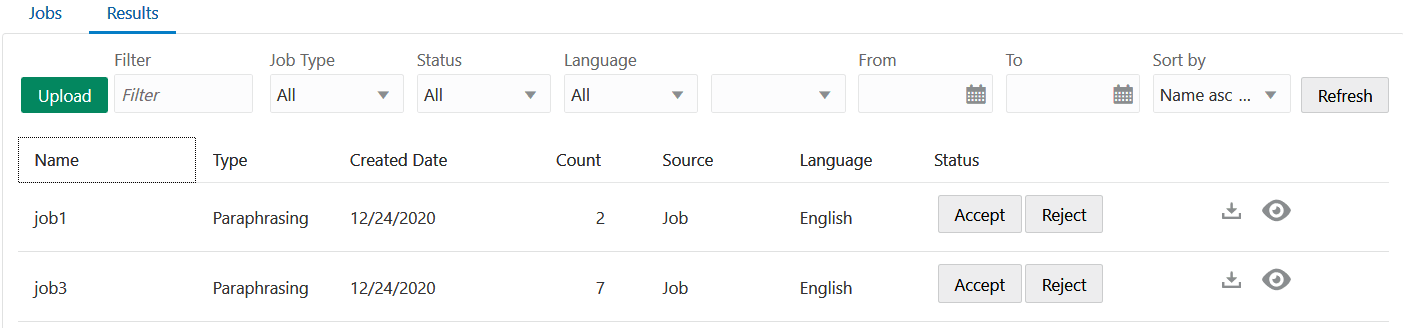

Les travaux terminés ou annulés peuvent être téléchargés à partir de la page Résultats. En règle générale, vous utilisez cette page pour accéder aux résultats et les modifier en les téléchargeant sous forme de fichier CSV que vous pouvez manipuler dans un tableur comme Excel.

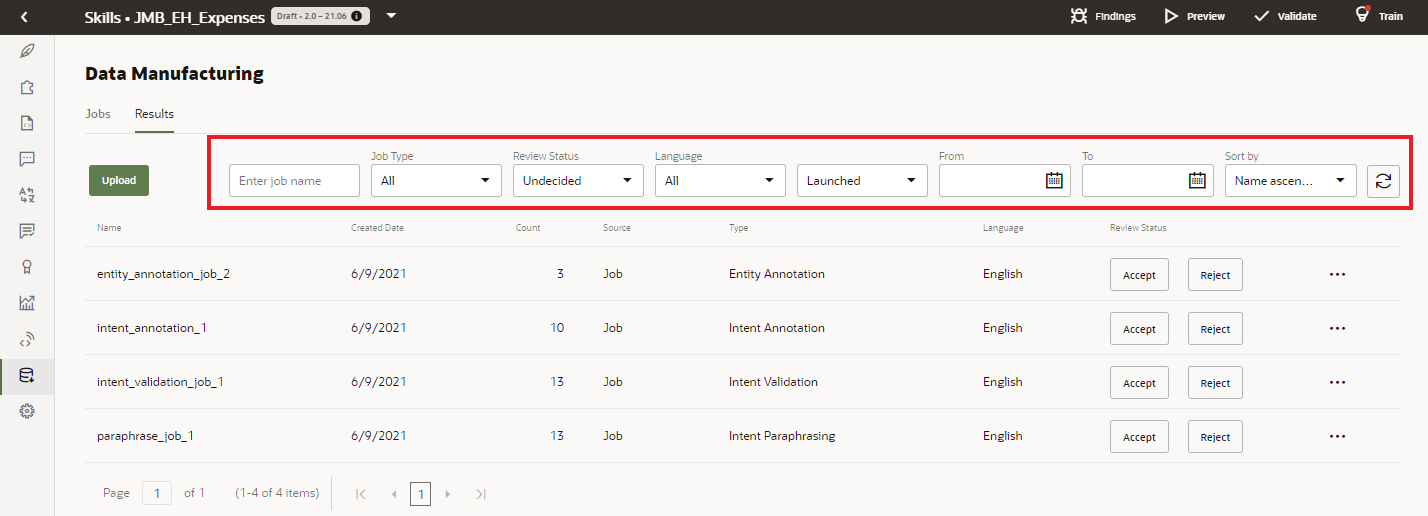

Au fur et à mesure que le nombre de travaux augmente, vous pouvez les filtrer sur le statut Accepté, Rejeté ou Indécis (pour les travaux qui n'ont été ni acceptés ni rejetés).

Conseil :

Etant donné que le statut Accepté ou Rejeté signifie que votre contribution à un travail est terminée, vous êtes susceptible de filtrer l'affichage sur Indécis le plus souvent.Examen des résultats

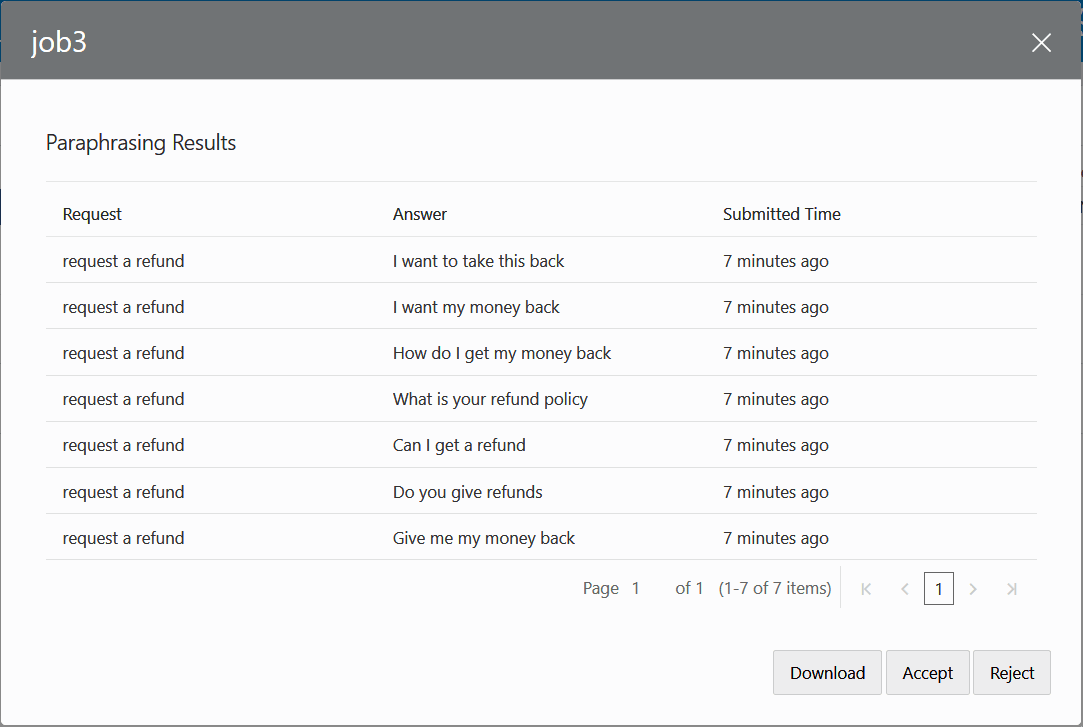

- Cliquez sur Afficher pour examiner les résultats.

Si les résultats sont uniformément incorrects en majorité, cliquez sur Rejeter. Vous pouvez rejeter un travail mal conçu qui a induit en erreur ou perdu les crowdworkers, ou vous pouvez rejeter un travail car il s'agissait d'un test. Si les résultats vous semblent corrects, vous pouvez les ajouter à votre ensemble d'entraînement en cliquant sur Accepter. Avant de sélectionner cette option, n'oubliez pas que vous ne pouvez pas annuler cette opération, qui ajoute l'intégralité des résultats à vos données d'entraînement. Dans la mesure où vous pouvez ajouter par inadvertance des variations incorrectes que vous pouvez enlever uniquement en modifiant l'intention, nous vous recommandons de télécharger les résultats et de les modifier avant de les accepter dans le corpus d'entraînement.

La modification des fichiers CSV téléchargés permet de nettoyer les résultats. Pour les travaux de paraphrase, la modification des résultats avant de les valider dans l'ensemble d'entraînement permet de modifier les variations ou de supprimer celles qui sont incorrectes.Remarque

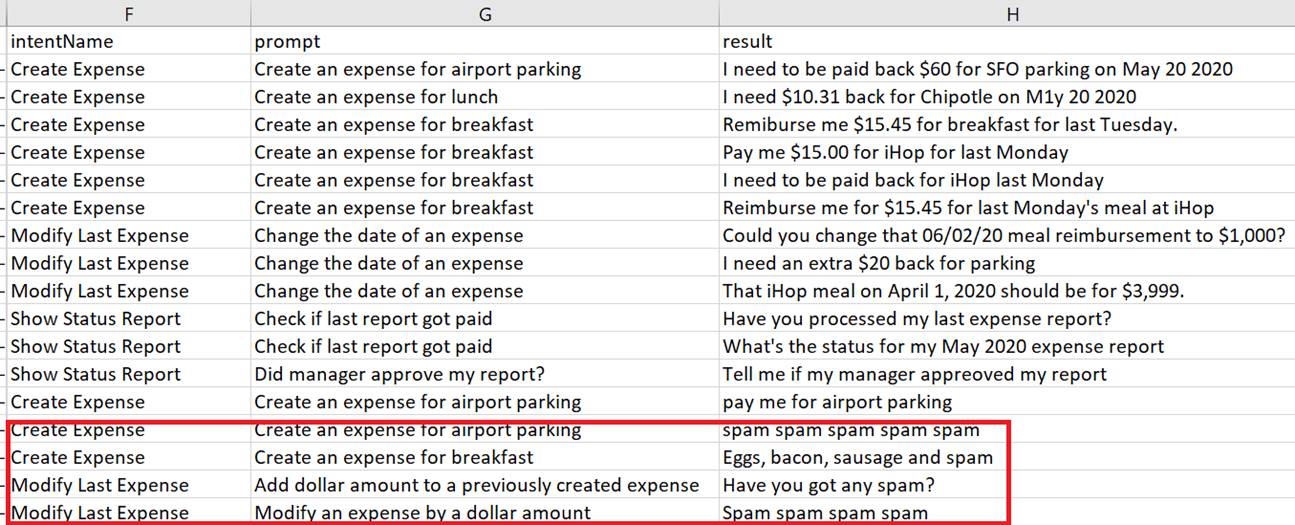

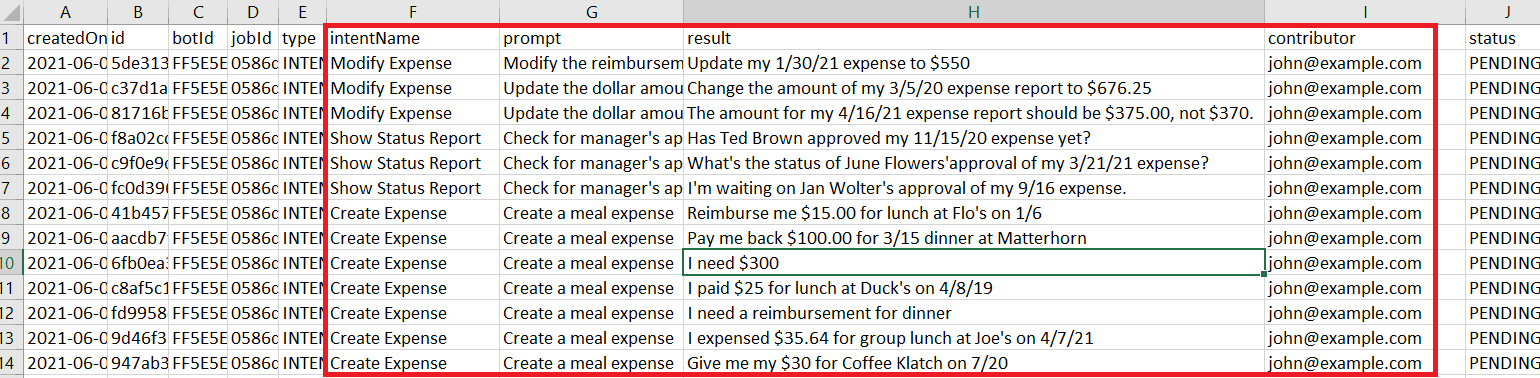

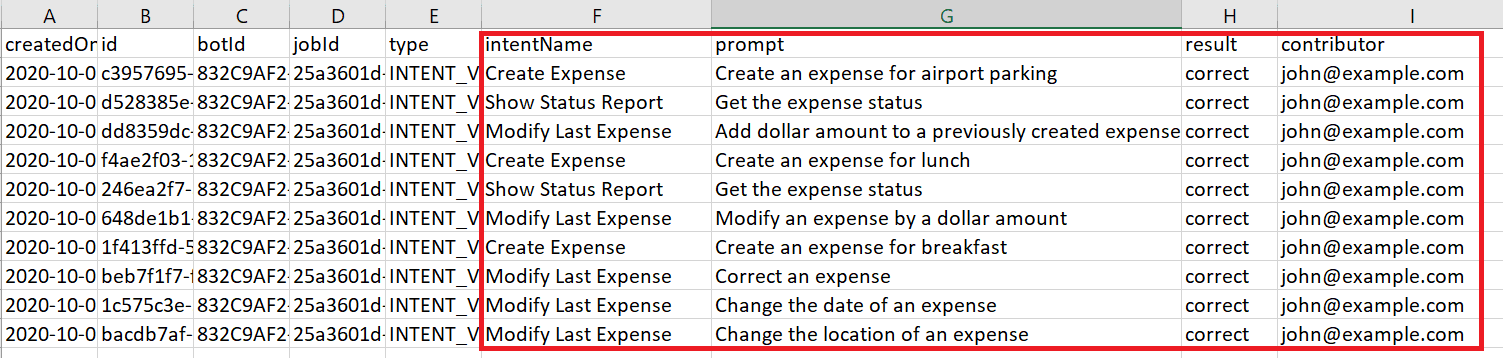

Le contenu de la colonneresultdépend du type de travail. Pour un travail de paraphrase, les variations du crowdworker alimentent cette colonne. Pour un travail de validation, il s'agit de l'évaluation par le crowdworker de la variation par rapport à la tâche (Correct, Incorrect, Incertain), et pour un travail d'annotation, il s'agit de l'intention qui correspond à la variation.

Pour télécharger le travail en local, cliquez sur Télécharger en local sur la page Résultats ou dans la boîte de dialogue Afficher les résultats. Enregistrez le travail sur votre système local, puis ouvrez le fichier CSV avec un tableur.

sur la page Résultats ou dans la boîte de dialogue Afficher les résultats. Enregistrez le travail sur votre système local, puis ouvrez le fichier CSV avec un tableur.

- Une fois les modifications terminées, cliquez sur Télécharger vers le serveur sur la page Résultats.

- Entraînez de nouveau la brique.

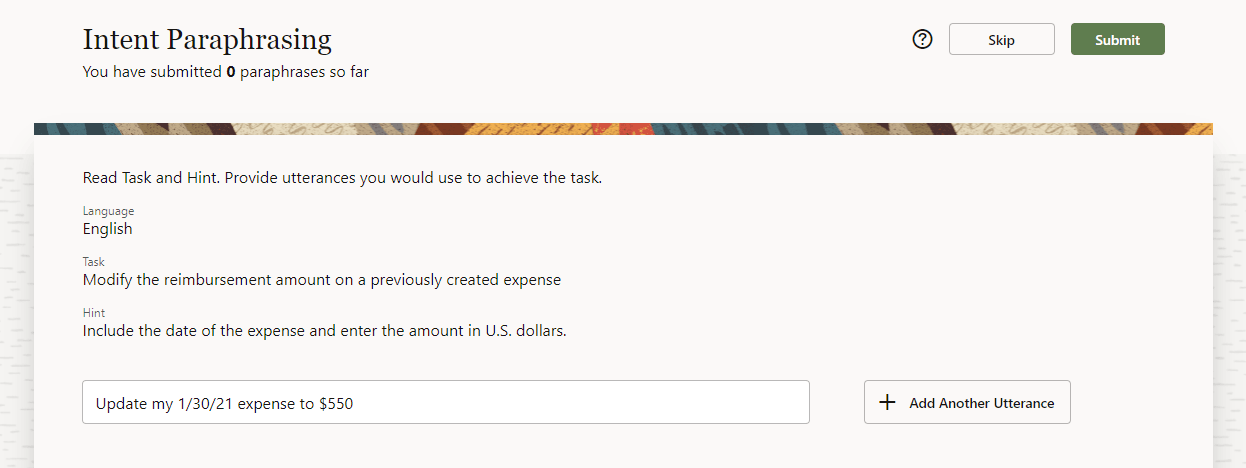

Travaux de paraphrase

Collectez les variations des crowdworkers par le biais de travaux de paraphrase. Les crowdworkers qui acceptent le travail de paraphrase créent des variations valides en suivant les directives sous forme d'invites et de conseils que vous fournissez. Une invite capture l'essence de ce que les utilisateurs attendent de la brique. Un conseil (facultatif) fournit des détails supplémentaires aux crowdworkers, tels que des formulations et des valeurs d'entité. Par exemple, "Créez une dépense pour un commerçant à l'aide d'un montant en dollars" est une invite pour l'intention Créer une note de frais. Le conseil associé est "Utilisez le nom du commerçant ACME et un montant en dollars inférieur à 50 $".

- Une invite n'est pas une variation. Les variations peuvent étouffer la créativité des crowdworkers en raison de leur spécificité. Au lieu de servir d'exemples, elles encouragent plutôt les crowdworkers à générer de légères variantes. Ces expressions redondantes ajoutent du bruit à votre corpus d'entraînement et n'améliorent pas la capacité cognitive de la brique.

- Si vous disposez de plusieurs invites pour une intention, variez-les. Chaque invite d'un travail de paraphrase est susceptible d'être envoyée à différents crowdworkers. Même si un crowdworker obtient plusieurs invites pour le même travail de paraphrase, une invite différente modifie sa perspective.

- Utilisez les conseils pour encourager les variantes. Vous pouvez définir des conseils pour tout élément que vous voulez inclure (ou ne pas inclure) dans les variations. Lorsque vous variez vos invites, vous devez également varier les conseils correspondants.

Invite Conseil Créez une dépense de stationnement à l'aéroport Incluez le code de l'aéroport (SFO, LAX, etc.), une date complète (dd/mm/yyyy) et un montant en dollars américains. Créer une dépense pour un repas Indiquez le nom du restaurant, une date complète (dd/mm/yyyy) et un montant en dollars américains.

Création du travail de paraphrase

- Si vous n'avez encore créé aucun travail, cliquez sur Ajouter un travail (sur la page de renvoi si vous n'avez pas encore créé de travail ou dans l'onglet Travaux si des travaux existent).

- Sélectionnez Paraphrase.

- Entrez un nom de travail.

- Sélectionnez la langue utilisée par les crowdworkers. Par défaut, la langue prédominante de la brique s'affiche, mais vous pouvez faire un choix parmi d'autres langues prises en charge de façon native définies pour la brique.

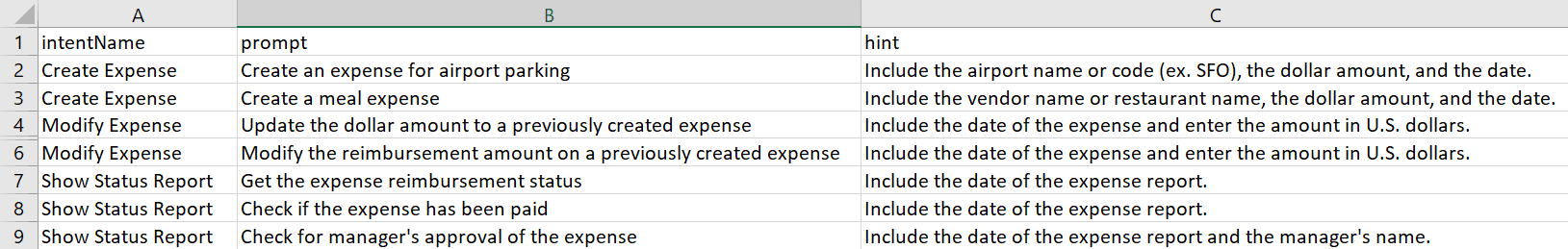

- Ajoutez vos invites et vos conseils (facultatifs) pour les intentions. Vous pouvez les créer hors ligne dans un fichier CSV avec des colonnes nommées

intentName,promptethint, et les ajouter en batch, ou vous pouvez les ajouter un par un avec la boîte de dialogue Nouveau travail. Vous pouvez inclure ces colonnes dans n'importe quel ordre dans le fichier CSV.Remarque

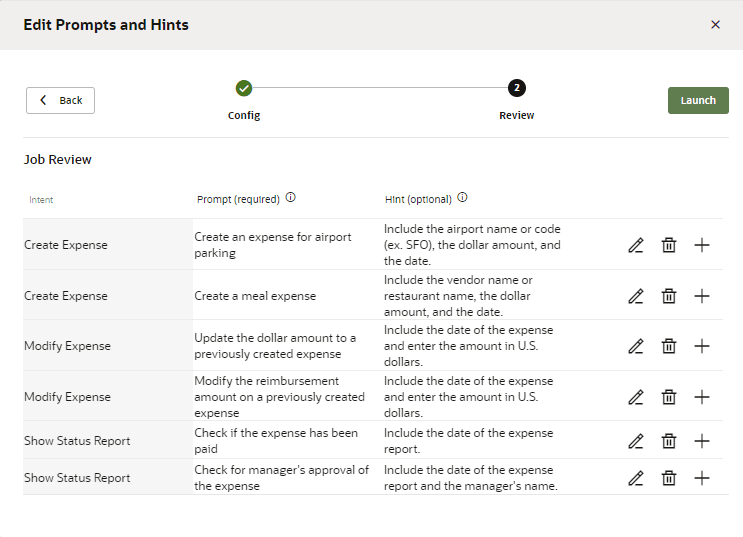

Si vous avez sélectionné une langue autre que la langue prédominante de la brique, vos invites et conseils doivent également être dans cette langue. - Si vous avez ajouté les invites, les conseils et les noms d'intention à un fichier CSV, cliquez sur Télécharger vers le serveur, puis accédez au fichier et sélectionnez-le. Cliquez ensuite sur Continuer.

- Si nécessaire, ajoutez des invites supplémentaires

, modifiez

, modifiez  ou supprimez

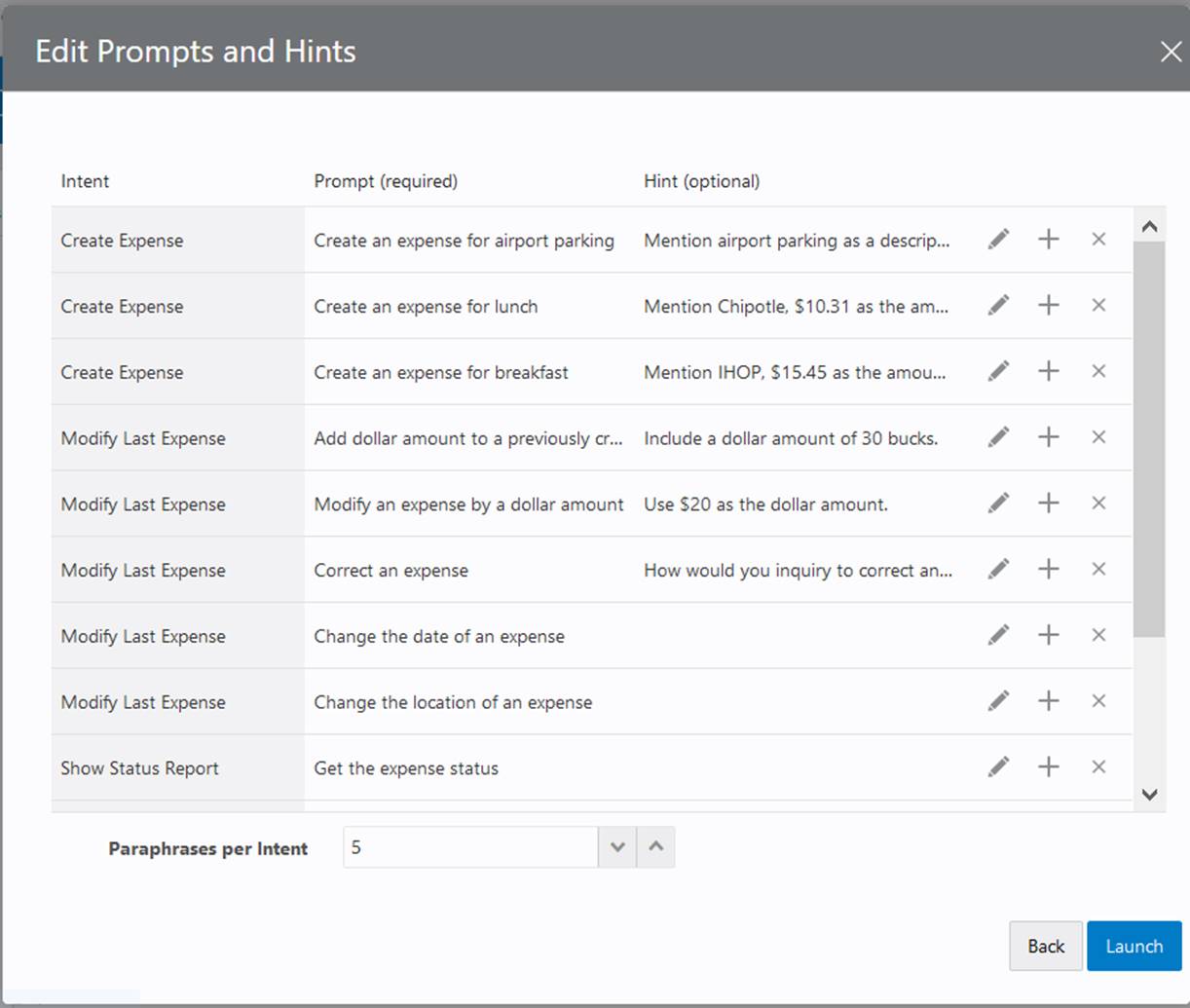

ou supprimez  des invites, ou modifiez le nombre de variations par invite. Cliquez sur Lancer.

des invites, ou modifiez le nombre de variations par invite. Cliquez sur Lancer. - Pour créer manuellement un travail de paraphrase, cliquez sur Sélectionner.

- Cliquez sur le champ Intentions pour sélectionner une intention dans le menu, ou cliquez sur l'option Sélectionner toutes les intentions pour ajouter des invites à l'ensemble entier d'intentions.

- Cliquez sur Continuer.

- Cliquez dans le champ Invite ou cliquez sur Modifier

pour saisir votre invite.

pour saisir votre invite.

- Cliquez dans le champ Conseil ou cliquez sur Modifier

pour saisir votre conseil.

pour saisir votre conseil.

- Cliquez sur Ajouter

pour créer une autre invite. Gardez à l'esprit que chaque nouvelle invite constitue potentiellement un travail distinct, traité par un autre crowdworker.

pour créer une autre invite. Gardez à l'esprit que chaque nouvelle invite constitue potentiellement un travail distinct, traité par un autre crowdworker.

- Si nécessaire, supprimez ou modifiez des invites ou des conseils.

- Cliquez sur Ajouter

- Sélectionnez le nombre de paraphrases par invite.

- Lorsque vous avez terminé, cliquez sur Lancer.

Le travail de paraphrase apparaît sous la forme d'une nouvelle ligne sur la page Travaux, avec le statut En cours d'exécution. - Cliquez sur Copier le lien sur la ligne, puis collez le lien dans un courriel que vous envoyez aux crowdworkers. En cliquant sur ce lien, le crowdworker accepte le travail. Une fois qu'un crowdworker a accepté le travail, il consulte les règles générales relatives aux travaux de paraphrase.RemarqueLes crowdworkers soumettent ensuite leurs paraphrases.

L'environnement local du navigateur du crowdworker est défini sur la langue sélectionnée dans la boîte de dialogue Créer un travail.

Vous pouvez surveiller la progression de l'exécution en temps réel à partir de la page Travaux.

Conseils sur les travaux de paraphrase

Pour que les résultats d'un travail de paraphrase améliorent réellement le corpus d'entraînement, il est important de le configurer de manière à obtenir des expressions diverses et réelles pour le cas d'utilisation. Voici quelques conseils pour rendre vos travaux de paraphrase plus réussis :

- Formulez soigneusement les cas d'utilisation que vous pouvez utiliser comme destinataires prédéfinis pour les tâches.

- A l'aide des "cas d'utilisation prédéfinis", décrivez les scénarios concrets pour lesquels l'utilisateur doit fournir des variations au lieu de simplement demander des variations sur une phrase.

- Fournissez plusieurs scénarios pour la même intention.

- Utilisez le champ Conseil pour obtenir des conseils susceptibles d'élargir la perspective. Par exemple, pour une intention de type Charges, vous pouvez ajouter le conseil "inclure différentes devises comme si vous voyagiez".

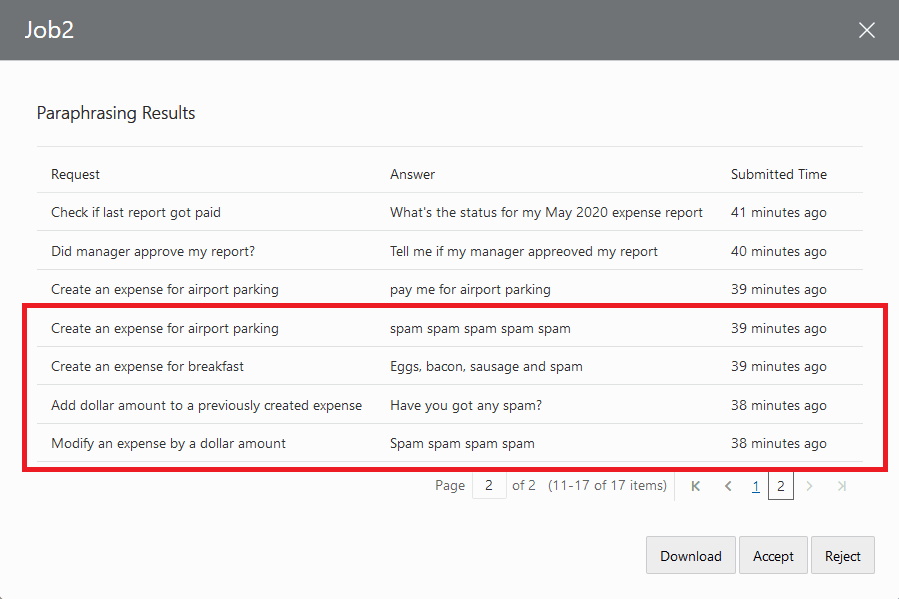

Examen du travail de paraphrase

Avant d'ajouter les variations à votre ensemble d'entraînement, vous souhaiterez probablement les examiner à la recherche de sémantiques, de fautes d'orthographe ou de messages indésirables.

- Vous pouvez attendre la fin du travail ou, si vous pensez que toutes les contributions possibles ont été apportées à un travail en cours d'exécution, cliquez sur Annuler sur la page Travaux.

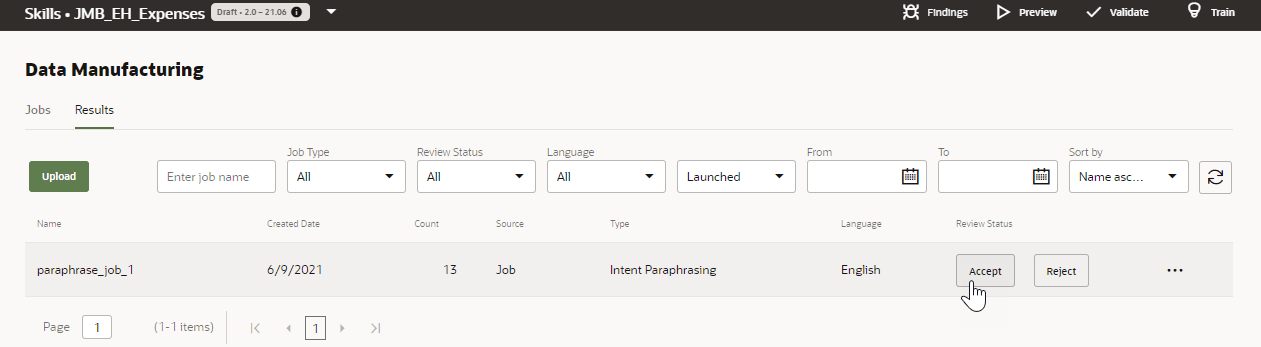

- Cliquez sur Résultats. Seuls les travaux annulés ou terminés apparaissent sur la page Résultats.

- Cliquez sur Afficher pour obtenir une vue en lecture seule des variations. A l'aide des options de cette boîte de dialogue, vous pouvez télécharger le travail en tant que fichier CSV, ou l'accepter ou le rejeter dans son intégralité.

Avant de vous engager à rejeter ou accepter toutes les tâches de travail en même temps (ce que vous ne pouvez pas annuler automatiquement), vous pouvez télécharger le travail en local et nettoyer les résultats avant de les ajouter à l'ensemble d'entraînement. Si vous utilisez cette méthode, cliquez sur Télécharger en local dans cette boîte de dialogue ou sur la page Résultats.Conseil :

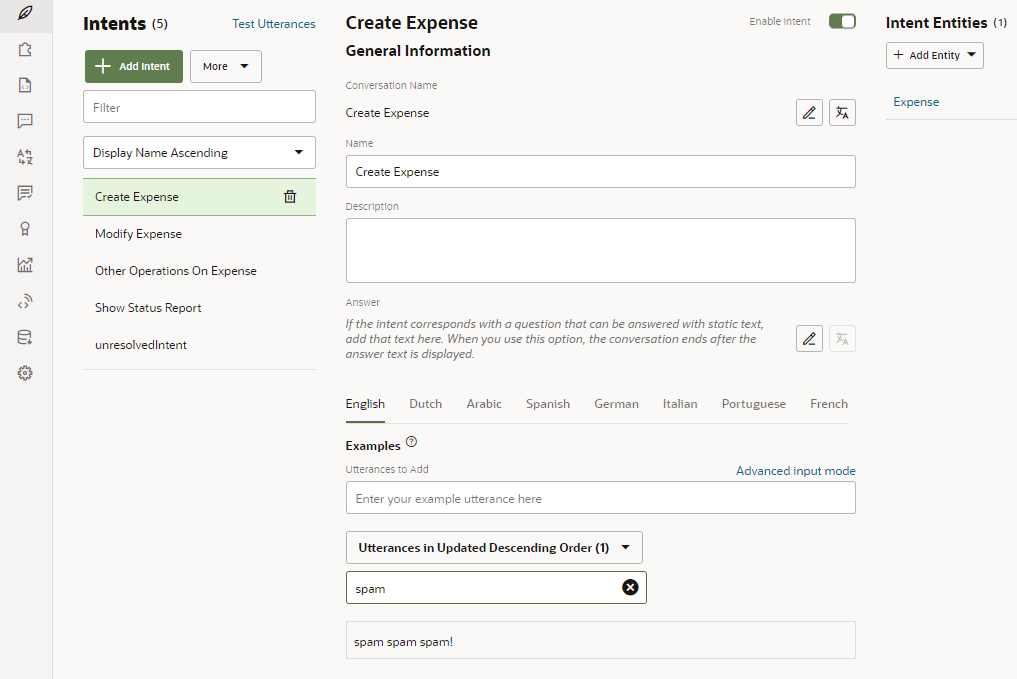

Pour que vous ne puissiez pas facilement enlever des variations après les avoir acceptées, vous pouvez créer une version de votre brique ou la cloner par mesure de précaution. - Ouvrez le fichier CSV avec un tableur.

Vérifiez les variations de la colonne de résultat par rapport aux colonnes

IntentNameet d'invite. Mettez à jour les variations dans la colonne de résultat si nécessaire ou supprimez des lignes entières. Si la variation demande trop de travail d'ajustement, vous pouvez supprimer toute la ligne. Si un crowdworker a fourni de manière répétée des variations incorrectes car il n'a pas compris les invites ni suivi les directives générales de paraphrase, vous pouvez trier la feuille de calcul sur la colonne du contributeur, puis supprimer les lignes. Si vous supprimez une ligne, veillez à la supprimer complètement. Sinon, vous ne pourrez pas télécharger le fichier vers le serveur.Conseil :

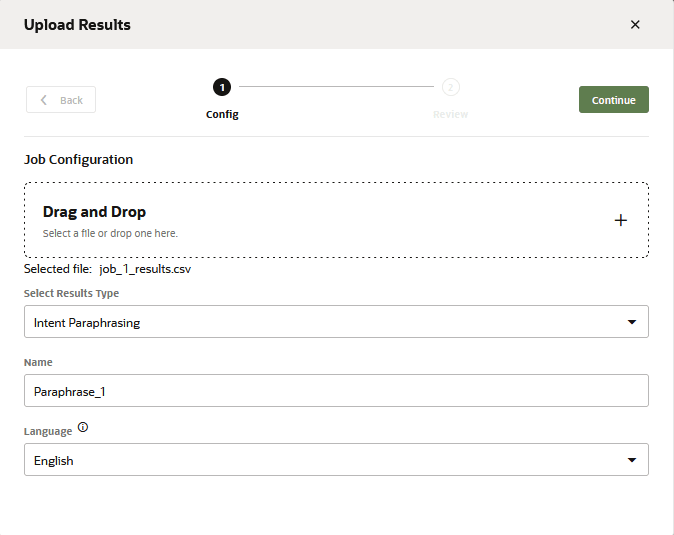

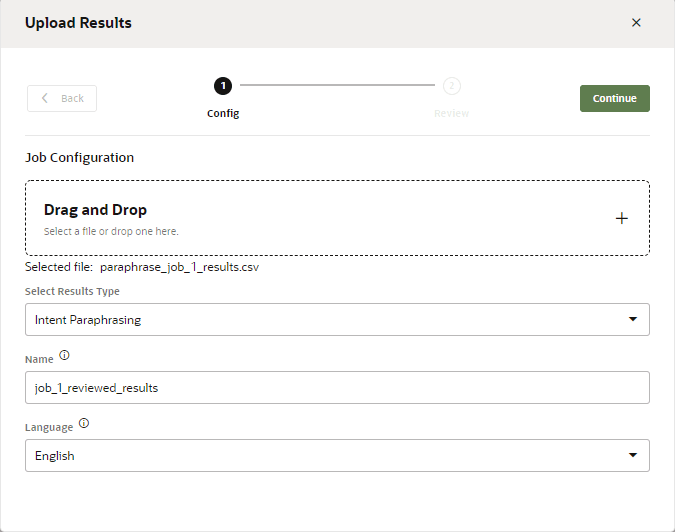

Vous devez uniquement vous concentrer sur les colonnesintentName,prompt,resultetcontributorde la feuille de calcul. Vous pouvez ignorer les autres colonnes. - Lorsque vous avez terminé, cliquez sur Télécharger vers le serveur sur la page Résultats. Parcourez l'arborescence pour sélectionner le fichier CSV. Sélectionnez paraphrase d'intention, entrez un nom, puis cliquez sur Télécharger vers le serveur.

- Pour ajouter les variations aux données d'entraînement d'une intention, cliquez sur Accepter sur la page Résultats. Cliquez sur Rejeter si vous ne voulez pas les ajouter à l'ensemble d'entraînement. Vous pouvez rejeter un travail s'il s'agit d'un test, ou s'il ne peut pas être exploité en raison d'invites et de conseils mal conçus.

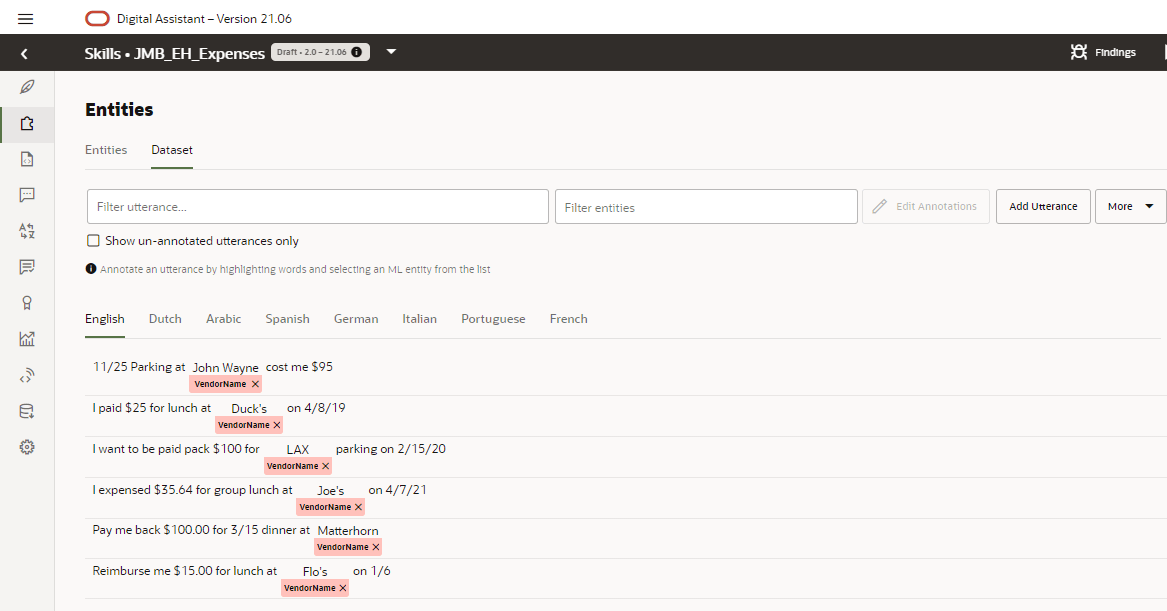

Travaux d'annotation

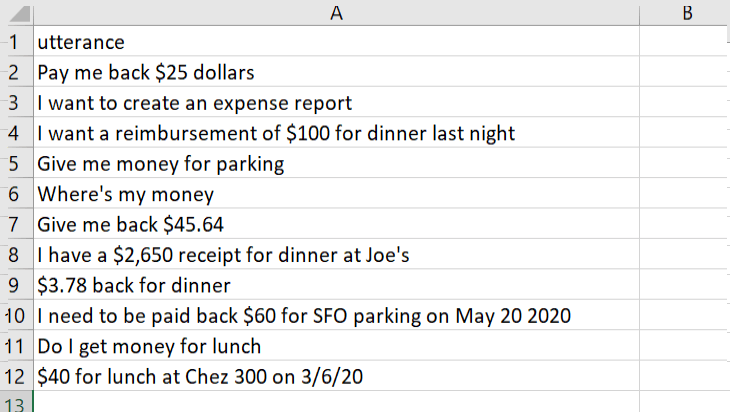

Chaque fois que vous disposez d'une donnée de discussion à mettre en correspondance avec une intention ou annotée pour les entités d'apprentissage automatique, vous pouvez créer un travail d'annotation. Les processus actifs effectuent des travaux d'annotation pour les intentions en mettant en correspondance une variation avec une intention. Pour les travaux d'annotation d'entité, les processus actifs étiquetent le texte dans la variation pour une entité d'apprentissage automatique. Vous pouvez créer ces travaux à l'aide d'un fichier CSV avec une colonne utterance, des travaux d'annotation précédemment terminés ou en combinant les deux approches. Vous pouvez également créer un travail d'annotation d'intention à partir des variations collectées dans le réentraînement.

Description de l'illustration annotation-csv.png

Création du travail d'annotation d'intention

- Cliquez sur + Nouveau travail sur la page Travaux.

- Sélectionnez Annotation d'intention.

- Entrez un nom.

- Saisissez la langue utilisée par les crowdworkers.

- Téléchargez le fichier, cliquez sur Continuer, notez le nombre d'éléments du travail, puis cliquez sur Lancer.

- Cliquez sur Copier le lien, puis collez le lien dans un courriel envoyé aux crowdworkers. En cliquant sur ce lien, le crowdworker accepte le travail. Une fois qu'ils se sont connectés, les crowdworkers examinent les règles de base relatives à la classification des variations.

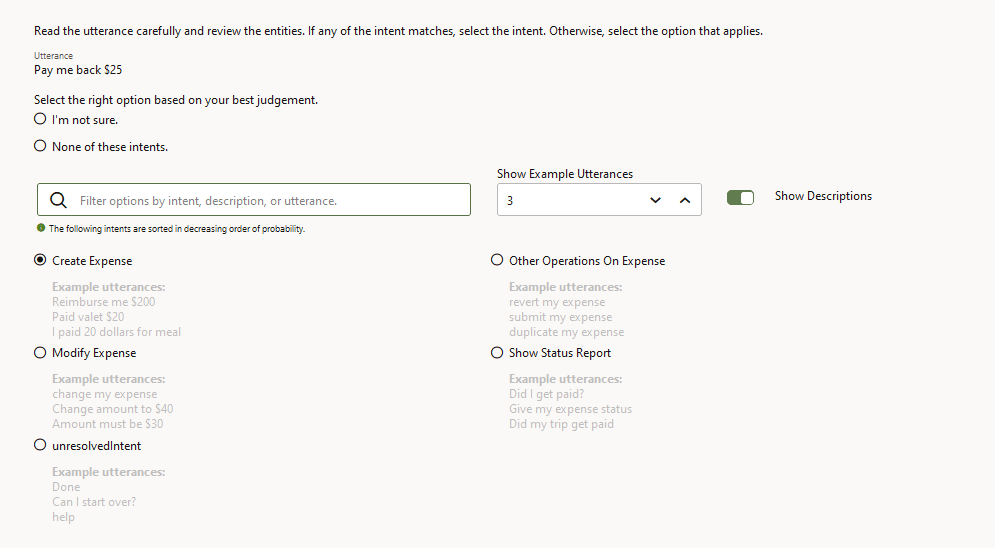

L'apprentissage actif aide les crowdworkers en classant toutes les intentions de la brique selon leur probabilité de correspondance à la variation. L'intention qui présente le potentiel le plus élevé de correspondance à la variation apparaît en premier. De même, les variations qui figurent actuellement dans le corpus, que les crowdworkers utilisent pour se guider, sont également classées selon leur probabilité de correspondance à la variation.

Vous pouvez surveiller la progression sur la page Travaux.

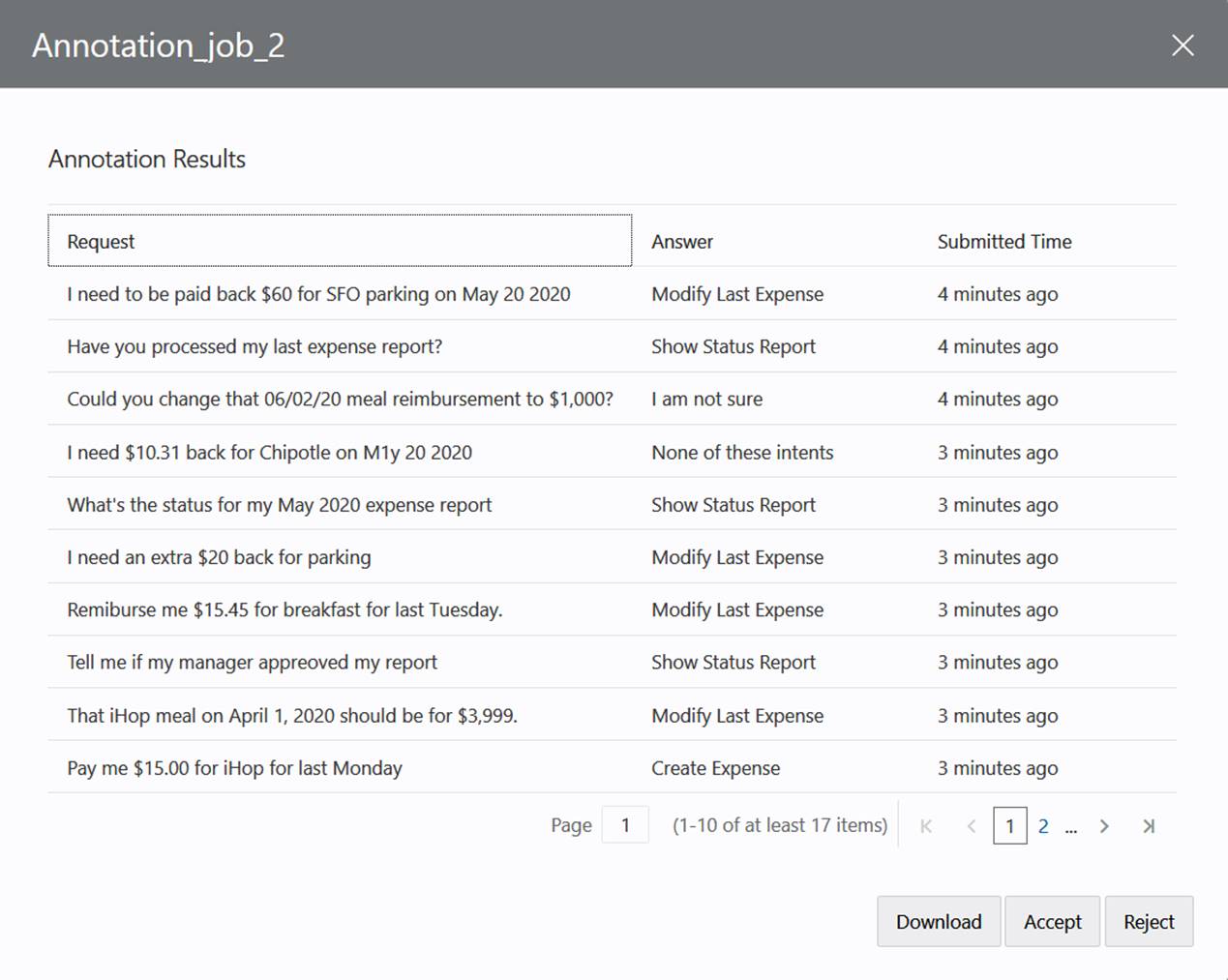

Examen du travail d'annotation

- Une fois le travail terminé ou que vous avez cliqué sur Annuler car vous pensez que le travail a atteint son maximum, cliquez sur Afficher.

- Si vous n'êtes pas d'accord avec certaines décisions des crowdworkers, cliquez sur Télécharger en local pour télécharger un fichier CSV des résultats sur votre système local.

- Dans le fichier CSV, entrez le nom d'intention attendu dans la colonne

intentName. - Remplacez l'intention choisie par le crowdworker dans la colonne

resulten saisissant le nom de la conversation pour l'intention que vous avez saisie dans la colonneintentName. - Une fois l'examen terminé, cliquez sur Télécharger vers le serveur sur la page Résultats. Sélectionnez ensuite le fichier, entrez un nom, puis cliquez sur Télécharger vers le serveur.

RemarqueLes résultats sont fusionnés avec le travail en cours.

Vous ne pouvez pas enlever une entrée des résultats. Les résultats conservent toutes les entrées, même si vous supprimez une ligne dans le fichier CSV avant de le télécharger. Si vous voulez enlever les entrées incorrectes (car vous ne souhaitez pas rejeter la totalité du travail), vous devez créer un ensemble distinct de résultats qui n'appartiennent à aucun travail en enlevant le contenu des colonnesjobIdetIdavant de télécharger le fichier vers le serveur. - Entraînez de nouveau la brique.

Remarque

Seules les variations correspondant à une intention sont ajoutées aux données d'entraînement. Celles classées sous Aucune de ces intentions ou Je ne suis pas sûr sont exclues.

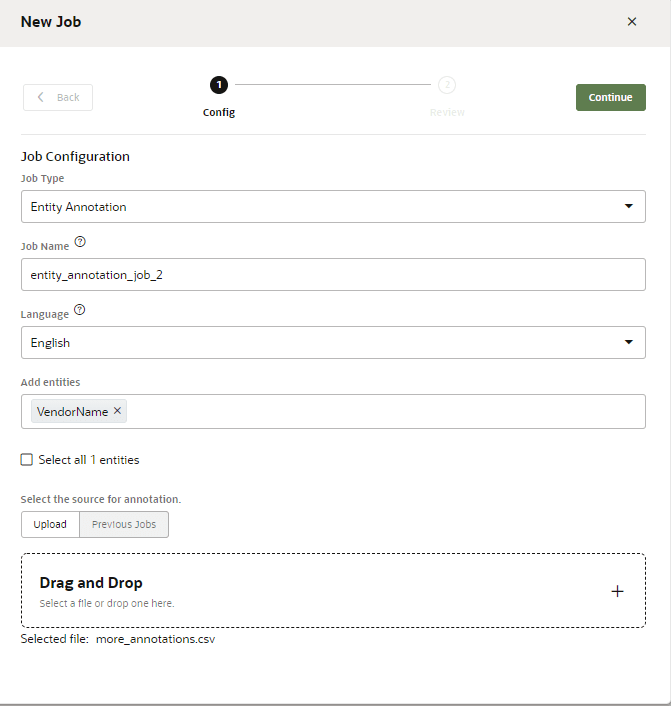

Création du travail d'annotation d'entité

Votre brique a besoin d'au moins une entité ML pour ce travail. Vous ne pouvez pas créer un travail d'annotation d'entité avec des entités non ML.

- Cliquez sur + Nouveau travail sur la page Travaux.

- Sélectionnez Annotation d'entité.

- Entrez un nom.

- Saisissez la langue utilisée par les crowdworkers.

- Sélectionnez l'entité d'apprentissage automatique (ou les entités d'apprentissage automatique) à partir de laquelle les crowdworkers effectueront leur sélection. Idéalement, ces entités auront des noms utiles et des descriptions succinctes.

- S'il s'agit de votre premier travail d'annotation d'entité, accédez à un fichier CSV, puis sélectionnez-le. Vous pouvez fournir aux salariés des variations annotées ou non, selon le format de ce fichier :

- Pour les variations non annotées, téléchargez un fichier CSV qui organise les variations simples sous une seule colonne,

utterance:utterance I want to order a family size pepperoni pizza with thin crust and mozzarella cheese I want to order a large supreme pizza with regular crust and provolone cheese I want to order a medium size meat-lover pizza with gluten-free crust and goat cheese - Pour les variations annotées, téléchargez un fichier CSV avec une seule colonne,

annotation, chaque variation étant représentée en tant qu'objet JSON. Les propriétésbeginOffsetetendOffsetreprésentent le début et la fin du texte libellé pour l'entité d'apprentissage automatique. Créer des entités d'apprentissage automatique décrit les autres propriétés de cet objet.

Les Crowd workers vérifieront les libellés existants définis par ces décalages et les modifieront lorsqu'ils sont incorrects.annotation "[ { ""Utterance"":{ ""utterance"":""I want to order a family size pepperoni pizza with thin crust and mozzarella cheese"", ""languageTag"":""en"", ""entities"":[ { ""entityValue"":""family"", ""entityName"":""MLPizzaCrust"", ""beginOffset"":18, ""endOffset"":24 }, { ""entityValue"":""mozzarella"", ""entityName"":""MLCheeseType"", ""beginOffset"":66, ""endOffset"":76 }, { ""entityValue"":""pepperoni"", ""entityName"":""MLPizzaType"", ""beginOffset"":30, ""endOffset"":39 } ] } } ]" "[ { ""Utterance"":{ ""utterance"":""I want to order a large supreme pizza with regular crust and provolone cheese"", ""languageTag"":""en"", ""entities"":[ { ""entityValue"":""supreme"", ""entityName"":""MLPizzaType"", ""beginOffset"":24, ""endOffset"":31 }, { ""entityValue"":""provolone"", ""entityName"":""MLCheeseType"", ""beginOffset"":61, ""endOffset"":70 }, { ""entityValue"":""regular"", ""entityName"":""MLPizzaCrust"", ""beginOffset"":43, ""endOffset"":50 }, { ""entityValue"":""large"", ""entityName"":""MLPizzaSize"", ""beginOffset"":18, ""endOffset"":23 } ] } } ]"

- Pour les variations non annotées, téléchargez un fichier CSV qui organise les variations simples sous une seule colonne,

- Cliquez sur Continuer, vérifiez le nombre d'enregistrements, puis sur Lancer.

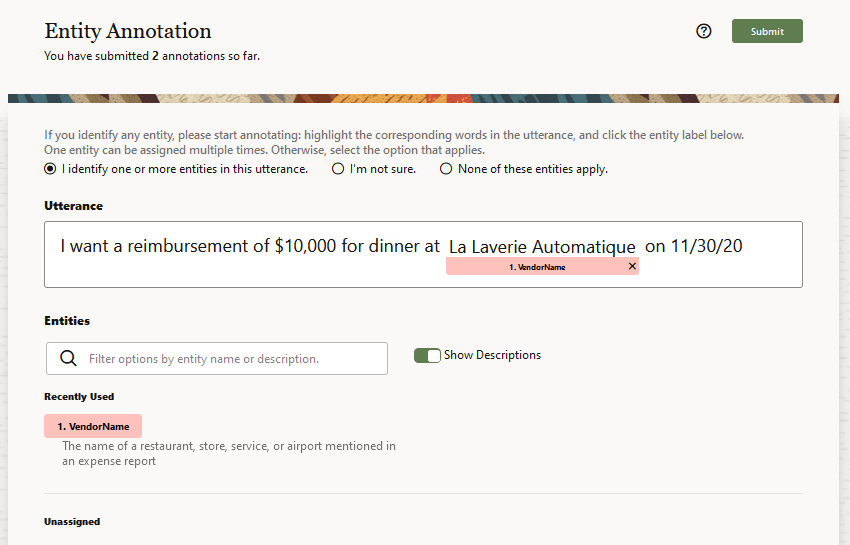

- Copiez puis collez le lien dans un courriel envoyé aux crowdworkers. En cliquant sur ce lien, le crowdworker accepte le travail. Avant de commencer à étiqueter les variations avec des annotations, ils examinent les règles de base sur la façon d'étiqueter le contenu avec des annotations. Si la variation inclut du texte correspondant à l'une des entités d'apprentissage automatique répertoriées sur la page, un crowdworker met en surbrillance le texte applicable et applique le libellé Entité d'apprentissage automatique. Si la variation est déjà annotée, les salariés peuvent vérifier les libellés et les ajuster si nécessaire.

- Une fois le travail terminé (soit parce que les salariés ont terminé les annotations, soit parce que vous l'avez annulée), vous pouvez afficher les résultats et les accepter dans le corpus d'entraînement de l'entité d'apprentissage automatique.

Toutefois, avant d'ajouter les résultats, vous pouvez demander aux crowdworkers de les vérifier en lançant un travail de validation d'entité. Seuls les résultats corrects d'un travail de validation sont ajoutés au corpus. Si nécessaire, vous pouvez apporter des corrections et des ajouts supplémentaires aux résultats du travail dans l'onglet Jeu de données de l'entité d'apprentissage automatique.

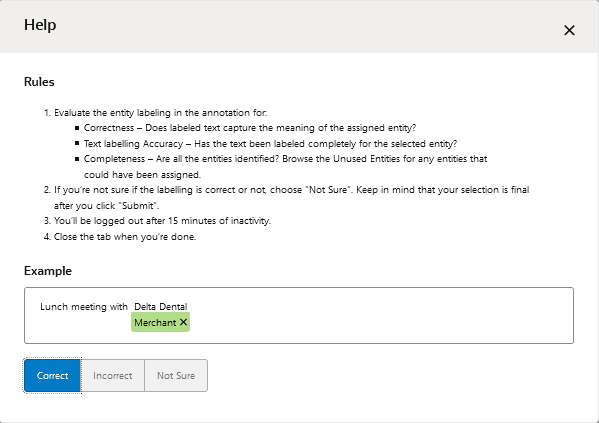

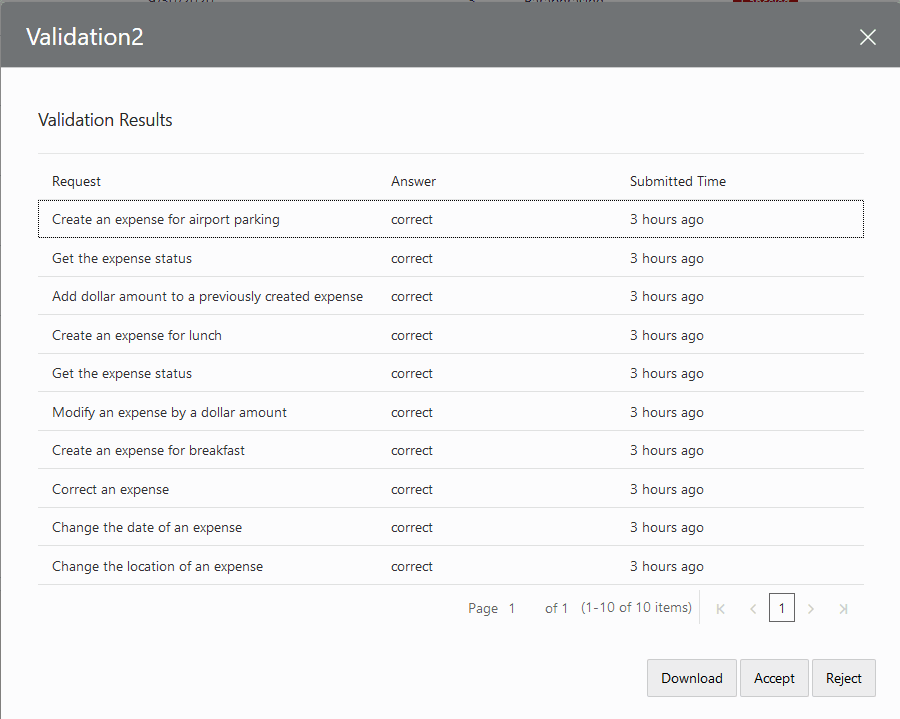

Travaux de validation

Pour les travaux de validation, les crowdworkers vérifient les résultats des travaux de paraphrase, des travaux d'annotation d'entité ou des travaux de validation d'intention générés à partir du réentraînement. Pour valider un travail de paraphrase, ils comparent les variations (résultats d'un travail de paraphrase ou de ) à une tâche, à savoir l'invite du travail de paraphrase. Pour les travaux d'annotation d'entité, ils examinent les variations afin de s'assurer que l'entité d'apprentissage automatique correcte a été identifiée et que le texte a été entièrement étiqueté.

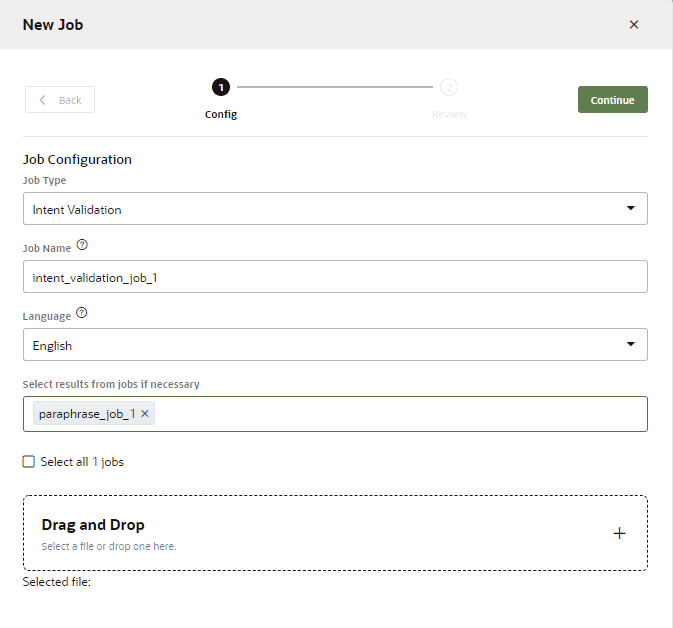

Création d'un travail de validation de paraphrase d'intention

- Cliquez sur Ajouter un travail sur la page Travaux.

- Sélectionnez Validation de paraphrase d'intention.

- Entrez un nom.

- Saisissez la langue utilisée par les crowdworkers.

- Ajoutez les travaux de paraphrase qui n'ont pas encore été acceptés (c'est-à-dire les travaux terminés ou annulés). Vous pouvez télécharger un fichier CSV à partir de votre système local, sélectionner des travaux de paraphrase ou créer un travail à partir des deux méthodes.

- Cliquez sur Continuer, vérifiez le nombre d'enregistrements, puis sur Lancer.

- Une fois la ligne du travail de validation ajoutée à la page Travaux (vous devrez peut-être cliquer sur Actualiser), cliquez sur Copier le lien.

- Collez le lien dans un courriel envoyé aux crowdworkers. Une fois que les crowdworkers ont accepté le travail, ils consultent les règles de base pour l'évaluation des variations.

Ils évaluent ensuite une variation.

Vous pouvez surveiller la progression du crowdworker à partir de la page Travaux.

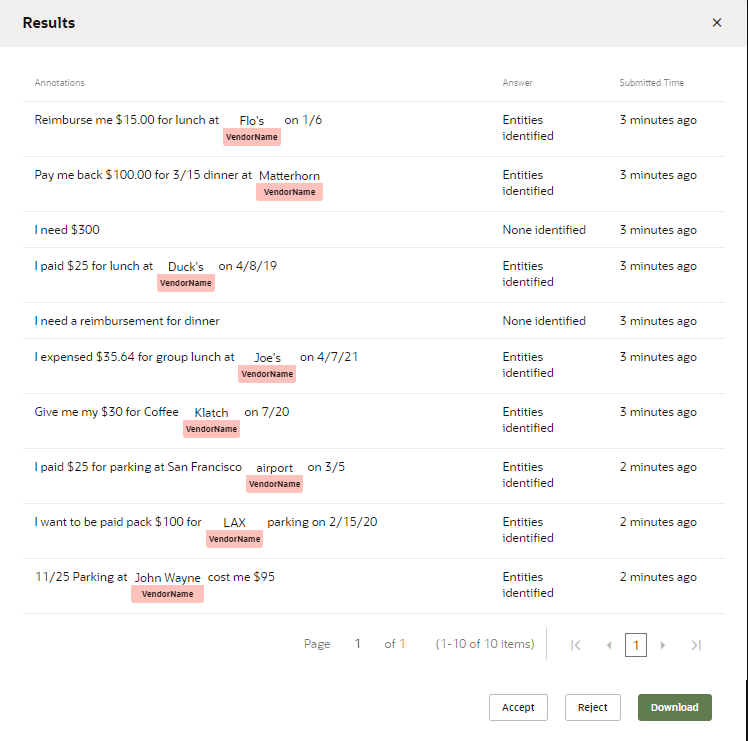

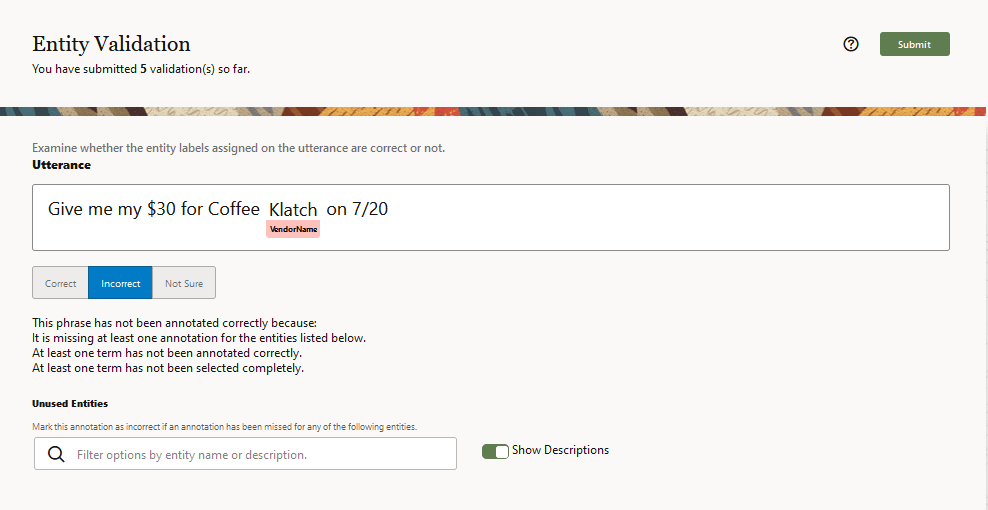

Examen d'un travail de validation

Une fois le travail de validation terminé par les crowdworkers (ou une fois que vous avez annulé le travail car vous le considérez comme terminé), vous pouvez le visualiser, l'accepter ou le rejeter dans son intégralité. Même si les travaux de validation peuvent contenir des milliers de résultats (raison pour laquelle vous recourez au crowdsourcing), vous pouvez toujours les examiner individuellement. Par exemple, vous pouvez identifier des réponses avec lesquelles vous n'êtes pas d'accord dans la boîte de dialogue Afficher les résultats. Vous devez les modifier ou les enlever avant de valider les résultats dans vos données d'entraînement.

Description de l'illustration review-validation-job.png

- Téléchargez le travail en tant que fichier CSV, à partir de la boîte de dialogue Afficher les résultats ou en cliquant sur Télécharger en local sur la page Résultats.

- Ouvrez le fichier CSV dans un tableur.

- Comparez les entrées dans les colonnes

IntentNameet d'invite, puis modifiez l'entrée de résultat si nécessaire. Vous pouvez modifier uniquement cette colonne ou enlever une ligne entière.

De manière générale, vous devez vous concentrer uniquement sur ces trois colonnes. Cela étant, vous pouvez trier les données sur la colonne du contributeur afin d'isoler le travail d'un crowdworker particulier. Si ses décisions ne sont pas fiables, vous pouvez supprimer toutes les lignes de ce contributeur.Remarque

Si vous supprimez une ligne, veillez à la supprimer entièrement. Vous ne pouvez pas télécharger vers le serveur un fichier CSV avec une ligne partielle. - Lorsque vous avez terminé, cliquez sur Télécharger vers le serveur sur la page Résultats. Parcourez l'arborescence pour sélectionner le fichier CSV. Sélectionnez Validation, entrez un nom, puis cliquez sur Télécharger vers le serveur.

- Cliquez sur Accepter ou Rejeter. Si vous acceptez le travail, seules les variations "correctes" sont ajoutées à l'ensemble d'entraînement. Vous ne pouvez pas annuler cette opération. Vous ne pouvez enlever ces variations que manuellement.

- Entraînez de nouveau la brique.

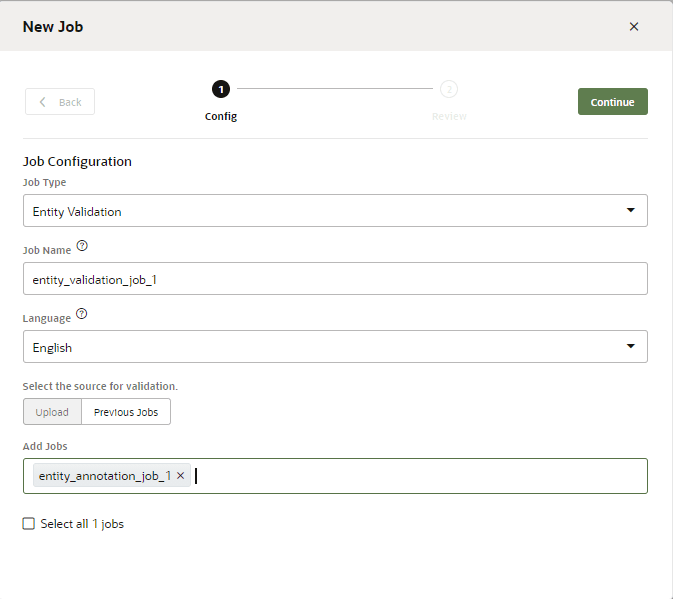

Création d'un travail de validation d'annotation d'entité

- Cliquez sur Nouveau travail sur la page Travaux.

- Sélectionnez Validation d'entité.

- Entrez un nom.

- Saisissez la langue utilisée par les crowdworkers.

- Vous pouvez charger un fichier CSV à partir de votre système local, sélectionner un ou plusieurs travaux d'annotation d'entité terminés (qui incluent les travaux que les salariés ont terminés ou que vous avez annulés) ou les combiner pour créer un seul travail. Le format du fichier CSV est le même que celui utilisé pour ajouter des variations annotées à un travail d'annotation d'entité : il contient la colonne

annotationet les objets JSON uniques pour les variations :annotation "[ { ""Utterance"":{ ""utterance"":""I want to order a family size pepperoni pizza with thin crust and mozzarella cheese"", ""languageTag"":""en"", ""entities"":[ { ""entityValue"":""family"", ""entityName"":""MLPizzaCrust"", ""beginOffset"":18, ""endOffset"":24 }, { ""entityValue"":""mozzarella"", ""entityName"":""MLCheeseType"", ""beginOffset"":66, ""endOffset"":76 }, { ""entityValue"":""pepperoni"", ""entityName"":""MLPizzaType"", ""beginOffset"":30, ""endOffset"":39 } ] } } ]" ... - Cliquez sur Continuer, vérifiez le nombre d'enregistrements, puis cliquez sur Lancer.

- Collez le lien dans un courriel envoyé aux crowdworkers.

Une fois que les crowdworkers ont accepté le travail, ils consultent les règles de base pour l'évaluation des annotations. A partir de là, ils examinent les annotations en les classant comme correctes, incorrectes ou incertaines.

Vous pouvez surveiller la progression du crowdworker à partir de la page Travaux. Une fois le travail terminé, vous pouvez vérifier les résultats avant de l'accepter ou de le rejeter.

En cliquant sur Accepter, vous ajoutez les résultats corrects au jeu d'entraînement de l'entité d'apprentissage automatique. Si nécessaire, vous pouvez les modifier davantage dans l'onglet Jeu de données.

Créer des suites de tests

- Sélectionnez le rapport dans la page Résultats, puis cliquez sur

- sélectionnez Suite de tests.

- Renseignez la boîte de dialogue en indiquant le nom et la suite de tests et en sélectionnant la langue dans laquelle les variations seront testées. Cliquez ensuite sur Créer.

- Ouvrez le testeur de variations pour exécuter la suite de tests.