동일한 리전의 클라우드 데이터베이스 간에 데이터 복제

개요

Oracle Cloud Infrastructure GoldenGate를 사용하면 동일한 리전 내에서 지원되는 데이터베이스를 복제할 수 있습니다. 다음 단계에서는 Oracle Data Pump를 사용하여 Target Database를 instantiate하고 소스에서 대상으로 데이터를 복제하는 방법을 설명합니다.

이 빠른 시작은 LiveLab으로도 제공됩니다. 워크샵 보기

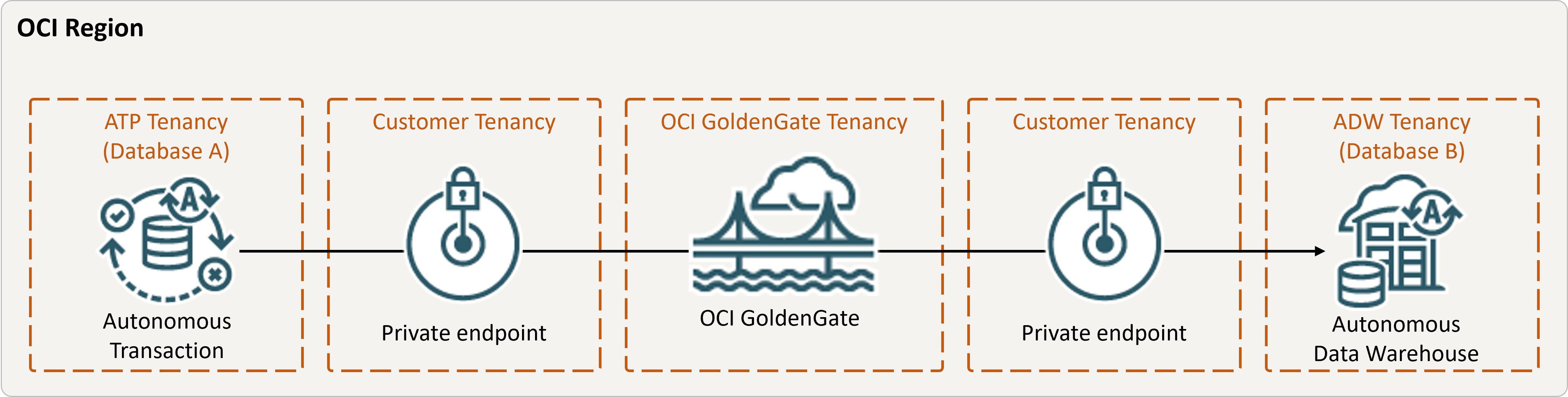

그림 same-region.png에 대한 설명

시작하기 전에

계속하려면 다음이 있어야 합니다.

- 기존 소스 데이터베이스

- 기존 대상 데이터베이스

- 소스 및 대상 데이터베이스는 동일한 영역의 단일 테넌시에 있어야 합니다.

- 샘플 데이터가 필요한 경우 Archive.zip을 다운로드한 다음 Lab 1, Task 3: Load the ATP schema의 지침을 따릅니다.

작업 3: Oracle Data Pump를 사용하여 데이터 엑스포트(ExpDP)

Oracle Data Pump(ExpDP)를 사용하여 원본 데이터베이스에서 Oracle Object Store로 데이터를 엑스포트합니다.