第2章 Oracle Private Cloud Applianceのモニタリングおよび管理

Oracle Private Cloud Applianceのモニタリングおよび管理は、Oracle Private Cloud Appliance Dashboardを使用して行います。 このwebベースのグラフィカル・ユーザー・インタフェースは、アプライアンスのパッケージ化に含まれるクイック・スタート・ポスターで提供されている手順を超えて、アプライアンスの初期構成を実行するためにも使用されます。

システムを起動して初期構成を適用する前に、「Oracle Private Cloud Applianceリリース・ノート」を読んで理解してください。 「既知の制約および回避策」の項には、このドキュメントの手順を正しく実行するために重要な情報が記載されています。 リリース・ノートを無視すると、システムを誤って構成する可能性があります。 システムを通常の動作に戻すには、完全な出荷時リセットが必要です。

Oracle Private Cloud Applianceダッシュボードでは、次のタスクを実行できます。

-

「セクション2.3、「ネットワーク設定」」で説明されている、ネットワーク環境ウィンドウを使用したアプライアンスの初期ソフトウェア構成(および再構成)。

-

「セクション2.2、「ハードウェア・ビュー」」で説明されているハードウェア・ビュー・ウィンドウからアクセスできる、アプライアンスで使用される各ハードウェア・コンポーネントのハードウェア・プロビジョニングのモニタリングと識別。

-

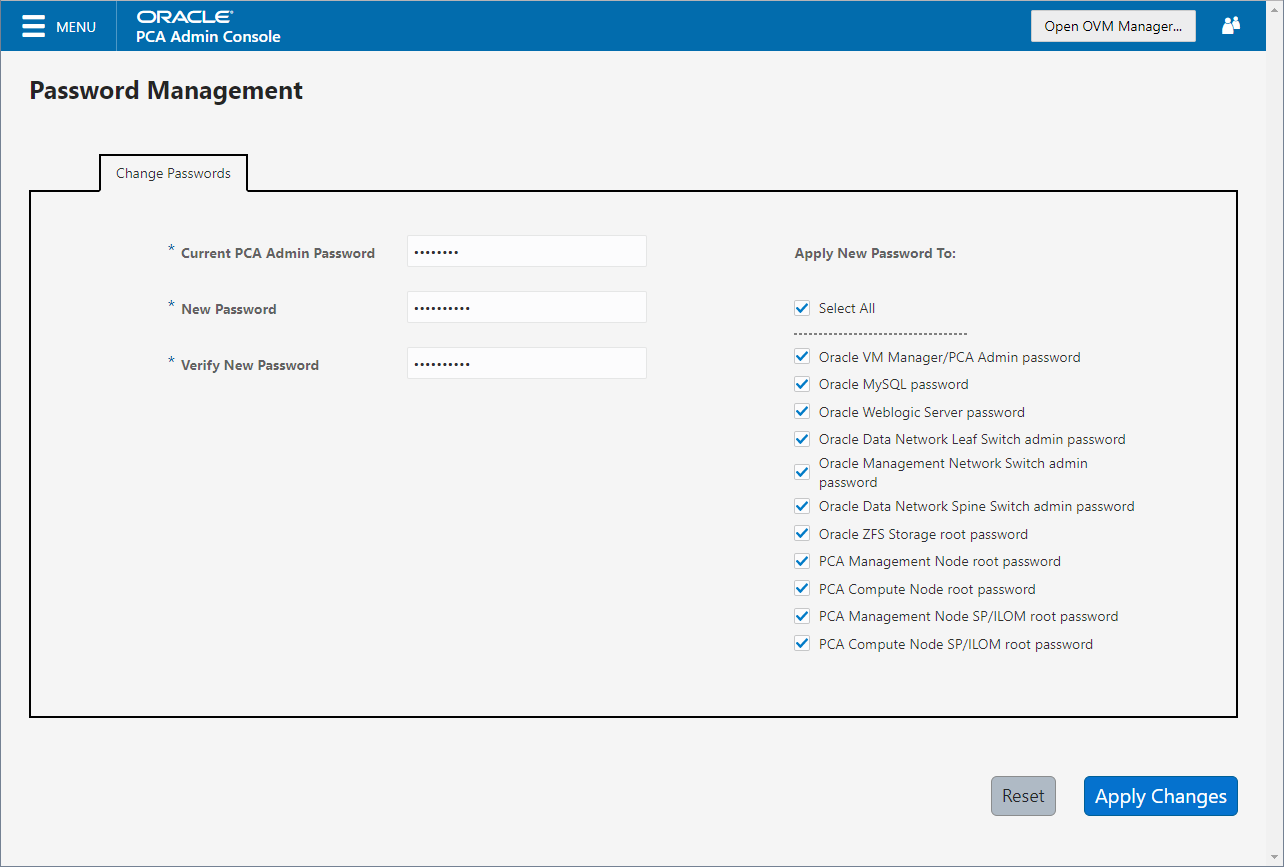

第2.8項、「認証」の説明に従い、パスワード管理ウィンドウを使用して、アプライアンス内の様々なコンポーネントに使用されるパスワードをリセットします。

Oracle Private Cloud Appliance Controllerソフトウェアには、ダッシュボード・ユーザー・インタフェースでは現在使用できない機能が含まれています。

-

バックアップ

Oracle Private Cloud Appliance内のすべてのコンポーネントの構成は、crontabエントリに基づいて自動的にバックアップされます。 この機能は構成可能ではありません。 バックアップのリストアには、Oracleに限定されたサービス担当者の介入が必要です。 詳細は、第1.6項、「Oracle Private Cloud Applianceバックアップ」を参照してください。

-

更新

更新プロセスは、Oracle Private Cloud Appliance Upgraderを使用して、アクティブな管理ノードのコマンドラインから制御されます。 詳細は、第1.7項、「Oracle Private Cloud Applianceのアップグレーダ」を参照してください。 ステップごとの指示は、「第3章Oracle Private Cloud Applianceの更新」を参照してください。

-

カスタム・ネットワーク

デフォルト・ネットワーク構成で十分でない場合は、コマンドライン・インタフェースにより、アプライアンス・レベルで追加のネットワークを作成できます。 詳細および段階的なステップは、「セクション2.5、「ネットワークのカスタマイズ」」を参照してください。

-

テナント・グループ

コマンドライン・インタフェースでは、必要に応じてOracle Private Cloud Appliance環境を多数の分離されたコンピュート・ノード・グループに分割するコマンドが提供されます。 このようなサーバーのグループはテナント・グループと呼ばれ、Oracle VMで異なるサーバー・プールとして反映されます。 詳細および段階的なステップは、第2.7項、「テナント・グループ」を参照してください。

2.1 Oracle Private Cloud Applianceダッシュボードへの接続とログイン

Oracle Private Cloud Applianceダッシュボードのログイン・ページを開くには、Webブラウザに次のアドレスを入力します。

https://manager-vip:7002/dashboard

manager-vipは、インストール時に管理ノード用に構成した共有仮想IPアドレスを指します。 共有仮想IPアドレスを使用することで、必ずアクティブ管理ノードのOracle Private Cloud Applianceダッシュボードにアクセスできます。

インストール・プロセスの後にOracle Private Cloud Applianceダッシュボードに初めてアクセスする場合、アクティブ管理ノードで使用されている仮想IPアドレスは、出荷時のデフォルト192.168.4.216に設定されます。 これは内部アプライアンス管理ネットワークのIPアドレスで、Cisco Nexus 9348GC-FXPスイッチで、ワークステーションによってパッチが適用され、使用可能なEthernetポート48に直接アクセスした場合にのみアクセスできます。

ファイアウォールは、ファイアウォールされた接続を介してOracle Private Cloud Applianceダッシュボードにアクセスする場合、Oracle Private Cloud Applianceダッシュボードが接続をリスニングするために使用しているポートでTCPトラフィックを許可するように構成されている必要があります。

「ユーザー名」フィールドに、Oracle Private Cloud Applianceダッシュボード管理ユーザー名を入力します。 これは、インストール時に構成した管理ユーザー名です。 「パスワード」フィールドに、Oracle Private Cloud Applianceダッシュボード管理ユーザー名のパスワードを入力します。

Oracle Private Cloud Applianceダッシュボードでは、セッション・データを格納するためにcookieを使用します。 したがって、Oracle Private Cloud Applianceダッシュボードを正常にログインして使用するには、webブラウザがOracle Private Cloud Applianceダッシュボード・ホストからのcookieを受け入れる必要があります。

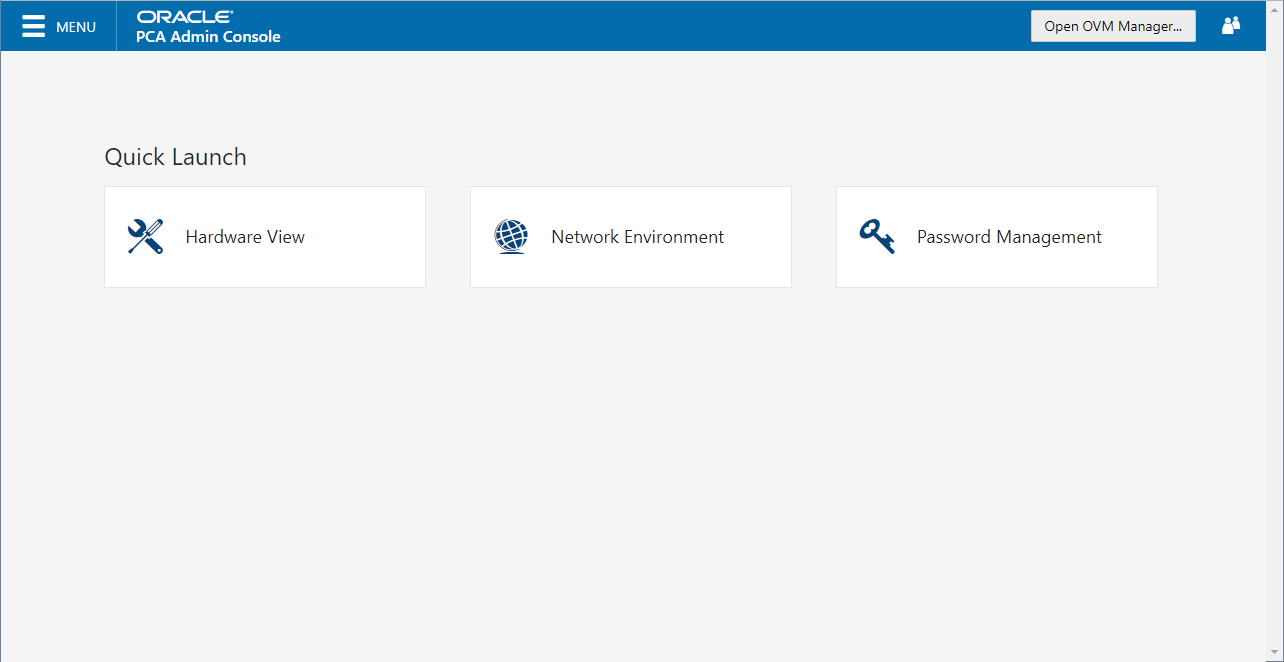

ダッシュボードへのログインに成功すると、ホーム・ページが表示されます。 ページの中央には、主要な機能領域に直接アクセスできるクイック起動ボタンがあります。

各ダッシュボード・ウィンドウから、左上隅にあるメニューをクリックして、リストから別のウィンドウを選択すると、いつでも他のウィンドウに移動できます。 ヘッダー領域のボタンで、Oracle VM Managerを開くことができます。

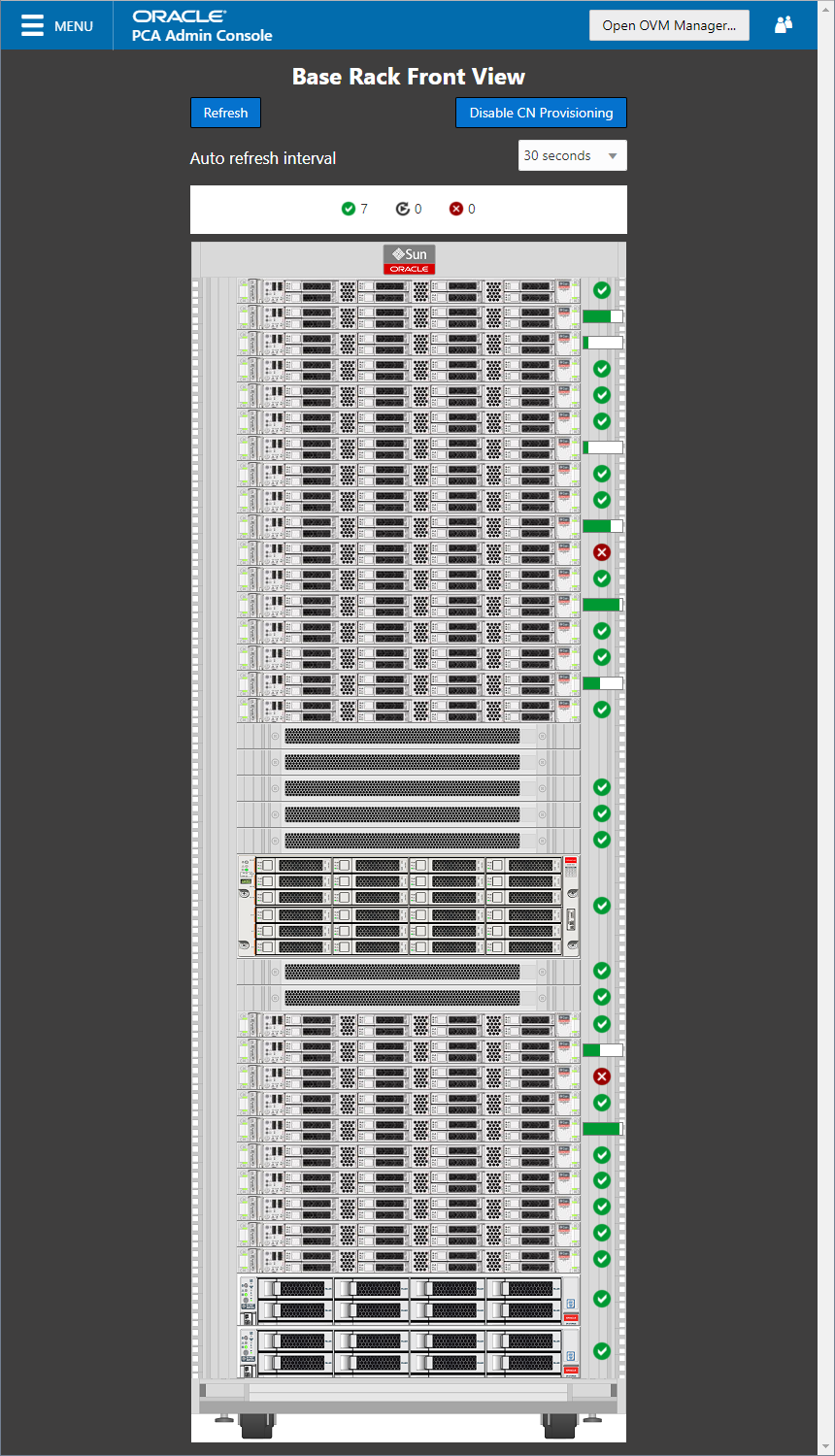

2.2 ハードウェアビュー

Oracle Private Cloud Appliance Dashboard内の「ハードウェア・ビュー」ウィンドウでは、ラック内にインストールされたとおりにハードウェア・コンポーネントがグラフィカルに表示されます。 これらのコンポーネントのステータスの表示は、デフォルトで30秒ごとに自動的にリフレッシュされます。 リフレッシュ間隔を設定、あるいは自動リフレッシュ間隔リストで無効にできます。 あるいは、ページ上部のボタンを使用して、いつでもビューをリフレッシュできます。

管理ノードのアップグレードなどの特定のメンテナンス・タスク中に、コンピュート・ノードのプロビジョニングを一時的に無効にする必要がある場合があります。 ページの上部にあるこのボタンを使用すると、プロビジョニング・アクティビティを一時停止できます。 コンピュート・ノードのプロビジョニングが一時停止されると、ボタン・テキストがに変わり、必要に応じてコンピュート・ノード・プロビジョニングを再開できるようになります。

マウスでグラフィックの各アイテムをロールオーバーすると、コンポーネントの名前、タイプおよび構成とステータス情報のサマリーを示すポップアップ・ウィンドウが表示されます。 コンピュート・ノードの場合、ポップアップ・ウィンドウにはボタンが表示されます。このボタンを使用すると、断続的な状態のノードがスタックした場合や、Oracle VMサーバー・プールに追加される前にエラー・ステータスになった場合に、プロビジョニング・プロセスを再起動できます。 「セクション7.8「プロビジョニング失敗時のコンピュート・ノードの再プロビジョニング」」には、コンピュート・ノードの再プロビジョニング手順が用意されています。

「唯一の」では、プロビジョニングの完了に失敗したコンピュート・ノードにボタンが使用されます。 仮想マシンが適切にプロビジョニングされているか、または仮想マシンが実行されているホスト(あるいはその両方)ノードの場合、ボタンは不正使用を防ぐために使用できなくなり、正常なコンピュート・ノードが機能の損失やデータ破損が防止されるか、環境から永続的にロックされます。

再編成によって、コンピュート・ノードがクリーン状態にリストアされます。 コンピュート・ノードが以前にOracle VM環境に追加されており、内部ZFSストレージのストレージ・リポジトリ以外のストレージ・リポジトリに対してアクティブな接続を持っている場合は、再プロビジョニング後に外部ストレージ接続を再度構成する必要があります。

アプライアンス・ラック内に取り付けられている各コンポーネントのそばに、ステータス・アイコンがコンポーネントのprovisioning statusを示します。 ステータス・サマリーがラック・イメージのすぐ上に表示され、アイコンと数、プロビジョニングされているノード、またはエラー・ステータスのノード数が示されます。 ハードウェア・ビューでは、アクティブなコンポーネントに関するリアルタイムのヘルスおよびステータス情報は提供されません。 そのモニタリング機能は、プロビジョニング・プロセスに制限されています。 コンポーネントが完全かつ正しくプロビジョニングされていると、コンポーネントが障害が発生したり電源が切断されたりしても、ハードウェア・ビューでは正しい操作が示され続けます。 異なるステータス・アイコンとその意味の概要は、「表2.1」を参照してください。

|

アイコン |

ステータス |

説明 |

|---|---|---|

|

|

OK |

コンポーネントは正常に実行中であり、すべてのヘルス・チェック操作に合格しました。 プロビジョニングが完了しました。 |

|

|

プロビジョニング |

コンポーネントは実行中で、プロビジョニングは進行中です。 コンポーネントがプロビジョニングの様々なステージを通過すると、進捗バーが表示されます。 コンピュート・ノードの主なステージは次のとおりです: HMPの初期化アクション、Oracle VM Serverインストール、ネットワーク構成、ストレージ設定およびサーバー・プール・メンバーシップ。 |

|

|

エラー |

コンポーネントは稼働中ではなく、ヘルス・チェック操作が失敗しました。 コンポーネントのトラブルシューティングが必要です。また、コンポーネントの交換が必要な場合もあります。 プロビジョニングに失敗した場合、コンピュート・ノードもこのステータスになります。 |

プロビジョニング後のアクティブなOracle Private Cloud Applianceハードウェアのリアルタイムのヘルスとステータスの情報は、Oracle VM ManagerまたはOracle Enterprise ManagerのUIを参照してください。

ハードウェア・ビューは、Oracle Private Cloud Appliance内のハードウェア・コンポーネントのトラブルシューティングや、これらのコンポーネントが実際にラック内の場所を特定するためのアクセス可能なツールを提供します。 コンポーネントを交換する必要がある場合、新しいコンポーネントは、構成を維持するためにラック内の古いコンポーネントの位置を取る必要があります。

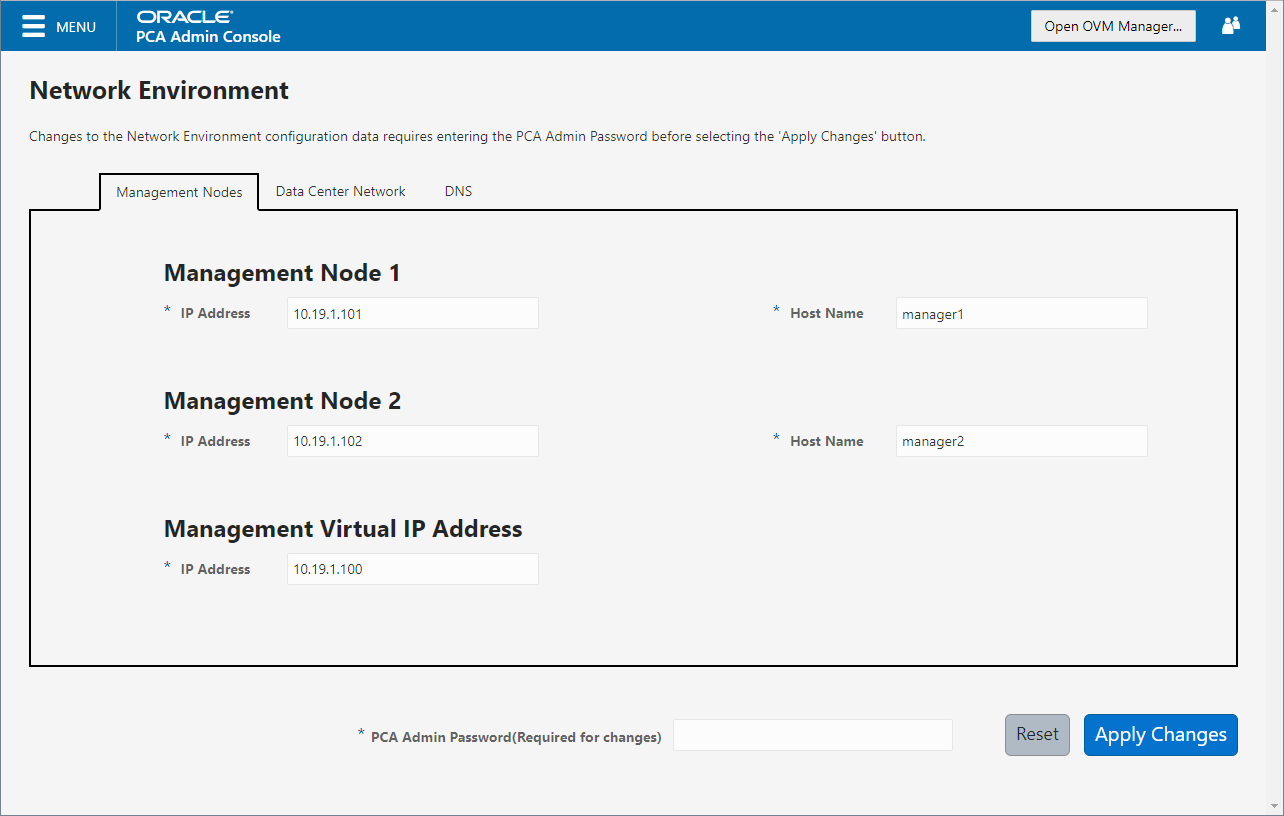

2.3 ネットワーク設定

「ネットワーク環境」ウィンドウは、管理ノードのネットワーキングおよびサービスの情報を構成するために使用します。 この目的のために、パブリック(データ・センター)ネットワーク内に3つのIPアドレスを予約する必要があります: 各管理ノードに1つ、および両方の管理ノードによって仮想IPアドレスとして使用されるノード。 仮想IPアドレスによって、ソフトウェアの初期化が完了するとダッシュボードにアクセスできるようになります。

ネットワークの干渉および競合を回避するには、データ・センター・ネットワークがOracle Private Cloud Applianceのデフォルト構成のインフラストラクチャ・サブネットのいずれとも重複していないことを確認する必要があります。 これらは、クリアしておく必要があるサブネットおよびVLANです。

サブネット:

-

192.168.4.0/24 - 内部マシン管理ネットワーク: ILOMと物理ホストの接続

-

192.168.32.0/21 - 内部管理ネットワーク: 管理ノードとコンピュート・ノード間のトラフィック

-

192.168.64.0/21 - アプライアンス環境内の東/西トラフィックのための基礎ネットワーク

-

192.168.72.0/21 - 北/南トラフィック用の基礎ネットワーク、外部接続を可能にする

-

192.168.40.0/21 - storage network: サーバーとZFSストレージ・アプライアンス間のトラフィック

各/21サブネットは、8つの/24サブネットまたは2000以上のIPアドレスのIP範囲で構成されます。 次に例を示します: 192.168.32.0/21は、192.168.32.1から192.168.39.255へのすべてのIPアドレスに対応しています。

VLAN:

-

1 - CiscoのデフォルトVLAN

-

3040 - デフォルト・サービスVLAN

-

3041-3072- 顧客VMおよびホスト・ネットワーク用に予約された31 VLANの範囲

-

3073-3099-システム・レベルの接続用に予約されている範囲

ノートVLAN 3073-3088は、内部ZFS機能へのVMアクセスに使用されています

VLAN 3090-3093は、前述の

/21サブネット経由のタグ付けされたトラフィックですでに使用されています。 -

3968-4095- Ciscoの内部デバイスの割当て用に予約された範囲

「ネットワーク環境」ウィンドウは3つのタブに分かれています: 管理ノード、データ・センター・ネットワークおよびDNS。 この項には、使用可能な構成フィールドの説明とともに各タブが表示されます。

リセット・ボタンをクリックすると、どのタブでも変更を元に戻すことができます。 行った構成の変更を確認するには、ウィンドウの下部にある適用可能なフィールドにダッシュボード管理ユーザーのパスワードを入力し、変更の適用をクリックします。

変更の適用をクリックすると、3つすべてのタブの構成設定が適用されます。 続行する前に、すべてのタブのすべての必須フィールドに有効な情報が含まれていることを確認してください。

「図2.4」に「管理ノード」タブが表示されます。 構成には次のフィールドを使用できます。

-

管理ノード 1:

-

IPアドレス: データ・センター・ネットワーク内のIPアドレスを指定します。このIPアドレスを使用すると、この管理ノードに直接アクセスできます。

-

ホスト名: 最初の管理ノード・システムのホスト名を指定します。

-

-

管理ノード 2:

-

IPアドレス: データ・センター・ネットワーク内のIPアドレスを指定します。このIPアドレスを使用すると、この管理ノードに直接アクセスできます。

-

ホスト名: 2番目の管理ノード・システムのホスト名を指定します。

-

-

管理仮想IPアドレス: アクティブ管理ノードに常にアクセスするために使用する共有仮想IPアドレスを指定します。 このIPアドレスは、各管理ノードに指定したIPアドレスと同じサブネットにある必要があります。

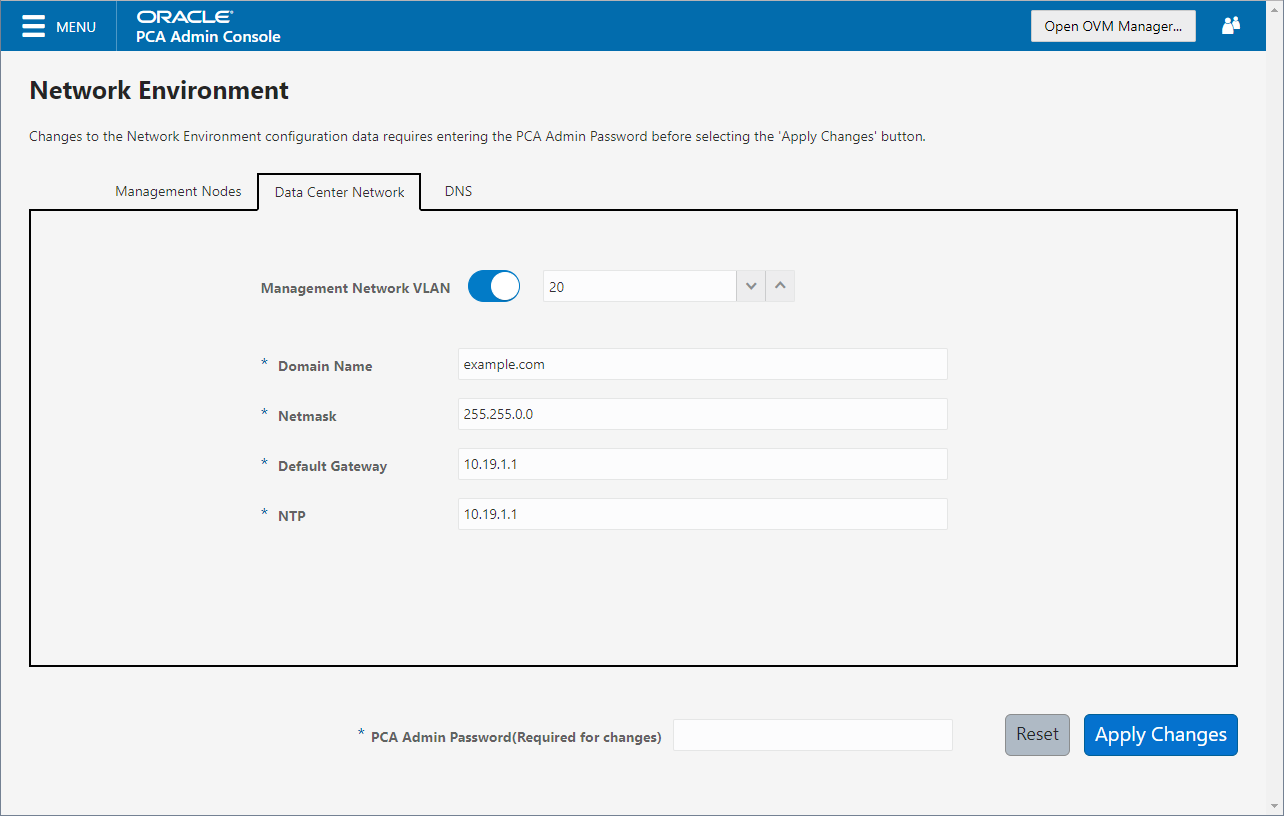

「図2.5」に「データ・センター・ネットワーク」タブが表示されます。 構成には次のフィールドを使用できます。

-

管理ネットワークVLAN: デフォルトの構成では、管理ネットワークがVLAN上に存在するものとはみなされません。 管理ネットワークのスイッチにVLANを構成した場合、スライダをactive設定に切り替えて、指定のフィールドにVLAN IDを指定します。

注意管理ネットワークにVLANを使用し、同じネットワーク上でVMトラフィックを有効化する必要がある場合は、必要なコンピュート・ノードのvx13040インタフェース上にVLANインタフェースを手動で構成し、IDを持つVLANに接続する必要があります。 コンピュート・ノードにVLANインタフェースを作成する手順については、Oracle VMドキュメントの「VLANを作成」セクションを参照してください。

-

ドメイン名: 管理ノードが属するデータ・センター・ドメインを指定します。

-

ネットマスク: 仮想IPアドレスおよび管理ノードのIPアドレスが属するネットワークのネットマスクを指定します。

-

デフォルト・ゲートウェイ: 仮想IPアドレスおよび管理ノードのIPアドレスが属するネットワークのデフォルト・ゲートウェイを指定します。

-

NTP: 管理ノードおよびその他のアプライアンス・コンポーネントがクロックの同期に使用する必要があるNTPサーバーを指定します。

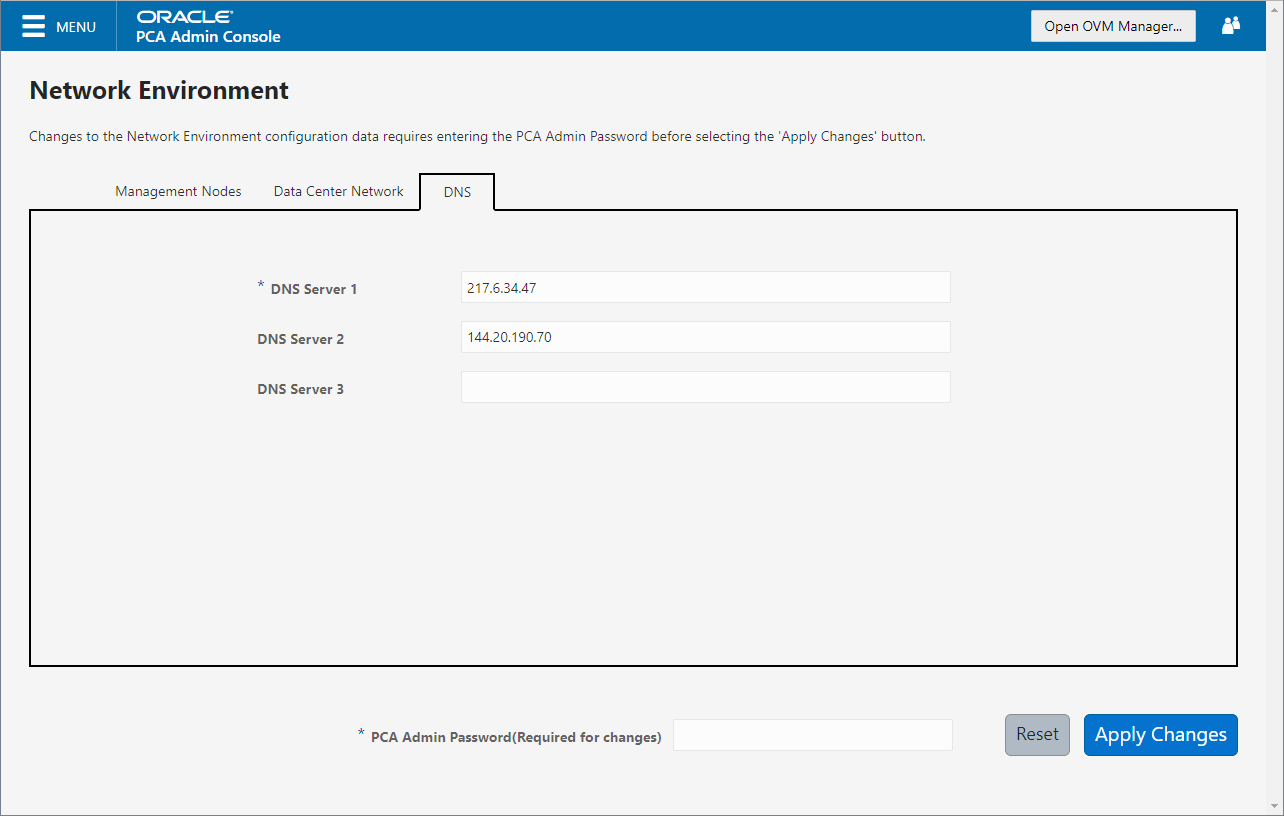

「図2.6」に「データ・センター・ネットワーク」タブが表示されます。 構成には次のフィールドを使用できます。

-

DNSサーバー1: 管理ノードでドメイン名解決に使用できるDNSサーバーを1つ以上指定します。

-

DNSサーバー2: オプションで、第2のDNSサーバーを指定します。

-

DNSサーバー3: オプションで、3つ目のDNSサーバーを指定します。

これらの設定を変更するには、現在のOracle Private Cloud Appliance 「管理者」アカウント・パスワードを入力する必要があります。 ページの下部にあるボタンをクリックすると、現在3つの「ネットワーク環境」タブすべてに入力されている設定が保存され、各管理ノードの構成が更新されます。 ovcaサービスはプロセス内で再起動されるため、後でダッシュボードに再度ログインする必要があります。

2.4 機能ネットワークの制限

Oracle Private Cloud Appliance環境には、ネットワーク構成の様々なレベルおよび領域があります。 ホスト・インフラストラクチャと仮想化環境の両方の正しい操作を行うには、管理者が異なるカテゴリのネットワークを機能的に区別できること、およびすべてのネットワークの構成方法と場所を把握することが重要です。 この項は、メインのネットワーク管理操作を実行するのに適したインタフェースを選択するためのガイダンスとして記載されています。

機能の観点から、実質的にはすべてのネットワークがアプライアンス・レベルまたは仮想化レベルのいずれかで動作します。 それぞれに独自の管理インタフェースがあります: 一方ではOracle Private Cloud ApplianceダッシュボードとCLI、他方ではOracle VM Managerです。 ただし、Oracle VMのネットワークはインフラストラクチャ・レベルの既存の構成に大きく依存するため、ネットワーク構成は明確に分離されていません。 たとえば、Oracle VM Managerで新しいパブリック仮想マシン・ネットワークを構成するには、ホストまたはコンピュート・ノードに、データ・センターのネットワークまたはインターネットへのゲートウェイを使用して基礎となるネットワークにすでに接続されているネットワーク・ポートがある必要があります。

かなりの構成 - ネットワークおよびその他 - コンピュート・ノード・プロビジョニング中にアプライアンス・レベルからOracle VMにプッシュされます。 これは、階層が存在することを意味します。標準の仮想マシン管理以外にOracle VM Managerで変更を行う前に、アプライアンス・レベルの構成操作について検討する必要があります。

2.4.1 ネットワークの構成

この項では、Oracle Private Cloud ApplianceおよびOracle VMネットワーク構成について説明します。

-

仮想マシン・ネットワーク

デフォルトでは、完全にプロビジョニングされたOracle Private Cloud Applianceは、仮想マシンのデプロイメントに対応しています。 Oracle VM Managerでは、仮想マシンを次のネットワークに直接接続できます。

-

プロビジョニング時にすべてのコンピュート・ノードの

vx13040VxLANインタフェース上で作成されるdefault_external -

プロビジョニング時にすべてのコンピュート・ノードの

vx2VxLANインタフェース上で作成されるdefault_internal

また、「仮想マシン」ロールを使用して追加のVLANインタフェースおよびVLANを作成することもできます。 パブリック接続が必要な仮想マシンの場合、コンピュート・ノード

vx13040VxLANインタフェースを使用します。 内部専用のVMトラフィックの場合は、vx2VxLANインタフェースを使用します。 詳細は、第5.6項、「仮想マシンのネットワーク・リソースの構成」を参照してください。ノートethポートを使用して仮想マシン・ネットワークを作成しないでください。 これらは物理コンピュート・ノード・ネットワーク・インタフェースとしてOracle VM Managerで検出されますが、配線されません。 また、xbondxOracle VM Manager Oracle VM ManagerポートおよびデフォルトのVLANインタフェース(tun-ext、tun-int、mgmt-intおよびstorage-int)は、アプライアンスのインフラストラクチャの一部であり、VMネットワーク構成では使用されません。カスタム・ネットワークを介して、仮想マシンのネットワーキングを強化したり分離できます。これについては、次で説明します。 カスタム・ネットワークは、Oracle Private Cloud Appliance CLIで作成する必要があります。 これにより、デフォルトの

vx13040およびvx2に相当する追加のVxLANインタフェースが生成されます。 カスタム・ネットワークおよび関連するネットワーク・インタフェースは自動的にOracle VM Managerで設定され、仮想マシンのネットワーク構成を新しく検出されたネットワーク・リソースで展開できます。 -

-

カスタム・ネットワーク

カスタム・ネットワークは、デフォルトの構成に加えて作成するインフラストラクチャ・ネットワークです。 これらは、デフォルトのプライベート・ネットワークとパブリック・ネットワークと同様に構成されますが、異なるコンピュート・ノードのネットワーク・インタフェースを使用し、異なるスパイン・スイッチのポートで終了します。 パブリック接続が必要な場合は、スパイン・スイッチと次のレベルのデータ・センター・スイッチの間の追加のケーブル接続が必要です。

これらは基礎となるOracle VMのインフラストラクチャの一部であるため、すべてのカスタム・ネットワークはOracle Private Cloud Appliance CLIを使用して構成する必要があります。 管理者は3つのタイプを選択します: プライベート、パブリックまたはホスト・ネットワーク。 各タイプの用途と構成の詳細は、「セクション2.5、「ネットワークのカスタマイズ」」を参照してください。

個別のOracle VMサーバー・プールである追加のテナント・グループが環境にある場合、カスタム・ネットワークを1つ以上のテナント・グループに関連付けることができます。 これにより、異なるテナント・グループに属するトラフィックと、その一部としてデプロイされた仮想マシンを安全に分離できます。 詳細は、第2.7項、「テナント・グループ」を参照してください。

Oracle Private Cloud Appliance CLIを使用してカスタム・ネットワークが完全に構成されると、ネットワークとそれに関連付けられたポートがOracle VM Managerに自動的に表示されます。 新しいVxLANインタフェースの上位に追加のVLANインタフェースを構成してから、仮想マシンの接続性のためにさらにVLANを作成するために使用することもできます。 ホスト・ネットワークは特殊なタイプのカスタム・パブリック・ネットワークであり、「ストレージ」ネットワーク・ロールを引き継いだり、外部ストレージをコンピュート・ノードに直接接続できます。

-

NETWORKプロパティ

ネットワーク・ロールはOracle VM内で使用されるプロパティです。 構成するほとんどのネットワークは「仮想マシン」ロールを持っていますが、ストレージ接続性または仮想マシンの移行に別のネットワークを使用することもできます。 ネットワーク・ロール - また、接続されるインタフェース、インタフェースのプロパティなど、名前や説明などの他のプロパティ - Oracle VM Managerでは、アプライアンス・レベルで定義されているプロパティと競合しないかぎり構成できます。

Oracle VM Managerで構成したVMネットワークのネットワーク・プロパティを変更するには、ほとんどリスクはありません。 ただし、構成は変更しないでください。 - ネットワーク・ロール、ポートなど - デフォルト・ネットワーク: eth_management、mgmt_internal、storage_internal、underlay_external、underlay_internal、default_externalおよびdefault_internal。 カスタム・ネットワークを含むコンピュート・ノードを接続するネットワークの場合は、Oracle Private Cloud Appliance CLIを使用する必要があります。 さらに、カスタム・ネットワークの機能プロパティを変更することもできません: このパッケージを削除して、必要なプロパティを指定した新規テンプレートを作成する必要があります。

ネットワーク・インタフェース、標準ポートまたはボンディングの最大転送単位(MTU)は変更できません。 これは、Oracle VM Manager内から制御できないハードウェア・プロパティまたはSDN構成によって決定されます。

-

VLAN管理

SDNを介して構成された基礎VLANネットワークと、Oracle Private Cloud Applianceダッシュボードの「ネットワーク設定」タブで構成したアプライアンス管理VLANを除き、すべてのVLAN構成および管理操作がOracle VM Managerで実行されます。 これらのVLANは、VMネットワークの一部です。

ヒント多数のVLANが必要な場合、プロセスには時間がかかるため、一度にそれらをすべて生成しないことをお勧めします。 かわりに、10のグループ内でVLANを追加(または削除)します。

2.5 ネットワークのカスタマイズ

Oracle Private Cloud Applianceコントローラ・ソフトウェアにより、アプライアンス・レベルでカスタム・ネットワークを追加できます。 これは、特定のハードウェア・コンポーネントでは、追加の接続を有効にするために構成の変更が必要であることを意味します。 その後、新しいネットワークがOracle VM環境に自動的に構成され、デフォルトのネットワーク構成の機能を超えるネットワーク・トラフィックの分離および最適化に使用できます。 内部およびパブリックの両方のカスタム・ネットワークはすべて、VLAN対応です。

Oracle Private Cloud Applianceでホストされている仮想マシンは、Oracle VM Managerがアクセス可能になるとすぐに、デフォルトの外部向けネットワークを介して外部コンピュート・リソースおよびストレージにアクセスできます。

追加のネットワーク機能が必要な場合は、カスタム・ネットワークを構成し、仮想マシンおよびコンピュート・ノード用に構成できます。 たとえば、カスタム・ネットワークでは、仮想マシンに追加の帯域幅や外部コンピュート・リソースまたはストレージへの追加アクセスを提供できます。 または、コンピュート・ノードが外部ストレージに含まれるストレージ・リポジトリおよびデータ・ディスクにアクセスする必要がある場合は、カスタム・ネットワークを使用できます。 次のセクションでは、これらのカスタム・ネットワーク用にOracle Private Cloud Applianceを構成して配線する方法について説明します。

アップグレード操作の実行中は、ネットワーク構成を変更しないでください。 アップグレード時には管理操作がサポートされていません。これにより、構成の不整合や重大な修復停止時間が発生する可能性があります。

Oracle VM Managerではカスタム・ネットワークを削除しないでください。 このように設定すると、非常に修復が困難なエラー状態のままになります。 停止時間およびデータ損失を回避するには、必ずOracle Private Cloud Appliance CLIでカスタム・ネットワーク操作を実行します。

ネットワークに関する次の制限事項が適用されます。

-

カスタム外部ネットワークの最大数は、テナント・グループまたはコンピュート・ノード当たり7です。

-

カスタム内部ネットワークの最大数は、テナント・グループまたはコンピュート・ノード当たり3です。

-

VLANの最大数は、テナント・グループごとまたはコンピュート・ノードごとに256です。

-

テナント・グループごと、またはコンピュート・ノードごとに、1つのホスト・ネットワークのみ割り当てることができます。

カスタム・ネットワークを構成する場合は、プロビジョニング操作または仮想マシン環境の変更が行われないことを確認してください。 これにより、Oracle VMリソースがロックされ、Oracle Private Cloud Appliance CLIコマンドが失敗することがあります。

カスタム・ネットワークを作成するには、CLIを使用する必要があります。 管理者は3つのタイプを選択します: アプライアンス内部のネットワーク、外部接続性のネットワーク、またはホスト・ネットワーク。 カスタム・ネットワークは、Oracle VM Managerで自動的に表示されます。 内部および外部ネットワークは「仮想マシン」ネットワーク・ロールを取りますが、ホスト・ネットワークは「仮想マシン」および「ストレージ」ネットワーク・ロールを持つ場合があります。

ホスト・ネットワークは外部ネットワークの特定のタイプです: その構成には、サブネットおよびルーティング用の追加パラメータが含まれています。 そのサブネットに接続されたサーバーは、そのサブネットのIPアドレスも受信します。その結果、外部のネットワーク・デバイスに接続できます。 ホスト・ネットワークは、ストレージ・デバイスに直接アクセスする場合に特に便利です。

2.5.1 カスタム・ネットワークの構成

外部接続を備えたすべてのネットワークでは、外部トラフィックをルーティングするようにこれらが再構成されるように、スパインCisco Nexus 9336C-FX2スイッチ・ポートを指定する必要があります。 これらのポートをケーブルで接続し、データセンター内の次レベルのスイッチに物理アップリンクを作成する必要があります。 詳細は、「Oracle Private Cloud Applianceインストレーション・ガイド」の「アプライアンスのアップリンク構成」を参照してください。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

カスタム・ネットワークにパブリック接続が必要な場合は、1つ以上のスパイン・スイッチのポートを使用する必要があります。 使用可能なポートの数を確認し、それに応じてネットワークのカスタマイズを慎重に計画してください。 次の例は、システムからその情報を取得する方法を示しています。

PCA> list network-port Port Switch Type State Networks ---- ------ ---- ----- -------- 1:1 ovcasw22r1 10G down None 1:2 ovcasw22r1 10G down None 1:3 ovcasw22r1 10G down None 1:4 ovcasw22r1 10G down None 2 ovcasw22r1 40G up None 3 ovcasw22r1 auto-speed down None 4 ovcasw22r1 auto-speed down None 5:1 ovcasw22r1 10G up default_external 5:2 ovcasw22r1 10G down default_external 5:3 ovcasw22r1 10G down None 5:4 ovcasw22r1 10G down None 1:1 ovcasw23r1 10G down None 1:2 ovcasw23r1 10G down None 1:3 ovcasw23r1 10G down None 1:4 ovcasw23r1 10G down None 2 ovcasw23r1 40G up None 3 ovcasw23r1 auto-speed down None 4 ovcasw23r1 auto-speed down None 5:1 ovcasw23r1 10G up default_external 5:2 ovcasw23r1 10G down default_external 5:3 ovcasw23r1 10G down None 5:4 ovcasw23r1 10G down None ----------------- 22 rows displayed Status: Success

-

外部接続を使用するカスタム・ネットワークの場合、このトラフィックで使用するアップリンク・ポートを使用してアップリンク・ポート・グループを構成します。 適切なブレークアウト・モードの選択

PCA> create uplink-port-group

MyUplinkPortGroup'1:1 1:2' 10g-4x Status: Successノートポートの引数は

'x:y'として指定されており、xはスイッチ・ポート番号、yはブレークアウト・ポートの番号です(スプリッタ・ケーブルがスイッチ・ポートにアタッチされている場合)。 上記の例は、その情報の取得方法を示しています。アップリンク・ポート・グループのブレークアウト・モードを設定する必要があります。 4方向の分割ケーブルを使用する場合、4つのすべてのポートを10Gbitまたは25Gbitに設定する必要があります。 プレークアウト・ケーブルを使用しない場合、接続要件に応じてアップリンク・ポート・グループのポート速度は100Gbitまたは40Gbitである必要があります。 コマンドの詳細は、第4.2.17項、「create uplink-port-group」を参照してください。

ネットワーク・ポートを複数のネットワーク構成の一部にすることはできません。

-

新しいネットワークを作成し、次のいずれかのタイプを選択します。

-

rack_internal_network: 外部ネットワークにアクセスできないOracle VM仮想マシン・ネットワーク。コンピュート・ノードにはIPアドレスが割り当てられていません。 このオプションを使用すると、仮想マシンがデフォルトの内部ネットワーク以外の帯域幅を追加できるようになります。 -

external_network: 外部ネットワークにアクセスできるOracle VM仮想マシン・ネットワーク。コンピュート・ノードにはIPアドレスが割り当てられていません。 このオプションは、デフォルトの外部向けネットワークとは別の物理ネットワーク上の外部ストレージにアクセスするときに、仮想マシンの追加帯域幅を許可する場合に使用します。 -

host_network: 外部ネットワークにアクセスできるOracle VMコンピュート・ノード・ネットワーク。IPアドレスはコンピュート・ノードに追加されます。 コンピュート・ノードがOracle Private Cloud Applianceの外部のストレージおよびコンピュート・リソースにアクセスできるようにするには、このオプションを使用します。 これは、仮想マシンがexternal_networkと同様に外部コンピュート・リソースにアクセスするために使用することもできます。

次の構文を使用します。

-

内部のみのネットワークの場合は、ネットワーク名を指定してください。

PCA> create network

MyInternalNetworkrack_internal_network Status: Success -

外部ネットワークの場合は、外部トラフィックに構成するネットワーク名とスパイン・スイッチのポート・グループを指定します。

PCA> create network

MyPublicNetworkexternal_networkMyUplinkPortGroupStatus: Success -

ホスト・ネットワークには、ネットワーク名、外部トラフィックに構成するスパイン・スイッチのポート、サブネットおよびルーティング構成(オプション)を指定します。

PCA> create network

MyHostNetworkhost_networkMyUplinkPortGroup\ 10.10.10 255.255.255.0 10.1.20.0/24 10.10.10.250 Status: Successノートこの例では、ホスト・ネットワークの追加のネットワークおよびルーティング引数は空白で区切って次のように指定されています。

-

10.10.10= サブネット・プレフィクス -

255.255.255.0= ネットワーク -

10.1.20.0/24=ルート宛先(サブネットまたはIPv4アドレスとして) -

10.10.10.250=ルート・ゲートウェイ

サブネット・プレフィクスとネットマスクは、ネットワークに参加するサーバーにIPアドレスを割り当てるときに使用します。 オプションのルート・ゲートウェイおよび宛先パラメータを使用して、サーバーのルーティング表の静的ルートを構成します。 デフォルトでは、ルート宛先は単一のIPアドレスです。したがって、サブネット内の異なるIPアドレスに対してトラフィックが予定されている場合は、ネットマスクを指定する必要があります。

ホスト・ネットワークを定義する場合、プレフィクス、ネットマスクおよびRoute_Destinationパラメータに対して無効な値または矛盾する値を入力できます。 たとえば、最初のオクテットとして0が付いたプレフィクスを入力した場合、0で始まるコンピュート・ノードのEthernetインタフェースでIPアドレスの構成が試行されます。 また、入力したルート宛先のネットマスク部分が無効の場合でも、例外が発生してもネットワークはまだ作成されています。 このように構成されていないネットワークが無効な状態の場合、標準コマンドで再構成または削除することはできません。 無効なネットワーク構成が適用されている場合は、

--forceオプションを使用してネットワークを削除します。ネットワーク作成コマンド引数の詳細は、第4.2.11項、「create network」でCLIリファレンスの章に記載されています。

注意ホスト・ネットワークのネットワークおよびルーティングのパラメータは変更できません。 これらの設定を変更するには、カスタム・ネットワークを削除し、更新された設定を使用して再作成します。

-

-

-

必要なサーバーを新しいカスタム・ネットワークに接続します。 接続するサーバーのネットワーク名および名前を指定する必要があります。

PCA> add network

MyPublicNetworkovcacn07r1Status: Success PCA> add networkMyPublicNetworkovcacn08r1Status: Success PCA> add networkMyPublicNetworkovcacn09r1Status: Success -

新しいカスタム・ネットワークの構成を確認します。

PCA> show network

MyPublicNetwork---------------------------------------- Network_Name MyPublicNetwork Trunkmode None Description None Ports ['1:1', '1:2'] vNICs None Status ready Network_Type external_network Compute_Nodes ovcacn07r1, ovcacn08r1, ovcacn09r1 Prefix None Netmask None Route Destination None Route Gateway None ---------------------------------------- Status: Successこれらのコマンドの結果、VxLANインタフェースが各サーバー上で構成され、新しいカスタム・ネットワークに接続されます。 これらの構成変更は、Oracle VM Managerの「ネットワーク」タブおよび「サーバーおよびVM」タブに反映されます。

ノートカスタム・ネットワークがホスト・ネットワークである場合、サーバーには、ネットワーク構成のプレフィクスとネットマスク・パラメータ、およびサーバーの内部管理IPアドレスの最後のオクテットに基づいて、IPアドレスが割り当てられます。

たとえば、192.168.4.9で内部IPアドレスを持つコンピュート・ノードが、この手順で説明するために使用されるホスト・ネットワークに接続された場合は、ホスト・ネットワークでアドレス10.10.10.9を受信することになります。

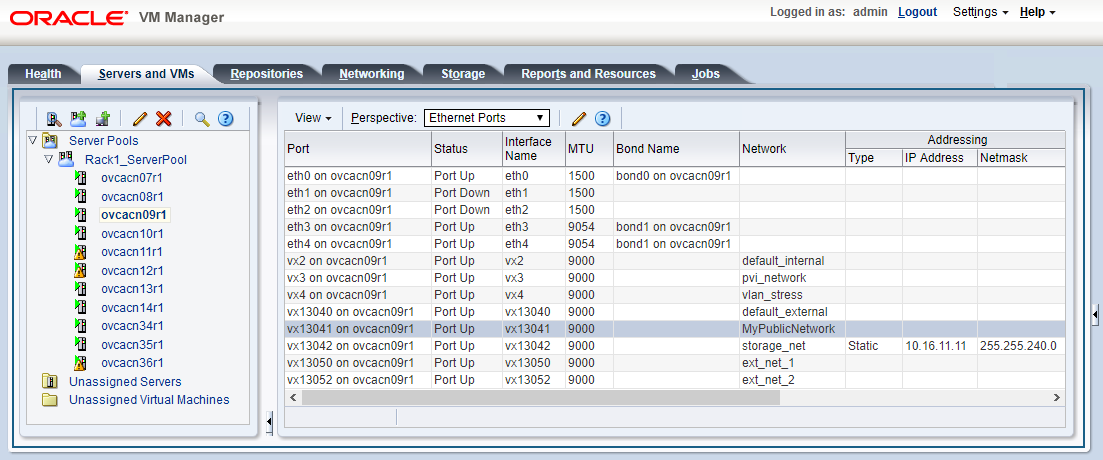

「図2.7」には、VLAN対応でコンピュート・ノード

vx13041インタフェースを使用するMyPublicNetworkという名前のカスタム・ネットワークが表示されます。図2.7 Oracle VM Managerカスタム・ネットワーク構成のビュー

-

カスタム・ネットワークからサーバーを切断するには、remove networkコマンドを使用します。

警告サーバーのネットワーク接続を削除する前に、仮想マシンがこのネットワークに依存していないことを確認してください。

サーバーがカスタム・ネットワークに接続されなくなった場合は、ポート構成がOracle VMでクリーンアップされることを確認してください。

PCA> remove network

MyPublicNetworkovcacn09r1************************************************************ WARNING !!! THIS IS A DESTRUCTIVE OPERATION. ************************************************************ Are you sure [y/N]:y Status: Success

2.5.2 カスタム・ネットワークの削除

この項では、カスタム・ネットワークを削除する方法について説明します。

カスタム・ネットワークを削除する前に、すべてのサーバーが最初に切断されていることを確認してください。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

すべてのサーバーがカスタム・ネットワークから切断されていることを確認します。 ネットワーク構成にvNICsやノードは表示されません。

注意Oracle VMにおける関連する構成変更も、クリーンアップする必要があります。

PCA> show network MyPublicNetwork ---------------------------------------- Network_Name MyPublicNetwork Trunkmode None Description None Ports ['1:1', '1:2'] vNICs None Status ready Network_Type external_network Compute_Nodes None Prefix None Netmask None Route_Destination None Route_Gateway None ----------------------------------------

-

カスタム・ネットワークを削除します。

PCA> delete network

MyPublicNetwork************************************************************ WARNING !!! THIS IS A DESTRUCTIVE OPERATION. ************************************************************ Are you sure [y/N]:y Status: Success注意カスタム・ネットワークが無効またはエラー状態のままで削除コマンドが失敗した場合は、

--forceオプションを使用して再試行できます。

2.6 VMストレージ・ネットワーク

Oracle Private Cloud Appliance Controller Softwareリリース2.4.3から、Oracle VM環境から内部ZFSストレージ・アプライアンスへのアクセスをユーザーに許可するプライベート・ストレージ・ネットワークを構成できます。 管理ノードへのルート・アクセス権を持つOracle Private Cloud Appliance管理者は、pca-adminコマンドライン・インタフェースを使用して、必要なネットワークおよびZFS共有(iSCSI/NFS)を作成および管理できます。 この機能を確実に使用するには、第3.2項、「ストレージ・ネットワークのアップグレード」の説明に従ってストレージ・ネットワークをアップグレードします。

Oracle Private Cloud Appliance管理者は、任意のテナント・グループ内の任意の仮想マシンがアクセスできる最大16のVMストレージ・ネットワークを作成できます。 Oracle Private Cloud Appliance管理者が設定を完了すると、仮想マシンのエンド・ユーザーは、NFSまたはiSCSIを介してこれらの内部ストレージ・ネットワーク1つ以上にアクセスするようにゲスト・オペレーティング・システムを構成します。

VMストレージ・ネットワークは、異なるビジネス・システムまたはエンド・ユーザーのグループを相互に分離するように設計されています。 たとえば、HR部門は仮想マシンに2つのVMストレージ・ネットワークを使用できますが、給与部門は独自のVMストレージ・ネットワークを3つまたは4つ持つことができます。 各VMストレージ・ネットワークには、異なるエンド・ユーザーが所有する他の仮想マシンからネットワークが分離されるように、単一のプライベート非ルーティングVXLANが割り当てられます。 エンド・ユーザーは、VMストレージ・ネットワークを介して内部ZFSストレージ・アプライアンスを管理するためのrootアクセス権を取得できません。

VMの内部ストレージ・ネットワークを直接定義する機能については、Oracle Private Cloud Appliance Controller Softwareリリース2.4.3を参照してください。 この機能を使用する前に、重要な詳細については、Oracle Support Document 2722899.1を参照してください。 ご質問がある場合は、Oracleサポートに連絡してください。

2.7 テナント・グループ

フル・ラック構成に構築された標準のOracle Private Cloud Appliance環境には、25個のコンピュート・ノードが含まれます。 tenant groupは、単一のOracle Private Cloud Appliance環境の論理的なサブセットです。 テナント・グループは、管理性と独立性を任意に行う方法で、Oracle Private Cloud Appliance管理者が環境を細分化するためのオプションのメカニズムを提供します。 テナント・グループは、エンド・ユーザーごとにコンピュート、ネットワークおよびストレージ・リソースを分離する手段を提供します。 また、クラスタの障害から分離することもできます。

2.7.1 仮定および制限の設計

Oracle Private Cloud Applianceでは、最大8つのテナント・グループがサポートされます。 この数には、環境から削除できないデフォルトのテナント・グループが含まれ、常に少なくとも1つのコンピュート・ノードが含まれる必要があります。 したがって、単一のカスタム・テナント・グループには最大24のコンピュート・ノードを含めることができ、デフォルトRack1_ServerPoolにはすべて25を含めることができます。

テナント・グループのメンバーシップに関係なく、すべてのコンピュート・ノードがすべてのデフォルトのOracle Private Cloud Applianceネットワークに接続されます。 カスタム・ネットワークを複数のテナント・グループに割り当てることができます。 コンピュート・ノードがテナント・グループに参加すると、そのテナント・グループに関連付けられているカスタム・ネットワークにも接続されます。 テナント・グループからコンピュート・ノードを削除すると、コンピュート・ノードはそれらのカスタム・ネットワークから切断されます。 テナント・グループ機能に組み込まれた同期メカニズムでは、テナント・グループ構成が変更される場合に、ノードのネットワーク接続が最新の状態に保たれます。

コンピュート・ノードを再プロビジョニングすると、それらのノードはテナント・グループから自動的に削除され、新規サーバーとして処理されます。 コンピュート・ノードを再プロビジョニングした場合、または環境に新しいコンピュート・ノードを追加した場合、Rack1_ServerPoolに自動的に追加されます。 プロビジョニングが成功すると、コンピュート・ノードを適切なテナント・グループに追加できます。

新しいテナント・グループを作成する場合、システムは新しいテナント・グループのストレージ・リポジトリを作成しません。 管理者は、Oracle VM Managerの仮想マシンに必要なストレージ・リソースを構成する必要があります。 第5.7項、「ストレージ・リソースの表示および管理」を参照してください。

2.7.2 テナント・グループの構成

テナント・グループ機能には、Oracle Private Cloud Appliance CLIからアクセスできます。 特定のコマンド・セットを使用して、テナント・グループ、そのメンバーのコンピュート・ノードおよび関連付けられているカスタム・ネットワークを管理します。 CLIでは、サーバー・プールを設定するための多数のOracle VM操作が開始され、同期サービスはテナント・グループのメンバー間で設定を維持します。

アップグレード操作の実行中は、テナント・グループ構成を変更しないでください。 アップグレード時には管理操作がサポートされていません。これにより、構成の不整合や重大な修復停止時間が発生する可能性があります。

Oracle VM Managerでは、テナント・グループ構成に非一貫性が生じ、同期サービスおよびOracle Private Cloud Appliance CLIの操作が中断されるため、サーバー・プールを変更しないでください。 Oracle VM Managerで編集できるのは、サーバー・プール・ポリシーのみです。

誤ってOracle VM Managerを使用してテナント・グループを変更した場合は、「セクション7.11「テナント・グループ構成の不一致からのリカバリ」」を参照してください。

Oracle Private Cloud Appliance CLIテナント・グループ・コマンドの詳細は、第4章、「Oracle Private Cloud Applianceコマンドライン・インタフェース(CLI)」を参照してください。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

新規テナント・グループを作成します。

PCA> create tenant-group

myTenantGroupStatus: Success PCA> show tenant-groupmyTenantGroup---------------------------------------- Name myTenantGroup Default False Tenant_Group_ID 0004fb00000200008154bf592c8ac33b Servers None State ready Tenant_Group_VIP None Tenant_Networks ['storage_internal', 'mgmt_internal', 'underlay_internal', 'underlay_external', 'default_external', 'default_internal'] Pool_Filesystem_ID 3600144f0d04414f400005cf529410003 ---------------------------------------- Status: Success新規テナント・グループが、Oracle VM Managerで新規サーバー・プールとして表示されます。 内部ZFSストレージ・アプライアンスに格納される12GBのサーバー・プール・ファイル・システムがあります。

-

テナント・グループにコンピュート・ノードを追加します。

現在、コンピュート・ノードが別のテナント・グループの一部である場合、まずそのテナント・グループから削除されます。

注意コンピュート・ノードが仮想マシンをホストしている場合、またはストレージ・リポジトリがコンピュート・ノードまたは現在のテナント・グループに提示されている場合、既存のテナント・グループからのコンピュート・ノードの削除は失敗します。 その場合、新しいテナント・グループにコンピュート・ノードを追加する前に、仮想マシンを移行して、リポジトリを再送信する必要があります。

PCA> add compute-node ovcacn07r1

myTenantGroupStatus: Success PCA> add compute-node ovcacn09r1myTenantGroupStatus: Success -

テナント・グループにカスタム・ネットワークを追加します。

PCA> add network-to-tenant-group

myPublicNetworkmyTenantGroupStatus: Successカスタム・ネットワーク全体をテナント・グループに追加できます。 このコマンドによって、テナント・グループの各サーバーでカスタム・ネットワークを構成する同期タスクが作成されます。

注意同期タスクの実行中に、構成変更に関連するすべてのコンピュート・ノードで再起動またはプロビジョニング操作が開始されないことを確認します。

-

新規テナント・グループの構成を確認します。

PCA> show tenant-group

myTenantGroup---------------------------------------- Name myTenantGroup Default False Tenant_Group_ID 0004fb00000200008154bf592c8ac33b Servers ['ovcacn07r1', 'ovcacn09r1'] State ready Tenant_Group_VIP None Tenant_Networks ['storage_internal', 'mgmt_internal', 'underlay_internal', 'underlay_external', 'default_external', 'default_internal', 'myPublicNetwork'] Pool_Filesystem_ID 3600144f0d04414f400005cf529410003 ---------------------------------------- Status: Success新しいテナント・グループは、同じ名前のOracle VMサーバー・プールに対応し、プール・ファイル・システムを持ちます。 また、コマンド出力は、サーバーおよびカスタム・ネットワークが正常に追加されたことを示します。

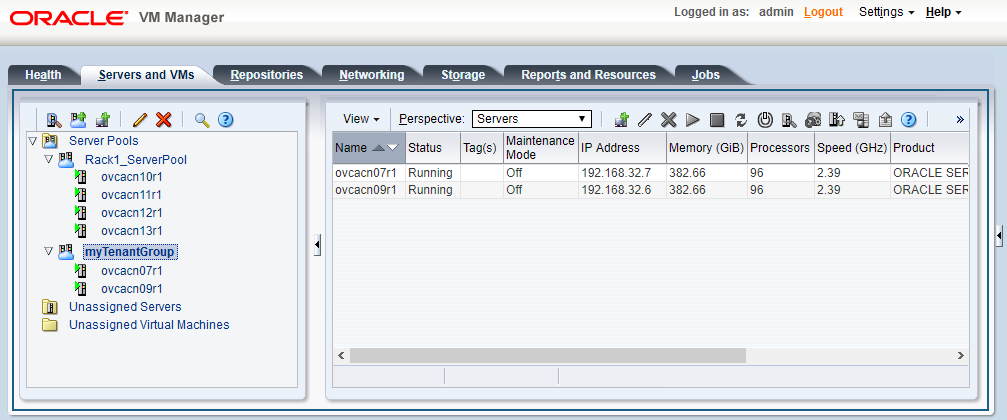

これらの構成変更は、Oracle VM Managerの「サーバーおよびVM」タブに反映されます。 「図2.8」には、MyTenantGroupという2つ目のサーバー・プールがあり、この手順の過程で例として追加された2つのコンピュート・ノードが含まれます。

新規テナント・グループ用のストレージ・リポジトリは作成されません。 管理者は、Oracle VM Managerの仮想マシンに必要なストレージ・リソースを構成する必要があります。 第5.7項、「ストレージ・リソースの表示および管理」を参照してください。

-

変更するテナント・グループを識別します。

PCA> list tenant-group Name Default State ---- ------- ----- Rack1_ServerPool True ready myTenantGroup False ready ---------------- 2 rows displayed Status: Success PCA> show tenant-group

myTenantGroup---------------------------------------- Name myTenantGroup Default False Tenant_Group_ID 0004fb00000200008154bf592c8ac33b Servers ['ovcacn07r1', 'ovcacn09r1'] State ready Tenant_Group_VIP None Tenant_Networks ['storage_internal', 'mgmt_internal', 'underlay_internal', 'underlay_external', 'default_external', 'default_internal', 'myPublicNetwork'] Pool_Filesystem_ID 3600144f0d04414f400005cf529410003 ---------------------------------------- Status: Success -

テナント・グループからネットワークを削除します。

テナント・グループに関連付けられていたカスタム・ネットワークは、再度削除できます。 コマンドを実行すると、同期サービスを使用しないシリアル操作が発生し、テナント・グループの各コンピュート・ノードでカスタム・ネットワークの構成が解除されます。

PCA> remove network-from-tenant-group

myPublicNetworkmyTenantGroup************************************************************ WARNING !!! THIS IS A DESTRUCTIVE OPERATION. ************************************************************ Are you sure [y/N]:y Status: Success -

テナント・グループからコンピュート・ノードを削除します。

Oracle VM Managerを使用して、テナント・グループから削除するためのコンピュート・ノードを準備します。 仮想マシンがコンピュート・ノードから離れて移行されており、ストレージ・リポジトリが提示されていないことを確認してください。

PCA> remove compute-node ovcacn09r1

myTenantGroup************************************************************ WARNING !!! THIS IS A DESTRUCTIVE OPERATION. ************************************************************ Are you sure [y/N]:y Status: Successテナント・グループからコンピュート・ノードを削除すると、そのテナント・グループに関連付けられているカスタム・ネットワークは、コンピュート・ノード・ネットワーク構成から自動的に削除されます。 テナント・グループに関連付けられていないカスタム・ネットワークは削除されません。

-

テナント・グループを削除します。

テナント・グループを削除する前に、すべてのコンピュート・ノードが削除されていることを確認してください。

テナント・グループから最後に残っているコンピュート・ノードを削除する前に、Oracle VM Managerを使用してコンピュート・ノードから共有リポジトリを非表示にしてから、その所有権を解放します。 詳細は、Doc ID 26535 15.1のサポート・ノートを参照してください。

PCA> delete tenant-group myTenantGroup ************************************************************ WARNING !!! THIS IS A DESTRUCTIVE OPERATION. ************************************************************ Are you sure [y/N]:y Status: Success

テナント・グループが削除されると、操作が起動されて内部のZFSストレージ・アプライアンスからサーバー・プールのファイルシステムLUNが削除されます。 テナント・グループに関連付けられているカスタム・ネットワークは破棄されません。

2.8 認証

「パスワード管理」ウィンドウは、グローバルなOracle Private Cloud Applianceパスワードをリセットしたり、アプライアンス内の個々のコンポーネントに一意のパスワードを設定したりするために使用されます。 このタブを介して実行される処理では、現在のPCA管理者パスワード:のラベルのフィールドにOracle Private Cloud Appliance adminユーザーの現在のパスワードを入力する必要があります。 フィールドでは、新しいパスワード値の指定と、値の確認ができます。

-

現在のPCA管理者パスワード: Oracle Private Cloud Appliance

adminユーザーにパスワードの変更を適用するには、現在のパスワードを入力する必要があります。 -

新規パスワード: 設定の新しいパスワードの値を指定してください。

-

パスワードの確認: 新しいパスワードを確認し、まだ入力していないことを確認してください。

このウィンドウには一連のチェック・ボックスがあり、パスワード変更に適用する粒度のレベルを簡単に選択できます。 「すべて選択」をクリックすると、アプライアンスで使用されているすべてのコンポーネントにグローバル・パスワードを適用できます。 このアクションは、特定のコンポーネントに設定されている個別のパスワードをリセットします。 より厳密なコントロールについては、パスワードを適用する各コンポーネントに関連付けられたチェック・ボックスを選択するだけで、個々のコンポーネントのパスワードを設定できます。

パスワードの変更はアプライアンス全体に即座に反映されるのではなく、タスク・キューを介して伝播されます。 パスワード変更を適用する場合は、少なくとも30分待って変更を有効にします。 この遅延中は、これ以上パスワードを変更しないでください。 パスワードの変更が正しく適用されていることを確認します。

-

すべて選択: すべてのコンポーネントに新しいパスワードを適用します。 リスト内のすべてのコンポーネントが選択されています。

-

Oracle VM Manager/PCA adminパスワード: Oracle VM ManagerおよびOracle Private Cloud Appliance Dashboard管理ユーザーの新規パスワードを設定します。

-

Oracle MySQLパスワード: Oracle VM Managerで使用されるMySQLのovsユーザーの新しいパスワードを設定します。

-

Oracle WebLogic Serverパスワード: WebLogic Serverのweblogicユーザーの新しいパスワードを設定します。

-

Oracleデータ・ネットワーク・リーフ・スイッチ管理者パスワード: leaf Cisco Nexus 9336C-FX2スイッチ用の管理ユーザーの新しいパスワードを設定します。

-

Oracle Management Network Switch管理パスワード: Cisco Nexus 9348GC-FXPスイッチについて、管理ユーザーの新しいパスワードを設定します。

-

Oracleデータ・ネットワーク・スパイン・スイッチ管理パスワード: spine Cisco Nexus 9336C-FX2スイッチ用の管理ユーザーの新しいパスワードを設定します。

-

Oracle ZFS Storageのルート・パスワード: ZFSストレージ・アプライアンスのルート・ユーザーの新しいパスワードを設定します。

-

PCA管理ノードのルート・パスワード: 両方の管理ノードのルート・ユーザーに新しいパスワードを設定します。

-

PCAコンピュート・ノード・ルート・パスワード: すべてのコンピュート・ノードに対するルート・ユーザーの新しいパスワードを設定します。

-

PCA管理ノードのSP/ILOM rootパスワード: 両方の管理ノードで、ILOMのルート・ユーザーの新しいパスワードを設定します。

-

PCAコンピュート・ノードSP/ILOM rootパスワード: すべてのコンピュート・ノードで、ILOMのルート・ユーザーに対して新しいパスワードを設定します。

Oracle Private Cloud Applianceダッシュボードで使用可能な機能は、第4.2.55項、「update password」で説明されているようにOracle Private Cloud Appliance CLIを使用して同等に使用できます。

コンポーネントのパスワードを手動で変更しないと、Oracle Private Cloud Appliance Walletに格納されている認証詳細との不一致が発生します。

2.9 ヘルス・モニタリング

Oracle Private Cloud Appliance Controllerソフトウェアには、アクティブ管理ノード上のovcaサービスで開始および停止されたモニタリング・サービスが含まれています。 システムの初回実行時には、「インベントリ・データベース」と「データベースの監視」が作成されます。 これらを設定し、モニタリング・サービスをアクティブにすると、ハードウェア・コンポーネントのヘルス情報が継続的に更新されます。

インベントリ・データベースには、モニタリングに使用するIPアドレスを含め、ラックにインストールされている様々なコンポーネントに関する情報が移入されます。 この情報を使用すると、ping managerは3分ごとにすべての既知のコンポーネントにpingを実行し、インベントリ・データベースを更新して、コンポーネントがping可能かどうか、および最後にオンラインになったかどうかを示します。 エラーが発生した場合、そのエラーはモニター・データベースに記録されます。 エラー情報はコンポーネントILOMから取得されます。

トラブルシューティングのために、「認可されたOracleフィールド・エンジニア」によるCLIサポート・モードを使用して履歴ヘルス・ステータスの詳細を取得できます。 CLIをサポート・モードで使用すると、多数の追加コマンドが使用できます。そのうちの2つは、ヘルス・モニタリング・データベースの内容を表示するために使用されます。

-

show db inventoryを使用して、インベントリ・データベースからコンポーネントのヘルス・ステータス情報を表示します。 -

show db monitorを使用して、モニタリング・データベースにログされるエラーを表示します。

アプライアンス管理者は、Oracle Private Cloud Applianceヘルス・チェック・ユーティリティを使用して、アクティブな管理ノードのOracle Linuxコマンドラインから現在のコンポーネントのヘルス・ステータス情報を取得できます。 ヘルス・チェック・ユーティリティは、Oracle Private Cloud Applianceアップグレード元のフレームワークに作成され、アップグレーダ・パッケージに含まれます。 これは、アプライアンス・ネットワーク・アーキテクチャを検出し、問題のシステムに定義されたヘルス・チェックのセットを実行します。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

ヘルス・チェック・ユーティリティを起動します。

# pca_healthcheck PCA Rack Type: PCA X8_BASE. Please refer to log file /nfs/shared_storage/pca_upgrader/log/pca_healthcheck_2019_10_04-12.09.45.log for more details.

ラック・タイプを検出した後、ユーティリティは適用可能なヘルス・チェックを実行します。

Beginning PCA Health Checks... Check Management Nodes Are Running 1/24 Check Support Packages 2/24 Check PCA DBs Exist 3/24 PCA Config File 4/24 Check Shares Mounted on Management Nodes 5/24 Check PCA Version 6/24 Check Installed Packages 7/24 Check for OpenSSL CVE-2014-0160 - Security Update 8/24 Management Nodes Have IPv6 Disabled 9/24 Check Oracle VM Manager Version 10/24 Oracle VM Manager Default Networks 11/24 Repositories Defined in Oracle VM Manager 12/24 PCA Services 13/24 Oracle VM Server Model 14/24 Network Interfaces on Compute Nodes 15/24 Oracle VM Manager Settings 16/24 Check Network Leaf Switch 17/24 Check Network Spine Switch 18/24 All Compute Nodes Running 19/24 Test for ovs-agent Service on Compute Nodes 20/24 Test for Shares Mounted on Compute Nodes 21/24 Check for bash ELSA-2014-1306 - Security Update 22/24 Check Compute Node's Active Network Interfaces 23/24 Checking for xen OVMSA-2014-0026 - Security Update 24/24 PCA Health Checks completed after 2 minutes

-

ヘルス・チェックが完了したら、レポートでエラーを確認します。

Check Management Nodes Are Running Passed Check Support Packages Passed Check PCA DBs Exist Passed PCA Config File Passed Check Shares Mounted on Management Nodes Passed Check PCA Version Passed Check Installed Packages Passed Check for OpenSSL CVE-2014-0160 - Security Update Passed Management Nodes Have IPv6 Disabled Passed Check Oracle VM Manager Version Passed Oracle VM Manager Default Networks Passed Repositories Defined in Oracle VM Manager Passed PCA Services Passed Oracle VM Server Model Passed Network Interfaces on Compute Nodes Passed Oracle VM Manager Settings Passed Check Network Leaf Switch Passed Check Network Spine Switch Failed All Compute Nodes Running Passed Test for ovs-agent Service on Compute Nodes Passed Test for Shares Mounted on Compute Nodes Passed Check for bash ELSA-2014-1306 - Security Update Passed Check Compute Node's Active Network Interfaces Passed Checking for xen OVMSA-2014-0026 - Security Update Passed --------------------------------------------------------------------------- Overall Status Failed --------------------------------------------------------------------------- Please refer to log file /nfs/shared_storage/pca_upgrader/log/pca_healthcheck_2019_10_04-12.09.45.log for more details.

-

特定のチェックが失敗した場合、ログ・ファイルで追加の診断情報を確認します。 "error"および"failed"などのテキスト文字列を検索します。

# grep -inr "failed" /nfs/shared_storage/pca_upgrader/log/pca_healthcheck_2019_10_04-12.09.45.log 726:[2019-10-04 12:10:51 264234] INFO (healthcheck:254) Check Network Spine Switch Failed - 731: Spine Switch ovcasw22r1 North-South Management Network Port-channel check [FAILED] 733: Spine Switch ovcasw22r1 Multicast Route Check [FAILED] 742: Spine Switch ovcasw23r1 North-South Management Network Port-channel check [FAILED] 750:[2019-10-04 12:10:51 264234] ERROR (precheck:148) [Check Network Spine Switch ()] Failed 955:[2019-10-04 12:12:26 264234] INFO (precheck:116) [Check Network Spine Switch ()] Failed # less /nfs/shared_storage/pca_upgrader/log/pca_healthcheck_2019_10_04-12.09.45.log [...] Spine Switch ovcasw22r1 North-South Management Network Port-channel check [FAILED] Spine Switch ovcasw22r1 OSPF Neighbor Check [OK] Spine Switch ovcasw22r1 Multicast Route Check [FAILED] Spine Switch ovcasw22r1 PIM RP Check [OK] Spine Switch ovcasw22r1 NVE Peer Check [OK] Spine Switch ovcasw22r1 Spine Filesystem Check [OK] Spine Switch ovcasw22r1 Hardware Diagnostic Check [OK] [...]

-

検出された問題を調査し、すべて修正します。 システムがすべてのチェックに合格するまでヘルス・チェックを繰り返します。

2.10 障害モニタリング

Oracle Private Cloud Applianceコントローラ・ソフトウェア・リリース2.4.3では、既存のヘルス・チェッカが、アクティブな管理ノードのovca-daemonによって起動されるサービスになります。 チェックは、コマンドラインから手動で実行することも、スケジューラの定義を使用して実行することもできます。 チェック定義に応じて、Oracle Private Cloud Applianceヘルス・チェッカ、Oracle VMヘルス・チェックおよびOracle Private Cloud Applianceアップグレード前チェックを起動できます。

-

pca_healthcheckは、システム・ハードウェア・コンポーネントのヘルスを監視します。 詳細は、「ヘルス・モニタリング」を参照してください。 -

ovm_monitorは、Oracle VMマネージャ・オブジェクトおよびその他の環境ファクタを監視します。 -

pca_upgraderは、アップグレード中にシステムを監視します。

ヘルス・チェックをZFS Phone Homeサービスと統合して、レポートを週単位でOracleに送信できます。 Phone Home機能はお客様がアクティブにする必要があり、アプライアンスがASRに登録されている必要があります。 個別のインストールは必要ありません。すべての機能は、Oracle Private Cloud Appliance 2.4.3以降のコントローラ・ソフトウェアに付属しています。 構成の詳細は、第2.10.2項、「フォン・ホーム・サービス」を参照してください。

2.10.1 障害モニタリング・チェックの使用

アプライアンス管理者は、Oracle Private Cloud Appliance障害モニタリング・ユーティリティを使用して、アクティブな管理ノードのOracle Linuxコマンドラインから現在のコンポーネントのヘルス・ステータス情報にアクセスできます。 障害モニタリング・ユーティリティはovcaサービスに含まれており、アクティブな管理ノードのOracle Private Cloud Applianceコマンドラインを使用してアクセスできます。 また、チェックを自動的に実行するようにスケジュールすることもできます。 ユーティリティはアプライアンスネットワークアーキテクチャを検出し、そのシステムに定義されている一連の健全性検査を実行します。

フォルト・モニタリング・ユーティリティには、個々のチェック、特定のモニタリング・サービスのすべてのチェックまたは使用可能なすべてのチェックの実行を選択できる柔軟性があります。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

使用可能なチェックをリストします。

[root@ovcamn05r1 ~]# pca-faultmonitor --help usage: pca-faultmonitor [-h] [--list_all_monitors][--list_ovm_monitors] [--list_pca_healthcheck_monitors] [--list_pca_upgrader_monitors] [--run_all_monitors] [--run_ovm_monitors] [--run_pca_healthcheck_monitors] [--run_pca_upgrader_monitors][-m MONITOR_LIST] [--print_report] optional arguments: -h, --help show this help message and exit --list_all_monitors List all Fault Monitors(Oracle VM, pca_healthcheck and pca_upgrader) --list_ovm_monitors List Oracle VM Fault Monitors --list_pca_healthcheck_monitors List pca_healthcheck Fault Monitors --list_pca_upgrader_monitors List pca_upgrader Fault Monitors --run_all_monitors Run all Fault Monitors --run_ovm_monitors Run Oracle VM Fault Monitors --run_pca_healthcheck_monitors Run pca_healthcheck Fault Monitors --run_pca_upgrader_monitors Run pca_upgrader Fault Monitors -m MONITOR_LIST Runs a list of Fault Monitors. Each Fault Monitor must be specified with -m option --print_report Prints the report on console None PCA Rack type: hardware_orange Please refer the log file in /var/log/ovca-faultmonitor.log Please look at fault report in /nfs/shared_storage/faultmonitor/20200512/ Note: Reports will not be created for success status[root@ovcamn05r1 faultmonitor]# pca-faultmonitor --list_pca_upgrader_monitors PCA Rack type: hardware_orange Please refer the log file in /var/log/faultmonitor/ovca-faultmonitor.log Please look at fault report in /nfs/shared_storage/faultmonitor/20200221/ Note: Reports will not be created for success status Listing all PCA upgrader faultmonitors check_ib_symbol_errors verify_inventory_cns check_hardware_faults check_server_name validate_image check_available_space check_ovs_version check_ovm_warning_error check_max_paths_iscsi check_serverUpdateConfiguration check_uptime check_ovmm_default_networks check_onf_error verify_password verify_ntp_server verify_no_upstream_proxies check_rpm_db verify_network_config check_custom_multipath check_ovmm check_yum_proxy check_motd verify_ovmm_cache check_keystore_loc check_yum_repo connect_mysql check_os check_multiple_tenant_groups check_osa_disabled check_xsigo_configs verify_ntp_xsigo check_ilom_version check_pca_services check_mysql_desync_passwords check_max_paths_fc check_dir_mounted check_storage_space verify_xms_cards

-

目的のチェックを実行します。

-

すべてのチェックを実行します。

[root@ovcamn05r1 ~]# pca-faultmonitor --run_all_monitors

-

特定のチェックまたは特定のチェックのリストを実行します。

-mで事前に追加されている1つ以上のチェックをリストします。[root@ovcamn05r1 ~]# pca-faultmonitor -m event_monitor -m check_storage_space

-

特定のモニターのチェックを実行します。

[root@ovcamn05r1 ~]# pca-faultmonitor --run_pca_upgrader_monitors [root@ovcamn05r1 faultmonitor]# pca-faultmonitor --run_ovm_monitors PCA Rack type: hardware_orange Please refer the log file in /var/log/faultmonitor/ovca-faultmonitor.log Please look at fault report in /nfs/shared_storage/faultmonitor/20200220/ Note: Reports will not be created for success status Beginning OVM Fault monitor checks ... event_monitor 1/13 repository_utilization_monitor 2/13 storage_utilization_monitor 3/13 db_size_monitor 4/13 onf_monitor 5/13 db_backup_monitor 6/13 firewall_monitor 7/13 server_connectivity_monitor 8/13 network_monitor 9/13 port_flapping_monitor 10/13 storage_path_flapping_monitor 11/13 repository_mount_monitor 12/13 server_pool_monitor 13/13 -------------------------------------------------- Fault Monitor Report Summary -------------------------------------------------- OVM_Event_Monitor Success OVM_Repository_Utilization_Monitor Success OVM_Storage_Utilization_Monitor Success DB_Size_Monitor Success ONF_Monitor Success DB_Backup_Monitor Success Firewall_Monitor Success Server_Connectivity_Monitor Success Network_Monitor Warning Port_Flapping_Monitor Success Storage_Path_Flapping_Monitor Success Repository_Mount_Monitor Warning Server_Pool_Monitor Success -------------------------------------------------- Overall Failure -------------------------------------------------- PCA Rack type: hardware_orange Please refer the log file in /var/log/faultmonitor/ovca-faultmonitor.log Please look at fault report in /nfs/shared_storage/faultmonitor/20200220/ Note: Reports will not be created for success status Monitor execution completed after 5 minutes

-

-

特定のチェックが失敗した場合は、コンソールまたはログ・ファイルで追加の診断情報を確認します。

-

検出された問題を調査し、すべて修正します。 システムがすべてのチェックに合格するまでチェックを繰り返します。

デフォルトでは、run_ovm_monitors、run_pca_healthcheck_monitorsおよびrun_pca_upgrader_monitorsのチェックは毎週実行されるようにスケジュールされています。 これらのチェックの頻度を変更したり、スケジューラに個別のチェックを追加できます。 スケジュールの変更を実装するには、ovcaサービスを再起動する必要があります。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

ovca-system.confファイルのスケジュール・プロパティを変更します。次に説明するスケジューリング形式を使用します。

* * * * * command - - - - - | | | | | | | | | –--- day of week (0-7, Sunday= 0 or 7) | | | –----- month (1-12) | | –------- day of month (1-31) | –--------- hour (0-23) –----------- minute (0-59)[root@ovcamn05r1 ~]# cat /var/lib/ovca/ovca-system.conf [faultmonitor] report_path: /nfs/shared_storage/faultmonitor/ report_format: json report_dir_cleanup_days: 10 disabled_check_list: validate_image enable_phonehome: 0 collect_report: 1 [faultmonitor_scheduler] run_ovm_monitors: 0 2 * * * run_pca_healthcheck_monitors: 0 1 * * * run_pca_upgrader_monitors: 0 0 * * * repository_utilization_monitor: 0 */2 * * * check_ovmm_version: */30 * * * *

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

ovca-system.confファイルの適切なプロパティを変更します。report_formatのオプションは、json、textまたはhtmlです。[root@ovcamn05r1 ~]# cat /var/lib/ovca/ovca-system.conf [faultmonitor] report_path: /nfs/shared_storage/faultmonitor/ report_format: json report_dir_cleanup_days: 10 disabled_check_list: validate_image enable_phonehome: 1 collect_report: 1

2.10.2 フォンホームサービス

障害管理ユーティリティは、管理ノードが障害データ・レポートを収集し、それらのレポートをZFSストレージ・アプライアンスにコピーするように設計されています。 Oracle Serviceでこれらの障害レポートをモニターする場合は、Phone Homeサービスを構成して、これらのレポートをOracleに週単位でプッシュできます。

Oracle Private Cloud Applianceは、ZFSストレージ・アプライアンスの既存のPhone Homeサービスを使用します。

-

ASRをOracle Private Cloud Applianceにインストールします。 「Private Cloud Appliance (PCA) X8にAuto Service Request (ASR)をインストールする方法(ドキュメントID 25609 88.1)」を参照してください。

-

ASRがPCAにインストールされたら、My Oracle Serviceアカウントにログインし、新しいアセットとしてOracle Private Cloud Applianceを承認する必要があります。 「My Oracle Supportで保留中のOracle Auto Service Request (ASR)アセットを管理および承認する方法(ドキュメントID 13292 00.1)」を参照してください。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

障害モニタリング・サービスでPhone Homeを有効にするには、両方の管理ノードの

ovca-system.confファイルでenable_phonehomeプロパティを1に設定します。デフォルトでは、Phone HomeはOracle Private Cloud Applianceで無効になっています。

[root@ovcamn05r1 ~]# edit /var/lib/ovca/ovca-system.conf [faultmonitor] report_path: /nfs/shared_storage/faultmonitor/ report_format: json report_dir_cleanup_days: 10 disabled_check_list: validate_image enable_phonehome: 1 collect_report: 1 -

ZFSストレージ・アプライアンスのブラウザ・インタフェースにログインし、フォン・ホームを有効にします。 「構成>サービス>フォン・ホームに移動」で、電源アイコンをクリックしてサービスをオンラインにします。

これで、自動サービス・レスポンスのためにフォルト・レポートをOracleに送信するようにシステムが構成されました。

2.11 クラウド・バックアップ

Oracle Private Cloud Appliance Cloud Backupサービスは、Oracle Cloud Infrastructure (OCI)の顧客テナンシへの重要なコンポーネントおよび構成データのバックアップを自動化します。 この機能は、壊滅的なイベント後にOracle Private Cloud Applianceを実行状態にリカバリするように設計されており、仮想マシン、ゲスト・オペレーティング・システムまたは仮想マシンでホストされているアプリケーションおよびデータをバックアップするように設計されていません。 顧客の仮想マシンおよびアプリケーションのバックアップは、Oracle Site Guardを使用して管理できます。 「Doc ID 1959182.1 Oracle VM 3: Oracle Site Guardを使用した障害時リカバリの開始」を参照してください。

クラウド・バックアップ・サービスには、Oracle Cloud Infrastructureクラウド・テナンシが必要です。 サービスは、システムからバックアップ・データのスナップショットを作成し、そのスナップショットを内部ZFSSAに格納してから、そのスナップショットをリモート・ストレージ用のOracle Cloud Infrastructureクラウドテナンシにプッシュするように設計されています。 一度構成すると、サービスは毎週バックアップを自動的に実行します。 リソース管理上の理由から、最新の10個のバックアップがZFSSAおよびOracle Cloud Infrastructureテナンシにローカルに格納されます。 現時点では、Oracle Serviceに連絡して、Oracle Cloud Infrastructureクラウド・バックアップからOracle Private Cloud Applianceをリストアします。

クラウド・バックアップ・サービスは、Oracle Cloud Infrastructureのオブジェクト・ストレージ機能を使用して、Oracle Private Cloud Appliance構成バックアップ・データを格納します。 Object Storageを使用すると、インターネットから直接、またはクラウド・プラットフォーム内からデータを安全かつ安全に格納または取得できます。 Object Storageはリージョン・サービスであり、特定のコンピュート・インスタンスに関連付けられていません。 インターネット接続があり、「Object Storageエンドポイント」のいずれかにアクセスできるかぎり、Oracle Cloud Infrastructureのコンテキストの内部または外部のどこからでもデータにアクセスできます。 Object Storageの詳細は、https://docs.cloud.oracle.com/en-us/iaas/Content/Object/Concepts/objectstorageoverview.htmを参照してください。

2.4.3より前のOracle Private Cloud Applianceリリース、またはリリース2.4.3にアップグレードされたシステムでクラウド・バックアップ・サービスを使用するには、Oracle Serviceに連絡してください。

クラウド・バックアップ・サービスを使用する最善の経験を得るには、次のアイテムを検討してください。

-

Oracle Private Cloud Applianceと同じリージョンにあるOracle Cloud Infrastructureリージョンを使用します。

-

顧客構内ネットワークでのネットワーク速度が非常に遅くなる(<100Mbps)と、特にリージョンを越える場合はタイムアウトになることがあります。

-

タイムアウトが発生した場合は、Oracle Serviceに連絡してください。

-

たとえば、管理ノードの再起動時にZFSストレージ・アプライアンスへの接続が切断されると、クラウド・バックアップ・サービスが破損する可能性があります。 「Oracle Private Cloud Applianceリリース・ノート」の「バックアップ中にZFSSAテイクオーバーが実行されたときにクラウド・バックアップ・タスクがハングする」を参照してください。

2.11.1 クラウド・バックアップ・サービスの構成

この項では、Oracle Private Cloud Applianceからバックアップを受信するようにOracle Cloud Infrastructureテナンシを準備する方法など、クラウド・バックアップ・サービスを初期構成する方法について説明します。

クラウド・バックアップ・サービスを構成すると、次の3つのことが実行されます: Oracle Cloud Infrastructureテナンシにバックアップを格納するロケーションを作成し、Oracle Private Cloud Applianceからバックアップ・データを収集するスクリプトをアクティブ化し、最後に、それらのバックアップをOracle Private Cloud ApplianceからOracle Cloud Infrastructureテナンシに週単位でプッシュします。

-

Oracle Cloud Infrastructureテナンシにオブジェクト・ストア・バケットを作成します。 「オブジェクト・ストレージへのデータの格納」の「バケットの作成」の項を参照してください。

ノートバケットのOCIDを特定するには、「バケットの管理」を参照してください。

各ターゲットは、独自のバケットに関連付ける必要があります。 この操作を実行して、Oracle Private Cloud Applianceバックアップの各ターゲットのロケーションを設定します。

-

Oracle Private Cloud Appliance Cloudバックアップ構成を設定します。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

ステップ1で作成したOracle Cloud Infrastructureオブジェクト・ストア・バケットに対応するOracle Cloud InfrastructureターゲットをOracle Private Cloud Applianceに作成します。

このステップでは、スケジュール済バックアップをOracle Cloud Infrastructureのオブジェクト・ストレージ・バケットに送信するターゲットをPCA ZFSSAに作成します。 詳細は、第4.2.15項、「create oci-target」を参照してください。

PCA> create oci-target <

target name> <target location> <target user> <target bucket> <target tenancy> <keyfile>次に例を示します。

PCA> create oci-target

cloud-target-1https://objectstorage.us-oci.com ocid1.user.oc1..oos-test mybucket ocid1.tenancy.oc1..nobody /root/oci_api_key.pem Status: Successこれで、クラウド・バックアップが毎週実行されるように構成されました。

-

2.11.2 クラウドの手動バックアップの構成

この項では、手動クラウド・バックアップをトリガーする方法について説明します。これは、システムのアップグレードの準備に役立ちます。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

クラウド・バックアップを作成します。

PCA> create oci-backup

oci-target-name1oci-target-name2The create oci-backup job has been submitted. Use "show task < task id>" to monitor the progress. Task_ID Status Progress Start_Time Task_Name ------- ------ -------- ---------- --------- 386c911399b38e RUNNING None 05-29-2020 21:48:24 oci_backup --------------- 1 row displayed Status: Success一度に実行できるバックアップは1つだけです。 競合がある場合は、次のエラーが表示されます:

Status: Failure Error Message: Error (SYSTEM_002): Cannot invoke API function oci_backup while lock oci_backup is in place.

この問題を解決するには、他のバックアップ・タスクが完了したら、手動バックアップを再度実行します。

2.11.3 クラウド・バックアップの削除

この項では、Oracle Private Cloud ApplianceとOracle Cloud Infrastructureテナンシの両方からバックアップを削除するクラウド・バックアップの削除方法について説明します。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

バックアップを削除します。

PCA> delete oci-backup <OVCA/OCI_backups@AK00000000_OCI_snap_2020_06_29-04.56.28 > WARNING !!! THIS IS A DESTRUCTIVE OPERATION. Are you sure [y/N]:y

2.11.4 Oracle Cloud InfrastructureTargetsの削除

この項では、Oracle Private Cloud ApplianceからOracle Cloud Infrastructureターゲットを削除する方法について説明します。 Oracle Cloud Infrastructureテナンシ内の関連オブジェクト・ストア・バケットは削除されません。この操作では、Oracle Private Cloud Appliance上の選択したターゲットが削除されるため、Oracle Cloud Infrastructureテナンシ内のそのターゲットへのリンクが壊れます。

-

SSHおよびスーパーユーザー権限のあるアカウントを使用して、アクティブ管理ノードにログインします。

# ssh root@10.100.1.101 root@10.100.1.101's password: root@ovcamn05r1 ~]#

-

Oracle Private Cloud Applianceコマンドライン・インタフェースを起動します。

# pca-admin Welcome to PCA! Release: 2.4.4 PCA>

-

Oracle Private Cloud Appliance上のOracle Cloud Infrastructureターゲットを削除します。

PCA> delete oci-target <

target>