3 Oracle Exadata Storage Serverの保守

Oracle Exadata Storage Serverに含まれているディスクやメモリー・デバイスには保守が必要になることがあります。

ノート:

- この章のすべての手順は、Oracle ExadataおよびOracle Exadata Storage拡張ラックに適用されます。

- 読みやすさを考慮して、Oracle ExadataとOracle Exadata Storage拡張ラックの両方に言及する場合、「Oracle Exadataラック」という名前を使用します。

- Oracle Exadata Storage Serverの保守

この項では、Oracle Exadata Storage Serverの保守を実行する方法について説明します。 - Exadata拡張(XT)ストレージ・サーバーの使用

Oracle Exadata拡張(XT)ストレージ・サーバーは、アクセス頻度の低いデータ、古いデータまたは規制データに使用できる低コストのストレージ・オプションを提供します。 - Oracle Exadata Storage Serverのハード・ディスクの保守

- Oracle Exadata Storage Serverのフラッシュ・ディスクの保守

- Oracle Exadata Storage ServerのPMEMデバイスの保守

永続メモリー(PMEM)デバイスは、大容量(HC)またはExtreme Flash (EF)ストレージを持つExadata X8M-2およびX9M-2ストレージ・サーバー・モデル内に存在します。 - Oracle Exadata Storage ServerのM.2ディスクの保守

Oracle Exadata X7以降のシステムには、システム領域を格納する2つの内蔵M.2デバイスが付属しています。 - Oracle Exadata System Softwareのレスキュー手順の使用

システム・ディスクで同時に障害が発生するまれな事例の場合、Oracle Exadata Storage Serverレスキュー手順を使用してシステムをリカバリする必要があります。 - ストレージ・セルの既存のエラスティック構成の変更

エラスティック構成を使用すると、Oracle Exadataの容量を変更できます。 - ディスク・コントローラのバッテリの管理

この項は、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。新しいディスク・コントローラは、メンテナンスや交換を必要としないスーパーキャパシタを使用します。 - F20 PCIeエネルギー・ストレージ・モジュールの管理

Sun Flash Accelerator F20 PCIeカードは、Oracle Exadata X3モデルで使用されています。 - Exadata Storage ServerのLEDインジケータの説明

Oracle Exadataストレージ・サーバーのインジケータLEDは、システム・ステータスを確認し、保守が必要なコンポーネントを識別するために役立ちます。 - Exadata Storage Serverのイメージ

Exadata Storage Serverのモデルには、様々な外部レイアウトおよび物理的外観があります。

3.1 Oracle Exadata Storage Serverの保守

この項では、Oracle Exadata Storage Serverの保守を実行する方法について説明します。

- Exadata Storage Serverのシャットダウン

Exadata Storage Serverの保守を実行する場合、セルの電源切断または再起動が必要になることがあります。 - ASMリバランス操作のステータスのチェック

Oracle ASMリバランス操作のステータスを確認できます。 - 診断ISOを使用したネットワーク接続の有効化

ストレージ・サーバーが再起動しない場合は、セルにアクセスして手動で修復できるようにするために、診断ISOが必要になることがあります。

3.1.1 Exadata Storage Serverのシャットダウン

Exadata Storage Serverの保守を実行する場合、セルの電源切断または再起動が必要になることがあります。

1つ以上のデータベースの実行中にExadata Storage Serverを停止する場合、Exadata Storage ServerのオフラインによるOracle ASMディスク・グループおよびデータベース可用性への影響がないことを確認する必要があります。データベースの可用性に影響を及ぼすことなくExadata Storage Serverをオフラインにする機能は、影響を受けるディスク・グループで使用されるOracle ASMの冗長性レベルによって異なります。可用性は、オフラインにするExadata Storage Serverのデータのミラー・コピーを持つ他のExadata Storage Serverのディスクの現在のステータスによっても異なります。

3.1.2 ASMリバランス操作のステータスのチェック

Oracle ASMリバランス操作のステータスを確認できます。

-

リバランス操作が正常に完了している可能性があります。Oracle ASMアラート・ログを確認してください。

-

リバランス操作が現在実行されている可能性がある場合。

GV$ASM_OPERATIONビューを確認して、リバランス操作が実行されているかどうか判別します。 -

リバランス操作が失敗した可能性がある場合。

V$ASM_OPERATION.ERRORビューを確認して、リバランス操作が失敗したかどうか判別します。 -

交換される物理ディスクに複数のディスク・グループのOracle ASMディスクが含まれる場合、複数のディスク・グループのリバランス操作を同じクラスタの異なるOracle ASMインスタンスで実行できます。Oracle ASMインスタンスは、一度に1つのリバランス操作を実行できます。すべてのOracle ASMインスタンスがビジー状態の場合、リバランス操作がキューに入れられます。

ノート:

Oracle Exadata System Softwareリリース12.1.2.0およびBP4のOracle Databaseリリース12.1.0.2以降では、ASMリバランス操作用のアラートが生成されます。以前のリリースでは、管理者が操作のステータスをチェックする必要がありました。

3.2 Exadata拡張(XT)ストレージ・サーバーの使用

Oracle Exadata拡張(XT)ストレージ・サーバーは、アクセス頻度の低いデータ、古いデータまたは規制データに使用できる低コストのストレージ・オプションを提供します。

- Oracle Exadata拡張(XT)ストレージ・サーバーについて

Oracle Exadata拡張(XT)ストレージ・サーバーは、オンライン状態の維持が必要なアクセス頻度の低いデータに向けて、Exadata Database Machineの操作性および管理性の利点を拡張するために利用できます。 - Oracle Exadata拡張(XT)ストレージ・サーバーに格納できるデータについて

Oracle Exadata拡張(XT)ストレージ・サーバーは、アクセス頻度の低いデータ、古いデータまたは規制データのために低コストのストレージを提供することを目的としています。 - Exadata拡張(XT)ストレージ・サーバーのスマート・スキャンの有効化

Oracle Exadata拡張(XT)ストレージ・サーバーのOracle Exadata System Softwareライセンスを購入していると、スマート・スキャンやストレージ索引などのパフォーマンスを向上するための機能を有効化できます。

3.2.1 Oracle Exadata拡張(XT)ストレージ・サーバーについて

Oracle Exadata拡張(XT)ストレージ・サーバーは、オンライン状態の維持が必要なアクセス頻度の低いデータに向けて、Exadata Database Machineの操作性および管理性の利点を拡張するために利用できます。

各XTストレージ・サーバーには、12個の大容量ディスク・ドライブが含まれています。ただし、低コストを実現するため、フラッシュ・デバイスは含まれていません。また、Oracle Exadata System Softwareのライセンスはオプションであり、一部のソフトウェア機能はライセンスがないかぎり無効になります。ハイブリッド列圧縮は、Oracle Exadata System Softwareライセンスを必要とせずに組み込まれています。

XTストレージ・サーバーは、Oracle Exadataラック内のその他のサーバーと同じRDMAネットワーク・ファブリックを使用します。XTストレージ・サーバーにより、アプリケーションに対する透過性、SQLに対する透過性、および同一の操作モデルを維持したまま、ストレージ容量が追加されます。Exadataに使用しているものと同じセキュリティ・モデルと暗号化を使用できます。

XTストレージ・サーバーは、エイス・ラック構成を含むOracle ExadataラックX4以降に追加できます。最初に少なくとも2台のサーバーを追加する必要があります。最初の2台のサーバーの後は、必要に応じてXTストレージ・サーバーを追加できます。高冗長性を実装するには、最小3台のXTストレージ・サーバーが必要になります。XTストレージ・サーバーは、High Capacity (HC)およびExtreme Flash (EF)ストレージ・サーバーと同じ配置パターンに従います。

Oracle ASMディスク・グループは、ストレージ・サーバー(HC、EFまたはXT)のいずれかのタイプのみが提供するストレージを使用する必要があります。XTストレージ・サーバーをラックに追加したら、そのストレージを使用する新しいディスク・グループを作成します。XTストレージ・サーバーのデフォルトのディスク・グループ名はXTNDです。ただし、別の名前を必要に応じて使用することもできます。

XTストレージ・サーバーは、Oracle Databaseに完全統合されるストレージを提供します。Oracleパーティション化、Oracle自動データ最適化、Oracle拡張圧縮などのデータベース機能が備わった新しいディスク・グループを使用できます。

親トピック: Exadata拡張(XT)ストレージ・サーバーの使用

3.2.2 Oracle Exadata拡張(XT)ストレージ・サーバーに格納できるデータについて

Oracle Exadata拡張(XT)ストレージ・サーバーは、アクセス頻度の低いデータ、古いデータまたは規制データのために低コストのストレージを提供することを目的としています。

XTストレージ・サーバーは、すべての必須データのオンライン状態を維持して問合せで利用できるようにするために役立ちます。次のようなデータが挙げられます。

- 履歴データ

- イメージ、BLOB、契約内容などの大きな表ベースのオブジェクト

- コンプライアンスおよび規制データ

- ローカル・バックアップ

XTストレージ・サーバーは、本番データベースと比べてパフォーマンス要件の緩い開発データベースにストレージを提供することもできます。

親トピック: Exadata拡張(XT)ストレージ・サーバーの使用

3.2.3 Exadata拡張(XT)ストレージ・サーバーのスマート・スキャンの有効化

Oracle Exadata拡張(XT)ストレージ・サーバーのOracle Exadata System Softwareライセンスを購入していると、スマート・スキャンやストレージ索引などのパフォーマンスを向上するための機能を有効化できます。

親トピック: Exadata拡張(XT)ストレージ・サーバーの使用

3.3 Oracle Exadata Storage Serverのハード・ディスクの保守

Oracle Exadataラック内のすべてのOracle Exadata Storage Serverにシステム領域があり、その領域にOracle Exadata System Softwareシステム・ソフトウェアが常駐しています。Oracle Exadata X7以降のシステムでは、このシステム領域は2つの内蔵M.2デバイスにあります。その他すべてのシステムでは、Oracle Exadata Storage Serverの最初の2つのディスクがシステム・ディスクとなっています。これらのシステム・ディスクの一部はシステム領域と呼ばれています。

Oracle Exadata X7以降のシステムでは、セル内のハード・ディスクはすべてデータ・ディスクになっています。Oracle Exadata X7より前のシステムでは、システム・ディスクのシステム領域以外の部分(データ・パーティションと呼ばれる)が通常のデータ・ストレージとして使用されます。セル内の他のディスクはすべてデータ・ディスクです。

Oracle Exadata System Softwareリリース11.2.3.2.0以降では、ディスク障害が発生すると、Oracle Exadata System Softwareによってディスクが交換可能であることを示すアラートが送信され、そのディスクの外部にすべてのデータがリバランスされた後で予測障害のあるハード・ディスクの青色の取外しOKのLEDが点灯します。リリース11.2.3.2.0より前のOracle Exadata System Softwareでは、ハード・ディスクに予測障害がある場合、青色のLEDではなく黄色の障害サービス必須LEDが点灯していました。このような場合、ディスクの交換を進める前に、すべてのデータがそのディスクの外部にリバランスされたかどうかを手動でチェックする必要があります。

Oracle Exadata System Softwareリリース18.1.0.0.0およびOracle Exadata X7システム以降では、冗長性が低くなったことを示す白色のサービス不可LEDが追加され、これにより、システム管理者やフィールド・エンジニアは、サービスのためにストレージ・サーバーの電源を切断することは避ける必要があることがわかります。冗長性がリストアされると、Oracle Exadata System Softwareによりサービス不可LEDが自動的に消灯され、サービスのためにセルの電源を切断できることが示されます。

ハード・ディスクで障害が発生すると、ドライブの青色の取外しOKのLEDと黄色の障害サービス必須LEDが両方とも点灯し、ディスク交換作業を実施できることが示されます。動作はすべてのリリースで同じです。Oracle Exadata System Softwareリリース11.2.3.2.0以降ではドライブLEDが点灯しますが、それより前のリリースではドライブLEDが点滅します。

ノート:

Oracle Exadata Storage Serverの物理ディスクを交換しているあいだ、Oracle Exadataラックはオンラインであり、使用可能です。この項では、次の項目について説明します。

- ハード・ディスクのステータスの監視

ハード・ディスクのステータスは、CellCLILIST PHYSICALDISKコマンドを使用して属性をチェックすることで監視できます。 - ディスク障害によるハード・ディスクの交換

- ディスクの問題によるハード・ディスクの交換

ハード・ディスクが警告 - 予測障害ステータスになったために、ディスクの交換が必要になることがあります。 - 低いパフォーマンスによるハード・ディスクの交換

1つの不良ハード・ディスクが、その他の正常なディスクのパフォーマンスを低下させることがあります。不良ディスクはそのままにしないでシステムから削除する必要があります。 - ハード・ディスクの事前交換

Exadata Storageソフトウェアは、ハード・ディスクで障害が発生した場合や、問題のあるディスクとしてフラグが設定された場合に、ハード・ディスクを保守するための自動化された操作を完備しています。ただし、状況によっては、構成からハード・ディスクを事前に取り外すことが必要になります。 - 別のExadata Storage Serverへのすべてのドライブの移動

Exadata Storage Server間ですべてのドライブの移動が必要になることがあります。 - ハード・ディスクの再利用

ディスクのすべてのデータを削除して、別の目的にディスクを使用できます。 - 同じハード・ディスクの取外しおよび交換

誤って意図しないハード・ディスクを取り外した場合はどうなるでしょうか。 - 拒否されたハード・ディスクの再有効化

不適切なスロットに挿入されたことが原因で物理ディスクが拒否された場合は、ディスクを再び有効にすることができます。

関連トピック

3.3.1 ハード・ディスクのステータスの監視

CellCLI LIST PHYSICALDISKコマンドを使用して属性をチェックすることによって、ハード・ディスクのステータスを監視できます。

たとえば、ハード・ディスクのステータスが障害 (以前のリリースでは、障害が発生したハード・ディスクのステータスはクリティカルでした)または警告 - 予測障害と同等の場合、問題が発生している可能性があり、交換が必要です。内部しきい値を超えると、ディスク・ファームウェアによってエラー・カウンタが保守され、ドライブはPredictive Failureとマーク付けされます。交換が必要かどうかは、セル・ソフトウェアではなくドライブによって決定されます。

ディスクI/Oエラーが発生すると、Oracle ASMはメディア・エラーによる読取りエラーの障害範囲の修理を実行します。ディスクはオンラインのままで、アラートは送信されません。Oracle ASMが物理的に対処されたメタデータ・ブロックに関する読取りエラーを取得すると、ブロックはミラーリングされず、ディスクはオフラインになります。その後、Oracle ASMはFORCEオプションを使用してディスクを削除します。

Oracle Exadata Storage Serverのハード・ディスク・ステータスは次のとおりです。

-

Oracle Exadata System Softwareリリース11.2.3.3以降:

- 正常

- 正常 - 交換のため切断

- 正常 - 制限されたオンライン

- 正常 - 制限されたオンライン - 交換のため切断

- 存在しない

- 失敗

- 障害 - 交換のため切断

- 障害 - 不適切なディスク・モデルのため拒否

- 障害 - 不適切なディスク・モデルのため拒否 - 交換のため切断

- 障害 - 間違ったスロットのため拒否

- 障害 - 間違ったスロットのため拒否 - 交換のため切断

- 警告 - 制限されたオンライン

- 警告 - 制限されたオンライン - 交換のため切断

- 警告 - ピア障害

- 警告 - 低いパフォーマンス

- 警告 - 低いパフォーマンス - 交換のため切断

- 警告 - 低いパフォーマンス、ライトスルー・キャッシュ

- 警告 - 予測障害、低いパフォーマンス

- 警告 - 予測障害、低いパフォーマンス - 交換のため切断

- 警告 - 予測障害、ライトスルー・キャッシュ

- 警告 - 予測障害

- 警告 - 予測障害 - 交換のため切断

- 警告 - 予測障害、低いパフォーマンス、ライトスルー・キャッシュ

- 警告 - ライトスルー・キャッシュ

-

Oracle Exadata System Softwareリリース11.2.3.2:

- 正常

- 正常 - 制限されたオンライン

- 存在しない

- 失敗

- 障害 - 不適切なディスク・モデルのため拒否

- 障害 - 間違ったスロットのため拒否

- 警告 - 制限されたオンライン

- 警告 - ピア障害

- 警告 - 低いパフォーマンス

- 警告 - 低いパフォーマンス、ライトスルー・キャッシュ

- 警告 - 予測障害、低いパフォーマンス

- 警告 - 予測障害、ライトスルー・キャッシュ

- 警告 - 予測障害

- 警告 - 予測障害、低いパフォーマンス、ライトスルー・キャッシュ

- 警告 - ライトスルー・キャッシュ

-

Oracle Exadata System Softwareリリース11.2.3.1.1以前:

- 正常

- critical

- 低いパフォーマンス

- 予測障害

- 存在しない

3.3.2 ディスク障害によるハード・ディスクの交換

ハード・ディスクの停止により、パフォーマンスおよびデータの冗長性の低下が発生する場合があります。したがって、すぐにディスクを新しいディスクに交換する必要があります。ディスクに障害が発生すると、ハード・ディスクのグリッド・ディスクに関連するOracle ASMディスクがFORCEオプションで自動的に削除され、Oracle ASMリバランスでデータの冗長性がリストアされます。

ディスクに障害が発生すると、Exadataアラートが生成されます。アラートには、ディスクを交換する特定の手順が含まれます。システムのアラート通知を構成している場合、電子メールでアラートが指定したアドレスに送信されます。

ハード・ディスクを交換すると、そのスロットの前のディスクにあったグリッド・ディスクとセル・ディスクは新しいハード・ディスクに再作成されます。これらのグリッド・ディスクがOracle ASMグループの一部である場合、ディスク・グループの冗長性およびASM_POWER_LIMITパラメータに基づいて、ディスクがディスク・グループに追加され、データがリバランスされます。

ノート:

BP4のOracle Databaseリリース12.1.0.2と一緒にOracle Exadata System Softwareリリース12.1.2.0を実行しているストレージ・サーバーの場合、Oracle ASMはリバランス操作のステータスについての電子メールを送信します。以前のリリースでは、管理者が操作のステータスをチェックする必要がありました。

以前のリリースについては、「ASMリバランス操作のステータスのチェック」で説明されているように、リバランス操作ステータスを確認してください。

次の手順は、ディスク障害によるハード・ディスクの交換方法を示しています。

まれに、自動ファームウェア更新が機能せず、LUNが再構築されない場合があります。これは、ms-odl.trcファイルをチェックして確認できます。

関連項目:

-

V$ASM_OPERATIONビューの詳細は、『Oracle Databaseリファレンス』 -

リバランス操作の詳細は、『Oracle Automatic Storage Management管理者ガイド』を参照してください。

3.3.3 ディスクの問題によるハード・ディスクの交換

ハード・ディスクが警告 - 予測障害ステータスになったために、ディスクの交換が必要になる場合もあります。

予測障害ステータスは、ハード・ディスクに障害が発生する可能性があり、できるだけすぐに交換する必要があることを示します。ハード・ドライブのグリッド・ディスクに関連するOracle ASMディスクが自動的に削除され、Oracle ASMリバランスで障害が発生する可能性のあるディスクから他のディスクにデータが移動されます。

ハード・ドライブが故障する前に削除を完了できなかった場合は、「ディスク障害によるハード・ディスクの交換」を参照してください

ディスクを削除すると、アラートが送信されます。ハード・ディスクを交換すると、スロットの前のディスクにあったグリッド・ディスクとセル・ディスクは新しいハード・ディスクに再作成されます。これらのグリッド・ディスクがOracle ASMディスク・グループの一部である場合、ディスク・グループの冗長性およびASM_POWER_LIMITパラメータに基づいて、ディスクがディスク・グループに追加され、データがリバランスされます。

ノート:

BP4のOracle Databaseリリース12.1.0.2と一緒にOracle Exadata System Softwareリリース12.1.2.0を実行しているOracle Exadata Storage Serverでは、Oracle ASMはリバランス操作のステータスについての電子メールを送信します。以前のリリースでは、管理者が操作のステータスをチェックする必要がありました。

以前のリリースについては、「ASMリバランス操作のステータスのチェック」で説明されているように、リバランス操作ステータスを確認してください。

関連項目:

V$ASM_OPERATIONビューの詳細は、『Oracle Databaseリファレンス』を参照してください。- リバランス操作のチューニングの詳細は、『Oracle Automatic Storage Management管理者ガイド』を参照してください。

V$ASM_DISK_STATビューの問合せの詳細は、『Oracle Databaseリファレンス』を参照してください。- 『Oracle Exadata System Softwareユーザーズ・ガイド』の

ALTER CELL VALIDATE CONFIGURATIONコマンドに関する項

3.3.4 低いパフォーマンスによるハード・ディスクの交換

1つの不良ハード・ディスクが、他の正常なディスクのパフォーマンスを低下させることがあります。不良ディスクはそのままにしないでシステムから削除する必要があります。

Oracle Exadata System Softwareリリース11.2.3.2以降では、パフォーマンスの低いディスクが自動的に識別され、アクティブな構成から削除されます。その後、Oracle Exadata Database Machineにより一連のパフォーマンス・テストが実行されます。CELLSRVでパフォーマンスの低いディスクが検出されると、セル・ディスクのステータスが正常 - 制限されたオンラインに変更され、ハード・ディスクのステータスが警告 - 制限されたオンラインに変更されます。

次の状況はディスク制限のトリガーとなります。

-

ディスクの応答停止。ストレージ・アラート・ログ内の原因コードは

CD_PERF_HANGです。 -

セル・ディスクの速度低下。次に例を示します。

-

サービス時間のしきい値が高い(原因コード

CD_PERF_SLOW_ABS) -

相対的サービス時間のしきい値が高い(原因コード

CD_PERF_SLOW_RLTV)

-

-

読取りまたは書込みでの長期待機時間。次に例を示します。

-

書込みでの待機時間が長い(原因コード

CD_PERF_SLOW_LAT_WT) -

読取りでの待機時間が長い(原因コード

CD_PERF_SLOW_LAT_RD) -

読取りおよび書込みでの待機時間が長い(原因コード

CD_PERF_SLOW_LAT_RW) -

頻繁に発生する個々のI/Oでの絶対的待機時間が非常に長い(原因コード

CD_PERF_SLOW_LAT_ERR)

-

-

I/Oエラーなどのエラー(原因コード

CD_PERF_IOERR)。

ディスクの問題が一時的なものであり、テストに合格した場合は、そのディスクは構成に戻されます。ディスクがテストに合格しない場合は、poor performanceとしてマークされ、Oracle Auto Service Request (ASR)によりディスク交換のためのサービス・リクエストが送信されます。可能な場合は、Oracle ASMによりグリッド・ディスクがテスト用にオフラインに変更されます。Oracle ASMがディスクをオフラインに変更できない場合、セル・ディスクのステータスは、ディスクを安全にオフラインに変更できるようになるまで、normal - confinedOnlineのまま変わりません。

ディスクのステータスの変更は、セルのアラート履歴にある次のエントリに関連付けられています。

MESSAGE ID date_time info "Hard disk entered confinement status. The LUN

n_m changed status to warning - confinedOnline. CellDisk changed status to normal

- confinedOnline. Status: WARNING - CONFINEDONLINE Manufacturer: name Model

Number: model Size: size Serial Number: serial_number Firmware: fw_release

Slot Number: m Cell Disk: cell_disk_name Grid Disk: grid disk 1, grid disk 2

... Reason for confinement: threshold for service time exceeded"

ストレージ・セルのアラート・ログには次の情報が記録されます。

CDHS: Mark cd health state change cell_disk_name with newState HEALTH_BAD_

ONLINE pending HEALTH_BAD_ONLINE ongoing INVALID cur HEALTH_GOOD

Celldisk entering CONFINE ACTIVE state with cause CD_PERF_SLOW_ABS activeForced: 0

inactiveForced: 0 trigger HistoryFail: 0, forceTestOutcome: 0 testFail: 0

global conf related state: numHDsConf: 1 numFDsConf: 0 numHDsHung: 0 numFDsHung: 0

...

ノート:

Oracle Exadata System Softwareリリース11.2.3.2より前のリリースでは、CALIBRATEコマンドを使用して不良ハード・ディスクを識別し、各ハード・ディスクについてスループットやIOPSが極端に低くないか調べてください。

次の手順は、不良ディスクが確認された場合のハード・ディスクの取外し方法を示しています。

関連項目:

-

ディスク・グループからのディスクの削除の詳細は、『Oracle Automatic Storage Management管理者ガイド』を参照してください。

3.3.5 ハード・ディスクの事前交換

Exadata Storageソフトウェアでは、ハード・ディスクで障害が発生したり、問題のあるディスクとしてフラグ付けされた場合に、自動化された一連の操作でディスクを保守できます。ただし、状況によっては、構成からハード・ディスクを事前に取り外すことが必要になります。

CellCLIのALTER PHYSICALDISKコマンドでは、DROP FOR REPLACEMENTオプションによって、データ損失のリスクなく安全に、正常に機能しているハード・ディスクを削除できるかどうかが確認されます。ただし、コマンドを実行した後、ストレージ・セルでハード・ディスクのグリッド・ディスクが非アクティブ化され、Oracle ASMディスク・グループでオフラインに設定されます。

ディスク・グループで十分な冗長性を確保できないリスクを抑えて、事前にハード・ディスクを交換するには、次の手順を実行します。

3.3.6 別のExadata Storage Serverへのすべてのドライブの移動

Exadata Storage Serverから別のExadata Storage Serverへのすべてのドライブの移動が必要になることがあります。

この作業が必要になるのは、マザーボードやILOM障害などのシャーシ・レベルのコンポーネント障害がある場合またはハードウェアの問題のトラブルシューティングを行う場合です。

関連項目:

-

Oracle Exadata Database Machine Oracle Auto Service Requestクイック・インストレーション・ガイド

- CellCLIユーティリティの詳細

-

ディスク修復時間の詳細は、Oracle Automatic Storage Management管理者ガイドを参照してください

3.3.7 ハード・ディスクの再利用

ディスクのすべてのデータを削除し、別の目的でディスクを使用できます。

ハード・ディスクを再利用する前に、ディスクのデータをコピーしてください。

システム・ディスク(ディスク0およびディスク1)に対してこの手順を使用した場合は、データ・パーティションのみが消去され、システム・パーティションは消去されません。

3.3.8 同じハード・ディスクの取外しおよび交換

誤って意図しないハード・ディスクを取り外した場合はどうなるでしょうか。

不注意で間違ったハード・ディスクを取り外した場合、ディスクを元に戻します。Oracle ASMディスク・グループに自動的に追加され、そのデータは再同期化されます。

ノート:

ディスク障害またはディスクの問題でディスクを交換すると、ディスク上でLEDが点灯し識別できます。

3.4 Oracle Exadata Storage Serverのフラッシュ・ディスクの保守

データはExadataセル間でミラー化され、書込み操作が少なくとも2つのストレージ・セルに送信されます。Oracle Exadata Storage Serverのフラッシュ・カードに問題が発生すると、別のOracle Exadata Storage Serverのミラー化されたデータによって読取りおよび書込み操作が実行されます。アプリケーションでサービスの中断は発生しません。

ライトバック・モード時にフラッシュ・カードに障害が発生すると、Oracle Exadata System Softwareは、ミラー・コピーからデータを読み取ってフラッシュ・キャッシュ内のデータを確認します。次に、フラッシュ・カードに障害が発生したセルにデータが書き込まれます。障害が発生したフラッシュ・キャッシュ内での損失データの場所が、Oracle Exadata System Softwareによってフラッシュの障害発生時に保存されます。損失データをミラー・コピーに置き換えることにより、復元が開始されます。復元中、グリッド・ディスクのステータスはACTIVE -- RESILVERING WORKINGになります。キャッシュがライトスルー・モードになっている場合、障害が発生したデバイスのデータはデータ・グリッド・ディスクにすでに存在しているため、ミラー復元の必要はありません。

- フラッシュ・ディスク障害によるフラッシュ・ディスクの交換

それぞれのOracle Exadata Storage Serverにフラッシュ・デバイスが装備されています。 - フラッシュ・ディスクの低下したパフォーマンス・ステータスについて

フラッシュ・ディスクのパフォーマンスが低下している場合は、ディスクの交換が必要になることがあります。 - フラッシュ・ディスクの問題によるフラッシュ・ディスクの交換

- フラッシュ・ディスクのホットプラグ交換の実行

Oracle Exadata Database Machine X7以降、Extreme Flash (EF)とHigh Capacity (HC)の両方のストレージ・サーバーはホットプラグに対応しています。 - ライトバック・フラッシュ・キャッシュの有効化

ディスクではなくフラッシュによって処理される書込み操作は、ライトバック・フラッシュ・キャッシュと呼ばれます。 - ライトバック・フラッシュ・キャッシュの無効化

ライトスルー・フラッシュ・キャッシュを有効にして、ライトバック・フラッシュ・キャッシュを無効化できます。 - フラッシュ・キャッシュの圧縮の有効化

- Exadataスマート・フラッシュ・キャッシュ使用状況統計の監視

- フラッシュ・キャッシュの圧縮の無効化

3.4.1 フラッシュ・ディスク障害によるフラッシュ・ディスクの交換

Oracle Exadata Storage Serverには、それぞれフラッシュ・デバイスが付属しています。

Oracle Exadata Database Machine X7以降では、Oracle Exadata Storage Serverでフラッシュ・デバイスはホットプラグに対応しています。Oracle Exadata Storage Server X7以降でフラッシュ・デバイスのホットプラグ交換を実行する場合は、ディスク・ステータスが交換のため切断になり、かつフラッシュ・カードの電源LEDが消灯している必要があり、このことは、フラッシュ・ディスクのオンライン交換が可能であることを示します。

注意:

電源LEDが点灯しているカードを取り外すと、システムがクラッシュする可能性があります。障害が発生したディスクのステータスが障害 - 交換のため切断であるのに電源LEDがまだ点灯している場合は、Oracleサポート・サービスに連絡してください。

Oracle Exadata Database Machine X6以前の場合、フラッシュ・デバイスはExtreme Flash (EF)ストレージ・サーバーではホットプラグ対応ですが、High Capacity (HC)ストレージ・サーバーではホットプラグ対応ではありません。HCストレージ・サーバーでは、ストレージ・サーバーを交換する前に電源を切断する必要があります。

障害が発生したフラッシュ・ディスクを確認するには、次のコマンドを使用します。

CellCLI> LIST PHYSICALDISK WHERE disktype=flashdisk AND status=failed DETAIL

Extreme Flashストレージ・サーバーからの出力例を次に示します。

name: NVME_10

deviceName: /dev/nvme7n1

diskType: FlashDisk

luns: 0_10

makeModel: "Oracle NVMe SSD"

physicalFirmware: 8DV1RA13

physicalInsertTime: 2016-09-28T11:29:13-07:00

physicalSerial: CVMD426500E21P6LGN

physicalSize: 1.4554837569594383T

slotNumber: 10

status: failed次に、Oracle Flash Accelerator F160 PCIeカードからの出力例を示します。

CellCLI> LIST PHYSICALDISK WHERE DISKTYPE=flashdisk AND STATUS=failed DETAIL

name: FLASH_5_1

deviceName: /dev/nvme1n1

diskType: FlashDisk

luns: 5_1

makeModel: "Oracle Flash Accelerator F160 PCIe Card"

physicalFirmware: 8DV1RA13

physicalInsertTime: 2016-11-30T21:24:45-08:00

physicalSerial: 1030M03UYM

physicalSize: 1.4554837569594383T

slotNumber: "PCI Slot: 5; FDOM: 1"

status: failed

次に、Sun Flash Accelerator F40 PCIeカードからの出力例を示します。

name: FLASH_5_3

diskType: FlashDisk

luns: 5_3

makeModel: "Sun Flash Accelerator F40 PCIe Card"

physicalFirmware: TI35

physicalInsertTime: 2012-07-13T15:40:59-07:00

physicalSerial: 5L002X4P

physicalSize: 93.13225793838501G

slotNumber: "PCI Slot: 5; FDOM: 3"

status: failed

PCIeカードの場合、nameおよびslotNumber属性は、PCIスロットおよびFDOM番号を示します。Extreme Flashストレージ・サーバーの場合、slotNumber属性は前面パネルのNVMeスロットを示します。

Oracle Exadata Database Machine X7以降のシステムでは、すべてのフラッシュ・ディスクがAdd-in-Card (AIC)方式でマザーボードのPCIeスロットに挿入されます。slotNumber属性は、EFストレージ・サーバーかHCストレージ・サーバーかを問わず、PCI番号およびFDOM番号を示します。

フラッシュ・ディスクの障害が検出されると、フラッシュ・ディスクとそのLUNで障害が発生したことを示すアラートが生成されます。アラート・メッセージには、PCIスロット番号とFDOM番号か、またはNVMeスロット番号が含まれています。これらの番号により、フィールド交換可能ユニット(FRU)が一意に識別されます。システムのアラート通知を構成している場合は、指定したアドレスにアラートが電子メール・メッセージで送信されます。

フラッシュ・ディスクの停止により、パフォーマンスの低下およびデータの冗長性が発生する場合があります。できるだけすぐに障害が発生したディスクを新しいフラッシュ・ディスクに交換する必要があります。フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、ストレージ・サーバーの有効なキャッシュ・サイズが縮小します。フラッシュ・ログにフラッシュ・ディスクを使用する場合、ディスクでフラッシュ・ログが無効になり、有効なフラッシュ・ログ・サイズが縮小します。グリッド・ディスクにフラッシュ・ディスクを使用する場合、FORCEオプションによってグリッド・ディスクに関連するOracle Automatic Storage Management (Oracle ASM)ディスクがOracle ASMディスク・グループから自動的に削除され、リバランス操作でデータの冗長性のリストアが開始されます。

次の手順は、フラッシュ・ディスクのオンライン交換をサポートしていないHigh Capacityストレージ・サーバーでディスク障害が発生した場合にFDOMを交換する方法を示しています。Extreme Flashストレージ・サーバーでのNVMeドライブの交換は、物理ディスクの交換と同様に、前面パネルからNVMeドライブを取り外して新しいものを挿入するのみです。ストレージ・サーバーを停止する必要はありません。

新しいフラッシュ・ディスクがシステムによって自動的に使用されます。フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、有効なキャッシュ・サイズが拡張します。グリッド・ディスクにフラッシュ・ディスクを使用する場合、グリッド・ディスクが新しいフラッシュ・ディスクに再作成されます。これらのグリッド・ディスクがOracle ASMディスク・グループの一部である場合、ディスク・グループの冗長性およびASM_POWER_LIMITパラメータに基づいて、ディスクがディスク・グループに追加され、データがリバランスされます。

関連項目:

- フラッシュ・ディスクのホットプラグ交換の実行

- Oracle DatabaseリファレンスのV$ASM_OPERATION

- 『Oracle Automatic Storage Management管理者ガイド』のASM_POWER_LIMIT

- 「関連ドキュメント」に記載されている、ご使用のシステムに適したPCIeカード・ユーザーズ・ガイド

3.4.2 フラッシュ・ディスクの低下したパフォーマンス・ステータスについて

フラッシュ・ディスクのパフォーマンスが低下している場合は、ディスクを交換する必要があることがあります。

ディスクが次のステータスのいすれかになるため、フラッシュ・ディスクの交換が必要な場合があります。

警告 - 予測障害警告 - 低いパフォーマンス警告 - ライトスルー・キャッシュ警告 - ピア障害

ノート:

リリース11.2.3.2.2より前のOracle Exadata System Softwareリリースの場合、ステータスはnot presentです。

フラッシュ・ディスクがpredictive failure、poor performance、write-through cachingまたはpeer failureステータスの場合、アラートが生成されます。アラートには、フラッシュ・ディスクを交換する特定の手順が含まれます。システムのアラート通知を構成している場合、電子メール・メッセージでアラートが指定したアドレスに送信されます。

予測障害

フラッシュ・ディスクのpredictive failureステータスは、フラッシュ・ディスクに障害が発生する可能性があり、できるだけすぐに交換する必要があることを示します。フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、引き続きフラッシュ・キャッシュとして使用されます。グリッド・ディスクにフラッシュ・ディスクを使用する場合、グリッド・ディスクに関連するOracle ASMディスクが自動的に削除され、Oracle ASMリバランスで障害が発生する可能性のあるディスクから他のディスクにデータが移動されます。

フラッシュ・ディスクが1つのため、フラッシュ・ディスクがpredictive failureになると、データがコピーされます。グリッド・ディスクにフラッシュ・ディスクを使用する場合、Oracle ASMと関連パートナが再びパートナになり、リバランスが実行されます。ライトバック・フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、フラッシュ・ディスクからグリッド・ディスクにデータがフラッシュされます。

predictive failureのフラッシュ・ディスクを確認するには、次のコマンドを使用します。

CellCLI> LIST PHYSICALDISK WHERE DISKTYPE=flashdisk AND STATUS= \

'warning - predictive failure' DETAIL

name: FLASH_1_1

deviceName: /dev/nvme3n1

diskType: FlashDisk

luns: 1_1

makeModel: "Oracle Flash Accelerator F160 PCIe Card"

physicalFirmware: 8DV1RA13

physicalInsertTime: 2016-11-30T21:24:45-08:00

physicalSerial: CVMD519000251P6KGN

physicalSize: 1.4554837569594383T

slotNumber: "PCI Slot: 1; FDOM: 1"

status: warning - predictive failure

低いパフォーマンス

フラッシュ・ディスクのpoor performanceステータスは、フラッシュ・ディスクのパフォーマンスが非常に低く、できるだけすぐに交換する必要があることを示します。Oracle Exadata System Softwareリリース11.2.3.2以降では、パフォーマンスの低いディスクが自動的に識別され、アクティブな構成から削除されます。フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、このディスクからフラッシュ・キャッシュが削除され、ストレージ・サーバーの有効なフラッシュ・キャッシュ・サイズが縮小します。グリッド・ディスクにフラッシュ・ディスクを使用する場合、このフラッシュ・ディスクのグリッド・ディスクに関連するOracle ASMディスクがFORCEオプションによって可能な場合に自動的に削除されます。オフライン・パートナのためにDROP...FORCEが失敗した場合、通常グリッド・ディスクが自動的に削除され、Oracle ASMリバランスでパフォーマンスの低いディスクから他のディスクにデータが移動されます。

その後、Oracle Exadata Database Machineにより一連のパフォーマンス・テストが実行されます。CELLSRVでパフォーマンスの低いディスクが検出されると、セル・ディスクのステータスがnormal - confinedOnlineに変更され、物理ディスクのステータスがwarning - confinedOnlineに変更されます。次の状況はディスク制限のトリガーとなります。

- ディスクの応答停止。ストレージ・アラート・ログ内の原因コードはCD_PERF_HANGです。

- セル・ディスクの速度低下。次に例を示します。

- サービス時間のしきい値が高い(原因コードCD_PERF_SLOW_ABS)

- 相対的サービス時間のしきい値が高い(原因コードCD_PERF_SLOW_RLTV)

- 読取りまたは書込みでの長期待機時間。次に例を示します。

- 書込みでの待機時間が長い(原因コードCD_PERF_SLOW_LAT_WT)

- 読取りでの待機時間が長い(原因コードCD_PERF_SLOW_LAT_RD)

- 読取りおよび書込みでの待機時間が長い(原因コードCD_PERF_SLOW_LAT_RW)

- 頻繁に発生する個々のI/Oでの絶対的待機時間が非常に長い(原因コードCD_PERF_SLOW_LAT_ERR)

- I/Oエラーなどのエラー(原因コードCD_PERF_IOERR)。

ディスクの問題が一時的なものであり、テストに合格した場合は、そのディスクは構成に戻されます。ディスクがテストに合格しない場合は、poor performanceとしてマークされ、Oracle Auto Service Request (ASR)によりディスク交換のためのサービス・リクエストが送信されます。可能な場合は、Oracle ASMによりグリッド・ディスクがテスト用にオフラインに変更されます。Oracle ASMがディスクをオフラインに変更できない場合、セル・ディスクのステータスは、ディスクを安全にオフラインに変更できるようになるまで、normal - confinedOnlineのまま変わりません。

poor performanceのフラッシュ・ディスクを確認するには、次のコマンドを使用します。

CellCLI> LIST PHYSICALDISK WHERE DISKTYPE=flashdisk AND STATUS= \

'warning - poor performance' DETAIL

name: FLASH_1_4

diskType: FlashDisk

luns: 1_4

makeModel: "Sun Flash Accelerator F20 PCIe Card"

physicalFirmware: D20Y

physicalInsertTime: 2012-09-27T13:11:16-07:00

physicalSerial: 508002000092e70FMOD2

physicalSize: 22.8880615234375G

slotNumber: "PCI Slot: 1; FDOM: 3"

status: warning - poor performance

ディスクのステータスの変更は、セルのアラート履歴にある次のエントリに関連付けられています。

MESSAGE ID date_time info "Hard disk entered confinement status. The LUN

n_m changed status to warning - confinedOnline. CellDisk changed status to normal

- confinedOnline. Status: WARNING - CONFINEDONLINE Manufacturer: name Model

Number: model Size: size Serial Number: serial_number Firmware: fw_release

Slot Number: m Cell Disk: cell_disk_name Grid Disk: grid disk 1, grid disk 2

... Reason for confinement: threshold for service time exceeded"

ストレージ・サーバーのアラート・ログには次の情報が記録されます。

CDHS: Mark cd health state change cell_disk_name with newState HEALTH_BAD_

ONLINE pending HEALTH_BAD_ONLINE ongoing INVALID cur HEALTH_GOOD

Celldisk entering CONFINE ACTIVE state with cause CD_PERF_SLOW_ABS activeForced: 0

inactiveForced: 0 trigger HistoryFail: 0, forceTestOutcome: 0 testFail: 0

global conf related state: numHDsConf: 1 numFDsConf: 0 numHDsHung: 0 numFDsHung: 0

...

ノート:

11.2.3.2より前のOracle Exadata System Softwareリリースでは、CALIBRATEコマンドを使用して不良フラッシュ・ディスクを識別し、各フラッシュ・ディスクについてスループットやIOPSが極端に低くないか調べてください。

フラッシュ・ディスクのパフォーマンスが非常に低い場合、poor performanceとしてマークされます。該当するフラッシュ・ディスクのフラッシュ・キャッシュが自動的に無効になり、そのフラッシュ・ディスクのグリッド・ディスクがOracle ASMディスク・グループから自動的に削除されます。

ライトスルー・キャッシュ

フラッシュ・ディスクのwrite-through cachingステータスは、PCIeカードのデータ・キャッシュのサポートに使用するキャパシタに障害が発生したため、できるだけすぐにカードを交換する必要があることを示します。

peer failure

フラッシュ・ディスクのpeer failureステータスは、同じSun Flash Accelerator PCIeカードのいずれかのフラッシュ・ディスクに障害または問題が発生したことを示します。たとえば、FLASH_5_3に障害が発生すると、FLASH_5_0、FLASH_5_1およびFLASH_5_2がpeer failureステータスになります。次に、例を示します。

CellCLI> LIST PHYSICALDISK

36:0 L45F3A normal

36:1 L45WAE normal

36:2 L45WQW normal

...

FLASH_5_0 5L0034XM warning - peer failure

FLASH_5_1 5L0034JE warning - peer failure

FLASH_5_2 5L002WJH warning - peer failure

FLASH_5_3 5L002X4P failed

CellSRVにより、ライトバック・フラッシュ・キャッシュに使用されているフラッシュ・ディスクで予測障害またはピア障害が検出され、不良FDOMが1つのみの場合は、その不良FDOMのデータが復元され、残りの3つのFDOMのデータはフラッシュされます。その後、有効なグリッド・ディスクが存在する場合、CellSRVはディスクに対してOracle ASMリバランスを開始します。不良ディスクは、タスクが完了するまで交換できません。ディスク交換が可能になると、MSによりアラートが送信されます。

3.4.3 フラッシュ・ディスクの問題によるフラッシュ・ディスクの交換

Oracle Exadata Storage Serverには、4枚のPCIeカードが付属しています。各カードに4個のフラッシュ・ディスク(FDOM)があり、合計16個のフラッシュ・ディスクが提供されます。4枚のPCIeカードは、PCIスロット番号1、2、4および5にあります。Oracle Exadata Database Machine X7以上では、ストレージ・サーバーの電源を切断しなくてもPCIeカードを交換できます。フラッシュ・ディスクのホットプラグ交換の実行を参照してください。

Oracle Exadata Database Machine X6以前のシステムでは、PCIeカードはホットプラグに対応していません。フラッシュ・ディスクまたはカードを交換する前にOracle Exadata Storage Serverの電源を切断する必要があります。

Oracle Exadata Database Machine X7以降では、High Capacityストレージ・サーバーおよびExtreme Flashストレージ・サーバーの各フラッシュ・カードは、フィールド交換可能ユニット(FRU)です。フラッシュ・カードはホットプラグにも対応しており、ストレージ・サーバーを停止しなくても取り外すことができます。

Oracle Exadata Database Machine X5およびX6システムでは、High Capacity上の各フラッシュ・カードおよびExtreme Flash上の各フラッシュ・ドライブはFRUです。これは、これらのシステムにはピア障害がないことを意味します。

Oracle Exadata Database Machine X3およびX4システムでは、フラッシュ・カード自体がFRUであるため、FDOMで障害が発生した場合、Oracle Exadata System Softwareは、そのカードの残りのFDOMを自動的にピア障害の状態にして、フラッシュ・カード交換の準備のためにデータを移動できるようにします。

Oracle Exadata Database Machine V2およびX2システムでは、各FDOMはFRUです。これらのシステムのフラッシュにはピア障害がありません。

ディスク交換にいつ進むかの決定は、次に示されているように、リリースによって異なります。

-

Oracle Exadata System Softwareリリース11.2.3.2より前の場合:

フラッシュ・ディスクの交換に進む前に、

V$ASM_DISK_STATビューの問合せを実行してOracle ASMディスクが正常に削除されるまで待機します。フラッシュ・ディスクで障害が発生する前に通常の削除を完了できなかった場合、FORCEオプションによってOracle ASMディスク・グループからOracle ASMディスクが自動的に削除されます。フラッシュ・ディスクで障害が発生する前にDROPコマンドが完了しなかった場合は、「フラッシュ・ディスク障害によるフラッシュ・ディスクの交換」を参照してください。 -

Oracle Exadata System Softwareリリース11.2.3.2以降の場合:

Oracle ASMディスクが削除されている場合は、アラートが送信され、フラッシュ・ディスクを安全に交換できます。フラッシュ・ディスクをライトバック・フラッシュ・キャッシュに使用する場合、フラッシュ・ディスクによってキャッシュされるグリッド・ディスクがなくなるまで待機します。すべてのグリッド・ディスクの

cachedBy属性をチェックするには、次のコマンドを使用します。フラッシュ・ディスクのセル・ディスクは、グリッド・ディスクのcachedBy属性には表示されません。CellCLI> LIST GRIDDISK ATTRIBUTES name, cachedByフラッシュ・ディスクをグリッド・ディスクとフラッシュ・キャッシュの両方に使用する場合は、アラートを受信し、セル・ディスクがグリッド・ディスクの

cachedBy属性に表示されなくなるまで待機します。

次の手順では、ディスクの問題により、Oracle Exadata Database Machine X6以前のHigh Capacityストレージ・サーバーのフラッシュ・ディスクを交換する方法について説明します。

ノート:

Oracle Exadata Database Machine X6のExtreme Flashストレージ・サーバーおよびOracle Exadata Database Machine X7以降のすべてのストレージ・サーバーでは、前面パネルからフラッシュ・ディスクを取り外し、新しいフラッシュ・ディスクを挿入するだけです。ストレージ・サーバーを停止する必要はありません。新しいフラッシュ・ディスクがシステムによって自動的に使用されます。フラッシュ・キャッシュにフラッシュ・ディスクを使用する場合、有効なキャッシュ・サイズが拡張します。グリッド・ディスクにフラッシュ・ディスクを使用する場合、グリッド・ディスクが新しいフラッシュ・ディスクに再作成されます。これらのグリッド・ディスクがOracle ASMディスク・グループの一部である場合、ディスク・グループの冗長性およびASM_POWER_LIMITパラメータに基づいて、ディスクがディスク・グループに追加され、データがリバランスされます。

関連項目:

ASM_POWER_LIMITパラメータの詳細は、Oracle Automatic Storage Management管理者ガイドを参照してください- 「関連ドキュメント」に記載されている、ご使用のシステムに適したPCIeカード・ユーザーズ・ガイド

3.4.4 フラッシュ・ディスクのホットプラグ交換の実行

Oracle Exadata Database Machine X7以上では、フラッシュ・ディスクはExtreme Flash (EF)ストレージ・サーバーとHigh Capacity (HC)ストレージ・サーバーの両方でホットプラグに対応しています。

また、Oracle Exadata Database Machine X6以前の場合、EFストレージ・サーバーのフラッシュ・デバイスはホットプラグ対応です。ただし、Oracle Exadata Database Machine X6以前のシステムのHCストレージ・サーバーの場合、フラッシュ・ディスクを交換する前にストレージ・サーバーの電源を切断する必要があります。

ホットプラグ対応のフラッシュ・ディスク・デバイスを交換するには:

3.4.5 ライトバック・フラッシュ・キャッシュの有効化

ディスクではなくフラッシュによって処理される書込み操作は、ライトバック・フラッシュ・キャッシュと呼ばれます。

Oracle Exadata System Softwareリリース11.2.3.2.1以上では、Exadataスマート・フラッシュ・キャッシュにより、頻繁にアクセスするデータを高速のソリッド状態の記憶装置に透過的にキャッシュして、問合せの応答時間とスループットを向上させることができます。

- 11.2.3.3.1以降でのライトバック・フラッシュ・キャッシュの有効化

ストレージ・サーバーのライトバック・フラッシュ・キャッシュを有効にして、問合せの応答時間とスループットを向上させます。 - 11.2.3.3.1より前のソフトウェア・バージョンのローリング形式でのライトバック・フラッシュ・キャッシュの有効化

ライトバック・フラッシュ・キャッシュは、ローリング形式で有効化できます。 - 11.2.3.3.1より前のソフトウェア・バージョンの非ローリング形式でのライトバック・フラッシュ・キャッシュの有効化

ライトバック・フラッシュ・キャッシュは、非ローリング形式で有効化できます。

3.4.5.1 11.2.3.3.1以上でのライトバック・フラッシュ・キャッシュの有効化

ストレージ・サーバーのライトバック・フラッシュ・キャッシュを有効にして、問合せの応答時間とスループットを向上させます。

Oracle Exadata System Softwareリリース11.2.3.3.1以降では、フラッシュ・キャッシュをライトスルー・モードからライトバック・モードに変更するときに、セル・サービスを停止したり、グリッド・ディスクを非アクティブ化する必要はありません。

ノート:

フラッシュ・キャッシュを削除して再作成すると、データベース操作のパフォーマンスに影響します。フラッシュ・キャッシュが再移入される間に、データベース・パフォーマンスに影響するキャッシュ・ミスがあります。親トピック: ライトバック・フラッシュ・キャッシュの有効化

3.4.5.2 11.2.3.3.1より前のソフトウェア・バージョンのローリング形式でのライトバック・フラッシュ・キャッシュの有効化

ライトバック・フラッシュ・キャッシュは、ローリング形式で有効化できます。

フラッシュ・キャッシュの属性をwritethroughからwritebackに変更するには、まず、そのフラッシュ・キャッシュを削除しておく必要があります。11.2.3.3.1より前のリリースのOracle Exadata System Softwareでは、ライトバック・フラッシュ・キャッシュを有効にするときに、セル・サービスを停止するか、グリッド・ディスクを非アクティブ化する必要があります。

ライトバック・フラッシュ・キャッシュの有効化と無効化を自動化するためのシェル・スクリプトが用意されています。スクリプトおよび詳細は、My Oracle Supportノート1500257.1を参照してください。

ノート:

フラッシュ・キャッシュを削除して再作成すると、データベース操作のパフォーマンスに影響します。フラッシュ・キャッシュが再移入される間に、データベース・パフォーマンスに影響するキャッシュ・ミスがあります。ライトバック・フラッシュ・キャッシュを使用するには、Oracle Grid InfrastructureホームおよびOracle Databaseホームをリリース11.2.0.3 BP9以上にする必要があります。Oracle Exadata System Software、Oracle Grid InfrastructureホームおよびOracle Databaseホームの最小リリース要件は、My Oracle Supportノート888828.1を参照してください。

3.4.5.3 11.2.3.3.1より前のソフトウェア・バージョンの非ローリング形式でのライトバック・フラッシュ・キャッシュの有効化

ライトバック・フラッシュ・キャッシュは、非ローリング形式で有効化できます。

flashCacheMode属性を変更する前に、セル・サービスをシャットダウンする必要があります。11.2.3.3.1より前のリリースのOracle Exadata System Softwareでは、非ローリング形式でライトバック・フラッシュ・キャッシュを無効にするときに、セル・サービスを停止する必要があります。

ライトバック・フラッシュ・キャッシュの有効化と無効化を自動化するためのシェル・スクリプトが用意されています。スクリプトおよび詳細は、My Oracle Supportノート1500257.1を参照してください。

ライトバック・フラッシュ・キャッシュを使用するには、Oracle Grid InfrastructureホームおよびOracle Databaseホームをリリース11.2.0.3 BP9以上にする必要があります。Oracle Exadata System Software、Oracle Grid InfrastructureホームおよびOracle Databaseホームの最小リリース要件は、My Oracle Supportノート888828.1を参照してください。

親トピック: ライトバック・フラッシュ・キャッシュの有効化

3.4.6 ライトバック・フラッシュ・キャッシュの無効化

ライトスルー・フラッシュ・キャッシュを有効にして、ライトバック・フラッシュ・キャッシュを無効化できます。

Oracle Exadata System Softwareリリース11.2.3.2.1以降では、Exadataスマート・フラッシュ・キャッシュにより、頻繁にアクセスするデータが高速のソリッドステート記憶装置に透過的にキャッシュされ、問合せの応答時間とスループットを向上させることができます。

ディスクではなくフラッシュによって処理される書込み操作は、「ライトバック・フラッシュ・キャッシュ」と呼ばれます。

- ライトバックPMEMキャッシュとライトバック・フラッシュ・キャッシュの無効化

- 11.2.3.3.1以上でのライトバック・フラッシュ・キャッシュの無効化

モードをライトスルーに変更することで、ストレージ・サーバーのライトバック・フラッシュ・キャッシュを無効化できます。 - 11.2.3.3.1より前のソフトウェア・バージョンのローリング形式でのライトバック・フラッシュ・キャッシュの無効化

ローリング方式を使用して、各ストレージ・サーバーのライトバック・フラッシュ・キャッシュを有効化できます。 - 11.2.3.3.1より前のソフトウェア・バージョンの非ローリング形式でのライトバック・フラッシュ・キャッシュの無効化

ライトバック・フラッシュ・キャッシュは、非ローリング形式で有効化できます。

3.4.6.1 ライトバックPMEMキャッシュとライトバック・フラッシュ・キャッシュの無効化

Oracle Exadata System Softwareリリース23.1.0より前のリリースでは、ライトバックPMEMキャッシュはライトバック・フラッシュ・キャッシュとの組合せでのみサポートされています。したがって、ライトバックPMEMキャッシュが有効な場合、ライトバック・フラッシュ・キャッシュを無効にするには、ライトバックPMEMキャッシュも無効にする必要があります。

この要件は、Oracle Exadata System Softwareリリース23.1.0より前に対してのみ適用されます。これはPMEMキャッシュがOracle Exadata System Softwareリリース23.1.0以降のライトスルー・モードでのみ動作するためです。

ノート:

アプリケーションのパフォーマンスへの影響を抑えるには、ワークロードが低い期間にキャッシュ・モードを変更します。

次のコマンド例では、手順の対象となるストレージ・サーバーのホスト名を含むcell_groupという名前のテキスト・ファイルを使用します。

親トピック: ライトバック・フラッシュ・キャッシュの無効化

3.4.6.2 11.2.3.3.1以上でのライトバック・フラッシュ・キャッシュの無効化

モードをライトスルーに変更することで、ストレージ・サーバーのライトバック・フラッシュ・キャッシュを無効化できます。

リリース11.2.3.3.1以上では、CELLSRVプロセスを停止する必要も、グリッド・ディスクを非アクティブ化する必要もありません。

ノート:

アプリケーションのパフォーマンスへの影響を抑えるには、ワークロードが低い期間にライトバック・フラッシュ・キャッシュを無効化します。親トピック: ライトバック・フラッシュ・キャッシュの無効化

3.4.6.3 11.2.3.3.1より前のソフトウェア・バージョンのローリング形式でのライトバック・フラッシュ・キャッシュの無効化

ローリング方式を使用して、各ストレージ・サーバーのライトバック・フラッシュ・キャッシュを有効化できます。

flashCacheMode属性を変更する前に、セル・サービスをシャットダウンする必要があります。セル・サービスは、ローリング形式でシャットダウンできます。属性をwritethroughに変更する前に、フラッシュ・キャッシュをフラッシュして削除する必要があります。フラッシュ操作が開始されると、フラッシュ・キャッシュへのすべてのキャッシュが停止されます。現在のストレージ・サーバーでセル・サービスの再同期化が完了してから、次のストレージ・サーバーを変更してください。

ライトバック・フラッシュ・キャッシュの有効化と無効化を自動化するためのシェル・スクリプトが用意されています。スクリプトおよび詳細は、My Oracle Supportノート1500257.1を参照してください。

親トピック: ライトバック・フラッシュ・キャッシュの無効化

3.4.6.4 11.2.3.3.1より前のソフトウェア・バージョンの非ローリング形式でのライトバック・フラッシュ・キャッシュの無効化

ライトバック・フラッシュ・キャッシュは、非ローリング形式で有効化できます。

フラッシュ・キャッシュ・モードを非ローリング形式で変更する場合は、クラスタ全体(Oracle Clusterwareスタックとすべてのデータベースを)含むを停止してください。flashCacheMode属性を変更する前に、セル・サービスをシャットダウンする必要があります。属性をwritethroughに変更する前に、フラッシュ・キャッシュをフラッシュして削除する必要があります。フラッシュ・キャッシュのフラッシュ操作は、クラスタ全体を停止する前に実行できます。フラッシュ操作が開始されると、フラッシュ・キャッシュへのすべてのキャッシュが停止されます。

親トピック: ライトバック・フラッシュ・キャッシュの無効化

3.4.7 フラッシュ・キャッシュの圧縮の有効化

Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X3-8フル・ラックの各システムでは、フラッシュ・キャッシュの圧縮を有効にできます。Oracle Exadata Database Machine X5-2およびX5-8以降のシステムにフラッシュ・キャッシュの圧縮機能はありません。フラッシュ・キャッシュの圧縮では、ユーザー・データがフラッシュ・キャッシュにロードされる際にデータを透過的に圧縮することによって、フラッシュ・キャッシュの論理容量が大幅に増加します。

ノート:

-

フラッシュ・キャッシュ圧縮を有効化するには、Oracle拡張圧縮オプションが必要です。

-

フラッシュ・キャッシュの圧縮を有効にした場合、ユーザー・データは保持されません。

次の手順では、フラッシュ・キャッシュの圧縮を有効にする方法について説明します。

3.4.9 フラッシュ・キャッシュの圧縮の無効化

Oracle Exadata Database Machine X4-2、Oracle Exadata Database Machine X3-2およびOracle Exadata Database Machine X3-8フル・ラックの各システムでは、フラッシュ・キャッシュの圧縮を無効にできます。Oracle Exadata Database Machine X5-2、X5-8およびそれ以上のシステムにフラッシュ・キャッシュの圧縮機能はありません。

ノート:

-

フラッシュ・キャッシュの圧縮を無効にした場合、ユーザー・データは保持されません。

次の手順では、フラッシュ・キャッシュの圧縮を無効にする方法について説明します。

3.5 Oracle Exadata Storage ServerのPMEMデバイスの保守

永続メモリー(PMEM)デバイスは、大容量(HC)またはExtreme Flash (EF)ストレージを持つExadata X8M-2およびX9M-2ストレージ・サーバー・モデル内に存在します。

PMEMデバイスに障害が発生すると、Oracle Exadata System Softwareは障害が発生したデバイスを分離し、デバイスを使用してキャッシュを自動的にリカバリします。

キャッシュがライトバック・モードの場合、リカバリ操作(ミラー復元とも呼ばれる)はミラー・コピーを読み取ることで、失われたデータをリストアします。復元中、グリッド・ディスクのステータスはACTIVE -- RESILVERING WORKINGになります。キャッシュがライトスルー・モードになっている場合、障害が発生したPMEMデバイスのデータはデータ・グリッド・ディスクにすでに保存されており、リカバリは必要ありません。

- デバイス障害によるPMEMデバイスの交換

PMEMデバイスのステータスがFailedの場合は、Oracle Exadata Storage ServerのPMEMデバイスを交換する必要があります。 - パフォーマンスの低下によるPMEMデバイスの交換

PMEMデバイスのパフォーマンスが低下している場合は、モジュールの交換が必要になることがあります。 - ライトバックPMEMキャッシュの有効化および無効化

3.5.1 デバイス障害によるPMEMデバイスの交換

PMEMデバイスのステータスがFailedの場合は、Oracle Exadata Storage ServerのPMEMデバイスを交換する必要があります。

PMEMの障害は、サーバーの再起動の原因になることがあります。障害が発生したデバイスは、できるだけすぐに新しいPMEMデバイスに交換する必要があります。PMEMデバイスを交換するまでは、対応するキャッシュ・サイズが減少します。PMEMデバイスをコミット・アクセラレーション(XRMEMLOGまたはPMEMLOG)に使用すると、対応するコミット・アクセラレータのサイズも減少します。

PMEMデバイスの障害が検出されると、アラートが生成されます。アラート・メッセージには、スロット番号とセル・ディスク名が含まれています。システムのアラート通知を構成している場合は、指定したアドレスにアラートが電子メール・メッセージで送信されます。

障害が発生したPMEMデバイスの特定には、次のコマンドを使用することもできます。

CellCLI> LIST PHYSICALDISK WHERE disktype=PMEM AND status=failed DETAIL

name: PMEM_0_1

diskType: PMEM

luns: P0_D1

makeModel: "Intel NMA1XBD128GQS"

physicalFirmware: 1.02.00.5365

physicalInsertTime: 2019-09-28T11:29:13-07:00

physicalSerial: 8089-A2-1838-00001234

physicalSize: 126.375G

slotNumber: "CPU: 0; DIMM: 1"

status: failed前述の出力で、slotNumberにソケット番号とDIMMスロット番号が表示されます。

新しいPMEMデバイスがシステムによって自動的に使用されています。キャッシュにPMEMデバイスを使用している場合は、有効なキャッシュ・サイズが増加します。PMEMデバイスをコミット・アクセラレーションに使用すると、デバイス上でコミット・アクセラレーションが有効になります。

3.5.2 パフォーマンスの低下によるPMEMデバイスの交換

PMEMデバイスのパフォーマンスが低下している場合は、モジュールの交換が必要になることがあります。

PMEMデバイスでパフォーマンスの低下が検出された場合、モジュール・ステータスはwarning - predictive failureに設定され、アラートが生成されます。このアラートには、PMEMデバイスの交換に関する特定の手順が含まれています。システムのアラート通知を構成している場合、電子メール・メッセージでアラートが指定したアドレスに送信されます。

predictive failure (予測障害)ステータスは、PMEMデバイスに障害が発生する可能性があり、できるだけ早く交換する必要があることを示しています。新しいデータは、交換されるまでPMEMデバイスにキャッシュされません。

ステータスがpredictive failure (予測障害)のPMEMデバイスの特定には、次のコマンドを使用することもできます。

CellCLI> LIST PHYSICALDISK WHERE disktype=PMEM AND status='warning - predictive failure' DETAIL

name: PMEM_0_6

diskType: PMEM

luns: P0_D6

makeModel: "Intel NMA1XBD128GQS"

physicalFirmware: 1.02.00.5365

physicalInsertTime: 2019-11-30T21:24:45-08:00

physicalSerial: 8089-A2-1838-00001234

physicalSize: 126.375G

slotNumber: "CPU: 0; DIMM: 6"

status: warning - predictive failure

そのPMEMデバイスは、LIST DISKMAPコマンドで次の情報によって特定することもできます。

CellCLI> LIST DISKMAP

Name PhysicalSerial SlotNumber Status PhysicalSize

CellDisk DevicePartition GridDisks

PMEM_0_1 8089-a2-0000-00000460 "CPU: 0; DIMM: 1" normal 126G

PM_00_cel01 /dev/dax5.0 PMEMCACHE_PM_00_cel01

PMEM_0_3 8089-a2-0000-000004c2 "CPU: 0; DIMM: 3" normal 126G

PM_02_cel01 /dev/dax4.0 PMEMCACHE_PM_02_cel01

PMEM_0_5 8089-a2-0000-00000a77 "CPU: 0; DIMM: 5" normal 126G

PM_03_cel01 /dev/dax3.0 PMEMCACHE_PM_03_cel01

PMEM_0_6 8089-a2-0000-000006ff "CPU: 0; DIMM: 6" warning - 126G

PM_04_cel01 /dev/dax0.0 PMEMCACHE_PM_04_cel01

PMEM_0_8 8089-a2-0000-00000750 "CPU: 0; DIMM: 8" normal 126G

PM_05_cel01 /dev/dax1.0 PMEMCACHE_PM_05_cel01

PMEM_0_10 8089-a2-0000-00000103 "CPU: 0; DIMM: 10" normal 126G

PM_01_cel01 /dev/dax2.0 PMEMCACHE_PM_01_cel01

PMEM_1_1 8089-a2-0000-000008f6 "CPU: 1; DIMM: 1" normal 126G

PM_06_cel01 /dev/dax11.0 PMEMCACHE_PM_06_cel01

PMEM_1_3 8089-a2-0000-000003bb "CPU: 1; DIMM: 3" normal 126G

PM_08_cel01 /dev/dax10.0 PMEMCACHE_PM_08_cel01

PMEM_1_5 8089-a2-0000-00000708 "CPU: 1; DIMM: 5" normal 126G

PM_09_cel01 /dev/dax9.0 PMEMCACHE_PM_09_cel01

PMEM_1_6 8089-a2-0000-00000811 "CPU: 1; DIMM: 6" normal 126G

PM_10_cel01 /dev/dax6.0 PMEMCACHE_PM_10_cel01

PMEM_1_8 8089-a2-0000-00000829 "CPU: 1; DIMM: 8" normal 126G

PM_11_cel01 /dev/dax7.0 PMEMCACHE_PM_11_cel01

PMEM_1_10 8089-a2-0000-00000435 "CPU: 1; DIMM: 10" normal 126G

PM_07_cel01 /dev/dax8.0 PMEMCACHE_PM_07_cel01

PMEMデバイスがライトバック・キャッシュに使用されている場合、データはPMEMデバイスからフラッシュ・キャッシュにフラッシュされます。PMEMデバイスからデータがフラッシュされていることを確認するには、すべてのグリッド・ディスクのcachedBy属性を調べて、影響を受けたPMEMデバイスがリストされていないことを確認します。

新しいPMEMデバイスがシステムによって自動的に使用されています。キャッシュにPMEMデバイスを使用している場合は、有効なキャッシュ・サイズが増加します。PMEMデバイスをコミット・アクセラレーションに使用すると、デバイス上でコミット・アクセラレーションが有効になります。

3.5.3 ライトバックPMEMキャッシュの有効化および無効化

Oracle Exadata System Softwareリリース23.1.0より前は、PMEMキャッシュをライトバック・モードで動作するように構成できます。このモードは、ライトバックPMEMキャッシュとも呼ばれ、キャッシュが書込み操作を処理できるようにします。

ノート:

ベスト・プラクティスの推奨事項は、PMEMキャッシュをライトスルー・モードで構成することです。この構成によって、最高のパフォーマンスと可用性が提供されます。

Oracle Exadata System Softwareリリース23.1.0以降、PMEMキャッシュはライトスルー・モードでのみ動作します。

- ライトバックPMEMキャッシュの有効化

- ライトバックPMEMキャッシュの無効化

ストレージ・サーバーのライトバックPMEMキャッシュを無効化する必要がある場合は、次のステップを使用します。

3.5.3.1 ライトバックPMEMキャッシュの有効化

ライトバックPMEMキャッシュは、ライトバック・フラッシュ・キャッシュとの組合せでのみサポートされます。したがって、ライトバックPMEMキャッシュを有効にするには、ライトバック・フラッシュ・キャッシュも有効にする必要があります。

ノート:

Oracle Exadata System Softwareリリース23.1.0以降では、PMEMキャッシュはライトスルー・モードでのみ動作するため、ライトバックPMEMキャッシュを有効にすることはできません。

ノート:

アプリケーションのパフォーマンスへの影響を抑えるには、ワークロードが低い期間にキャッシュ・モードを変更します。

次のコマンド例では、手順の対象となるストレージ・サーバーのホスト名を含むcell_groupという名前のテキスト・ファイルを使用します。

親トピック: ライトバックPMEMキャッシュの有効化および無効化

3.5.3.2 ライトバックPMEMキャッシュの無効化

ストレージ・サーバーのライトバックPMEMキャッシュを無効化する必要がある場合は、次のステップを使用します。

ライトバックPMEMキャッシュを無効化するときには、cellsrvプロセスを停止する必要も、グリッド・ディスクを非アクティブ化する必要もありません。ただし、アプリケーションのパフォーマンスへの影響を抑えるために、ライトバックPMEMキャッシュはワークロードが低い期間に無効化してください。

親トピック: ライトバックPMEMキャッシュの有効化および無効化

3.6 Oracle Exadata Storage ServerのM.2ディスクの保守

Oracle Exadata X7以降のシステムには、システム領域を含む2つの内蔵M.2デバイスが付属しています。

以前のすべてのシステムでは、Oracle Exadata Storage Serverの最初の2つのディスクがシステム・ディスクで、これらのシステム・ディスクの一部がシステム領域と呼ばれています。

ノート:

Oracle ExadataラックおよびOracle Exadata Storage Serverは、M.2ディスクの交換中もオンライン状態で使用可能です。- M.2ディスクのステータスの監視

M.2ディスクのステータスは、CellCLILIST PHYSICALDISKコマンドを使用して属性をチェックすることで監視できます。 - 障害またはその他の問題によるM.2ディスクの交換

3.6.1 M.2ディスクのステータスの監視

CellCLI LIST PHYSICALDISKコマンドを使用して属性をチェックすることによって、M.2ディスクのステータスを監視できます。

ディスク・ファームウェアによってエラー・カウンタが保守され、ディスクで障害が発生しそうになると、ドライブに予測障害というマークが付けられます。交換が必要かどうかは、セル・ソフトウェアではなくドライブによって決定されます。

3.6.2 障害またはその他の問題によるM.2ディスクの交換

M.2ディスクで障害が発生すると、システム領域の冗長性が低くなり、パッチ適用、イメージ化およびシステムのレスキューに影響を及ぼす場合があります。したがって、すぐにディスクを新しいディスクに交換する必要があります。M.2ディスクで障害が発生すると、非アクティブなシステム・ディスクに格納されているソフトウェアを使用するようにストレージ・サーバーが自動的かつ透過的に切り替わり、そのシステム・ディスクがアクティブになります。

M.2ディスクに障害が発生すると、Exadataアラートが生成されます。アラートには、ディスクを交換する特定の手順が含まれます。システムのアラート通知を構成している場合、電子メールでアラートが指定したアドレスに送信されます。

M.2ディスクはホットプラグ対応で、電源の投入時に交換できます。

M.2ディスクの交換後、Oracle Exadata System Softwareによって新しいデバイスが自動的にシステム・パーティションに追加され、再構築プロセスが開始されます。

3.7 Oracle Exadata System Softwareのレスキュー手順の使用

システム・ディスクで同時に障害が発生するまれな事例の場合、Oracle Exadata Storage Serverレスキュー手順を使用してシステムをリカバリする必要があります。

- Oracle Exadata System Softwareのレスキュー手順について

システム・ディスクで障害が発生した場合や、オペレーティング・システムに破損したファイル・システムがある場合、ブート領域が損傷している場合にはレスキュー手順が必要です。 - レスキュー手順の実行

レスキュー手順を使用して、Oracle Exadata Storage Serverシステム・ソフトウェアをリカバリできます。 - Oracle Exadata Storage Serverのレスキュー後の構成

レスキューが成功したら、セルを構成する必要があります。データ・パーティションを維持した場合は、レスキュー手順の実行時にセル・ディスクが自動的にインポートされています。 - Oracle Exadata Database Machineエイス・ラックのストレージ・サーバーのレスキュー後の構成

エイス・ラック・システムに含まれるストレージ・サーバーの場合は、レスキューの成功後に次のステップを使用して、セルを構成する必要があります。 - 損傷したCELLBOOT USBフラッシュ・ドライブの再作成

3.7.1 Oracle Exadata System Softwareのレスキュー手順について

システム・ディスクで障害が発生した場合、オペレーティング・システムに破損したファイル・システムがある場合またはブート領域が損傷している場合、レスキュー手順が必要です。

1つのシステム・ディスクのみで障害が発生した場合、リカバリにCellCLIコマンドを使用します。

通常の冗長性を使用している場合、レスキューされるセルのミラー・コピーは1つだけです。レスキュー手順の実行中にこのミラーでも障害が発生すると、リカバリできないデータの損失が発生する可能性があります。ミラー・コピーのデータの完全なバックアップを作成し、すぐにミラー・コピー・セルをオフラインにしてレスキュー前の新しいデータ変更を防止することをお薦めします。これにより、レスキュー・プロセス中は、障害が発生したセルのグリッド・ディスクのすべてのデータおよびそのミラー・コピーにアクセスできなくなります。

Oracle Automatic Storage Management (Oracle ASM)ディスク修復タイマーのデフォルトの修復時間は、3.6時間です。この時間内にレスキュー手順を実行できないことがわかった場合、レスキュー手順を実行できるまで、Oracle ASMリバランス手順を使用してディスクをリバランスする必要があります。

高冗長性ディスク・グループを使用している場合(たとえば、障害が発生したセルのすべてのグリッド・ディスクにOracle ASMの複数のミラー・コピーがある場合)は、障害が発生したセルをオフラインにします。構成したOracle ASMのタイムアウト後に、障害が発生したセルのグリッド・ディスクはOracle ASMによって自動的に削除され、ミラー・コピーを使用したデータのリバランスが開始されます。デフォルトのタイムアウトは2時間です。セルのレスキューに2時間以上かかる場合は、Oracle ASMでレスキューしたセルにグリッド・ディスクを再作成する必要があります。

注意:

十分に注意してレスキュー手順を使用してください。誤って手順を使用すると、データの損失が発生する可能性があります。レスキュー手順を使用する場合、次の点に注意してください。

-

レスキュー手順により、セルの一部またはすべてのディスクが書き換えられる可能性があります。この場合、リカバリできずにそれらのディスクのすべての内容を失う可能性があります。

この手順を使用する場合は十分に注意し、プロンプトを確認してください。レスキュー手順は、Oracleサポート・サービスの支援を受ける場合や、一部または全部のディスクのデータを失っても問題がない場合にのみ使用してください。

-

レスキュー手順の実行中に明示的に選択しないかぎり、レスキュー手順により、データ・ディスクの内容またはシステム・ディスクのデータ・パーティションの内容は破棄されません。

-

Oracle Exadata System Softwareリリース11.2以降では、レスキュー手順によりOracle Exadata System Softwareが同じリリースにリストアされます。これには、最後に正常にブートしたときのセルのパッチが含まれます。レスキュー手順の使用に関して、次の点に注意してください。

-

セル構成情報(アラート構成、SMTP情報、管理者の電子メール・アドレスなど)はリストアされません。

-

/usr/local/bin/ipconfユーティリティの実行が最後に成功したときに存在したネットワーク構成はリストアされます。 -

セルのSSH IDと、

root、celladminおよびcellmonitorユーザーは復元されます。 -

Oracle Exadata Storage Serverに対するIntegrated Lights Out Manager (ILOM)の構成はリストアされません。通常、ILOM構成は、Oracle Exadata System Softwareに障害が発生しても損なわれません。

-

-

レスキュー手順により、データ・ディスクまたはシステム・ディスクのデータ・パーティションの確認または再構築は行われません。グリッド・ディスクにデータの破損がある場合、レスキュー手順は使用しないでください。かわりに、Oracle DatabaseおよびOracle ASMのレスキュー手順を使用してください。

正常なレスキューの実行後、セルを再構成し、データを保存する場合はセル・ディスクをインポートする必要があります。データを保存しない場合は、新しいセル・ディスクおよびグリッド・ディスクを作成する必要があります。

3.7.3 Oracle Exadata Storage Serverのレスキュー後の構成

レスキューが成功した後、セルを構成する必要があります。データ・パーティションを維持した場合は、レスキュー手順の実行時にセル・ディスクが自動的にインポートされています。

3.7.4 Oracle Exadata Database Machineエイス・ラックのストレージ・サーバーのレスキュー後の構成

エイス・ラック・システムに含まれるストレージ・サーバーの場合は、レスキューの成功後に次のステップを使用してセルを構成する必要があります。

Oracle Exadata System Softwareリリース11.2.3.3以降では、セル・レスキュー後に追加のステップは必要ありません。

3.8 「ストレージ・セルの既存のエラスティック構成の変更」

エラスティック構成を使用すると、Oracle Exadataの容量を変更できます。

- ストレージ・サーバーの追加

このトピックでは、新しいストレージ・サーバー(またはセル)を既存のOracle Exadataエラスティック構成に追加するステップバイステップの手順について説明します。 - エイス・ラック・クラスタへの新しいストレージ・サーバーの追加

既存のOracle Exadata X7以降のエイス・ラックに新しいOracle Exadata X7以降のストレージ・サーバーを追加するには、次のステップを実行します。 - OEDACLIを使用したストレージ・セルの追加

OEDACLIには、様々な構成のエラスティック・ストレージ拡張(ベアメタル、単一のOracle VMまたは複数のOracle VMなど)を実行するためのインタフェースがあります。 - 既存のExadataストレージ・グリッドの拡張

- 既存のディスク・グループまたはストレージ・グリッドからのストレージ・サーバーの削除

既存のOracle Exadataラックからストレージ・サーバーを削除できます。 - OEDACLIを使用したストレージ・サーバーの削除

OEDACLIには、様々な構成のストレージ・サーバー(ベアメタル、単一のOracle VMまたは複数のOracle VMなど)を削除するためのインタフェースがあります。

関連トピック

3.8.1 ストレージ・サーバーの追加

このトピックでは、新しいストレージ・サーバー(またはセル)を既存のOracle Exadataエラスティック構成に追加するステップバイステップの手順について説明します。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.8.2 エイス・ラック・クラスタへの新しいストレージ・サーバーの追加

既存のOracle Exadata X7以降のエイス・ラックに新しいOracle Exadata X7以降のストレージ・サーバーを追加するには、次のステップを実行します。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.8.3 OEDACLIを使用したストレージ・セルの追加

OEDACLIには、様々な構成のエラスティック・ストレージ拡張(ベアメタル、単一のOracle VMまたは複数のOracle VMなど)を実行するためのインタフェースがあります。

前提条件

- すべての新しいストレージ・サーバーは物理ラックに設置されていて接続されている必要があります。

- すべての新しいストレージ・サーバーは、管理およびRDMAネットワーク・ファブリックの構成が実行されている必要があります。

- OEDACLIは、データベース・サーバー(ベアメタルまたはゲスト・ドメイン)およびストレージ・サーバーにネットワーク・アクセスできるマシンで実行する必要があります。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.8.4 既存のExadataストレージ・グリッドの拡張

このシナリオでは、Exadataラック内にExadataストレージ・セルが存在し、最も拡張の必要なExadataストレージ・グリッドにストレージ・セルを追加します。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.8.5 既存のディスク・グループまたはストレージ・グリッドからのストレージ・サーバーの削除

既存のOracle Exadataラックからストレージ・サーバーを削除できます。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.8.6 OEDACLIを使用したストレージ・サーバーの削除

OEDACLIには、様々な構成(ベアメタル、単一のOracle VMまたは複数のOracle VMなど)のストレージ・サーバーを削除するためのインタフェースがあります。

ディスク・グループからディスクを削除して、ストレージ・サーバーのオブジェクトを削除する手順は、わずかな数のコマンドで実施します。トリガーされるリバランス操作は、削除するストレージ・セルの数に関係なく1つのみです。

前提条件

- 有効なOEDA XML構成ファイル(拡張する環境内で使用している計算ノードとストレージ・セルの完全リストを反映しているもの)。このタスクの最初のステップでは、新しいOEDA XML構成ファイルを生成することで、現在の構成が確実に使用されるようにしています。

- OEDACLIは、データベース・サーバー(ベアメタルまたはゲスト・ドメイン)およびストレージ・サーバーにネットワーク・アクセスできるマシンで実行する必要があります。

親トピック: ストレージ・セルの既存のエラスティック構成の変更

3.9 ディスク・コントローラのバッテリの管理

この項は、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。新しいディスク・コントローラは、メンテナンスや交換を必要としないスーパーキャパシタを使用します。

- ディスク・コントローラのバッテリについて

Exadata X4以前のシステムのディスク・コントローラには、書込みパフォーマンスを高速化するバッテリ・バックアップ式の書込みキャッシュがあります。 - ストレージ・サーバーのハード・ディスク・コントローラのバッテリおよびキャッシュ・モードの監視

Exadata X4以前のシステムのハード・ディスク・コントローラは、定期的にコントローラのバッテリの放電と充電を実行します。操作中は、書込みキャッシュ・ポリシーにより、ライトバック・キャッシュからライトスルー・キャッシュに変更されます。 - データベース・サーバーのバッテリの監視

- ディスク・コントローラのバッテリの交換

3.9.1 ディスク・コントローラのバッテリについて

Exadata X4以前のシステムのディスク・コントローラには、書込みパフォーマンスを高速化するバッテリ・バックアップ式の書込みキャッシュがあります。

ノート:

このトピックは、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。

充電容量が低下して48時間以上電力の供給されないキャッシュ・データをバッテリで保護できない場合、書込みキャッシュが無効になり、ディスク・コントローラがライトスルー・モードに切り替わります。これにより、書込みパフォーマンスが低下しますが、データは失われません。充電容量が不十分の場合や温度が高い場合、バッテリを交換する必要がある場合は、Oracle Exadata Storage Serverがアラートを生成します。

バッテリの充電容量は徐々に低下し、寿命は動作温度と反比例します。最低の条件下のOracle Exadataラックのバッテリ寿命は、次のとおりです。

| インレット環境の温度 | バッテリの寿命 |

|---|---|

|

< 摂氏25度(華氏77度) |

3年 |

|

< 摂氏32度(華氏89.6度) |

2年 |

親トピック: ディスク・コントローラのバッテリの管理

3.9.2 ストレージ・サーバーのハード・ディスク・コントローラのバッテリおよびキャッシュ・モードの監視

Exadata X4以前のシステムのハード・ディスク・コントローラは、定期的にコントローラのバッテリの放電と充電を実行します。操作中は、書込みキャッシュ・ポリシーにより、ライトバック・キャッシュからライトスルー・キャッシュに変更されます。

ノート:

このトピックは、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。

ライトスルー・キャッシュ・モードはライトバック・キャッシュ・モードより時間を要します。ただし、Oracle Exadata Storage Serverの電源が落ちたり障害が発生したりすると、ライトバック・キャッシュ・モードの場合はデータ損失のリスクがあります。Oracle Exadata System Softwareリリース11.2.1.3以前の場合は、この処理が毎月発生します。リリース11.2.1.3.0以上のOracle Exadata System Softwareの場合、この処理は3か月ごとに発生します(たとえば、1月、4月、7月、10月の17日の01:00時)。

親トピック: ディスク・コントローラのバッテリの管理

3.9.3 データベース・サーバーのバッテリの監視

ノート:

このトピックは、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。

ノート:

充電容量が不十分であるか温度が高い場合およびバッテリを交換する必要がある場合、Exadata Storage Serverがアラートを生成します。

データベース・サーバーのバッテリの充電容量と温度は、次のコマンドを使用して監視できます。

ノート:

Oracle Exadata System Software 19.1.0以上を実行している場合は、次のコマンドで/opt/MegaRAID/MegaCli/MegaCli64を/opt/MegaRAID/storcli/storcli64に置き換えます。

# /opt/MegaRAID/MegaCli/MegaCli64 -AdpBbuCmd -a0 | grep "Full Charge" -A5 | sort \

| grep Full -A1Full Charge Capacity: 1357 mAh

Max Error: 2 %

/opt/MegaRAID/MegaCli/MegaCli64 -AdpBbuCmd -a0 | grep BatteryType; \

/opt/MegaRAID/MegaCli/MegaCli64 -AdpBbuCmd -a0 | grep -i temperBatteryType: iBBU08

Temperature: 38 C

Temperature : OK

Over Temperature : No

親トピック: ディスク・コントローラのバッテリの管理

3.9.4 ディスク・コントローラのバッテリの交換

ノート:

このトピックは、バッテリを使用してディスク・コントローラのキャッシュを保護するExadata X4以前のシステムにのみ適用されます。

ディスク・コントローラの充電容量が最小しきい値を下回った場合、システムがOracle Premier Support for Systemsの対象または保証期間中であれば、故障したバッテリが無償で交換されます。

Premier Support for Systemsのお客様を対象に、ベスト・エフォート原則に基づいて寿命が終わる前にOracle Exadataラックのバッテリを事前に交換します。

親トピック: ディスク・コントローラのバッテリの管理

3.10 F20 PCIeエネルギー・ストレージ・モジュールの管理

Sun Flash Accelerator F20 PCIeカードは、Oracle Exadata X3モデルで使用されています。

- F20 PCIeエネルギー・ストレージ・モジュールについて

Sun Flash Accelerator F20 PCIeカードには、停電時のデータ整合性を確保するために、バッテリ・バックアップと同様に機能するエネルギー・ストレージ・モジュール(ESM)が組み込まれています。 - フラッシュESMの交換

3.10.1 F20 PCIeエネルギー・ストレージ・モジュールについて

Sun Flash Accelerator F20 PCIeカードには、停電時のデータ整合性を確保するために、バッテリ・バックアップと同様に機能するエネルギー・ストレージ・モジュール(ESM)が組み込まれています。

Sun Flash Accelerator F20 PCIeカードは、頻繁にアクセスされるOracleデータベース・データをキャッシュし、Exadata Storage Serverのディスクに対する物理I/Oを不要とすることで、Oracle Exadataラックのパフォーマンスを高速化します。フラッシュ・カードに対する書込み操作は、書込み操作を高速化するためにカード上の揮発性のローカルDRAMメモリーに一時的にステージングされます。DRAM内のデータは、エネルギー・ストレージ・モジュール(ESM)によって保護されています。このモジュールは、十分な電力を提供して、電源障害の際にDRAM内のデータをローカル・フラッシュに移動します。

Oracle Exadata X3システムで使用されているフラッシュ・モジュールの予想耐久期間は、書込み集中型のアプリケーションでも10年以上です。フラッシュの耐久期間は、主に、何年にもわたってフラッシュに書き込まれる合計データ量および書き込まれるデータのタイプによって決まります。何年もの間、常時最大フラッシュ書込みIOPSで実行されるアプリケーションはありません。また、アプリケーションでは多くの読取りが実行され、アクティビティが多い期間と少ない期間があります(日中と夜間、四半期末、取引日の終了間際など)。非常に高い書込み集中型のアプリケーションで数か月にわたって測定したところ、最大フラッシュ書込みIOPSの25%が平均となります。各Exadata X3ストレージ・サーバーの耐久期間中の合計フラッシュ書込みは、一般的なデータベース・データの場合で50PBを超えます。フル・ラックでは、アプリケーションの平均書込みが10年間で250,000 8KフラッシュIOPS (最大書込みの25%)である場合、各セルに合計41PBのデータが書き込まれます。これは、セルの耐久期間中の50PBを下回ります。

ESMの充電が十分ではない場合、F20 PCIeカードは、DRAMメモリーを回避してすべてのデータを直接フラッシュに書き込むフェイルセーフのライトスルー・モードで動作します。これにより、書込みパフォーマンスが低下しますが、データは失われません。ESM容量が不十分な場合およびESMを交換する必要がある場合、Exadata Storage Serverがアラートを生成します。

ESMの充電容量は徐々に低下し、寿命は動作温度と反比例します。最低の条件下のOracle ExadataラックのESMの寿命は、次のとおりです。

| Exadata Storage Serverのタイプ | 寿命 |

|---|---|

|

Sun Fire X4275 Serverを使用したExadata Storage Server |

3年 |

|

Sun Fire X4270 M2 Serverを使用したExadata Storage Server |

4年 |

3.11 Exadata Storage ServerのLEDインジケータの説明

Oracle Exadataストレージ・サーバーのインジケータLEDは、システム・ステータスを確認し、保守が必要なコンポーネントを識別するために役立ちます。

Oracle Exadataストレージ・サーバーの様々なインジケータLEDについては、使用しているシステムのサーバー・サービス・マニュアルのサーバーのフロント・パネルおよびバック・パネルのステータス・インジケータを使用したトラブルシューティングの項を参照してください。

サーバー・サービス・マニュアルのリストについては、関連ドキュメントを参照してください。

また、サービス不可LEDは、Oracle Exadata X7-2以降のストレージ・サーバーにのみ含まれています。

Oracle Exadataストレージ・サーバーでは、サービス不可LEDの状態は次のとおりです:

-

サービス不可LEDが白色/点灯: データの可用性を維持するためにストレージ・サーバーをオンラインのままにする必要があることを示します。ストレージ・サーバーを再起動したり、電源を切ったりしないでください。そうでない場合、データの可用性が損なわれる可能性があります。

通常、サービス不可LEDは、パートナ・ストレージ・サーバーの問題に対応して点灯します。ただし、サービス不可LEDも次の状況で点灯します:

-

Oracle ASMクラスタのローリング・アップグレード中は、参加しているすべてのストレージ・サーバーでサービス不可LEDが同時に点灯します。さらに、影響を受けるグリッド・ディスクでは、

asmDeactivationOutcome属性に値(Cannot deactivate because ASM is in rolling upgrade mode)が含まれます。 -

投票ディスクを含むデータベース・サーバーが停止すると、すべてのストレージ・サーバーでサービス不可LEDが同時に点灯し、クラスタ内の定数を保持するためにストレージ・サーバーを停止しないよう警告されます。

-

-

サービス不可LEDが消灯: サービスのためにストレージ・サーバーの電源を安全に切断できます。

3.12 Exadata Storage Serverのイメージ

Exadata Storage Serverのモデルには、様々な外部レイアウトおよび物理的外観があります。

- Oracle Exadata Storage Server X10M Extreme Flashサーバーのイメージ

- Oracle Exadata Storage Server X10M High Capacityサーバーのイメージ

- Oracle Exadata Storage Server X10M拡張サーバーのイメージ

- Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーのイメージ

- Oracle Exadata Storage Server X9M-2 High Capacityサーバーのイメージ

- Oracle Exadata Storage Server X9M-2拡張サーバーのイメージ

- Oracle Exadata Storage Server X8M-2およびX8-2 High Capacityおよび拡張(XT)サーバーのイメージ

- Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flashサーバーのイメージ

- Oracle Exadata Storage Server X7-2 High Capacityサーバーのイメージ

- Oracle Exadata Storage Server X7-2 Extreme Flashサーバーのイメージ

- High Capacity Exadata Storage Server X6-2のイメージ

- Extreme Flash Exadata Storage Server X6-2のイメージ

- High Capacity Exadata Storage Server X5-2のイメージ

- Extreme Flash Exadata Storage Server X5-2のイメージ

- Exadata Storage Server X4-2Lのイメージ

- Exadata Storage Server X3-2Lのイメージ

- Sun Fire X4270 M2を使用したExadata Storage Serverのイメージ

- Sun Fire X4275を使用したExadata Storage Serverのイメージ

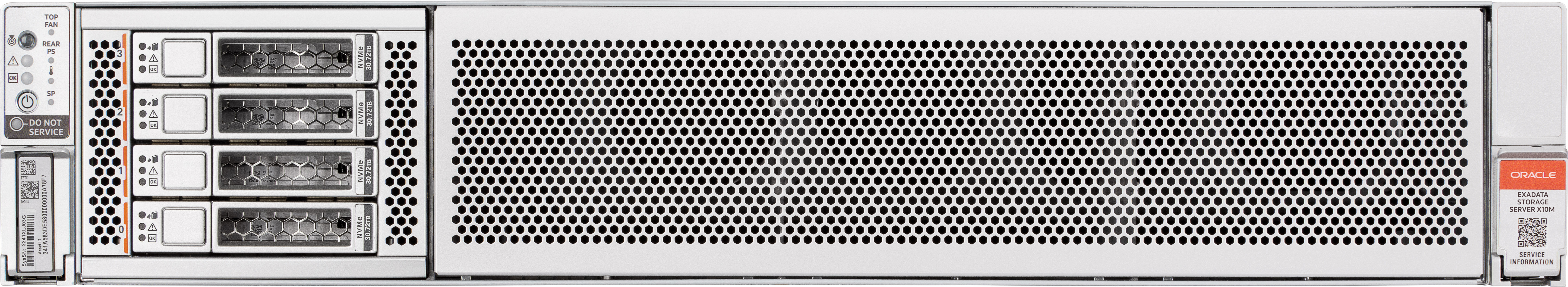

3.12.1 Oracle Exadata Storage Server X10M Extreme Flashサーバーのイメージ

次の図に、Oracle Exadata Storage Server X10M Extreme Flash (EF)サーバーの前面図を示します。

図3-1 Oracle Exadata Storage Server X10M EFサーバーの前面図

「図3-1 Oracle Exadata Storage Server X10M EFサーバーの前面図」の説明

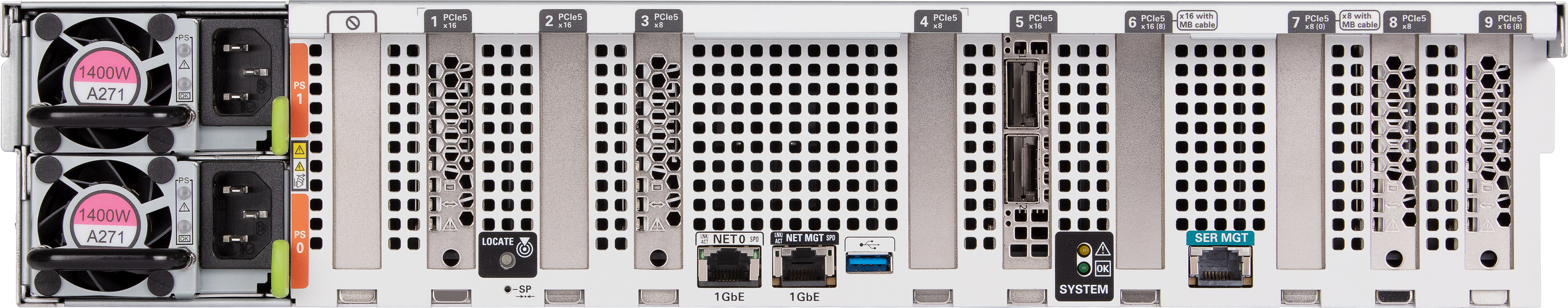

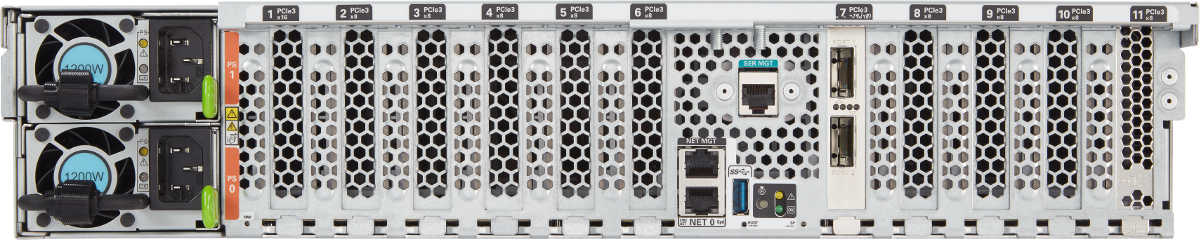

次の図に、Oracle Exadata Storage Server X10M EFサーバーの背面図を示します。

図3-2 Oracle Exadata Storage Server X10M EFサーバーの背面図

「図3-2 Oracle Exadata Storage Server X10M EFサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

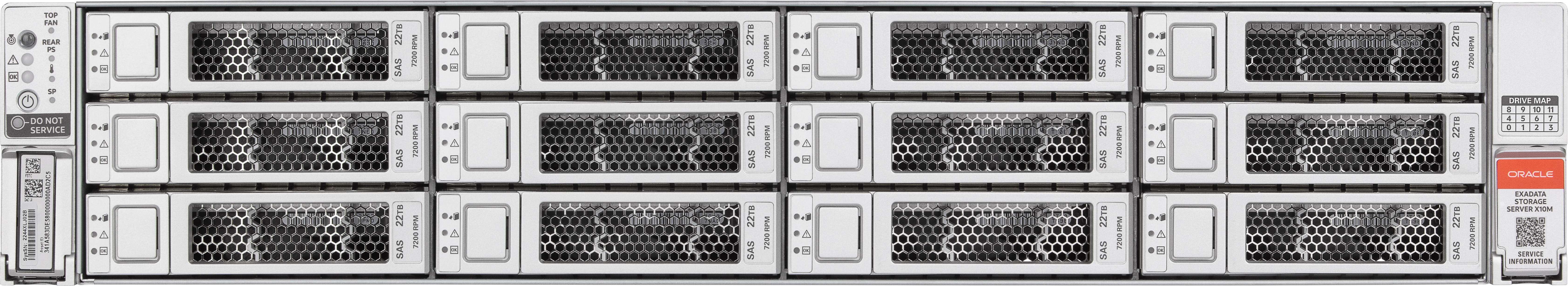

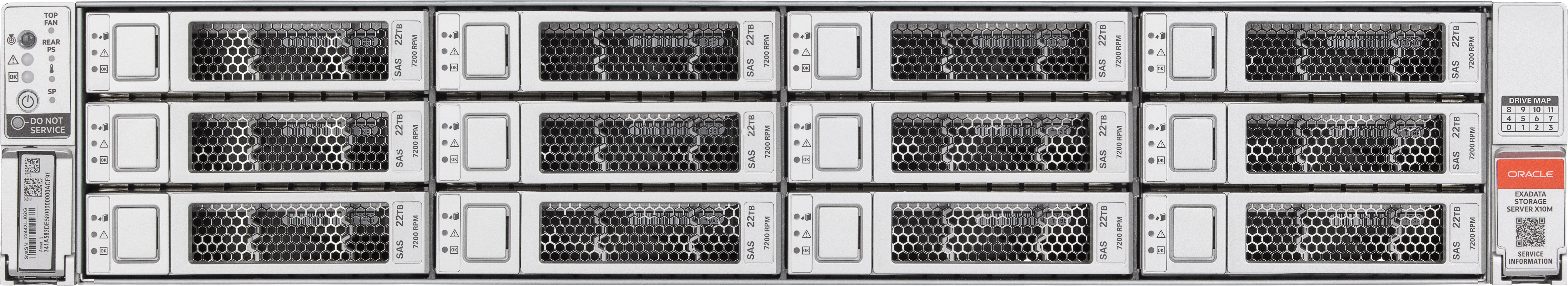

3.12.2 Oracle Exadata Storage Server X10M High Capacityサーバーのイメージ

次の図に、Oracle Exadata Storage Server X10M High Capacity (HC)サーバーの前面図を示します。

図3-3 Oracle Exadata Storage Server X10M HCサーバーの前面図

「図3-3 Oracle Exadata Storage Server X10M HCサーバーの前面図」の説明

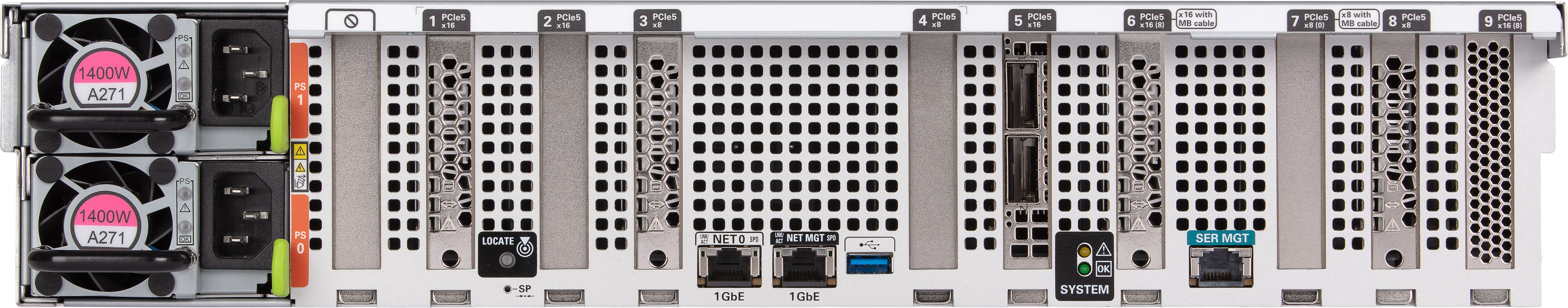

次の図に、Oracle Exadata Storage Server X10M HCサーバーの背面図を示します。

図3-4 Oracle Exadata Storage Server X10M HCサーバーの背面図

「図3-4 Oracle Exadata Storage Server X10M HCサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.3 Oracle Exadata Storage Server X10M拡張サーバーのイメージ

次の図に、Oracle Exadata Storage Server X10M拡張(XT)サーバーの前面図を示します。

図3-5 Oracle Exadata Storage Server X10M XTサーバーの前面図

「図3-5 Oracle Exadata Storage Server X10M XTサーバーの前面図」の説明

次の図に、Oracle Exadata Storage Server X10M XTサーバーの背面図を示します。

図3-6 Oracle Exadata Storage Server X10M XTサーバーの背面図

「図3-6 Oracle Exadata Storage Server X10M XTサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

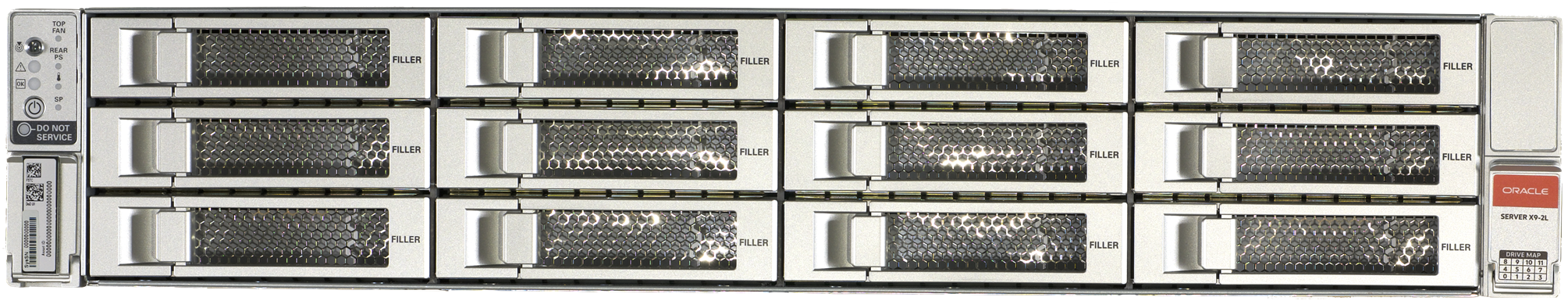

3.12.4 Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーのイメージ

次の図に、Oracle Exadata Storage Server X9M-2 Extreme Flash (EF)サーバーの前面図を示します。

図3-7 Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーの前面図

「図3-7 Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーの前面図」の説明

次の図に、Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーの背面図を示します。

図3-8 Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーの背面図

「図3-8 Oracle Exadata Storage Server X9M-2 Extreme Flashサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

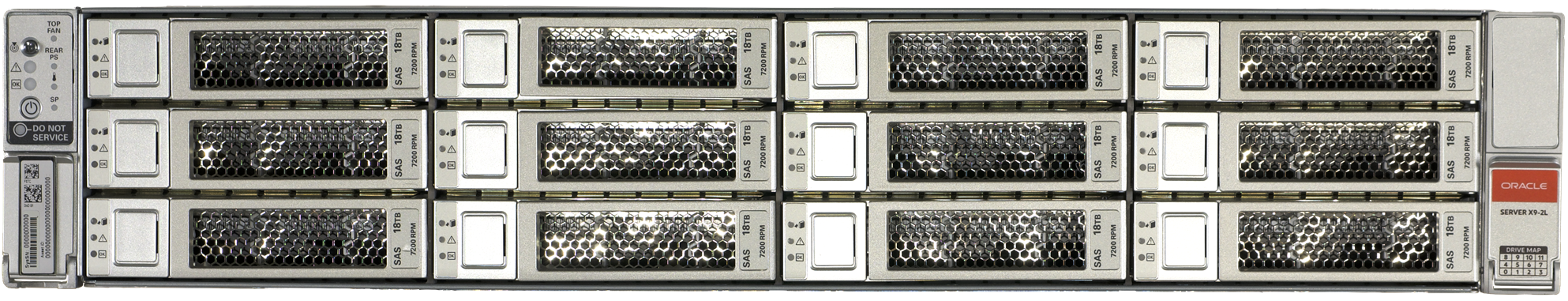

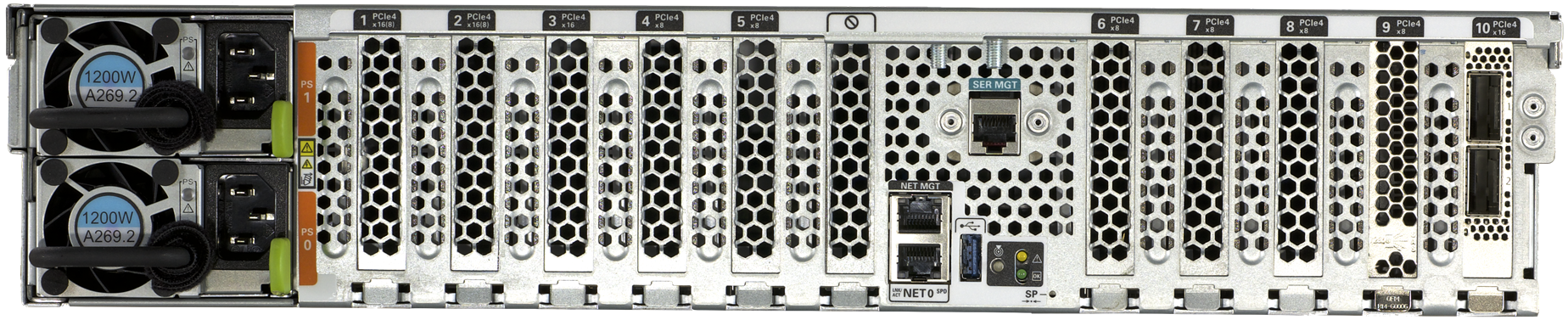

3.12.5 Oracle Exadata Storage Server X9M-2 High Capacityサーバーのイメージ

次の図に、Oracle Exadata Storage Server X9M-2 High Capacity (HC)サーバーの前面図を示します。

図3-9 Oracle Exadata Storage Server X9M-2 High Capacityサーバーの前面図

「図3-9 Oracle Exadata Storage Server X9M-2 High Capacityサーバーの前面図」の説明

次の図に、Oracle Exadata Storage Server X9M-2 High Capacityサーバーの背面図を示します。

図3-10 Oracle Exadata Storage Server X9M-2 High Capacityサーバーの背面図

「図3-10 Oracle Exadata Storage Server X9M-2 High Capacityサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

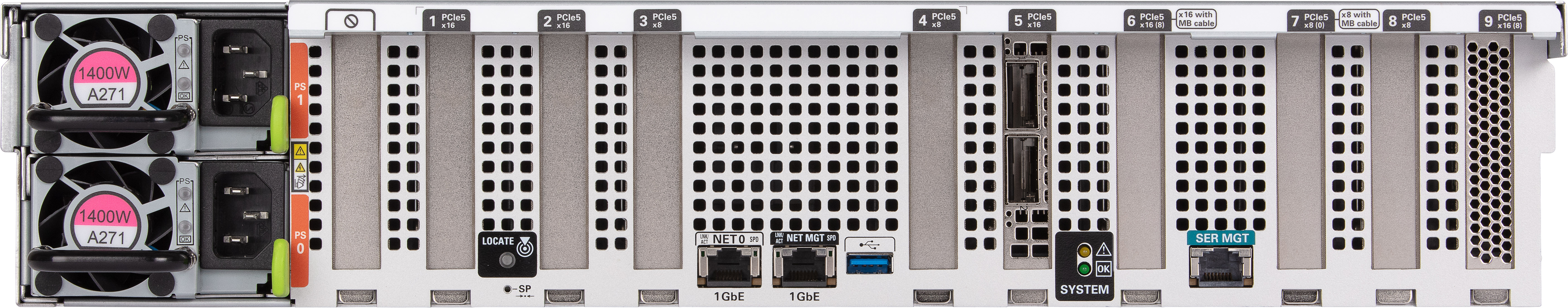

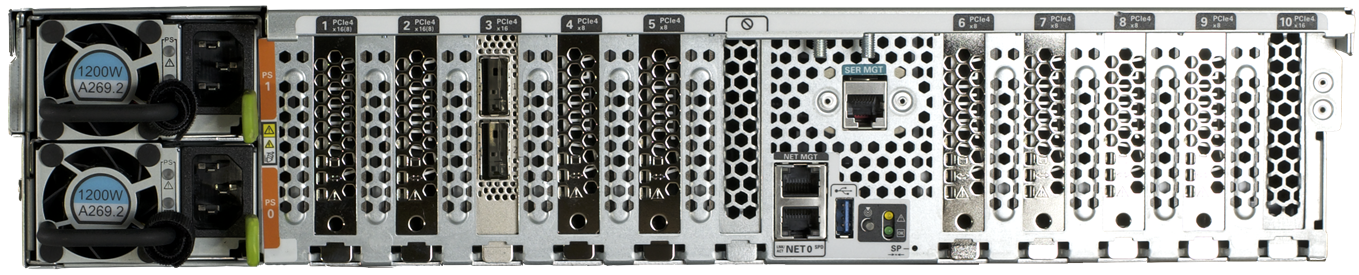

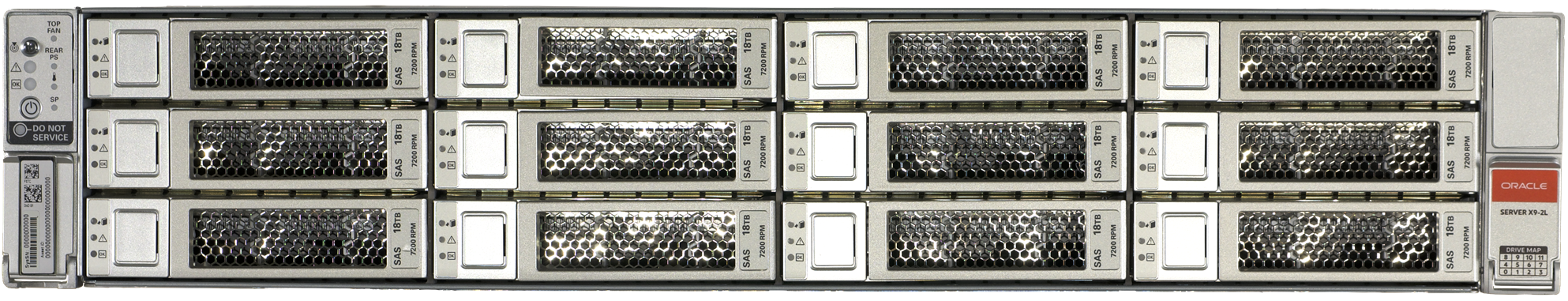

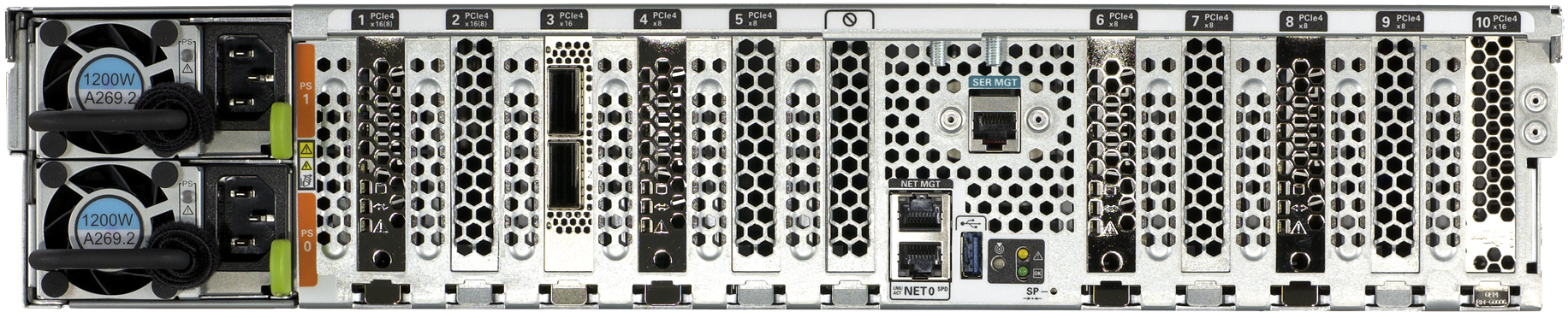

3.12.6 Oracle Exadata Storage Server X9M-2拡張サーバーのイメージ

次の図に、Oracle Exadata Storage Server X9M-2拡張(XT)サーバーの前面図を示します。

図3-11 Oracle Exadata Storage Server X9M-2拡張サーバーの前面図

「図3-11 Oracle Exadata Storage Server X9M-2拡張サーバーの前面図」の説明

次の図に、Oracle Exadata Storage Server X9M-2拡張サーバーの背面図を示します。

図3-12 Oracle Exadata Storage Server X9M-2拡張サーバーの背面図

「図3-12 Oracle Exadata Storage Server X9M-2拡張サーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.7 Oracle Exadata Storage Server X8M-2およびX8-2 High Capacityおよび拡張(XT)サーバーのイメージ

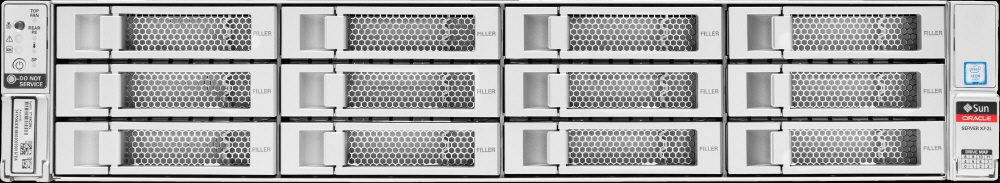

次の図に、Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの前面図を示します。

図3-13 Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの前面図

「図3-13 Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの前面図」の説明

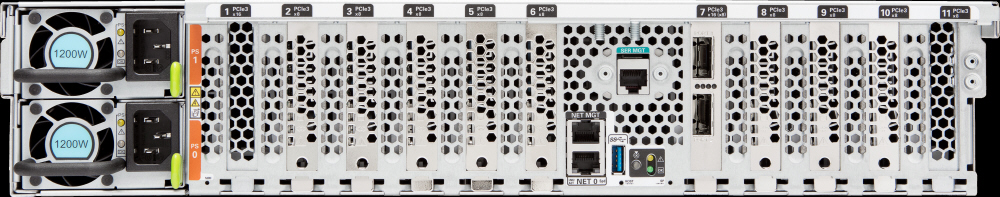

次の図に、Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの背面図を示します。

図3-14 Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの背面図

「図3-14 Oracle Exadata Storage Server X8M-2およびX8-2 High CapacityおよびXTサーバーの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

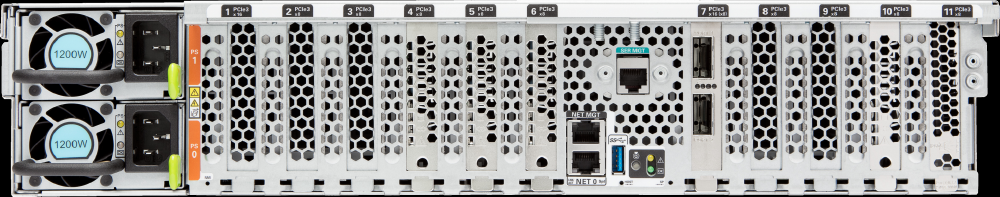

3.12.8 Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flashサーバーのイメージ

Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flashサーバーの前面図は、X7-2サーバーとほぼ同じです。主な違いは製品ロゴです。

図3-15 Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flash Serverの前面図

「図3-15 Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flash Serverの前面図」の説明

Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flashサーバーの背面図は、X7-2サーバーとほぼ同じです。主な違いは製品ロゴです。

図3-16 Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flash Serverの背面図

「図3-16 Oracle Exadata Storage Server X8M-2およびX8-2 Extreme Flash Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.9 Oracle Exadata Storage Server X7-2 High Capacityサーバーのイメージ

次の図に、Oracle Exadata Storage Server X7-2 High Capacity Serverの前面図を示します。

図3-17 Oracle Exadata Storage Server X7-2 High Capacity Serverの前面図

「図3-17 Oracle Exadata Storage Server X7-2 High Capacity Serverの前面図」の説明

次の図に、Oracle Exadata Storage Server X7-2 High Capacity Serverの背面図を示します。

図3-18 Oracle Exadata Storage Server X7-2 High Capacity Serverの背面図

「図3-18 Oracle Exadata Storage Server X7-2 High Capacity Server背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.10 Oracle Exadata Storage Server X7-2 Extreme Flashサーバーのイメージ

次の図に、Oracle Exadata Storage Server X7-2 Extreme Flash Serverの前面図を示します。

図3-19 Oracle Exadata Storage Server X7-2 Extreme Flash Serverの前面図

「3-19 Oracle Exadata Storage Server X7-2 Extreme Flash Serverの前面図」の説明

次の図に、Oracle Exadata Storage Server X7-2 Extreme Flash Serverの背面図を示します。

図3-20 Oracle Exadata Storage Server X7-2 Extreme Flash Serverの背面図

「図3-20 Oracle Exadata Storage Server X7-2 Extreme Flash Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.11 High Capacity Exadata Storage Server X6-2のイメージ

次の図に、Oracle Exadata Storage Server X6-2 High Capacityサーバーの前面図を示します。

図3-21 Oracle Exadata Storage Server X6-2 High Capacity Serverの前面図

「図3-21 Oracle Exadata Storage Server X6-2 High Capacity Serverの前面図」の説明

次の図に、Oracle Exadata Storage Server X6-2 High Capacityサーバーの背面図を示します。

図3-22 Oracle Exadata Storage Server X6-2 High Capacity Serverの背面図

「図3-22 Oracle Exadata Storage Server X6-2 High Capacity Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.12 Extreme Flash Exadata Storage Server X6-2のイメージ

次の図に、Oracle Exadata Storage Server X6-2 Extreme Flashサーバーの前面図を示します。

図3-23 Oracle Exadata Storage Server X6-2 Extreme Flash Serverの前面図

「3-23 Oracle Exadata Storage Server X6-2 Extreme Flash Serverの前面図」の説明

次の図に、Oracle Exadata Storage Server X6-2 Extreme Flashサーバーの背面図を示します。

図3-24 Oracle Exadata Storage Server X6-2 Extreme Flash Serverの背面図

「図3-24 Oracle Exadata Storage Server X6-2 Extreme Flash Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.13 High Capacity Exadata Storage Server X5-2のイメージ

次の図に、High Capacity Exadata Storage Server X5-2 Serverの前面図を示します。

図3-25 High Capacity Exadata Storage Server X5-2 Serverの前面図

「図3-25 High Capacity Exadata Storage Server X5-2 Serverの前面図」の説明

次の図に、High Capacity Exadata Storage Server X5-2 Serverの背面図を示します。

図3-26 High Capacity Exadata Storage Server X5-2 Serverの背面図

「図3-26 High Capacity Exadata Storage Server X5-2 Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.14 Extreme Flash Exadata Storage Server X5-2のイメージ

次の図に、Extreme Flash Exadata Storage Server X5-2 Serverの前面図を示します。

図3-27 Extreme Flash Exadata Storage Server X5-2 Serverの前面図

「図3-27 Extreme Flash Exadata Storage Server X5-2 Serverの前面図」の説明

次の図に、Extreme Flash Exadata Storage Server X5-2 Serverの背面図を示します。

図3-28 Extreme Flash Exadata Storage Server X5-2 Serverの背面図

「図3-28 Extreme Flash Exadata Storage Server X5-2 Serverの背面図」の説明

親トピック: Exadata Storage Serverのイメージ

3.12.15 Exadata Storage Server X4-2Lのイメージ

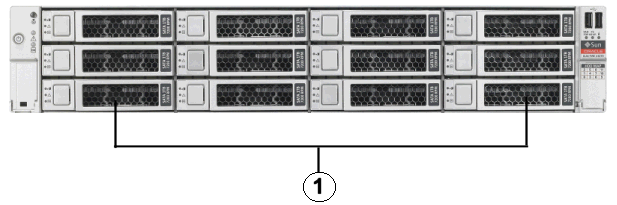

次の図に、Exadata Storage Server X4-2L Serverの前面図を示します。ハード・ドライブには、左下から始まり左から右へと番号が付けられます。下段のドライブの番号は0、1、2および3です。中段のドライブの番号は4、5、6および7です。上段のドライブの番号は8、9、10および11です。

次の図に、Exadata Storage Server X4-2L Serverの背面図を示します。

親トピック: Exadata Storage Serverのイメージ

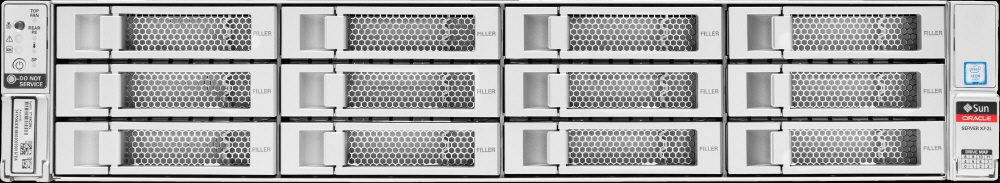

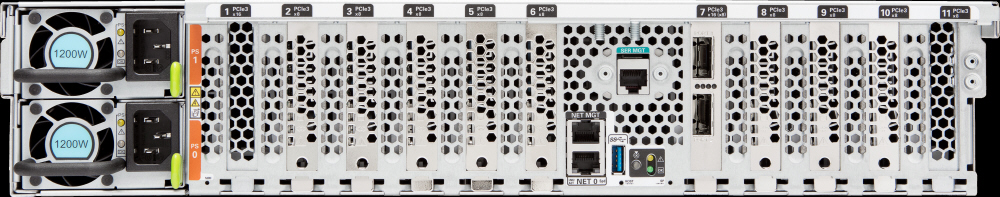

3.12.16 Exadata Storage Server X3-2Lのイメージ

次の図に、Exadata Storage Server X3-2L Serverの前面図を示します。ハード・ドライブには、左下から始まり左から右へと番号が付けられます。下段のドライブの番号は0、1、2および3です。中段のドライブの番号は4、5、6および7です。上段のドライブの番号は8、9、10および11です。

次の図に、Exadata Storage Server X3-2L Serverの背面図を示します。

親トピック: Exadata Storage Serverのイメージ

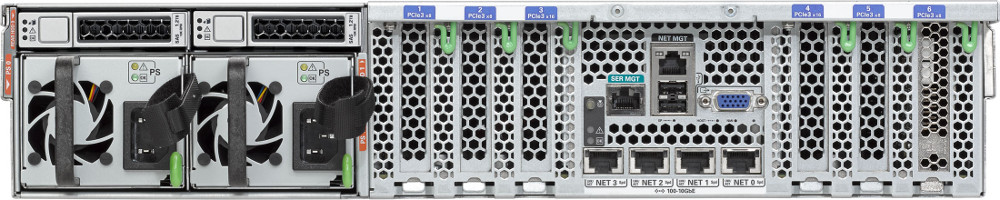

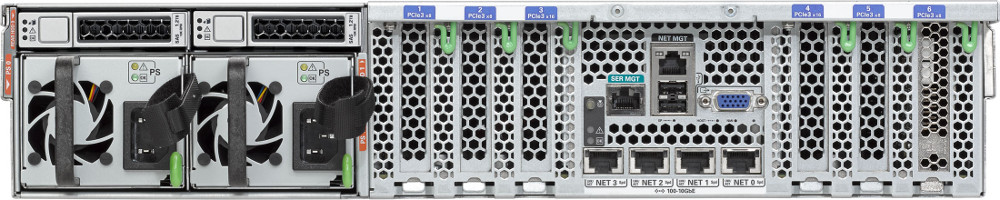

3.12.17 Sun Fire X4270 M2を使用したExadata Storage Serverのイメージ

次の図に、Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの前面図を示します。

図3-33 Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの前面図

「図3-33 Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの前面図」の説明

-

ハード・ディスク・ドライブ。上位ドライブは、左から右にHDD2、HDD5、HDD8およびHDD11です。中位ドライブは、左から右にHDD1、HDD4、HDD7およびHDD10です。下位ドライブは、左から右にHDD0、HDD3、HDD6およびHDD9です。

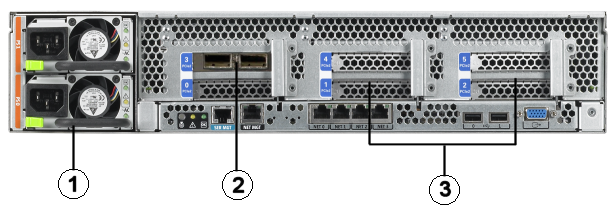

次の図に、Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの背面図を示します。

図3-34 Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの背面図

「図3-34 Sun Fire X4270 M2 Serverを使用したExadata Storage Serverの背面図」の説明

-

電源。

-

InfiniBandホスト・チャネル・アダプタPCI Expressモジュール。

-

Sun Flash Accelerator F20 PCIeカード。

親トピック: Exadata Storage Serverのイメージ

3.12.18 Sun Fire X4275を使用したExadata Storage Serverのイメージ

次の図に、Sun Fire X4275 Serverの前面図を示します。

-

ハード・ディスク・ドライブ。上位ドライブは、左から右にHDD2、HDD5、HDD8およびHDD11です。中位ドライブは、左から右にHDD1、HDD4、HDD7およびHDD10です。下位ドライブは、左から右にHDD0、HDD3、HDD6およびHDD9です。

次の図に、Sun Fire X4275 Serverの背面図を示します。

親トピック: Exadata Storage Serverのイメージ