Treinamento e Teste de Intenções

O treinamento de um modelo com seu corpus de treinamento permite que seu bot identifique o que os usuários dizem (ou, em alguns casos, o que estão tentando dizer).

Você pode melhorar a adequação da cognição por meio de rodadas de testes e treinamento de intenções. Você controla o treinamento pelas definições de intenção sozinhas; a habilidade não pode aprender por conta própria pelo chat do usuário.

Testando Declarações

Recomendamos que você reserve 20% de seu corpus para teste de intenção e use os 80% restantes para treinar suas intenções. Mantenha esses dois conjuntos separados para que as declarações de teste, que você incorpora em casos de teste, permaneçam "desconhecidas" para sua habilidade.

Aplique a divisão 80/20 ao conjunto de dados de cada intenção. Randomize suas declarações antes de fazer essa divisão para permitir que os modelos de treinamento ponderem os termos e padrões das declarações igualmente.

O Testador de Declaração

O Testador de Declaração é sua janela para a cognição da sua habilidade. Ao digitar frases que não fazem parte do corpus de treinamento, você consegue descobrir se elaborou bem suas intenções revisando a classificação de confiança da intenção e o JSON retornado. Essa classificação, que é a estimativa da habilidade para o melhor candidato a resolver a entrada do usuário, demonstra sua precisão no momento atual.

Descrição da ilustração declarance-tester-quick-test.png

Usando o Testador de Declaração, é possível executar testes rápidos para testes únicos ou incorporar uma declaração como caso de teste para avaliar a resolução da intenção em diferentes versões dos modelos de treinamento.

Casos de Teste

Cada teste tem uma declaração e a intenção para a qual ele deve ser resolvido, que é conhecida como correspondência de label. Um caso de teste também pode incluir valores de entidade correspondentes e o idioma esperado para a declaração. Você pode executar casos de teste quando estiver desenvolvendo uma habilidade e, posteriormente, quando a habilidade estiver em produção, poderá usar os casos de teste para teste de regressão. Nesse último, você pode executar casos de teste para descobrir se uma nova versão do modelo de treinamento afetou negativamente a resolução da intenção.

Como os casos de teste que você cria com o Testador de Conversa, os casos de teste de declaração fazem parte da habilidade e acompanham cada versão. Se você estender uma habilidade, a extensão herdará os casos de teste. Enquanto os casos de teste de conversa se destinam a testar um cenário, os casos de teste de declaração se destinam a testar fragmentos de uma conversa independentemente, garantindo que cada declaração seja resolvida com a intenção correta.

Gerenciar Casos de Teste

nluTestSuites que abriga os conjuntos de testes da habilidade quando a habilidade é exportada.Criar Conjuntos de Testes

- Clique em + Conjunto de Testes.

- Na guia Geral, substitua o nome do espaço reservado (TestSuite0001, por exemplo) por um mais significativo adicionando um valor no campo Nome para Exibição.

- Opcionalmente, adicione uma descrição que explique a funcionalidade coberta pelo conjunto de testes.

- Preencha o conjunto de testes com casos de teste usando qualquer (ou uma combinação de ) os seguintes métodos:

- Adicionar manualmente casos de teste (seja criando um caso de teste ou salvando uma declaração como um caso de teste do Testador de Declarações).

- Importando casos de teste.

Observação

Para designar um caso de teste a um conjunto de testes por meio da importação, o campotestSuitedo CSV pode estar vazio ou deve conter um nome que corresponda ao conjunto de testes selecionado na caixa de diálogo de importação. - Editando um caso de teste para reatribuir seu conjunto de testes.

- Se você quiser excluir o conjunto de testes das execuções de teste iniciadas usando as opções Tudo e Executar Tudo, desative Ativar Conjunto de Testes.

- Se você não quiser que o conjunto de testes seja incluído na exportação de habilidades, desative Incluir na Exportação de Habilidades. Quando você desativar essa opção para uma suíte de teste, ela não será incluída na pasta

nluTestSuitesque abriga as suítes de teste da habilidade no arquivo ZIP exportado.

Criar Casos de Teste de Declaração

Você pode adicionar casos de teste um a um usando o Testador de Declaração ou a caixa de diálogo Novo Caso de Teste (acessada clicando em + Caso de Teste) ou pode adicioná-los em massa fazendo o upload de um CSV.

Cada caso de teste deve pertencer a uma suíte de teste; por isso, antes de criar um caso de teste, você pode primeiro criar uma suíte de teste que reflita uma capacidade da habilidade ou algum aspecto do teste de intenção, como teste de falha, teste no domínio ou teste fora do domínio.

Dica:

Para fornecer cobertura adequada em seus testes, crie declarações de suíte de testes que não sejam apenas variadas conceitualmente, mas também gramaticalmente, pois os usuários não farão solicitações de maneira uniforme. Você pode adicionar essas dimensões criando suítes de teste com base na mensagem real do usuário que foram consultadas no Insights Retrainer e também com base na entrada de origem coletiva obtida do Data Manufacturing.Adicionar Casos de Teste do Testador de Declaração

- Clique em Testar Declarações.

- Se a habilidade for multilíngue, selecione o idioma nativo.

- Digite a declaração e clique em Testar.

- Clique em Salvar como Caso de Teste e escolha uma suíte de teste.

Criar um Caso de Teste

- Clique em Ir para Casos de Teste no Testador de Declaração.

- Clique em + Caso de Teste.

- Preencha a caixa de diálogo Novo Caso de Teste:

- Se necessário, desative o caso de teste.

- Digite a declaração de teste.

- Selecione a suíte de teste.

- Selecione a intenção esperada. Se você estiver criando um caso de teste para teste de falha, selecione unresolvedIntent.

- Para habilidades multilíngues, selecione a tag de idioma e o idioma esperado.

- Clique em Adicionar à Suíte. Na página Casos de Teste, você pode excluir um caso de teste ou editar um caso de teste, o que inclui reatribuir o caso de teste a outro conjunto de testes.

- Para testar valores de entidade:

- Ative Entidades de Teste. Clique em Continuar.

- Destaque a palavra (ou palavras) e, em seguida, aplique um rótulo de entidade a ela selecionando uma entidade na lista. Quando terminar, clique em Adicionar ao Suite.

Observação

Sempre selecione palavras ou frases na declaração do caso de teste depois de ativar Entidades de Teste. O caso de teste falhará se você tiver ativado Entidades de Teste, mas não tiver destacado palavras.

Importar Casos de Teste de Suítes de Teste no Nível da Habilidade

testSuite- O nome da suíte de teste à qual o caso de teste pertence. O campotestSuiteem cada linha do CSV pode ter um nome de suíte de teste diferente ou pode ficar vazio.- Casos de teste com campos

testSuitevazios são adicionados a um conjunto de testes selecionado quando você importa o CSV. Se você não selecionar um conjunto de testes, ele será atribuído ao Conjunto de Testes Padrão. - Os casos de teste com campos

testSuitepreenchidos são designados ao conjunto de testes selecionado quando você importa o CSV somente quando o nome do conjunto de testes selecionado corresponde ao nome no campotestSuite. - Se um conjunto de testes com o nome do especificado no campo

testSuiteainda não existir, ele será criado depois que você importar o CSV.

- Casos de teste com campos

utterance– Um exemplo de declaração (obrigatório). Mapeado paraquerynas versões anteriores à 21.04 do Oracle Digital Assistant.expectedIntent– A intenção de correspondência (obrigatória). Este campo é mapeado paraTopIntentnas versões anteriores à 21.04 do Oracle Digital Assistant.Dica:

Importar versões anteriores à versão 21.04 do CSV mostra como reformatar CSVs anteriores à versão 21.04 para que você possa usá-los para testes em lote.enabled–TRUEinclui o caso de teste na execução do teste.FALSEo exclui.languageTag- A tag de idioma (en, por exemplo). Quando não há valor, o idioma detectado nas definições de idioma da habilidade é usado por padrão.expectedLanguageTag(opcional) - Para habilidades multilíngues, esta é a tag de idioma do idioma que você deseja que o modelo use ao resolver a declaração de teste para uma intenção. Para que o caso de teste seja aprovado, essa tag deve corresponder ao idioma detectado.expectedEntities- As entidades correspondentes na declaração do caso de teste, representadas como um array de objetosentityName. CadaentityNameidentifica a posição do valor da entidade na declaração usando as propriedadesbeginOffseteendOffset. Esse deslocamento é determinado por caractere, não por palavra, e é calculado a partir do primeiro caractere da declaração (0-1). Por exemplo, o objetoentityNamepara o valor de entidade PizzaSize pequeno em Quero pedir uma pizza pequena é:[{"entityName":"PizzaSize","beginOffset":18,"endOffset":23,"originalString":"small"}, …]

- Clique em Mais e selecione Importar.

- Procure e selecione o CSV.

- Escolha o conjunto de testes. O caso de teste só poderá ser designado ao conjunto de testes selecionado se o campo

testSuiteestiver vazio ou corresponder ao nome do conjunto de testes selecionado. - Clique em Upload.

Importação de versões anteriores à versão 21.04 do CSV

query e TopIntent, são adicionados somente ao Conjunto de testes padrão. Você pode reatribuir esses casos de teste a outros conjuntos de testes individualmente editando-os depois de importar o CSV ou pode atualizar o CSV para o formato atual e editá-lo antes de importá-lo da seguinte forma:

- Clique em Mais > Importar.

- Depois que a importação for concluída, selecione Suíte de Teste Padrão e clique em Mais > Exportar Suíte Selecionada. O arquivo exportado será convertido para o formato atual.

- Extraia o arquivo ZIP e edite o CSV. Quando terminar, importe o CSV novamente ( Mais > Importar). Talvez seja necessário excluir casos de teste duplicados da Suite de Teste Padrão.

Observação

Se você fizer upload do mesmo CSV várias vezes com alterações menores, quaisquer dados novos ou atualizados serão mesclados com os antigos: novas atualizações serão aplicadas e novas linhas serão inseridas. No entanto, não será possível excluir qualquer declaração fazendo upload de um novo CSV. Se precisar excluir declarações, será necessário excluí-las manualmente da interface do usuário.

Criar Execuções de Teste

As execuções de teste são uma compilação de casos de teste ou conjuntos de testes destinados a avaliar algum aspecto da cognição da habilidade. O conteúdo (e o volume) de uma execução de teste depende da capacidade que você deseja testar, portanto, uma execução de teste pode incluir um subconjunto de casos de teste de um conjunto de teste, um conjunto de teste completo ou vários conjuntos de teste.

Os casos de teste incluídos em uma execução de teste são avaliados em relação ao limite de confiança definido para a habilidade. Para que um caso de teste seja aprovado na execução geral do teste, ele deve ser resolvido para a intenção esperada no limite de confiança ou acima dele. Se especificado, o caso de teste também deve atender ao valor da entidade e aos critérios de correspondência de idioma. Ao revisar os resultados da execução de teste, você pode descobrir se as alterações feitas na plataforma ou na própria habilidade comprometeram a precisão da resolução da intenção.

Além de testar o modelo, você também pode usar os resultados da execução do teste para avaliar a confiabilidade do teste. Por exemplo, os resultados que mostram que quase todos os casos de teste passaram podem, na superfície, indicar o funcionamento ideal do modelo. No entanto, uma revisão dos casos de teste aprovados pode revelar que os casos de teste não refletem o treinamento atual porque suas declarações são muito simples ou têm sobreposição significativa em termos dos conceitos e palavreados para os quais estão testando. Um grande número de testes com falha, por outro lado, pode indicar deficiências nos dados de treinamento, mas uma revisão desses casos de teste pode revelar que suas declarações são pareadas com as intenções esperadas erradas.

- Clique em Executar Tudo para criar uma execução de teste de todos os casos de teste em uma suíte selecionada. (Ou se quiser executar todas as suítes de teste, selecione Tudo e clique em Executar Tudo).

- Para criar uma execução de teste para uma seleção de casos de teste dentro de uma suíte (ou uma execução de teste para o subconjunto de todos os casos de teste se você selecionou Tudo), filtre os casos de teste adicionando uma string que corresponda ao texto da declaração e a uma intenção esperada. Selecione a(s) declaração(ões) e clique em Executar.

- Para excluir o conjunto de testes da execução de teste, primeiro selecione o conjunto de testes, abra a guia Geral e, em seguida, desative Ativar Conjunto de Testes.

- Para habilidades multilíngues, você também pode filtrar pelas opções Tag de Idioma e Idioma Esperado (acessado por meio de Atributos Opcionais).

- Para criar uma execução de teste para uma seleção de casos de teste dentro de uma suíte (ou uma execução de teste para o subconjunto de todos os casos de teste se você selecionou Tudo), filtre os casos de teste adicionando uma string que corresponda ao texto da declaração e a uma intenção esperada. Selecione a(s) declaração(ões) e clique em Executar.

- Insira um nome de execução de teste que reflita o assunto do teste. Esta etapa é opcional.

- Clique em Iniciar

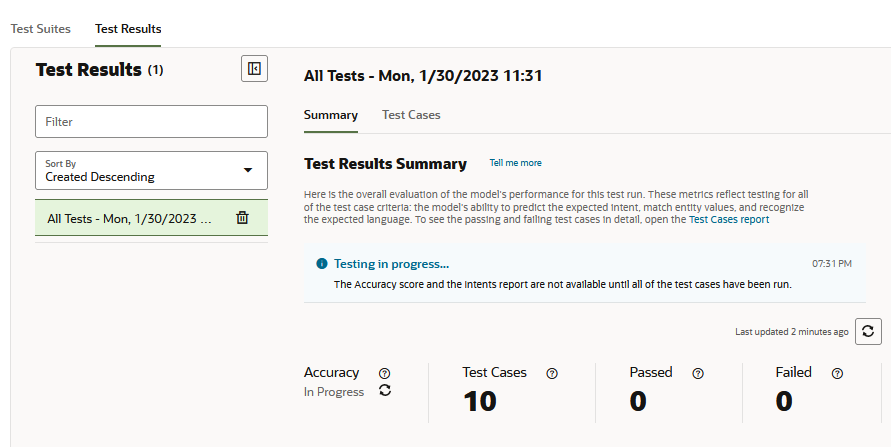

- Clique em Testar Resultados e selecione a execução de teste.

Dica:

Execuções de teste que contêm um grande número de casos de teste podem levar alguns minutos para serem concluídas. Para essas grandes execuções de teste, talvez seja necessário clicar em Atualizar periodicamente até que o teste seja concluído. Uma porcentagem substitui o status Em Andamento para a métrica Precisão e o relatório Intenções é renderizado depois que todos os casos de teste foram avaliados.

- Revise os relatórios de execução de teste. Por exemplo, primeiro revise as métricas de alto nível para a execução de teste fornecidas pelo relatório de Visão Geral. Em seguida, valide os resultados do teste em relação aos casos de teste reais filtrando o relatório Casos de Teste, que lista todos os casos de teste incluídos na execução do teste, para casos de teste aprovados e com falha. Em seguida, você pode examinar os resultados do caso de teste individual. Você também pode comparar a pontuação de Precisão no relatório Visão Geral com a pontuação de Precisão no relatório de Intenções, que mede a capacidade do modelo de prever as intenções corretas. Para revisar os casos de teste listados neste relatório, abra o relatório Casos de Teste e filtre por intenções.

Relatório Resumido de Execução de Teste

O relatório Resumo fornece uma avaliação geral de como o modelo pode tratar com sucesso o tipo de entrada do usuário que é abordado na execução do teste. Para os conjuntos de testes incluídos na execução do teste, ele mostra o número total de casos de teste que foram usados para avaliar o modelo e, desse total, o número de casos de teste (confiáveis e não confiáveis) que falharam junto com o número de casos de teste confiáveis e não confiáveis aprovados. A precisão geral do modelo - sua capacidade de prever intenções esperadas no nível de confiança da habilidade ou acima dela, reconhecer valores de entidade e resolver declarações no idioma da habilidade - é medida pela taxa de sucesso dos testes de aprovação na execução do teste.

Descrição da ilustração test-run-test-results-summary.png

Métricas do Relatório Sumariado

- Precisão - A precisão do modelo em termos da taxa de sucesso dos casos de teste de aprovação (o número de casos de teste de aprovação em comparação com o número total de casos de teste incluídos na execução do teste).

Observação

Os casos de teste desativados não são fatorados na pontuação de Precisão. Os testes também não falharam devido a erros. Qualquer teste que falhou é adicionado à contagem de falhas.Uma pontuação de baixa Precisão pode indicar que a execução do teste está avaliando o modelo em conceitos e linguagem que não são adequadamente suportados pelos dados de treinamento. Para aumentar a pontuação de Precisão, treine novamente o modelo com declarações que reflitam os casos de teste na execução do teste.

Essa métrica de Precisão se aplica a toda a execução do teste e fornece uma pontuação separada da métrica de Precisão no relatório de Intenções. Esta métrica é a porcentagem de casos de teste em que o modelo passou em todos os critérios do caso de teste. A pontuação de Precisão no relatório de Intenções, por outro lado, não é um teste de ponta a ponta. É a porcentagem de casos de teste em que o modelo teve apenas que prever a intenção esperada no ou acima do limite de confiança da habilidade. Outros critérios de caso de teste (como valor da entidade ou idioma da habilidade) não são considerados. Dados os diferentes critérios do que um caso de teste aprovado significa para esses dois relatórios, suas respectivas pontuações de Precisão podem nem sempre estar em etapa. A pontuação de Precisão de correspondência da intenção pode ser maior que a pontuação geral de execução do teste quando os dados do teste não estiverem alinhados com os dados do treinamento. O novo treinamento do modelo com declarações que suportam os casos de teste permitirá que ele preveja as intenções esperadas com maior confiança que, por sua vez, aumentará a pontuação de Precisão para a execução do teste.

Observação

A métrica Precisão não estará disponível até que a execução do teste seja concluída e não esteja disponível para execuções de teste que foram concluídas quando a habilidade foi executada nas versões anteriores à versão 22.12 da plataforma Oracle Digital Assistant. - Casos de Teste - O número total de casos de teste (tanto confiáveis quanto não confiáveis) incluídos na execução do teste. Os casos de teste ignorados são incluídos nessa contagem, mas não são considerados ao calcular a métrica de Precisão.

- Aprovado - O número de casos de teste (confiáveis e não confiáveis) que passaram resolvendo para a intenção no limite de confiança e correspondendo aos valores ou idioma da entidade selecionada.

- Falha - O número de casos de teste (bot confiável e não confiável) que não foram resolvidos para a intenção esperada no limite de confiança e não corresponderam aos valores ou idioma da entidade selecionada.

Para revisar os casos de teste reais por trás das métricas Aprovadas e Com Falha neste relatório, abra o relatório Casos de Teste e aplique seus filtros Aprovado ou Com Falha.

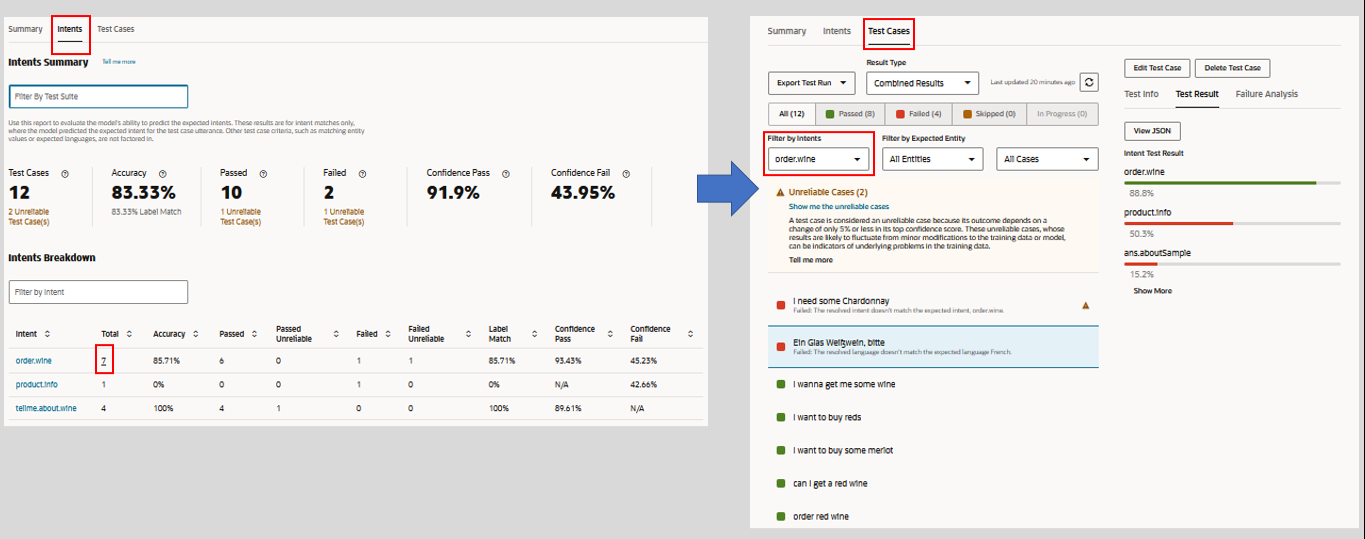

Descrição da ilustração test-runs-intent-report.png

Detalhamento do Conjunto de Testes

A tabela Detalhamento do Conjunto de Testes lista os conjuntos de testes incluídos na execução do teste e suas estatísticas individuais. Você pode revisar os casos de teste reais pertencentes a um conjunto de testes clicando no link na coluna Conjunto de Testes.

Descrição da ilustração test-suite-breakdown.png

Relatório de Intenções

As métricas deste relatório rastreiam as correspondências do label do modelo em todos os casos de teste da execução do teste. É aqui que o modelo prevê corretamente a intenção esperada para a declaração do caso de teste. No contexto deste relatório, a precisão, a aprovação e a falha são medidas em termos dos casos de teste em que o modelo previu a intenção esperada correta no limite de confiança ou acima dele. Outros critérios considerados no relatório de resumo, como correspondências de valor de entidade ou idioma da habilidade, não são considerados. Como resultado, este relatório fornece uma visão diferente da precisão do modelo, que ajuda a verificar se o treinamento atual permite que o modelo preveja consistentemente as intenções corretas.

Este relatório não está disponível para execuções de teste que foram concluídas quando a habilidade foi executada em uma versão anterior à versão 22.12 da plataforma Oracle Digital Assistant.

Métricas de Relatório de Intenções

- Casos de Teste - O número de casos de teste incluídos nesta execução de teste. Este total inclui casos de teste confiáveis e não confiáveis. Os casos de teste ignorados não são incluídos nessa contagem.

Dica:

Os links de caso de teste não confiáveis para as métricas Casos de Teste, Aprovados e com Falha abrem o relatório Casos de Teste filtrado por casos de teste não confiáveis. Essa navegação não está disponível quando você filtra o relatório por conjunto de testes. - Precisão - A precisão do modelo em corresponder à intenção esperada no ou acima do limite de confiança da habilidade nos casos de teste nesta execução de teste. A submétrica Correspondência de Rótulo representa a porcentagem de casos de teste na execução de teste em que o modelo previu corretamente a intenção esperada, independentemente da pontuação de confiança. Como os fatores de Correspondência de Rótulo em casos de teste com falha e casos de teste aprovados, sua pontuação pode ser maior que a pontuação de Precisão.

Você pode comparar essa métrica de Precisão com a métrica de Precisão do relatório de Resumo. Quando a pontuação de Precisão no relatório de Resumo for baixa, você poderá usar esse relatório para descobrir rapidamente se as falhas do modelo podem ser atribuídas à incapacidade de prever a intenção esperada. No entanto, quando a pontuação de Precisão neste relatório for alta, você poderá descartar a correspondência de rótulos como a raiz do problema e, em vez de ter que revisar fortemente os dados de treinamento para aumentar a pontuação de Precisão da execução do teste, você poderá se concentrar na adição de declarações que reflitam os conceitos e o idioma nas declarações do caso de teste.

- Aprovado - O número de casos de teste (confiáveis e não confiáveis) em que o modelo previu a intenção esperada no limite de confiança da habilidade.

- Falha - O número de casos de teste (confiáveis e não confiáveis) em que o modelo previu a intenção esperada abaixo do limite de confiança da habilidade.

- Passagem de Confiança - Uma média das pontuações de confiança de todos os casos de teste aprovados nessa execução de teste.

- Falha na Confiança - Uma média das pontuações de confiança de todos os casos de teste que falharam nesta execução de teste.

Quando você filtra o relatório de Intenções por conjunto de testes, o acesso ao relatório de Casos de Teste dos links de caso de teste não confiáveis nos mosaicos Casos de Teste, Aprovados e Com Falha não está disponível. Esses links se tornam ativos novamente quando você remove todas as entradas do campo Filtrar por Conjunto de Testes.

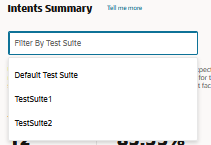

Filtrar por Conjunto de Testes

O relatório ajusta as métricas de cada conjunto de testes adicionado (ou subsequentemente removido). Ela tabula os resultados de correspondência de intenção em termos do número de casos de teste ativados que pertencem ao conjunto de testes selecionado.

Não é possível filtrar por suítes de teste que foram executadas em uma plataforma anterior à Versão 23.06. Para incluir esses conjuntos de testes, você precisa executá-los novamente após atualizar para a versão 23.06 ou superior.

A filtragem por conjunto de testes desativa a navegação para o relatório Casos de Teste dos links de casos de teste não confiáveis nos blocos Casos de Teste, Aprovados e Falhados. Os links na coluna Total do Detalhamento de Intenções também estão desativados. Todos esses links se tornam ativos novamente depois que você remove todas as entradas do campo Filtrar por Conjunto de Testes.

Detalhamento de Intenções

O campo Filtrar por Intenção altera a exibição da tabela Detalhamento de Intenções, mas não altera as métricas gerais do relatório. Essas métricas refletem as entradas (ou a falta de entradas) no campo Filtrar por pacote de teste.

- Intenção - O nome da intenção esperada.

- Total - O número de casos de teste, representados como um link, para a intenção esperada. Você pode percorrer o relatório Casos de Teste clicando neste link.

Observação

Não é possível navegar até o relatório Casos de Teste quando você aplicou um filtro da suíte de teste a esse relatório. Esse link torna-se ativo novamente quando você remove todas as entradas do campo Filtrar por Conjunto de Testes. - Precisão - A porcentagem de casos de teste que resultaram em correspondências de label para a intenção esperada ou acima do limite de confiança da habilidade.

- Aprovado - O número de casos de teste (incluindo casos de teste não confiáveis) em que o modelo previu a intenção esperada no limite de confiança da habilidade ou acima dele.

- Aprovado - Não Confiável - Os casos de teste de número em que o modelo previu a intenção esperada em 5% ou menos acima do limite de confiança da habilidade.

- Falha - O número de casos de teste na execução de teste que falharam porque o modelo previu a intenção esperada abaixo do limite de confiança da habilidade.

- Falha - Não Confiável - O número de casos de teste que falharam porque a confiança do modelo na previsão da intenção esperada caiu 5% abaixo do limite de confiança da habilidade. Esses casos de teste podem levar em consideração

- Correspondência de Rótulo - O número de casos de teste em que o modelo previu com sucesso a intenção esperada, independentemente do nível de confiança. Como isso ocorre em casos de teste com falha, as pontuações de Correspondência e Precisão do Rótulo podem nem sempre estar em sintonia. Por exemplo, quatro casos de teste aprovados de cinco resultam em uma pontuação de 80% de Precisão para a intenção. No entanto, se o modelo previu a intenção corretamente para um caso de teste com falha, a Correspondência de Rótulo superaria a Precisão em 20%.

- Passagem de Confiança - Uma média das pontuações de confiança de todos os casos de teste que corresponderam com sucesso à intenção esperada.

- Falha na Confiança - Uma média das pontuações de confiança de todos os casos de teste que não corresponderam à intenção esperada.

Dica:

Para revisar os casos de teste reais, abra o relatório Casos de Teste e o filtro pela intenção.

Relatório de Casos de Teste

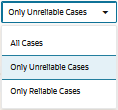

- Você pode filtrar os resultados clicando em All, Passed (green) ou Failed (red). Os casos de teste contados como ignorados incluem os desativados e aqueles em que a intenção esperada foi desativada.

Você pode filtrar os resultados casos de teste não confiáveis clicando em Mostrar casos não confiáveis na mensagem de advertência ou selecionando o filtro Somente Casos Não Confiáveis. - Se necessário, filtre os resultados para uma intenção ou entidade específica ou por casos de teste confiáveis ou não confiáveis.

- Para casos de teste não confiáveis e com falha, clique em Exibir Declarações Semelhantes (localizados na página Informações de Teste) para descobrir se a declaração do caso de teste tem qualquer semelhança com as declarações no conjunto de treinamento.

- Verifique os seguintes resultados:

- Informações de Teste - Apresenta a visão geral do caso de teste, incluindo o limite de confiança de destino, a intenção esperada e os valores de entidade correspondentes.

- Resultado do Teste - A classificação da intenção por nível de confiança. Quando presente, o relatório também identifica as entidades contidas na declaração por nome e valor da entidade. Você também pode exibir o objeto JSON que contém os resultados completos.

- Análise de Falha - Explica por que o caso de teste falhou. Por exemplo, a intenção real não é a intenção esperada, o valor da entidade rotulada no caso de teste não corresponde à entidade resolvida ou o idioma esperado não é o mesmo que o idioma detectado.

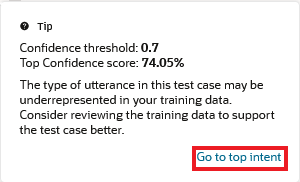

Casos de Teste Não Confiáveis

Alguns casos de teste não podem fornecer resultados consistentes porque eles são resolvidos dentro de 5% ou menos do Limite de Confiança. Essa margem estreita torna esses casos de teste não confiáveis. Quando o Limite de Confiança da habilidade é definido como 0,7, por exemplo, um caso de teste que está passando em 74% pode falhar depois que você fez apenas pequenas modificações nos seus dados de treinamento ou porque a habilidade foi atualizada para uma nova versão do modelo. A fragilidade desses casos de teste pode indicar que as declarações que elas representam nos dados de treinamento podem ser muito poucas em número e que talvez você precise equilibrar os dados de treinamento da intenção com declarações semelhantes.

- Execute o conjunto de testes. Em seguida, clique em Testar Resultados e selecione a execução de teste. Os casos de teste não confiáveis são classificados no início dos resultados da execução do teste e são sinalizados com advertências

.

. - Para isolar os casos de teste não confiáveis:

- Clique em Mostrar os casos não confiáveis na mensagem.

- Selecione Somente Casos Não Confiáveis no menu Filtrar por Casos.

- Clique em Mostrar os casos não confiáveis na mensagem.

- Para localizar a proximidade da intenção de classificação superior do caso de teste com o Limite de Confiança, abra a janela Resultado do Teste. Para obter uma comparação da pontuação de confiança de primeira linha com o Limite de Confiança, clique em

.

. - Se você precisar complementar os dados de treinamento para a intenção de classificação superior, clique em Ir para a intenção superior na mensagem de advertência.

- Se quiser determinar a quantidade de declarações representadas pelo caso de teste nos dados de treinamento, clique em Exibir Declarações Semelhantes.

Você também pode verificar se alguma das declarações mais semelhantes à declaração do caso de teste também são anomalias no conjunto de treinamento executando o Relatório de Anomalias.

Execuções de Teste Exportadas

As execuções de teste não são persistidas com a habilidade, mas você pode fazer download delas no sistema para análise clicando em Exportar Execução de Teste. Se as intenções não resolverem mais a entrada do usuário conforme esperado ou se as alterações na plataforma tiverem impactado negativamente a resolução da intenção, você poderá reunir os detalhes de uma SR (solicitação de serviço) usando os logs das execuções de teste exportadas.

Teste de Falha

O teste de falha (ou negativo) permite que você teste em massa declarações que nunca devem ser resolvidas, porque elas resultam em unresolvedIntent ou porque só são resolvidas para outras intenções abaixo do limite de confiança para todas as intenções.

- Especifique unresolvedIntent como Intenção Esperada para todos os casos de teste que você espera que não sejam resolvidos. Idealmente, essas frases "falsas" permanecerão não resolvidas.

- Se necessário, ajuste o limite de confiança ao criar uma execução de teste para confirmar que as frases falsas (aquelas com

unresolvedIntentcomo intenção esperada) só podem ser resolvidas abaixo do valor definido aqui. Por exemplo, aumentar o limite pode resultar na falha de resolução das frases falsas no nível de confiança para qualquer intenção (incluindo unresolvedIntent), o que significa que elas são aprovadas porque são consideradas não resolvidas. - Confira os resultados do teste, verificando se os casos de teste foram aprovados, correspondendo a unresolvedIntent no limite, ou se não corresponderam a qualquer intenção (unresolvedIntent ou outra) no limite.

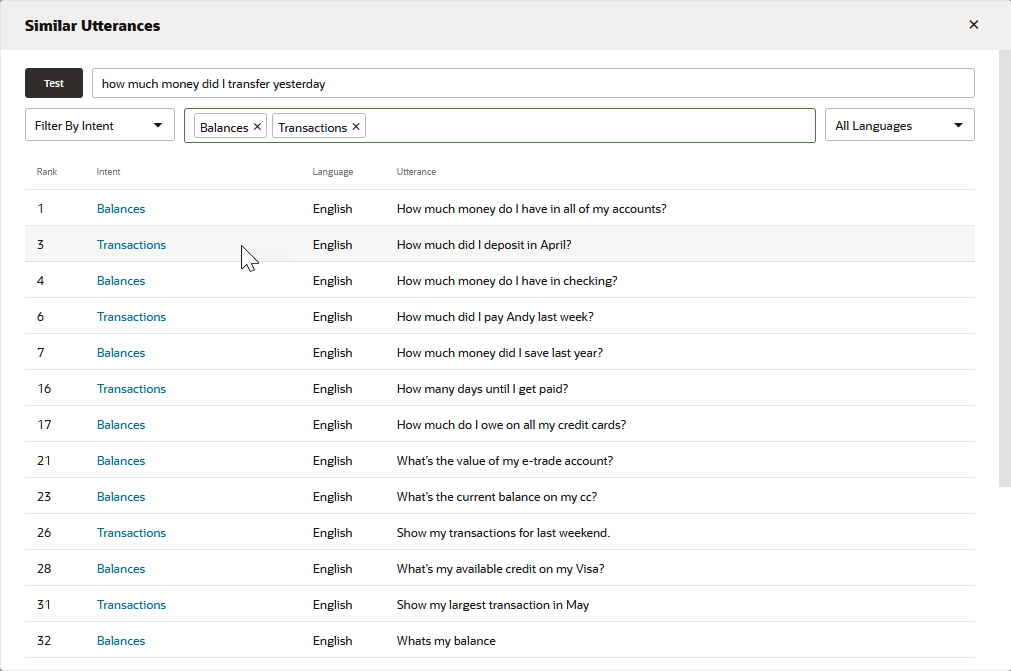

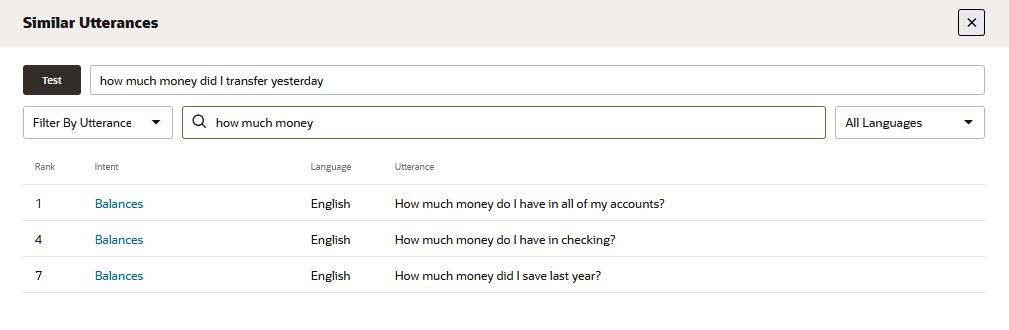

Declarações Semelhantes

Você pode descobrir o quanto sua frase de teste é semelhante às declarações no corpus de treinamento clicando em Exibir Declarações Semelhantes. Essa ferramenta fornece uma perspectiva adicional sobre os dados de treinamento da habilidade, mostrando como suas declarações são semelhantes à frase de teste e, por extensão, como as declarações são semelhantes entre si entre intenções. Usando essa ferramenta, você pode descobrir se a similaridade da frase de teste com as declarações pertencentes a outras intenções é a razão pela qual a frase de teste não está resolvendo como esperado. Pode até apontar onde os dados de treinamento pertencem à intenção errada porque se forem semelhantes à frase de teste.

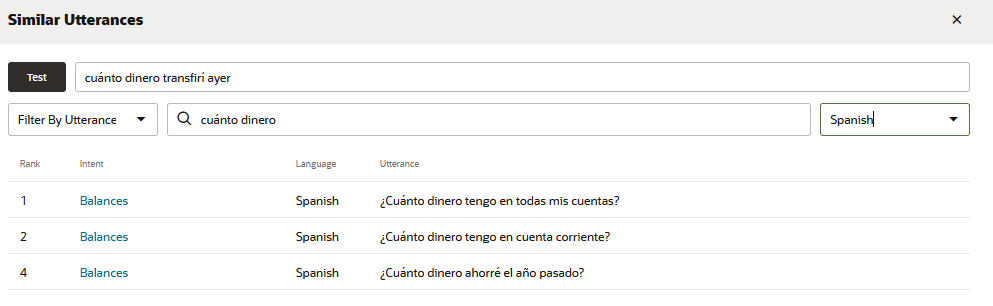

Descrição da ilustração similar-utterance-report-all-intents.png

A lista gerada por essa ferramenta classifica 20 declarações (junto com suas intenções associadas) que estão mais próximas da frase de teste. Idealmente, a declaração de classificação superior nesta lista - a mais parecida com a frase de teste - pertence à intenção direcionada para a frase de teste. Se a declaração mais próxima que pertence à intenção esperada estiver mais abaixo, uma revisão da lista poderá fornecer algumas dicas sobre o motivo. Por exemplo, se você estiver testando uma declaração de intenção de Transações, quanto dinheiro transferi ontem?, espere que a declaração de classificação superior também pertença a uma intenção de Transações. No entanto, se essa declaração de teste estiver resolvendo para a intenção errada ou resolvendo abaixo do nível de confiança, a lista poderá revelar que ela tem mais em comum com declarações altamente classificadas com palavras semelhantes que pertencem a outras intenções. A intenção de Saldos Quanto dinheiro tenho em todas as minhas contas?, por exemplo, pode estar mais próxima da declaração de teste do que a declaração de Quanto depositei em abril? da intenção de Transações.

Você só pode usar essa ferramenta para habilidades treinadas no Trainer Tm (ela não está disponível para habilidades treinadas com Ht).

- Filtrar por Intenção - Retorna 20 declarações que estão mais próximas da declaração de teste que pertencem à intenção (ou intenções) selecionada.

- Filtrar por Declaração - Retorna 20 das declarações mais próximas da declaração de teste que contêm uma palavra ou frase.

- Idioma - Para habilidades multilíngues, você pode consultar e filtrar o relatório selecionando um idioma.

A aplicação desses filtros não altera as classificações, apenas a view. Uma declaração classificada em terceiro lugar, por exemplo, será anotada como tal, independentemente do filtro. As classificações e o conteúdo do relatório só mudam quando você atualiza o corpus e treina novamente a habilidade com o Trainer Tm.