この項では、InfiniBandベースのネットワーク・アーキテクチャでシステムのストレージ容量を拡張するオプションについて説明します。

Oracle Private Cloud Applianceでは、必要なテクノロジに応じて、Fabric Interconnectに接続されている追加のファイバ・チャネルまたはInfiniBandストレージ・デバイスをサポートできます。 この章では、これらの各テクノロジについてアプライアンスを拡張する方法について説明します。

「表8.1」では、追加のファイバ・チャネルまたはInfiniBandストレージ・ハードウェアをFabric Interconnectに接続してサイトでOracle Private Cloud Applianceストレージ容量を拡張するステップについて説明します。

表8.1 Oracle Private Cloud Applianceストレージ容量の拡張のステップ

ステップ | 説明 | リンク |

|---|---|---|

1 | 安全のためのガイドラインとサイトのチェックリストを確認します。 | |

2 | インストールする外部ストレージのタイプを識別します。

| |

3 | 外部ストレージをアプライアンスに接続します。 これには、物理的な配線と、その基になった自動構成が関係します。 | ファイバ・チャネル: InfiniBand: |

4 | Oracle Private Cloud Applianceで使用する外部ストレージを構成します。 これは、Oracle Private Cloud Applianceに接続されたストレージ・ハードウェア上のソフトウェア構成を示します。 | ファイバ・チャネル: InfiniBand: |

5 | Oracle Private Cloud Applianceを構成して外部ストレージを有効にします。 これは、Oracle Private Cloud Applianceに接続されたストレージ・ハードウェアとの接続を有効にするOracle VM Managerの構成を示します。 | ファイバ・チャネル: InfiniBand: |

EthernetベースおよびInfiniBandベースのネットワーク・アーキテクチャを持つOracle Private Cloud Applianceでは、Oracle Server X8-2拡張コンピュート・ノードは、インストール前のオプションの32GbitファイバChannelカードでオーダーできます。 これらの「物理」 HBAを介して、拡張コンピュート・ノードをデータセンター内の標準のFCスイッチおよびストレージ・ハードウェアに接続できます。 ただし、FabricインターコネクトにアタッチされるFCストレージへのアタッチに通常使用される「仮想」 HBAは、無効にしておく必要があります。

コンピュート・ノード内の物理HBAを介して接続されたFCストレージは、InfiniBandベースとEthernetベースの両方のOracle Private Cloud Applianceシステム上で、標準のFCストレージと同様に動作します。 Etherneベース・システムについては第8.1.3項、「外部ファイバ・チャネル・ストレージの追加」を参照してください。

この項で説明する構成は、Fabric InterconnectのI/OモジュールのFCポートにアタッチされているFCストレージを指します。 この項の情報は、InfiniBandベースのネットワーク・アーキテクチャを備えたシステムおよびFC拡張カードを持たないコンピュート・ノードに固有です。

ファイバ・チャネル(FC)は、Fabric Interconnect上で使用可能なFCポートを使用して、Oracle Private Cloud Appliance (PCA)に追加のFC対応ストレージ・デバイスを接続するために使用できます。 Oracle Private Cloud Applianceでは、Oracle Private Cloud Applianceラックの各サーバーに仮想ホストBusアダプタ(vHBAs)が自動的に作成されます。 これらのvHBAsに対して定義されているWorld Wide Port Names (WWPNs)を使用して、ストレージ・アプライアンス上でイニシエータ・グループを定義すると、コンピュート・ノードと管理ノードで使用可能にするLUNへのアクセスを容易にできます。

Oracle Private Cloud Applianceは、Fabric Interconnectにあるファイバ・チャネルのI/Oモジュールを使用せずにオーダーできます。 ただし、これらのモジュールは個別にオーダーして、後でインストールできます。 インストール手順は、第8.2.2.2項、「オプションのファイバ・チャネルI/Oモジュールのインストール」を参照してください。

Oracle Private Cloud Applianceは、Fabric InterconnectをユーザーのFCスイッチまたはスイッチに接続するために使用されるFCポートをまとめた、ストレージ・クラウドの概念を導入しています。 Fabric Interconnectのそれぞれに2つのFCポートがクラウドに割り当てられています。 vHBAは、各ストレージ・クラウドの各サーバー上に作成されます。 4つのストレージ・クラウドの合計は、Oracle Private Cloud Applianceのプロビジョニング時に定義され、コンピュート・ノードと管理ノードのそれぞれに4つのvHBAsが生成されます。

ストレージ・クラウドにより、全体的なスループットの改善や完全なHA対応インフラストラクチャの構築など、外部ストレージをケーブルで構成したり、構成したりできます。 ストレージ・クラウドが自動的に作成および構成されるため、必要な作業は、使用するHA構成のタイプを選択し、それに応じてケーブルを選択することです。 ストレージ・クラウド構成の設計により、構成の複雑さが軽減され、HA要件の観点から最大限の柔軟性が得られます。

少なくとも、単一のクラウドを使用して、各コンピュート・ノード上または管理ノード上のストレージにアクセスできます。 ただし、単純なHA構成をお薦めします。 このためには、各Fabricインターコネクトから少なくとも2つのクラウドをクロス配線する必要があります。 HA対応環境では、Fabric Interconnectと独自のFCスイッチの2つの間で配線される4つのすべてのクラウドを使用できます。

HAが不要な場合は、複数のクラウドを使用すると全体のスループットを向上できます。 この構成では、3つのクラウドを別のスイッチにケーブルで接続し、同じストレージに接続できます。 1つのクラウドがフェイルオーバーされた場合、4番目のクラウドを起動してその機能を引き継ぎ、同じレベルのスループットを維持できます。

これらの構成はすべて、FCスイッチやスイッチにFabric Interconnectへのパッチを適用するという点で、まったく異なる方法で実現されます。 これらのアプローチの詳細は、第8.2.2.3項、「ファイバ・チャネル・ハードウェアの接続」を参照してください。

ストレージ・クラウドは各サーバー上のvHBAsに直接マップされるため、FCスイッチ上にゾーンを構成するか、ストレージ・クラウドごとにセキュアに別個のトラフィックに切り替えることができます。 これにより、セキュアなチャネルを使用して、ストレージ上のサーバーとLUN間の通信を容易にするために、別々のクラウドを別々の目的で使用できます。 これについては、第8.2.2.4項、「ゾーンの構成に関する項」で説明されています。

Oracle Private Cloud Applianceでファイバ・チャネルを使用するには、独自のNPIV対応FCスイッチまたはスイッチを提供する必要があります。 FC対応ストレージにFabricインターコネクト上のFCポートに直接パッチを適用することはできません。 これは、Fabric InterconnectでNPIVが使用されているためです。 - ファイバ・チャネル・ノードのポートID仮想化 - ポート・ノードを、各サーバーで作成されたvHBAsのWorld Wide Node Names (WWNNs)にマップします。 WWNNへのWWPNの翻訳に必要なソフトウェアは、ほとんどのFCストレージ・デバイスのストレージ・ヘッドに存在しないため、ストレージ・デバイスを直接アタッチすると、各サーバー上で利用できるvHBAs用のwwpnの登録が防止されます。

Oracle Private Cloud Applianceの各サーバーは、InfiniBand (IB)接続を介してFabric Interconnectに接続されます。 Fabric Interconnectは、ファイバ・チャネル・ポート上の接続を変換して、これらのIB接続を介して接続を再ルーティングすることができます。 これを容易にするために、Fabric Interconnect上で定義されているストレージ・クラウドにマップするvHBAsを、各サーバー上で定義する必要があります。 これらのvHBAsがマップするストレージ・クラウドは、Fabric Interconnect上でどのFCポートに関連するかを決定します。

管理ノードの初期構成中に、各ストレージ・クラウドはFabric InterconnectおよびvHBAs上で自動的に構成され、各クラウドは管理ノードごとに作成されます。 管理ノード上のvHBAsに対してWWNNおよびWWPNが生成されます。 ストレージ・クラウド用のケーブルを接続し、ストレージ・アプライアンスに接続する場合、これらのWWPNをストレージ・イニシエータ・グループに追加して、管理ノードで使用できるようにするLUNをエクスポートできます。 必要に応じて、これらのディスクを管理ノードにマウントできます。 管理ノードはvHBAsで構成され、外部に接続されたストレージを使用して必要に応じてバックアップおよびログ・データを格納できるように、別のストレージ・クラウドに接続できます。

WWNNとWWPNを区別することが重要です。 WWNNはHBAなどのデバイスまたはノードの識別に使用され、WWPNはその同じデバイスを介してアクセスできるポートの識別に使用されます。 一部のデバイスには複数のポートがあることがあるため、1つのデバイスに1つのWWNNと複数のWWPNがある場合があります。

各コンピュート・ノードで生成されるvHBAsの場合、vHBAごとに1つのWWNNと1つのWWPNがあります。 これらはほぼ同一ですが、WWNNを構成する4番目の16進数が異なります。 これを次に示します。

WWPN | WWNN |

|---|---|

50:01:39:70:00:4F:91:00 | 50:01:39:71:00:4F:91:00 |

ストレージ・イニシエータおよびイニシエータ・グループを構成するとき、各vHBAのWWPNに対してこれらを構成するようにしてください。 イニシエータ・グループ内でvHBAに対してWWNNを使用すると、そのイニシエータ・グループが予期したとおりに機能しなくなる場合があります。

コンピュート・ノードも同様に構成されますが、コンピュート・ノードのプロビジョニング時にプロセスが発生するため、コンピュート・ノードがプロビジョニング時に構成されます。 つまり、コンピュート・ノードをラックに追加すると、外部にアタッチされたストレージにアクセスできるように自動的に構成されます。 vHBAsの作成および構成もアップグレード・プロセスに組み込まれているため、既存の環境で外部FCストレージを使用できます。 ストレージのためにケーブル接続を行い、ストレージにイニシエータ・グループを構成したら、Oracle VM Managerで直接コンピュート・ノードに使用できるLUNを表示できます。

ファクトリ・インストールされたファイバ・チャネルI/Oモジュールを使用してOracle Private Cloud Applianceを購入した場合、これらのプロセスは完全に自動化されるため、介入は必要ありません。

ファイバ・チャネルI/Oモジュールを使用せずにOracle Private Cloud Applianceを購入した場合、まずFabricインターコネクトにオプション・モジュールをインストールする必要があるときは、第8.2.2.2項、「オプションのファイバ・チャネルI/Oモジュールのインストール」の指示に注意してください。

Oracle Private Cloud Applianceリリース2.0.3ソフトウェアを含むX5-2ベース・ラックでは、ファイバ・チャネルI/Oモジュールのある場合とない場合がある最初の構成がマークされます。 ファイバ・チャネル接続を使用しないOracle Private Cloud Applianceでは、2つのFabricインターコネクトのスロット3および12は空です。 結果として、ファイバ・チャネル接続のためのソフトウェア・クラウドおよびvHBAsはプロビジョニング時には作成されません。

ファイバ・チャネル接続をあとで追加する場合は、オプションのファイバ・チャネルI/Oモジュールをオーダーしてインストールし、コントローラ・ソフトウェアをアップグレードし、必要なストレージ・クラウドとvHBAsを構成する必要があります。

プロビジョニングされたアプライアンスへのファイバ・チャネル接続の追加

Oracle Private Cloud Applianceにファクトリで取り付けられているファイバ・チャネルI/Oモジュールがない場合は、まずアプライアンス・コントローラ・ソフトウェアがリリース2.1.1以降であることを確認する必要があります。 更新プロセスには通常、少なくとも2.5時間かかります。

ソフトウェア更新手順の詳細は、「Oracle Private Cloud Appliance管理者ガイド」の「Oracle Private Cloud Applianceの更新」を参照してください。

コントローラ・ソフトウェアの更新が正常に完了したら、各Oracle Fabric Interconnect F1-15のスロット3および12に、合計4つのファイバ・チャネルI/Oモジュールを取り付けます。 新しいモジュールは、Fabric Interconnectの電源を切断することなくインストールできます。

注意スロット3および12のみを使用する必要があります。 ほかのスロットに取り付けられたファイバ・チャネルI/Oモジュールは、今後のアップグレード問題を引き起こす可能性があるため、Oracle Private Cloud Appliance内ではサポートされません。

モジュール・コンポーネント側がシャーシの右端方向にあることを確認します。 また、モジュールの上部と下部のエッジが、各モジュール・スロットの左端の上部と下部のトラックに正しく整列されていることを確認します。

モジュールの背面パネルの下端にある固定ねじを締め付けることで、スロット内のモジュールを固定します。

注意ねじをきつく締めて、軽量にします。 ねじを締め付けると、損傷を与える可能性があります。

4つのファイバ・チャネルI/Oモジュールがすべてインストールされたら、Oracle Private Cloud Applianceコマンドライン・インタフェース(CLI)から適切なコマンドを実行して、ストレージ・クラウドおよびvHBAsを構成します。

両方の管理ノードでvHBAsを構成します。

PCA> configure vhbas ovcamn05r1 ovcamn06r1 Compute_Node Status ------------ ------ ovcamn05r1 Succeeded ovcamn06r1 Succeeded ---------------- 2 rows displayed Status: Success

クラウドが構成されていることを確認します。

PCA> list storage-network Network_Name Description ------------ ----------- Cloud_A Default Storage Cloud ru22 port1 - Do not delete or modify Cloud_B Default Storage Cloud ru22 port2 - Do not delete or modify Cloud_C Default Storage Cloud ru15 port1 - Do not delete or modify Cloud_D Default Storage Cloud ru15 port2 - Do not delete or modify ---------------- 4 rows displayed Status: Success

4つのストレージ・クラウドが正しく構成されている場合は、すべてのコンピュート・ノードでvHBAsを構成します。

PCA> configure vhbas ALL Compute_Node Status ------------ ------ ovcacn07r1 Succeeded ovcacn08r1 Succeeded [...] ovcacn36r1 Succeeded ovcacn37r1 Succeeded ---------------- 20 rows displayed Status: Success

これらのステップは、この手順の概要のみを説明しています。 詳細な手順は、「Oracle Private Cloud Appliance管理者ガイド」の「プロビジョニングされたアプライアンスでのファイバ・チャネル接続の有効化」を参照してください。

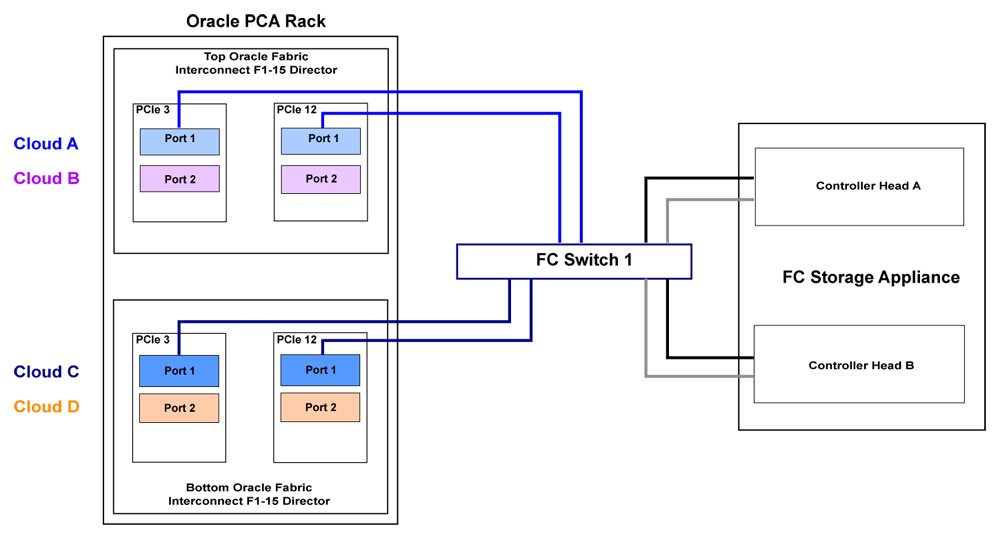

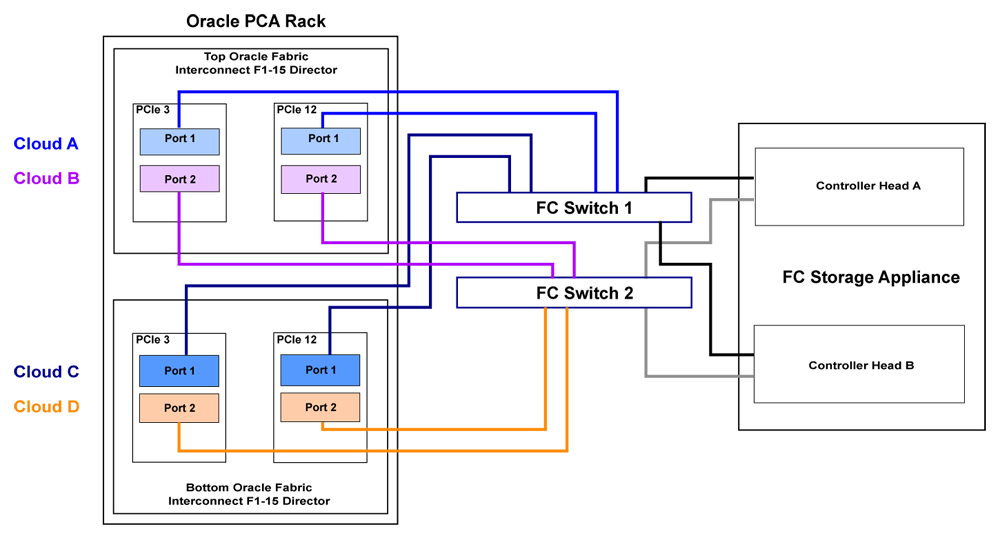

外部のFC対応ストレージをOracle Private Cloud Applianceにアタッチするための配線要件は、Fabric Interconnect上のストレージ・クラウド用のFCポートのグループ化のために非常に具体的です。 ストレージ・クラウドの配線を行う場合は、ストレージ・クラウドに定義された両方のポートをFCスイッチにケーブル接続するようにする必要があります。 理想的には、ラック内の各Fabricインターコネクトで、合計8本のケーブルですべての4つのFCポートを同時にケーブルで接続する必要があります。 これらは、ラックの外部の単一のファイバ・チャネル・スイッチに接続するか、または冗長性を改善するためにラックの外部にある2つのファイバ・チャネル・スイッチにクロス接続する必要があります。 次の表に、各クラウドを作成するためにポートをグループ化する方法を示します。

表8.2 ファイバ・チャネル・ポートおよびクラウド・マッピング

マッピング | 上位Oracle Fabric Interconnect F1-15 (RU 22-25): | Oracle Fabric Interconnect F1-15の下位(RU 15-18): | ||

|---|---|---|---|---|

クラウド名 | 入出力モジュール 3 | 入出力モジュール 12 | 入出力モジュール 3 | 入出力モジュール 12 |

A | ポート1 | ポート1 | なし | なし |

B | ポート2 | ポート2 | なし | なし |

C | なし | なし | ポート1 | ポート1 |

D | なし | なし | ポート2 | ポート2 |

ベア最小構成の場合、2つのケーブルを使用してFCスイッチをクラウドAに接続できます。 これには、I/O Module 3 Port 1およびI/O Module 12 Port 1を使用して、ラック内の上位のFabric Interconnectにケーブルを接続する必要があります。 FCストレージ・アプライアンス上の各コントローラ・ヘッドをFCスイッチに接続します。 通常は、各コントローラ・ヘッドに2つのケーブルを使用します。

基本的なHA構成の場合、クラウドaおよびクラウドcにケーブルを接続します。 これによって、冗長性を改善するためにラック内で両方のFabric Interconnectを使用できます。 これが推奨されるデフォルトの最小構成です。 クラウドAとクラウドcが同じFCスイッチに接続していることが重要です。

HA構成を最大化するには、追加のFCスイッチを使用して、クラウドbとクラウドdを2番目のFCスイッチにケーブル接続します。 この状況では、各コントローラ・ヘッドがFCストレージ・アプライアンス上のコントローラ・ヘッドをクロス・ケーブルで接続し、各コントローラ・ヘッドがFCスイッチのそれぞれに接続されるようにする必要があります。

その他の配線の可能性もあります。これには、クラウドがそれぞれ独立したFCスイッチに接続されている、スループットを最大化したり、物理的なトラフィックの分離を実現する場合の、前述の構成などがあります。 通常、この構成では、一方のクラウドがスタンバイで切断されたままになっているため、他方のクラウドのいずれかがなんらかの理由で失敗した場合に、障害が発生したクラウドの機能を引き継ぐためにスタンバイ・クラウドに接続できます。 この場合、スタンバイ・クラウド用のWWPNが、ストレージ・アプライアンス上のイニシエータ・グループ内の失敗したクラウドと置き換えられるように構成する必要があります。

配線に関する最も重要な点は、次のとおりです。

クラウドは、同じFabricインターコネクト上の代替I/Oモジュール上の2つの同等のポートで構成されます。 たとえば、ラック内の上位のFabric Interconnect上のクラウドAは、I/Oモジュール3のポート1とI/Oモジュール12上のポート1で構成されています。一方、ラックの下のFabric Interconnect上のクラウドDは、I/Oモジュール3のポート2およびI/Oモジュール12上のポート2で構成されています。

必須ではありませんが、冗長性を実現し、スループットを改善するために、クラウドに属する両方のポートをケーブルで接続するようにしてください。

複数のFCスイッチにまたがるゾーンを定義していない場合、クラウドに属するポートは、同じFCスイッチに接続するために配線する必要があります。

HA構成の場合、代替のFabricインターコネクト上のクラウドは同じFCスイッチに接続する必要があります。 たとえば、クラウドAとクラウドcは同じFCスイッチに接続する必要がありますが、クラウドbとクラウドdは代替スイッチに接続できます。

FCケーブルはいつでもアプライアンスに接続できます。また、システムをシャットダウンする必要はありません。これにより、ストレージを動的に追加したり、必要に応じて冗長性を改善できます。

Oracle Private Cloud Applianceでは、ファイバチャネルチャネルチャネルチャネルチャネルチャネルチャネルチャネルチャネルチャネルチャネルゾーニングが外部FCスイッチ上で構成されていて、効率的なLUN検出のためにストレージ・ネットワーク上のトラフィックの量を制御し、環境内の安定性を最大にする必要があります。

FCゾーニングは、ストレージ・ネットワーク上でトラフィックを分離する余分なレイヤーを提供することで、セキュリティを強化するためにも使用されます。 ストレージ・イニシエータ・グループを使用してLUNマスキングを実行している場合でも、一般に、LUNのエクスポージャを制限し、このネットワーク・メディアを無制限に使用するようにFCゾーンを構成することもお薦めします。 ゾーン構成は、FCのスイッチまたはスイッチがOracle Private Cloud Appliance以外のデバイスと共有される場合に非常に便利です。

Oracle Private Cloud Applianceでは、業界のベスト・プラクティスを備えた1つのイニシエータpWWNゾーンがサポートされています。 ラックへのすべてのファイバ・チャネル接続に対して単一のイニシエータpWWNゾーンを構成することを強くお薦めします。 これには、NPIVをサポートするファイバ・チャネル・スイッチが必要です。

ケーブル接続されているすべてのストレージ・クラウドの場合、各コンピュート・ノードのWWPNごとに少なくとも1つのゾーンを構成する必要があります。 ただし、配線に応じて、各WWPNに対して複数のゾーンを作成することもできます。 4つのすべてのストレージ・クラウドを使用する設定では、各コンピュート・ノードのファイバ・チャネル・スイッチに4つのゾーンが存在する必要があります。 pca-admin list wwpn-infoコマンドを実行して、コンピュート・ノードのWWPNのリストを取得できます。

アクティブ/アクティブ・クラスタ内に2つのコントローラ・ヘッドがあり、各ヘッドに2つのターゲットが構成されているファイバ・チャネル・ストレージ・デバイスを使用すると、各LUNには4つのストレージ・パスがあります。 ストレージ・パスは、ターゲットとストレージ・クラウド間の接続です。 各LUNには、ストレージ・クラウドとそのLUNを所有するコントローラ・ヘッドとの間に2つのアクティブ・パスがあり、同じストレージ・クラウドとほかのコントローラ・ヘッドの間に追加の2つのスタンバイ・パスがあります。 LUNを所有するストレージ・ヘッドに障害が発生する必要がある場合は、ほかのストレージ・ヘッドがテイ・クオーバーして、スタンバイ・パスがアクティブになります。 このようにして、特定のクラウドのストレージ接続は中断されないままです。 フェイルオーバー/フェイルバック操作のサポートを改善するには、ストレージ・クラウドごとに2つのゾーンを使用するゾーニング戦略の使用を検討します。 このアプローチでは、指定されたクラウドを1つのコントローラ・ヘッドのターゲットに接続する1つのゾーンと、同じクラウドをもう1つのコントローラ・ヘッドのターゲットに接続する2つ目のゾーンが関与します。

ファイバ・チャネルの単一のイニシエータpWWNゾーンの構成はオプションではありません。 ファイバ・チャネルを使用してストレージを拡張しようとしたときに、FCスイッチ上にゾーンを構成しなかった場合は、すぐにそれを行うようにしてください。 さらに、Dゾーン・ゾーンをすでに構成している場合は、スイッチをゾーン変更して単一のイニシエータpWWNゾーンを使用することが重要です。

1つのイニシエータpWWNゾーンを構成するために実行する必要がある構成ステップの詳細は、スイッチ・ベンダーのドキュメントを参照してください。

Oracle VM Manager内で直接ストレージにアクセスする前に、アプライアンス上でいくつかの初期構成ステップが必要になる場合があります。 通常は、これらのステップで、各LUNへのアクセス権を持つサーバーおよびクラウドを最終的に定義する特定のイニシエータ・グループにLUNをマッピングすることによって達成されるなんらかの形式のLUNマスキングを構成します。 これらのステップは、次のようにまとめることができます。

ストレージ・アプライアンス内の各クラウド内の異なるサーバーを識別するために使用するイニシエータを作成します。 これを行うには、Oracle Private Cloud Applianceラックの各サーバー上にvHBAs用に作成されたWorld Wide Port Names (WWPN)をアプライアンスに登録し、それらの別名を割り当てることにより、特定のサーバーおよびクラウドに属するものとして容易に識別できるようにします。 ほとんどのアプライアンスは、Fabric Interconnectによって提供されるWWPNを確認できる必要があります。また、Oracle Private Cloud Applianceコマンドライン・インタフェースを使用して、一致するWWPNを識別し、イニシエータを作成する際に使用する必要がある推奨の別名と一致させることができます。 これを行うには、pca-admin list wwpn-infoコマンドを実行します。

PCA> list wwpn-info WWPN vHBA Cloud_Name Server Type Alias ---- ---- ---------- ------ ---- ----- 50:01:39:70:00:69:F1:06 vhba01 Cloud_A ovcacn08r1 CN ovcacn08r1-Cloud_A 50:01:39:70:00:69:F1:08 vhba01 Cloud_A ovcacn32r1 CN ovcacn32r1-Cloud_A 50:01:39:70:00:69:F1:0C vhba01 Cloud_A ovcacn30r1 CN ovcacn30r1-Cloud_A 50:01:39:70:00:69:F1:0A vhba01 Cloud_A ovcacn29r1 CN ovcacn29r1-Cloud_A 50:01:39:70:00:69:F1:07 vhba02 Cloud_B ovcacn08r1 CN ovcacn08r1-Cloud_B 50:01:39:70:00:69:F1:09 vhba02 Cloud_B ovcacn32r1 CN ovcacn32r1-Cloud_B 50:01:39:70:00:69:F1:0B vhba02 Cloud_B ovcacn29r1 CN ovcacn29r1-Cloud_B 50:01:39:70:00:69:F1:0D vhba02 Cloud_B ovcacn30r1 CN ovcacn30r1-Cloud_B 50:01:39:70:00:6A:11:0A vhba03 Cloud_C ovcacn29r1 CN ovcacn29r1-Cloud_C 50:01:39:70:00:6A:11:0C vhba03 Cloud_C ovcacn30r1 CN ovcacn30r1-Cloud_C 50:01:39:70:00:6A:11:08 vhba03 Cloud_C ovcacn32r1 CN ovcacn32r1-Cloud_C 50:01:39:70:00:6A:11:06 vhba03 Cloud_C ovcacn08r1 CN ovcacn08r1-Cloud_C 50:01:39:70:00:6A:11:0D vhba04 Cloud_D ovcacn30r1 CN ovcacn30r1-Cloud_D 50:01:39:70:00:6A:11:0B vhba04 Cloud_D ovcacn29r1 CN ovcacn29r1-Cloud_D 50:01:39:70:00:6A:11:09 vhba04 Cloud_D ovcacn32r1 CN ovcacn32r1-Cloud_D 50:01:39:70:00:6A:11:07 vhba04 Cloud_D ovcacn08r1 CN ovcacn08r1-Cloud_D ----------------- 16 rows displayed Status: Success

出力例の別名列に注目してください。 アプライアンス上でイニシエータを構成するときは、この列に表示される値を、一致するWWPNごとに使用します。 Oracle Private Cloud Appliance CLIの詳細は、「Oracle Private Cloud Appliance管理者ガイド」の" 「Oracle Private Cloud Applianceコマンドライン・インタフェース(CLI)」 "で入手できる項を参照してください。

ご使用の環境内の別のコンピュート・ノードおよび仮想マシンへのストレージの提示方法を定義するイニシエータ・グループを作成します。 このステップは独自のストレージ要件に大きく依存します。Oracle Private Cloud Applianceと連携して記憶域アプライアンスの使用を開始する前に、慎重に計画する必要があります。

各コンピュート・ノードのvHBA上には、Fabric Interconnectで定義された各ストレージ・クラウドを表すWWPNがあります。 HA構成では、同じイニシエータ・グループに別のストレージ・クラウド用のWWPNをアタッチします。 このアプローチを使用すると、ストレージ・クラウドで障害が発生した場合に、イニシエータ・グループに対して公開されているLUNは、代替vHBAを介して各コンピュート・ノードで使用可能なままになります。 または、各コンピュート・ノードのvHBAのWWPNが異なるイニシエータ・グループで個別に使用される柔軟な構成で、高可用性をさらに犠牲にすることができます。 このタイプの構成は、仮想マシンに提供されるストレージや、リポジトリおよびサーバー関連機能に使用されるストレージなど、様々な機能のストレージを分離する場合に、意味をなす可能性があります。

ストレージ・アプライアンスで作成したLUNを、先ほど作成したイニシエータ・グループにマップします。 LUNは、それらのLUNで使用するイニシエータ・グループにのみマップするようにしてください。 LUNの再マッピングは可能ですが、Oracle VMで使用されているLUNを再マッピングすることはお薦めしません。その場合は、Oracle VMで予期しない動作が発生する可能性があります。 したがって、この構成を進める前に、要件を中心にこのステップを慎重に計画することが重要です。

注意ホスト当たり最大1024個のLUNパスが適用されます。

これらのステップを実行するには、アプライアンスに適したドキュメントを参照するか、またはベンダーに次のステップをサポートするよう依頼してください。 「例8.1 Oracleストレージ・アプライアンスZS3-4の構成」には、この目的でOracle Storage Appliance ZS3-4を正しく構成する方法を示す例が用意されています。

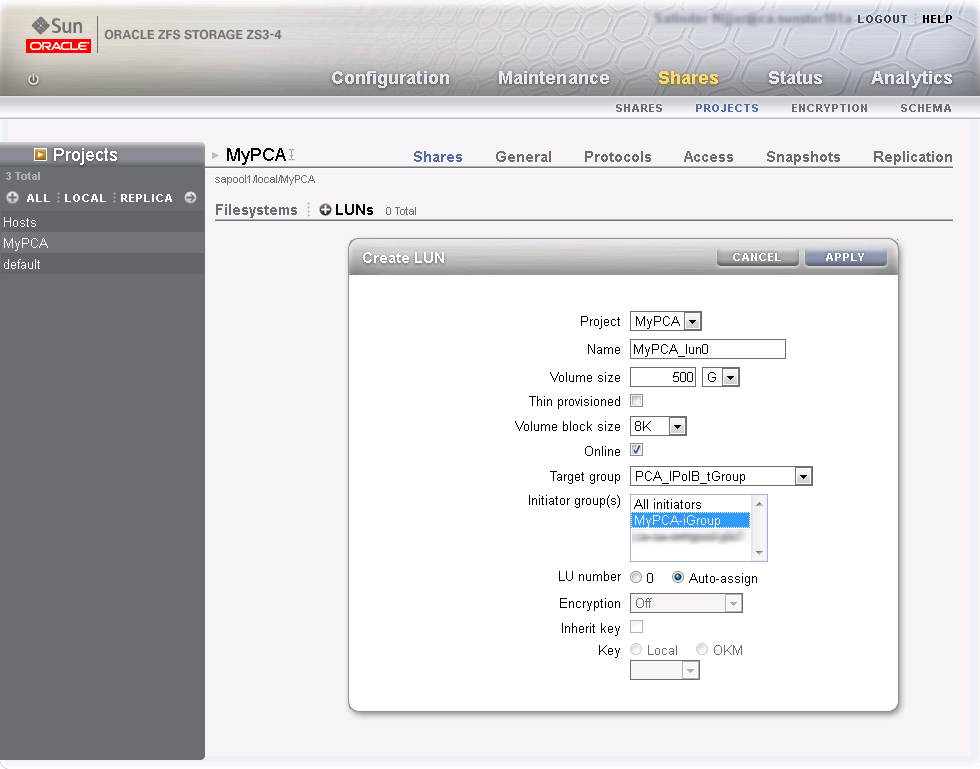

例8.1 Oracle Storage Appliance ZS3-4の構成

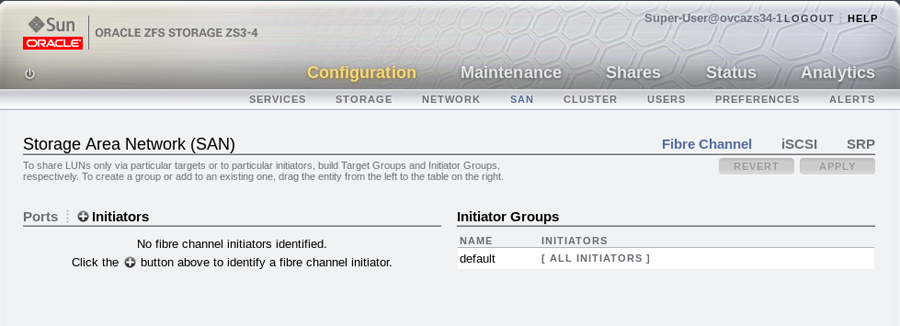

webベースのユーザー・インタフェースまたはコマンドライン・インタフェースを使用して、Oracle Storage Appliance ZS3-4を構成できます。 この手順では、webベースのユーザー・インタフェースを使用していることが前提となっています。このインタフェースには、実際に検出できるすべてのWWPNが示されているためです。

ルートまたは適切な権限を持つユーザーとしてwebベースのユーザー・インタフェースにログインし、イニシエータ・グループおよびLUNを作成してください。

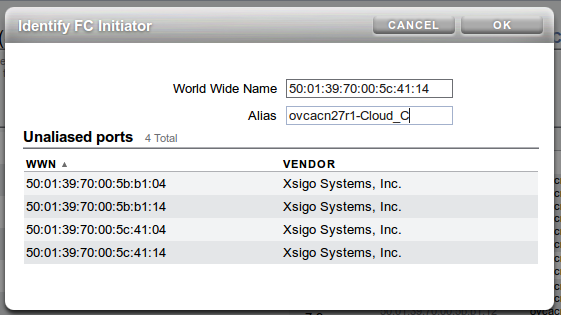

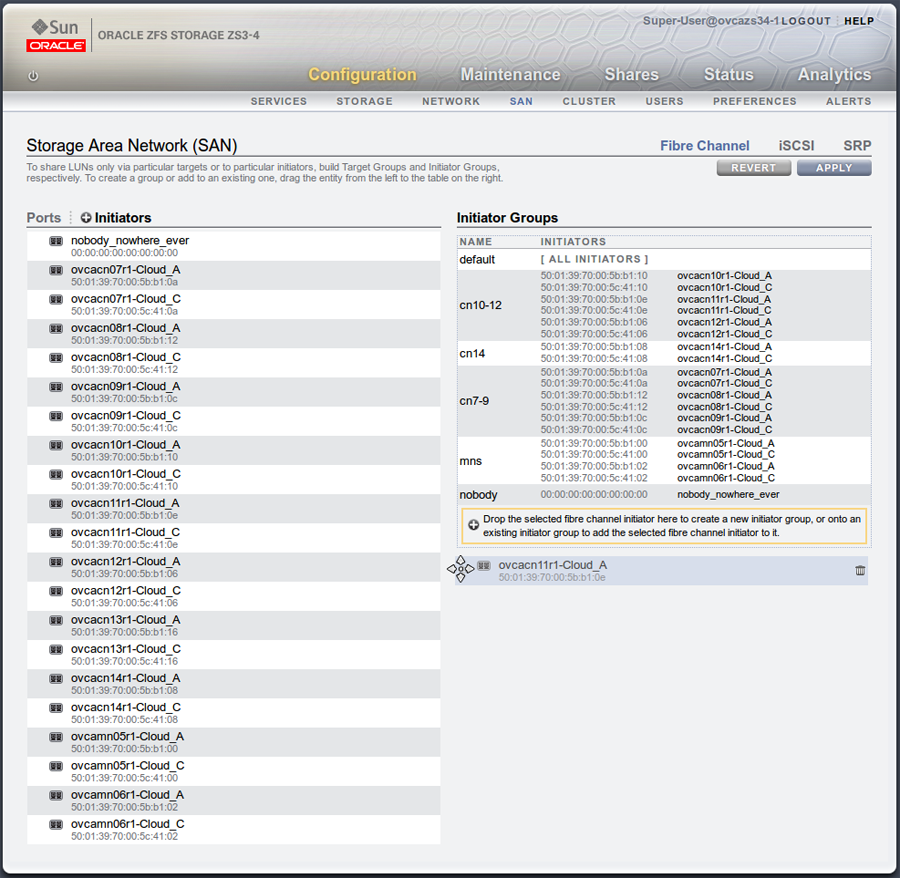

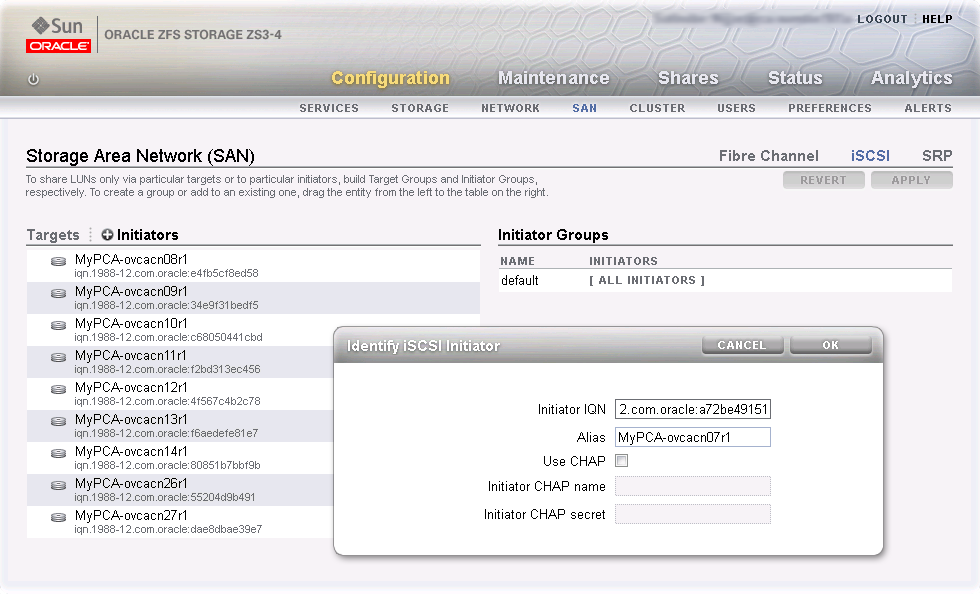

Configurationリンクをクリックし、次にSANリンクをクリックします。Fibre Channelがまだ選択されていない場合は、Fibre Channelリンクをクリックします。 「SANサマリー」ページが表示されます。次のイメージに示されている

+ Initiatorsリンクをクリックします。Identify FC Initiatorダイアログが開き、ZS3-4が検出できるWWPNが一覧表示されます。 リストされている各WWPNに対して、わかりやすい別名を作成する必要があります。これにより、これらのマップをOracle Private Cloud Appliance内で構成されたノードおよびクラウド上でどのように識別しやすくなります。 マスター管理ノードのOracle Private Cloud Applianceコマンドライン・インタフェースを使用して、すべてのWWPNおよび使用する推奨の別名のリストを取得します。 これを行うには、pca-admin list wwpn-infoコマンドを実行します。Identify FC Initiatorダイアログで一致するWWPNを検索し、これをクリックして、推奨される別名を別名フィールドに入力します。 すべてのWWPNに対してこの処理を繰り返します。 次の図は、このステップを説明したものです。各WWPNの別名の作成を完了したら、後でLUNが構成で示されるストレージ・イニシエータ・グループの作成を開始できます。 SANサマリー・ビューで新しいストレージ・イニシエータ・グループを作成するには、

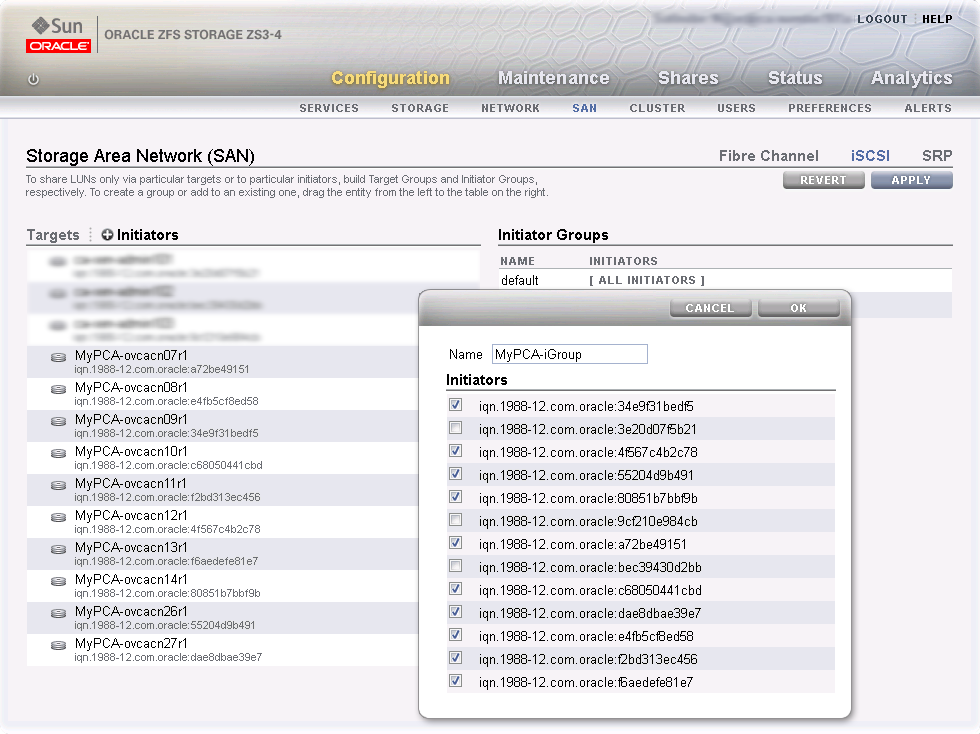

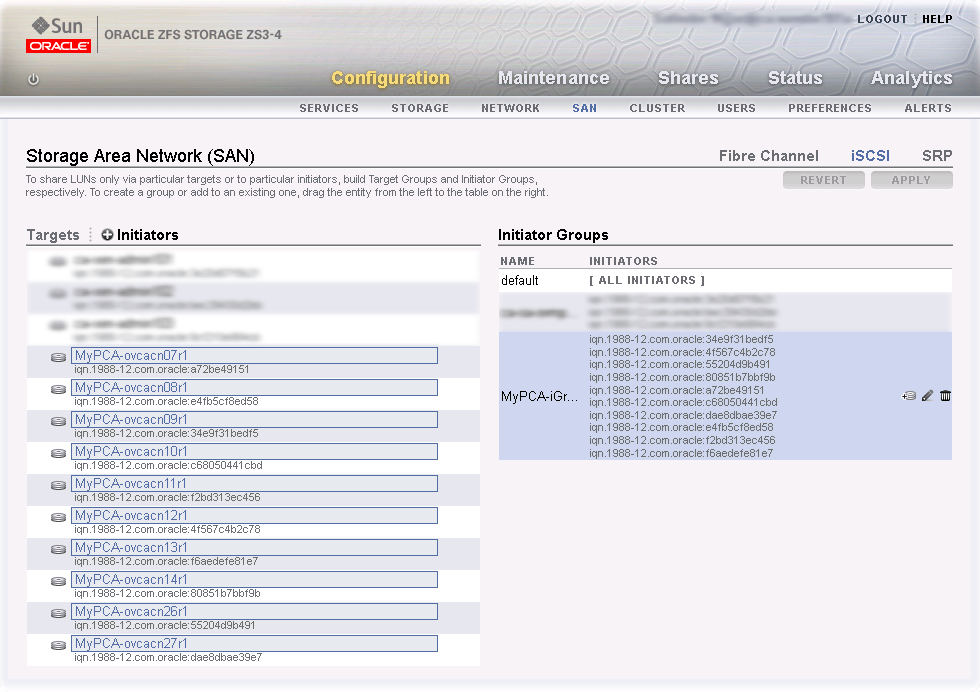

moveアイコンが表示されるまでWWN名の左側にマウスを移動し、画面の右側までドラッグして表示されるCreate New Initiator Groupボックス内にドロップします。 次の図は、このステップを説明したものです。イニシエータ・グループはいくつでも作成できます。 ほとんどの場合、ストレージがOracle Private Cloud Applianceの外部で使用されておらず、Oracle Private Cloud Appliance内のストレージを分離する必要がない場合は、デフォルトのイニシエータ・グループを使用できます。 ただし、ストレージがOracle Private Cloud Applianceの外部のアプライアンスと共有される場合は、Oracle Private Cloud Appliance内のノードに属するすべてのイニシエータのイニシエータ・グループを少なくとも作成する必要があります。 ストレージをさらに分離する必要がある場合は、画面ショットに示すように、特定のコンピュート・ノード用のイニシエータのみを含めるイニシエータ・グループを作成できます。

新しいイニシエータ・グループを作成したら、マウスを使用してそれをロールオーバーし、鉛筆の形式で表示される編集アイコンをクリックします。 イニシエータ名を編集して、より適切な名前に変更できるダイアログが表示されます。 イニシエータ・グループに含める残りのイニシエータを選択することもできます。 イニシエータ・グループの編集が終了したら、をクリックします。

イニシエータ・グループの作成および編集が終了したら、「SANサマリー」ページのボタンをクリックして、変更内容を保存することが重要です。

要件に応じて、LUNをイニシエータ・グループにマッピングする方法を定義できるようになりました。 これを実行するには、ページ上部にあるナビゲーション・バーの

Sharesリンクをクリックします。Project Summaryページでは、定義したストレージ・プールと、それらのプールに関連付けられたLUNを表示できます。 必要に応じて、各ストレージ・プールに新しいLUNを作成することもできます。 このページでは、をクリックしてLUNを編集し、表示されるストレージ・イニシエータ・グループを編集できます。 このビューでは、前のステップで定義したすべてのストレージ・イニシエータにLUNにアクセスできるようにします。

vHBAsはプロビジョニングまたはアップグレードのプロセスで各コンピュート・ノードに作成されるため、このプロセスの一環としてストレージがOracle VM Manager内で自動的にリフレッシュされ、物理ディスクはOracle VM Manager内で即時に表示される必要があります。 ただし、初期サーバー検出の実行後にOracle VM Manager内にディスクが表示されない場合は、Oracle VM Managerにアクセス可能なvHBAsとLUNが表示されるように、コンピュート・ノードを再表示する必要がある場合があります。 次のステップでは、これらのディスクがOracle VM Manager内に自動的に表示されない場合に、新しくアタッチしたFCストレージの使用を開始するためにOracle VM Managerで実行する必要があるアクションについて説明します。

再編成によって、コンピュート・ノードがクリーン状態にリストアされます。 外部記憶域リポジトリへのアクティブな接続を持つコンピュート・ノードを再プロビジョニングする場合は、再プロビジョニング後に外部ストレージ接続を再度構成する必要があります。

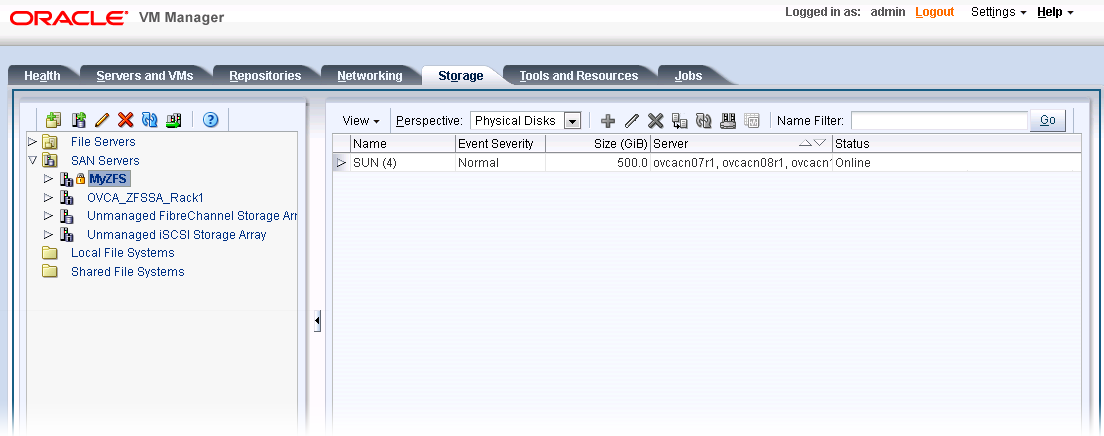

Oracle Private Cloud ApplianceのOracle VM Manager webインタフェースにログインします。

Servers and VMsタブをクリックし、すべてのコンピュート・ノード・サーバーを選択します。Rediscover Serversアイコンをクリックすると、すべてのサーバーが再表示されます。再検出の終了後、ナビゲーション・ペインでサーバーをクリックして、パースペクティブを

Storage Initiatorsに変更し、各サーバーに4つの新規vHBAsがあることを確認します。Storageタブをクリックします。ナビゲーション・ペインで

SAN Serversアイテムを展開し、Unmanaged Fibre Channel Storage Arrayを選択します。Editアイコンをクリックし、表示されるダイアログのAdmin Serversタブにナビゲートします。すべてのコンピュート・ノード・サーバーをストレージ・アレイの管理サーバーとして追加し、をクリックしてダイアログを閉じます。

Refresh SAN Serverアイコンをクリックし、確認ダイアログでをクリックします。すべてのサーバーが更新されるまで待機します。 この操作が完了するまでには数分かかる場合があります。

LUNは、

Unmanaged Fibre Channel Storage ArrayのPhysical Disksのパースペクティブに表示されます。サーバーをクリックして、

Physical Disksビューのパースペクティブを変更することによって、Servers and VMsのタブでサーバーに対してLUNが使用可能であることを確認できます。

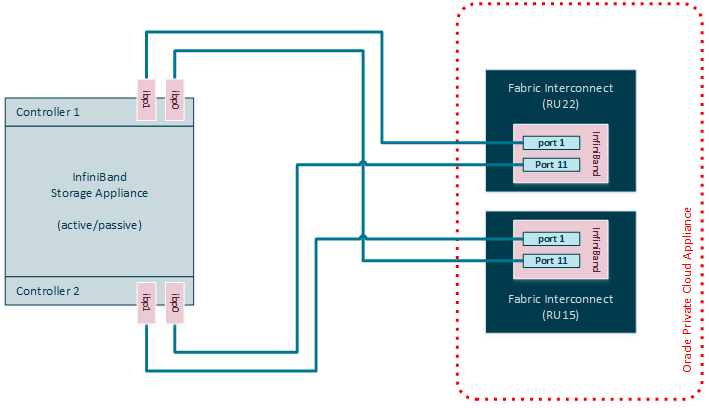

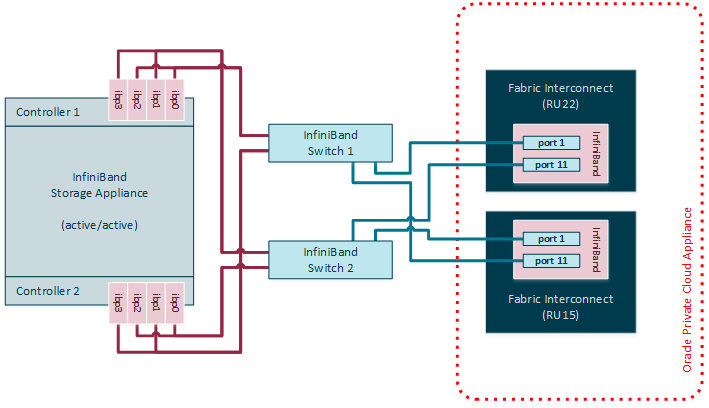

InfiniBandを使用すると、Fabricインターコネクトの使用可能なポートを使用して、追加のZFS Storage AppliancesをOracle Private Cloud Appliance (PCA)に接続できます。 ZFS Storage Appliancesは断続的に管理されるため、各ZFS Controllerヘッドには、各Fabric Interconnectへの独自のInfiniBand接続があり、ZFS Storage Applianceの側面とOracle Private Cloud Applianceの側面の両方で冗長性が提供されます。

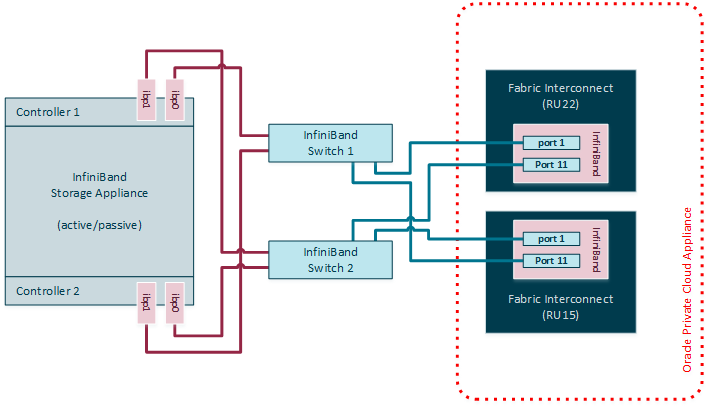

Oracle Fabric Interconnect F1-15sには、使用可能なInfiniBandポートが4つのみあります。 - Fabric Interconnectごとに2つ - 外部ストレージをアタッチする場合。 パフォーマンスを向上する必要がある場合、または複数のストレージ・アプライアンスを接続する必要がある場合は、外部ストレージとFabric Interconnect間の2つの外部NM2-36P Sun Datacenter InfiniBand拡張スイッチをラック内に追加できます。 ZFS Storage Applianceは、アクティブ/パッシブまたはアクティブ/アクティブ構成のInfiniBandスイッチに接続できます。 アクティブ/アクティブ構成が選択されている場合、両方のストレージ・コントローラを、ZFSコントローラ・ヘッドごとの合計4 InfiniBandポートの場合は追加のHCAで拡張する必要があります。

Oracle Private Cloud Applianceを使用したInfiniBandのストレージに関する最新の詳細情報は、「Oracle ZFS Storage Applianceを使用したOracle Private Cloud Applianceの拡張」というホワイト・ペーパーを参照してください。

ZFSアプライアンスをOracle Private Cloud Applianceクロス・コネクトに接続するために実装する必要のある推奨されるケーブル構成では、4つの接続の合計を求める各コントローラ・ヘッドがFabric Interconnectに接続されます。 この構成により、冗長性とスループットが最大化されます。 次の表では、Oracle Private Cloud ApplianceとZFS Storage Appliance上のFabric Interconnect間の配線の接続方法を説明します。

表8.3 InfiniBand Cabling to Attach a ZFS Storage Appliance to the Oracle Private Cloud Appliance Fabric Interconnects

上位Oracle Fabric Interconnect F1-15 (RU 22-25): | Oracle Fabric Interconnect F1-15の下位(RU 15-18): | ZFS Storage Appliance Controller Head 1 | ZFS Storage Appliance Controller Head 2 |

|---|---|---|---|

IBポート1 | なし | IBポート1 (ibp0) | なし |

IBポート11 | なし | なし | IBポート1 (ibp0) |

なし | IBポート1 | IBポート2 (ibp1) | なし |

なし | IBポート11 | なし | IBポート2 (ibp1) |

外部ストレージとアプライアンス・ラックの間に2つのInfiniBandスイッチを設置した場合、これらのスイッチは、直接アタッチされたZFS Storage Applianceの2つのコントローラと同じ配線パターンを使用してFabric Interconnectポートにアタッチします。 ZFS Storage Applianceの側面では、アクティブ/パッシブ構成の配線パターンは、InfiniBandスイッチに接続されているか、Fabric Interconnectに直接接続されているかに関係なく同一になります。

ZFS Storage Applianceがアクティブ/アクティブ構成である場合、ZFSコントローラとInfiniBandスイッチのペアの間の冗長性を提供するために、ケーブル接続を空ける必要があります。 両方のコントローラ・ヘッドがアクティブ・モードであるため、両方のコントローラに2つのスイッチへの冗長接続が必要です(つまり、コントローラごとに4本のケーブルを意味します)。

サポートされている様々なケーブル接続レイアウトを次の図に示します。

次のIPアドレス・ブロックは、Oracle Private Cloud Applianceラック外部のZFS Storage Applianceで使用するために予約されています。

192.168.40.242

192.168.40.243

192.168.40.244

192.168.40.245

192.168.40.246

192.168.40.247

192.168.40.248

192.168.40.249

この項では、Oracle Private Cloud ApplianceとともにIPoIBを使用するためにZFS Storage Applianceで実行する必要がある構成ステップについて説明します。 ここで説明する説明では、iSCSIを使用してLUNをコンピュート・ノードまたは仮想マシンを物理ディスクとしてサーブして、アクティブ/パッシブ管理クラスタを持つ一般的な構成を想定しています。 ZFS Storage Applianceは標準的なNFS構成もサポートします。

追加の拡張カードをZFS Storage Applianceコントローラに取り付け、外部ストレージとFabric Interconnectの間にInfiniBandスイッチのペアを追加すると、アクティブ/アクティブ構成でZFS Storage Appliance管理クラスタを設定できます。 次の手順の注意事項では、必要な追加構成を強調表示しています。

ZFS Storage Applianceでの基本的なIPoIB構成の作成

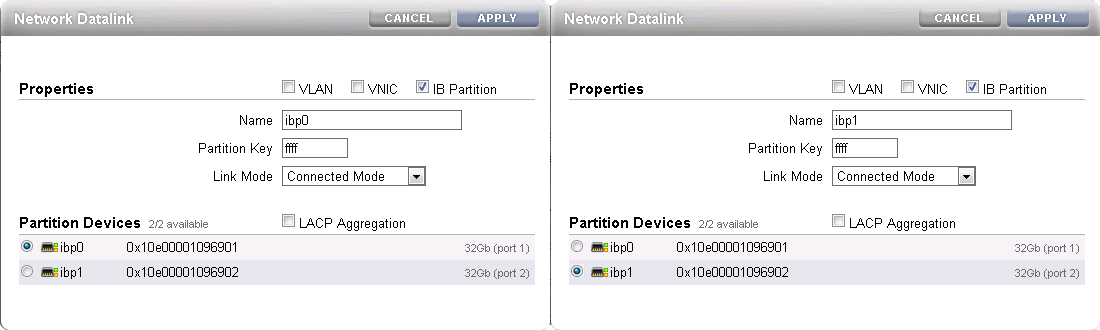

データリンクの作成

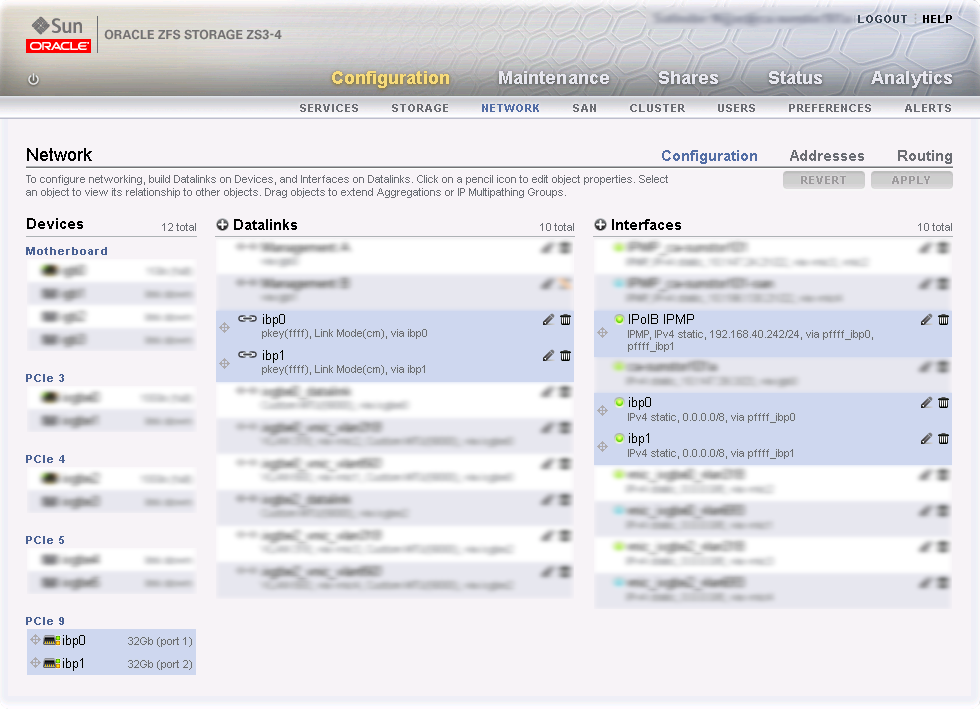

マスターとして使用するコントローラ・ヘッド上の管理ユーザー・インタフェースにログオンします。 、の順に移動します。 正しく配線している場合は、2つのアクティブ・デバイスが配線IBポートにマップされていることを示します。

注意「アクティブ/アクティブ構成」では、両方のコントローラのヘッドに4つのアクティブなデバイスがあります: 通常、

ibp0、ibp1、ibp2およびibp3。これらの各データリンクをデータリンク・メニューにドラッグして、各デバイスに新しいデータリンクを作成します。 これらの各データリンクを編集して、データリンク名とパーティション・キーを指定します。

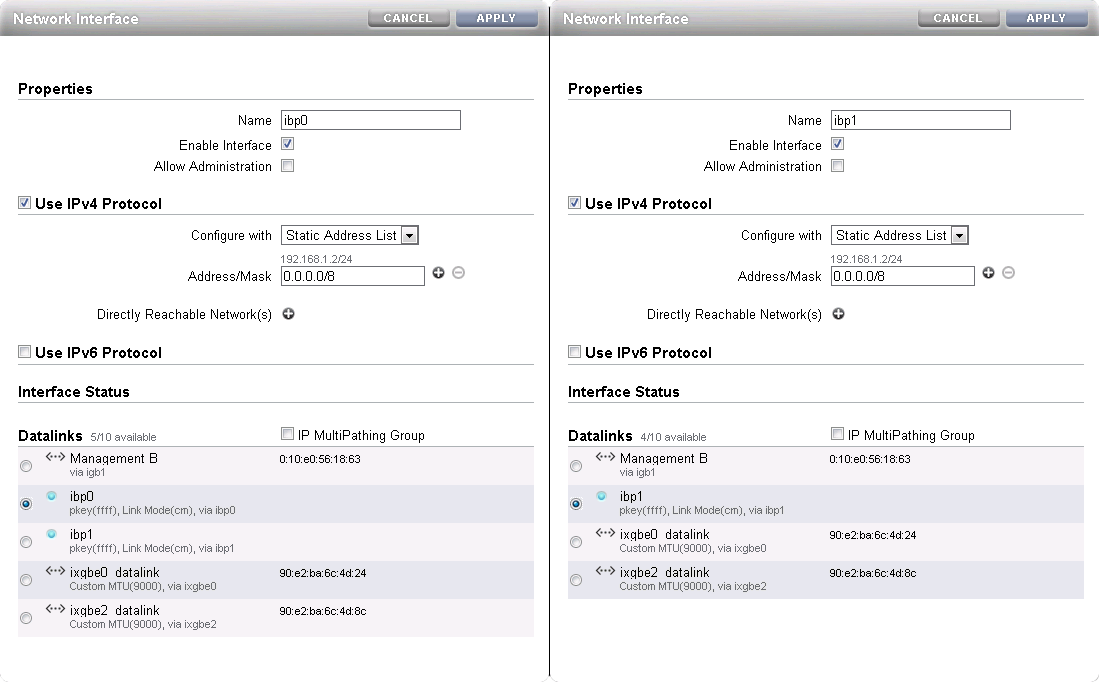

インタフェースを作成

構成済の各データリンクをインタフェース・メニューにドラッグして、定義した各データリンクのインタフェースを作成します。 各インタフェースを編集して、インタフェースを簡単に識別できる名前フィールドの値を指定します。 ネットマスク0.0.0.0/8を各インタフェースに追加して、ネットワーク接続の背後にあるルーティングの詳細のプローブおよびテストをシステムが実行しないようにします。 IP MultiPathingグループは選択しないままにします。 この段階ではIPアドレスを構成しないでください。

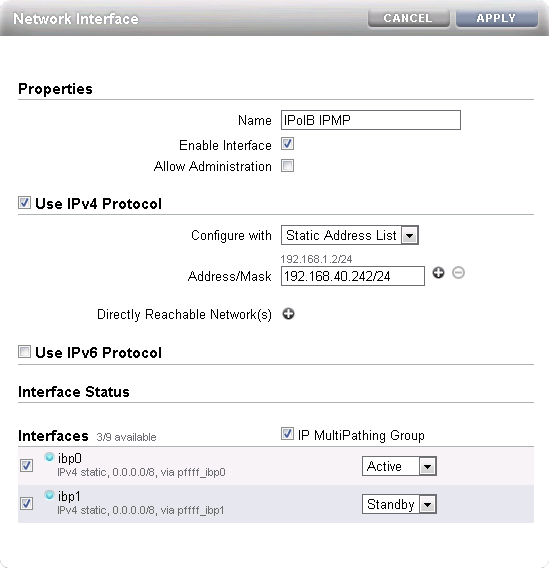

マルチパスの構成

インタフェース・メニューのプラス・アイコンをクリックして、追加のインタフェースを作成します。 この追加インタフェースにより、前のステップで作成した2つのインタフェース全体でIPMPが有効になります。 名前フィールドに、IPMPインタフェースを簡単に識別できる値を入力します。 Oracle Private Cloud Applianceストレージ・ネットワークの予約済IPのリストからIPアドレスを割り当てます。

ウィンドウの下部にあるIP MultiPathingグループ・チェック・ボックスを選択します。 以前に構成した2つのインタフェースを選択し、最初のインタフェースをアクティブ、2番目のインタフェースをスタンバイとしてマークします。 選択したIPアドレスは、スタンバイ・インタフェースへのフェイルオーバーが発生するまで、アクティブ・インタフェース上で構成されます。

注意「アクティブ/アクティブ構成」で、2つのIPMPインタフェースを作成します: 一方が

ibp0とibp2をインタフェースし、もう一方がibp1とibp3のインタフェースをインタフェースします。 これにより、2つのPCIe InfiniBand拡張カードの冗長性が確保されます。 各IPMPインタフェースにIPアドレスを割り当てます。 構成が他方のストレージ・コントローラにレプリケートされます。接続構成の適用

適用ボタンをクリックして、この時点までに実行した接続構成をコミットします。 構成に関連付けられたデバイス、データリンクまたはインタフェースを選択すると、次のスクリーンショットに示すように、すべての関連アイテムがユーザー・インタフェースで強調表示されます。 イメージでは、このプロシージャの構成に関連しないその他すべてのアイテムが選択解除されています。

管理クラスタ構成の検証

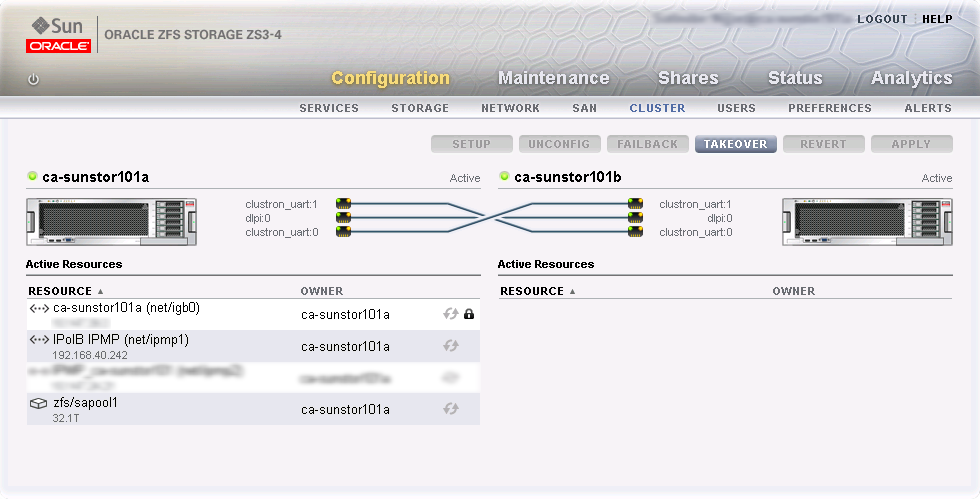

この章で提案される外部ストレージ設定には、アクティブ/パッシブのクラスタ構成があります。 このため、Oracle Private Cloud Applianceのすべてのストレージ・リソースは、一度に1つの特定のIPアドレスで使用できる必要があります。 IPアドレスおよびストレージ・リソースは管理クラスタ内のアクティブ・ヘッドによって所有され、スタンバイ・ヘッドはIPアドレスを引き継ぎ、アクティブ・ヘッドで障害が発生すると同じストレージ・リソースを公開します。

アクティブなストレージ・コントローラで、に移動して、次にに移動します。 次のスクリーンショットに、アクティブ/パッシブ・クラスタ構成を示します。 Oracle Private Cloud Appliance外部ストレージ設定に含まれるすべてのリソースは、アクティブ・ヘッドによって所有されます: ストレージ・アプライアンス管理インタフェース、Oracle Private Cloud Appliance外部ストレージ接続用に特に構成されたIPMPインタフェース、およびLUNが作成されるストレージ・プール。

この設定では、構成全体がアクティブ・コントローラに適用され、スタンバイ・コントローラに自動的にレプリケートされます。 すべてのリソースはアクティブ・ヘッドが所有しているため、スタンバイ・ヘッドにログオンして構成を変更する必要はありません。

注意「アクティブ/アクティブ構成」のストレージ・コントローラは、ストレージ・プール内のストレージ・リソースの所有権を取ります。 各ストレージ・コントローラは、個別の冗長なネットワーク・パスを使用してOracle Private Cloud Applianceにストレージ・リソースを提示します。 特定の時点でアクティブなパスがマルチパスを通して特定されます。

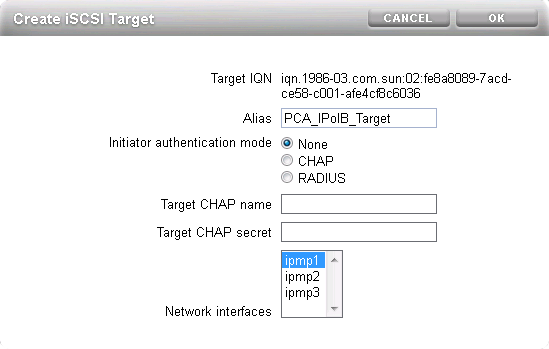

iSCSIターゲットの構成

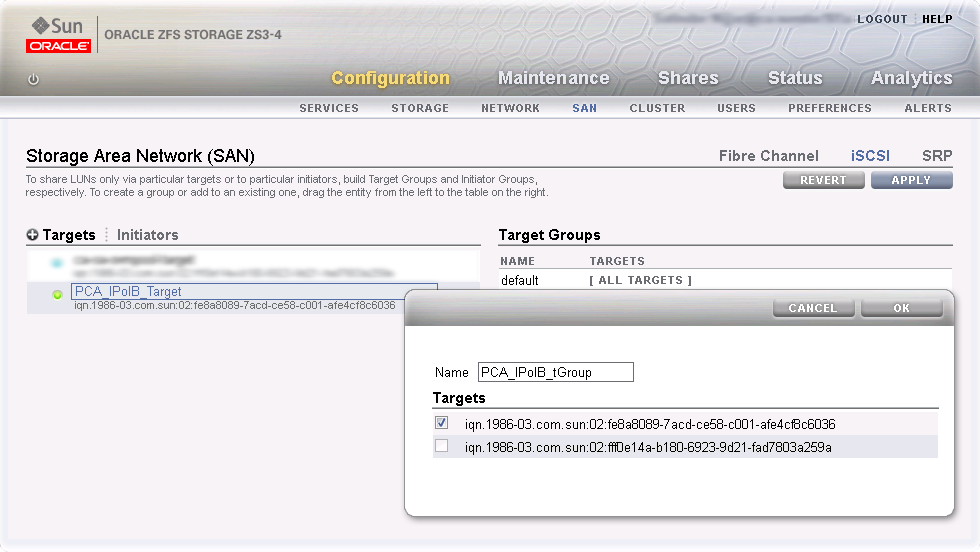

アクティブなコントローラで、、およびに移動します。 ターゲット・メニューのプラス・アイコンをクリックして、新しいiSCSIターゲットを作成します。 別名フィールドに、iSCSIターゲットを簡単に識別できる値を入力します。 Oracle Private Cloud Appliance外部ストレージ接続用に特に構成したIPMPインタフェースを選択します。 OKをクリックして新しいターゲットを作成します。

作成したiSCSIターゲットをターゲット・グループ領域にドラッグして、ターゲット・グループを作成します。 ターゲット・グループを編集し、適切な名前を付けて、正しいiSCSIターゲットのIQNが選択されていることを確認します。 「OK」をクリックして、変更を保存します。

注意「アクティブ/アクティブ構成」では、各ストレージ・コントローラでiSCSIターゲットとターゲット・グループを作成する必要があります。 ターゲット構成で、作成した2つのIPMPインタフェースを選択します。

次のステップで構成されるiSCSIイニシエータおよびイニシエータ・グループは、2番目のストレージ・コントローラに自動的にレプリケートされます。

iSCSIイニシエータの構成

最初に、外部ストレージへのアクセス権を付与する各コンピュート・ノードのIQNを取得する必要があります。 Oracle Private Cloud Applianceのマスター管理ノードにログオンし、次の手順を実行します。

CLIを使用して、すべてのコンピュート・ノードを一覧表示します。

[root@ovcamn05r1 ~]# pca-admin list compute-node Compute_Node IP_Address Provisioning_Status ILOM_MAC Provisioning_State ------------ ---------- ------------------- -------- ------------------ ovcacn09r1 192.168.4.7 RUNNING 00:10:e0:3f:82:75 running ovcacn13r1 192.168.4.11 RUNNING 00:10:e0:3f:87:73 running ovcacn26r1 192.168.4.13 RUNNING 00:10:e0:3e:46:db running ovcacn12r1 192.168.4.10 RUNNING 00:10:e0:3f:8a:c7 running ovcacn08r1 192.168.4.6 RUNNING 00:10:e0:3f:84:df running ovcacn27r1 192.168.4.14 RUNNING 00:10:e0:3f:9f:13 running ovcacn07r1 192.168.4.5 RUNNING 00:10:e0:3f:75:73 running ovcacn11r1 192.168.4.9 RUNNING 00:10:e0:3f:83:23 running ovcacn10r1 192.168.4.8 RUNNING 00:10:e0:3f:89:83 running ovcacn14r1 192.168.4.12 RUNNING 00:10:e0:3f:8b:5d running ----------------- 10 rows displayed Status: Success

各コンピュート・ノードにSSHして、ファイル

initiatorname.iscsiの内容を表示します。[root@ovcamn05r1 ~]# ssh ovcacn07r1 root@ovcacn07r1's password: [root@ovcacn07r1 ~]# cat /etc/iscsi/initiatorname.iscsi InitiatorName=iqn.1988-12.com.oracle:a72be49151 [root@ovcacn07r1 ~]# exit logout Connection to ovcacn07r1 closed. [root@ovcamn05r1 ~]#

ヒントSSHを使用して、リストされた各コンピュート・ノードに接続すると、IQNを取得する最も高速な方法です。 ただし、各サーバーのストレージ・イニシエータ・パースペクティブで、Oracle VM Managerユーザー・インタフェースからもコピーできます。

コンピュート・ノードのIQNをコピーし、これを使用して、ZFS Storage Applianceユーザー・インタフェースで対応するiSCSIイニシエータを定義します。

イニシエータ・リンクをクリックして、LUNを公開するコンピュート・ノード用のiSCSIイニシエータを定義します。 プラス・アイコンをクリックして、新しいiSCSIイニシエータを識別します。 コンピュート・ノードのイニシエータIQNと、iSCSIイニシエータを簡単に識別できる別名を入力します。 すべてのイニシエータがリストに表示されるように、各コンピュート・ノードに対してこの操作を繰り返します。

作成したiSCSIイニシエータの1つをイニシエータ・グループ領域にドラッグして、新しいイニシエータ・グループを作成します。 イニシエータ・グループを編集して適切な名前を付け、このイニシエータ・グループのメンバーにするコンピュート・ノードのすべてのIQNが選択されていることを確認します。 「OK」をクリックして、変更を保存します。

iSCSIターゲットとイニシエータの構成を適用

適用ボタンをクリックして、この時点までに実行したiSCSIターゲットとイニシエータの構成をコミットします。 構成に関連付けられたイニシエータまたはイニシエータ・グループを選択すると、次のスクリーンショットに示すように、すべての関連アイテムがユーザー・インタフェースで強調表示されます。 このプロシージャの構成に関連しないその他のアイテムは、イメージで外部に出力されました。

LUNの作成

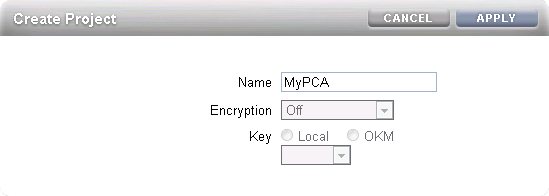

管理を容易にするために、ストレージ・リソースを別々のプロジェクトに編成することをお薦めします。 まずOracle Private Cloud Appliance外部ストレージのプロジェクトを作成し、必要に応じてLUNを追加してください。

アクティブなストレージ・コントローラで、に移動します。 左側のプラス・アイコンをクリックして、新規プロジェクトを作成します。 「プロジェクトの作成」ダイアログ・ボックスで、名前を入力してプロジェクトを簡単に識別できるようにします。 適用をクリックして新規プロジェクトを保存します。

左側のナビゲーション・ペインで、作成したプロジェクトを選択します。 シェア・ウィンドウで、最初にLUNを選択してからPlusアイコンをクリックし、このプロジェクトの一部として新規LUNを作成します。

LUNプロパティを入力し、前に作成したiSCSIターゲット・グループとイニシエータ・グループを選択し、名前を入力すると、LUNを簡単に識別できます。 適用をクリックして、LUNを選択したプロジェクトに追加します。

注意「アクティブ/アクティブ構成」では、各ストレージ・コントローラはストレージ・プールを所有します。 各ストレージ・コントローラでOracle Private Cloud Applianceとともに使用するストレージ・プロジェクトを作成する必要があります。 作成したLUNを、Oracle Private Cloud Applianceコンピュート・ノードを含むiSCSIイニシエータ・グループ、および選択したストレージ・コントローラのiSCSIターゲット・グループに関連付けます。 その結果、問題のLUNは、そのストレージ・コントローラによって所有されます。 最適なパフォーマンスのために、ストレージ・リソースの所有権を両方のアクティブなストレージ・コントローラの間で均衡化する必要があります。

これらのLUNにOracle VM Manager内の物理ディスクとしてアクセスする場合は、まずOracle VM Managerを構成する必要があります。 詳細は、「ISCSI構成」を参照してください。

ZFSアプライアンスを使用して、Oracle VMで直接使用するストレージを提供し、リポジトリおよび仮想マシンをホストする場合、使用する前にOracle VM Manager内にストレージを構成する必要があります。 実行する必要がある構成ステップは、ZFS Storage ApplianceでiSCSIまたはNFSを構成したかどうかによって異なります。 この項では、これらの各テクノロジのOracle VM Managerを構成するために実行する必要があるステップの概要を説明します。 詳細は、Oracle VMドキュメントを参照してください。

このストレージを個々の仮想マシンで使用できるようにする場合で、基礎となるOracle VMインフラストラクチャのストレージを使用しない場合、この項に記載されているステップを実行する必要はありませんが、NFSまたはiSCSIを介してストレージにアクセスするには、各仮想マシンを直接構成する必要があります。

再編成によって、コンピュート・ノードがクリーン状態にリストアされます。 外部記憶域リポジトリへのアクティブな接続を持つコンピュート・ノードを再プロビジョニングする場合は、再プロビジョニング後に外部ストレージ接続を再度構成する必要があります。

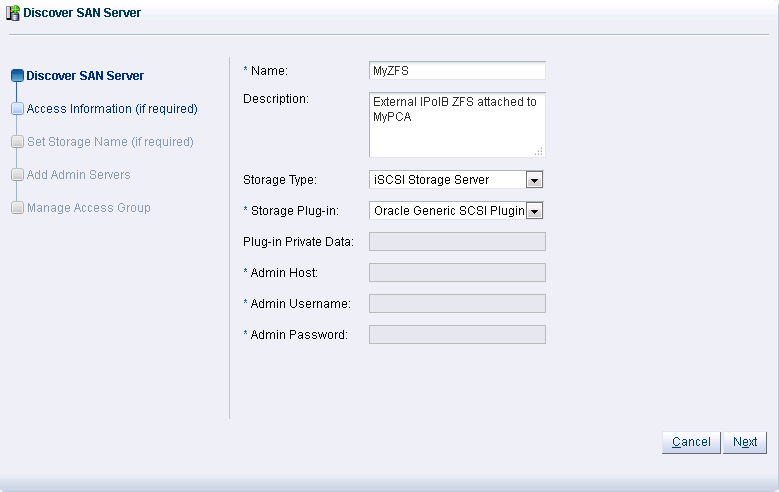

iSCSI用にストレージ・アプライアンスを構成した場合は、Oracle VM Managerで次の構成ステップを実行する必要があります。 Oracle VM ManagerでSANサーバーを追加するプロセスは、「Oracle VM Managerユーザーズ・ガイド」のドキュメントに記載されています。 「Discover SANサーバー」のタイトルの項を参照してください。

Oracle Private Cloud ApplianceでOracle VM Managerにログインします。

Storageタブを選択して、ストレージを構成しますDiscover SAN Serverアイコンをクリックし、ウィザードをロードします名前フィールドにストレージ・アプライアンスのDNS名を入力します。 「ストレージのタイプ」フィールドで、ドロップダウン・セレクタを使用して

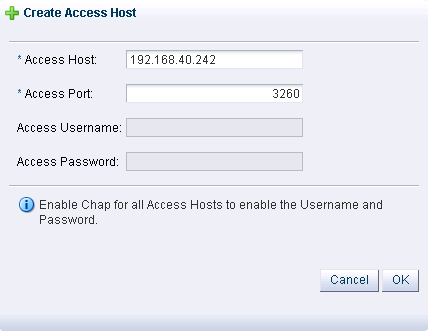

iSCSI Storage Serverを選択します。 「ストレージ・プラグイン」フィールドで、Oracle Generic SCSI pluginを選択する必要があります。 この構成では、代替ストレージ・プラグインはサポートされないことに注意してください。 をクリックします。「アクセス情報」ダイアログで、新しいアクセス・ホストを追加できるアイコンをクリックします。 「アクセス・ホストの作成」ダイアログが開きます。 192.168.40.242など、ストレージ・アプライアンスのIPMPインタフェースに対して構成したIPアドレスを入力します。 CHAPアクセスを使用してストレージ・アプライアンスを構成している場合は、ここでCHAPユーザー名およびパスワードも入力する必要があります。 をクリックして「アクセス・ホストの作成」ダイアログを閉じます。 をクリックします。

「管理サーバーの追加」ダイアログで、使用可能なサーバー・フレームのすべてのサーバーを選択し、選択したサーバー・フレームに移動します。 をクリックします。

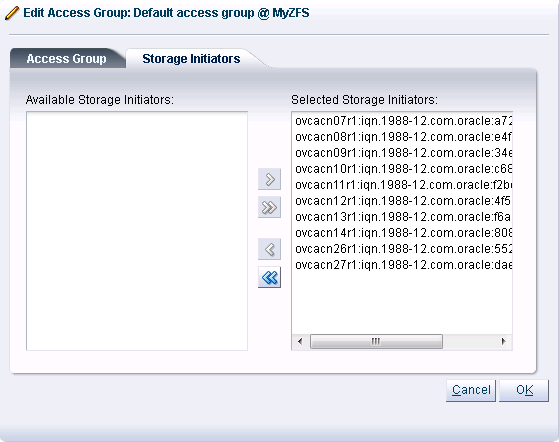

「アクセス・グループの管理」ダイアログで、

Default Access Groupをクリックして、編集アイコンをクリックします。 「アクセス・グループの編集」ダイアログが開きます。Storage Initiatorsタブをクリックします。 ZFS Storage Appliance上で構成したすべてのイニシエータからIQN名を選択し、「選択したストレージ・イニシエータ」ペインに移動します。 通常、すべてのIQNを移動できます。 変更を保存する場合は、をクリックします。ボタンをクリックしてウィザードを終了し、変更を保存します。

iSCSIサーバーがナビゲーション・ペインのSANサーバー・ツリーに表示されます。 ストレージ検出のあと、LUNは物理ディスクのパースペクティブに表示されます。

ZFS Storage Applianceがアクティブ/アクティブ構成で実行されている場合、公開された2つのiSCSIターゲットは、Oracle VM Managerによる別のSANサーバーとして検出されます。 各アクセス・ホストIPアドレスに対してDiscover SANサーバー手順を個別に実行して、2つのそれぞれのコントローラが所有するストレージ・リソースをOracle Private Cloud Applianceで使用できるようにする必要があります。

NFSのストレージ・アプライアンスを構成した場合は、Oracle VM Managerで次の構成ステップを実行する必要があります。 Oracle VM Managerのファイル・サーバーを追加するプロセスは、「Oracle VM Managerユーザーズ・ガイド」のドキュメントに記載されています。 「Discoverファイル・サーバー」のタイトルの項を参照してください。

Oracle Private Cloud ApplianceでOracle VM Managerにログインします。

Storageタブを選択して、ストレージを構成しますDiscover File Serverアイコンをクリックし、ウィザードをロードします必要な情報をすべてウィザードに入力します。 デバイスに対して構成したIPアドレスを、192.168.40.242などのアクセス・ホストIPとして使用します。

管理サーバーとして指定する必要があるすべてのコンピュート・ノードを選択します。

サーバーのリフレッシュに使用する2つまたは3つのコンピュート・ノードを選択します。

使用するファイル・システムを選択します。

「終了」ボタンをクリックします。ファイル・サーバーがナビゲーション・ペインのファイル・サーバー・ツリーに表示されます。

ZFS Storage Applianceがアクティブ/アクティブ構成で実行されている場合は、アクセス・ホストIPアドレスごとにDiscoverファイル・サーバー手順を個別に実行して、2つのそれぞれのコントローラが所有するストレージ・リソースをOracle Private Cloud Applianceで使用できるようにする必要があります。